Wdrażanie wysokiej jakości, wytrenowanych modeli uczenia maszynowego (ML) do przeprowadzania wnioskowania wsadowego lub w czasie rzeczywistym jest kluczowym elementem przynoszącym wartość klientom. Jednak proces eksperymentowania z uczeniem maszynowym może być żmudny — istnieje wiele podejść, których wdrożenie wymaga znacznej ilości czasu. Dlatego wstępnie przeszkolone modele ML, takie jak te dostarczone w Modelowe zoo PyTorch są tak pomocne. Amazon Sage Maker zapewnia ujednolicony interfejs do eksperymentowania z różnymi modelami ML, a PyTorch Model Zoo pozwala nam łatwo wymieniać nasze modele w ustandaryzowany sposób.

Ten post na blogu pokazuje, jak przeprowadzić wnioskowanie ML przy użyciu modelu wykrywania obiektów z Zoo modelowego PyTorch w SageMaker. Wstępnie wytrenowane modele ML z PyTorch Model Zoo są gotowe i mogą być łatwo używane jako część aplikacji ML. Konfigurowanie tych modeli ML jako punktu końcowego SageMaker lub Transformacja wsadowa SageMaker zadanie do wnioskowania online lub offline jest łatwe dzięki krokom opisanym w tym poście na blogu. użyjemy a Szybszy R-CNN model wykrywania obiektów do przewidywania ramek ograniczających dla predefiniowanych klas obiektów.

Przechodzimy przez kompleksowy przykład, od załadowania wag modelu wykrywania obiektów Faster R-CNN, do zapisania ich w Usługa Amazon Simple Storage (Amazon S3) wiadra, oraz do napisania pliku punktu wejścia i zrozumienia kluczowych parametrów w API PyTorchModel. Na koniec wdrożymy model ML, przeprowadzimy na nim wnioskowanie za pomocą SageMaker Batch Transform, sprawdzimy dane wyjściowe modelu ML i nauczymy się interpretować wyniki. To rozwiązanie można zastosować do dowolnego innego wstępnie wytrenowanego modelu w PyTorch Model Zoo. Aby uzyskać listę dostępnych modeli, zobacz Dokumentacja PyTorch Model Zoo.

Omówienie rozwiązania

Ten wpis na blogu przeprowadzi Cię przez następujące kroki. Aby uzyskać pełną wersję roboczą wszystkich kroków, zobacz create_pytorch_model_sagemaker.ipynb

- Krok 1: Konfiguracja

- Krok 2: Ładowanie modelu ML z PyTorch Model Zoo

- Krok 3 Zapisz i prześlij artefakty modelu ML do Amazon S3

- Krok 4: Budowanie skryptów wnioskowania o modelu ML

- Krok 5: Uruchomienie zadania transformacji wsadowej SageMaker

- Krok 6: Wizualizacja wyników

Schemat architektury

struktura katalogów

Kod tego bloga można znaleźć w this Repozytorium GitHub. Baza kodu zawiera wszystko, czego potrzebujemy do tworzenia artefaktów modelu ML, uruchamiania zadania transformacji i wizualizacji wyników.

To jest przepływ pracy, którego używamy. Wszystkie poniższe kroki będą odnosiły się do modułów w tej strukturze.

Połączenia sagemaker_torch_model_zoo folder powinien zawierać inference.py jako plik punktu wejścia i create_pytorch_model_sagemaker.ipynb, aby załadować i zapisać wagi modelu, utworzyć obiekt modelu SageMaker i ostatecznie przekazać go do zadania transformacji wsadowej SageMaker. Aby wprowadzić własne modele ML, zmień ścieżki w sekcji Krok 1: konfiguracja notebooka i załaduj nowy model w sekcji Krok 2: Ładowanie modelu ML z sekcji PyTorch Model Zoo. Pozostałe poniższe kroki pozostaną takie same.

Krok 1: Konfiguracja

Role IAM

SageMaker wykonuje operacje na infrastrukturze zarządzanej przez SageMaker. SageMaker może wykonywać tylko czynności dozwolone zgodnie z definicją w towarzyszącej notatnikowi roli wykonawczej IAM dla SageMaker. Aby uzyskać bardziej szczegółową dokumentację dotyczącą tworzenia ról IAM i zarządzania uprawnieniami IAM, zobacz Dokumentacja ról AWS SageMaker. Możemy stworzyć nową rolę, lub możemy dostać Notatnik SageMaker (Studio).domyślną rolę wykonawczą, uruchamiając następujące wiersze kodu:

Powyższy kod pobiera rolę wykonawczą SageMaker dla instancji notatnika. To jest rola IAM, którą utworzyliśmy dla naszej instancji notatnika SageMaker lub SageMaker Studio.

Parametry konfigurowane przez użytkownika

Oto wszystkie konfigurowalne parametry potrzebne do zbudowania i uruchomienia naszego zadania transformacji wsadowej SageMaker:

Krok 2: Ładowanie modelu ML z PyTorch Model Zoo

Następnie określamy model wykrywania obiektów z PyTorch Model Zoo i zapisujemy jego wagi modelu ML. Zazwyczaj zapisujemy model PyTorch z rozszerzeniem pliku .pt lub .pth. Poniższy fragment kodu pobiera wstępnie przeszkolony model Faster R-CNN ResNet50 ML z PyTorch Model Zoo:

model = torchvision.models.detection.fasterrcnn_resnet50_fpn(pretrained=True)

Transformacja wsadowa SageMaker wymaga jako danych wejściowych pewnych wag modelu, więc zapiszemy wstępnie wytrenowany model ML jako model.pt. Jeśli chcemy załadować niestandardowy model, możemy zamiast tego zapisać wagi modelu z innego modelu PyTorch jako model.pt.

Krok 3: Zapisz i prześlij artefakty modelu ML do Amazon S3

Ponieważ będziemy używać SageMaker do wnioskowania ML, musimy przesłać wagi modelu do zasobnika S3. Możemy to zrobić za pomocą następujących poleceń lub pobierając i po prostu przeciągając i upuszczając plik bezpośrednio do S3. Następujące polecenia najpierw skompresują grupę plików w obrębie model.pt do tarballa i skopiuj wagi modelu z naszej lokalnej maszyny do zasobnika S3.

Note: Aby uruchomić następujące polecenia, musisz mieć Interfejs wiersza poleceń AWS (AWS CLI) zainstalowany.

Następnie kopiujemy nasz obraz wejściowy do S3. Poniżej znajduje się pełna ścieżka S3 dla obrazu.

Możemy skopiować ten obraz do S3 za pomocą innego polecenia aws s3 cp.

Krok 4: Budowanie skryptów wnioskowania o modelu ML

Teraz przejrzymy nasz plik punktu wejścia, inference.py moduł. Możemy wdrożyć model PyTorch przeszkolony poza SageMaker przy użyciu klasy PyTorchModel. Najpierw tworzymy instancję obiektu PyTorchModelZoo. Następnie skonstruujemy plik punktu wejścia inference.py, aby wykonać wnioskowanie ML przy użyciu transformacji wsadowej SageMaker na przykładowych danych hostowanych w Amazon S3.

Zrozumienie obiektu PyTorchModel

Połączenia Model PyTorch class w SageMaker Python API pozwala nam na wnioskowanie ML przy użyciu naszego pobranego artefaktu modelu.

Aby zainicjować klasę PyTorchModel, musimy zrozumieć następujące parametry wejściowe:

name: Nazwa modelu; zalecamy użycie nazwy modelu + daty i godziny lub losowego ciągu znaków + daty i godziny w celu uzyskania wyjątkowości.model_data: Identyfikator URI S3 spakowanego artefaktu modelu ML.entry_point: Zdefiniowany przez użytkownika plik języka Python, który ma być używany przez wnioskowany obraz platformy Docker do definiowania programów obsługi dla żądań przychodzących. Kod definiuje ładowanie modelu, wstępne przetwarzanie danych wejściowych, logikę przewidywania i końcowe przetwarzanie danych wyjściowych.framework_version: Musi być ustawiona wersja 1.2 lub nowsza, aby włączyć automatyczne przepakowywanie modelu PyTorch.source_dir: katalog pliku entry_point.role: rola IAM do wysyłania żądań usług AWS.image_uri: Użyj tego obrazu kontenera Amazon ECR Docker jako bazy dla środowiska obliczeniowego modelu ML.sagemaker_session: Sesja SageMakera.py_version: Wersja języka Python, która ma być używana

Poniższy fragment kodu tworzy instancję klasy PyTorchModel w celu przeprowadzenia wnioskowania przy użyciu wstępnie wytrenowanego modelu PyTorch:

Zrozumienie pliku punktu wejścia (inference.py)

Parametr entry_point wskazuje plik Pythona o nazwie inference.py. Ten punkt wejścia definiuje ładowanie modelu, wstępne przetwarzanie danych wejściowych, logikę przewidywania i końcowe przetwarzanie danych wyjściowych. Uzupełnia kod obsługujący model ML we wstępnie zbudowanym PyTorch Kontener głębokiego uczenia SageMaker obraz.

Inference.py będzie zawierał następujące funkcje. W naszym przykładzie implementujemy model_fn, input_fn, predict_fn i output_fn funkcje, aby zastąpić domyślna procedura obsługi wnioskowania PyTorch.

model_fn: pobiera katalog zawierający punkty kontrolne modelu statycznego w obrazie wnioskowania. Otwiera i ładuje model z określonej ścieżki i zwraca model PyTorch.input_fn: Pobiera ładunek przychodzącego żądania (request_body) i typ zawartości przychodzącego żądania (request_content_type) jako dane wejściowe. Obsługuje dekodowanie danych. Ta funkcja musi być dostosowana do danych wejściowych oczekiwanych przez model.predict_fn: Wywołuje model danych deserializowanych w input_fn. Wykonuje przewidywanie na deserializowanym obiekcie z załadowanym modelem ML.output_fn: serializuje wynik przewidywania do żądanego typu zawartości odpowiedzi. Konwertuje prognozy uzyskane z funkcji przewidywania_fn na formaty JSON, CSV lub NPY.

Krok 5: Uruchomienie zadania transformacji wsadowej SageMaker

W tym przykładzie uzyskamy wyniki wnioskowania ML za pomocą zadania transformacji wsadowej SageMaker. Zadania przekształcania wsadowego są najbardziej przydatne, gdy chcemy jednorazowo uzyskać wnioski z zestawów danych, bez konieczności stosowania trwałego punktu końcowego. Tworzymy instancję a sagemaker.transformator.transformator obiekt do tworzenia i interakcji z zadaniami transformacji wsadowej SageMaker.

Zapoznaj się z dokumentacją dotyczącą tworzenia zadania transformacji wsadowej pod adresem UtwórzZadaniePrzekształć.

Krok 6: Wizualizacja wyników

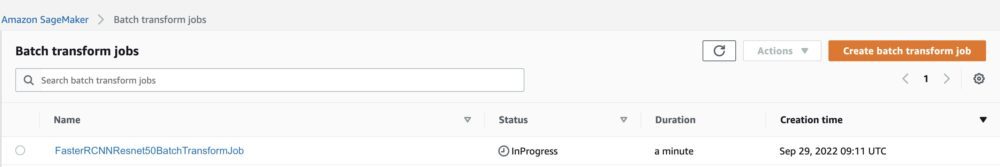

Po zakończeniu zadania transformacji wsadowej SageMaker możemy załadować dane wyjściowe wnioskowania ML z Amazon S3. W tym celu przejdź do Konsola zarządzania AWS i wyszukaj Amazon SageMaker. Na lewym panelu pod Wnioskowanie, Patrz Zadania przekształcania wsadowego.

Po wybraniu Transformacja wsadowa, zobacz stronę internetową z listą wszystkich zadań transformacji wsadowej SageMaker. Możemy zobaczyć postęp naszej ostatniej realizacji zadania.

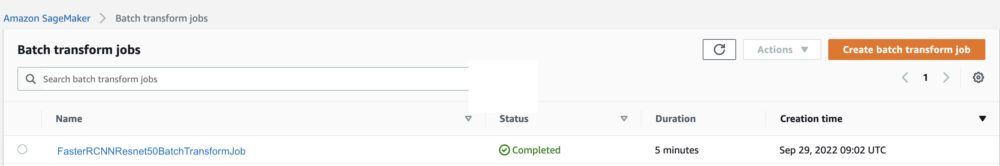

Po pierwsze, zadanie będzie miało status „W toku”. Po zakończeniu zobacz zmianę stanu na Ukończono.

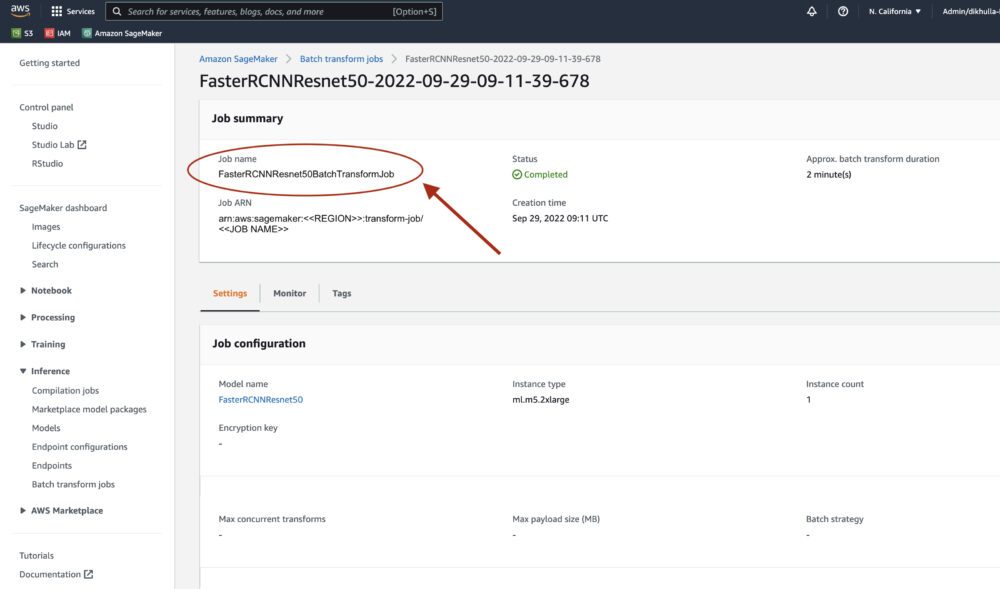

Gdy status zostanie oznaczony jako ukończony, możemy kliknąć zadanie, aby wyświetlić wyniki. Ta strona internetowa zawiera podsumowanie zadania, w tym konfiguracje zadania, które właśnie wykonaliśmy.

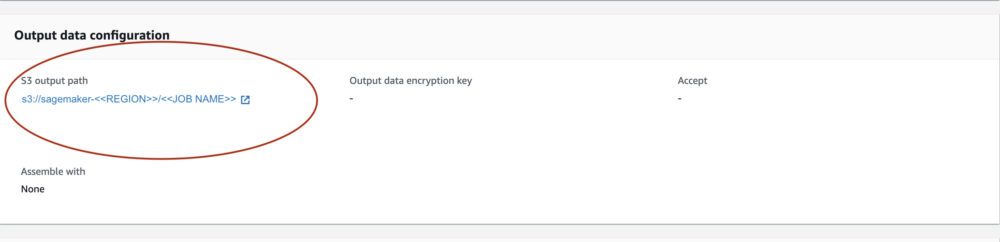

Pod Konfiguracja danych wyjściowych, zobaczymy ścieżkę wyjściową S3. Tutaj znajdziemy dane wyjściowe wnioskowania ML.

Wybierz ścieżkę wyjściową S3 i zobacz plik [image_name].[file_type].out z naszymi danymi wyjściowymi. Nasz plik wyjściowy będzie zawierał listę mapowań. Przykładowe wyjście:

Następnie przetwarzamy ten plik wyjściowy i wizualizujemy nasze prognozy. Poniżej określamy nasz próg ufności. Otrzymujemy listę klas z Mapowanie obiektów zestawu danych COCO. Podczas wnioskowania model wymaga tylko tensorów wejściowych i zwraca predykcje po przetworzeniu jako List[Dict[Tensor]], po jednym dla każdego obrazu wejściowego. Pola Dict są następujące, gdzie N to liczba wykryć:

- pudełka (FloatTensor[N, 4]): przewidywane pudełka w

[x1, y1, x2, y2]format, z0 <= x1 < x2 <= W and 0 <= y1 < y2 <= H, GdzieWjest szerokością obrazu iHto wysokość obrazu - etykiety (

Int64Tensor[N]): przewidywane etykiety dla każdego wykrycia - wyniki (

Tensor[N]): wyniki przewidywania dla każdego wykrycia

Aby uzyskać więcej informacji na temat wyjścia, patrz PyTorch Szybsza dokumentacja R-CNN FPN.

Dane wyjściowe modelu zawierają obwiednie z odpowiednimi wynikami ufności. Możemy zoptymalizować wyświetlanie fałszywych alarmów, usuwając obwiednie, dla których model nie jest pewny. Poniższe fragmenty kodu przetwarzają prognozy w pliku wyjściowym i rysują obwiednie na prognozach, w których wynik przekracza nasz próg ufności. Ustalamy próg prawdopodobieństwa, CONF_THRESH, do 75 w tym przykładzie.

Na koniec wizualizujemy te mapowania, aby zrozumieć nasze dane wyjściowe.

Note: jeśli obraz nie wyświetla się w twoim notatniku, znajdź go w drzewie katalogów po lewej stronie JupyterLab i otwórz go stamtąd.

Uruchamianie przykładowego kodu

Aby uzyskać pełny działający przykład, sklonuj kod w pliku amazon-sagemaker-przykłady GitHub i uruchomić komórki w create_pytorch_model_sagemaker.ipynb notatnik.

Wnioski

W tym poście na blogu zaprezentowaliśmy kompleksowy przykład przeprowadzania wnioskowania ML przy użyciu modelu wykrywania obiektów z PyTorch Model Zoo przy użyciu transformacji wsadowej SageMaker. Omówiliśmy ładowanie wag modelu wykrywania obiektów Faster R-CNN, zapisywanie ich w zasobniku S3, pisanie pliku punktu wejścia i zrozumienie kluczowych parametrów w interfejsie API PyTorchModel. Na koniec wdrożyliśmy model i przeprowadziliśmy wnioskowanie o modelu ML, zwizualizowaliśmy dane wyjściowe modelu i nauczyliśmy się interpretować wyniki.

O autorach

Dipika Khullar jest inżynierem ML w Laboratorium rozwiązań Amazon ML. Pomaga klientom integrować rozwiązania ML w celu rozwiązywania ich problemów biznesowych. Ostatnio budowała potoki szkoleniowe i wnioskowania dla klientów mediów oraz modele predykcyjne dla marketingu.

Dipika Khullar jest inżynierem ML w Laboratorium rozwiązań Amazon ML. Pomaga klientom integrować rozwiązania ML w celu rozwiązywania ich problemów biznesowych. Ostatnio budowała potoki szkoleniowe i wnioskowania dla klientów mediów oraz modele predykcyjne dla marketingu.

Marcelo Aberle jest inżynierem ML w organizacji AWS AI. Kieruje działaniami MLOps w Laboratorium rozwiązań Amazon ML, pomagając klientom projektować i wdrażać skalowalne systemy uczenia maszynowego. Jego misją jest prowadzenie klientów w ich podróży ML w przedsiębiorstwie i przyspieszenie ich ścieżki ML do produkcji.

Marcelo Aberle jest inżynierem ML w organizacji AWS AI. Kieruje działaniami MLOps w Laboratorium rozwiązań Amazon ML, pomagając klientom projektować i wdrażać skalowalne systemy uczenia maszynowego. Jego misją jest prowadzenie klientów w ich podróży ML w przedsiębiorstwie i przyspieszenie ich ścieżki ML do produkcji.

Ninada Kulkarniego jest naukowcem stosowanym w Laboratorium rozwiązań Amazon ML. Pomaga klientom wdrażać ML i AI, tworząc rozwiązania rozwiązujące ich problemy biznesowe. Ostatnio budował modele predykcyjne dla klientów sportowych, motoryzacyjnych i medialnych.

Ninada Kulkarniego jest naukowcem stosowanym w Laboratorium rozwiązań Amazon ML. Pomaga klientom wdrażać ML i AI, tworząc rozwiązania rozwiązujące ich problemy biznesowe. Ostatnio budował modele predykcyjne dla klientów sportowych, motoryzacyjnych i medialnych.

Yash Shah jest kierownikiem naukowym w Laboratorium rozwiązań Amazon ML. On i jego zespół naukowców stosowanych i inżynierów ML pracują nad szeregiem przypadków użycia ML w opiece zdrowotnej, sporcie, motoryzacji i produkcji.

Yash Shah jest kierownikiem naukowym w Laboratorium rozwiązań Amazon ML. On i jego zespół naukowców stosowanych i inżynierów ML pracują nad szeregiem przypadków użycia ML w opiece zdrowotnej, sporcie, motoryzacji i produkcji.

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- Uczenie maszynowe Amazon

- Laboratorium rozwiązań Amazon ML

- Amazon Sage Maker

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- Uczenie maszynowe AWS

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Instrukcje techniczne

- zefirnet