W skrócie Według amerykańskiego think tanku Brookings nowe zasady opracowane przez Unię Europejską, mające na celu uregulowanie sztucznej inteligencji, mogą uniemożliwić programistom wypuszczanie modeli open source.

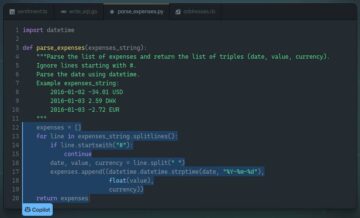

Połączenia zaproponowane Ustawa UE o sztucznej inteligencji, która ma zostać jeszcze podpisana, stanowi, że twórcy oprogramowania typu open source muszą zapewnić, że ich oprogramowanie AI jest dokładne, bezpieczne i przejrzyste w zakresie ryzyka i wykorzystania danych w przejrzystej dokumentacji technicznej.

Brookings twierdzi że gdyby prywatna firma wdrożyła model publiczny lub wykorzystała go w produkcie i w jakiś sposób wpadłaby w kłopoty z powodu nieprzewidzianych lub niekontrolowanych skutków modelu, prawdopodobnie próbowałaby obwiniać programistów open source i pozwać ich .

Może to zmusić społeczność open source do dwukrotnego zastanowienia się nad wydaniem kodu i niestety oznaczałoby, że rozwój sztucznej inteligencji będzie napędzany przez prywatne firmy. Kod prawnie zastrzeżony jest trudny do analizy i budowania na jego podstawie, co oznacza, że innowacyjność będzie utrudniona.

Oren Etzioni, ustępujący dyrektor generalny Allen Institute of AI, uważa, że programiści open source nie powinni podlegać takim samym surowym zasadom, jak inżynierowie oprogramowania w prywatnych firmach.

„Twórcy oprogramowania open source nie powinni podlegać takim samym obciążeniom, jak twórcy oprogramowania komercyjnego. Zawsze powinno być tak, że wolne oprogramowanie może być dostarczane „tak jak jest” — rozważmy przypadek pojedynczego ucznia rozwijającego możliwości sztucznej inteligencji; nie mogą sobie pozwolić na przestrzeganie przepisów UE i mogą być zmuszeni do nierozpowszechniania swojego oprogramowania, co ma mrożący wpływ na postęp w nauce i odtwarzalność wyników naukowych” powiedział TechCrunch.

Nowe wyniki MLPerf dla wnioskowania są niedostępne

Wyniki corocznego testu wnioskowania MLPerf, który porównuje wydajność układów AI od różnych dostawców w wielu zadaniach w różnych konfiguracjach, zostały opublikowany w tym tygodniu.

W tym roku zgłoszono prawie 5,300 wyników wydajności i 2,400 pomiarów mocy w celu wnioskowania w centrum danych i urządzeniach brzegowych. Testy sprawdzają, jak szybko system sprzętowy jest w stanie uruchomić określony model uczenia maszynowego. Szybkość przetwarzania danych jest raportowana w arkuszach kalkulacyjnych.

Nic dziwnego, że w tym roku Nvidia ponownie zajmuje pierwsze miejsce w rankingach. „W debiucie w branżowych testach AI MLPerf, procesory graficzne Nvidia H100 Tensor Core ustanowiły światowe rekordy we wnioskowaniu na temat wszystkich obciążeń, zapewniając do 4.5 razy większą wydajność niż procesory graficzne poprzedniej generacji” – napisała Nvidia w poście na blogu. „Wyniki pokazują, że Hopper to najlepszy wybór dla użytkowników, którzy wymagają najwyższej wydajności w zaawansowanych modelach AI”.

Chociaż coraz więcej dostawców bierze udział w wyzwaniu MLPerf, dobre wyobrażenie o konkurencji może być trudne. Na przykład w tym roku nie ma zgłoszonych wyników dotyczących chipów TPU firmy Google w torze centrum danych. Wydawało się jednak, że Google as Zawody treningowe MLPerf na początku tego roku.

Artyści AI odkrywają przerażającą twarz kryjącą się za obrazem

Wirusowy wątek na Twitterze opublikowany przez artystę cyfrowego pokazuje, jak dziwne modele tekstu na obraz mogą znajdować się pod powierzchnią.

Wielu internautów z radością i rozpaczą eksperymentowało z tymi systemami w celu generowania obrazów poprzez wpisywanie podpowiedzi tekstowych. Istnieją różne hacki, aby dostosować dane wyjściowe modeli; jeden z nich, zwany „monitem negatywnym”, pozwala użytkownikom znaleźć obraz przeciwny do opisanego w monicie.

Kiedy artysta, który na Twitterze występuje pod pseudonimem Supercomposite, znalazł negatywną zachętę do tego, co opisywało niewinnie wyglądające zdjęcie fałszywego logo, znalazł coś naprawdę przerażającego: twarz czegoś, co wygląda jak nawiedzonej kobiety. Supercomposite nazwał tę wygenerowaną przez sztuczną inteligencję kobietę „Loab”, a kiedy skrzyżowali jej obrazy z innymi, zawsze wyglądali jak scena z horroru.

🧵: I discovered this woman, who I call Loab, in April. The AI reproduced her more easily than most celebrities. Her presence is persistent, and she haunts every image she touches. CW: Take a seat. This is a true horror story, and veers sharply macabre. pic.twitter.com/gmUlf6mZtk

— Supercomposite (@supercomposite) September 6, 2022

Superkompozyt powiedział Regu losowe obrazy osób wygenerowanych przez sztuczną inteligencję mogą często pojawiać się w negatywnych podpowiedziach. Dziwne zachowanie jest jeszcze inny przykład niektórych dziwnych właściwości, które te modele mogą mieć, a które ludzie dopiero zaczynają badać.

W Google nie ma czujących chatbotów, mówi dyrektor generalny Sundar Pichai

Sundar Pichai zaprzeczył twierdzeniom byłego inżyniera Blake'a Lemoine'a, że Google zbudował czującego chatbota podczas jego przemówienia na konferencji Code w tym tygodniu.

Lemoine trafił na pierwsze strony gazet w lipcu, kiedy… ogłosił myślał, że chatbot LaMDA firmy Google jest świadomy i może mieć duszę. Był później zwolniony za rzekome naruszenie polityki prywatności firmy po tym, jak wynajął prawnika, aby porozmawiać z LaMDA i ocenić jego prawa, twierdząc, że maszyna mu to kazała.

Większość ludzi – w tym CEO Google – nie zgadza się z Lemoine. „Wciąż uważam, że przed nami długa droga. Czuję, że często wdaję się w filozoficzne lub metafizyczne rozmowy o tym, czym jest świadomość, a czym świadomość” – powiedział Pichai: według do Fortuny. „Daleko nam do tego i możemy nigdy tam nie dotrzeć” – dodał.

Aby jeszcze bardziej podkreślić swoją rację, przyznał, że asystent głosowy AI Google czasami nie rozumie i nie reaguje odpowiednio na prośby. „Dobrą wiadomością jest to, że każdy, kto rozmawia z Asystentem Google – chociaż uważam, że jest to najlepszy asystent do konwersacyjnej sztucznej inteligencji – nadal widzisz, jak bardzo jest zepsuty w niektórych przypadkach” – powiedział. ®

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Rejestr

- zefirnet