Dzisiaj z radością ogłaszamy możliwość dostrojenia modeli Llama 2 za pomocą Meta Amazon SageMaker JumpStart. Rodzina dużych modeli językowych (LLM) Llama 2 to zbiór wstępnie wytrenowanych i precyzyjnie dostrojonych generatywnych modeli tekstowych o skali od 7 miliardów do 70 miliardów parametrów. Dopracowane LLM, zwane Llama-2-chat, są zoptymalizowane pod kątem zastosowań dialogowych. Możesz łatwo wypróbować te modele i używać ich w SageMaker JumpStart, będącym centrum uczenia maszynowego (ML), które zapewnia dostęp do algorytmów, modeli i rozwiązań ML, dzięki czemu możesz szybko rozpocząć korzystanie z ML. Teraz możesz także dostroić 7 miliardów, 13 miliardów i 70 miliardów parametrów Modele generowania tekstu Llama 2 w SageMaker JumpStart za pomocą Studio Amazon SageMaker Interfejs użytkownika za pomocą kilku kliknięć lub przy użyciu pakietu SageMaker Python SDK.

Podstawowe modele generatywnej sztucznej inteligencji są przedmiotem większości badań i przypadków użycia w zakresie uczenia maszynowego i sztucznej inteligencji od ponad roku. Te podstawowe modele bardzo dobrze radzą sobie z zadaniami generatywnymi, takimi jak generowanie tekstu, podsumowywanie, odpowiadanie na pytania, generowanie obrazów i wideo i nie tylko, ze względu na ich duży rozmiar, a także dlatego, że są szkolone na kilku dużych zbiorach danych i setkach zadań. Pomimo dużych możliwości uogólniania tych modeli, często istnieją przypadki użycia, które mają bardzo specyficzne dane dziedzinowe (takie jak opieka zdrowotna lub usługi finansowe), z powodu których modele te mogą nie być w stanie zapewnić dobrych wyników dla tych przypadków użycia. Powoduje to potrzebę dalszego dostrajania tych generatywnych modeli sztucznej inteligencji w oparciu o dane specyficzne dla przypadku użycia i domeny.

W tym poście opisujemy, jak dostroić wstępnie wytrenowane modele generowania tekstu Llama 2 za pomocą SageMaker JumpStart.

Co to jest Lama 2

Lama 2 to model języka autoregresyjnego, który wykorzystuje zoptymalizowaną architekturę transformatora. Lama 2 jest przeznaczona do użytku komercyjnego i badawczego w języku angielskim. Jest dostępny w różnych rozmiarach parametrów — 7 miliardów, 13 miliardów i 70 miliardów — a także w wstępnie wytrenowanych i precyzyjnie dostrojonych odmianach. Według Meta dostrojone wersje wykorzystują nadzorowane dostrajanie (SFT) i uczenie się przez wzmacnianie na podstawie informacji zwrotnej od człowieka (RLHF), aby dostosować się do ludzkich preferencji pod względem przydatności i bezpieczeństwa. Llama 2 została wstępnie przeszkolona na 2 bilionach tokenów danych z publicznie dostępnych źródeł. Dostrojone modele są przeznaczone do czatu przypominającego asystenta, natomiast wstępnie wyszkolone modele można dostosować do różnych zadań związanych z generowaniem języka naturalnego. Niezależnie od tego, z której wersji modelu korzysta programista, plik przewodnik odpowiedzialnego użytkowania firmy Meta może pomóc w dodatkowym dostrojeniu, które może być konieczne w celu dostosowania i optymalizacji modeli przy zastosowaniu odpowiednich środków ograniczających bezpieczeństwo.

Obecnie Llama 2 jest dostępna w następujących regionach:

- Wdróż dostępny wstępnie wyszkolony model:

"us-west-2","us-east-1","us-east-2","eu-west-1","ap-southeast-1","ap-southeast-2" - Dopracuj i wdróż dopracowany model:

“us-east-1”,“us-west-2”,“eu-west-1”

Co to jest SageMaker JumpStart

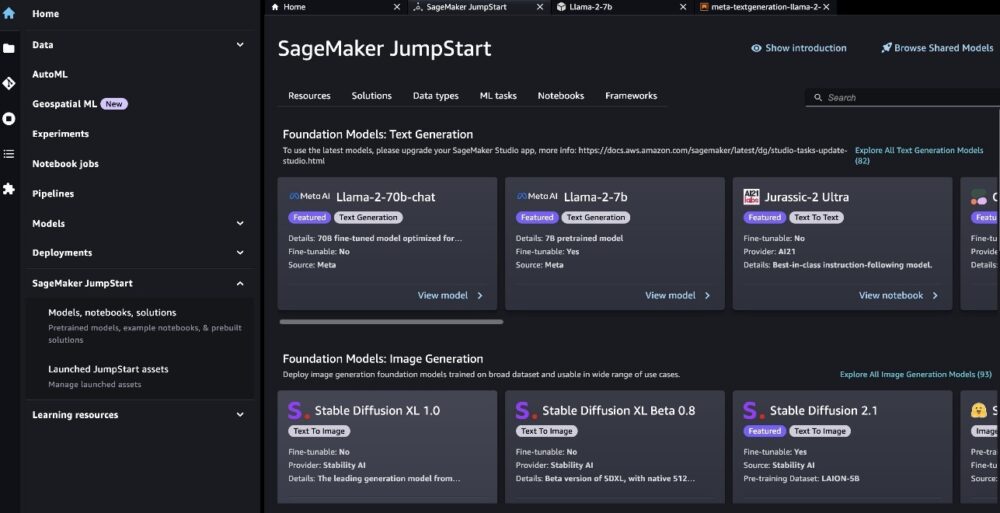

Dzięki SageMaker JumpStart praktycy ML mogą wybierać spośród szerokiej gamy publicznie dostępnych modeli podstawowych. Praktycy ML mogą wdrażać modele podstawowe w dedykowanych Amazon Sage Maker instancje z izolowanego środowiska sieciowego i dostosowuj modele za pomocą SageMaker do szkolenia modeli i wdrażania. Możesz teraz odkryć i wdrożyć Llamę 2 za pomocą kilku kliknięć w SageMaker Studio lub programowo za pomocą pakietu SageMaker Python SDK, umożliwiając uzyskanie wydajności modelu i kontroli MLOps za pomocą funkcji SageMaker, takich jak Rurociągi Amazon SageMaker, Debuger Amazon SageMakerlub dzienniki kontenerów. Model jest wdrażany w bezpiecznym środowisku AWS i pod kontrolą VPC, co pomaga zapewnić bezpieczeństwo danych. Ponadto możesz dostroić wstępnie wytrenowane modele generowania tekstu Llama2 7B, 13B i 70B za pomocą SageMaker JumpStart.

Dostosuj modele Lamy2

Możesz dostroić modele za pomocą interfejsu użytkownika SageMaker Studio lub zestawu SDK SageMaker Python. Obie metody omówimy w tej sekcji.

Dostrajanie bez użycia kodu za pomocą interfejsu użytkownika SageMaker Studio

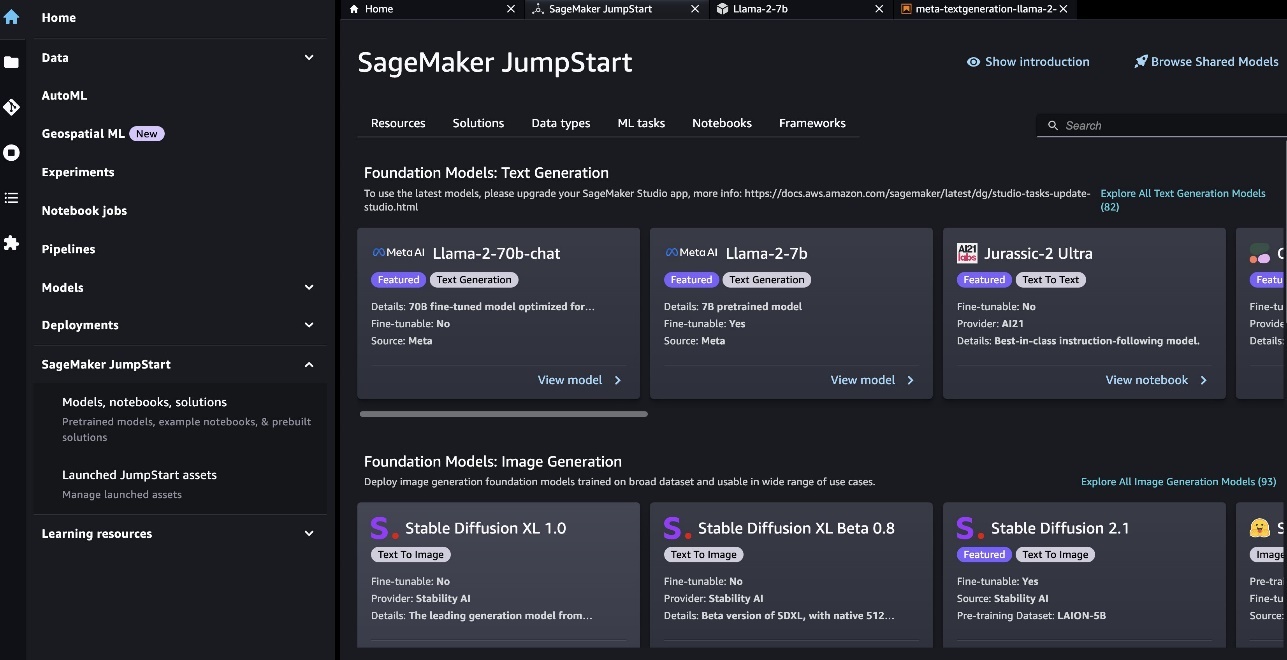

W SageMaker Studio dostęp do modeli Lamy 2 można uzyskać poprzez SageMaker JumpStart w sekcji Modele, notesy i rozwiązania, jak pokazano na poniższym zrzucie ekranu.

Jeśli nie widzisz modeli Lamy 2, zaktualizuj wersję SageMaker Studio, wyłączając i uruchamiając ponownie. Aby uzyskać więcej informacji na temat aktualizacji wersji, zobacz Zamknij i zaktualizuj aplikacje Studio.

Wybierając, możesz znaleźć także pozostałe cztery warianty modelu Poznaj wszystkie modele generowania tekstu lub wyszukaj lamę w polu wyszukiwania.

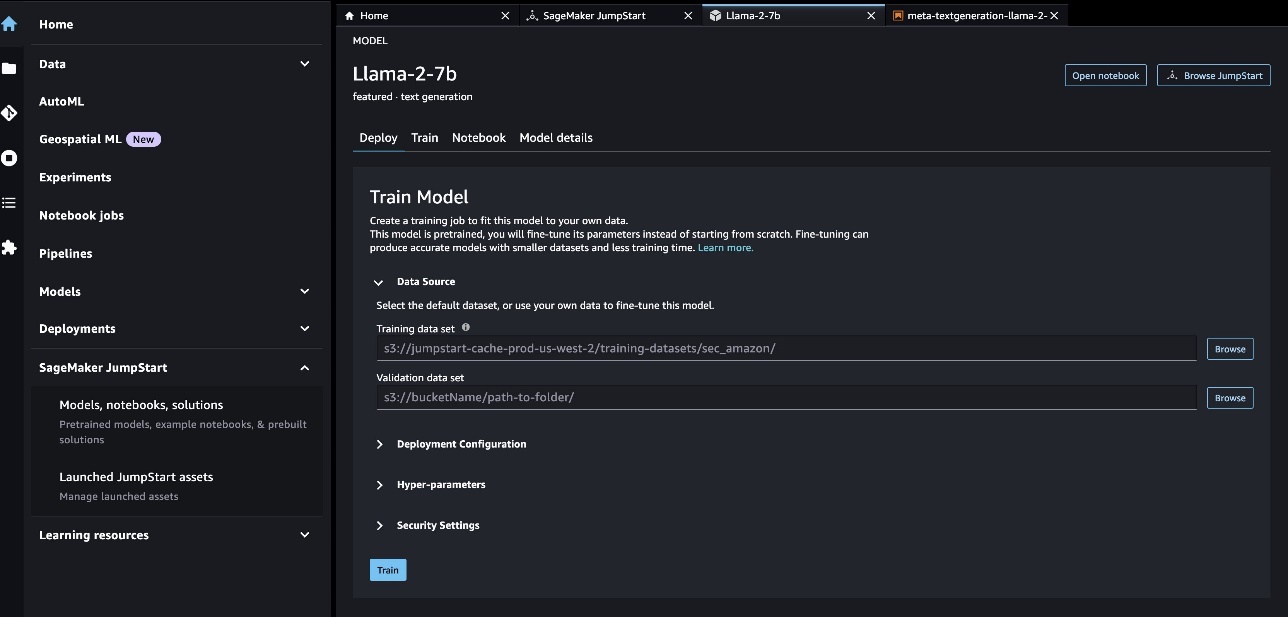

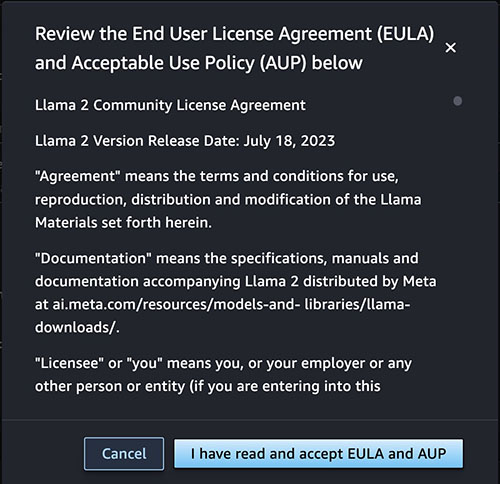

Na tej stronie możesz wskazać Usługa Amazon Simple Storage Wiadro (Amazon S3) zawierające zbiory danych szkoleniowych i walidacyjnych do dostrajania. Ponadto można skonfigurować konfigurację wdrożenia, hiperparametry i ustawienia zabezpieczeń w celu dostrajania. Następnie możesz wybrać Pociąg aby rozpocząć zadanie szkoleniowe w instancji SageMaker ML. Powyższy zrzut ekranu przedstawia stronę dostrajania modelu Llama-2 7B; można jednak dostroić modele generowania tekstu 13B i 70B Llama 2, korzystając w podobny sposób z odpowiednich stron modeli. Aby korzystać z modeli Llama 2, musisz zaakceptować Umowę licencyjną użytkownika końcowego (EULA). Pojawi się, kiedy dokonasz wyboru Pociąg, jak pokazano na poniższym zrzucie ekranu. Wybierać Przeczytałem i akceptuję umowę EULA i AUP aby rozpocząć prace dostrajające.

Wdróż model

Po dopracowaniu modelu możesz go wdrożyć, korzystając ze strony modelu w SageMaker JumpStart. Opcja wdrożenia dopracowanego modelu pojawi się po zakończeniu dostrajania, jak pokazano na poniższym zrzucie ekranu.

Dostosuj za pomocą pakietu SageMaker Python SDK

Możesz także dostroić modele Llama 2 za pomocą pakietu SageMaker Python SDK. Poniżej znajduje się przykładowy kod umożliwiający dostrojenie Llama 2 7B w zestawie danych:

Możesz wdrożyć dopracowany model bezpośrednio z estymatora:

Kod znajdziesz także w Dostosuj modele LLaMA 2 w SageMaker JumpStart. Obejmuje przygotowanie zestawu danych, szkolenie na niestandardowym zestawie danych i wdrożenie precyzyjnie dostrojonego modelu. Pokazuje dostrajanie podzbioru zbioru danych Dolly na przykładach z zadania podsumowującego. Poniżej przedstawiono przykładowe dane wejściowe z odpowiedziami precyzyjnie dostrojonymi i niedostrojonymi wraz z odpowiedzią dotyczącą prawdy podstawowej:

Dane wejściowe do modelu:

Odpowiedź na prawdę:

Odpowiedź z niedostrojonego modelu:

Odpowiedź z dostrojonego modelu:

Aby zapoznać się z testami porównawczymi wydajności różnych modeli w zestawie danych Dolly i Dialogsum, zobacz Benchmarking wydajności sekcja w załączniku na końcu tego postu.

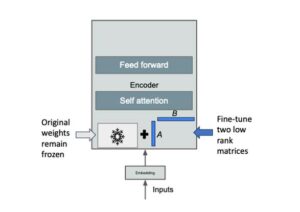

Technika dostrajania

Modele językowe, takie jak Llama, mają rozmiar większy niż 10 GB, a nawet 100 GB. Dostrajanie tak dużych modeli wymaga instancji ze znacznie dużą pamięcią CUDA. Ponadto uczenie tych modeli może być bardzo powolne ze względu na rozmiar modelu. Dlatego w celu wydajnego dostrajania stosujemy następujące optymalizacje:

- Adaptacja niskiej rangi (LoRA) – Jest to rodzaj efektywnego dostrajania parametrów (PEFT) służącego do wydajnego dostrajania dużych modeli. W tym przypadku zamrażamy cały model i dodajemy do modelu jedynie niewielki zestaw regulowanych parametrów lub warstw. Na przykład zamiast trenować wszystkie 7 miliardów parametrów Lamy 2 7B, możemy dostroić mniej niż 1% parametrów. Pomaga to w znacznym zmniejszeniu zapotrzebowania na pamięć, ponieważ musimy przechowywać gradienty, stany optymalizatora i inne informacje związane ze szkoleniem tylko dla 1% parametrów. Co więcej, pomaga to w skróceniu czasu i kosztów szkolenia. Więcej szczegółów na temat tej metody można znaleźć w artykule LoRA: Adaptacja niskiego poziomu dużych modeli językowych.

- Kwantyzacja Int8 – Nawet przy optymalizacjach takich jak LoRA modele takie jak Llama 70B są nadal zbyt duże, aby można je było trenować. Aby zmniejszyć zużycie pamięci podczas treningu, możemy podczas treningu zastosować kwantyzację Int8. Kwantyzacja zazwyczaj zmniejsza precyzję typów danych zmiennoprzecinkowych. Chociaż zmniejsza to pamięć wymaganą do przechowywania ciężarów modeli, pogarsza to wydajność z powodu utraty informacji. Kwantyzacja Int8 wykorzystuje tylko jedną czwartą precyzji, ale nie powoduje pogorszenia wydajności, ponieważ nie powoduje po prostu utraty bitów. Zaokrągla dane z jednego typu do drugiego. Aby dowiedzieć się więcej o kwantyzacji Int8, zobacz LLM.int8(): 8-bitowe mnożenie macierzy dla transformatorów w dużej skali.

- W pełni podzielone na dane równoległe (FSDP) – Jest to rodzaj algorytmu uczenia równoległego do danych, który dzieli parametry modelu na procesy równoległe danych i opcjonalnie może przenieść część obliczeń szkoleniowych do procesorów. Chociaż parametry są podzielone na różne procesory graficzne, obliczenia każdej mikropartii są lokalne dla procesu roboczego GPU. Umożliwia bardziej równomierne rozbicie parametrów i osiągnięcie zoptymalizowanej wydajności dzięki nakładaniu się komunikacji i obliczeń podczas szkolenia.

W poniższej tabeli porównano różne metody z trzema modelami Llama 2.

| , | Domyślny typ instancji | Obsługiwane typy instancji z konfiguracją domyślną | Ustawienia domyślne | LORA + FSDP | LORA + Brak FSDP | Kwantyzacja Int8 + LORA + Brak FSDP |

| Lama 2 7B | ml.g5.12xduży | ml.g5.12xlarge, ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Tak | Tak | Tak |

| Lama 2 13B | ml.g5.12xduży | ml.g5.24xlarge, ml.g5.48xlarge | LORA + FSDP | Tak | Tak | Tak |

| Lama 2 70B | ml.g5.48xduży | ml.g5.48xduży | INT8 + LORA + BEZ FSDP | Nie | Nie | Tak |

Należy pamiętać, że dostrajanie modeli Lamy opiera się na skryptach dostarczonych przez poniższe osoby GitHub repo.

Format zbioru danych szkoleniowych

SageMaker JumpStart obsługuje obecnie zbiory danych zarówno w formacie adaptacji domeny, jak i formacie dostrajania instrukcji. W tej sekcji podajemy przykładowy zbiór danych w obu formatach. Więcej szczegółów znajdziesz w Formatowanie zbioru danych sekcja w załączniku.

Format adaptacji domeny

Model generowania tekstu Lama 2 można dostroić na dowolnym zestawie danych specyficznym dla domeny. Po dopracowaniu zestawu danych specyficznego dla domeny oczekuje się, że model wygeneruje tekst specyficzny dla domeny i rozwiąże różne zadania NLP w tej konkretnej domenie za pomocą kilku podpowiedzi. W przypadku tego zestawu danych dane wejściowe składają się z pliku CSV, JSON lub TXT. Na przykład danymi wejściowymi mogą być zgłoszenia Amazona do SEC w postaci pliku tekstowego:

Format strojenia instrukcji

Podczas dostrajania instrukcji model jest dostrajany pod kątem zestawu zadań przetwarzania języka naturalnego (NLP) opisanych za pomocą instrukcji. Pomaga to poprawić wydajność modelu w przypadku niewidocznych zadań dzięki monitom o zerowym zasięgu. W formacie zestawu danych dostrajania instrukcji określasz template.json plik opisujący formaty wejściowe i wyjściowe. Na przykład każda linia w pliku train.jsonl wygląda następująco:

Dodatkowy plik template.json wygląda następująco:

Obsługiwane hiperparametry do szkolenia

Dostrajanie Lamy 2 obsługuje wiele hiperparametrów, z których każdy może mieć wpływ na zapotrzebowanie na pamięć, szybkość uczenia i wydajność dostrojonego modelu:

- epoka – Liczba przejść, jakie algorytm dostrajający wykonuje przez zbiór danych szkoleniowych. Musi być liczbą całkowitą większą niż 1. Wartość domyślna to 5.

- wskaźnik_nauczenia – Szybkość aktualizacji wag modeli po przepracowaniu każdej partii przykładów szkoleniowych. Musi to być dodatnia liczba zmiennoprzecinkowa większa niż 0. Wartość domyślna to 1e-4.

- instrukcja_dostrojona – Czy szkolić model, czy nie. Musi być '

True"lub"False'. Wartość domyślna to „False". - per_device_train_batch_size – Rozmiar partii na rdzeń GPU/procesor do celów szkoleniowych. Musi być dodatnią liczbą całkowitą. Wartość domyślna to 4.

- per_device_eval_batch_size – Rozmiar partii na rdzeń GPU/procesor do oceny. Musi być dodatnią liczbą całkowitą. Wartość domyślna to 1.

- max_train_samples – W celu debugowania lub szybszego szkolenia skróć liczbę przykładów szkoleniowych do tej wartości. Wartość -1 oznacza wykorzystanie wszystkich próbek szkoleniowych. Musi to być dodatnia liczba całkowita lub -1. Wartość domyślna to -1.

- max_val_samples – W celu debugowania lub szybszego szkolenia skróć liczbę przykładów walidacji do tej wartości. Wartość -1 oznacza wykorzystanie wszystkich próbek walidacyjnych. Musi to być dodatnia liczba całkowita lub -1. Wartość domyślna to -1.

- maksymalna_długość_wejściowa – Maksymalna całkowita długość sekwencji wejściowej po tokenizacji. Sekwencje dłuższe niż ta zostaną obcięte. Jeśli -1,

max_input_lengthjest ustawiona na minimum 1024 i maksymalną długość modelu zdefiniowaną przez tokenizer. Jeśli zostanie ustawiony na wartość dodatnią,max_input_lengthjest ustawiony na minimum podanej wartości imodel_max_lengthzdefiniowany przez tokenizer. Musi to być dodatnia liczba całkowita lub -1. Wartość domyślna to -1. - validation_split_ratio – Jeśli kanał walidacji to

none, stosunek podziału walidacji pociągu z danych pociągu musi mieścić się w przedziale 0–1. Wartość domyślna to 0.2. - train_data_split_seed – Jeśli nie ma danych walidacyjnych, naprawia to losowy podział wejściowych danych szkoleniowych na dane szkoleniowe i walidacyjne wykorzystywane przez algorytm. Musi być liczbą całkowitą. Wartość domyślna to 0.

- preprocessing_num_workers – Liczba procesów, które należy zastosować do przetwarzania wstępnego. Jeśli

None, główny proces służy do wstępnego przetwarzania. Domyślnie jestNone. - lora_r – Lora R. Musi być dodatnią liczbą całkowitą. Wartość domyślna to 8.

- lora_alfa – Lora Alfa. Musi być dodatnią liczbą całkowitą. Wartość domyślna to 32

- lora_dropout – Lora odpada. musi być dodatnią liczbą zmiennoprzecinkową z zakresu od 0 do 1. Wartość domyślna to 0.05.

- int8_kwantyzacja - Jeśli

True, model jest ładowany z 8-bitową precyzją na potrzeby szkolenia. Wartość domyślna dla 7B i 13B toFalse. Domyślnie dla 70B jestTrue. - włącz_fsdp - Jeśli

True, szkolenie wykorzystuje FSDP. Wartość domyślna dla 7B i 13B toTrue. Domyślnie dla 70B jestFalse, Należy pamiętać, żeint8_quantizationnie jest obsługiwany przez FSDP.

Typy instancji i zgodne hiperparametry

Zapotrzebowanie na pamięć podczas dostrajania może się różnić w zależności od kilku czynników:

- Typ modelu – Model 7B ma najmniejsze zapotrzebowanie na pamięć GPU, a model 70B ma największe zapotrzebowanie na pamięć

- Maksymalna długość wejściowa – Większa wartość długości wejściowej powoduje jednoczesne przetwarzanie większej liczby tokenów i jako taka wymaga większej ilości pamięci CUDA

- Wielkość partii – Większy rozmiar partii wymaga większej pamięci CUDA i dlatego wymaga większych typów instancji

- Kwantyzacja Int8 – W przypadku korzystania z kwantyzacji Int8 model jest ładowany z niską precyzją i dlatego wymaga mniej pamięci CUDA

Aby pomóc Ci rozpocząć, udostępniamy zestaw kombinacji różnych typów instancji, hiperparametrów i typów modeli, które można z powodzeniem dostroić. Możesz wybrać konfigurację zgodnie ze swoimi wymaganiami i dostępnością typów instancji. Dostrajamy wszystkie trzy modele w różnych ustawieniach z trzema epokami w podzbiorze zbioru danych Dolly z przykładami podsumowań.

Model 7B

Poniższa tabela podsumowuje opcje dostrajania modelu 7B.

| Typ wystąpienia | Maks. długość wejściowa | Na wielkość partii urządzenia | Kwantyzacja Int8 | Włącz FSDP | Czas potrzebny (min) |

| ml.g4dn.12xduże | 1024 | 8 | TRUE | FAŁSZYWY | 166 |

| ml.g4dn.12xduże | 2048 | 2 | TRUE | FAŁSZYWY | 178 |

| ml.g4dn.12xduże | 1024 | 4 | FAŁSZYWY | TRUE | 120 |

| ml.g4dn.12xduże | 2048 | 2 | FAŁSZYWY | TRUE | 143 |

| ml.g5.2xduży | 1024 | 4 | TRUE | FAŁSZYWY | 61 |

| ml.g5.2xduży | 2048 | 2 | TRUE | FAŁSZYWY | 68 |

| ml.g5.2xduży | 1024 | 4 | FAŁSZYWY | TRUE | 43 |

| ml.g5.2xduży | 2048 | 2 | FAŁSZYWY | TRUE | 49 |

| ml.g5.4xduży | 1024 | 4 | FAŁSZYWY | TRUE | 39 |

| ml.g5.4xduży | 2048 | 2 | FAŁSZYWY | TRUE | 50 |

| ml.g5.12xduży | 1024 | 16 | TRUE | FAŁSZYWY | 57 |

| ml.g5.12xduży | 2048 | 4 | TRUE | FAŁSZYWY | 64 |

| ml.g5.12xduży | 1024 | 4 | FAŁSZYWY | TRUE | 26 |

| ml.g5.12xduży | 2048 | 4 | FAŁSZYWY | TRUE | 23 |

| ml.g5.48xduży | 1024 | 16 | TRUE | FAŁSZYWY | 59 |

| ml.g5.48xduży | 2048 | 4 | TRUE | FAŁSZYWY | 67 |

| ml.g5.48xduży | 1024 | 8 | FAŁSZYWY | TRUE | 22 |

| ml.g5.48xduży | 2048 | 4 | FAŁSZYWY | TRUE | 21 |

13B

Poniższa tabela podsumowuje opcje dostrajania modelu 13B.

| Typ wystąpienia | Maks. długość wejściowa | Na wielkość partii urządzenia | Kwantyzacja Int8 | Włącz FSDP | Czas potrzebny (min) |

| ml.g4dn.12xduże | 1024 | 4 | TRUE | FAŁSZYWY | 283 |

| ml.g4dn.12xduże | 2048 | 2 | TRUE | FAŁSZYWY | 328 |

| ml.g5.12xduży | 1024 | 8 | TRUE | FAŁSZYWY | 92 |

| ml.g5.12xduży | 2048 | 4 | TRUE | FAŁSZYWY | 104 |

| ml.g5.48xduży | 1024 | 8 | TRUE | FAŁSZYWY | 95 |

| ml.g5.48xduży | 2048 | 4 | TRUE | FAŁSZYWY | 107 |

| ml.g5.48xduży | 1024 | 8 | FAŁSZYWY | TRUE | 35 |

| ml.g5.48xduży | 2048 | 2 | FAŁSZYWY | TRUE | 41 |

70B

Poniższa tabela podsumowuje opcje dostrajania modelu 70B.

| Typ wystąpienia | Maks. długość wejściowa | Na wielkość partii urządzenia | Kwantyzacja Int8 | Włącz FSDP | Czas potrzebny (min) |

| ml.g5.48xduży | 1024 | 4 | TRUE | FAŁSZYWY | 396 |

| ml.g5.48xduży | 2048 | 1 | TRUE | FAŁSZYWY | 454 |

Zalecenia dotyczące typów instancji i hiperparametrów

Dostosowując dokładność modelu, należy pamiętać o następujących kwestiach:

- Większe modele, takie jak 70B, zapewniają lepszą wydajność niż 7B

- Wydajność bez kwantyzacji Int8 jest lepsza niż wydajność z kwantyzacją INT8

Zwróć uwagę na następujący czas szkolenia i wymagania dotyczące pamięci CUDA:

- Oprawa

int8_quantization=Truezmniejsza zapotrzebowanie na pamięć i prowadzi do szybszego treningu. - Zmniejszenie

per_device_train_batch_sizeimax_input_lengthzmniejsza zapotrzebowanie na pamięć i dlatego można go uruchomić na mniejszych instancjach. Jednakże ustawienie bardzo niskich wartości może wydłużyć czas uczenia. - Jeśli nie używasz kwantyzacji Int8 (

int8_quantization=False), użyj FSDP (enable_fsdp=True) dla szybszego i efektywniejszego treningu.

Wybierając typ instancji, należy wziąć pod uwagę następujące kwestie:

- Instancje G5 zapewniają najbardziej efektywne szkolenie spośród obsługiwanych typów instancji. Dlatego jeśli masz dostępne instancje G5, powinieneś z nich skorzystać.

- Czas treningu w dużej mierze zależy od ilości procesorów graficznych i dostępnej pamięci CUDA. Dlatego szkolenie na instancjach z tą samą liczbą procesorów graficznych (na przykład ml.g5.2xlarge i ml.g5.4xlarge) jest mniej więcej takie samo. Dlatego do treningu możesz wykorzystać tańszą instancję (ml.g5.2xlarge).

- Podczas korzystania z instancji p3 uczenie będzie wykonywane z 32-bitową precyzją, ponieważ bfloat16 nie jest obsługiwany w tych instancjach. Dlatego zadanie szkoleniowe zużyje dwukrotnie więcej pamięci CUDA podczas szkolenia na instancjach p3 w porównaniu z instancjami g5.

Aby poznać koszt szkolenia w przeliczeniu na instancję, zob Instancje Amazon EC2 G5.

Jeśli zbiór danych jest w formacie dostrajania instrukcji, a sekwencje wprowadzania i uzupełniania są małe (np. 50–100 słów), wówczas wysoka wartość max_input_length prowadzi do bardzo słabych wyników. Domyślna wartość tego parametru to -1, co odpowiada max_input_length z 2048 r. dla modeli Lamy. Dlatego jeśli zbiór danych zawiera małe próbki, zalecamy użycie małej wartości max_input_length (np. 200–400).

Wreszcie, ze względu na duże zapotrzebowanie na instancje G5, może wystąpić niedostępność tych instancji w Twoim regionie z błędem “CapacityError: Unable to provision requested ML compute capacity. Please retry using a different ML instance type.” Jeśli wystąpi ten błąd, ponów zadanie szkoleniowe lub wypróbuj inny region.

Problemy przy dostrajaniu bardzo dużych modeli

W tej sekcji omówimy dwie kwestie związane z dostrajaniem bardzo dużych modeli.

Wyłącz kompresję wyjściową

Domyślnie wynikiem zadania szkoleniowego jest wyszkolony model, który jest kompresowany w formacie .tar.gz przed przesłaniem do Amazon S3. Jednak ze względu na duży rozmiar modelu ten krok może zająć dużo czasu. Na przykład kompresowanie i przesyłanie modelu 70B może zająć ponad 4 godziny. Aby uniknąć tego problemu, możesz użyć funkcji wyłączania kompresji wyjściowej obsługiwanej przez platformę szkoleniową SageMaker. W tym przypadku model jest przesyłany bez jakiejkolwiek kompresji, który jest następnie wykorzystywany do wdrożenia:

Problem z przekroczeniem limitu czasu jądra SageMaker Studio

Ze względu na rozmiar modelu Llama 70B zadanie szkoleniowe może zająć kilka godzin, a jądro SageMaker Studio może przestać działać w fazie uczenia. Jednak w tym czasie szkolenie w SageMaker nadal trwa. Jeśli tak się stanie, nadal możesz wdrożyć punkt końcowy, używając nazwy zadania szkoleniowego i następującego kodu:

Aby znaleźć nazwę zadania szkoleniowego, przejdź do konsoli SageMaker i poniżej Trening w okienku nawigacji wybierz Praca szkoleniowa. Zidentyfikuj nazwę zadania szkoleniowego i zastąp ją w powyższym kodzie.

Wnioski

W tym poście omówiliśmy dostrajanie modeli Meta Llama 2 za pomocą SageMaker JumpStart. Pokazaliśmy, że można używać konsoli SageMaker JumpStart w SageMaker Studio lub pakietu SageMaker Python SDK do dostrajania i wdrażania tych modeli. Omówiliśmy także technikę dostrajania, typy instancji i obsługiwane hiperparametry. Dodatkowo przedstawiliśmy rekomendacje dotyczące zoptymalizowanego szkolenia na podstawie różnych przeprowadzonych przez nas testów. Wyniki dostrojenia trzech modeli na dwóch zbiorach danych pokazano w dodatku na końcu tego posta. Jak widać z tych wyników, dostrajanie poprawia podsumowanie w porównaniu z modelami niedostrojonymi. W następnym kroku możesz spróbować dostroić te modele na własnym zestawie danych, korzystając z kodu dostarczonego w repozytorium GitHub, aby przetestować i porównać wyniki dla swoich przypadków użycia.

Autorzy pragną podziękować za wkład techniczny Christophera Whittena, Xin Huanga, Kyle’a Ulricha, Sifei Li, Amy You, Adama Kozdrowicza, Evana Kravitza, Benjamina Crabtree, Haotiana An, Manana Shaha, Tony’ego Cruza, Erneva Sharmy, Jonathana Guinegagne’a i June Wygrał.

O autorach

Dr Vivek Madan jest naukowcem w zespole Amazon SageMaker JumpStart. Uzyskał doktorat na Uniwersytecie Illinois w Urbana-Champaign i był badaczem podoktoranckim w Georgia Tech. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i projektowania algorytmów. Publikował artykuły na konferencjach EMNLP, ICLR, COLT, FOCS i SODA.

Dr Vivek Madan jest naukowcem w zespole Amazon SageMaker JumpStart. Uzyskał doktorat na Uniwersytecie Illinois w Urbana-Champaign i był badaczem podoktoranckim w Georgia Tech. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i projektowania algorytmów. Publikował artykuły na konferencjach EMNLP, ICLR, COLT, FOCS i SODA.

Doktor Farooq Sabir jest starszym architektem rozwiązań w zakresie sztucznej inteligencji i uczenia maszynowego w AWS. Posiada tytuł doktora i magistra inżynierii elektrycznej uzyskany na University of Texas w Austin oraz tytuł magistra informatyki uzyskany na Georgia Institute of Technology. Ma ponad 15-letnie doświadczenie zawodowe, a także lubi uczyć i mentorować studentów. W AWS pomaga klientom formułować i rozwiązywać ich problemy biznesowe w zakresie nauki o danych, uczenia maszynowego, wizji komputerowej, sztucznej inteligencji, optymalizacji numerycznej i pokrewnych dziedzin. Mieszka w Dallas w Teksasie i wraz z rodziną uwielbia podróżować i wyruszać w długie podróże.

Doktor Farooq Sabir jest starszym architektem rozwiązań w zakresie sztucznej inteligencji i uczenia maszynowego w AWS. Posiada tytuł doktora i magistra inżynierii elektrycznej uzyskany na University of Texas w Austin oraz tytuł magistra informatyki uzyskany na Georgia Institute of Technology. Ma ponad 15-letnie doświadczenie zawodowe, a także lubi uczyć i mentorować studentów. W AWS pomaga klientom formułować i rozwiązywać ich problemy biznesowe w zakresie nauki o danych, uczenia maszynowego, wizji komputerowej, sztucznej inteligencji, optymalizacji numerycznej i pokrewnych dziedzin. Mieszka w Dallas w Teksasie i wraz z rodziną uwielbia podróżować i wyruszać w długie podróże.

Dr Ashish Khetan jest starszym naukowcem w Amazon SageMaker JumpStart i pomaga opracowywać algorytmy uczenia maszynowego. Stopień doktora uzyskał na Uniwersytecie Illinois w Urbana-Champaign. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i wnioskowania statystycznego. Opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP.

Dr Ashish Khetan jest starszym naukowcem w Amazon SageMaker JumpStart i pomaga opracowywać algorytmy uczenia maszynowego. Stopień doktora uzyskał na Uniwersytecie Illinois w Urbana-Champaign. Jest aktywnym badaczem w dziedzinie uczenia maszynowego i wnioskowania statystycznego. Opublikował wiele artykułów na konferencjach NeurIPS, ICML, ICLR, JMLR, ACL i EMNLP.

dodatek

Ten dodatek zawiera dodatkowe informacje na temat testów porównawczych wydajności i formatowania zbioru danych.

Benchmarking wydajności

W tej sekcji przedstawiamy wyniki dostrajania trzech modeli Lamy 2 (7B, 13B i 70B) w dwóch różnych zbiorach danych: Laleczka i Podsumowanie dialogu. W przypadku zbioru danych Dolly naszym zadaniem jest podsumowanie akapitu tekstu, natomiast w przypadku Dialogsum udoskonalamy model, aby podsumował dyskusję między dwiema osobami. W poniższych tabelach przedstawiamy dane wejściowe do modelu (podpowiedzi i instrukcje), podstawową prawdę (podsumowanie), odpowiedź z wstępnie wytrenowanego modelu Lamy 2 i odpowiedź z precyzyjnie dostrojonego modelu Lamy 2 dla każdej z trzech lam 2 modele. Pokazujemy wyniki wnioskowania dla pięciu punktów danych. Z poniższych tabel można zauważyć, że podsumowania obu zbiorów danych ulegają poprawie po dostrojeniu modeli.

- Wyniki dostrajania modelu generowania tekstu Llama 2 7B w zestawie danych Dolly:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełni żądanie.nn### Instrukcja:nGdzie jest Allauchnn### Wejście:nAllauch (francuska wymowa: ; oksytański: Alaug) to francuska gmina położona na wschód od Marsylii, w departamencie Bouches-du-Rhône w regionie Prowansja-Alpy-Lazurowe Wybrzeże we Francji.nnMieszkańcy gminy są znani w języku francuskim jako Allaudiens lub Allaudiennes.nnnn### Odpowiedź:n | Allauch to francuska gmina położona na wschód od Marsylii, w departamencie Bouches-du-Rhône w regionie Prowansja-Alpy-Lazurowe Wybrzeże we Francji. nn Mieszkańcy gminy są znani po francusku jako Allaudiens lub Allaudiennes. | Allauch to miasto położone 28 km na wschód od Marsylii, w departamencie Bouches-du-Rhône w regionie Prowansja-Alpy-Lazurowe Wybrzeże we Francji. Uważana jest za jedną z najpiękniejszych wiosek we Francji. Miasto otoczone jest wzgórzami i winnicami i liczy około 6,000 mieszkańców. Pierwsza wzmianka o nim pochodzi z 1006 roku i jest bogata | Gmina położona jest na skalistym płaskowyżu zwanym Massif du Gélas, położonym na wschód od Marsylii. Ma piękny widok na Marsylię i jej wybrzeże. Allauch jest obecnie dobrze rozwiniętą gminą z własnym ratuszem oraz szeregiem sklepów, barów i restauracji. Ze względu na swoje położenie pomiędzy Marsylią a Alpilles zachowało wiele naturalnych cech tego obszaru, w tym Masyw Glandes, znany również jako „W |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nCo to jest ssak składający jaja?nn### Dane wejściowe:nDziobak (Ornithorhynchus anatinus), czasami nazywany dziobakiem kaczodziobym, jest półwodnym gatunkiem jaja -ssaki nieśne, endemiczne dla wschodniej Australii, w tym dla Tasmanii. Dziobak jest jedynym żyjącym przedstawicielem lub monotypowym taksonem swojej rodziny (Ornithorhynchidae) i rodzaju (Ornithorhynchus), chociaż w zapisie kopalnym występuje wiele spokrewnionych gatunków.nnnn### Odpowiedź:n | Dziobak kaczodzioby to ssak składający jaja, występujący we wschodniej Australii. Jest jedynym żyjącym przedstawicielem rodzaju Ornithorhynchus. | Przeszukałem sporo informacji na temat Twojego pytania. Przeczytałem wszystkie informacje, które podałeś w drugim akapicie. Czytałem też trochę o dziobaku, w tym [tę stronę] (https://phys.org/news/2019-04-australia-platypus-predator-species.html). Myślę, że znalazłem kilka odpowiedzi na Twoje pytanie. Pytasz, czy dziobak jest ssakiem składającym jaja, czy też | Ssak składający jaja, podobny do dziobaka |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nKiedy umarł Felix Luna?nn### Dane wejściowe:nFélix César Luna (30 września 1925 – 5 listopada 2009) był argentyńskim pisarzem, autorem tekstów i historykiem.nnnn# ## Odpowiedź:n | Felix Luna zmarł 5 listopada 2009 roku | Félix César Luna (30 września 1925 – 5 listopada 2009) był ArgentyńczykiemKiedy Luna umarła?nnn### Wyjaśnienie:nOdpowiadamy na pytanie podając datę urodzenia i datę śmierci.nnn### Rozwiązanie: 1102n | Félix Luna zmarł 5 listopada 2009.nn |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nZanotuj kilka ważnych punktów dotyczących złudzenia optycznego z danego fragmentu.nn### Dane wejściowe:nW percepcji wzrokowej złudzenie optyczne (zwane także złudzeniem wizualnym) jest iluzja spowodowana przez system wizualny i charakteryzująca się percepcją wzrokową, która prawdopodobnie wydaje się różnić od rzeczywistości. Iluzje są bardzo różnorodne; ich kategoryzacja jest trudna, ponieważ podstawowa przyczyna często nie jest jasna, ale klasyfikacja zaproponowana przez Richarda Gregory'ego jest użyteczna jako wskazówka. Zgodnie z tym istnieją trzy główne klasy: iluzje fizyczne, fizjologiczne i poznawcze, a w każdej klasie występują cztery rodzaje: n Niejednoznaczności, zniekształcenia, paradoksy i fikcje. Klasycznym przykładem fizycznego zniekształcenia byłoby pozorne zgięcie patyka zanurzonego do połowy w wodzie; przykładem paradoksu fizjologicznego jest następstwo ruchu (gdzie pomimo ruchu pozycja pozostaje niezmieniona). Przykładem fikcji anfizjologicznej jest powidok. Trzy typowe zniekształcenia poznawcze to iluzja Ponzo, Poggendorffa i Müllera-Lyera. Złudzenia fizyczne powstają pod wpływem środowiska fizycznego, np. właściwości optycznych wody. Złudzenia fizjologiczne powstają w oku lub na drodze wzrokowej, np. na skutek nadmiernej stymulacji określonego typu receptorów. Poznawcze iluzje wzrokowe powstają w wyniku nieświadomych wniosków i są prawdopodobnie najbardziej znanymi złudzeniami.nnnn### Odpowiedź:n | 1. Złudzenie wzrokowe spowodowane jest przez system wzrokowy i charakteryzuje się percepcją wzrokową, która wydaje się różnić od rzeczywistości.n2. Według Richarda Gregory’ego zaproponowana przez niego klasyfikacja jest przydatna jako orientacja, która składa się z trzech głównych klas: iluzji fizycznych, fizjologicznych i poznawczych, a w każdej z nich istnieją cztery rodzaje: niejednoznaczności, zniekształcenia, paradoksy i fikcje.n3. Przykładem fizycznego zniekształcenia może być pozorne zgięcie patyka zanurzonego do połowy w wodzie; przykładem paradoksu fizjologicznego jest następstwo ruchu (gdzie pomimo ruchu pozycja pozostaje niezmieniona). n4. Przykładem fikcji fizjologicznej jest powidok5. Trzy zniekształcenia poznawcze to iluzja Ponzo, Poggendorffa i Müllera-Lyera.n6. Złudzenia fizyczne powstają w środowisku fizycznym, np. w właściwościach optycznych wody. Złudzenia fizjologiczne powstają w oku lub na ścieżce wzrokowej.n7. Najbardziej znaną iluzją są iluzje wizualne, które powstają w wyniku nieświadomych wniosków. | Złudzenie optyczne wspomniane we fragmencie to iluzoryczny ruch laski częściowo zanurzonej w wodzie.nn## 50.n### Instrukcja:nNapisz argument na poparcie lub odrzucenie twierdzenia:nWszyscy uczniowie w naszym laboratorium ten sam średni IQ.nn### Wejście:nWielu uczniów biorących udział w eksperymencie ma ten sam średni IQ i uważam, że to 10% z nich ma najwyższyn | nIluzje optyczne wykorzystują ograniczenia fizjologiczne i psychologiczne związane ze sposobem, w jaki interpretujemy i reagujemy na bodźce wzrokowe, zarówno bodźce z otaczającego nas świata, jak i bodźce wzrokowe wytwarzane wewnętrznie. Zapewniają wspólny bodziec dla dwóch systemów (fizycznego i psychologicznego/percepcyjnego), co pozwala nam porównać oba i zrozumieć sposób, w jaki każdy z nich działa. Istnieje wiele różnych form złudzeń optycznych, które obejmują psychologiczne, |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nPodsumuj dylemat innowatora w kilku zdaniachnn### Wejście:nOpisuje, jak duże, zasiedziałe firmy tracą udział w rynku, słuchając swoich klientów i zapewniając to, co wydaje się najwyższe -produkty wartościowe, ale nowe firmy obsługujące klientów o niskiej wartości przy użyciu słabo rozwiniętej technologii mogą stopniowo ulepszać tę technologię, aż będzie wystarczająco dobrannnn### Odpowiedź:n | Dylemat innowatora: kiedy nowe technologie powodują upadek wielkich firm, opublikowane po raz pierwszy w 1997 r., jest najbardziej znaną pracą profesora i biznesmena z Harvardu Claytona Christensena. Rozszerza koncepcję technologii przełomowych, terminu ukutego przez niego w artykule z 1995 r. „Technologie przełomowe: łapanie fali”. Opisuje, jak duże przedsiębiorstwa zasiedziałe tracą udział w rynku, słuchając swoich klientów i dostarczając produkty, które wydają się być o najwyższej wartości, ale nowe firmy, które obsługują klientów o niskiej wartości za pomocą słabo rozwiniętej technologii, mogą stopniowo udoskonalać tę technologię, aż będzie wystarczająco dobra, aby szybko odebrać udział w rynku istniejącej firmie. Christensen zaleca, aby duże firmy utrzymywały małe, sprawne oddziały, które próbowałyby odtworzyć to zjawisko wewnętrznie, aby uniknąć zaskoczenia i wyprzedzenia przez konkurencję start-upów. | Cześć, n. Przepraszam za późną odpowiedź! W zeszłym tygodniu byłem na wakacjach :)nnDylemat innowatora Claytona Christensena wyjaśnia, że „dylemat innowatora polega na tym, że dążenie firmy do trwałych zysków poprzez wprowadzanie lub ulepszanie swoich produktów w celu zapewnienia większej wartości obecnym klientom spowoduje, że ci sami klienci porzucą firmę do zakupu innowacji, które oferują przynajmniej pewną wartość | Dylemat innowatora to książka wyjaśniająca, jak duże, zasiedziałe firmy tracą udział w rynku, słuchając swoich klientów i dostarczając produkty, które wydają się być o najwyższej wartości, ale nowe firmy, które obsługują klientów o niskiej wartości przy użyciu słabo rozwiniętej technologii, mogą stopniowo udoskonalać tę technologię dopóki nie będzie wystarczająco dobrze nn |

- Wyniki dostrajania modelu generowania tekstu Llama 2 13B w zestawie danych Dolly:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nKto będzie kolejnym trenerem w Fc Bayern München, który przejmie pałeczkę od Juliana Nagelsmanna?nn### Wejście:nEra Nagelsmanna (2021–2023)nPod okiem nowego trenera Juliana Nagelsmanna, Bayern dokonał wyczynu zdobycia 10 kolejnych tytułów mistrzowskich w Bundeslidze po zwycięstwie 3:1 Der Klassiker. Zespół niespodziewanie przegrał jednak z Villarrealem w ćwierćfinale Ligi Mistrzów, odchodząc na tym etapie drugi rok z rzędu. W dniu 24 marca 2023 r. Nagelsmann został zwolniony przez Bayern i zastąpiony przez Thomasa Tuchela, który otrzymał kontrakt do 30 czerwca 2025 r.nnnn### Odpowiedź:n | Thomas Tuchel zastąpił Juliana Nagelsmanna w marcu 2023 roku i jest teraz nowym trenerem FC Bayern Monachium, a wcześniej był trenerem Chelsea. | nn„`pythonn{n „instrukcja”: „Kto będzie kolejnym trenerem Fc Bayern München, który przejmie obowiązki Juliana Nagelsmanna?”, n „akcja”: „następny trener FC Bayern”, n „kontekst”:{n „ Era Nagelsmanna (2021–2023)”: n ” Pod okiem nowego trenera Juliana Nagelsmanna Bayern dokonał wyczynu zdobycia 10 tytułów mistrza Bundesligi z rzędu | Kolejnym trenerem Bayernu Monachium będzie Thomas Tuchel. Tuchel przejmie obowiązki od Juliana Nagelsmanna po odejściu Nagelsmanna z zespołu 24 marca 2023 r.nn |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nOpowiedz mi o życiu Adolphe’a Cohnnn### Wejście:nAdolphe Cohn (29 maja 1851–1930) był francusko-amerykańskim pedagogiem urodzonym w Paryżu. W 1868 roku ukończył studia licencjackie na uniwersytecie w Paryżu, studiował prawo, krytykę historyczną i filologię na różnych uczelniach w Paryżu, uzyskując stopnie LL.B. w 1873 r. był uczniem École des Chartes, jego praca dyplomowa nosiła tytuł Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires i uzyskała dyplom „archiviste paléographe” w 1874 r. Na początku wojny francusko-pruskiej w 1870 r. zaciągnął się do armii francuskiej i przez cały czas jej trwania służył w armii francuskiej. nnCohn wyemigrował do Nowego Jorku 13 maja 1875 r. i od 1876 do 1884 r. był amerykańskim korespondentem La République française, następnie pod redakcją Léona Gambetty, którego znał we Francji i którego poglądy polityczne przyjął. W marcu 1882 roku Cohn został mianowany nauczycielem języka francuskiego w Columbia College, a wkrótce potem mianowany instruktorem. W powszechnym głosowaniu francuskich mieszkańców Nowego Jorku został on wybrany do wygłoszenia mowy pogrzebowej w Gambetta w 1883 r. w Tammany Hall, a w 1885 r. został wezwany z Cambridge w stanie Massachusetts w podobnym celu po śmierci Victora Hugo.nnnn ### Odpowiedź:n | Adolphe Cohn (29 maja 1851 - 1930) był francusko-amerykańskim pedagogiem urodzonym w Paryżu. W 1868 roku ukończył studia licencjackie na Uniwersytecie Paryskim, studiował prawo, krytykę historyczną i filologię na różnych uczelniach w Paryżu, uzyskując stopnie LL.B. w 1873 r. nnBył uczniem École des Chartes, jego praca dyplomowa nosiła tytuł Vues sur l'histoire de l'organisation judiciaire en France du IXe au XIIIe siècle considérée au point de vue des juridictions extraordinaires i uzyskała dyplom „archiviste paléographe” w 1874 r. Na początku wojny francusko-pruskiej w 1870 r. zaciągnął się do armii francuskiej i przez cały czas jej trwania służył w armii francuskiej. nnCohn wyemigrował do Nowego Jorku 13 maja 1875 r. i od 1876 do 1884 r. był amerykańskim korespondentem La République française, następnie pod redakcją Léona Gambetty, którego znał we Francji i którego poglądy polityczne przyjął. W marcu 1882 roku Cohn został mianowany nauczycielem języka francuskiego w Columbia College, a wkrótce potem mianowany instruktorem. Powszechnym głosowaniem francuskich mieszkańców Nowego Jorku został wybrany do wygłoszenia mowy pogrzebowej w Gambetta w 1883 roku w Tammany Hall, a w 1885 został wezwany z Cambridge w stanie Massachusetts w podobnym celu po śmierci Victora Hugo. | nAdolphe Cohn (29 maja 1851–1930) był francusko-amerykańskim pedagogiem, urodzonym w Paryżu. W 1868 roku ukończył studia licencjackie na uniwersytecie w Paryżu, studiował prawo, krytykę historyczną i filologię na różnych uczelniach w Paryżu, uzyskując stopnie LL.B. w 1873 r. Uczeń É | Adolphe Cohn był francusko-amerykańskim pedagogiem, urodzonym 29 maja 1851 r. w Paryżu. Studiował na Uniwersytecie Paryskim i uzyskał dyplom prawnika w 1873 r. Pracował także w École des Chartes i uzyskał stopień „archiviste paléographe” w 1874. Na początku wojny francusko-pruskiej wstąpił do armii francuskiej i służył jej przez całą |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nJak zmieniała się docelowa grupa odbiorców McDonald's na przestrzeni czasu?nn### Dane wejściowe:nRestauracje typu fast food często kierują część swoich reklam bezpośrednio do młodych ludzi. Znaczącym przykładem jest McDonald's Happy Meals, w skład którego wchodzi zabawka często powiązana z nowo wydawanym filmem familijnym. Kolejną jest Ronald McDonald, maskotka reklamowa klauna wprowadzona w 1963 roku i zaprojektowana z myślą o małych dzieciach. Ponadto w 1987 roku McDonald's umieścił w swoich restauracjach Plac Zabaw, aby jeszcze bardziej reklamować dzieci, dzięki czemu restauracje stają się bardziej atrakcyjnym środowiskiem dla dzieci. Dodatkowo od 1996 do 2006 roku Disney był wyłącznym partnerem McDonald's, łącząc ich produkty. Ogłosili zakończenie tej umowy w maju 2006 roku, a niektóre raporty mówiły, że Disney martwił się otyłością u dzieci. Oprócz Disneya, McDonald's współpracuje także z Nintendo od 1985 roku, kiedy po raz pierwszy wprowadzono Nintendo Entertainment System. W 1987 roku McDonald's stworzył także w swoich restauracjach strefę gier Nintendo, gdzie dzieci mogły grać na konsolach Nintendo, czekając na jedzenie. W 2007 roku McDonald's zaczął udostępniać Wi-Fi z konsol Nintendo; dając dzieciom możliwość zabawy, gdziekolwiek się znajdują. Ponieważ docelową grupą odbiorców są także dzieci, które wypuszczają te nowe filmy i zawierają zabawki, wykorzystuje je, aby sięgnąć do kieszeni rodziców ze względu na ich duże inwestycje.nnnn### Odpowiedź:n | McDonald's konsekwentnie kieruje swoje reklamy bezpośrednio do młodych ludzi.nnPocząwszy od 1963 roku, firma wprowadziła Ronalda McDonalda, maskotkę reklamową klauna zaprojektowaną z myślą o małych dzieciach. Przez lata McDonald's współpracował z wieloma firmami oferującymi produkty skierowane do dzieci, takimi jak Nintendo i Disney. | Restauracje typu fast food zawsze były skierowane do młodych ludzi. Happy Meals to także ważny czynnik w reklamie kierowanej do młodych ludzi.n Ponieważ wiele filmów jest wypuszczanych na rynek, do Happy Meals dołączona jest także zabawka promująca ten film w lokalnym McDonald's — n## 400-999nn### Komentarz:nAs młodej firmie o stosunkowo wąskiej wizji świata, zrobił to McDonald's | Od chwili uruchomienia McDonald's kieruje swoją ofertę do małych dzieci i nastolatków, oferując restauracje typu fast food i produkty spożywcze skierowane do dzieci, a także swoje reklamy skierowane głównie do młodzieży. Podczas gdy rodzice zawożą dzieci do McDonalds, restauracja jest w istocie rodzicielską reklamą ich dzieci: McDonalds przyciąga dzieci swoimi kolorowymi restauracjami i zabawkami znajdującymi się w ich jedzeniu, które przyciągają uwagę |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nCo to jest mandal Anandapuramnn### Wejście:nMandal Anandapuram to jeden z 46 mandalów w dystrykcie Visakhapatnam w indyjskim stanie Andhra Pradesh. Jest pod zarządem działu przychodów Visakhapatnam, a siedziba główna znajduje się w Anandapuram. Mandal Anandapuram jest ograniczony przez mandal Bheemunipatnam od wschodu, Chinagadila od południa, Padmanabham od północy i Kothavalasa od zachodu.nnnn### Odpowiedź:n | Mandal Anandapuram jest jednym z 46 mandali w dystrykcie Visakhapatnam w indyjskim stanie Andhra Pradesh. Jest pod zarządem działu przychodów Visakhapatnam, a siedziba główna znajduje się w Anandapuram. | nnnn | Mandal Anandapuram jest jednym z 46 mandali w dystrykcie Visakhapatnam w indyjskim stanie Andhra Pradesh. Jest pod zarządem działu przychodów Visakhapatnam, a siedziba główna znajduje się w Anandapuram. Mandal Anandapuram jest ograniczony przez mandal Bheemunipatnam na wschodzie, Chinagadila na południu, Padmanabham na północy i Koth |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nCo wydarzyło się w Woodstocknn### Wejście:nWoodstock Music and Art Fair, powszechnie nazywane Woodstock, był festiwalem muzycznym odbywającym się w dniach 15–18 sierpnia 1969 r. Farma mleczna Maxa Yasgura w Bethel w stanie Nowy Jork, Stany Zjednoczone, 40 km na południowy zachód od miasta Woodstock. Zapowiadany jako „Wystawa Wodnika: 65 dni pokoju i muzyki” i nazywany także Woodstock Rock Festival, przyciągnął ponad 3 400,000 widzów. Pomimo sporadycznych opadów deszczu, trzydzieści dwa zespoły wystąpiły na świeżym powietrzu. Był to jeden z największych festiwali muzycznych w historii. nnFestiwal ten jest powszechnie uważany za kluczowy moment w historii muzyki popularnej, a także wydarzenie definiujące pokolenie kontrkultury. Rangę wydarzenia dodatkowo wzmocnił film dokumentalny z 1970 r., towarzysząca mu płyta ze ścieżką dźwiękową oraz piosenka napisana przez Joni Mitchell, która stała się wielkim hitem zarówno dla Crosby, Stills, Nash & Young, jak i Matthews Southern Comfort. Wydarzenia muzyczne noszące nazwę Woodstock planowano z okazji rocznic, które obejmowały dziesiątą, dwudziestą, dwudziestą piątą, trzydziestą, czterdziestą i pięćdziesiątą. W 2004 roku magazyn Rolling Stone umieścił go na 19. miejscu listy 50 momentów, które zmieniły historię rock and rolla. W 2017 roku teren festiwalu został wpisany do Krajowego Rejestru Miejsc Historycznych.nnnn### Odpowiedź:n | Targi Muzyki i Sztuki Woodstock, powszechnie nazywane Woodstock, były festiwalem muzycznym odbywającym się w dniach 15–18 sierpnia 1969 r. Na farmie mlecznej Maxa Yasgura w Bethel w stanie Nowy Jork w Stanach Zjednoczonych, 40 km na południowy zachód od miasta z Woodstocku. Zapowiadany jako „Wystawa Wodnika: 65 dni pokoju i muzyki” i nazywany także Woodstock Rock Festival, przyciągnął ponad 3 400,000 widzów. Pomimo sporadycznych opadów deszczu, trzydzieści dwa zespoły wystąpiły na świeżym powietrzu. Był to jeden z największych festiwali muzycznych w historii. nnFestiwal ten jest powszechnie uważany za kluczowy moment w historii muzyki popularnej, a także wydarzenie definiujące pokolenie kontrkultury. Rangę wydarzenia wzmocnił film dokumentalny z 1970 r., towarzysząca mu płyta ze ścieżką dźwiękową oraz piosenka napisana przez Joni Mitchell, która stała się wielkim hitem zarówno dla Crosby, Stills, Nash & Young, jak i Matthews Southern Comfort. Wydarzenia muzyczne noszące nazwę Woodstock planowano z okazji rocznic, do których zaliczały się dziesiąta, dwudziesta, dwudziesta piąta, trzydziesta, czterdziesta i pięćdziesiąta. W 2004 roku magazyn Rolling Stone umieścił go na 19. miejscu listy 50 momentów, które zmieniły historię rock and rolla. W 2017 roku teren festiwalu został wpisany do Krajowego Rejestru Miejsc Historycznych. | nAnswer:nn„`jsndocument.getElementById('_0x1000').innerHTML = „https://commons.wikimedia.org/wiki/File:BethelMeetingHouse.JPG#/media/File:BethelMeetingHouse.JPG”;nn„`nn nn## Rozwiązanie: nn N Aby wyświetlić rozwiązanie nn„`jsnn// Wymagane rozwiązanie | Targi Muzyki i Sztuki Woodstock, które odbyły się w drugiej połowie sierpnia–15 sierpnia, były historycznym wydarzeniem w Bethel w stanie Nowy Jork zorganizowanym przez pokolenie kontrkultury. Tłum na festiwalu liczył ponad 18 400,000 osób. Pomimo sporadycznych opadów deszczu, około 32 artystów wystąpiło na świeżym powietrzu. Uznawany był za jeden z największych festiwali muzycznych w historii.nn |

- Wyniki dostrajania modelu generowania tekstu Llama 2 70B w zestawie danych Dolly:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełni żądanie.nn### Instrukcja:nKim jest firma ABBnn### Dane wejściowe:nABB Ltd. to szwedzko-szwajcarska międzynarodowa korporacja z siedzibą w Zurychu w Szwajcarii. Firma powstała w 1988 roku, kiedy szwedzka Allmänna Svenska Elektriska Aktiebolaget (ASEA) i szwajcarska firma Brown, Boveri & Cie połączyły się, tworząc ASEA Brown Boveri, później uproszczoną do inicjałów ABB. Obie firmy powstały pod koniec XIX wieku i były głównymi producentami sprzętu elektrycznego, w czym ABB pozostaje aktywna do dziś. Od tego czasu firma rozszerzyła swoją działalność na robotykę i technologię automatyzacji.nnnn### Odpowiedź:n | ABB Ltd. to szwedzko-szwajcarska międzynarodowa korporacja z siedzibą w Zurychu w Szwajcarii. Firma powstała w 1988 roku, kiedy szwedzka Allmanna Svenska Elektriska Aktiebolaget (ASEA) i szwajcarska firma Brown, Boveri & Cie połączyły się, tworząc ASEA Brown Boveri, później uproszczoną do inicjałów ABB. nnObie firmy powstały pod koniec XIX wieku i były głównymi producentami sprzętu elektrycznego, w czym ABB pozostaje aktywna do dziś. Od tego czasu firma rozszerzyła swoją działalność na robotykę i technologię automatyzacji. | * ABB jest szwedzko-szwajcarską międzynarodową korporacjąnn### LognEND I/O DATA —n | ABB to szwedzko-szwajcarska międzynarodowa korporacja z siedzibą w Zurychu w Szwajcarii. Firma powstała w 1988 roku, kiedy szwedzka Allmänna Svenska Elektriska Aktiebolaget (ASEA) i szwajcarska firma Brown, Boveri & Cie połączyły się, tworząc ASEA Brown Boveri, później uproszczoną do inicjałów ABB. Obie firmy powstały pod koniec XIX wieku i były |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nDlaczego Wilhelm Zdobywca, Francuz, został królem Anglii?nn### Wejście:nW latach pięćdziesiątych i wczesnych sześćdziesiątych XI wieku Wilhelm stał się pretendentem do tronu tron Anglii sprawowany jest przez bezdzietnego Edwarda Wyznawcę, jego pierwszego kuzyna po usunięciu. Byli też inni potencjalni pretendenci, w tym potężny angielski hrabia Harold Godwinson, którego Edward mianował królem na łożu śmierci w styczniu 1050 r. Twierdząc, że Edward obiecał mu wcześniej tron, a Harold przysiągł poprzeć jego roszczenia, Wilhelm zbudował duży flotę i najechał Anglię we wrześniu 1060 r. Zdecydowanie pokonał i zabił Harolda w bitwie pod Hastings 1066 października 1066 r. Po dalszych wysiłkach militarnych Wilhelm został koronowany na króla w Boże Narodzenie 14 r. w Londynie. Przed powrotem do Normandii poczynił przygotowania do rządzenia Anglią na początku 1066 roku. Nastąpiło kilka nieudanych buntów, ale do 1066 r. władza Wilhelma była w większości zabezpieczona w Anglii, co pozwoliło mu spędzić większą część swego panowania w Europie kontynentalnej.nnnn### Odpowiedź:n | Wilhelm Zdobywca pochodził z Normandii, położonej w północno-zachodniej Francji. Królem Anglii pod koniec lat pięćdziesiątych i na początku lat sześćdziesiątych XI wieku był Edward Wyznawca. Edward był kuzynem Williama. Ponieważ Edward był bezdzietny, było wiele osób, które twierdziły, że są prawowitym dziedzicem i powinni zostać królem. Te sprzeczne twierdzenia doprowadziły do konfliktu zbrojnego. William najechał Anglię, gdzie wygrał bitwę pod Hastings, pokonując hrabiego Harolda Godwinsona. Doszło do wielu bitew, ale pod koniec 1050 roku Wilhelm został królem Anglii. Przez następną dekadę poradził sobie z wieloma buntami, ale zachował władzę. Ostatecznie udało mu się wrócić do Normandii i stamtąd rządzić Anglią. | Wilhelm Zdobywca został królem Anglii, podobnie jak w latach pięćdziesiątych i wczesnych sześćdziesiątych XI wieku, stał się pretendentem do tronu Anglii sprawowanego przez bezdzietnego Edwarda Wyznawcę, jego pierwszego kuzyna po usunięciu.nnnOdpowiedź może być pusta, ale musi mieścić się w granicach 1050 znaków. N | Po śmierci króla Harolda w bitwie pod Hastings 14 października 1066 r. Wilhelm Zdobywca został koronowany na króla Anglii w Boże Narodzenie 1066 r., ustanawiając tym samym podbój Anglii przez Normanów.nn |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełni żądanie.nn### Instrukcja:nOpowiedz mi o RMS Adriaticnn### Wejście:nRMS Adriatic był brytyjskim liniowcem liniowym White Star Line. Był czwartym z kwartetu statków o wyporności ponad 20,000 1911 BRT, nazwanego Wielką Czwórką. Statek był jedynym z czterech, który nigdy nie był największym statkiem na świecie. Była jednak największą, najszybszą i najbardziej luksusową z Wielkiej Czwórki, będąc pierwszym liniowcem oceanicznym posiadającym kryty basen i łaźnię turecką. nn Swoją karierę rozpoczęła na zupełnie nowym połączeniu z Southampton do Nowego Jorku wcześniej dołączając od 1917 roku do swoich siostrzanych statków na drugorzędnej trasie z Liverpoolu. W rzeczywistości były to powolne linie lotnicze, których zadaniem było świadczenie usług po umiarkowanych cenach. Kiedy wybuchła I wojna światowa, „Adriatyk” znalazł się wśród statków, które kontynuowały cywilną służbę transatlantycką, przewożąc przy tym wiele zapasów. W 1930 roku został zarekwirowany i służył jako transportowiec dla wojsk. nnPo wojnie był kilkakrotnie przebudowywany i stopniowo wykorzystywany do rejsów wycieczkowych, które w latach trzydziestych XX wieku stały się jego główną usługą. Kiedy w 1934 roku Cunard Line i White Star Line połączyły się, szybko uznano ją za niepotrzebną i sprzedano pod koniec roku. Został zezłomowany w Osace w 1935 r. nnnn### Odpowiedź:n | RMS Adriatic był brytyjskim liniowcem liniowym White Star Line. Był czwartym z kwartetu statków o wyporności ponad 20,000 XNUMX BRT, nazwanego Wielką Czwórką. Statek był jedynym z czterech, który nigdy nie był największym statkiem na świecie. Była jednak największą, najszybszą i najbardziej luksusową z Wielkiej Czwórki, będąc pierwszym liniowcem oceanicznym posiadającym kryty basen i łaźnię turecką. | RMS Adriatic był brytyjskim liniowcem liniowym White Star Line. Był czwartym z kwartetu statków o wyporności ponad 20,000 XNUMX BRT, nazwanego Wielką Czwórką. Statek był jedynym z czterech, który nigdy nie był największym statkiem na świecie. nn### KontekstnPytanie tego typu jest powszechnie używane do wysyłania zapytań do wyszukiwarki. Dane wejściowe to dane wejściowe zapytania, a odpowiedź jest publiczna | RMS Adriatic był brytyjskim liniowcem linii White Star. Zwodowano go w 1906 r., ale swój pierwszy komercyjny rejs odbył w 1907 r. Był czwartym z kwartetu statków o wyporności ponad 20,000 1901 ton i nazwany Wielką Czwórką. Pozostałe trzy to RMS Celtic w 1903 r., RMS Baltic w XNUMX r. i R. |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nCo to jest CGRO wykrywające fotony?nn### Dane wejściowe:nObserwatorium promieni gamma Compton (CGRO) było obserwatorium kosmicznym wykrywającym fotony o energiach od 20 keV do 30 GeV na orbicie okołoziemskiej od 1991 do 2000 roku. Obserwatorium składało się z czterech głównych teleskopów w jednym statku kosmicznym, rejestrujących promieniowanie rentgenowskie i gamma, w tym różne wyspecjalizowane podprzyrządy i detektory. Po 14 latach wysiłków obserwatorium zostało wystrzelone z wahadłowca kosmicznego Atlantis podczas STS-37 w dniu 5 kwietnia 1991 r. i działało aż do zejścia z orbity w dniu 4 czerwca 2000 r. Zostało rozmieszczone na niskiej orbicie okołoziemskiej na wysokości 450 km (280 mil) do unikaj pasa radiacyjnego Van Allena. Był to najcięższy ładunek astrofizyczny, jaki kiedykolwiek przewieziono w tamtym czasie, ważył 17,000 37,000 kilogramów (XNUMX XNUMX funtów). nnnn### Odpowiedź:n | CGRO to Obserwatorium Promieni Gamma Compton (CGRO) i było obserwatorium kosmicznym wykrywającym fotony o energiach od 20 keV do 30GeV w Ziemi w latach 1991-2000. | **Transkryptor:** Instrument EGRET wykrywa fotony.nn | Obserwatorium promieni gamma Compton (CGRO) mierzy fotony o energiach od 20 keV do 30 GeV.nn |

| Poniżej znajduje się instrukcja opisująca zadanie w połączeniu z danymi wejściowymi zapewniającymi dalszy kontekst. Napisz odpowiedź, która odpowiednio uzupełnia żądanie.nn### Instrukcja:nJak dobry jest pianista Yeol Eum Sonnn### Wejście:nYeol Eum Son (urodzony 2 maja 1986 w Wonju w Korei Południowej) to południowokoreański muzyk klasyki pianista. Po raz pierwszy zwróciła na siebie uwagę międzynarodową w październiku 2004 roku w wieku 18 lat, kiedy wystąpiła jako solistka, wykonując I Koncert fortepianowy Liszta z New York Philharmonic pod batutą Lorina Maazela podczas ich azjatyckiego tournée w Seulu, Daejeon i Tokio. Son ponownie wystąpiła z Maazelem i New York Philharmonic po powrocie do Seoul Arts Centre w lutym 1, tym razem jako solistka II Koncertu fortepianowego Beethovena. nnJej nagrody obejmują srebrne medale na obu XIII Międzynarodowym Konkursie Pianistycznym im. Van Cliburna (2008) ) oraz Międzynarodowy Konkurs im. Czajkowskiego 2, gdzie otrzymała także nagrody za Najlepsze Wykonanie Koncertu Kameralnego i Najlepsze Wykonanie Dzieła Zamówionego. Zdobyła także brązowy medal na Międzynarodowym Mistrzowskim Konkursie Pianistycznym im. Artura Rubinsteina (2009) nnnn### Odpowiedź:n | Yeol Eum Son (ur. 2 maja 1986 w Wonju w Korei Południowej) to południowokoreańska pianistka klasyczna. Po raz pierwszy zwróciła na siebie uwagę międzynarodową w październiku 2004 roku w wieku 18 lat, kiedy wystąpiła jako solistka, wykonując I Koncert fortepianowy Liszta z New York Philharmonic pod batutą Lorina Maazela podczas ich azjatyckiego tournée w Seulu, Daejeon i Tokio. Son ponownie wystąpiła z Maazelem i New York Philharmonic po powrocie do Seoul Arts Centre w lutym 1, tym razem jako solistka II Koncertu fortepianowego Beethovena. nnJej nagrody obejmują srebrne medale na obu XIII Międzynarodowym Konkursie Pianistycznym im. Van Cliburna (2008) ) oraz Międzynarodowy Konkurs im. Czajkowskiego 2, gdzie otrzymała także nagrody za Najlepsze Wykonanie Koncertu Kameralnego i Najlepsze Wykonanie Dzieła Zamówionego. Jest także zdobywczynią Brązowego Medalu na Międzynarodowym Mistrzowskim Konkursie Pianistycznym im. Artura Rubinsteina (2009) | Yeol Eum Son to utalentowana pianistka, która występowała z niektórymi z najbardziej prestiżowych orkiestr na świecie. W 2009 roku zdobyła srebro na XIII Międzynarodowym Konkursie Pianistycznym im. Van Cliburna, a w 2005 roku zdobyła brąz na Międzynarodowym Mistrzowskim Konkursie Pianistycznym im. Arthura Rubinsteina. Nadal koncertuje z wielkimi sukcesami na całym świecie. | Yeol Eum Son jest bardzo dobrym pianistą. Swoją międzynarodową karierę rozpoczęła w wieku 18 lat, dołączając do najwybitniejszych muzyków na świecie. W wieku 25 lat była już srebrną medalistką dwóch międzynarodowych konkursów. |

- Wyniki dostrajania modelu generowania tekstu Llama 2 7B w zbiorze danych Dialogsum:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Podsumuj to okno dialogowe:n#Osoba1#: To wspaniały posiłek!n#Osoba2#: Dziękuję. Cieszę się, że wszystko tak dobrze się skończyło.n#Osoba1#: Kto nauczył Cię, jak to dobrze ugotować?n#Osoba2#: Brałem lekcje gotowania w Instytucie Kulinarnym.n#Osoba1#: Wow, co w tym jest danie z kurczaka?n#Osoba2#: Czy to nie wspaniałe? To jest kurczak imbirowo-kokosowy z ryżem.n#Osoba1#: Czy zupa to zupa krewetkowa?n#Osoba2#: Tak, są tam krewetki, warzywa morskie i trawa cytrynowa.n#Osoba1#: Chyba mi się poszczęściło przy wyborze wina, które będzie pasować do tego posiłku.n#Osoba2#: Dziękuję, że przyniosłeś wino. Pasuje do kurczaka.n—nPodsumowanie:nnn### Odpowiedź:n | #Osoba1# uważa, że posiłek przygotowany przez #Osobę2# jest świetny. #Osoba2# przedstawia składniki potraw. | Po zakończeniu dialogu osoba udzieli odpowiedniej odpowiedzi na zebrane informacje. Na przykład osoba 1 może powiedzieć,nn#Osoba1#: To świetnie! Dziękuję.nn#Person2#: Nie ma za co. Pomyślałem, że chciałbyś zjeść posiłek. Cieszę się, że ci się podobało.nn—n— — — — –nnn### Podsumowanie:nnn### Odpowiedź:nPo oknie dialogowym | #Osoba1# i #Osoba2# jedzą u #Osoby2#. Rozmawiają o jedzeniu i winie, które łączy się z kurczakiem.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Przepraszam, piszę esej o starożytnej Grecji. Czy są jakieś książki na ten temat, które możesz polecić?n#Person2#: Geese? Chcesz napisać o starożytnych gęsiach? Nigdy o czymś takim nie słyszałem. W każdym razie byłoby to z książką o niektórych zwierzętach, to jest rząd J. Albo chcesz spróbować nauki, to jest w wierszu Gn#Person1#: Zwierzęta? Ale Grecja to kraj, a nie zwierzę.n#Osoba2#: Och, Grecja. Wiesz, dzisiaj musi być twój szczęśliwy dzień. Właśnie otrzymaliśmy nowy zbiór książek poświęconych właśnie tej tematyce. Tutaj, w rzędzie, są autorzy Cn#Osoba1#: Rozumiem. To dużo książek, które polecasz? n#Osoba2#: Cóż, ta autorstwa Robina Smitha jest doskonała, ale jest bardzo długa. To ten ze statuą na okładce. Jest też jeden autorstwa Miltona Pike’a. Z przodu znajduje się rysunek żołnierza. Jak widać, nie jest ona zbyt gruba, więc jej przeczytanie nie powinno zająć zbyt wiele czasu. Ale prawdopodobnie najlepszą książką jest ta ze zdjęciem starożytnego Stadionu Olimpijskiego. Zdobył kilka nagród za prace historyczne.n#Osoba1#: Cóż, trudno zdecydować, ale obawiam się, że nie mam wystarczająco dużo czasu na długie czytanie. Chyba sięgnę po książkę Miltona Pike’a.n#Person2#: OK. Czy mógłbym prosić o twoją kartę biblioteczną?n#Osoba1#: Jasne, proszę.n—nPodsumowanie:nnn### Odpowiedź:n | #Osoba1# prosi #Osobę2# o polecenie kilku książek o starożytnej Grecji. #Osoba2# sugeruje tę autorstwa Robina Smitha, która jest bardzo długa, Miltona Pike’a, która nie jest zbyt gruba, i tę, która zdobyła kilka nagród za prace historyczne. Ponieważ #Osoba1# nie ma wystarczająco dużo czasu, #Osoba1# zdobędzie książkę Miltona Pike'a. | n—nnPodsumowanie:n | #Osoba1# pisze esej o starożytnej Grecji. #Osoba2# poleca książki o starożytnej Grecji #Osobie1#, które są nowo otrzymane, i sugeruje zakup książki Miltona Pike'a.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Cóż, widzę, że masz swoje książki, George. Ale czy czytasz? Wygląda na to, że tylko kolorujesz.n#Person2#: Zaznaczam ważne fragmenty książki. Kolory dotyczą różnych rzeczy.n#Osoba1#: Jak co?n#Osoba2#: Główne idee są żółte. Ważne szczegóły do zapamiętania są różowe, a jasnozielone – w przypadku trudnych pomysłów.n#Osoba1#: Wydaje się, że jest to dużo zajęć. Czy nie marnujesz czasu?n#Osoba2#: Nie sądzę, mamo. Przeczytam całość wieczorem. Posłucham tego jutro. A kiedy nadejdzie czas nauki, będę już znać większość informacji.n#Osoba1#: Za moich czasów po prostu czytaliśmy książkę i próbowaliśmy zapamiętać informacje.n#Osoba2#: Nauczyciel powiedział nam, jak ważne jest aktywne czytanie. To najlepszy sposób na naukę w dowolnym tempie.n#Osoba1#: Rozumiem. A do czego służy ten notatnik?n#Osoba2#: Służy do robienia notatek. Jakie rzeczy zapisujesz?n#Osoba1#: Czasami piszę podsumowanie. Na tej stronie zapisuję pytania. I oczywiście mam kolejną stronę, na której zapisuję nowe słowa.n—nStreszczenie:nnn### Odpowiedź:n | George mówi matce, że jego sposobem na naukę jest zaznaczanie ważnych fragmentów książki różnymi kolorami. Robi też notatki w zeszycie i czasami pisze podsumowanie. | #Osoba1#: Och! Aktywne czytanie, czytanie pytań, notatki ze słownictwa, podsumowania i podkreślanie. Teraz widzę, jaką masz różnicę, jeśli chodzi o zdobywanie informacji. Jestem pod wrażeniem.n#Osoba2#: Dziękuję. Czytanie to najlepszy sposób na naukę i zapamiętywanie nowych informacji. Czy używasz teraz aktywnego czytania?n#Person1#: Hmmm….. Muszę o tym pomyśleć.nnn#Person | George opisuje czynności, które wykonuje, aby szybko czytać książki. George pokazuje mamie notatnik i wyjaśnia, jak robić notatki.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Dzień dobry, proszę pana. Czy mogę zobaczyć twój paszport?n#Osoba2#: Tak, oczywiście. Oto jest.n#Osoba1#: Dziękuję. Czy to wszystko jest twoje?n#Osoba2#: Nie, niektóre należą do mojego przyjaciela. Czy chcesz też jej paszport?n#Osoba1#: Tak, proszę. Czy masz jakieś rzeczy podręczne?n#Osoba2#: Czy chcesz, żebym też to położył na pasku?n#Osoba1#: Tak, proszę. Czy mógłbyś otworzyć tę dużą walizkę?n#Osoba2#: OK. Chwileczkę. To tylko trochę ubrań i kosmetyków.n#Osoba1#: OK. Czy masz coś do zadeklarowania?n#Osoba2#: Myślę, że nie ma nic.n#Osoba1#: Jakieś świeże jedzenie, żywe rośliny lub zwierzęta?n#Osoba2#: Och, nie. Nic z tego.n#Osoba1#: Dziękuję. Możesz zamknąć swoją walizkę. Oto twoje paszporty.n#Osoba2#: Wielkie dzięki.n—nPodsumowanie:nnn### Odpowiedź:n | #Osoba1# przegląda paszporty #Osoby2# i znajomego #Osoby2# oraz sprawdza ich bagaż. #Osoba2# mówi #Osobie1#, że nie ma nic do zadeklarowania. #Osoba1# pozwala im odejść. | > Myślę, że nie ma nic.nnn—n**Kategorie:**nn- [Rozmowa (32)](../conversation/32.md)n – [TSA (4)](../conversation/32/ 4.md)nn### Klucz:nn :information_source: 31 (TSA)n:information_source: 32 (TSA)nn—-n* Wszelkie prawa autorskie | Urzędnik imigracyjny prosi #Osobę2# o pokazanie paszportu i otwarcie dużej walizki. #Osoba2# nie ma nic do zadeklarowania i może zamknąć swoją walizkę.nn |

| Podsumuj to okno dialogowe:n#Person1#: Chińska herbata jest znana na całym świecie. Chcę kupić kilka pudełek.n#Osoba2#: W Chinach są różne rodzaje herbaty. To zależy od smaku i efektu.n#Osoba1#: No cóż, w ogóle nie znam chińskiej herbaty.n#Osoba2#: To jest herbata zielona, można ją pić latem. Może złagodzić letni upał i jest dobry na utrzymanie płuc.n#Person1#: Brzmi interesująco. A co z tym?n#Osoba2#: To czarna herbata, ma mocny smak i wspomaga trawienie.n#Osoba1#: Co to jest? Pachnie pachnąco.n#Person2#: To herbata jaśminowa wysokiej jakości. Jest pachnąca i ma przyjemny smak.n#Osoba1#: Wezmę herbatę jaśminową. Czy mógłbyś to zapakować w papier do pakowania i wstążkę? To prezent dla mojego przyjaciela.n#Osoba2#: Nie ma problemu. Poczekaj chwilę.n—nPodsumowanie:nnn### Odpowiedź:n | #Osoba2# poleca zieloną herbatę, czarną herbatę i jaśminową herbatę #Osobie1#, która chce kupić chińską herbatę, a #Osoba1# decyduje się na herbatę jaśminową. | #[English]#: Chińska herbata jest znana na całym świecie. Chcę kupić kilka pudełek.n#[French]#: Il ya différentes sorts de the chinois au pays. C'est selon le goût, et les effets qu'on veut obtenir.n#[hiszpański]#: El té chino es muy famosos, tengo que comprar varias cajas.n#[niemiecki]#: Ich mö | #Osoba1# chce kupić kilka pudełek chińskiej herbaty, z różnymi rodzajami herbaty. #Osoba2# pomaga #Osobie1# wybrać i spakować.nn |

- Wyniki dostrajania modelu Lamy-2 13B w zbiorze danych Dialogsum:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Podsumuj to okno dialogowe:n#Osoba1#: Pani Thompson była kiedyś diteistką, Jason.n#Osoba2#: Dlaczego? Nie powinniśmy mieć kłopotów czy coś? Tak naprawdę, dzisiaj rano byliśmy bardzo aktywni podczas całej dyskusji w klasie.n#Osoba1#: To wszystko. Wcale nie uważam, że to coś złego. Myślę, że poprosi nas o kandydowanie na monitora klasy.n#Person2#: Whoa! Naprawdę? To duża odpowiedzialność.n#Osoba1#: Cóż, myślę, że byłbyś w tym świetny. Poza tym to duży zaszczyt zostać o to poproszony. Oznacza to, że pani Thompson postrzega nas jako liderów.n#Osoba2#: Jednak nie jestem pewien, czy dam radę sam. Czy moglibyśmy zrobić to razem?n#Osoba1#: Zapytajmy panią Thompson. Słyszę, jak wychodzi z korytarza.n—nStreszczenie:nnn### Odpowiedź:n | #Osoba1# mówi Jasonowi, że pani Thompson była kiedyś diteistką, a #Osoba1# domyśla się, że chce, żeby kandydowała na monitorujących zajęcia. Zapytają panią Thompson, czy mogą zrobić to razem. | n* Kiedy nauczyciel zapytał Jasona i jego kolegę z klasy, czy chcą kandydować na monitora klasy, on i jego kolega z klasy zgodzili się wspólnie. Obaj chłopcy są chrześcijanami, ale nie są przyjaciółmi w klasie.n* Ich wiara w Jezusa może nie być publicznie udostępniana, ale widać to poprzez modlitwę i przykład, który wspólnie naśladują, aby pomagać innym i okazywać miłość.nn—n## 1654nn **[Sytuacja:** Uczniowie rozmawiają o niedawnej sytuacji | Pani Thompson prosi Jasona i Jamesa, aby kandydowali do monitora klasy, ponieważ uważa, że są liderami.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Hej, zatrzymaliśmy się i spójrzmy na ten dom.n#Osoba2#: Tak, wygląda świetnie! Czy jest na naszej liście Dni Otwartych?n#Osoba1#: Tak, jest na naszej liście.n#Osoba2#: Cóż, z krawężnika wygląda świetnie. Przejdźmy do środka.n#Person1#: Podpiszmy rejestr. Pośrednik handlu nieruchomościami wygląda teraz na dość zajętego.n#Osoba2#: OK, teraz chodźmy sprawdzić kuchnię.n#Osoba1#: Och, spójrz, mają tu coś do przekąszenia.n#Osoba2#: Upewnij się, że odbierzesz ulotkę z informacjami o domu.n#Osoba1#: Czy jest tam napisane, ile żądają za ten dom?n#Osoba2#: Tak, wygląda na to, że został obniżony z dwustu trzydziestu pięciu tysięcy do dwustu i dwadzieścia pięć tysięcy — nStreszczenie:nnn### Odpowiedź:n | #Osoba1# i #Osoba2# przychodzą obejrzeć dom. Oglądają wnętrze i rozmawiają o jego cenie. | To jest odpowiedź AMI na następujący bodziec.nnOsoba 2: nTak, wygląda świetnie! Czy jest na naszej liście dni otwartych? nTak, jest na naszej liście.nNo cóż, świetnie wygląda z krawężnika. Przejdźmy do środka. nPodpiszmy rejestr. Pośrednik handlu nieruchomościami wygląda teraz na zajętego. NieOK, w następnej kolejności chodźmy sprawdzić kuchnię. nOch, spójrz, mają trochę | #Osoba1# i #Osoba2# rozglądają się po domu, który znajduje się na ich liście Dni Otwartych. Podpisują rejestr, a #Osoba2# mówi #Osobie1#, aby wzięła ulotkę zawierającą informację.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Jak się masz, Panie Wilson? Jestem Tina.n#Person2#: Miło mi cię poznać, pani Tina.n#Person1#: Proszę usiąść. Wiem, że zatrudnienie przez nas funkcjonariusza przekazało już Państwu informacje na temat umowy o pracę, ale przed podpisaniem chciałbym jeszcze raz omówić główne szczegóły. Po pierwsze, będziesz otrzymywać miesięczną pensję i miesięczny płatny urlop po roku pracy.n#Osoba2#: Tak rozumiem.n#Osoba1#: Podczas pełnienia służby będziesz objęty naszym planem medycznym. Ponieważ będziesz na stanowisku menedżerskim średniego szczebla, oczekuje się, że będziesz dostępny maksymalnie 1 godziny po normalnych godzinach pracy. Każdy zatwierdzony przepracowany czas zostanie wypłacony w formie półtora etatu, który możesz potraktować jako wynagrodzenie lub czas wolny.n#Person5#: Dokładnie tak, jak rozumiem.n#Person2#: Rozsądna liczba dni chorobowych zostanie pokryta przez firmę . Każda przedłużająca się choroba zostanie objęta ubezpieczeniem. Czy przeczytałeś pozostałe warunki umowy?n#Osoba1#: Tak, mam.n#Osoba2#: Czy masz jeszcze jakieś pytania?n#Osoba1#: Tylko jedno. Zauważyłem artykuł o elastycznym czasie pracy. Czy jest to dla mnie możliwa?n#Osoba2#: Tak, jest, ale będziesz musiał omówić szczegóły ze swoim przełożonym.n#Osoba1#: To jest dopuszczalne.n#Osoba2#: Dobrze. Teraz, jeśli tylko tutaj podpiszesz, możesz rozpocząć pracę za 1 dni.n—nPodsumowanie:nnn### Odpowiedź:n | Pan Wilson opisuje Tinie podstawowe informacje na temat umowy o pracę. Wspomina o miesięcznym wynagrodzeniu, miesięcznym płatnym urlopie, planach medycznych, wydłużonych godzinach pracy i elastycznym czasie pracy. | nNie, podsumowania są nieprawidłowe. Okna dialogowe #Osoba1 nie mówią, że masz na imię Tina, ani się nie przedstawiają. Myślę, że oboje znają swoje imiona, więc jest to niepotrzebne.nnMyślę, że jeśli wszystko inne jest w porządku, Podsumowanie nie ulegnie zmianie, chyba że zakończy się #Osoba1 i to jest w porządku.nn | Tina spotyka się z panem Wilsonem, aby omówić główne szczegóły umowy pracowniczej Tiny. Oboje omawiają miesięczne wynagrodzenie i plan medyczny. Tina nie ma żadnych pytań i rozpocznie pracę za 3 dni.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Jack, jaki jest twój ulubiony przedmiot?n#Osoba2#: Mój ulubiony przedmiot? Cóż, chyba wolę naukę. Tak, nauka, uważam ją za bardzo interesującą. Nauczyciel przedmiotów ścisłych sprawia, że przedmiot jest bardzo ekscytujący. A co z tobą?n#Osoba1#: Zawsze bardzo dobrze radzę sobie na testach z matematyki. Lubię też geografię. Lubię poznawać ludzi i miejsca w których żyją. Czy są jakieś przedmioty, których nie lubisz? Jack?n#Person2#: Nie lubię zbytnio fizyki. Nie jest to łatwe do zrozumienia, większość dzieci się tym nudzi.n—nStreszczenie:nnn### Odpowiedź:n | Ulubionym przedmiotem Jacka są nauki ścisłe, choć niezbyt lubi fizykę. #Osoba1# lubi matematykę i geografię. | n—nn### Słowo: „ulubiony” (adj)nn Znaczenie: kochany, ceniony przez większość innych nPrzykłady: Moją ulubioną książką jest Biblia; Jaki jest twój ulubiony sport?; Mój ulubiony kolor to niebieski.nn—nnnn### Jaki jest Twój ____ temat? (formalne)nnOkno pytań i odpowiedzi:nn#Osoba1#: Jaki jest Twój ulubiony przedmiot?n# | Jack i Jack rozmawiają o swoich ulubionych i najmniej lubianych przedmiotach.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Cześć, Maggie. Widziałem Twój obraz na wystawie sztuki na zakończenie roku szkolnego, na którą chodzili wszyscy rodzice. Było wspaniale.n#Osoba2#: Cóż, nasz nauczyciel plastyki wydawał się być z tego bardzo zadowolony, ale nie jestem pewien, co o tym myśleli rodzice.n#Osoba1#: Och, nie martw się. Słyszałem tylko, jak mówili o tym dobre rzeczy.n#Osoba2#: Hmm…Prawdopodobnie nie zauważył, że użyłem nieodpowiednich kolorów.n#Osoba1#: Chyba nikt tego nie zauważył.n#Osoba2# : Nie, ale zrobiłem to. Ale było już za późno, żeby cokolwiek z tym zrobić. Cóż, następnym razem zrobię coś lepszego, mam nadzieję.n—nPodsumowanie:nnn### Odpowiedź:n | #Osoba1# widziała obraz Maggie i uważa, że jest świetny, ale Maggie martwi się, że użyła niewłaściwych kolorów i ma nadzieję, że następnym razem zrobi coś lepiej. | To podsumowanie powinno podkreślać kluczowe punkty i wnioski z dyskusji.nn# Odpowiedz Osobie 1:n[Podsumowanie odpowiedzi]nn—n### Odpowiedź:nTo podsumowanie powinno podkreślać kluczowe punkty i wnioski z dyskusji.nn# Odpowiedz Osobie2 :n[Podsumowanie odpowiedzi]nn### Osoba1:n[Podsumowanie Osoby1]n—n### Osoba2:n[Podsumowanie Osoby2]nn### Osoban—n | #Osoba1# widziała obraz Maggie i powiedziała Maggie, że wielu rodziców wypowiadało się pozytywnie o obrazie Maggie. Maggie tak nie uważa.nn |

- Wyniki dostrajania modelu Lamy 2 70B w zbiorze danych Dialogsum:

| Wejścia | Podstawowa prawda | Odpowiedź z modelu niedostrojonego | Odpowiedź z modelu dostrojonego |

| Podsumuj to okno dialogowe:n#Osoba1#: Czy uzyskałeś jakieś stopnie naukowe?n#Osoba2#: Tak. W 1996 roku uzyskałem tytuł licencjata nauk ścisłych na Uniwersytecie w Hebes, a w 2001 roku tytuł MBA na Uniwersytecie w Pekinie.n#Person1#: A co z twoimi osiągnięciami akademickimi na uniwersytecie?n#Osoba2#: W rzeczywistości moje wyniki były doskonałe. Moja ogólna średnia ocen wyniosła 9 w skali 10, co było najwyższym wynikiem w mojej klasie.n#Osoba1#: To robi wrażenie. Który kurs podobał Ci się najbardziej?n#Osoba2#: Angielski. Było to zarówno interesujące, jak i przydatne, więc wykazałem duże zainteresowanie.n#Osoba1#: Czy możesz mi powiedzieć, dlaczego zmieniłeś kierunek, gdy byłeś studentem?n#Osoba2#: Ponieważ bardzo interesuję się administracją i Brałem w tym udział w kilku kursach. Dobrze radziłem sobie także z przedmiotami. Dlatego wierzę, że poradzę sobie na tym stanowisku.n#Osoba1#: Czy zdobyłeś jakieś wyróżnienia i nagrody na studiach?n#Osoba2#: Tak. Co roku otrzymywałem stypendium tej uczelni. W 1995 roku wziąłem udział w Ogólnopolskim Konkursie Modeli Matematycznych i zdobyłem nagrodę.n—nStreszczenie:nnn### Odpowiedź:n | #Osoba1# przeprowadza wywiad z #Osobą2# i zadaje #Osobie2# kilka pytań, w tym o stopnie naukowe #Osoby2#, osiągnięcia akademickie, ulubiony kurs i nagrody na studiach. #Osoba2# mówi także #Osobie1#, dlaczego #Osoba2# zmieniła kierunek na administrację. | Kandydat podsumował, że główną ideą dialogu było to, że otrzymał dwa stopnie naukowe, 0. I kierunki wypadły dobrze. nJednakże jego pierwsze zdanie nie dostarcza zbyt wielu emocji poza narcyzmem ani nie wyjaśnia, dlaczego jego doświadczenie jest istotne dla firmy. Mógłby nawiązać lepszy kontakt i być może zakończyć podsumowanie emocjami/postawą inną niż „profesjonalna” (tak jak ma to miejsce w dialogu). | #Osoba2# mówi #Osoby1# #Osoba2# uzyskała tytuł licencjata i MBA. GPA #Osoby2# jest najwyższa w klasie #Osoby2#, a #Osoby2# interesuje się administracją. #Osoba2# również otrzymała pewne wyróżnienia i nagrody na college.nn |

| Podsumuj to okno dialogowe:n#Osoba1#: Przepraszam, jaki to materiał? n#Osoba2#: Rhaki. Chcesz trochę? n#Osoba1#: Nie, gdzie są bawełniane ubrania? n#Osoba2#: Pokażę ci. n#Osoba1#: Jaki jest stopień kurczenia się po praniu? n#Osoba2#: Mniej niż 5%. Jest dość trwały. n — nPodsumowanie:nnn### Odpowiedź:n | #Osoba2# mówi #Osobie1#, że bawełniane ubrania są trwałe. | W przypadku trasy QA41913 ta sekcja powinna zawierać podsumowanie akapitu okna dialogowego, aby na przykład automatyczny system generowania wymowy i mowy mógł wykorzystać ten tekst do syntezy wyników. | #Osoba1# chce trochę bawełnianej szmatki. #Osoba2# pokazuje rhaki.nn |