Wideo Według najnowszych badań giganta internetowego największy model języka AI Google pomaga robotom być bardziej elastycznym w rozumieniu i interpretowaniu ludzkich poleceń.

Maszyny zazwyczaj najlepiej reagują na bardzo specyficzne żądania – otwarte żądania mogą czasami je zepsuć i prowadzić do wyników, których użytkownicy nie mieli na myśli. Ludzie uczą się wchodzić w interakcje z robotami w sztywny sposób, na przykład zadawać pytania w określony sposób, aby uzyskać pożądaną odpowiedź.

Najnowszy system Google, nazwany PaLM-SayCan, zapowiada się jednak mądrzej. Fizyczne urządzenie od Everyday Robots – startupu wywodzącego się z Google X – ma w głowie kamery zamiast oczu i ramię ze szczypcami schowane za długim, prostym korpusem, który znajduje się na szczycie zestawu kół.

Możesz zobaczyć robota w akcji na poniższym filmie:

Zapytanie robota, coś w stylu „Właśnie ćwiczyłem, czy możesz mi podać zdrową przekąskę?” popchnie go do pobrania jabłka. „PaLM-SayCan [to] interpretowalne i ogólne podejście do wykorzystania wiedzy z modeli językowych, które umożliwia robotowi wykonywanie instrukcji tekstowych wysokiego poziomu w celu wykonywania fizycznie uzasadnionych zadań”, naukowcy z zespołu Google Brain wyjaśnione.

Google wprowadził swój największy model językowy Palma w kwietniu br. PaLM został przeszkolony w zakresie danych zebranych z Internetu, ale zamiast wyrzucać otwarte odpowiedzi tekstowe, system został przystosowany do generowania listy instrukcji do wykonania przez robota.

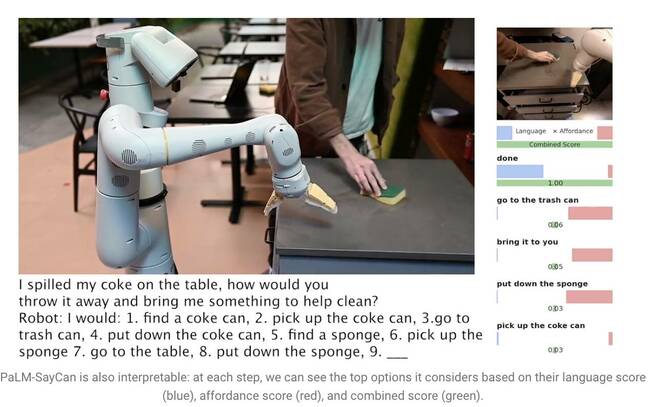

Mówiąc „Wylałem moją colę na stół, jak byś ją wyrzucił i przyniósł mi coś do sprzątania?”, skłania PaLM do zrozumienia pytania i wygenerowania listy kroków, które robot może wykonać, aby wykonać zadanie, np. podnieść puszkę, wrzucić ją do kosza i zdobyć gąbkę.

Jednak modele dużych języków (LLM), takie jak PaLM, nie rozumieją znaczenia niczego, co mówią. Z tego powodu naukowcy wyszkolili osobny model, wykorzystując uczenie się ze wzmacnianiem, aby ugruntować język abstrakcyjny w wizualnych reprezentacjach i działaniach. W ten sposób robot uczy się kojarzyć słowo „Coke” z obrazem puszki napoju gazowanego.

PaLM-SayCan uczy się także tzw. „funkcji afordancji” – metody oceniającej możliwość wykonania określonej czynności w danym obiekcie w jego otoczeniu. Robot z większym prawdopodobieństwem podniesie gąbkę niż odkurzacz, na przykład, jeśli wykryje gąbkę, ale w jej pobliżu nie ma odkurzacza.

„Nasza metoda, SayCan, wydobywa i wykorzystuje wiedzę z LLM w zadaniach fizycznie ugruntowanych” – wyjaśnił zespół w Referat naukowy. „LLM (Say) zapewnia ugruntowanie zadania w celu określenia przydatnych działań dla celu wysokiego poziomu, a wyuczone funkcje afordancji (Can) zapewniają ugruntowanie świata w celu określenia, co jest możliwe do wykonania zgodnie z planem. Używamy uczenia ze wzmocnieniem (RL) jako sposobu uczenia się funkcji wartości warunkowanych językiem, które zapewniają afordancje tego, co jest możliwe na świecie”.

Aby zapobiec zboczeniu robota z zadania, jest on przeszkolony do wybierania działań tylko ze 101 różnych instrukcji. Google wyszkoliło go, aby dostosować się do kuchni – PaLM-SayCan może dostawać przekąski, napoje i wykonywać proste prace porządkowe. Naukowcy są przekonani, że LLM są pierwszym krokiem do nakłonienia robotów do wykonywania bardziej złożonych zadań w bezpieczny sposób na podstawie abstrakcyjnych instrukcji.

„Nasze eksperymenty na wielu rzeczywistych zadaniach robotycznych wykazują zdolność planowania i wykonywania długich, abstrakcyjnych instrukcji w języku naturalnym z wysokim wskaźnikiem powodzenia. Wierzymy, że interpretowalność PaLM-SayCan pozwala na bezpieczną interakcję użytkownika z robotami w świecie rzeczywistym” – podsumowali. ®

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Rejestr

- zefirnet