W dynamicznym świecie streamingu Amazon Muzykakażde wyszukiwanie utworu, podcastu lub playlisty kryje w sobie historię, nastrój lub powódź emocji czekających na ujawnienie. Poszukiwania te służą jako brama do nowych odkryć, cennych doświadczeń i trwałych wspomnień. Pasek wyszukiwania nie służy tylko do wyszukiwania utworu; chodzi o miliony aktywnych użytkowników rozpoczynających osobistą podróż do bogatego i różnorodnego świata, jaki ma do zaoferowania Amazon Music.

Zapewnienie najwyższej jakości obsługi klienta w celu natychmiastowego znalezienia muzyki, której szukają użytkownicy, wymaga platformy, która jest zarówno inteligentna, jak i responsywna. Aby to osiągnąć, Amazon Music wykorzystuje moc sztucznej inteligencji. Jednak optymalizacja obsługi klienta przy jednoczesnym zarządzaniu kosztami szkolenia i wnioskowania na podstawie modeli sztucznej inteligencji, które obsługują funkcje paska wyszukiwania, takie jak sprawdzanie pisowni w czasie rzeczywistym i wyszukiwanie wektorów, jest trudne w godzinach szczytu.

Amazon Sage Maker zapewnia kompleksowy zestaw usług, które pozwalają Amazon Music budować, szkolić i wdrażać w chmurze AWS przy minimalnym wysiłku. Dbając o niezróżnicowane podnoszenie ciężkich przedmiotów, SageMaker pozwala skupić się na pracy nad modelami uczenia maszynowego (ML) i nie martwić się o takie rzeczy, jak infrastruktura. W ramach modelu współodpowiedzialności SageMaker dba o to, aby świadczone przez niego usługi były niezawodne, wydajne i skalowalne, a Ty masz pewność, że zastosowanie modeli ML najlepiej wykorzystuje możliwości, jakie zapewnia SageMaker.

W tym poście opisujemy podróż, którą Amazon Music podjęła w celu optymalizacji wydajności i kosztów przy użyciu oprogramowania SageMaker, NVIDIA Triton Inference Server i TensorRT. Zagłębiamy się w pokazanie, jak działa ten pozornie prosty, ale skomplikowany pasek wyszukiwania, zapewniający nieprzerwaną podróż do wszechświata Amazon Music z niewielkimi do zera frustrującymi opóźnieniami w przypadku literówek i trafnymi wynikami wyszukiwania w czasie rzeczywistym.

Amazon SageMaker i NVIDIA: Zapewniają szybkie i dokładne wyszukiwanie wektorów oraz sprawdzanie pisowni

Amazon Music oferuje obszerną bibliotekę zawierającą ponad 100 milionów utworów i miliony odcinków podcastów. Jednak znalezienie odpowiedniego utworu lub podcastu może być trudne, zwłaszcza jeśli nie znasz dokładnego tytułu, wykonawcy lub nazwy albumu albo wyszukiwane hasło jest bardzo szerokie, np. „podcasty informacyjne”.

Amazon Music przyjął dwutorowe podejście do usprawnienia procesu wyszukiwania i odzyskiwania. Pierwszym krokiem jest wprowadzenie wyszukiwania wektorowego (znanego również jako pobieranie oparte na osadzaniu) – techniki uczenia maszynowego, która może pomóc użytkownikom znaleźć najbardziej odpowiednią treść, której szukają, korzystając z semantyki treści. Drugi krok polega na wprowadzeniu do stosu wyszukiwania modelu korekcji pisowni opartej na transformatorze. Może to być szczególnie przydatne podczas wyszukiwania muzyki, ponieważ użytkownicy nie zawsze znają dokładną pisownię tytułu utworu lub nazwiska wykonawcy. Korekta pisowni może pomóc użytkownikom znaleźć muzykę, której szukają, nawet jeśli popełnią błąd ortograficzny w zapytaniu.

Wprowadzenie modeli Transformera do potoku wyszukiwania i pobierania (w generowaniu osadzania zapytań potrzebnych do wyszukiwania wektorowego i generatywnego modelu transformatora Seq2Seq w korekcji pisowni) może prowadzić do znacznego wzrostu ogólnego opóźnienia, co negatywnie wpływa na doświadczenie klienta. Dlatego też priorytetem stała się dla nas optymalizacja opóźnień wnioskowania w czasie rzeczywistym dla modeli wyszukiwania wektorowego i poprawiania pisowni.

Amazon Music i NVIDIA połączyły siły, aby zapewnić klientom możliwie najlepszą obsługę paska wyszukiwania, wykorzystując SageMaker do wdrożenia zarówno szybkich i dokładnych funkcji sprawdzania pisowni, jak i sugestii wyszukiwania semantycznego w czasie rzeczywistym przy użyciu technik opartych na wyszukiwaniu wektorowym. Rozwiązanie obejmuje korzystanie z hostingu SageMaker obsługiwanego przez instancje G5, które korzystają z procesorów graficznych NVIDIA A10G Tensor Core, kontenera serwera NVIDIA Triton Inference obsługiwanego przez SageMaker oraz NVIDIA TensorRT formacie modelu. Zmniejszając opóźnienie wnioskowania w modelu sprawdzania pisowni do 25 milisekund w godzinach szczytu oraz zmniejszając opóźnienie generowania wyszukiwanych haseł średnio o 63% i koszt o 73% w porównaniu z wnioskowaniem opartym na procesorze, Amazon Music zwiększyło wydajność paska wyszukiwania.

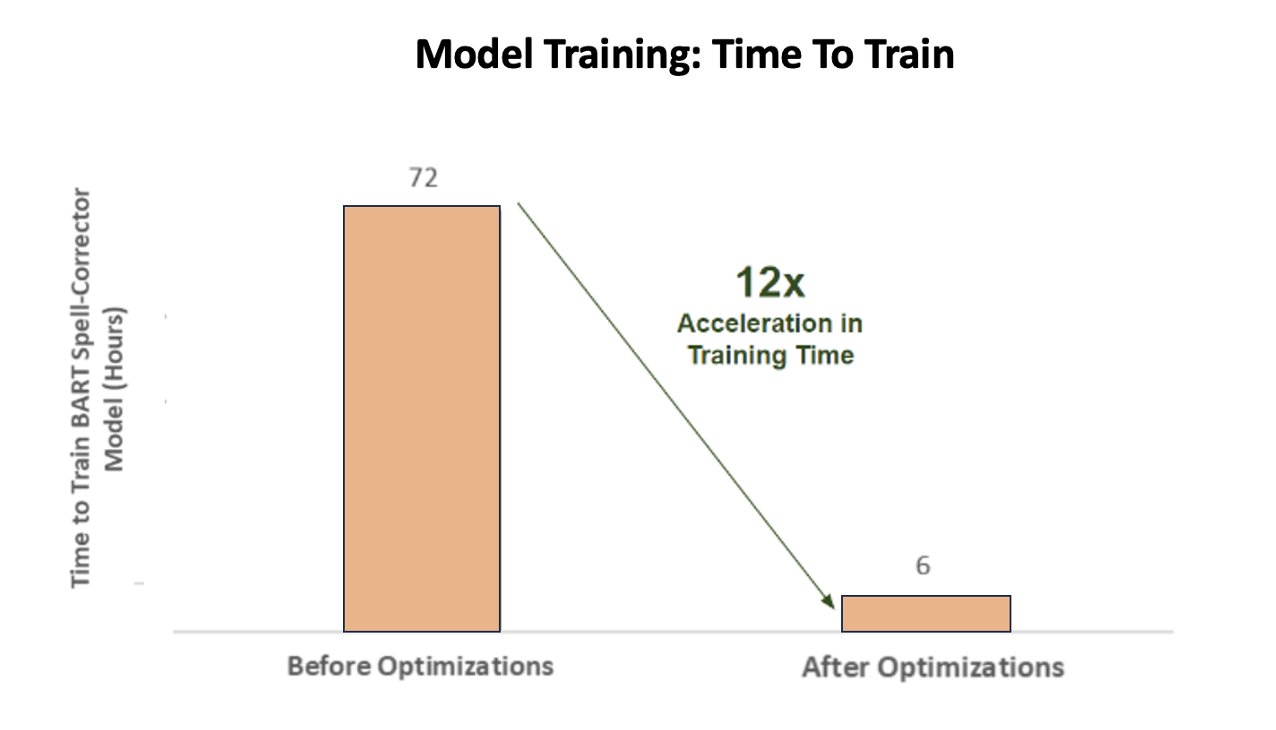

Dodatkowo, szkoląc model sztucznej inteligencji w celu zapewnienia dokładnych wyników, firma Amazon Music osiągnęła aż 12-krotne przyspieszenie czasu szkolenia swojego modelu transformatora korekcji pisowni BART sekwencja po sekwencji, oszczędzając czas i pieniądze poprzez optymalizację wykorzystania procesora graficznego.

Amazon Music nawiązał współpracę z firmą NVIDIA, aby nadać priorytet wyszukiwaniu klientów i stworzyć pasek wyszukiwania z dobrze zoptymalizowanymi funkcjami sprawdzania pisowni i wyszukiwania wektorowego. W kolejnych sekcjach dzielimy się więcej informacjami na temat sposobu, w jaki zaaranżowano te optymalizacje.

Optymalizacja treningu z procesorami graficznymi NVIDIA Tensor Core

Uzyskanie dostępu do procesora graficznego NVIDIA Tensor Core w celu szkolenia modeli w dużych językach nie wystarczy, aby uchwycić jego prawdziwy potencjał. Istnieją kluczowe kroki optymalizacyjne, które muszą zostać wykonane podczas treningu, aby w pełni zmaksymalizować wykorzystanie procesora graficznego. Jednak niewykorzystany procesor graficzny niewątpliwie doprowadzi do nieefektywnego wykorzystania zasobów, wydłużenia czasu trwania szkoleń i zwiększonych kosztów operacyjnych.

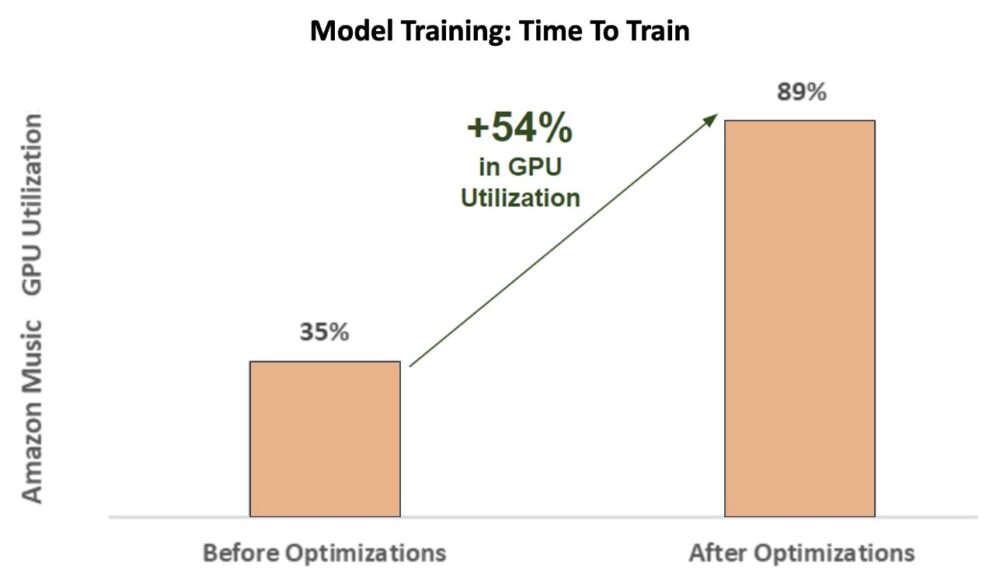

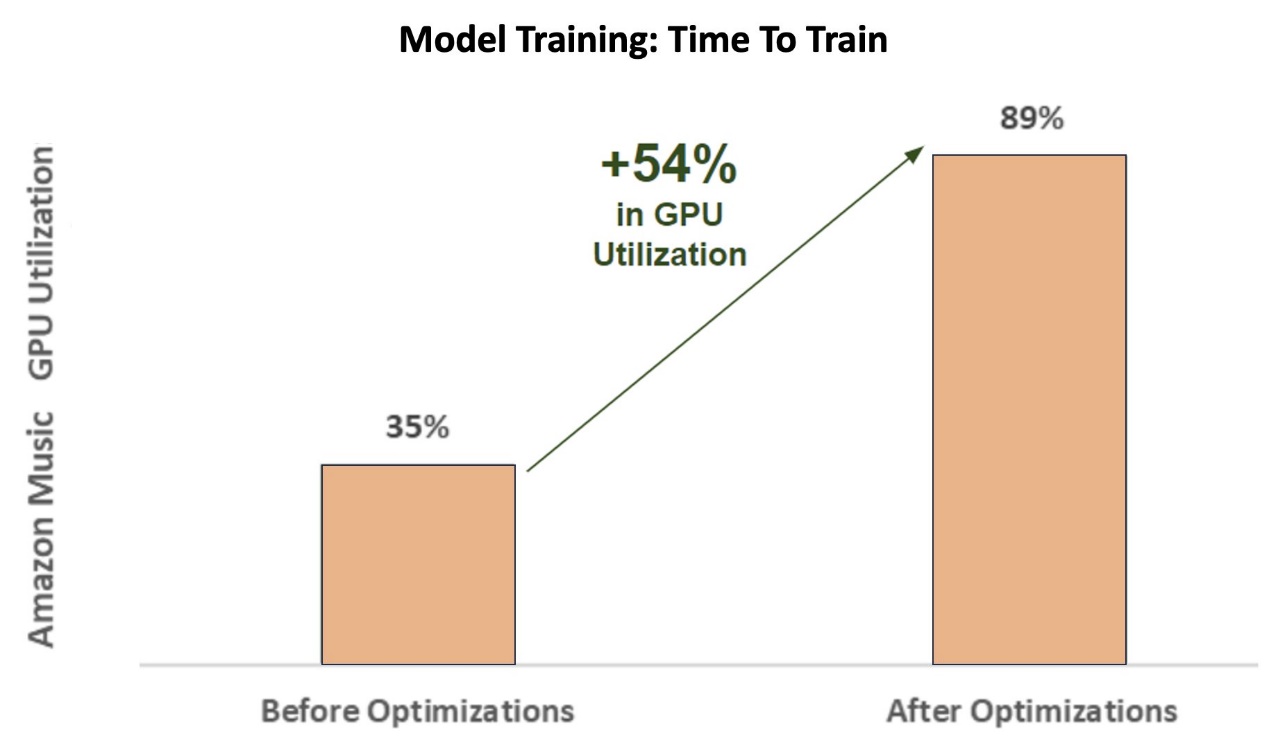

W początkowej fazie szkolenia korektor pisowni BART (baza barta) model transformatora na instancji SageMaker ml.p3.24xlarge (8 procesorów graficznych NVIDIA V100 Tensor Core), wykorzystanie procesora graficznego Amazon Music wyniosło około 35%. Aby zmaksymalizować korzyści płynące ze szkoleń akcelerowanych przez procesor graficzny NVIDIA, architekci rozwiązań AWS i NVIDIA wspierali firmę Amazon Music w identyfikowaniu obszarów wymagających optymalizacji, szczególnie w zakresie wielkości partii i parametrów precyzji. Te dwa kluczowe parametry wpływają na efektywność, szybkość i dokładność uczenia modeli głębokiego uczenia się.

Wynikające z tego optymalizacje zaowocowały nowym, ulepszonym wykorzystaniem procesora graficznego V100, utrzymującym się na stałym poziomie około 89%, drastycznie skracając czas szkolenia Amazon Music z 3 dni do 5–6 godzin. Zmieniając wielkość partii z 32 na 256 i stosując techniki optymalizacji, takie jak uruchamianie automatyczny trening o mieszanej precyzji zamiast korzystać wyłącznie z precyzji FP32, firma Amazon Music była w stanie zaoszczędzić zarówno czas, jak i pieniądze.

Poniższy wykres ilustruje wzrost wykorzystania procesora graficznego o 54% po optymalizacji.

Poniższy rysunek ilustruje przyspieszenie czasu treningu.

To zwiększenie rozmiaru partii umożliwiło procesorowi graficznemu NVIDIA przetwarzanie znacznie większej liczby danych jednocześnie na wielu rdzeniach Tensor, co skutkowało przyspieszeniem czasu szkolenia. Ważne jest jednak zachowanie delikatnej równowagi z pamięcią, ponieważ większe partie wymagają większej ilości pamięci. Zarówno zwiększenie rozmiaru partii, jak i zastosowanie mieszanej precyzji może mieć kluczowe znaczenie w uwolnieniu mocy procesorów graficznych NVIDIA Tensor Core.

Po wyszkoleniu modelu pod kątem konwergencji przyszedł czas na optymalizację pod kątem wdrożenia wnioskowania na pasku wyszukiwania Amazon Music.

Korekta pisowni: wnioskowanie z modelu BART

Dzięki instancjom SageMaker G5 i NVIDIA Triton Inference Server (oprogramowaniu obsługującemu wnioskowanie typu open source), a także NVIDIA TensorRT, pakietowi SDK do wysokowydajnego wnioskowania głębokiego uczenia się, który obejmuje optymalizator wnioskowania i czas działania, Amazon Music ogranicza sprawdzanie pisowni BART (baza barta) modeluje opóźnienie wnioskowania serwera do zaledwie 25 milisekund przy szczytowym ruchu. Obejmuje to koszty ogólne, takie jak równoważenie obciążenia, przetwarzanie wstępne, wnioskowanie o modelu i czas przetwarzania końcowego.

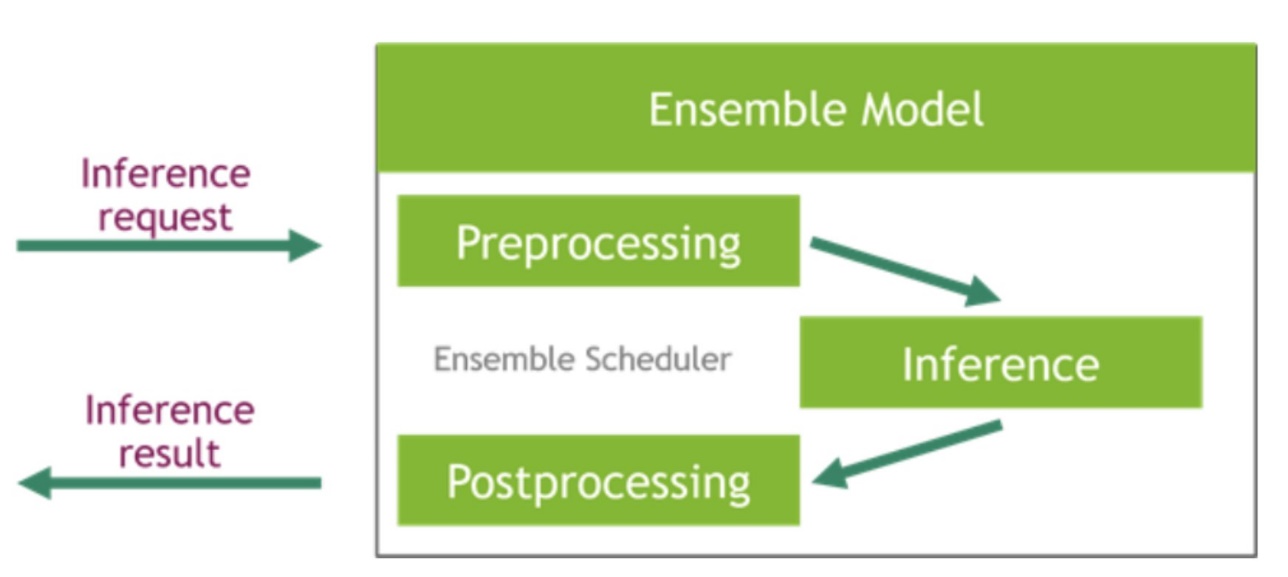

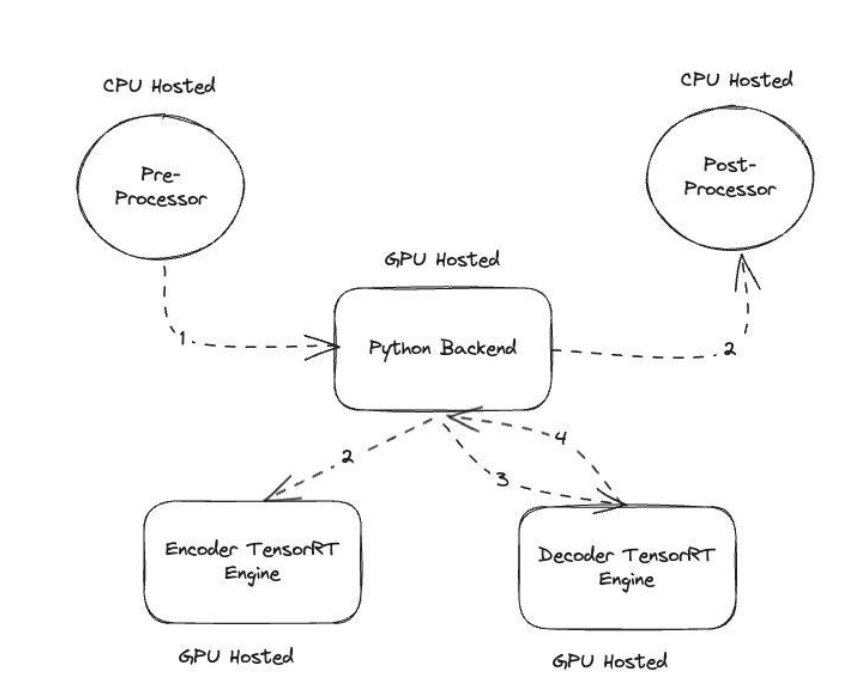

Serwer wnioskowania NVIDIA Triton udostępnia dwa różne rodzaje backendów: jeden do hostowania modeli na GPU oraz backend w języku Python, w którym możesz wprowadzić własny, niestandardowy kod do wykorzystania na etapach przetwarzania wstępnego i końcowego. Poniższy rysunek ilustruje schemat zespołu modelowego.

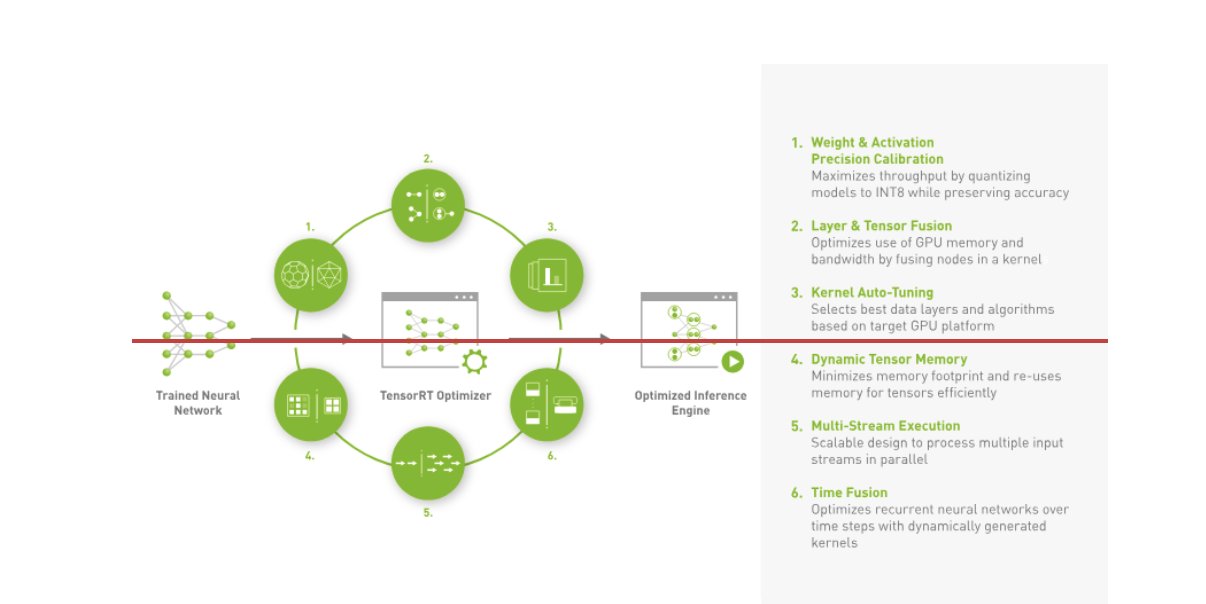

Amazon Music zbudował swój BART potok wnioskowania uruchamiając zarówno etapy przetwarzania wstępnego (tokenizacja tekstu), jak i przetwarzania końcowego (tokeny na tekst) na procesorach, podczas gdy etap wykonywania modelu działa na Procesory graficzne NVIDIA A10G Tensor Core. Backend Pythona znajduje się pośrodku etapów przetwarzania wstępnego i końcowego i jest odpowiedzialny za komunikację z modelami BART przekonwertowanymi za pomocą TensorRT, a także sieciami koderów/dekoderów. TensorRT zwiększa wydajność wnioskowania dzięki precyzyjnej kalibracji, fuzji warstw i tensorów, automatycznemu dostrajaniu jądra, dynamicznej pamięci tensora, wykonywaniu wielu strumieni i fuzji czasu.

Poniższy rysunek ilustruje projekt wysokiego poziomu kluczowych modułów tworzących potok wnioskowania modelu korektora pisowni BART.

Wyszukiwanie wektorów: Zapytanie osadzające generowanie zdania, wnioskowanie o modelu BERT

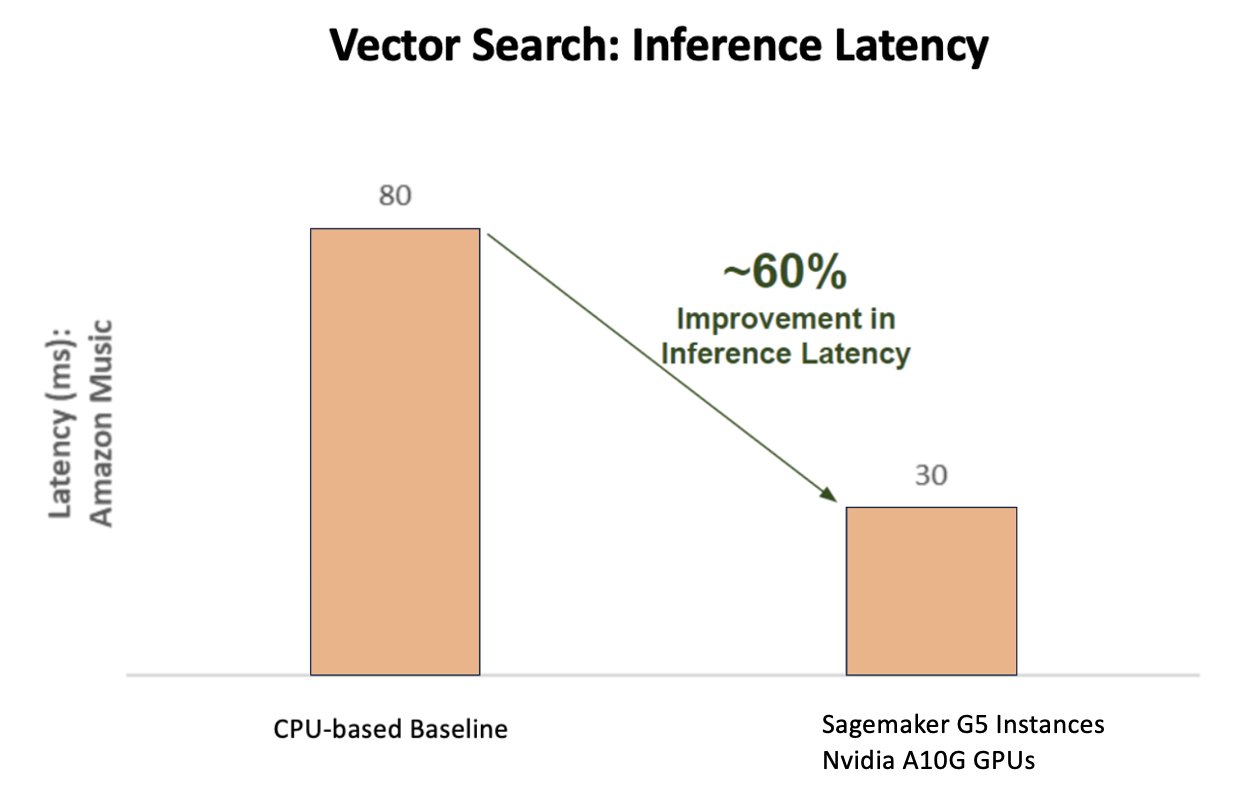

Poniższy wykres ilustruje 60% poprawę opóźnień (obsługując p90 800–900 TPS) podczas korzystania z platformy NVIDIA AI Inference Platform w porównaniu z bazową wersją opartą na procesorze.

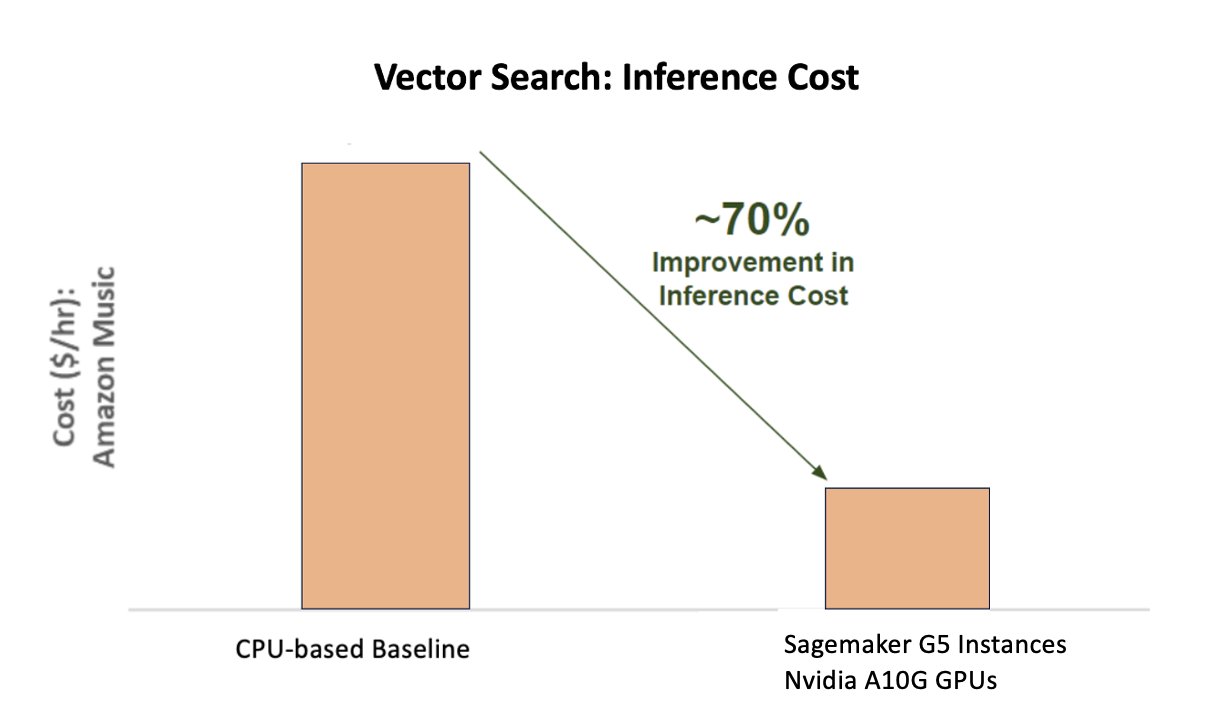

Poniższy wykres pokazuje 70% poprawę kosztów w przypadku korzystania z platformy NVIDIA AI Inference Platform w porównaniu z bazową wersją opartą na procesorze.

Poniższy rysunek ilustruje zestaw SDK do wysokowydajnego wnioskowania głębokiego uczenia się. Zawiera optymalizator wnioskowania głębokiego uczenia się i środowisko wykonawcze, które zapewnia niskie opóźnienia i wysoką przepustowość dla aplikacji wnioskowania.

Aby osiągnąć te wyniki, firma Amazon Music eksperymentowała z kilkoma różnymi parametrami wdrożenia Triton Analizator modelu Tritona, narzędzie pomagające znaleźć najlepszą konfigurację modelu NVIDIA Triton w celu wdrożenia wydajnego wnioskowania. Aby zoptymalizować wnioskowanie o modelu, Triton oferuje funkcje takie jak dynamiczne przetwarzanie wsadowe i współbieżne wykonywanie modelu, a także obsługuje platformę zapewniającą inne możliwości elastyczności. Dynamiczne grupowanie gromadzi żądania wnioskowania, płynnie grupując je w kohorty w celu maksymalizacji przepustowości, a wszystko to przy jednoczesnym zapewnieniu odpowiedzi w czasie rzeczywistym dla użytkowników Amazon Music. Możliwość jednoczesnego wykonywania modelu dodatkowo zwiększa wydajność wnioskowania poprzez hostowanie wielu kopii modelu na tym samym procesorze graficznym. Wreszcie, wykorzystując Analizator modelu Tritona, Amazon Music był w stanie dokładnie dostroić parametry dynamicznego przetwarzania wsadowego i hostowania wnioskowania o współbieżności modelu, aby znaleźć optymalne ustawienia, które maksymalizują wydajność wnioskowania przy użyciu symulowanego ruchu.

Wnioski

Optymalizacja konfiguracji z Triton Inference Server i TensorRT w SageMaker pozwoliła firmie Amazon Music osiągnąć znakomite wyniki zarówno w przypadku potoków szkoleniowych, jak i wnioskowania. Platforma SageMaker to kompleksowa, otwarta platforma dla produkcyjnej sztucznej inteligencji, zapewniająca szybki czas uzyskania korzyści i wszechstronność niezbędną do obsługi wszystkich głównych przypadków użycia sztucznej inteligencji, zarówno na sprzęcie, jak i oprogramowaniu. Optymalizując wykorzystanie procesora graficznego V100 do celów szkoleniowych i przełączając się z procesorów na instancje G5 przy użyciu procesorów graficznych NVIDIA A10G Tensor Core, a także korzystając ze zoptymalizowanego oprogramowania NVIDIA, takiego jak Triton Inference Server i TensorRT, firmy takie jak Amazon Music mogą zaoszczędzić czas i pieniądze, jednocześnie zwiększając wydajność w obu szkolenia i wnioskowanie, co bezpośrednio przekłada się na lepsze doświadczenia klientów i niższe koszty operacyjne.

SageMaker obsługuje niezróżnicowane ciężkie prace związane ze szkoleniem i hostingiem ML, dzięki czemu Amazon Music zapewnia niezawodne, skalowalne operacje ML zarówno na sprzęcie, jak i oprogramowaniu.

Zachęcamy do sprawdzania, czy obciążenia są zoptymalizowane przy użyciu programu SageMaker, poprzez każdorazową ocenę wybranego sprzętu i oprogramowania w celu sprawdzenia, czy istnieją sposoby na osiągnięcie lepszej wydajności przy niższych kosztach.

Aby dowiedzieć się więcej na temat sztucznej inteligencji NVIDIA w AWS, zapoznaj się z poniższymi informacjami:

O autorach

Siddhartha Sharmy jest liderem technologii uczenia maszynowego w zespole Science & Modeling w Amazon Music. Specjalizuje się w problematyce związanej z wyszukiwaniem, pobieraniem, rankingiem i modelowaniem związanym z NLP. Siddharth ma bogate doświadczenie w pracy nad problemami uczenia maszynowego na dużą skalę, które są wrażliwe na opóźnienia, np. kierowanie reklam, pobieranie wielomodalne, zrozumienie zapytań wyszukiwania itp. Przed pracą w Amazon Music Siddharth pracował w takich firmach jak Meta, Walmart Labs, Rakuten na temat problemów ML skoncentrowanych na handlu elektronicznym. Siddharth spędził pierwszą część swojej kariery pracując dla start-upów zajmujących się technologią reklamową w Bay Area.

Siddhartha Sharmy jest liderem technologii uczenia maszynowego w zespole Science & Modeling w Amazon Music. Specjalizuje się w problematyce związanej z wyszukiwaniem, pobieraniem, rankingiem i modelowaniem związanym z NLP. Siddharth ma bogate doświadczenie w pracy nad problemami uczenia maszynowego na dużą skalę, które są wrażliwe na opóźnienia, np. kierowanie reklam, pobieranie wielomodalne, zrozumienie zapytań wyszukiwania itp. Przed pracą w Amazon Music Siddharth pracował w takich firmach jak Meta, Walmart Labs, Rakuten na temat problemów ML skoncentrowanych na handlu elektronicznym. Siddharth spędził pierwszą część swojej kariery pracując dla start-upów zajmujących się technologią reklamową w Bay Area.

Tarun Sharma jest menedżerem ds. rozwoju oprogramowania, wiodącym w zakresie trafności wyszukiwania muzyki w serwisie Amazon. Jego zespół naukowców i inżynierów ML jest odpowiedzialny za dostarczanie trafnych kontekstowo i spersonalizowanych wyników wyszukiwania klientom Amazon Music.

Tarun Sharma jest menedżerem ds. rozwoju oprogramowania, wiodącym w zakresie trafności wyszukiwania muzyki w serwisie Amazon. Jego zespół naukowców i inżynierów ML jest odpowiedzialny za dostarczanie trafnych kontekstowo i spersonalizowanych wyników wyszukiwania klientom Amazon Music.

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi poznawać nowe kultury, nowe doświadczenia i być na bieżąco z najnowszymi trendami technologicznymi. Możesz go znaleźć na LinkedIn.

James Park jest architektem rozwiązań w Amazon Web Services. Współpracuje z Amazon.com przy projektowaniu, budowaniu i wdrażaniu rozwiązań technologicznych w AWS, a szczególnie interesuje się sztuczną inteligencją i uczeniem maszynowym. W wolnym czasie lubi poznawać nowe kultury, nowe doświadczenia i być na bieżąco z najnowszymi trendami technologicznymi. Możesz go znaleźć na LinkedIn.

Kszitiz Gupta jest architektem rozwiązań w firmie NVIDIA. Lubi edukować klientów korzystających z chmury na temat technologii GPU AI, które firma NVIDIA ma do zaoferowania, i pomagać im w przyspieszaniu ich aplikacji do uczenia maszynowego i uczenia głębokiego. Poza pracą lubi biegać, wędrować i obserwować dziką przyrodę.

Kszitiz Gupta jest architektem rozwiązań w firmie NVIDIA. Lubi edukować klientów korzystających z chmury na temat technologii GPU AI, które firma NVIDIA ma do zaoferowania, i pomagać im w przyspieszaniu ich aplikacji do uczenia maszynowego i uczenia głębokiego. Poza pracą lubi biegać, wędrować i obserwować dziką przyrodę.

Jiahong Liu jest architektem rozwiązań w zespole Cloud Service Provider firmy NVIDIA. Pomaga klientom we wdrażaniu rozwiązań uczenia maszynowego i sztucznej inteligencji, które wykorzystują akcelerowane obliczenia NVIDIA, aby sprostać wyzwaniom związanym ze szkoleniem i wnioskowaniem. W wolnym czasie lubi origami, projekty DIY i grę w koszykówkę.

Jiahong Liu jest architektem rozwiązań w zespole Cloud Service Provider firmy NVIDIA. Pomaga klientom we wdrażaniu rozwiązań uczenia maszynowego i sztucznej inteligencji, które wykorzystują akcelerowane obliczenia NVIDIA, aby sprostać wyzwaniom związanym ze szkoleniem i wnioskowaniem. W wolnym czasie lubi origami, projekty DIY i grę w koszykówkę.

Tugrul Konuk jest starszym architektem rozwiązań w firmie NVIDIA, specjalizującym się w szkoleniach na dużą skalę, multimodalnym głębokim uczeniu się i wysokowydajnych obliczeniach naukowych. Przed dołączeniem do firmy NVIDIA pracował w branży energetycznej, koncentrując się na opracowywaniu algorytmów do obrazowania obliczeniowego. W ramach doktoratu zajmował się głębokim uczeniem się opartym na fizyce na potrzeby symulacji numerycznych na dużą skalę. W wolnym czasie czyta, gra na gitarze i pianinie.

Tugrul Konuk jest starszym architektem rozwiązań w firmie NVIDIA, specjalizującym się w szkoleniach na dużą skalę, multimodalnym głębokim uczeniu się i wysokowydajnych obliczeniach naukowych. Przed dołączeniem do firmy NVIDIA pracował w branży energetycznej, koncentrując się na opracowywaniu algorytmów do obrazowania obliczeniowego. W ramach doktoratu zajmował się głębokim uczeniem się opartym na fizyce na potrzeby symulacji numerycznych na dużą skalę. W wolnym czasie czyta, gra na gitarze i pianinie.

Rohila Bhargawę jest menedżerem ds. marketingu produktów w firmie NVIDIA, zajmującym się wdrażaniem frameworków aplikacji NVIDIA i pakietów SDK na określonych platformach CSP.

Rohila Bhargawę jest menedżerem ds. marketingu produktów w firmie NVIDIA, zajmującym się wdrażaniem frameworków aplikacji NVIDIA i pakietów SDK na określonych platformach CSP.

Eliutha Triany Isazy jest menedżerem ds. relacji z programistami w firmie NVIDIA, który umożliwia specjalistom ds. rozwiązań AI MLOps, DevOps, naukowcom i ekspertom technicznym AWS firmy Amazon w opanowaniu stosu obliczeniowego NVIDIA w celu przyspieszania i optymalizacji modeli generatywnej AI Foundation, obejmujących przechowywanie danych, szkolenie GPU, wnioskowanie o modelach i wdrażanie produkcyjne na instancjach GPU AWS . Ponadto Eliuth jest zapalonym kolarzem górskim, narciarzem, tenisistą i pokerzystą.

Eliutha Triany Isazy jest menedżerem ds. relacji z programistami w firmie NVIDIA, który umożliwia specjalistom ds. rozwiązań AI MLOps, DevOps, naukowcom i ekspertom technicznym AWS firmy Amazon w opanowaniu stosu obliczeniowego NVIDIA w celu przyspieszania i optymalizacji modeli generatywnej AI Foundation, obejmujących przechowywanie danych, szkolenie GPU, wnioskowanie o modelach i wdrażanie produkcyjne na instancjach GPU AWS . Ponadto Eliuth jest zapalonym kolarzem górskim, narciarzem, tenisistą i pokerzystą.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Zdolny

- O nas

- przyśpieszony

- przyspieszenie

- przyśpieszenie

- dostęp

- wykonać

- precyzja

- dokładny

- Osiągać

- osiągnięty

- w poprzek

- aktywny

- dodatek

- adres

- Przyjęcie

- Reklamy

- wpływający

- Po

- AI

- Modele AI

- przypadki użycia ai

- Album

- Algorytmy

- Wszystkie kategorie

- dopuszczać

- dozwolony

- Pozwalać

- pozwala

- również

- zawsze

- Amazonka

- Amazon Web Services

- Amazon.com

- an

- i

- Zastosowanie

- aplikacje

- podejście

- architekci

- SĄ

- POWIERZCHNIA

- obszary

- na około

- artysta

- AS

- pomoc

- pomaga

- At

- średni

- AWS

- Backend

- Bilans

- równoważenie

- bar

- na podstawie

- Baseline

- Koszykówka

- Zatoka

- BE

- stał

- bo

- Korzyści

- BEST

- Ulepsz Swój

- pobudzanie

- zwiększa

- obie

- przynieść

- szeroki

- budować

- wybudowany

- by

- CAN

- możliwości

- zdolność

- zdobyć

- który

- Kariera

- ostrożnie

- Etui

- wyzwania

- wyzwanie

- Wykres

- ZOBACZ

- ceniony

- wybory

- klientów

- Chmura

- kod

- COM

- jak

- przyległy

- Firmy

- w porównaniu

- obliczeniowy

- computing

- równoległy

- systemu

- Pojemnik

- zawartość

- Konwergencja

- rdzeń

- Koszty:

- Koszty:

- rzemiosło

- krytyczny

- istotny

- CSP

- kuracja

- zwyczaj

- klient

- doświadczenie klienta

- Klientów

- dane

- Data

- Dni

- zmniejszony

- głęboko

- głęboka nauka

- opóźnienia

- dostarczyć

- dostarczanie

- dostarcza

- Kreowanie

- rozwijać

- wdrażanie

- Wdrożenie

- Wnętrze

- Deweloper

- rozwijanie

- oprogramowania

- różne

- trudny

- bezpośrednio

- nurkować

- inny

- DIY

- nie

- drastycznie

- podczas

- dynamiczny

- e

- e-commerce

- Wcześnie

- edukowanie

- efektywność

- wydajny

- wysiłek

- podniesiony

- osadzanie

- emocje

- zatrudniający

- uprawniającej

- włączony

- zachęcać

- koniec końców

- energia

- Inżynierowie

- Poprawia

- dość

- zapewnienie

- szczególnie

- itp

- oceny

- Parzyste

- Każdy

- egzekucja

- doświadczenie

- Doświadczenia

- eksperci

- FAST

- Korzyści

- Postać

- W końcu

- Znajdź

- znalezieniu

- i terminów, a

- Elastyczność

- powódź

- Skupiać

- koncentruje

- skupienie

- następujący

- W razie zamówieenia projektu

- format

- Fundacja

- Framework

- Ramy

- od

- frustrujące

- w pełni

- funkcjonalności

- dalej

- fuzja

- Bramka

- generacja

- generatywny

- generatywna sztuczna inteligencja

- GPU

- GPU

- Uchwyty

- zdarzyć

- sprzęt komputerowy

- Have

- he

- ciężki

- ciężkie podnoszenie

- pomoc

- pomocny

- pomaga

- Wysoki

- na wysokim szczeblu

- wysoka wydajność

- go

- jego

- posiada

- Hosting

- GODZINY

- W jaki sposób

- Jednak

- HTML

- HTTPS

- identyfikacja

- if

- ilustruje

- Obrazowanie

- wdrożenia

- ważny

- podnieść

- ulepszony

- poprawa

- in

- obejmuje

- Zwiększać

- wzrosła

- wzrastający

- przemysł

- niewydajny

- wpływ

- Infrastruktura

- początkowy

- przykład

- natychmiast

- zamiast

- odsetki

- najnowszych

- przedstawiać

- wprowadzenie

- IT

- JEGO

- podróż

- jpg

- właśnie

- Klawisz

- Uprzejmy

- Wiedzieć

- znany

- Labs

- język

- duży

- na dużą skalę

- większe

- trwały

- Utajenie

- firmy

- warstwa

- prowadzić

- prowadzący

- UCZYĆ SIĘ

- nauka

- Dźwignia

- Biblioteka

- Modernizacja

- lubić

- Limity

- załadować

- poszukuje

- niski

- niższy

- maszyna

- uczenie maszynowe

- utrzymać

- poważny

- robić

- WYKONUJE

- kierownik

- zarządzający

- Marketing

- mistrz

- Maksymalizuj

- Może..

- wspomnienia

- Pamięć

- Meta

- Środkowy

- milion

- miliony

- milisekund

- minimalny

- błąd

- mieszany

- ML

- MLOps

- model

- modelowanie

- modele

- Moduły

- pieniądze

- jeszcze

- większość

- Góra

- wielo

- wielokrotność

- Muzyka

- musi

- Nazwa

- potrzebne

- ujemnie

- sieci

- Nowości

- nlp

- Nvidia

- of

- oferta

- Oferty

- on

- ONE

- tylko

- koncepcja

- open source

- operacyjny

- operacyjny

- operacje

- Optymalny

- optymalizacja

- Optymalizacja

- zoptymalizowane

- optymalizacji

- or

- orkiestrowany

- zamówienie

- Inne

- na zewnątrz

- zewnętrzne

- wybitny

- koniec

- ogólny

- własny

- parametry

- część

- szczególny

- szczególnie

- partner

- namiętny

- Szczyt

- procent

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- osobisty

- Personalizowany

- PhD

- rurociąg

- Platforma

- Platformy

- plato

- Analiza danych Platona

- PlatoDane

- gracz

- gra

- Podcast

- Podcasty

- punkt

- poker

- możliwy

- Post

- potencjał

- power

- powered

- Detaliczność

- Wcześniejszy

- Priorytet

- priorytet

- problemy

- wygląda tak

- Produkt

- Produkcja

- projektowanie

- zapewniać

- dostawca

- zapewnia

- że

- Python

- Szybki

- Ranking

- Czytający

- w czasie rzeczywistym

- redukcja

- odnosić się

- związane z

- relacje

- mających znaczenie

- rzetelny

- wywołań

- Wymaga

- Zasoby

- Odpowiedzi

- odpowiedzialność

- odpowiedzialny

- czuły

- wynikły

- Efekt

- Bogaty

- prawo

- bieganie

- działa

- Czas

- sagemaker

- taki sam

- Zapisz

- oszczędność

- skalowalny

- Skala

- nauka

- naukowy

- Naukowcy

- Sdk

- SDKS

- płynnie

- Szukaj

- wyszukiwania

- poszukiwania

- druga

- działy

- widzieć

- poszukuje

- pozornie

- semantyka

- senior

- wrażliwy

- wyrok

- służyć

- serwer

- usługa

- Usługodawca

- Usługi

- służąc

- zestaw

- w panelu ustawień

- kilka

- Share

- shared

- Targi

- znaczący

- znacznie

- Prosty

- siada

- Rozmiar

- rozmiary

- mądry

- Tworzenie

- rozwoju oprogramowania

- rozwiązanie

- Rozwiązania

- piosenka

- Źródło

- napięcie

- specjalizuje się

- specjalizujący się

- specyficzny

- prędkość

- Zaklęcie

- pisownia

- spędził

- stos

- Startowy

- Startups

- przebywający

- stały

- Ewolucja krok po kroku

- Cel

- Historia

- Streaming

- taki

- przełożony

- wsparcie

- Utrzymany

- pewnie

- Zadania

- biorąc

- kierowania

- zespół

- tech

- Techniczny

- technika

- Techniki

- Technologies

- Technologia

- XNUMX

- że

- Połączenia

- ich

- Im

- Tam.

- w związku z tym

- Te

- one

- rzeczy

- to

- Przez

- wydajność

- czas

- czasy

- Tytuł

- do

- razem

- tokenizacja

- Żetony

- wziął

- narzędzie

- Top

- Tps

- ruch drogowy

- Pociąg

- przeszkolony

- Trening

- transformator

- Trendy

- Tryton

- prawdziwy

- drugiej

- zrozumienie

- niewątpliwie

- Wszechświat

- odblokowywanie

- odsłonięty

- us

- posługiwać się

- używany

- Użytkownicy

- zastosowania

- za pomocą

- Wykorzystując

- wartość

- Naprawiono

- wszechstronność

- początku.

- Czekanie

- spacer

- Walmart

- była

- oglądania

- sposoby

- we

- sieć

- usługi internetowe

- DOBRZE

- były

- jeśli chodzi o komunikację i motywację

- natomiast

- Podczas

- będzie

- w

- Praca

- pracował

- pracujący

- działa

- świat

- martwić się

- jeszcze

- wydany

- You

- Twój

- zefirnet