Ten post został napisany wspólnie przez Christophera Diaza, Sama Kinarda, Jaime Hidalgo i Daniela Suareza z CCC Intelligent Solutions.

W tym poście omawiamy, jak to zrobić Inteligentne rozwiązania CCC (CCC) łącznie Amazon Sage Maker z innymi usługami AWS w celu stworzenia niestandardowego rozwiązania zdolnego do obsługi przewidywanych rodzajów złożonych modeli sztucznej inteligencji (AI). CCC jest wiodącą platformą typu oprogramowanie jako usługa (SaaS) dla wartej wiele bilionów dolarów ekonomii ubezpieczeń majątkowych i wypadkowych, wspierającą operacje ubezpieczycieli, warsztatów, producentów samochodów, dostawców części, pożyczkodawców i nie tylko. Technologia chmurowa CCC łączy ponad 30,000 XNUMX firm, cyfryzując przepływy pracy o znaczeniu krytycznym, handel i doświadczenia klientów. Jako zaufany lider w dziedzinie sztucznej inteligencji, Internetu rzeczy (IoT), obsługi klienta oraz zarządzania siecią i przepływem pracy, CCC dostarcza innowacje, które sprawiają, że życie ludzi idzie do przodu, gdy ma to największe znaczenie.

Wyzwanie

CCC przetwarza rocznie ponad 1 bilion dolarów transakcji związanych z roszczeniami. Ponieważ firma stale ewoluuje, aby zintegrować sztuczną inteligencję z istniejącym i nowym katalogiem produktów, wymaga to wyrafinowanego podejścia do szkolenia i wdrażania wielomodalnych modeli uczenia maszynowego (ML) w celu rozwiązywania złożonych potrzeb biznesowych. Jest to klasa modeli, które obejmują zastrzeżone algorytmy i specjalistyczną wiedzę w danej dziedzinie, którą CCC doskonaliło przez lata. Modele te powinny być w stanie pozyskiwać nowe warstwy szczegółowych danych i reguł klientów w celu tworzenia pojedynczych wyników prognozy. W tym poście na blogu dowiemy się, w jaki sposób CCC wykorzystało hosting Amazon SageMaker i inne usługi AWS do wdrożenia lub hostowania wielu modeli multimodalnych w potoku wnioskowania zespołowego.

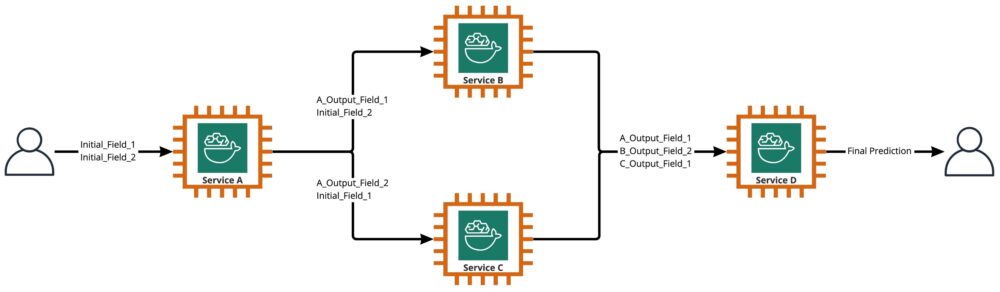

Jak pokazano na poniższym diagramie, zespół jest zbiorem dwóch lub więcej modeli, które są ustawione tak, aby działały w sposób liniowy lub nieliniowy w celu uzyskania pojedynczej prognozy. Po zestawieniu liniowym poszczególne modele zespołu mogą być bezpośrednio przywoływane w celu prognozowania, a następnie konsolidowane w celu ujednolicenia. Czasami modele zespołowe można również zaimplementować jako szeregowy potok wnioskowania.

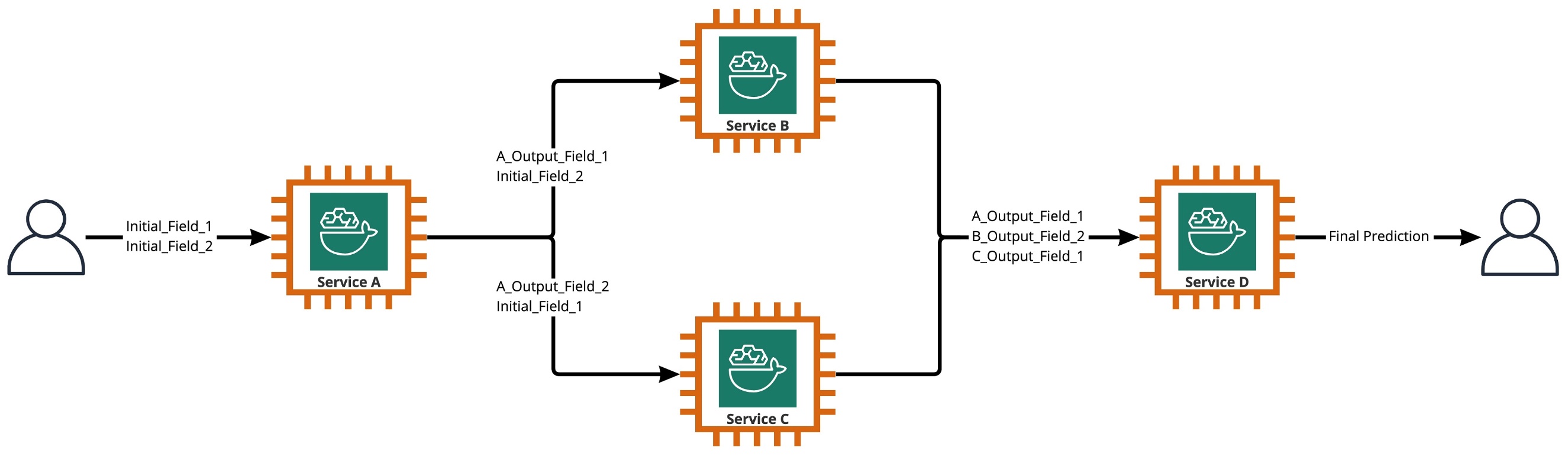

W naszym przypadku potok zespołowy jest ściśle nieliniowy, jak pokazano na poniższym diagramie. Nieliniowe potoki zespołowe są teoretycznie bezpośrednio acyklicznymi grafami (DAG). W naszym przypadku ten potok DAG miał zarówno niezależne modele, które są uruchamiane równolegle (usługi B, C), jak i inne modele, które wykorzystują prognozy z poprzednich kroków (usługa D).

Praktyką, która wynika z kultury badawczej w CCC, jest ciągły przegląd technologii, które można wykorzystać w celu zwiększenia wartości dla klientów. Gdy CCC stanęło przed tym wyzwaniem zespołowym, kierownictwo uruchomiło inicjatywę weryfikacji koncepcji (POC), aby dokładnie ocenić ofertę AWS, aby odkryć, w szczególności, czy Amazon SageMaker i inne narzędzia AWS mogą zarządzać hostingiem poszczególnych modeli AI w złożonych, nieliniowych zespoły.

Zespół wyjaśnił: W tym kontekście zespół to grupa 2 lub więcej modeli AI, które współpracują ze sobą w celu uzyskania 1 ogólnej prognozy.

Pytania napędzające badania

Czy Amazon SageMaker może być używany do hostowania złożonych zespołów modeli AI, które współpracują ze sobą, aby zapewnić jedną ogólną prognozę? Jeśli tak, czy SageMaker może oferować inne korzyści, takie jak zwiększona automatyzacja, niezawodność, monitorowanie, automatyczne skalowanie i środki oszczędnościowe?

Znalezienie alternatywnych sposobów wdrażania modeli AI CCC z wykorzystaniem postępu technologicznego dostawców usług w chmurze pozwoli CCC na szybsze wprowadzanie rozwiązań AI na rynek niż konkurencja. Ponadto posiadanie więcej niż jednej architektury wdrażania zapewnia elastyczność w znajdowaniu równowagi między kosztami a wydajnością w oparciu o priorytety biznesowe.

W oparciu o nasze wymagania sfinalizowaliśmy następującą listę funkcji jako listę kontrolną dla architektury wdrożeniowej klasy produkcyjnej:

- Wsparcie dla złożonych zespołów

- Gwarantowany czas pracy wszystkich komponentów

- Konfigurowalne automatyczne skalowanie dla wdrożonych modeli AI

- Zachowanie danych wejściowych i wyjściowych modelu AI

- Metryki i dzienniki użytkowania dla wszystkich składników

- Mechanizmy oszczędnościowe

Ponieważ większość rozwiązań AI firmy CCC opiera się na komputerowych modelach wizyjnych, wymagana była nowa architektura do obsługi plików obrazów i wideo, których rozdzielczość stale rośnie. Istniała silna potrzeba zaprojektowania i wdrożenia tej architektury jako modelu asynchronicznego.

Po cyklach badań i wstępnych testach porównawczych firma CCC stwierdziła, że SageMaker idealnie pasuje do większości wymagań produkcyjnych, zwłaszcza jeśli chodzi o gwarantowany czas pracy, jaki zapewnia SageMaker dla większości komponentów wnioskowania. Domyślna funkcja punktów końcowych Amazon SageMaker Asynchronous Inference zapisywania danych wejściowych/wyjściowych w Amazon S3 upraszcza zadanie zachowania danych generowanych ze złożonych zespołów. Ponadto, ponieważ każdy model AI jest hostowany przez własny punkt końcowy, zarządzanie zasadami automatycznego skalowania na poziomie modelu lub punktu końcowego staje się łatwiejsze. Dzięki uproszczeniu zarządzania potencjalną oszczędnością kosztów jest to, że zespoły deweloperskie mogą przeznaczyć więcej czasu na dostrajanie zasad skalowania, aby zminimalizować nadmierne przydzielanie zasobów obliczeniowych.

Decydując się na wykorzystanie SageMaker jako kluczowego komponentu architektury, zdaliśmy sobie również sprawę, że SageMaker może być częścią jeszcze większej architektury, uzupełnionej o wiele innych bezserwerowych usług zarządzanych przez AWS. Ten wybór był potrzebny, aby ułatwić orkiestrację wyższego rzędu i potrzeby obserwowalności tej złożonej architektury.

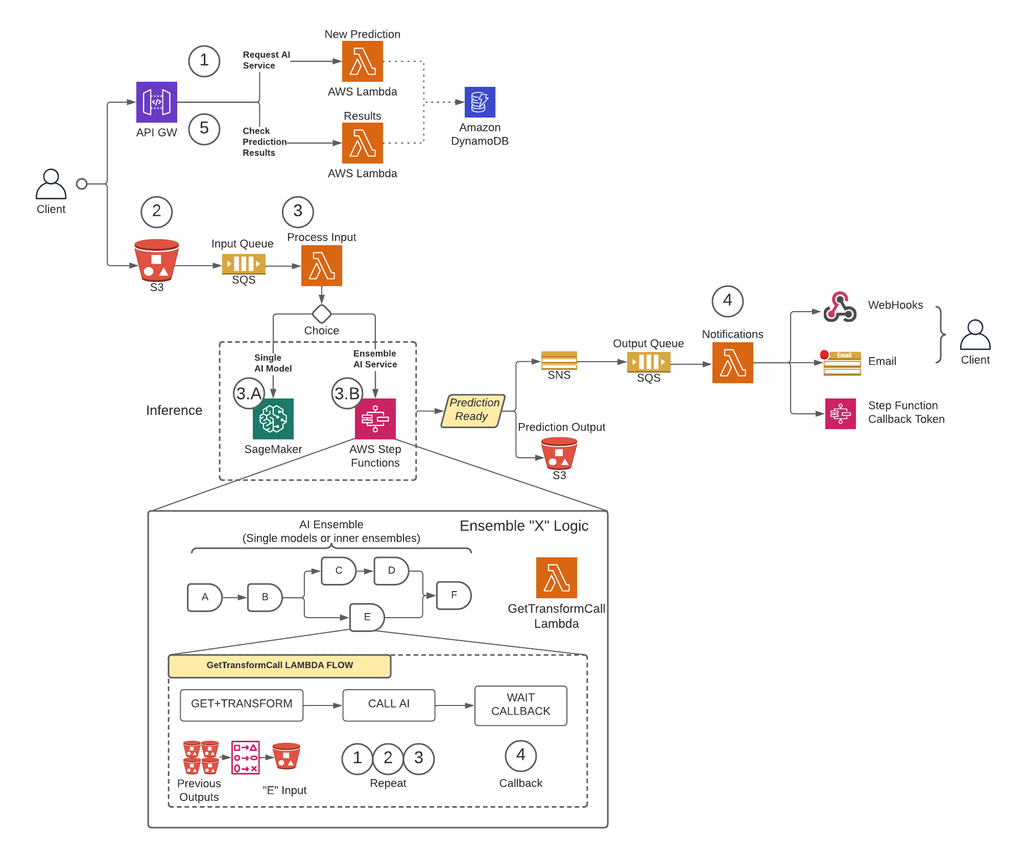

Po pierwsze, aby usunąć ograniczenia rozmiaru ładunku i znacznie zredukować ryzyko przekroczenia limitu czasu podczas scenariuszy o dużym natężeniu ruchu, CCC wdrożyło architekturę, która uruchamia prognozy asynchronicznie przy użyciu Punkty końcowe wnioskowania asynchronicznego SageMaker w połączeniu z innymi usługami zarządzanymi przez AWS jako podstawowe elementy składowe. Ponadto interfejs użytkownika systemu jest zgodny ze wzorcem projektowym „odpal i zapomnij”. Innymi słowy, gdy użytkownik prześle swoje dane do systemu, nic więcej nie trzeba robić. Zostaną powiadomieni, gdy prognoza będzie dostępna. Poniższy rysunek ilustruje ogólne omówienie naszej asynchronicznej architektury sterowanej zdarzeniami. W następnej sekcji przyjrzyjmy się szczegółowo przebiegowi wykonania zaprojektowanej architektury.

Rozwiązanie krok po kroku

Krok 1

Klient składa wniosek do Brama API AWS punkt końcowy. Treść żądania zawiera nazwę usługi AI, z której potrzebuje prognozy oraz żądaną metodę powiadomienia.

Ta prośba jest przekazywana do a Lambda funkcja o nazwie Nowa prognoza, którego głównymi zadaniami są:

- Sprawdź, czy żądana przez klienta usługa jest dostępna.

- Przypisz do żądania unikalny identyfikator prognozy. Ten identyfikator prognozy może być używany przez użytkownika do sprawdzania stanu prognozy w trakcie całego procesu.

- Generuj Amazon S3 wstępnie podpisany adres URL, którego użytkownik będzie musiał użyć w następnym kroku, aby przesłać treść wejściową żądania prognozy.

- Utwórz wpis w Amazon DynamoDB z informacją o otrzymanym zapytaniu.

Funkcja Lambda zwróci następnie odpowiedź za pośrednictwem punktu końcowego API Gateway z komunikatem zawierającym identyfikator prognozy przypisany do żądania i wstępnie podpisany adres URL usługi Amazon S3.

Krok 2

Klient bezpiecznie przesyła zawartość wejściową prognozy do zasobnika S3 przy użyciu wstępnie podpisanego adresu URL wygenerowanego w poprzednim kroku. Zawartość wejściowa zależy od usługi AI i może składać się z obrazów, danych tabelarycznych lub kombinacji obu.

Krok 3

Zasobnik S3 jest skonfigurowany do wyzwalania zdarzenia, gdy użytkownik przesyła zawartość wejściową. To powiadomienie jest wysyłane do kolejki Amazon SQS i obsługiwane przez funkcję Lambda o nazwie Wejście procesowe, Wejście procesowe Lambda uzyska informacje związane z tym identyfikatorem predykcji z DynamoDB, aby uzyskać nazwę usługi, do której ma być skierowane żądanie.

Ta usługa może być pojedynczym modelem AI, w takim przypadku Wejście procesowe Lambda wyśle żądanie do punktu końcowego SageMaker, który obsługuje ten model (krok 3-A), lub może to być usługa zespołowa AI, w którym to przypadku Wejście procesowe Lambda wyśle żądanie do maszyny stanowej funkcji krokowych, które obsługują logikę zespołową (krok 3-B).

W obu opcjach (pojedynczy model AI lub zespołowa usługa AI), kiedy ostateczna prognoza będzie gotowa, zostanie zapisana w odpowiednim zasobniku S3, a dzwoniący zostanie powiadomiony za pomocą metody określonej w kroku 1 (więcej szczegółów na temat powiadomień w kroku 4).

Krok 3-A

Jeśli identyfikator prognozy jest powiązany z pojedynczym modelem AI, plik Wejście procesowe Lambda wyśle żądanie do punktu końcowego SageMaker, który obsługuje model. W tym systemie obsługiwane są dwa typy punktów końcowych SageMaker:

- Asynchroniczny: the Wejście procesowe Lambda wysyła żądanie do asynchronicznego punktu końcowego SageMaker. Natychmiastowa odpowiedź obejmuje lokalizację S3, w której SageMaker zapisze dane wyjściowe prognozy. To żądanie jest asynchroniczne, zgodne ze wzorcem „odpal i zapomnij” i nie blokuje przepływu wykonywania funkcji Lambda.

- Synchroniczny: the Wejście procesowe Lambda wysyła żądanie do synchronicznego punktu końcowego SageMaker. Ponieważ jest to żądanie synchroniczne, wejście procesowe czeka na odpowiedź, a po jej otrzymaniu przechowuje ją w S3 w analogiczny sposób, jak robią to asynchroniczne punkty końcowe SageMaker.

W obu przypadkach (synchroniczne lub asynchroniczne punkty końcowe) predykcja jest przetwarzana w równoważny sposób, przechowując dane wyjściowe w zasobniku S3. Kiedy asynchroniczny punkt końcowy SageMaker zakończy przewidywanie, wyzwalane jest zdarzenie Amazon SNS. To zachowanie jest również replikowane dla synchronicznych punktów końcowych z dodatkową logiką w funkcji Lambda.

Krok 3-B

Jeśli identyfikator predykcji jest powiązany z zespołem AI, plik Wejście procesowe Lambda wyśle żądanie do funkcji kroku powiązanej z tym zespołem AI. Jak wspomniano powyżej, AI Ensemble to architektura oparta na grupie modeli AI pracujących razem w celu wygenerowania jednej ogólnej prognozy. Orkiestracja zespołu AI odbywa się za pomocą funkcji krokowej.

Funkcja kroku ma jeden krok na usługę AI, która obejmuje zespół. Każdy krok wywoła funkcję Lambda, która przygotuje dane wejściowe odpowiedniej usługi AI przy użyciu różnych kombinacji zawartości wyjściowej z poprzednich wywołań usługi AI z poprzednich kroków. Następnie wykonuje połączenie z każdą usługą AI, która w tym kontekście może być pojedynczym modelem AI lub innym zespołem AI.

Ta sama funkcja Lambda, tzw PobierzTransformCall używany do obsługi pośrednich prognoz zespołu AI jest używany w całej funkcji kroku, ale z różnymi parametrami wejściowymi dla każdego kroku. To wejście zawiera nazwę usługi AI, która ma zostać wywołana. Zawiera również definicję mapowania służącą do konstruowania danych wejściowych dla określonej usługi AI. Odbywa się to przy użyciu niestandardowej składni, którą Lambda może dekodować, co w skrócie jest słownikiem JSON, w którym wartości należy zastąpić treścią z poprzednich prognoz AI. Lambda pobierze te poprzednie prognozy z Amazon S3.

Na każdym kroku tzw PobierzTransformCall Lambda odczytuje z Amazon S3 poprzednie dane wyjściowe, które są potrzebne do zbudowania danych wejściowych określonej usługi AI. Następnie wywoła tzw Nowa prognoza Kod lambda używany wcześniej w kroku 1 i podaj nazwę usługi, metodę wywołania zwrotnego („funkcja kroku”) oraz token potrzebny do wywołania zwrotnego w ładunku żądania, który jest następnie zapisywany w DynamoDB jako nowy rekord predykcji. Lambda przechowuje również utworzone dane wejściowe tego etapu w zasobniku S3. W zależności od tego, czy ten etap jest pojedynczym modelem AI, czy zespołem AI, Lambda wysyła żądanie do punktu końcowego SageMaker lub innej funkcji kroku, która zarządza zespołem AI, który jest zależny od zespołu nadrzędnego.

Po wysłaniu żądania funkcja kroku przechodzi w stan oczekiwania, dopóki nie otrzyma tokena wywołania zwrotnego wskazującego, że może przejść do następnego etapu. Akcja wysłania tokena wywołania zwrotnego jest wykonywana przez funkcję Lambda o nazwie Powiadomienia (więcej szczegółów w kroku 4), gdy prognoza pośrednia jest gotowa. Proces ten jest powtarzany dla każdego etapu zdefiniowanego w funkcji krokowej, aż ostateczna predykcja będzie gotowa.

Krok 4

Gdy prognoza jest gotowa i zapisana w zasobniku S3, wyzwalane jest powiadomienie SNS. To zdarzenie może zostać wywołane na różne sposoby w zależności od przepływu:

- Automatycznie, gdy asynchroniczny punkt końcowy SageMaker zakończy przewidywanie.

- Jako ostatni krok funkcji step.

- By Wejście procesowe or PobierzTransformCall Lambda, gdy synchroniczny punkt końcowy SageMaker zwrócił prognozę.

Dla B i C tworzymy wiadomość SNS podobną do tej, którą automatycznie wysyła A.

Funkcja Lambda o nazwie powiadomienia jest subskrybowana w tym temacie SNS. Powiadomienia Lambda pobiorą informacje związane z identyfikatorem predykcji z DynamoDB, zaktualizują wpis o wartość statusu na „zakończony” lub „błąd” i wykonają niezbędne działania w zależności od trybu wywołania zwrotnego zapisanego w rekordzie bazy danych.

Jeśli ta predykcja jest pośrednią predykcją zespołu AI, jak opisano w kroku 3-B, tryb wywołania zwrotnego powiązany z tą predykcją będzie „funkcją skokową”, a rekord bazy danych będzie miał token wywołania zwrotnego powiązany z określonym krokiem w funkcja krokowa. Powiadomienia Lambda wykonają wywołanie API AWS Step Functions przy użyciu metody „SendTaskSuccess” lub „SendTaskFailure”. Umożliwi to przejście funkcji kroku do następnego kroku lub wyjścia.

Jeśli predykcja jest końcowym wyjściem funkcji step, a trybem wywołania zwrotnego jest „Webhook” [lub e-mail, brokerzy wiadomości (Kafka) itp.], to powiadomienia Lambda powiadomi klienta w określony sposób. W dowolnym momencie użytkownik może poprosić o status swojej prognozy. Żądanie musi zawierać identyfikator prognozy, który został przypisany w kroku 1, oraz wskazywać poprawny adres URL w API Gateway, aby skierować żądanie do funkcji Lambda o nazwie wyniki.

Wyniki Lambda wykona żądanie do DynamoDB, uzyskując status żądania i zwracając informacje użytkownikowi. Jeśli stan prognozy to błąd, wówczas w odpowiedzi zostaną zawarte odpowiednie szczegóły dotyczące awarii. Jeśli stan przewidywania to sukces, zostanie zwrócony wstępnie podpisany adres URL S3, aby użytkownik mógł pobrać treść prognozy.

Wyniki

Wstępne wyniki testów wydajności są obiecujące i przemawiają za rozszerzeniem wdrożenia tej nowej architektury wdrożeniowej przez CCC.

Godne uwagi obserwacje:

- Testy ujawniają siłę przetwarzania wsadowego lub równoczesnych żądań z wysoką przepustowością i zerowym współczynnikiem niepowodzeń w scenariuszach o dużym natężeniu ruchu.

- Kolejki komunikatów zapewniają stabilność w systemie podczas nagłych napływów żądań, dopóki wyzwalacze skalowania nie będą w stanie udostępnić dodatkowych zasobów obliczeniowych. Przy 3-krotnym zwiększeniu ruchu średnie opóźnienie żądania wzrosło tylko o 5 procent.

- Ceną stabilności jest zwiększone opóźnienie spowodowane narzutem komunikacyjnym między różnymi komponentami systemu. Gdy ruch użytkowników przekracza próg linii bazowej, dodatkowe opóźnienie można częściowo złagodzić, udostępniając więcej zasobów obliczeniowych, jeśli wydajność ma wyższy priorytet niż koszt.

- Asynchroniczne punkty końcowe wnioskowania SageMaker umożliwiają skalowanie liczby instancji do zera, przy jednoczesnym utrzymywaniu aktywnego punktu końcowego w celu otrzymywania żądań. Ta funkcja umożliwia kontynuowanie działania wdrożeń bez ponoszenia kosztów obliczeniowych i skalowanie od zera w razie potrzeby w dwóch scenariuszach: wdrożenia usług używane w środowiskach o niższym poziomie testowania i te, które mają minimalny ruch bez konieczności natychmiastowego przetwarzania.

Wnioski

Jak zaobserwowano podczas procesu POC, innowacyjny projekt stworzony wspólnie przez CCC i AWS zapewnia solidną podstawę do wykorzystania Amazon SageMaker z innymi usługami zarządzanymi przez AWS do hostowania złożonych multimodalnych zespołów AI oraz efektywnej i bezproblemowej orkiestracji potoków wnioskowania. Wykorzystując gotowe funkcje Amazon SageMaker, takie jak wnioskowanie asynchroniczne, CCC ma więcej możliwości skupienia się na specjalistycznych zadaniach o znaczeniu krytycznym dla biznesu. W duchu kultury CCC opartej na badaniach, ta nowatorska architektura będzie nadal ewoluować, ponieważ CCC przewodzi, wraz z AWS, w uwalnianiu potężnych nowych rozwiązań AI dla klientów.

Aby uzyskać szczegółowe instrukcje dotyczące tworzenia, wywoływania i monitorowania asynchronicznych punktów końcowych wnioskowania, zapoznaj się z sekcją dokumentacja, który zawiera również przykładowy notatnik aby pomóc Ci zacząć. Aby uzyskać informacje o cenach, odwiedź Cennik Amazon SageMaker.

Przykłady wykorzystania wnioskowania asynchronicznego z danymi nieustrukturyzowanymi, takimi jak przetwarzanie obrazu komputerowego i przetwarzanie języka naturalnego (NLP), można znaleźć w Uruchom wnioskowanie o wizji komputerowej na dużych filmach za pomocą asynchronicznych punktów końcowych Amazon SageMaker i Popraw wartościowe badania dzięki asynchronicznym punktom końcowym wnioskowania Hugging Face i Amazon SageMaker, Odpowiednio.

O autorach

Krzysztof Diaz jest Lead R&D Engineer w CCC Intelligent Solutions. Jako członek zespołu badawczo-rozwojowego pracował nad różnymi projektami, począwszy od narzędzi ETL, tworzenia zaplecza internetowego, współpracy z naukowcami w celu szkolenia modeli AI w systemach rozproszonych oraz ułatwiania dostarczania nowych usług AI między zespołami badawczymi i operacyjnymi. Ostatnio skupiał się na badaniu rozwiązań w zakresie narzędzi chmurowych w celu usprawnienia różnych aspektów cyklu życia firmy w zakresie opracowywania modeli sztucznej inteligencji. W wolnym czasie lubi próbować nowych restauracji w swoim rodzinnym Chicago i kolekcjonować tyle zestawów LEGO, ile zmieści się w jego domu. Christopher uzyskał tytuł Bachelor of Science in Computer Science na Northeastern Illinois University.

Krzysztof Diaz jest Lead R&D Engineer w CCC Intelligent Solutions. Jako członek zespołu badawczo-rozwojowego pracował nad różnymi projektami, począwszy od narzędzi ETL, tworzenia zaplecza internetowego, współpracy z naukowcami w celu szkolenia modeli AI w systemach rozproszonych oraz ułatwiania dostarczania nowych usług AI między zespołami badawczymi i operacyjnymi. Ostatnio skupiał się na badaniu rozwiązań w zakresie narzędzi chmurowych w celu usprawnienia różnych aspektów cyklu życia firmy w zakresie opracowywania modeli sztucznej inteligencji. W wolnym czasie lubi próbować nowych restauracji w swoim rodzinnym Chicago i kolekcjonować tyle zestawów LEGO, ile zmieści się w jego domu. Christopher uzyskał tytuł Bachelor of Science in Computer Science na Northeastern Illinois University.

Zdobywca nagrody Emmy Sama Kinarda jest Senior Managerem Inżynierii Oprogramowania w CCC Intelligent Solutions. Mieszka w Austin w Teksasie i walczy z AI Runtime Team, który jest odpowiedzialny za obsługę produktów AI CCC z wysoką dostępnością i na dużą skalę. W wolnym czasie Sam lubi być pozbawiony snu z powodu dwójki swoich wspaniałych dzieci. Sam ma tytuł Bachelor of Science w dziedzinie informatyki i Bachelor of Science w dziedzinie matematyki na University of Texas w Austin.

Zdobywca nagrody Emmy Sama Kinarda jest Senior Managerem Inżynierii Oprogramowania w CCC Intelligent Solutions. Mieszka w Austin w Teksasie i walczy z AI Runtime Team, który jest odpowiedzialny za obsługę produktów AI CCC z wysoką dostępnością i na dużą skalę. W wolnym czasie Sam lubi być pozbawiony snu z powodu dwójki swoich wspaniałych dzieci. Sam ma tytuł Bachelor of Science w dziedzinie informatyki i Bachelor of Science w dziedzinie matematyki na University of Texas w Austin.

Jaimego Hidalgo jest Starszym Inżynierem Systemowym w CCC Intelligent Solutions. Zanim dołączył do zespołu badawczego AI, kierował globalną migracją firmy do architektury mikrousług, projektując, budując i automatyzując infrastrukturę w AWS w celu wsparcia wdrażania produktów i usług w chmurze. Obecnie buduje i obsługuje lokalny klaster centrum danych stworzony do szkolenia w zakresie sztucznej inteligencji, a także projektuje i buduje rozwiązania chmurowe na potrzeby przyszłych badań i wdrażania sztucznej inteligencji w firmie.

Jaimego Hidalgo jest Starszym Inżynierem Systemowym w CCC Intelligent Solutions. Zanim dołączył do zespołu badawczego AI, kierował globalną migracją firmy do architektury mikrousług, projektując, budując i automatyzując infrastrukturę w AWS w celu wsparcia wdrażania produktów i usług w chmurze. Obecnie buduje i obsługuje lokalny klaster centrum danych stworzony do szkolenia w zakresie sztucznej inteligencji, a także projektuje i buduje rozwiązania chmurowe na potrzeby przyszłych badań i wdrażania sztucznej inteligencji w firmie.

Daniel Suarez jest Data Science Engineer w CCC Intelligent Solutions. Jako członek zespołu AI Engineering zajmuje się automatyzacją i przygotowywaniem modeli AI w produkcji, ewaluacji i monitorowaniu metryk oraz innych aspektów operacji ML. Daniel uzyskał tytuł magistra informatyki na Illinois Institute of Technology oraz tytuł magistra i licencjata inżynierii telekomunikacyjnej na Universidad Politecnica de Madrid.

Daniel Suarez jest Data Science Engineer w CCC Intelligent Solutions. Jako członek zespołu AI Engineering zajmuje się automatyzacją i przygotowywaniem modeli AI w produkcji, ewaluacji i monitorowaniu metryk oraz innych aspektów operacji ML. Daniel uzyskał tytuł magistra informatyki na Illinois Institute of Technology oraz tytuł magistra i licencjata inżynierii telekomunikacyjnej na Universidad Politecnica de Madrid.

Arunprasath Shankar jest starszym architektem rozwiązań AI/ML z AWS, pomagającym globalnym klientom skutecznie i wydajnie skalować ich rozwiązania AI w chmurze. W wolnym czasie Arun lubi oglądać filmy science fiction i słuchać muzyki klasycznej.

Arunprasath Shankar jest starszym architektem rozwiązań AI/ML z AWS, pomagającym globalnym klientom skutecznie i wydajnie skalować ich rozwiązania AI w chmurze. W wolnym czasie Arun lubi oglądać filmy science fiction i słuchać muzyki klasycznej.

Justina McWhirtera jest menedżerem architekta rozwiązań w AWS. Współpracuje z zespołem niesamowitych Architektów Rozwiązań, którzy pomagają klientom uzyskać pozytywne doświadczenia podczas wdrażania platformy AWS. Kiedy nie jest w pracy, Justin lubi grać w gry wideo ze swoimi dwoma chłopcami, hokeja na lodzie i jeździć w terenie swoim jeepem.

Justina McWhirtera jest menedżerem architekta rozwiązań w AWS. Współpracuje z zespołem niesamowitych Architektów Rozwiązań, którzy pomagają klientom uzyskać pozytywne doświadczenia podczas wdrażania platformy AWS. Kiedy nie jest w pracy, Justin lubi grać w gry wideo ze swoimi dwoma chłopcami, hokeja na lodzie i jeździć w terenie swoim jeepem.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/how-ccc-intelligent-solutions-created-a-custom-approach-for-hosting-complex-ai-models-using-amazon-sagemaker/

- 000

- 1

- 100

- 7

- a

- Zdolny

- O nas

- powyżej

- Działania

- aktywny

- acykliczny

- w dodatku

- Dodatkowy

- do tego

- Przyjęcie

- postępy

- AI

- Inżynieria AI

- ai badania

- Usługi AI

- Trening AI

- AI / ML

- Algorytmy

- Wszystkie kategorie

- wzdłuż

- alternatywny

- zdumiewający

- Amazonka

- Amazon Sage Maker

- i

- Rocznie

- Inne

- api

- podejście

- awanse

- właściwy

- architektura

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- aspekty

- przydzielony

- powiązany

- Autorzy

- producenci samochodów

- automatycznie

- automatycznie

- automatyzacja

- Automatyzacja

- dostępność

- dostępny

- średni

- nagroda

- AWS

- Funkcje kroków AWS

- Backend

- Bilans

- na podstawie

- Baseline

- bo

- staje się

- zanim

- jest

- poniżej

- Benchmarkingu

- korzyści

- Korzyści

- pomiędzy

- Blokować

- Bloki

- Blog

- Pudełko

- przynieść

- brokerów

- budować

- Budowanie

- Buduje

- wybudowany

- biznes

- biznes

- wezwanie

- nazywa

- Gość

- Połączenia

- zdolny

- walizka

- Etui

- katalog

- ccc

- Centrum

- wyzwanie

- ZOBACZ

- Chicago

- Dzieci

- wybór

- Christopher

- roszczenia

- klasa

- klient

- klientów

- Chmura

- TECHNOLOGIA W CHMURZE

- Grupa

- kod

- współpracę

- Zbieranie

- kolekcja

- połączenie

- kombinacje

- połączony

- Handel

- Komunikacja

- sukcesy firma

- Firma

- konkurencja

- Ukończył

- kompleks

- składnik

- składniki

- w składzie

- obliczać

- komputer

- Computer Science

- Wizja komputerowa

- równoległy

- łączy

- skonstruować

- zawiera

- zawartość

- kontekst

- kontynuować

- ciągły

- ciągły

- rdzeń

- Odpowiedni

- Koszty:

- Koszty:

- mógłby

- sprzężony

- Stwórz

- stworzony

- kultura

- Obecnie

- zwyczaj

- klient

- doświadczenie klienta

- Klientów

- Cykle

- DZIEŃ

- Daniel

- dane

- Centrum danych

- nauka danych

- Baza danych

- postanowiła

- głęboko

- głębokie nurkowanie

- Domyślnie

- dostarcza

- dostawa

- Zależność

- W zależności

- zależy

- rozwijać

- wdrażane

- Wdrożenie

- wdrożenia

- opisane

- Wnętrze

- zaprojektowany

- projektowanie

- projekty

- szczegółowe

- detale

- ustalona

- oprogramowania

- różne

- digitalizacja

- bezpośrednio

- odkryj

- dyskutować

- dystrybuowane

- systemy rozproszone

- domena

- pobieranie

- jazdy

- podczas

- każdy

- zdobył

- łatwiej

- gospodarka

- faktycznie

- skutecznie

- starania

- bądź

- Umożliwia

- Punkt końcowy

- inżynier

- Inżynieria

- Wchodzi

- Cały

- wejście

- środowiska

- Równoważny

- szczególnie

- itp

- ewaluację

- Parzyste

- wydarzenie

- ewoluuje

- przykłady

- egzekucja

- Przede wszystkim system został opracowany

- Wyjście

- doświadczenie

- Doświadczenia

- ekspertyza

- wyjaśnione

- rozciągać się

- Twarz

- w obliczu

- ułatwiać

- ułatwienie

- Brak

- Moda

- szybciej

- Cecha

- Korzyści

- Postać

- Akta

- finał

- sfinalizowane

- znalezieniu

- dopasować

- Elastyczność

- pływ

- Skupiać

- następujący

- następujący sposób

- Naprzód

- Fundacja

- od

- funkcjonować

- funkcjonalności

- Funkcjonalność

- Funkcje

- przyszłość

- Games

- Bramka

- Generować

- wygenerowane

- otrzymać

- Globalne

- wykresy

- bardzo

- Zarządzanie

- gwarantowane

- uchwyt

- mający

- pomoc

- pomoc

- Wysoki

- na wysokim szczeblu

- wyższy

- Strona główna

- gospodarz

- hostowane

- Hosting

- W jaki sposób

- How To

- HTML

- HTTPS

- ICE

- Illinois

- obraz

- zdjęcia

- Natychmiastowy

- wdrożenia

- realizacja

- realizowane

- in

- W innych

- zawierać

- włączony

- obejmuje

- Zwiększać

- wzrosła

- wzrastający

- niezależny

- indywidualny

- Informacja

- Infrastruktura

- początkowy

- inicjatywa

- innowacje

- Innowacyjny

- wkład

- przykład

- Instytut

- ubezpieczenie

- integrować

- Inteligencja

- Inteligentny

- Interfejs

- Internet

- Internet przedmiotów

- Internet przedmiotów

- IT

- łączący

- json

- Justin

- Trzymać

- konserwacja

- język

- duży

- większe

- Nazwisko

- Utajenie

- uruchomiona

- nioski

- prowadzić

- lider

- Przywództwo

- prowadzący

- Wyprowadzenia

- UCZYĆ SIĘ

- nauka

- Doprowadziło

- kredytodawców

- poziom

- lewarowanie

- Ograniczenia

- Lista

- Słuchanie

- Zyje

- lokalizacja

- maszyna

- uczenie maszynowe

- zrobiony

- Główny

- Większość

- robić

- WYKONUJE

- zarządzanie

- zarządzane

- i konserwacjami

- kierownik

- zarządza

- zarządzający

- wiele

- mapowanie

- rynek

- mistrzowski

- matematyka

- Materia

- Matters

- środków

- Poznaj nasz

- członek

- wzmiankowany

- wiadomość

- metoda

- Metryka

- mikroserwisy

- migracja

- minimalny

- ML

- Moda

- model

- modele

- monitor

- monitorowanie

- jeszcze

- większość

- ruch

- Kino

- przeniesienie

- wielokrotność

- Muzyka

- Nazwa

- Naturalny

- Przetwarzanie języka naturalnego

- niezbędny

- Potrzebować

- wymagania

- sieć

- Nowości

- nowy produkt

- Następny

- nlp

- powiadomienie

- Powiadomienia

- powieść

- uzyskane

- uzyskiwanie

- oferta

- Oferty

- ONE

- operacje

- Szanse

- Option

- orkiestracja

- Inne

- ogólny

- przegląd

- własny

- Parallel

- parametry

- część

- minęło

- Wzór

- Ludzie na

- procent

- doskonały

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- rurociąg

- kluczowy

- Platforma

- plato

- Analiza danych Platona

- PlatoDane

- gra

- PoC

- punkt

- polityka

- pozytywny

- Post

- potencjał

- mocny

- Zasilanie

- praktyka

- przepowiednia

- Przewidywania

- Przygotować

- poprzedni

- poprzednio

- Cena

- wycena

- priorytet

- wygląda tak

- Obrobiony

- procesów

- przetwarzanie

- produkować

- Produkt

- Produkcja

- Produkty

- projektowanie

- obiecujący

- własność

- własność

- zapewniać

- dostawców

- zapewnia

- że

- zaopatrzenie

- R & D

- nośny

- Kurs

- gotowy

- realizowany

- otrzymać

- Odebrane

- otrzymuje

- niedawny

- rekord

- zmniejszyć

- związane z

- niezawodność

- usunąć

- powtórzony

- otrzymuje

- replikowane

- zażądać

- wywołań

- wymagany

- wymagania

- Wymaga

- Badania naukowe

- Badacze

- Rozkład

- Zasoby

- odpowiedź

- odpowiedzialny

- restauracji

- Efekt

- powrót

- powrót

- ujawniać

- przeglądu

- Ryzyko

- Trasa

- reguły

- run

- bieganie

- SaaS

- sagemaker

- Sam

- taki sam

- Zapisz

- oszczędność

- Skala

- skalowaniem

- scenariusze

- sci-fi

- nauka

- płynnie

- Sekcja

- bezpiecznie

- wysyłanie

- senior

- seryjny

- Bezserwerowe

- służy

- usługa

- Usługi

- służąc

- Zestawy

- powinien

- pokazane

- podobny

- upraszczanie

- ponieważ

- pojedynczy

- Rozmiar

- spać

- So

- Tworzenie

- Inżynieria oprogramowania

- solidny

- rozwiązanie

- Rozwiązania

- Rozwiązywanie

- wyrafinowany

- specjalista

- wyspecjalizowanym

- specyficzny

- swoiście

- określony

- duch

- Stabilność

- ułożone w stos

- STAGE

- rozpoczęty

- Stan

- Rynek

- Ewolucja krok po kroku

- Cel

- przechowywany

- sklep

- jest determinacja.

- silny

- przedmiot

- taki

- nagły

- PODSUMOWANIE

- dostawcy

- wsparcie

- Utrzymany

- podpory

- składnia

- system

- systemy

- Zadanie

- zadania

- zespół

- Zespoły

- techniczny

- Technologies

- Technologia

- telekomunikacja

- test

- Testowanie

- texas

- Połączenia

- Informacje

- Państwo

- ich

- rzeczy

- całkowicie

- próg

- Przez

- poprzez

- wydajność

- czas

- czasy

- do

- razem

- żeton

- narzędzia

- aktualny

- w kierunku

- ruch drogowy

- Pociąg

- Trening

- transakcje

- wyzwalać

- rozsierdzony

- Trylion

- zaufany

- typy

- wyjątkowy

- uniwersytet

- zbliżających

- Aktualizacja

- przesłanych

- uptime

- URL

- us

- posługiwać się

- przypadek użycia

- Użytkownik

- Interfejs użytkownika

- wartość

- Wartości

- różnorodność

- różnorodny

- przez

- Wideo

- gier wideo

- Filmy

- wizja

- oglądania

- sposoby

- sieć

- Tworzenie stron internetowych

- Co

- czy

- który

- Podczas

- KIM

- będzie

- w ciągu

- bez

- wspaniale

- słowa

- Praca

- pracować razem

- pracował

- przepływów pracy

- pracujący

- działa

- by

- lat

- You

- zefirnet

- zero