Wprowadzenie

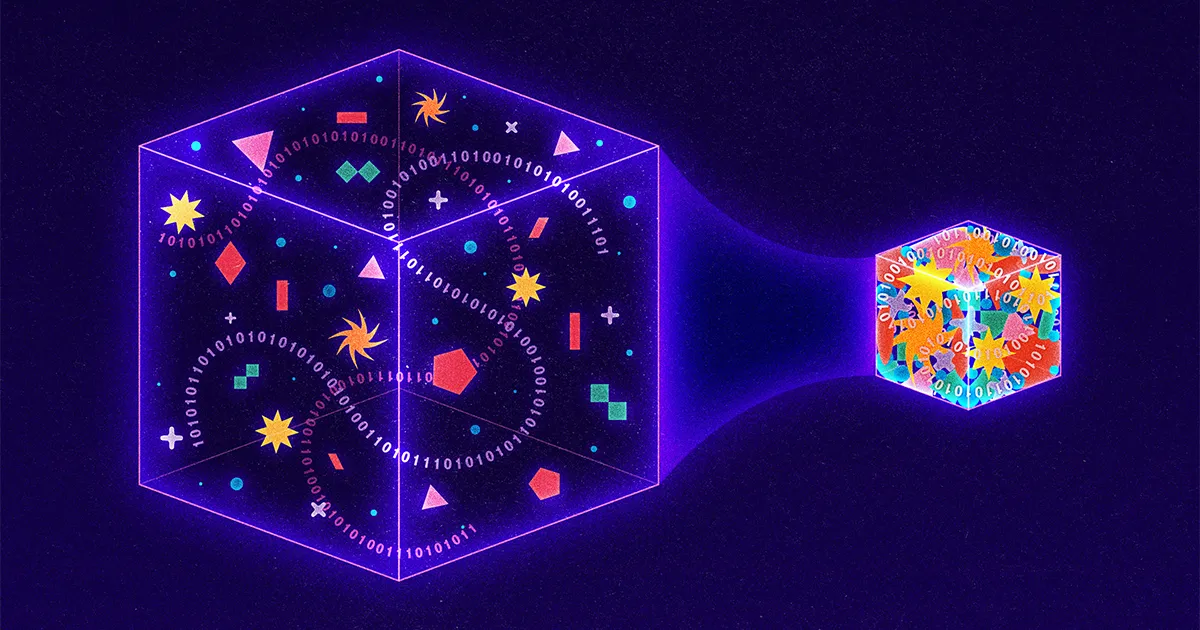

Każdego dnia w Internecie przepływa ponad 9 miliardów gigabajtów informacji, dlatego badacze nieustannie poszukują nowych sposobów kompresji danych do mniejszych pakietów. Najnowocześniejsze techniki koncentrują się na podejściach stratnych, które osiągają kompresję poprzez celową „utratę” informacji z transmisji. Na przykład Google niedawno ujawnił stratną strategię, w której komputer wysyłający usuwa szczegóły z obrazu, a komputer odbierający wykorzystuje sztuczną inteligencję do odgadnięcia brakujących części. Nawet Netflix stosuje stratne podejście, obniżając jakość wideo, gdy firma wykryje, że użytkownik ogląda na urządzeniu o niskiej rozdzielczości.

Natomiast bardzo niewiele badań jest obecnie prowadzonych nad strategiami bezstratnymi, w których transmisje są zmniejszane, ale nie poświęca się żadnej substancji. Powód? Podejścia bezstratne są już niezwykle wydajne. Obsługują wszystko, od standardu obrazu JPEG po wszechobecne oprogramowanie narzędziowe PKZip. A wszystko to za sprawą studenta, który po prostu szukał wyjścia z trudnego egzaminu końcowego.

Siedemdziesiąt lat temu Robert Fano, profesor Massachusetts Institute of Technology, dał studentom na swoich zajęciach z teorii informacji wybór: przystąpić do tradycyjnego egzaminu końcowego lub udoskonalić wiodący algorytm kompresji danych. Fano mógł, ale nie musiał, informować swoich uczniów, że jest autorem istniejącego algorytmu lub że od lat poluje na ulepszenia. Wiemy tylko, że Fano zaoferował swoim uczniom następujące wyzwanie.

Rozważ wiadomość złożoną z liter, cyfr i znaków interpunkcyjnych. Prostym sposobem zakodowania takiej wiadomości byłoby przypisanie każdemu znakowi unikalnej liczby binarnej. Na przykład komputer może reprezentować literę A jako 01000001, a wykrzyknik jako 00100001. Powoduje to, że kody są łatwe do przeanalizowania — co osiem cyfr lub bitów odpowiada jednemu unikalnemu znakowi — ale strasznie nieefektywne, ponieważ ta sama liczba cyfr binarnych jest używany zarówno dla wpisów powszechnych, jak i nietypowych. Lepszym podejściem byłoby coś w rodzaju alfabetu Morse'a, gdzie częsta litera E jest reprezentowana przez tylko pojedynczą kropkę, podczas gdy mniej powszechne Q wymaga dłuższej i bardziej pracochłonnej kreski-kreski-kropki-kreski.

Jednak alfabet Morse'a jest również nieefektywny. Jasne, niektóre kody są krótkie, a inne długie. Ale ponieważ długość kodu jest różna, komunikaty zapisane alfabetem Morse'a nie mogą być zrozumiane, chyba że zawierają krótkie okresy ciszy między każdą transmisją znaków. Rzeczywiście, bez tych kosztownych przerw odbiorcy nie byliby w stanie odróżnić wiadomości Morse'a kreska kropka-kreska-kropka kropka-kropka kreska kropka („banalne”) od kreska kropka-kreska-kropka kropka-kropka-kreska kropka („prawda” ).

Fano rozwiązał tę część problemu. Zdał sobie sprawę, że może używać kodów o różnej długości bez konieczności stosowania kosztownych spacji, o ile nigdy nie używa tego samego wzoru cyfr zarówno jako pełnego kodu, jak i początku innego kodu. Na przykład, jeśli litera S była tak powszechna w konkretnej wiadomości, że Fano przypisał jej wyjątkowo krótki kod 01, to żadna inna litera w tej wiadomości nie byłaby zakodowana z niczym, co zaczynało się od 01; kody takie jak 010, 011 lub 0101 byłyby zabronione. W rezultacie zakodowaną wiadomość można było czytać od lewej do prawej, bez żadnych dwuznaczności. Na przykład, gdy literze S przypisano 01, literze A przypisano 000, literze M przypisano 001, a literze L przypisano 1, nagle wiadomość 0100100011 może zostać natychmiast przetłumaczona na słowo „mały”, mimo że L jest reprezentowane przez jeden cyfra, S o dwie cyfry, a pozostałe litery po trzy.

Aby faktycznie określić kody, Fano zbudował drzewa binarne, umieszczając każdą niezbędną literę na końcu gałęzi wizualnej. Kod każdej litery został następnie zdefiniowany przez ścieżkę od góry do dołu. Jeśli ścieżka rozgałęziała się w lewo, Fano dodawał 0; prawe gałęzie otrzymały 1. Struktura drzewa ułatwiła Fano unikanie tych niepożądanych nakładek: gdy Fano umieścił literę w drzewie, ta gałąź się kończyła, co oznaczało, że żaden przyszły kod nie mógł zaczynać się w ten sam sposób.

Wprowadzenie

Aby zdecydować, które litery trafią dokąd, Fano mógł wyczerpująco przetestować każdy możliwy wzór pod kątem maksymalnej wydajności, ale byłoby to niepraktyczne. Zamiast tego opracował przybliżenie: dla każdej wiadomości uporządkował odpowiednie litery według częstotliwości, a następnie przypisał litery do gałęzi, tak aby litery po lewej stronie w dowolnej parze gałęzi zostały użyte w wiadomości mniej więcej tyle samo razy, co litery po prawej stronie. W ten sposób często używane znaki trafiałyby na krótsze, mniej gęste gałęzie. Niewielka liczba liter o wysokiej częstotliwości zawsze równoważy większą liczbę liter o niższej częstotliwości.

Wprowadzenie

Rezultatem była niezwykle skuteczna kompresja. Ale to było tylko przybliżenie; musiała istnieć lepsza strategia kompresji. Więc Fano rzucił wyzwanie swoim uczniom, aby go znaleźli.

Fano zbudował swoje drzewa od góry do dołu, zachowując jak największą symetrię między parami gałęzi. Jego uczeń, David Huffman, odwrócił ten proces do góry nogami, budując te same typy drzew, ale od dołu do góry. Wgląd Huffmana polegał na tym, że niezależnie od tego, co się stanie, w wydajnym kodzie dwa najrzadziej występujące znaki powinny mieć dwa najdłuższe kody. Tak więc Huffman zidentyfikował dwie najrzadziej spotykane postacie, zgrupował je w rozgałęzioną parę, a następnie powtórzył proces, tym razem szukając dwóch najmniej powszechnych wpisów spośród pozostałych postaci i pary, którą właśnie zbudował.

Rozważ wiadomość, w której podejście Fano słabnie. W „schoolroom” O pojawia się cztery razy, a S/C/H/L/R/M raz. Podejście równoważenia Fano zaczyna się od przypisania O i jednej innej litery do lewej gałęzi, przy czym pięć całkowitych zastosowań tych liter równoważy pięć występów pozostałych liter. Wynikowa wiadomość wymaga 27 bitów.

Z kolei Huffman zaczyna od dwóch rzadkich liter — powiedzmy R i M — i grupuje je razem, traktując parę jak pojedynczą literę.

Wprowadzenie

Jego zaktualizowany wykres częstotliwości oferuje mu następnie cztery możliwości: O, które pojawia się cztery razy, nowy połączony węzeł RM, który jest funkcjonalnie używany dwukrotnie, oraz pojedyncze litery S, C, H i L. Huffman ponownie wybiera dwie najrzadziej spotykane opcje, pasujące (powiedzmy) H z L.

Wprowadzenie

Wykres ponownie się aktualizuje: O nadal ma wagę 4, RM i HL mają teraz wagę 2, a litery S i C stoją osobno. Huffman kontynuuje stamtąd, na każdym etapie grupując dwie najrzadziej występujące opcje, a następnie aktualizując zarówno drzewo, jak i wykres częstotliwości.

Wprowadzenie

Ostatecznie „sala szkolna” staje się 11101111110000110110000101, goląc nieco podejście odgórne Fano.

Wprowadzenie

Jeden bit może nie wydawać się dużo, ale nawet niewielkie oszczędności rosną ogromnie, gdy są skalowane o miliardy gigabajtów.

Rzeczywiście, podejście Huffmana okazało się tak potężne, że obecnie prawie każda strategia bezstratnej kompresji wykorzystuje wgląd Huffmana w całości lub w części. Potrzebujesz PKZip do skompresowania dokumentu Word? Pierwszy krok obejmuje kolejną sprytną strategię identyfikowania powtórzeń, a tym samym kompresji rozmiaru wiadomości, ale drugim krokiem jest pobranie powstałej skompresowanej wiadomości i przeprowadzenie jej przez proces Huffmana. Przechowywać obraz jako JPEG? Twój komputer najpierw tłumaczy obraz na reprezentację tekstową, a następnie ponownie używa kodowania Huffmana do kompresji tego tekstu.

Nieźle jak na projekt pierwotnie motywowany pragnieniem absolwenta, aby pominąć egzamin końcowy.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoAiStream. Analiza danych Web3. Wiedza wzmocniona. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Kupuj i sprzedawaj akcje spółek PRE-IPO z PREIPO®. Dostęp tutaj.

- Źródło: https://www.quantamagazine.org/how-lossless-data-compression-works-20230531/

- :ma

- :Jest

- :nie

- :Gdzie

- ][P

- $W GÓRĘ

- 000

- 1

- 27

- 9

- a

- Osiągać

- faktycznie

- w dodatku

- ponownie

- temu

- algorytm

- Wszystkie kategorie

- sam

- już

- zawsze

- Dwuznaczność

- wśród

- an

- i

- Inne

- każdy

- wszystko

- zjawić się

- Występy

- pojawia się

- podejście

- awanse

- SĄ

- sztuczny

- sztuczna inteligencja

- AS

- przydzielony

- At

- autor

- uniknąć

- Łazienka

- Bilans

- równoważenie

- BE

- bo

- staje się

- być

- rozpocząć

- jest

- Ulepsz Swój

- pomiędzy

- Miliard

- miliardy

- Bit

- obie

- Dolny

- Oddział

- gałęzie

- Budowanie

- wybudowany

- ale

- by

- CAN

- nie może

- wyzwanie

- zakwestionowany

- charakter

- znaków

- Wykres

- wybór

- wybory

- klasa

- kod

- kodowane

- połączony

- wspólny

- sukcesy firma

- kompletny

- komputer

- stale

- ciągły

- kontrast

- kosztowny

- mógłby

- Obecnie

- pionierski nowatorski

- myślnik

- dane

- David

- dzień

- zdecydować

- zdefiniowane

- detale

- Ustalać

- rozwinięty

- urządzenie

- cyfry

- rozróżniać

- do

- dokument

- DOT

- na dół

- Krople

- e

- każdy

- łatwo

- Efektywne

- efektywność

- wydajny

- więcej

- zakończenia

- ogromnie

- Parzyste

- Każdy

- codziennie

- wszystko

- egzamin

- przykład

- istnieć

- Przede wszystkim system został opracowany

- niezwykle

- Załamuje się

- finał

- Znajdź

- i terminów, a

- Skupiać

- następujący

- W razie zamówieenia projektu

- cztery

- Częstotliwość

- częsty

- często

- od

- funkcjonalnie

- przyszłość

- dany

- Go

- absolwent

- Grupy

- Rosnąć

- miał

- dzieje

- Have

- he

- głowa

- Wysoka częstotliwość

- go

- jego

- W jaki sposób

- HTTPS

- Łowiectwo

- zidentyfikowane

- identyfikacja

- if

- obraz

- natychmiast

- podnieść

- poprawa

- in

- zawierać

- niewydajny

- Informacja

- poinformowany

- wgląd

- przykład

- zamiast

- Instytut

- Inteligencja

- celowo

- Internet

- najnowszych

- IT

- JEGO

- właśnie

- Wiedzieć

- większe

- prowadzący

- najmniej

- lewo

- mniej

- list

- lubić

- mało

- długo

- dłużej

- poszukuje

- zrobiony

- magazyn

- Utrzymywanie

- massachusetts

- Instytut Technologii w Massachusetts

- dopasowywanie

- maksymalny

- Może..

- znaczenie

- wiadomość

- wiadomości

- może

- brakujący

- jeszcze

- zmotywowani

- dużo

- O imieniu

- prawie

- niezbędny

- Potrzebować

- potrzeba

- Netflix

- nigdy

- Nowości

- Nie

- węzeł

- już dziś

- numer

- z naszej

- of

- poza

- oferowany

- Oferty

- on

- pewnego razu

- ONE

- te

- tylko

- Opcje

- or

- pierwotnie

- Inne

- Pozostałe

- na zewnątrz

- Pakiety

- đôi

- sparowany

- część

- szczególny

- strony

- ścieżka

- Wzór

- okresy

- Wybiera

- wprowadzanie

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- możliwy

- power

- mocny

- Problem

- wygląda tak

- Profesor

- projekt

- jakość

- Czytaj

- realizowany

- powód

- odbieranie

- niedawno

- odbiorców

- pozostały

- powtórzony

- reprezentować

- reprezentacja

- reprezentowane

- Wymaga

- Badania naukowe

- Badacze

- dalsze

- wynikły

- Efekt

- prawo

- ROBERT

- w przybliżeniu

- run

- s

- taki sam

- Oszczędności

- powiedzieć

- druga

- wysyłanie

- Short

- powinien

- Cisza

- po prostu

- pojedynczy

- Rozmiar

- mały

- mniejszy

- So

- Tworzenie

- kilka

- coś

- Dźwięk

- obowiązuje

- stoisko

- standard

- początek

- rozpoczęty

- rozpocznie

- Ewolucja krok po kroku

- Nadal

- sklep

- bezpośredni

- strategie

- Strategia

- Struktura

- student

- Studenci

- substancja

- taki

- Brać

- Techniki

- Technologia

- niż

- że

- Połączenia

- Im

- następnie

- teoria

- Tam.

- a tym samym

- one

- to

- tych

- chociaż?

- trzy

- Przez

- czas

- czasy

- do

- już dziś

- razem

- także

- Top

- Kwota produktów:

- tradycyjny

- Podróżowanie

- leczenia

- drzewo

- Drzewa

- Obrócony

- Dwa razy

- drugiej

- typy

- wszechobecny

- Niezwykły

- zrozumiany

- wyjątkowy

- odsłonięty

- zaktualizowane

- Nowości

- aktualizowanie

- posługiwać się

- używany

- Użytkownik

- zastosowania

- użyteczność

- Wideo

- była

- oglądania

- Droga..

- sposoby

- we

- webp

- waga

- były

- Co

- cokolwiek

- jeśli chodzi o komunikację i motywację

- ilekroć

- który

- KIM

- cały

- w

- bez

- słowo

- działa

- by

- lat

- jeszcze

- Twój

- zefirnet