By Kenny Hughes-Castleberry wysłano 02 grudnia 2022 r

Dzięki postępowi technologicznemu coraz trudniej jest stwierdzić, co jest prawdziwe, a co nie. Ten problem pogarsza się przy użyciu technologii deepfake —audio i wideo które wykorzystują sztuczną inteligencję do zastępowania osób lub ich głosów. Podczas gdy wiele deepfake'ów zostało z powodzeniem wykorzystanych w celach rozrywkowych (takich jak if Nicholas Cage było w Poszukiwacze zaginionej Arki) lub gier (takich jak w sportowcy FIFA), duży odsetek z nich został stworzony dla więcej złowrogie powody. Ponieważ tworzenie tych sfabrykowanych filmów staje się coraz łatwiejsze, wielu ekspertów ma nadzieję, że obliczenia kwantowe mogą pomóc przezwyciężyć potencjalne zagrożenia związane z tą rozwijającą się technologią.

Jak działa technologia Deepfake?

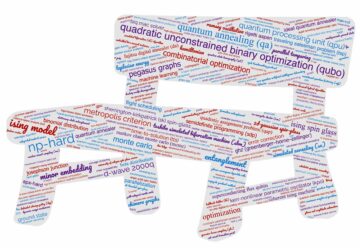

Aby stworzyć udany film typu deepfake, potrzebujesz uczenie maszynowe algorytmy. „Algorytmy głębokiego uczenia uczą się, jak rozwiązywać problemy z dużych zbiorów danych, a następnie są używane do zamiany twarzy w wideo i innych treściach cyfrowych” — wyjaśnił Post-kwantowe CEO Andersena Chenga. Post-Quantum to wiodąca firma zajmująca się cyberbezpieczeństwem, która koncentruje się na odporny na kwanty bezpieczeństwa, w tym przed deepfake'ami. „Istnieje wiele metod tworzenia tych głębokich podróbek”, stwierdził Cheng, „ale najbardziej popularna jest głęboka sieć neuronowa z wykorzystaniem autoenkoderów. jakiś autokoder to program sztucznej inteligencji do głębokiego uczenia się, który bada klipy wideo, aby zrozumieć, jak dana osoba wygląda z różnych perspektyw i otaczającego środowiska, a następnie mapuje tę osobę na osobę, znajdując wspólne cechy”.

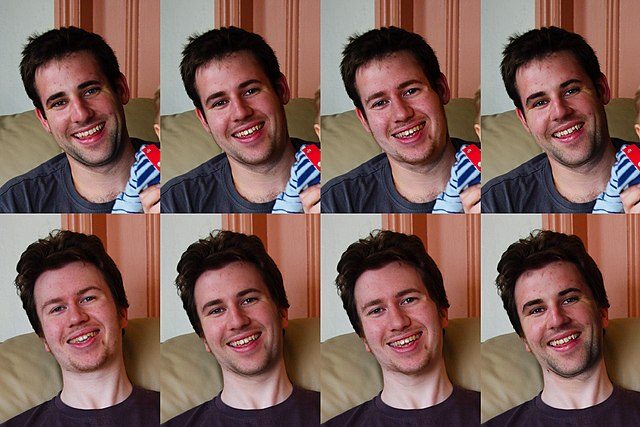

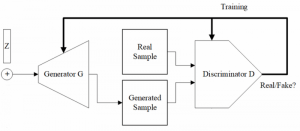

Konfiguracja technologii deepfake (PC Wikimedia Commons)

Aby zapewnić pomyślne działanie autokodera, należy przeanalizować wiele klipów wideo twarzy osoby, aby uzyskać większą pulę danych. Następnie autoenkoder może pomóc w stworzeniu złożonego wideo, zamieniając oryginalną osobę z nowym tematem. Drugi typ uczenia maszynowego, zwany General Adversarial Network (GAN), będzie wykrywał i poprawiał błędy w nowym kompozytowym wideo. Według artykuł z 2022 r.: „Sieci GAN szkolą„ generator ”, aby tworzyć nowe obrazy z ukrytej reprezentacji obrazu źródłowego, oraz„ dyskryminator ”, aby oceniać realizm generowanych materiałów”. Proces ten powtarza się kilka razy, dopóki dyskryminator nie będzie w stanie stwierdzić, czy wideo jest sfałszowane, a deepfake jest kompletny.

Zagrożenie technologią Deepfake

Obecnie istnieje wiele oprogramowania typu open source lub bezpłatnych aplikacji, których użytkownicy mogą używać do tworzenia deepfake'ów. Chociaż może się to wydawać korzystne dla wielu osób, zwłaszcza z branży rozrywkowej, doprowadziło to do poważnych problemów, nawet kryminalnych. Według Raport DeepTrace, 96% fałszywych filmów online w 2019 r. to, co nie jest zaskakujące, pornografia. Podczas gdy wiele z tych nielegalnych filmów powstało w celu zemsty na byłym, inne zostały wykorzystane do wywołania skandali wśród celebrytek, a nawet polityków. W 2018 roku opublikowano film typu deepfake z a belgijska partia polityczna przedstawiający ówczesnego prezydenta Trumpa omawiającego paryskie porozumienia klimatyczne. Ponieważ fałszywe wiadomości stają się już problemem dla ogółu społeczeństwa, głębokie fałszywe filmy mogą być kroplą, która przełamie grzbiet wielbłąda. Nawet sfałszowany dźwięk sieje spustoszenie, jak jeden sfałszowany plik audio z CEO firmy technologicznej przyczynił się do popełnienia oszustwa. Według Chenga tego typu media mogą dość szybko osłabić zaufanie publiczne. „Mamy szerszą kwestię zaufania społecznego – w jaki sposób opinia publiczna będzie w stanie rozróżnić, co jest prawdziwe, a co jest deepfake” – dodał Cheng. „Jak widzieliśmy, istnieją nawet dowody na to, że deepfake są wykorzystywane do obejścia środków ochronnych, takich jak uwierzytelnianie biometryczne”. W związku z tymi rosnącymi obawami Cheng i jego zespół z Post-Quantum wierzą, że mają rozwiązanie w postaci Nomidio, specjalistyczne oprogramowanie ultra-bezpieczne.

Przygotowanie na zagrożenia związane z technologią DeepFake

Patrząc na liczne zagrożenia stwarzane przez obliczenia kwantowe i deepfake, Cheng i jego zespół stworzyli Nomidio, aby upewnić się, że tożsamości logowania, a nawet uwierzytelnianie biometryczne pozostają bezpieczne. „Nomidio to biometryczna, wieloczynnikowa usługa biometryczna (MFB) bez hasła, która umożliwia bezpieczne uwierzytelnianie za pomocą prostego i intuicyjnego interfejsu użytkownika” — powiedział Cheng. „Zastępuje logowanie oparte na nazwie użytkownika/haśle i jednokrotne logowanie, a użytkownicy są uwierzytelniani na podstawie ich profilu biometrycznego z uwierzytelnianiem wieloskładnikowym (MFA) za kulisami”. Ponieważ Cheng od wielu lat jest ekspertem w dziedzinie cyberbezpieczeństwa, upewnił się, że Nomidio może być również zabezpieczone przed deepfake'ami. „Naszą podstawową filozofią podczas tworzenia było wykorzystanie jak największej liczby dodatkowych danych wejściowych i prawdziwego uwierzytelniania wieloskładnikowego (tj. z więcej niż dwoma czynnikami), więc w rzeczywistości jest to idealne rozwiązanie do radzenia sobie z wszelkimi przyszłymi zmianami w technologii deepfake. Ostatecznie wynika to z faktu, że tradycyjne MFA jest niewystarczające, ale MFB może praktycznie uniemożliwić ataki w czasie rzeczywistym. Oznacza to, że połączenie na przykład głosu, twarzy i kodu PIN jest wysoce bezpieczne, ponieważ można sfałszować dowolny pojedynczy czynnik, ale sfałszowanie wszystkich trzech w tym samym przypadku jest praktycznie niemożliwe. Dzięki Nomidio połączenie biometrii głosu i twarzy, rozpoznawania mowy, danych zależnych od kontekstu, a nawet analizy behawioralnej można połączyć w jeden system uwierzytelniania. ”

Chociaż samo Nomidio nie wykorzystuje obliczeń kwantowych do przezwyciężenia zagrożeń typu deepfake, komputery kwantowe mogą potencjalnie działać przeciwko tym fałszywym plikom multimedialnym. Jak komputery kwantowe często wykorzystują algorytmy uczenia maszynowego do szybszej i wydajniejszej pracy, mogą być w stanie wykryć fałszywe filmy lub pliki audio w szybszym tempie. Podczas gdy technologia jest wciąż rozwijana, a niewielu patrzy na deepfake jako potencjalny przypadek użycia komputerów kwantowych, te maszyny następnego poziomu mogą zostać wykorzystane w przyszłości, aby nasze media były bardziej zgodne z prawdą i dokładne.

Ponieważ zagrożenia związane z technologią deepfake stają się coraz bardziej widoczne, wiele rządów i firm już próbuje znaleźć sposoby na walkę z nią. W 2021 roku Facebook uruchomił tzw Wyzwanie Deepfake Detection, z nagrodą w wysokości 500,000 XNUMX USD dla twórców nowej technologii wykrywania deepfake'ów. W Stanach Zjednoczonych stany takie jak Kalifornia, Teksas i Wirginia mają przepisy, które zabraniają wykorzystywania deepfake zarówno w celach pornograficznych, jak i politycznych. The Parlament Europejski ustanowił również więcej przepisów dotyczących deepfake'ów, modyfikując ustawę o usługach cyfrowych, aby nakładać etykiety na fałszywe filmy. Chociaż przepisy te wejdą w życie dopiero w 2024 r., pokazują one powagę zagrożenia związanego z technologią deepfake.

Kenna Hughes-Castleberry jest pisarzem personelu w Inside Quantum Technology i Science Communicator w JILA (partnerstwo między University of Colorado Boulder i NIST). Jej pisarskie bity obejmują deep tech, metaverse i technologię kwantową.