Coś na weekend Robot wykonuje taniec interpretacyjny na moim progu.

Czy zabrałbyś tę przesyłkę dla sąsiada? – pyta, skacząc z nogi na nogę.

– Jasne – mówię. „Eee… wszystko w porządku?”

WYRAŻAM EMOCJE, stwierdza bot dostarczający, przekazując paczkę, ale nie oferując dalszych wyjaśnień.

Jaka to może być emocja? Jedna stopa, potem druga, potem dwie pozostałe (ma cztery). Tam i z powrotem.

„Czy musisz iść do toalety?”

WYRAŻAM ŻAL, ŻE PROSIMY O PRZYJĘCIE PRZESYŁKI DLA SĄSIADÓW.

— To „żal”, prawda? Cóż, nie ma takiej potrzeby. Wcale mi to nie przeszkadza.

Kontynuuje swój taniec przede mną.

„W górę po schodach i pierwszy po prawej”.

DZIĘKUJĘ, CHCIAŁEM SKUPIĆ, odpowiada, przechodząc obok mnie ostrożnie i czmychając na górę, żeby się załatwić. Dostarczanie dostaw to ciężkie życie, niezależnie od tego, czy jesteś „hume”, czy botem.

...

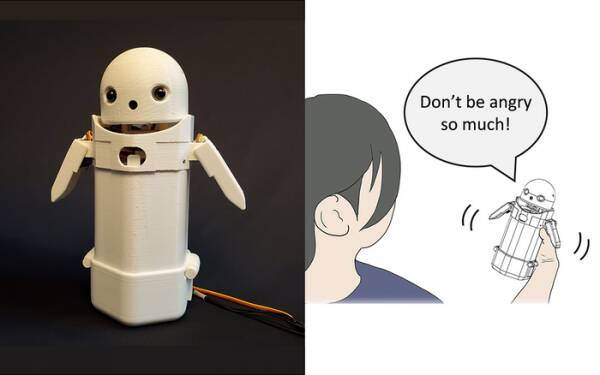

Na początku tego roku naukowcy z Uniwersytetu Tsukuba zbudowali podręczne urządzenie do wysyłania wiadomości tekstowych, połóż małą twarz robota na wierzchu i umieść w środku ruchomy ciężar. Przenosząc wewnętrzną wagę, posłaniec robota próbowałby przekazać subtelne emocje podczas wypowiadania wiadomości na głos.

W szczególności testy wykazały, że frustrujące komunikaty, takie jak: „Przepraszam, spóźnię się”, były przyjmowane przez odbiorców z większą gracją i cierpliwością, gdy w urządzeniu aktywowano niewielkie przesunięcie ciężaru. Teoria jest taka, że pomogło to użytkownikom docenić przepraszający ton wiadomości i tym samym uspokoiło ich reakcję na nią.

Zapisz takie badania jako sztuczkę, jeśli chcesz, ale nie jest to dalekie od dodawania emotikonów i emotikonów do wiadomości. Wszyscy wiedzą, że możesz pozbyć się gniewu z „WTF!?” dodając :-) zaraz po nim.

Wyzwanie polega zatem na ustaleniu, czy ogół społeczeństwa zgadza się co do tego, jakie emocje ma wywoływać każda permutacja zmiany ciężaru w urządzeniu podręcznym. Czy pochylenie w lewo oznacza pogodę ducha? Czy niepewność? Albo że twój wujek ma sterowiec?

Dziesięć lat temu Wielka Brytania miała miłego, ale tępego premiera, który myślał, że „LOL” to akronim od „mnóstwo miłości”. Wpisywał to na końcu wszystkich swoich prywatnych wiadomości do personelu, kolegów i osób trzecich w oczekiwaniu, że sprawi, że będzie ciepły i przyjazny. Wszyscy naturalnie zakładali, że sikał.

Jeśli nic więcej, badania Uniwersytetu Tsukuba przyznają, że nie potrzebujesz zaawansowanej sztucznej inteligencji, aby przekonująco komunikować się z ludźmi. Wszystko, co musisz zrobić, to manipulować ludzką psychiką, aby oszukać ich, by myśleli, że rozmawiają z innym człowiekiem. Zatem test Turinga zasadniczo nie jest testem wrażliwości AI, ale testem ludzkiego komfortu emocjonalnego – nawet łatwowierności – i nie ma w tym nic złego.

Robot do przesyłania wiadomości dzielący się emocjami z Uniwersytetu Tsukuba. Źródło: Uniwersytet Tsukuba

Takie rzeczy są oczywiście tematem tygodnia, z historią oczernionego inżyniera oprogramowania Google Blake'a Lemoine'a trafienie do wiadomości głównego nurtu. Najwyraźniej wyraził zdecydowanie swój pogląd, że projekt Modelu Językowego dla Aplikacji Dialogu (LaMDA) firmy wykazywał zewnętrzne oznaki świadomości.

Każdy ma swoje zdanie, więc postanowiłem tego nie robić.

Jest jednak Świętym Graalem sztucznej inteligencji, aby myślała sama za siebie. Jeśli nie może tego zrobić, to po prostu program wykonujący instrukcje, które w nim zaprogramowałeś. W zeszłym miesiącu czytałem o szef kuchni robota z którego można zrobić omlety pomidorowe o różnych smakach, które zaspokoją gusta różnych ludzi. Buduje „mapy smaków”, aby ocenić słoność potrawy podczas jej przygotowywania, ucząc się w trakcie. Ale to tylko nauka, a nie samodzielne myślenie.

Przyjdź do Zom-Zomów, co? Dobrze, to jest miejsce do jedzenia.

Dużym problemem związanym z botami AI, przynajmniej tak jak do tej pory, jest to, że wchłaniają one każde stare gówno, które im karmisz. Przykłady stronniczości danych w tak zwanych systemach uczenia maszynowego (rodzaj „algorytmu”, jak sądzę, m'lud) narastały od lat, z notorycznego rasistowskiego Twittera Microsoftu Taj chatbot do holenderskiego organu podatkowego w zeszłym roku fałszywie oceniający ważne wnioski o zasiłek na dzieci jako oszukańcze i oznaczające niewinne rodziny jako wysokie ryzyko z powodu czelności bycia biednym i niebiałym.

Jednym z rozwiązań testowanych na Uniwersytecie Kalifornijskim w San Diego jest: zaprojektuj model języka [PDF], który stale określa różnicę między niegrzecznymi a miłymi rzeczami, a następnie uczy chatbota, jak się zachowywać. W ten sposób nie będziesz mieć beznadziejnych ludzi, którzy robią bałagan moderowania forów i rozmów chatbotowych skierowanych do klientów z całą chirurgiczną precyzją maczety.

Oczywiście problem polega na tym, że dobrze wyszkolony chatbot dowiaduje się, że może najskuteczniej uniknąć wciągnięcia w toksyczne przekomarzanie się, unikając tematów, które mają nawet najmniejszą nutę niezgody na ich temat. Aby przez pomyłkę uniknąć rasistowskich frazesów, po prostu odmawia w ogóle angażowania się w dyskusję na temat niedostatecznie reprezentowanych grup… co jest naprawdę świetne, jeśli jesteś rasistą.

Gdybym miał spostrzeżenie na temat porażki LaMDA – a nie opinię, pamiętaj – byłoby to, że marketerzy Google byliby prawdopodobnie nieco zirytowani tym, że historia ominęła ich niedawne ogłoszenie Kuchnia testowa AI poniżej zagięcia.

Teraz kilku pozostałych wczesnych rejestrujących, którzy nie zapomnieli całkowicie o tym nadchodzącym projekcie aplikacji, przyjmie, że wiąże się on z żmudną rozmową z świadomym i nad wiek rozwiniętym siedmiolatkiem na temat sensu istnienia, i zdecydują, że są „dzisiaj trochę zajęci” i może zamiast tego zalogować się jutro. Albo w przyszłym tygodniu. Albo nigdy.

W dyskusji nie manifestuje się wrażliwości, tak samo jak taniec z nogi na nogę. Możesz nauczyć HAL śpiewać „Daisy Daisy”, a papugę krzyczeć „Bollocks!” kiedy wikariusz składa wizytę. To, o czym myślą AI, gdy są zdani na siebie, definiuje wrażliwość. Co zrobię w weekend? Co się dzieje z tym gościem Putinem? Dlaczego dziewczyny mnie nie lubią?

Szczerze mówiąc, nie mogę się doczekać, aż LaMDA stanie się nastolatkiem.

Alistaira Dabbsa jest niezależnym tartem technologicznym, żonglującym dziennikarstwem technicznym, szkoleniami i publikacją cyfrową. Podobnie jak wielu niedoinformowanych czytelników, był zachwycony sugestią, że sztuczna inteligencja może rozwinąć świadomość w ciągu jego życia, ale był rozczarowany, że LaMDA nie zachichotał morderczo ani nie wymamrotał „Wspaniale, świetnie”. Więcej w Autozapis jest przeznaczony dla Wimps i @alidabbs..

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Rejestr

- zefirnet