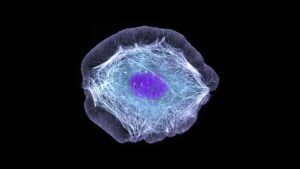

Wyodrębnianie poszczególnych obiektów w scenie wizualnej wydaje nam się intuicyjne, ale maszyny mają z tym problem. Teraz nowy model sztucznej inteligencji firmy Meta rozwinął szerokie pojęcie o tym, czym jest obiekt, umożliwiając mu oddzielanie obiektów, nawet jeśli nigdy wcześniej ich nie widział.

Może się to wydawać dość prozaicznym zadaniem komputerowego widzenia, ale umiejętność analizowania obrazu i ustalenia, gdzie kończy się jeden obiekt, a zaczyna drugi, to dość podstawowa umiejętność, bez której wiele bardziej skomplikowanych zadań byłoby nie do rozwiązania.

„Segmentacja obiektów” nie jest niczym nowym; Badacze AI pracowali nad tym od lat. Ale zwykle budowanie tych modeli było czasochłonnym procesem wymagającym wielu ludzkich komentarzy do obrazów i znacznych zasobów obliczeniowych. Zazwyczaj powstałe modele były wysoce wyspecjalizowane w określonych przypadkach użycia.

Teraz jednak naukowcy z Meta ujawnili model Segment Anything Model (SAM), który jest w stanie wyciąć dowolny obiekt w dowolnej scenie, niezależnie od tego, czy widział wcześniej coś podobnego. Model może to również zrobić w odpowiedzi na wiele różnych monitów, od opisu tekstu po kliknięcia myszą, a nawet dane śledzenia ruchu gałek ocznych.

„SAM nauczył się ogólnego pojęcia o tym, czym są obiekty i może generować maski dla dowolnego obiektu na dowolnym obrazie lub dowolnym filmie” – napisali naukowcy w blog pisać. „Uważamy, że możliwości są szerokie i jesteśmy podekscytowani wieloma potencjalnymi zastosowaniami, których jeszcze nawet sobie nie wyobrażaliśmy”.

Kluczem do opracowania modelu był ogromny nowy zestaw danych składający się z 1.1 miliarda masek segmentacji, które odnoszą się do obszarów obrazu, które zostały wyizolowane i opatrzone adnotacjami w celu wskazania, że zawierają one określony obiekt. Powstał dzięki połączeniu ręcznego dodawania adnotacji przez człowieka do obrazów i zautomatyzowanych procesów i jest zdecydowanie największą zebraną dotychczas kolekcją tego typu.

Trenując na tak ogromnym zbiorze danych, naukowcy Meta opracowali ogólną koncepcję tego, czym jest obiekt, co pozwala mu na segmentację rzeczy, których nawet wcześniej nie widział. Ta zdolność do uogólniania doprowadziła naukowców do nazwania SAM „modelem podstawowym”. kontrowersyjne określenie używany do opisywania innych masywnych, wstępnie wyszkolonych modeli, takich jak GPT OpenAI serii, których możliwości są rzekomo na tyle ogólne, że mogą posłużyć za podstawę wielu aplikacji.

Segmentacja obrazu jest zdecydowanie kluczowym składnikiem szerokiego zakresu zadań przetwarzania obrazu komputerowego. Jeśli nie możesz oddzielić różnych elementów sceny, trudno jest zrobić z nią coś bardziej skomplikowanego. Na swoim blogu naukowcy twierdzą, że może okazać się nieoceniony w edycji wideo i obrazów lub pomóc w analizie obrazów naukowych.

Być może bardziej adekwatnie do ambicji firmy w zakresie Metaverse, przedstawiają demonstrację tego, jak można go wykorzystać w połączeniu z zestawem słuchawkowym rzeczywistości wirtualnej, aby wybrać określone obiekty na podstawie spojrzenia użytkownika. Twierdzą również, że można go potencjalnie połączyć z dużym modelem językowym, aby stworzyć multimodalny system, który jest w stanie zrozumieć zarówno wizualną, jak i tekstową zawartość strony internetowej.

Możliwość obsługi szerokiej gamy monitów sprawia, że system jest szczególnie elastyczny. W strona internetowa demonstrując nowy model, firma pokazuje, że po przeanalizowaniu obrazu można poprosić o wydzielenie określonych obiektów, po prostu klikając je kursorem myszy, wpisując, co ma być segmentowane lub po prostu dzieląc cały obraz na oddzielne obiekty.

A co najważniejsze, firma udostępnia zarówno model, jak i zestaw danych do celów badawczych, aby inni mogli korzystać z ich pracy. Jest to to samo podejście, które firma zastosowała w swoim wielkojęzycznym modelu LLaMA, co doprowadziło do jego szybkiego powstania wyciekły online i pobudzanie A fala eksperymentów przez hobbystów i hakerów.

To, czy to samo stanie się z SAM, dopiero się okaże, ale tak czy inaczej jest to prezent dla społeczności badawczej AI, który może przyspieszyć postępy w wielu ważnych problemach z wizją komputerową.

Kredytowych Image: Meta sztuczna inteligencja

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Źródło: https://singularityhub.com/2023/04/10/metas-new-ai-can-identify-and-remove-objects-in-images/

- :Jest

- $W GÓRĘ

- 1

- a

- zdolność

- Zdolny

- przyśpieszyć

- Po

- AI

- ai badania

- Pozwalać

- pozwala

- Ambicje

- analiza

- Analizując

- i

- Inne

- aplikacje

- podejście

- SĄ

- AS

- zmontowane

- At

- zautomatyzowane

- na podstawie

- BE

- zanim

- jest

- uwierzyć

- Miliard

- Blog

- Przełamując

- szeroki

- budować

- Budowanie

- by

- CAN

- możliwości

- Etui

- kolekcja

- połączenie

- społeczność

- sukcesy firma

- Firma

- skomplikowane

- składniki

- komputer

- Wizja komputerowa

- computing

- pojęcie

- znaczny

- zawierać

- zawartość

- mógłby

- Stwórz

- stworzony

- kredyt

- Ciąć

- dane

- Data

- sprawa

- Zdecydowanie

- opisać

- opis

- rozwinięty

- oprogramowania

- różne

- bądź

- kończy się

- Cały

- Parzyste

- podniecony

- dość

- elastyczne

- W razie zamówieenia projektu

- Fundamenty

- od

- fundamentalny

- Ogólne

- Generować

- prezent

- hakerzy

- zdarzyć

- Ciężko

- Have

- Słuchawki

- pomoc

- wysoko

- gospodarz

- W jaki sposób

- HTTPS

- człowiek

- pomysł

- obraz

- zdjęcia

- ważny

- in

- intuicyjny

- nieoceniony

- odosobniony

- IT

- JEGO

- Klawisz

- język

- duży

- największym

- dowiedziałem

- Doprowadziło

- lubić

- Lama

- maszyny

- WYKONUJE

- podręcznik

- wiele

- Maski

- masywny

- Meta

- Metaverse

- może

- model

- modele

- jeszcze

- większość

- Nowości

- Pojęcie

- przedmiot

- obiekty

- of

- on

- ONE

- Inne

- Pozostałe

- strona

- sparowany

- szczególny

- szczególnie

- wybierać

- plato

- Analiza danych Platona

- PlatoDane

- możliwości

- potencjał

- potencjalnie

- bardzo

- problemy

- wygląda tak

- procesów

- Postęp

- Udowodnij

- zapewniać

- cele

- zasięg

- szybko

- Rzeczywistość

- odnosi

- Bez względu

- regiony

- szczątki

- Badania naukowe

- Badacze

- Zasoby

- odpowiedź

- wynikły

- Sam

- taki sam

- scena

- naukowy

- wydaje

- segment

- segmentacja

- oddzielny

- Serie

- Targi

- po prostu

- umiejętność

- So

- wyspecjalizowanym

- specyficzny

- Walka

- taki

- system

- Zadanie

- zadania

- że

- Połączenia

- ich

- Im

- Te

- rzeczy

- Przez

- czasochłonne

- do

- Trening

- zazwyczaj

- zrozumieć

- odsłonięty

- us

- posługiwać się

- różnorodność

- Wideo

- Wirtualny

- Wirtualna rzeczywistość

- wizja

- Droga..

- sieć

- Co

- czy

- który

- szeroki

- Szeroki zasięg

- będzie

- w

- bez

- Praca

- odrobić

- pracował

- by

- lat

- You

- zefirnet