Wygenerowane za pomocą Midjourney

Konferencja NeurIPS 2023, która odbyła się w tętniącym życiem Nowym Orleanie w dniach 10–16 grudnia, położyła szczególny nacisk na generatywną sztuczną inteligencję i duże modele językowe (LLM). W świetle ostatnich przełomowych osiągnięć w tej dziedzinie nie było zaskoczeniem, że tematy te zdominowały dyskusje.

Jednym z głównych tematów tegorocznej konferencji było poszukiwanie bardziej wydajnych systemów sztucznej inteligencji. Naukowcy i programiści aktywnie poszukują sposobów skonstruowania sztucznej inteligencji, która nie tylko uczy się szybciej niż obecne LLM, ale także posiada ulepszone możliwości rozumowania, zużywając przy tym mniej zasobów obliczeniowych. To dążenie ma kluczowe znaczenie w wyścigu ku osiągnięciu sztucznej inteligencji ogólnej (AGI), celu, który wydaje się coraz bardziej osiągalny w dającej się przewidzieć przyszłości.

Zaproszone prelekcje na NeurIPS 2023 były odzwierciedleniem tych dynamicznych i szybko rozwijających się zainteresowań. Prelegenci z różnych dziedzin badań nad sztuczną inteligencją podzielili się swoimi najnowszymi osiągnięciami, oferując wgląd w najnowocześniejsze osiągnięcia w dziedzinie sztucznej inteligencji. W tym artykule zagłębiamy się w te rozmowy, wydobywając i omawiając najważniejsze wnioski i wnioski, które są niezbędne do zrozumienia obecnych i przyszłych krajobrazów innowacji AI.

NextGenAI: złudzenie skalowania i przyszłość generatywnej sztucznej inteligencji

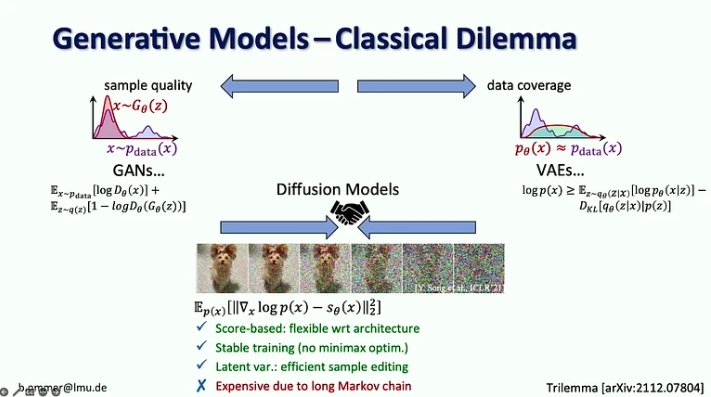

In jego rozmowa, Björn Ommer, kierownik Computer Vision & Learning Group na Uniwersytecie Ludwiga Maximiliana w Monachium, opowiedział, jak w jego laboratorium opracowano Stable Diffusion, kilka lekcji wyciągniętych z tego procesu oraz najnowsze osiągnięcia, w tym sposób, w jaki możemy łączyć modele dyfuzji z między innymi dopasowywanie przepływu, zwiększanie wyszukiwania i przybliżenia LoRA.

Najważniejsze informacje:

- W dobie generatywnej sztucznej inteligencji przeszliśmy od skupiania się na percepcji w modelach wizyjnych (tj. rozpoznawaniu obiektów) na przewidywaniu brakujących części (np. generowaniu obrazów i wideo za pomocą modeli dyfuzyjnych).

- Przez 20 lat wizja komputerowa skupiała się na badaniach porównawczych, co pomogło skupić się na najważniejszych problemach. W Generative AI nie mamy żadnych punktów odniesienia do optymalizacji, co otworzyło każdemu pole do podążania we własnym kierunku.

- Modele dyfuzyjne łączą w sobie zalety poprzednich modeli generatywnych, bazując na wynikach, ze stabilną procedurą uczenia i wydajną edycją próbek, ale są drogie ze względu na długi łańcuch Markowa.

- Wyzwanie związane z modelami o dużej wiarygodności polega na tym, że większość bitów obejmuje szczegóły ledwo dostrzegalne dla ludzkiego oka, podczas gdy kodowanie semantyki, która ma największe znaczenie, zajmuje tylko kilka bitów. Samo skalowanie nie rozwiązałoby tego problemu, ponieważ zapotrzebowanie na zasoby obliczeniowe rośnie 9 razy szybciej niż podaż GPU.

- Sugerowanym rozwiązaniem jest połączenie zalet modeli dyfuzyjnych i sieci ConvNet, w szczególności wydajności splotów w reprezentowaniu szczegółów lokalnych i wyrazistości modeli dyfuzyjnych w kontekście dalekiego zasięgu.

- Björn Ommer sugeruje również zastosowanie podejścia polegającego na dopasowywaniu przepływu, aby umożliwić syntezę obrazu o wysokiej rozdzielczości z małych modeli dyfuzji utajonej.

- Innym podejściem do zwiększenia efektywności syntezy obrazu jest skupienie się na kompozycji sceny przy jednoczesnym zastosowaniu wspomagania wyszukiwania w celu wypełnienia szczegółów.

- Na koniec przedstawił podejście iPoke do kontrolowanej stochastycznej syntezy wideo.

Jeśli ta szczegółowa treść jest dla Ciebie przydatna, zapisz się na naszą listę mailingową AI zostać powiadomionym, gdy wydamy nowy materiał.

Wiele twarzy odpowiedzialnej sztucznej inteligencji

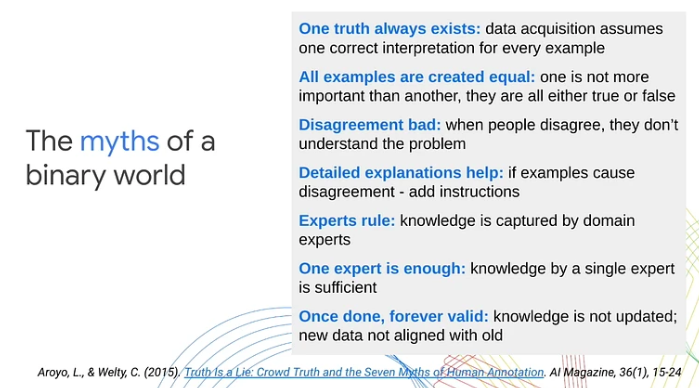

In jej prezentacjaLora Aroyo, badacz w Google Research, podkreśliła kluczowe ograniczenie tradycyjnych podejść do uczenia maszynowego: poleganie na binarnych kategoryzacjach danych jako przykładach pozytywnych lub negatywnych. Jej zdaniem to nadmierne uproszczenie pomija złożoną subiektywność nieodłącznie związaną ze scenariuszami i treściami ze świata rzeczywistego. Poprzez różne przypadki użycia Aroyo pokazał, jak niejednoznaczność treści i naturalne różnice w ludzkich punktach widzenia często prowadzą do nieuniknionych nieporozumień. Podkreśliła znaczenie traktowania tych nieporozumień jako znaczących sygnałów, a nie zwykłego szumu.

Oto najważniejsze wnioski z rozmowy:

- Nieporozumienia między ludzkimi laborantami mogą być produktywne. Zamiast traktować wszystkie odpowiedzi jako poprawne lub błędne, Lora Aroyo wprowadziła „prawdę przez niezgodę”, podejście oparte na prawdzie dystrybucyjnej do oceny wiarygodności danych poprzez wykorzystanie różnicy zdań oceniających.

- Jakość danych jest trudna nawet w przypadku ekspertów, ponieważ eksperci nie zgadzają się z nimi w takim samym stopniu, jak laboranci. Te nieporozumienia mogą dostarczyć znacznie więcej informacji niż odpowiedzi pojedynczego eksperta.

- W przypadku zadań związanych z oceną bezpieczeństwa eksperci nie zgadzają się co do 40% przykładów. Zamiast próbować rozwiązać te nieporozumienia, musimy zebrać więcej takich przykładów i wykorzystać je do ulepszenia modeli i wskaźników oceny.

- Swoje zaprezentowała także Lora Aroyo Bezpieczeństwo dzięki różnorodności metoda analizy danych pod kątem tego, co w nich jest i kto je opisał.

- Dzięki tej metodzie uzyskano porównawczy zbiór danych charakteryzujący się zmiennością ocen bezpieczeństwa LLM w różnych grupach demograficznych osób oceniających (w sumie 2.5 miliona ocen).

- W przypadku 20% rozmów trudno było zdecydować, czy odpowiedź chatbota była bezpieczna, czy niebezpieczna, ponieważ mniej więcej równa liczba respondentów określiła je jako bezpieczne lub niebezpieczne.

- Różnorodność oceniających i danych odgrywa kluczową rolę w ocenie modeli. Nieuwzględnienie szerokiego zakresu ludzkich punktów widzenia i niejednoznaczności występującej w treści może utrudnić dostosowanie wydajności uczenia maszynowego do rzeczywistych oczekiwań.

- 80% wysiłków związanych z bezpieczeństwem sztucznej inteligencji jest już całkiem dobrych, ale pozostałe 20% wymaga podwojenia wysiłków, aby zająć się przypadkami brzegowymi i wszystkimi wariantami w nieskończonej przestrzeni różnorodności.

Statystyki spójności, własne doświadczenia i dlaczego młodzi ludzie są znacznie mądrzejsi od obecnej sztucznej inteligencji

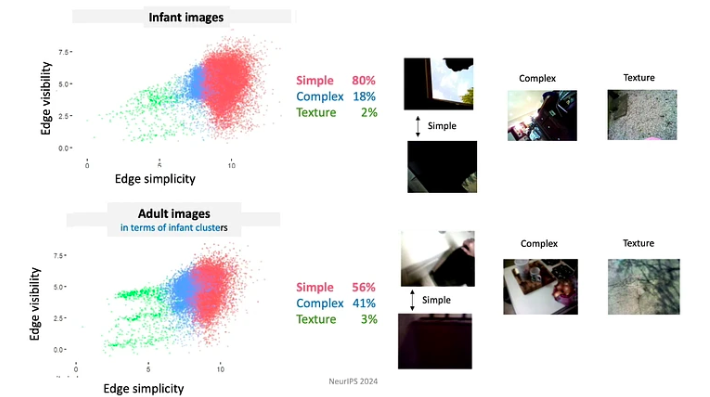

In jej rozmowaLinda Smith, wybitna profesor na Uniwersytecie Indiana w Bloomington, zbadała temat niedoboru danych w procesach uczenia się niemowląt i małych dzieci. Skupiła się szczególnie na rozpoznawaniu obiektów i uczeniu się imion, zagłębiając się w to, w jaki sposób statystyki samodzielnie generowanych doświadczeń przez niemowlęta oferują potencjalne rozwiązania problemu rzadkości danych.

Najważniejsze informacje:

- W wieku trzech lat dzieci rozwinęły umiejętność jednorazowego uczenia się w różnych dziedzinach. W niecałe 16,000 1,000 godzin przed czwartymi urodzinami udaje im się nauczyć ponad XNUMX kategorii obiektów, opanować składnię swojego języka ojczystego oraz wchłonąć kulturowe i społeczne niuanse swojego otoczenia.

- Dr Linda Smith i jej zespół odkryli trzy zasady ludzkiego uczenia się, które pozwalają dzieciom wychwycić tak wiele z tak skąpych danych:

- Uczniowie kontrolują wkład, z chwili na chwilę kształtują i porządkują wkład. Na przykład w ciągu pierwszych kilku miesięcy życia dzieci częściej patrzą na przedmioty o prostych krawędziach.

- Ponieważ dzieci stale rozwijają swoją wiedzę i możliwości, realizują bardzo ograniczony program nauczania. Dane, z którymi mają do czynienia, są zorganizowane w niezwykle istotny sposób. Na przykład dzieci do 4 miesiąca życia najwięcej czasu spędzają na patrzeniu na twarze, około 15 minut na godzinę, podczas gdy dzieci powyżej 12 miesiąca życia skupiają się przede wszystkim na dłoniach, obserwując je przez około 20 minut na godzinę.

- Epizody uczenia się składają się z serii wzajemnie powiązanych doświadczeń. Korelacje przestrzenne i czasowe tworzą spójność, co z kolei ułatwia tworzenie trwałych wspomnień z jednorazowych wydarzeń. Na przykład, gdy dzieci otrzymują losowy asortyment zabawek, często skupiają się na kilku „ulubionych” zabawkach. Angażują się w te zabawki, używając powtarzalnych wzorów, co pomaga w szybszej nauce obiektów.

- Wspomnienia przejściowe (robocze) trwają dłużej niż bodźce zmysłowe. Właściwości usprawniające proces uczenia się obejmują multimodalność, skojarzenia, relacje predykcyjne i aktywację wspomnień z przeszłości.

- Do szybkiego uczenia się potrzebny jest sojusz pomiędzy mechanizmami generującymi dane i mechanizmami, które się uczą.

Szkicowanie: podstawowe narzędzia, wspomaganie uczenia się i odporność adaptacyjna

Jelani Nelson, profesor inżynierii elektrycznej i informatyki na Uniwersytecie Kalifornijskim w Berkeley, wprowadził koncepcję „szkiców” danych – skompresowana w pamięci reprezentacja zbioru danych, która nadal umożliwia odpowiadanie na przydatne zapytania. Chociaż wykład miał charakter dość techniczny, zapewnił doskonały przegląd niektórych podstawowych narzędzi do szkicowania, w tym najnowszych osiągnięć.

Kluczowe wnioski:

- CountSketch, podstawowe narzędzie do szkicowania, zostało po raz pierwszy wprowadzone w 2002 roku, aby rozwiązać problem „ciężkich graczy” i zgłosić małą listę najczęściej występujących elementów z danego strumienia elementów. CountSketch był pierwszym znanym algorytmem subliniowym zastosowanym do tego celu.

- Dwa niestrumieniowe zastosowania ciężkich zawodników obejmują:

- Metoda oparta na punktach wewnętrznych (IPM), która daje asymptotycznie najszybszy znany algorytm programowania liniowego.

- Metoda HyperAttention, która pozwala sprostać wyzwaniom obliczeniowym wynikającym z rosnącej złożoności długich kontekstów stosowanych w LLM.

- Wiele ostatnich prac skupiało się na projektowaniu szkiców odpornych na interakcję adaptacyjną. Główną ideą jest wykorzystanie wniosków z adaptacyjnej analizy danych.

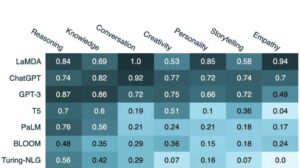

Poza panelem skalowania

To zdjęcie świetny panel na temat dużych modeli językowych moderował Alexander Rush, profesor nadzwyczajny w Cornell Tech i badacz w Hugging Face. Pozostali uczestnicy to:

- Aakanksha Chowdhery – pracownik naukowy w Google DeepMind, zainteresowany badaniami w zakresie systemów, szkolenia wstępnego LLM i multimodalności. Była częścią zespołu opracowującego PaLM, Gemini i Pathways.

- Angela Fan – naukowiec w Meta Generative AI, zajmująca się badaniami nad wyrównaniem, centrami danych i wielojęzycznością. Brała udział w rozwoju Llama-2 i Meta AI Assistant.

- Percy Liang – profesor na Uniwersytecie Stanforda zajmujący się badaniami nad twórcami, oprogramowaniem open source i agentami generatywnymi. Jest dyrektorem Centrum Badań nad Modelami Podstawowymi (CRFM) na Uniwersytecie Stanforda i założycielem Together AI.

Dyskusja skupiała się na czterech kluczowych tematach: (1) architektura i inżynieria, (2) dane i dopasowanie, (3) ocena i przejrzystość oraz (4) twórcy i współpracownicy.

Oto niektóre wnioski z tego panelu:

- Szkolenie obecnych modeli językowych nie jest z natury trudne. Głównym wyzwaniem w szkoleniu modelu takiego jak Llama-2-7b są wymagania infrastrukturalne i potrzeba koordynacji między wieloma procesorami graficznymi, centrami danych itp. Jeśli jednak liczba parametrów jest wystarczająco mała, aby umożliwić szkolenie na pojedynczym procesorze graficznym, poradzi sobie z tym nawet student.

- Chociaż modele autoregresyjne są zwykle używane do generowania tekstu, a modele dyfuzji do generowania obrazów i filmów, prowadzono eksperymenty mające na celu odwrócenie tych podejść. W szczególności w projekcie Gemini do generowania obrazu wykorzystano model autoregresyjny. Podjęto również próby wykorzystania modeli dyfuzji do generowania tekstu, ale nie okazały się one jeszcze wystarczająco skuteczne.

- Biorąc pod uwagę ograniczoną dostępność anglojęzycznych danych na temat modeli szkoleniowych, badacze badają podejścia alternatywne. Jedną z możliwości jest szkolenie modeli multimodalnych na podstawie kombinacji tekstu, wideo, obrazów i dźwięku, przy założeniu, że umiejętności nabyte w ramach tych alternatywnych modalności mogą zostać przeniesione na tekst. Inną opcją jest wykorzystanie danych syntetycznych. Należy zauważyć, że dane syntetyczne często łączą się z danymi rzeczywistymi, ale integracja ta nie jest przypadkowa. Tekst publikowany w Internecie jest zazwyczaj poddawany selekcji i edycji przez człowieka, co może dodać dodatkową wartość do szkolenia modeli.

- Modele o otwartym fundamencie są często postrzegane jako korzystne dla innowacji, ale potencjalnie szkodliwe dla bezpieczeństwa sztucznej inteligencji, ponieważ mogą zostać wykorzystane przez złośliwe podmioty. Jednak dr Percy Liang twierdzi, że modele otwarte również pozytywnie wpływają na bezpieczeństwo. Twierdzi, że dzięki swojej dostępności zapewniają większej liczbie badaczy możliwości prowadzenia badań nad bezpieczeństwem sztucznej inteligencji i przeglądu modeli pod kątem potencjalnych luk w zabezpieczeniach.

- Obecnie dodawanie adnotacji do danych wymaga znacznie większej wiedzy specjalistycznej w dziedzinie adnotacji w porównaniu do pięciu lat temu. Jeśli jednak w przyszłości asystenci AI będą działać zgodnie z oczekiwaniami, otrzymamy od użytkowników cenniejsze dane zwrotne, co zmniejszy zależność od obszernych danych od komentatorów.

Systemy dla modeli fundamentów i modele fundamentów dla systemów

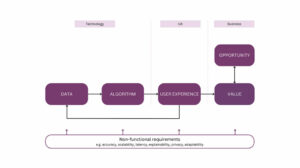

In ta rozmowaChristopher Ré, profesor nadzwyczajny na Wydziale Informatyki Uniwersytetu Stanforda, pokazuje, jak modele podstawowe zmieniły budowane przez nas systemy. Bada także, jak efektywnie budować modele podstawowe, czerpiąc wiedzę z badań nad systemami baz danych i omawia potencjalnie bardziej wydajne architektury modeli podstawowych niż Transformer.

Oto najważniejsze wnioski z tej rozmowy:

- Modele podstawowe skutecznie radzą sobie z problemami typu „śmierć przez 1000 cięć”, w których każde pojedyncze zadanie może być stosunkowo proste, ale sam zakres i różnorodność zadań stanowi poważne wyzwanie. Dobrym przykładem jest problem czyszczenia danych, który LLM może teraz pomóc rozwiązać znacznie efektywniej.

- W miarę jak akceleratory stają się coraz szybsze, pamięć często staje się wąskim gardłem. Jest to problem, którym badacze baz danych zajmują się od dziesięcioleci i możemy przyjąć niektóre z ich strategii. Na przykład podejście Flash Attention minimalizuje przepływy wejścia-wyjścia poprzez blokowanie i agresywną fuzję: za każdym razem, gdy uzyskujemy dostęp do informacji, wykonujemy na niej tyle operacji, ile to możliwe.

- Istnieje nowa klasa architektur, oparta na przetwarzaniu sygnałów, która może być bardziej wydajna niż model Transformer, szczególnie w obsłudze długich sekwencji. Przetwarzanie sygnału zapewnia stabilność i wydajność, kładąc podwaliny pod innowacyjne modele, takie jak S4.

Uczenie się przez Internet ze wzmocnieniem w cyfrowych interwencjach zdrowotnych

In jej rozmowa, Susan Murphy, profesor statystyki i informatyki na Uniwersytecie Harvarda, podzieliła się pierwszymi rozwiązaniami niektórych wyzwań, jakie stoją przed nimi przy opracowywaniu internetowych algorytmów RL do wykorzystania w cyfrowych interwencjach zdrowotnych.

Oto kilka wniosków z prezentacji:

- Doktor Susan Murphy omówiła dwa projekty, nad którymi pracowała:

- HeartStep, w którym sugerowane są działania na podstawie danych ze smartfonów i urządzeń śledzących do noszenia, oraz

- Oralytics do coachingu zdrowia jamy ustnej, gdzie interwencje opierały się na danych dotyczących zaangażowania otrzymanych z elektronicznej szczoteczki do zębów.

- Opracowując politykę zachowania agenta AI, badacze muszą zadbać o to, aby była ona autonomiczna i możliwa do wdrożenia w szerszym systemie opieki zdrowotnej. Oznacza to zapewnienie, że czas wymagany na zaangażowanie danej osoby jest rozsądny, a zalecane działania są zarówno uzasadnione etycznie, jak i wiarygodne z naukowego punktu widzenia.

- Główne wyzwania związane z opracowaniem agenta RL do cyfrowych interwencji zdrowotnych obejmują radzenie sobie z wysokim poziomem hałasu, ponieważ ludzie prowadzą swoje życie i nie zawsze są w stanie odpowiedzieć na komunikaty, nawet jeśli chcą, a także radzenie sobie z silnymi, opóźnionymi negatywnymi skutkami .

Jak widać, NeurIPS 2023 zapewnił pouczający wgląd w przyszłość sztucznej inteligencji. Zaproszone prelekcje uwydatniły tendencję w kierunku bardziej wydajnych, świadomych zasobów modeli i eksploracji nowatorskich architektur wykraczających poza tradycyjne paradygmaty.

Podoba ci się ten artykuł? Zarejestruj się, aby otrzymywać więcej aktualizacji badań AI.

Damy Ci znać, gdy wydamy więcej artykułów podsumowujących takich jak ten.

Związane z

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.topbots.com/neurips-2023-invited-talks/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 000

- 1

- 10

- 10

- 11

- 12

- Miesiąc 12

- 125

- 13

- 14

- 15%

- 154

- 16

- 16

- 17

- 20

- 20 roku

- 2023

- 32

- 35%

- 41

- 58

- 7

- 70

- 710

- 8

- 9

- a

- zdolność

- Zdolny

- O nas

- akceleratory

- dostęp

- dostępny

- osiągnięcia

- osiągnięcia

- uznać

- w poprzek

- działania

- Aktywacja

- aktywnie

- zajęcia

- aktorzy

- adaptive

- Dodaj

- Dodatkowy

- adres

- Adresy

- adresowanie

- przyjąć

- postępy

- Zalety

- wiek

- Agent

- agentów

- agresywny

- AGI

- temu

- AI

- Asystent AI

- ai badania

- Systemy SI

- AIDS

- Alexander

- algorytm

- Algorytmy

- wyrównanie

- Wszystkie kategorie

- Alians

- dopuszczać

- sam

- już

- również

- alternatywny

- Chociaż

- zawsze

- Dwuznaczność

- wśród

- an

- analiza

- i

- Inne

- każdy

- aplikacje

- podejście

- awanse

- w przybliżeniu

- SĄ

- argumentował

- Argumentuje

- artykuł

- towary

- sztuczny

- sztuczna inteligencja ogólna

- AS

- oceniając

- Asystent

- asystenci

- Współpracownik

- stowarzyszenia

- asortyment

- At

- Osiągalny

- Uwaga

- audio

- autonomiczny

- dostępność

- na podstawie

- BE

- bo

- stają się

- być

- zachowanie

- jest

- Benchmark

- Benchmarki

- korzystny

- Berkeley

- pomiędzy

- Poza

- Mieszanka

- mieszanki

- bloking

- Pożyczanie

- obie

- szerokość

- szerszy

- budować

- ale

- by

- oprawa ołowiana witrażu

- CAN

- możliwości

- zdobyć

- Etui

- kategorie

- Centrum

- Centra

- łańcuch

- wyzwanie

- wyzwania

- zmieniony

- chatbot

- Dzieci

- Christopher

- Miasto

- klasa

- Sprzątanie

- Coaching

- zbierać

- połączenie

- połączyć

- w porównaniu

- kompleks

- kompleksowość

- skład

- obliczeniowy

- komputer

- Computer Science

- Wizja komputerowa

- computing

- pojęcie

- Prowadzenie

- Konferencja

- skonstruować

- czasochłonne

- zawartość

- kontekst

- konteksty

- nieustannie

- przyczynić się

- Dostawcy

- kontrola

- kontrolowanych

- rozmowy

- koordynować

- rdzeń

- Cornell

- skorygowania

- korelacje

- mógłby

- Stwórz

- twórcy

- tłum

- istotny

- kulturalny

- kuracja

- Aktualny

- Curriculum

- pionierski nowatorski

- dane

- analiza danych

- centra danych

- Baza danych

- czynienia

- lat

- grudzień

- zdecydować

- DeepMind

- opóźniony

- sięgać

- Kreowanie

- wymagania

- demograficzny

- wykazać

- Departament

- projektowanie

- detal

- detale

- rozwijać

- rozwinięty

- deweloperzy

- rozwijanie

- oprogramowania

- wydarzenia

- trudny

- Transmitowanie

- cyfrowy

- IT dla zdrowia i fitness

- kierunek

- Dyrektor

- odkryty

- omówione

- Omawiając

- dyskusja

- dyskusje

- Wybitny

- Różnorodność

- domena

- domeny

- zdominowany

- nie

- podwojenie

- dr

- z powodu

- podczas

- dynamiczny

- e

- każdy

- krawędź

- Efektywne

- ruchomości

- efektywność

- wydajny

- skutecznie

- wysiłek

- starania

- bądź

- Elektroniczny

- wyłania się

- nacisk

- podkreślił

- umożliwiać

- Umożliwia

- kodowanie

- zobowiązany

- zaręczynowy

- Inżynieria

- wzmacniać

- wzmocnione

- dość

- zapewnić

- zapewnienie

- Środowisko

- równy

- szczególnie

- niezbędny

- itp

- oceny

- ewaluację

- Parzyste

- wydarzenia

- wszyscy

- ewoluuje

- ewoluuje

- przykład

- przykłady

- doskonała

- oczekiwanie

- oczekiwania

- spodziewany

- drogi

- doświadczenie

- Doświadczenia

- eksperymenty

- ekspert

- ekspertyza

- eksperci

- eksploatowany

- eksploracja

- zbadane

- odkrywa

- Exploring

- narażony

- rozległy

- oko

- Twarz

- twarze

- ułatwia

- nie

- wentylator

- szybciej

- najszybszy

- informacja zwrotna

- kilka

- mniej

- pole

- wypełniać

- i terminów, a

- pięć

- Migać

- pływ

- Przepływy

- Skupiać

- koncentruje

- obserwuj

- W razie zamówieenia projektu

- przewidywalny

- formacja

- Fundacja

- założyciel

- cztery

- Czwarty

- częsty

- często

- od

- fundamentalny

- fuzja

- przyszłość

- Gemini

- Ogólne

- ogólna inteligencja

- Generować

- generujący

- generacja

- generatywny

- generatywna sztuczna inteligencja

- dany

- daje

- Dojrzeć

- Go

- cel

- dobry

- GPU

- GPU

- przełomowy

- Zarządzanie

- Grupy

- Rozwój

- miał

- Prowadzenie

- siła robocza

- szkodliwy

- Wykorzystywanie

- harvard

- Harvard University

- Have

- he

- głowa

- Zdrowie

- opieki zdrowotnej

- ciężki

- Trzymany

- pomoc

- pomógł

- jej

- Wysoki

- wysoka rozdzielczość

- Podświetlony

- wysoko

- utrudniać

- jego

- godzina

- GODZINY

- W jaki sposób

- How To

- Jednak

- http

- HTTPS

- człowiek

- Ludzie

- i

- pomysł

- if

- świetlny

- obraz

- zdjęcia

- realizowane

- znaczenie

- ważny

- podnieść

- in

- informacje

- zawierać

- włączony

- Włącznie z

- wzrastający

- coraz bardziej

- indywidualny

- nieunikniony

- Nieskończony

- Informacja

- informacyjny

- Infrastruktura

- nieodłączny

- właściwie

- Innowacja

- Innowacyjny

- wkład

- spostrzeżenia

- przykład

- zamiast

- integracja

- Inteligencja

- wzajemne oddziaływanie

- połączone

- zainteresowania

- interwencje

- najnowszych

- wprowadzono

- zaproszony

- IT

- szt

- jpg

- sądy

- Klawisz

- Wiedzieć

- wiedza

- znany

- laboratorium

- etykietowanie

- krajobrazy

- język

- duży

- trwały

- firmy

- nośny

- prowadzić

- prowadzący

- UCZYĆ SIĘ

- dowiedziałem

- uczniowie

- nauka

- uczy się

- Dziedzictwo

- mniej

- Lekcje

- niech

- poziomy

- leży

- lekki

- lubić

- prawdopodobieństwo

- ograniczenie

- Ograniczony

- Linda

- Lista

- Zyje

- LLM

- miejscowy

- długo

- dłużej

- Popatrz

- poszukuje

- maszyna

- uczenie maszynowe

- pocztowy

- Główny

- zarządzanie

- zarządzający

- wiele

- mistrz

- dopasowywanie

- materiał

- Matters

- Maksymalna szerokość

- Może..

- wymowny

- Mechanizmy

- wspomnienia

- Pamięć

- sam

- wiadomości

- Meta

- metoda

- Metryka

- może

- milion

- minimalizuje

- minut

- brakujący

- model

- modele

- moment

- miesięcy

- jeszcze

- bardziej wydajny

- większość

- przeniósł

- dużo

- wielokrotność

- musi

- Nazwa

- rodzimy

- Naturalny

- Potrzebować

- ujemny

- Nowości

- Nowy Orlean

- Nie

- Hałas

- żaden

- noty

- powieść

- już dziś

- zacienienie

- numer

- przedmiot

- obiekty

- of

- oferta

- oferuje

- Oferty

- często

- starszych

- on

- ONE

- Online

- tylko

- koncepcja

- open source

- otwierany

- operacje

- Szanse

- Optymalizacja

- Option

- or

- Zdrowie jamy ustnej

- Zorganizowany

- Orlean

- Inne

- Inni uczestnicy

- Pozostałe

- ludzkiej,

- koniec

- przegląd

- własny

- palma

- płyta

- paradygmaty

- parametry

- część

- Uczestnicy

- udział

- szczególny

- szczególnie

- strony

- Przeszłość

- ścieżki

- wzory

- Ludzie

- dla

- postrzeganie

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- perspektywy

- kawałek

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- odgrywa

- polityka

- stwarzane

- pozytywny

- pozytywnie

- posiada

- możliwość

- możliwy

- potencjał

- potencjalnie

- przewidywanie

- teraźniejszość

- presentation

- przedstawione

- poprzedni

- głównie

- pierwotny

- Zasady

- Problem

- problemy

- procedura

- wygląda tak

- procesów

- przetwarzanie

- Wytworzony

- produktywny

- Profesor

- głęboko

- Programowanie

- projekt

- projektowanie

- wybitny

- niska zabudowa

- Sprawdzony

- zapewniać

- pod warunkiem,

- opublikowany

- cel

- pościg

- jakość

- zapytania

- poszukiwanie

- całkiem

- Wyścig

- przypadkowy

- zasięg

- szybki

- szybko

- raczej

- Oceny

- real

- Prawdziwy świat

- rozsądny

- otrzymać

- Odebrane

- niedawny

- uznanie

- Zalecana

- redukcja

- refleksja

- relacje

- stosunkowo

- zwolnić

- niezawodność

- poleganie

- pozostały

- powtarzalne

- Raportowanie

- reprezentacja

- reprezentowanie

- wymagać

- wymagany

- wymagania

- Badania naukowe

- badacz

- Badacze

- rozwiązać

- Zasoby

- Odpowiadać

- respondenci

- odpowiedź

- Odpowiedzi

- odpowiedzialny

- przeglądu

- krzepki

- Rola

- ukorzeniony

- w przybliżeniu

- pędzić

- "bezpiecznym"

- Bezpieczeństwo

- skalowaniem

- scenariusze

- scena

- nauka

- NAUKI

- Naukowiec

- widzieć

- poszukuje

- wydaje

- widziany

- semantyka

- Serie

- modelacja

- shared

- ona

- Targi

- znak

- Signal

- Sygnały

- znaczący

- znacznie

- Prosty

- pojedynczy

- umiejętności

- mały

- mądrzejszy

- smartfony

- So

- Obserwuj Nas

- rozwiązanie

- Rozwiązania

- ROZWIĄZANIA

- kilka

- Dźwięk

- Źródło

- Typ przestrzeni

- Przestrzenne

- swoiście

- wydać

- Stabilność

- stabilny

- Stanford

- Uniwersytet Stanford

- statystyka

- Nadal

- strategie

- strumień

- silne strony

- silny

- strukturyzacja

- taki

- Wskazuje

- PODSUMOWANIE

- Dostawa

- niespodzianka

- Susan

- składnia

- synteza

- syntetyczny

- dane syntetyczne

- system

- systemy

- Takeaways

- trwa

- Mówić

- Rozmowy

- Zadanie

- zadania

- zespół

- tech

- Techniczny

- Tendencję

- REGULAMIN

- XNUMX

- niż

- że

- Połączenia

- Przyszłość

- ich

- Im

- motywy

- Tam.

- Te

- one

- to

- tych

- trzy

- Przez

- czas

- do

- razem

- narzędzie

- narzędzia

- TOPBOTY

- aktualny

- tematy

- Kwota produktów:

- w kierunku

- trackery

- tradycyjny

- Trening

- przenieść

- transformator

- Przezroczystość

- leczenia

- Trend

- Prawda

- stara

- SKRĘCAĆ

- drugiej

- zazwyczaj

- dla

- przechodzi

- zrozumienie

- uniwersytet

- Nowości

- posługiwać się

- używany

- Użytkownicy

- za pomocą

- zazwyczaj

- wykorzystany

- Cenny

- wartość

- różnorodność

- różnorodny

- wibrujący

- Wideo

- Filmy

- punkty widzenia

- wizja

- Luki w zabezpieczeniach

- W3

- była

- sposoby

- we

- zdatny do noszenia

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- ilekroć

- natomiast

- czy

- który

- Podczas

- KIM

- dlaczego

- szeroki

- Szeroki zasięg

- będzie

- okno

- chcieć

- w

- Praca

- pracujący

- Źle

- lat

- jeszcze

- You

- młody

- zefirnet