Wprowadzenie

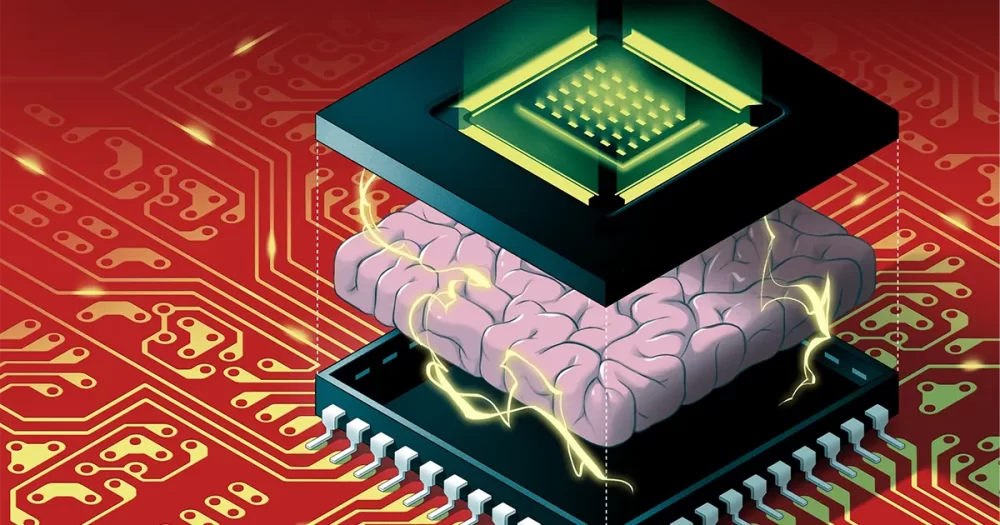

Algorytmy sztucznej inteligencji nie mogą rozwijać się w obecnym tempie. Algorytmy takie jak głębokie sieci neuronowe – które są luźno inspirowane mózgiem, z wieloma warstwami sztucznych neuronów połączonych ze sobą za pomocą wartości liczbowych zwanych wagami – stają się coraz większe z każdym rokiem. Ale w dzisiejszych czasach ulepszenia sprzętu nie nadążają już za ogromną ilością pamięci i mocy obliczeniowej wymaganych do uruchamiania tych ogromnych algorytmów. Wkrótce rozmiar algorytmów sztucznej inteligencji może zderzyć się ze ścianą.

I nawet gdybyśmy mogli nadal skalować sprzęt, aby sprostać wymaganiom sztucznej inteligencji, jest jeszcze jeden problem: uruchamianie ich na tradycyjnych komputerach powoduje marnowanie ogromnej ilości energii. Wysoka emisja dwutlenku węgla generowana przez uruchamianie dużych algorytmów AI jest już szkodliwa dla środowiska, a będzie się tylko pogarszać, gdy algorytmy będą coraz bardziej gigantyczne.

Jedno z rozwiązań, zwane obliczeniami neuromorficznymi, czerpie inspirację z mózgów biologicznych do tworzenia energooszczędnych projektów. Niestety, chociaż te chipy mogą wyprzedzić komputery cyfrowe pod względem oszczędzania energii, brakowało im mocy obliczeniowej potrzebnej do uruchomienia sporej głębokiej sieci neuronowej. Dzięki temu badacze AI mogą je łatwo przeoczyć.

To w końcu zmieniło się w sierpniu, kiedy Weiera Wana, H.-S. Filipa Wonga, Gerta Cauwenberghsa i ich współpracowników ujawnił nowy chip neuromorficzny zwany NeuRRAM, który zawiera 3 miliony komórek pamięci i tysiące neuronów wbudowanych w swój sprzęt do uruchamiania algorytmów. Wykorzystuje stosunkowo nowy typ pamięci zwany rezystancyjną pamięcią RAM lub RRAM. W przeciwieństwie do poprzednich chipów RRAM, NeuRRAM jest zaprogramowany do działania w sposób analogowy, aby zaoszczędzić więcej energii i miejsca. Podczas gdy pamięć cyfrowa jest binarna — przechowując 1 lub 0 — analogowe komórki pamięci w układzie NeuRRAM mogą przechowywać wiele wartości w całkowicie ciągłym zakresie. Dzięki temu chip może przechowywać więcej informacji z potężnych algorytmów sztucznej inteligencji w tej samej ilości miejsca na chipie.

W rezultacie nowy chip może wykonywać tak samo dobrze, jak komputery cyfrowe w złożonych zadaniach AI, takich jak rozpoznawanie obrazu i mowy, a autorzy twierdzą, że jest do 1,000 razy bardziej energooszczędny, co daje małym chipom możliwość uruchamiania coraz bardziej skomplikowanych algorytmów w małych urządzeniach, które wcześniej nie były odpowiednie dla sztucznej inteligencji, takich jak inteligentne zegarki i telefony.

Badacze niezaangażowani w prace byli pod ogromnym wrażeniem wyników. „Ten artykuł jest dość wyjątkowy” – powiedział Zhongrui Wanga, długoletni badacz RRAM na Uniwersytecie w Hong Kongu. „Wnosi wkład na różnych poziomach — na poziomie urządzenia, na poziomie architektury obwodów i na poziomie algorytmu”.

Tworzenie nowych wspomnień

W komputerach cyfrowych ogromne ilości energii marnowanej podczas działania algorytmów AI są spowodowane prostą i wszechobecną wadą projektową, która sprawia, że każde obliczenie jest nieefektywne. Zazwyczaj pamięć komputera — przechowująca dane i wartości liczbowe, które przetwarza podczas obliczeń — jest umieszczona na płycie głównej z dala od procesora, w którym odbywa się przetwarzanie.

Jeśli chodzi o informacje płynące przez procesor, „to tak, jakbyś spędzał osiem godzin na dojeździe, ale wykonujesz dwie godziny pracy”, powiedział Wan, informatyk dawniej na Uniwersytecie Stanforda, który niedawno przeniósł się do start-upu AI Aizip.

Wprowadzenie

Rozwiązanie tego problemu za pomocą nowych chipów all-in-one, które umieszczają pamięć i obliczenia w tym samym miejscu, wydaje się proste. Jest również bliższy temu, w jaki sposób nasz mózg prawdopodobnie przetwarza informacje, ponieważ wielu neuronaukowców uważa, że obliczenia zachodzą w populacjach neuronów, podczas gdy wspomnienia powstają, gdy synapsy między neuronami wzmacniają lub osłabiają ich połączenia. Jednak tworzenie takich urządzeń okazało się trudne, ponieważ obecne formy pamięci są niezgodne z technologią procesorów.

Informatycy dziesiątki lat temu opracowali materiały do tworzenia nowych chipów, które wykonują obliczenia, w których przechowywana jest pamięć — technologia znana jako obliczenie w pamięci. Ale przy tak dobrych wynikach tradycyjnych komputerów cyfrowych te pomysły były pomijane przez dziesięciolecia.

„Ta praca, podobnie jak większość prac naukowych, została trochę zapomniana” – powiedział Wong, profesor w Stanford.

Rzeczywiście, pierwsze takie urządzenie sięga co najmniej 1964 roku, kiedy inżynierowie elektrycy ze Stanford odkryli, że mogą manipulować niektórymi materiałami, zwanymi tlenkami metali, aby włączać i wyłączać ich zdolność przewodzenia elektryczności. Jest to istotne, ponieważ zdolność materiału do przełączania się między dwoma stanami stanowi podstawę tradycyjnego przechowywania w pamięci. Zazwyczaj w pamięci cyfrowej stan wysokiego napięcia odpowiada 1, a niskiemu 0.

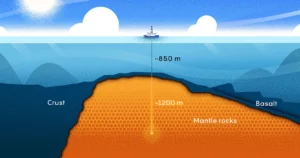

Aby urządzenie RRAM przełączało stany, przykładasz napięcie do metalowych elektrod podłączonych do dwóch końców tlenku metalu. Zwykle tlenki metali są izolatorami, co oznacza, że nie przewodzą prądu. Ale przy wystarczającym napięciu prąd narasta, w końcu przebijając się przez słabe punkty materiału i tworząc ścieżkę do elektrody po drugiej stronie. Gdy prąd się przebije, może swobodnie płynąć tą ścieżką.

Wong porównuje ten proces do błyskawicy: gdy w chmurze zgromadzi się wystarczająco dużo ładunku, szybko znajduje ścieżkę o niskim oporze i uderza piorun. Ale w przeciwieństwie do pioruna, którego ścieżka znika, ścieżka przez tlenek metalu pozostaje, co oznacza, że pozostaje on przewodzący w nieskończoność. Możliwe jest wymazanie ścieżki przewodzącej poprzez przyłożenie innego napięcia do materiału. Naukowcy mogą więc przełączać pamięć RRAM między dwoma stanami i wykorzystywać ją do przechowywania pamięci cyfrowej.

Badacze z połowy wieku nie dostrzegli potencjału energooszczędnego przetwarzania, ani nie potrzebowali go jeszcze z mniejszymi algorytmami, z którymi pracowali. Dopiero na początku XXI wieku, wraz z odkryciem nowych tlenków metali, naukowcy zdali sobie sprawę z możliwości.

Wong, który pracował w tym czasie w IBM, wspomina, że nagradzany kolega pracujący nad RRAM przyznał, że nie w pełni rozumiał związaną z tym fizykę. „Jeśli tego nie rozumie”, wspomina Wong, „może nie powinienem próbować tego zrozumieć”.

Jednak w 2004 roku naukowcy z Samsung Electronics ogłosili, że: pomyślnie zintegrowana pamięć RRAM zbudowany na tradycyjnym chipie obliczeniowym, co sugeruje, że w końcu możliwe będzie zastosowanie chipu obliczeniowego w pamięci. Wong postanowił przynajmniej spróbować.

Chipy obliczeniowe w pamięci dla AI

Przez ponad dekadę badacze tacy jak Wong pracowali nad rozwinięciem technologii RRAM do punktu, w którym mogłaby ona niezawodnie obsługiwać zadania obliczeniowe o dużej mocy. Około 2015 roku informatycy zaczęli dostrzegać ogromny potencjał tych energooszczędnych urządzeń dla dużych algorytmów sztucznej inteligencji, które zaczęły się rozwijać. W tym roku naukowcy z Uniwersytetu Kalifornijskiego w Santa Barbara pokazał że urządzenia RRAM mogą robić więcej niż tylko przechowywać pamięć w nowy sposób. Mogą samodzielnie wykonywać podstawowe zadania obliczeniowe — w tym zdecydowaną większość obliczeń, które mają miejsce w sztucznych neuronach sieci neuronowej, które są prostymi zadaniami mnożenia macierzy.

W układzie NeuRRAM krzemowe neurony są wbudowane w sprzęt, a komórki pamięci RRAM przechowują wagi — wartości reprezentujące siłę połączeń między neuronami. A ponieważ komórki pamięci NeuRRAM są analogowe, wagi, które przechowują, reprezentują pełny zakres stanów rezystancji, które występują, gdy urządzenie przełącza się między stanem niskiej rezystancji a stanem wysokiej rezystancji. Umożliwia to jeszcze wyższą efektywność energetyczną niż cyfrowa pamięć RRAM, ponieważ chip może wykonywać wiele obliczeń macierzowych równolegle — a nie jedno po drugim, jak w wersjach z cyfrowym przetwarzaniem.

Ale ponieważ przetwarzanie analogowe jest wciąż opóźnione o dziesięciolecia w stosunku do przetwarzania cyfrowego, wciąż pozostaje wiele problemów do rozwiązania. Jednym z nich jest to, że analogowe chipy RRAM muszą być niezwykle precyzyjne, ponieważ niedoskonałości fizycznego chipa mogą wprowadzać zmienność i szum. (W przypadku tradycyjnych chipów, z tylko dwoma stanami, te niedoskonałości nie mają większego znaczenia.) To znacznie utrudnia uruchamianie algorytmów AI przez analogowe urządzenia RRAM, biorąc pod uwagę, że dokładność rozpoznawania obrazu ucierpi, jeśli stan przewodzenia urządzenia RRAM nie jest za każdym razem dokładnie taki sam.

„Kiedy patrzymy na ścieżkę oświetlenia, za każdym razem jest ona inna” — powiedział Wong. „W rezultacie RRAM wykazuje pewien stopień stochastyczności – za każdym razem, gdy je programujesz, jest nieco inny”. Wong i jego współpracownicy udowodnili, że urządzenia RRAM mogą przechowywać ciągłe wagi AI i nadal być tak dokładne, jak komputery cyfrowe, jeśli algorytmy zostaną przeszkolone, aby przyzwyczaić się do szumu, jaki napotykają na chipie, postęp, który umożliwił im wyprodukowanie chipa NeuRRAM.

Wprowadzenie

Innym ważnym problemem, który musieli rozwiązać, była elastyczność niezbędna do obsługi różnych sieci neuronowych. W przeszłości projektanci chipów musieli ustawiać malutkie urządzenia RRAM w jednym obszarze obok większych neuronów krzemowych. Urządzenia RRAM i neurony były okablowane na stałe bez możliwości programowania, więc obliczenia mogły być wykonywane tylko w jednym kierunku. Aby wspierać sieci neuronowe z obliczeniami dwukierunkowymi, potrzebne były dodatkowe przewody i obwody, zwiększając zapotrzebowanie na energię i przestrzeń.

Zespół Wonga zaprojektował więc nową architekturę chipów, w której zmieszano urządzenia pamięci RRAM i neurony krzemowe. Ta niewielka zmiana w projekcie zmniejszyła całkowitą powierzchnię i zaoszczędziła energię.

„Myślałem, że [układ] jest naprawdę piękny” — powiedział Melika Payvand, badacz neuromorfów ze Szwajcarskiego Federalnego Instytutu Technologii w Zurychu. „Zdecydowanie uważam to za przełomowe dzieło”.

Przez kilka lat zespół Wonga współpracował ze współpracownikami nad projektowaniem, produkcją, testowaniem, kalibracją i uruchamianiem algorytmów AI na chipie NeuRRAM. Rozważano użycie innych powstających typów pamięci, które mogą być również używane w chipach obliczeniowych w pamięci, ale pamięć RRAM miała przewagę ze względu na jej zalety w programowaniu analogowym i dlatego, że była stosunkowo łatwa do zintegrowania z tradycyjnymi materiałami obliczeniowymi.

Ich ostatnie wyniki reprezentują pierwszy układ RRAM, który może obsługiwać tak duże i złożone algorytmy sztucznej inteligencji – wyczyn, który wcześniej był możliwy tylko w symulacjach teoretycznych. „Jeśli chodzi o prawdziwy krzem, brakowało tej możliwości” — powiedział Anup Das, informatyk na Uniwersytecie Drexel. „Ta praca jest pierwszą demonstracją”.

„Cyfrowe systemy sztucznej inteligencji są elastyczne i precyzyjne, ale o rzędy wielkości mniej wydajne” – powiedział Cauwenberghs. Teraz, jak powiedział Cauwenberghs, ich elastyczny, precyzyjny i energooszczędny analogowy chip RRAM „po raz pierwszy wypełnił lukę”.

Skalowanie

Projekt zespołu sprawia, że chip NeuRRAM jest malutki — tylko wielkości paznokcia — jednocześnie wyciskając 3 miliony urządzeń pamięci RRAM, które mogą służyć jako procesory analogowe. I chociaż może obsługiwać sieci neuronowe co najmniej tak dobrze, jak komputery cyfrowe, chip może również (i po raz pierwszy) uruchamiać algorytmy wykonujące obliczenia w różnych kierunkach. Ich układ może wprowadzać napięcie do wierszy tablicy RRAM i odczytywać dane wyjściowe z kolumn, tak jak jest to standardowe dla układów RRAM, ale może również robić to wstecz z kolumn do wierszy, dzięki czemu może być używany w sieciach neuronowych, które działają z danymi przepływającymi w różnych kierunkach.

Podobnie jak w przypadku samej technologii RRAM, było to możliwe od dawna, ale nikt nie pomyślał, aby to zrobić. „Dlaczego wcześniej o tym nie pomyśleliśmy?” — zapytał Payvand. „Z perspektywy czasu nie wiem”.

„To faktycznie otwiera wiele innych możliwości” – powiedział Das. Jako przykłady podał zdolność prostego systemu do uruchamiania ogromnych algorytmów potrzebnych do wielowymiarowych symulacji fizyki lub samojezdnych samochodów.

Problemem jest jednak rozmiar. Największe sieci neuronowe zawierają teraz miliardy wag, a nie miliony zawarte w nowych chipach. Wong planuje zwiększyć skalę, układając wiele chipów NeuRRAM jeden na drugim.

Równie ważne będzie utrzymanie niskich kosztów energii w przyszłych urządzeniach lub ich dalsze zmniejszanie. Jednym ze sposobów, aby się tam dostać, jest kopiowanie mózgu jeszcze ściślej, aby przyjąć sygnał komunikacyjny używany między prawdziwymi neuronami: impuls elektryczny. Jest to sygnał wysyłany z jednego neuronu do drugiego, gdy różnica napięcia między wnętrzem i zewnętrzem komórki osiąga krytyczny próg.

„Są tam duże wyzwania” – powiedział Tony'ego Kenyona, badacz nanotechnologii z University College London. „Ale nadal możemy chcieć iść w tym kierunku, ponieważ … są szanse, że będziesz mieć większą wydajność energetyczną, jeśli użyjesz bardzo rzadkich kolców”. Kenyon zauważył, że uruchomienie algorytmów, które przyspieszają działanie obecnego układu NeuRRAM, prawdopodobnie wymagałoby zupełnie innej architektury.

Na razie efektywność energetyczna, jaką zespół osiągnął podczas uruchamiania dużych algorytmów AI na chipie NeuRRAM, stworzyła nową nadzieję, że technologie pamięci mogą reprezentować przyszłość obliczeń ze sztuczną inteligencją. Może pewnego dnia będziemy nawet w stanie dopasować 86 miliardów neuronów ludzkiego mózgu i biliony synaps, które je łączą, bez wyczerpania mocy.