GTC Długo oczekiwane akceleratory Hopper H100 firmy Nvidia zaczną być dostarczane pod koniec przyszłego miesiąca w układach HGX zbudowanych przez producentów OEM, poinformował krzemowy gigant na dzisiejszej konferencji GPU Technology Conference (GTC).

Jednak ci, którzy czekają, aby zdobyć systemy Nvidia DGX H100, będą musieli poczekać do pierwszego kwartału przyszłego roku. DGX to linia stacji roboczych i serwerów Nvidii wykorzystujących jej procesory graficzne i połączenia, a systemy HGX to serwery stworzone przez partnerów, ponownie wykorzystujące technologię Nv.

I podczas gdy Nvidia reklamuje swoją architekturę Hopper w centrum danych, większość zestawu Enterprise Kit ogłoszonego w tym tygodniu nie dostanie w najbliższym czasie flagowej architektury tego giganta chipowego.

Na krawędzi Nvidia wydaje się być zadowolona z pełnego życia dzięki swojej architekturze Ampere.

Dzisiaj Nvidia szczegółowo opisała platformę nowej generacji AI i robotyki, którą nazywa IGX.

IGX to „kompleksowa platforma obliczeniowa, która przyspiesza wdrażanie inteligentnych maszyn i urządzeń medycznych w czasie rzeczywistym” – powiedziała Kimberly Powell, szefowa służby zdrowia w Nvidii. W swej istocie system jest w zasadzie rozszerzoną wersją ogłoszonego wcześniej przez Nvidię modułu Jetson AGX Orin. wiosna.

„IGX to pełny system z procesorem robotycznym Nvidia Orin, procesorem tensorowym Ampere, procesorem I/O strumieniowego przesyłania strumieniowego ConnectX, funkcjonalną wyspą bezpieczeństwa i jednostką mikrokontrolera bezpieczeństwa, ponieważ coraz więcej robotów i ludzi będzie pracować w tym samym środowisku ," ona dodała.

Pod względem wydajności nie ma tu wiele nowego. Powiedziano nam, że platforma jest oparta na systemie przemysłowym Orin na module z 64 GB pamięci, który jest porównywalny pod względem wydajności z modułem AGX Orin wprowadzonym na rynek na początku tego roku. System ten zawierał 32 GB pamięci, ośmiordzeniowy procesor Arm Cortex A78AE i procesor graficzny Ampere.

IGX zyskuje zintegrowaną kartę sieciową ConnectX-7 zapewniającą szybką łączność za pomocą dwóch interfejsów 200 Gb/s. Płyta wydaje się również zawierać pełen zestaw pamięci M.2, gniazda PCIe i co najmniej jedno starsze gniazdo PCI do rozbudowy.

Nvidia kieruje platformę IGX do różnych przypadków użycia sztucznej inteligencji i robotyki w opiece zdrowotnej, produkcji i logistyce, gdzie poufność lub opóźnienia sprawiają, że bardziej scentralizowane systemy stają się niepraktyczne.

Podobnie jak AGX Orin, system uzupełnia pakiet oprogramowania AI Enterprise firmy Nvidia oraz platforma Fleet Command do wdrażania i zarządzania.

Jednym z pierwszych zastosowań platformy IGX będzie wykorzystanie platformy obrazowania robotów firmy Nvidia.

„Nvidia Clara Holoscan to nasza platforma aplikacji, która znajduje się na szczycie IGX dla urządzeń medycznych i obrazowania rurociągów robotyki” – wyjaśnił Powell.

Trzej producenci urządzeń medycznych – Activ Surgical, Moon Surgical i Proximinie – planują wykorzystać IGX i Clara Holoscan do zasilania swoich platform robotyki chirurgicznej i teleobecności. Zestawy deweloperskie IGX Orin mają zostać wysłane na początku przyszłego roku wraz z systemami produkcyjnymi dostępnymi od ADLink, Advantech, Dedicated Computing, Kontron, MBX i Onyx, aby wymienić tylko kilka.

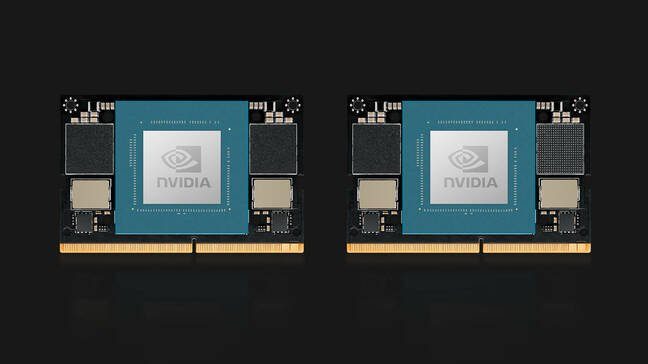

W temacie Orin, Nvidia zaprezentowała również swoje moduły obliczeniowe Jetson Orin Nano. Orin Nano jest dostępny w dwóch konfiguracjach w momencie premiery, w tym wersja 8 GB zdolna do 40 TOPS wnioskowania AI oraz wersja okrojona z 4 GB pamięci zdolna do 20 TOPS.

Podobnie jak poprzednie moduły Jetson, Orin Nano wykorzystuje złącze krawędziowe zgodne ze stykami, przypominające złącze używane w pamięci SODIMM laptopa i zużywa od 5 W do 15 W w zależności od aplikacji i SKU. Moduły Nvidia Jetson Orin Nano są dostępne w styczniu w cenie od 199 USD.

Odświeżenie OVX

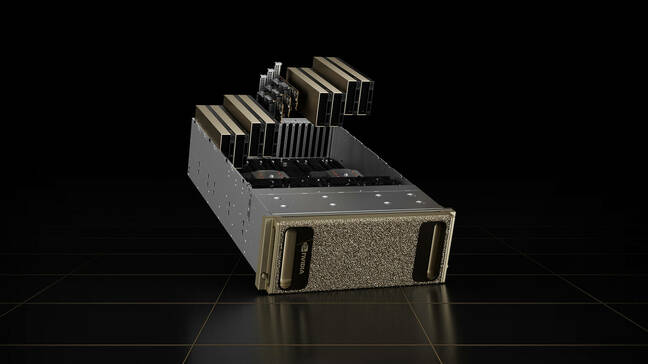

Serwery OVX firmy Nvidia, które zostały zaprojektowane do obsługi platformy Omniverse, również nie będą działać na Hopperze.

Systemy wizualizacji drugiej generacji i bliźniacze cyfrowe firmy są wyposażone w osiem procesorów graficznych L40. Karty są oparte na architekturze Ada Lovelace nowej generacji i zawierają rdzenie ray tracingu trzeciej generacji oraz rdzenie tensorowe czwartej generacji.

Procesorom graficznym towarzyszy para procesorów Ice Lake Intel Xeon Platinum 8362, co daje łącznie 128 wątków procesora z częstotliwością do 3.6 GHz.

Zmieniony system OVX firmy Nvidia zawiera osiem procesorów graficznych Ada Lovelace w złotej obudowie

Systemowi obliczeniowemu towarzyszą trzy karty sieciowe ConnectX-7, każda o przepustowości 400 Gb/s, oraz 16 TB pamięci NVMe. Chociaż system jest dostępny jako pojedyncze węzły, Nvidia przewiduje, że będzie wdrażany jako część tego, co nazywa OVX SuperPod, który zawiera 32 systemy połączone za pomocą przełączników firmy Spectrum-51.2 o przepustowości 3 Tb/s.

Systemy drugiej generacji będą dostępne w firmach Lenovo, Supermicro i Inspur od 2023 roku. W przyszłości Nvidia planuje rozszerzyć dostępność systemów na kolejnych partnerów.

Wskoczyłem na Drive Thor

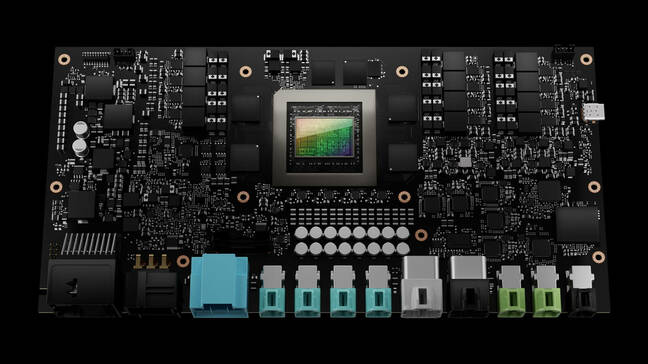

Jedynym elementem zestawu ogłoszonym podczas GTC w tym tygodniu, który otrzyma architekturę Hopper firmy Nvidia, jest system komputerowy pojazdu autonomicznego Drive Thor.

Drive Thor zastępuje platformę Nvidia Atlan w planie działania na 2025 r. i obiecuje dostarczyć 2,000 TOPS wydajności wnioskowania po jej uruchomieniu.

Komputer autonomicznego pojazdu Drive Thor firmy Nvidia obiecuje 2,000 TOPS wydajności, gdy zostanie wprowadzony na rynek w 2025 r

„Drive Thor jest wyposażony w najnowocześniejsze możliwości wprowadzone w naszym procesorze Grace, naszym procesorze graficznym Hopper i naszej architekturze GPU nowej generacji” – powiedział na konferencji prasowej Danny Shapiro, wiceprezes ds. motoryzacji w firmie Nvidia. Powiedział, że Drive Thor ma na celu ujednolicenie litanii systemów komputerowych, które zasilają nowoczesne samochody w jedną scentralizowaną platformę.

„Spójrz na dzisiejsze zaawansowane systemy wspomagania kierowcy – parkowanie, monitorowanie kierowcy, lusterka, cyfrowy zestaw wskaźników, systemy informacyjno-rozrywkowe – wszystkie znajdują się na różnych komputerach rozmieszczonych w całym pojeździe” – powiedział. „Jednak w 2025 roku te funkcje nie będą już oddzielnymi komputerami. Drive Thor pozwoli raczej producentom na skuteczną konsolidację tych funkcji w jednym systemie”.

Aby poradzić sobie ze wszystkimi informacjami przesyłanymi strumieniowo z czujników samochodowych, chip posiada izolację wielu domen obliczeniowych, która, jak twierdzi Nvidia, umożliwia równoczesne uruchamianie krytycznych procesów bez przerw.

Technologia pozwala również chipowi na jednoczesne uruchamianie wielu systemów operacyjnych, aby dostosować je do różnych zastosowań pojazdu. Na przykład podstawowy system operacyjny samochodu może działać pod kontrolą systemu Linux, podczas gdy system informacyjno-rozrywkowy może obsługiwać QNX lub Android.

Nie wiadomo jednak, kiedy zobaczymy tę technologię w akcji. W tej chwili wszyscy trzej partnerzy startowi Nvidii – Zeekr, Xpeng i QCraft – mają siedzibę w Chinach. ®

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- sztuczna inteligencja w bankowości

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- głęboka nauka

- google to

- uczenie maszynowe

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- Rejestr

- zefirnet