1IRIF, CNRS – Université Paris Cité, Francja

2QC Ware, Palo Alto, USA i Paryż, Francja

3Szkoła Informatyki, Uniwersytet w Edynburgu, Szkocja, Wielka Brytania

4F. Hoffmann La Roche AG

Czy ten artykuł jest interesujący czy chcesz dyskutować? Napisz lub zostaw komentarz do SciRate.

Abstrakcyjny

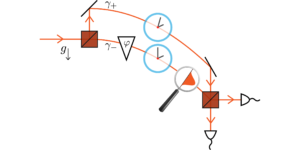

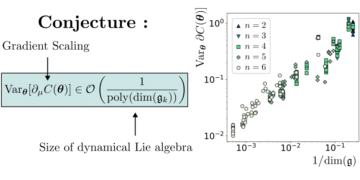

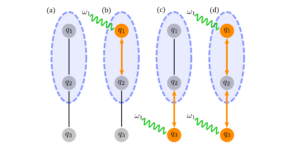

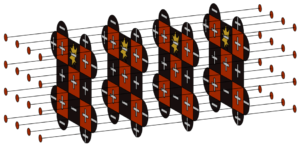

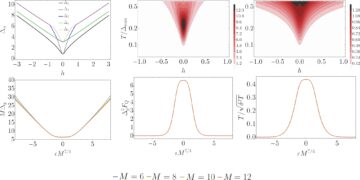

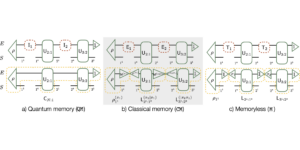

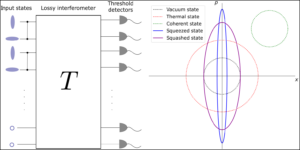

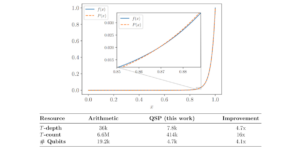

W tej pracy transformatory kwantowe zostały zaprojektowane i szczegółowo przeanalizowane poprzez rozszerzenie najnowocześniejszych klasycznych architektur sieci neuronowych transformatorów, o których wiadomo, że są bardzo wydajne w przetwarzaniu języka naturalnego i analizie obrazu. Bazując na wcześniejszej pracy, w której do ładowania danych wykorzystuje się sparametryzowane obwody kwantowe oraz ortogonalne warstwy neuronowe, wprowadzamy trzy typy transformatorów kwantowych do uczenia i wnioskowania, w tym transformator kwantowy oparty na macierzach złożonych, co gwarantuje teoretyczną przewagę mechanizmu uwagi kwantowej w porównaniu do ich klasycznego odpowiednika zarówno pod względem asymptotycznego czasu działania, jak i liczby parametrów modelu. Te architektury kwantowe można zbudować przy użyciu płytkich obwodów kwantowych i uzyskać jakościowo różne modele klasyfikacji. Trzy proponowane warstwy uwagi kwantowej różnią się zakresem widma od zbliżonego do klasycznych transformatorów i wykazywania bardziej cech kwantowych. Jako elementy składowe transformatora kwantowego proponujemy nowatorską metodę ładowania macierzy w postaci stanów kwantowych, a także dwie nowe, nadające się do trenowania kwantowe warstwy ortogonalne, które można dostosować do różnych poziomów łączności i jakości komputerów kwantowych. Przeprowadziliśmy obszerne symulacje transformatorów kwantowych na standardowych zbiorach danych obrazów medycznych, które wykazały konkurencyjną, a czasami lepszą wydajność w porównaniu z klasycznymi wzorcami, w tym najlepszymi w swojej klasie klasycznymi transformatorami wizyjnymi. Transformatory kwantowe, które przeszkoliliśmy na tych małych zbiorach danych, wymagają mniejszej liczby parametrów w porównaniu ze standardowymi klasycznymi wzorcami. Na koniec wdrożyliśmy nasze transformatory kwantowe w nadprzewodzących komputerach kwantowych i uzyskaliśmy zachęcające wyniki w przypadku maksymalnie sześciu eksperymentów z kubitami.

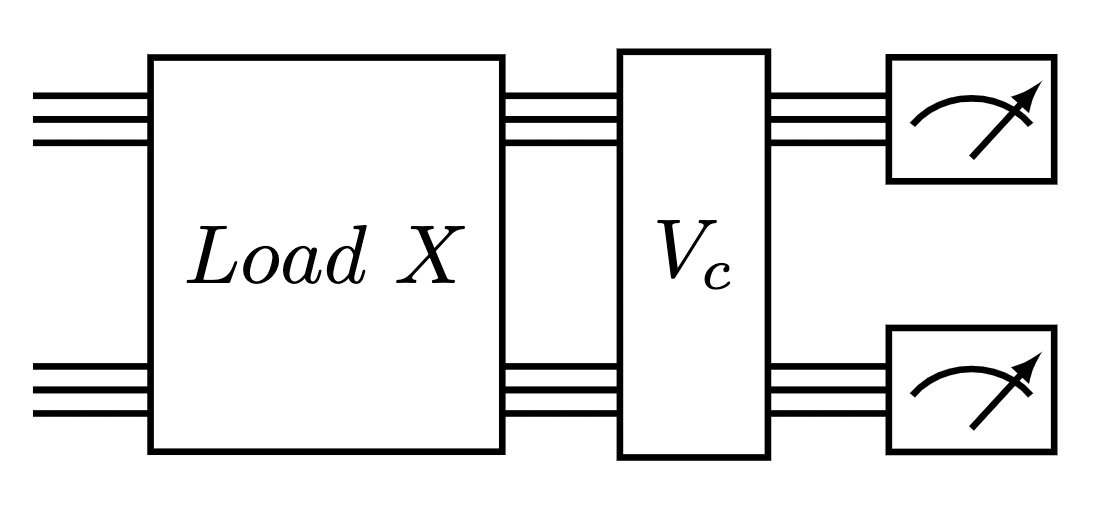

Wyróżniony obraz: Obwód kwantowy uruchamiający jedną warstwę uwagi transformatora złożonego. Moduł ładujący dane macierzowe, po którym następuje ortogonalna warstwa kwantowa.

Popularne podsumowanie

► Dane BibTeX

► Referencje

[1] Jacob Biamonte, Peter Wittek, Nicola Pancotti, Patrick Rebentrost, Nathan Wiebe i Seth Lloyd. „Kwantowe uczenie maszynowe”. Przyroda 549, 195–202 (2017).

https: / / doi.org/ 10.1038 / nature23474

[2] Iris Cong, Soonwon Choi i Mikhail D Lukin. „Kwantowe splotowe sieci neuronowe”. Fizyka przyrody 15, 1273–1278 (2019).

https://doi.org/10.1038/s41567-019-0648-8

[3] Kishor Bharti, Alba Cervera-Lierta, Thi Ha Kyaw, Tobias Haug, Sumner Alperin-Lea, Abhinav Anand, Matthias Degroote, Hermanni Heimonen, Jakob S Kottmann, Tim Menke i in. „Hałasowe algorytmy kwantowe o średniej skali”. Recenzje współczesnej fizyki 94, 015004 (2022).

https: / / doi.org/ 10.1103 / RevModPhys.94.015004

[4] Marco Cerezo, Andrew Arrasmith, Ryan Babbush, Simon C Benjamin, Suguru Endo, Keisuke Fujii, Jarrod R McClean, Kosuke Mitarai, Xiao Yuan, Łukasz Cincio i in. „Wariacyjne algorytmy kwantowe”. Nature Recenzje Fizyka 3, 625–644 (2021).

https://doi.org/10.1038/s42254-021-00348-9

[5] Jonas Landman, Natansh Mathur, Yun Yvonna Li, Martin Strahm, Skander Kazdaghli, Anupam Prakash i Iordanis Kerenidis. „Metody kwantowe sieci neuronowych i zastosowanie do klasyfikacji obrazów medycznych”. Kwant 6, 881 (2022).

https://doi.org/10.22331/q-2022-12-22-881

[6] Bobak Kiani, Randall Balestriero, Yann LeCun i Seth Lloyd. „projunn: Efektywna metoda uczenia głębokich sieci z macierzami unitarnymi”. Postępy w systemach przetwarzania informacji neuronowych 35, 14448–14463 (2022).

[7] Ashish Vaswani, Noam Shazeer, Niki Parmar, Jakob Uszkoreit, Llion Jones, Aidan N Gomez, Łukasz Kaiser i Illia Polosukhin. „Uwaga to wszystko, czego potrzebujesz”. Postępy w neuronowych systemach przetwarzania informacji 30 (2017).

[8] Jacob Devlin, Ming-Wei Chang, Kenton Lee i Kristina Toutanova. „Bert: Wstępne szkolenie głębokich dwukierunkowych transformatorów do rozumienia języka” (2018).

[9] Alexey Dosovitskiy, Lucas Beyer, Alexander Kolesnikov, Dirk Weissenborn, Xiaohua Zhai, Thomas Unterthiner, Mostafa Dehghani, Matthias Minderer, Georg Heigold, Sylvain Gelly, Jakob Uszkoreit i Neil Houlsby. „Obraz jest wart 16×16 słów: Transformatory do rozpoznawania obrazu na dużą skalę”. Międzynarodowa konferencja na temat reprezentacji uczenia się (2021). url: openreview.net/forum?id=YicbFdNTTy.

https:///openreview.net/forum?id=YicbFdNTTy

[10] Yi Tay, Mostafa Dehghani, Dara Bahri i Donald Metzler. „Efektywne transformatory: ankieta”. Ankiety komputerowe ACM (CSUR) (2020).

https: / / doi.org/ 10.1145 / 3530811

[11] Dzmitry Bahdanau, Kyunghyun Cho i Yoshua Bengio. „Neuralowe tłumaczenie maszynowe poprzez wspólną naukę wyrównywania i tłumaczenia” (2016). arXiv:1409.0473 [cs, stat].

arXiv: 1409.0473

[12] J. Schmidhubera. „Zmniejszanie stosunku między złożonością uczenia się a liczbą zmiennych zmiennych w czasie w sieciach w pełni rekurencyjnych”. W: Stan Gielen i Bert Kappen, redaktorzy, ICANN '93. Strony 460–463. Londyn (1993). Skoczek.

https://doi.org/10.1007/978-1-4471-2063-6_110

[13] Jürgena Schmidhubera. „Nauka kontrolowania szybkich wspomnień: alternatywa dla dynamicznych sieci rekurencyjnych”. Obliczenia neuronowe 4, 131–139 (1992).

https: // doi.org/ 10.1162 / neco.1992.4.1.131

[14] Peter Cha, Paul Ginsparg, Felix Wu, Juan Carrasquilla, Peter L McMahon i Eun-Ah Kim. „Tomografia kwantowa oparta na uwadze”. Uczenie maszynowe: nauka i technologia 3, 01LT01 (2021).

https:///doi.org/10.1088/2632-2153/ac362b

[15] Riccardo Di Sipio, Jia-Hong Huang, Samuel Yen-Chi Chen, Stefano Mangini i Marcel Worring. „Początki kwantowego przetwarzania języka naturalnego”. W ICASSP 2022-2022 Międzynarodowa konferencja IEEE na temat akustyki, mowy i przetwarzania sygnałów (ICASSP). Strony 8612–8616. IEEE (2022).

https:///doi.org/10.1109/ICASSP43922.2022.9747675

[16] Guangxi Li, Xuanqiang Zhao i Xin Wang. „Kwantowe sieci neuronowe samouważności do klasyfikacji tekstów” (2022).

[17] Fabio Sanches, Sean Weinberg, Takanori Ide i Kazumitsu Kamiya. „Krótkie obwody kwantowe w zasadach uczenia się przez wzmacnianie dla problemu trasowania pojazdów”. Przegląd fizyczny A 105, 062403 (2022).

https: / / doi.org/ 10.1103 / PhysRevA.105.062403

[18] YuanFu Yang i Min Sun. „Wykrywanie defektów półprzewodników metodą hybrydowego głębokiego uczenia klasyczno-kwantowego”. CVPRStrony 2313–2322 (2022).

https:///doi.org/10.1109/CVPR52688.2022.00236

[19] Maxwell Henderson, Samriddhi Shakya, Shashindra Pradhan i Tristan Cook. „Kwanwolucyjne sieci neuronowe: wspomaganie rozpoznawania obrazów za pomocą obwodów kwantowych”. Inteligencja maszyn kwantowych 2, 1–9 (2020).

https: / / doi.org/ 10.1007 / s42484-020-00012-y

[20] Edwarda Farhiego i Hartmuta Nevena. „Klasyfikacja z kwantowymi sieciami neuronowymi na procesorach bliskiego terminu” (2018). adres URL: doi.org/10.48550/arXiv.1802.06002.

https:///doi.org/10.48550/arXiv.1802.06002

[21] Kosuke Mitarai, Makoto Negoro, Masahiro Kitagawa i Keisuke Fujii. „Uczenie się obwodów kwantowych”. Przegląd fizyczny A 98, 032309 (2018).

https: / / doi.org/ 10.1103 / PhysRevA.98.032309

[22] Kui Jia, Shuai Li, Yuxin Wen, Tongliang Liu i Dacheng Tao. „Ortogonalne głębokie sieci neuronowe”. Transakcje IEEE dotyczące analizy wzorców i inteligencji maszynowej (2019).

https: // doi.org/ 10.1109 / TPAMI.2019.2948352

[23] Rogera A Horna i Charlesa R. Johnsona. „Analiza macierzowa”. Prasa uniwersytecka w Cambridge. (2012).

https: / / doi.org/ 10.1017 / CBO9780511810817

[24] Iordanis Kerenidis i Anupam Prakash. „Kwantowe uczenie maszynowe ze stanami podprzestrzennymi” (2022).

[25] Brooks Foxen, Charles Neill, Andrew Dunsworth, Pedram Roushan, Ben Chiaro, Anthony Megrant, Julian Kelly, Zijun Chen, Kevin Satzinger, Rami Barends i in. „Wykazanie ciągłego zestawu bramek dwukubitowych dla krótkoterminowych algorytmów kwantowych”. Listy przeglądu fizycznego 125, 120504 (2020).

https: / / doi.org/ 10.1103 / PhysRevLett.125.120504

[26] Sonika Johri, Shantanu Debnath, Avinash Mocherla, Alexandros Singk, Anupam Prakash, Jungsang Kim i Iordanis Kerenidis. „Klasyfikacja najbliższego środka ciężkości na komputerze kwantowym z uwięzionymi jonami”. npj Quantum Information 7, 122 (2021).

https://doi.org/10.1038/s41534-021-00456-5

[27] James W Cooley i John W Tukey. „Algorytm maszynowego obliczania złożonych szeregów Fouriera”. Matematyka obliczeniowa 19, 297–301 (1965).

https://doi.org/10.1090/S0025-5718-1965-0178586-1

[28] Li Jing, Yichen Shen, Tena Dubcek, John Peurifoy, Scott A. Skirlo, Yann LeCun, Max Tegmark i Marin Soljacic. „Przestrajalne wydajne unitarne sieci neuronowe (eunn) i ich zastosowanie do rnns”. Na międzynarodowej konferencji na temat uczenia maszynowego. (2016). adres URL: api.semanticscholar.org/CorpusID:5287947.

https:///api.semanticscholar.org/CorpusID:5287947

[29] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla i Elham Kashefi. „Możliwość trenowania i ekspresywność obwodów kwantowych zachowujących masę Hamminga na potrzeby uczenia maszynowego” (2023). arXiv:2309.15547.

arXiv: 2309.15547

[30] Enrico Fontana, Dylan Herman, Shouvanik Chakrabarti, Niraj Kumar, Romina Yalovetzky, Jamie Heredge, Shree Hari Sureshbabu i Marco Pistoia. „Wszystko, czego potrzebujesz, to dodatek: scharakteryzowanie jałowych płaskowyżów w kwantowej ansätze” (2023). arXiv:2309.07902.

arXiv: 2309.07902

[31] Michael Ragone, Bojko N. Bakalov, Frédéric Sauvage, Alexander F. Kemper, Carlos Ortiz Marrero, Martin Larocca i M. Cerezo. „Ujednolicona teoria jałowych płaskowyżów dla głęboko sparametryzowanych obwodów kwantowych” (2023). arXiv:2309.09342.

arXiv: 2309.09342

[32] Xuchen You i Xiaodi Wu. „Wykładniczo wiele minimów lokalnych w kwantowych sieciach neuronowych”. Na międzynarodowej konferencji na temat uczenia maszynowego. Strony 12144–12155. PMLR (2021).

[33] Eric R. Anschuetz i Bobak Toussi Kiani. „Kwantowe algorytmy wariacyjne są zawalone pułapkami”. Komunikacja przyrodnicza 13 (2022).

https://doi.org/10.1038/s41467-022-35364-5

[34] Ilya O. Tolstikhin, Neil Houlsby, Alexander Kolesnikov, Lucas Beyer, Xiaohua Zhai, Thomas Unterthiner, Jessica Yung, Daniel Keysers, Jakob Uszkoreit, Mario Lucic i Alexey Dosovitskiy. „Mlp-mixer: architektura oparta wyłącznie na mlp dla wizji”. W NeurIPS. (2021).

[35] Jiancheng Yang, Rui Shi i Bingbing Ni. „Klasyfikacja medmnist decathlon: lekki test porównawczy automl do analizy obrazów medycznych” (2020).

https:///doi.org/10.1109/ISBI48211.2021.9434062

[36] Jiancheng Yang, Rui Shi, Donglai Wei, Zequan Liu, Lin Zhao, Bilian Ke, Hanspeter Pfister i Bingbing Ni. „Medmnist v2 – lekki test porównawczy na dużą skalę do klasyfikacji obrazów biomedycznych 2D i 3D”. Dane naukowe 10, 41 (2023).

https://doi.org/10.1038/s41597-022-01721-8

[37] Angelos Katharopoulos, Apoorv Vyas, Nikolaos Pappas i François Fleuret. „Transformatory to rnns: szybkie transformatory autoregresyjne z liniową uwagą”. Na międzynarodowej konferencji na temat uczenia maszynowego. Strony 5156–5165. PMLR (2020).

[38] James Bradbury, Roy Frostig, Peter Hawkins, Matthew James Johnson, Chris Leary, Dougal Maclaurin, George Necula, Adam Paszke, Jake VanderPlas, Skye Wanderman-Milne i Qiao Zhang. „JAX: komponowalne transformacje programów Python+NumPy”. GitHuba (2018). adres URL: http:///github.com/google/jax.

http: // github.com/ google / jax

[39] Diederik P. Kingma i Jimmy Ba. „Adam: Metoda optymalizacji stochastycznej”. CoRR abs/1412.6980 (2015).

[40] Hyeonwoo Noh, Tackgeun You, Jonghwan Mun i Bohyung Han. „Regulowanie głębokich sieci neuronowych przez szum: jego interpretacja i optymalizacja”. NeurIPS (2017).

[41] Xue Ying. „Przegląd nadmiernego dopasowania i jego rozwiązań”. W Journal of Physics: Seria konferencji. Tom 1168, strona 022022. Wydawnictwo IOP (2019).

https://doi.org/10.1088/1742-6596/1168/2/022022

Cytowany przez

[1] David Peral García, Juan Cruz-Benito i Francisco José García-Peñalvo, „Przegląd literatury systematycznej: kwantowe uczenie maszynowe i jego zastosowania”, arXiv: 2201.04093, (2022).

[2] El Amine Cherrat, Snehal Raj, Iordanis Kerenidis, Abhishek Shekhar, Ben Wood, Jon Dee, Shouvanik Chakrabarti, Richard Chen, Dylan Herman, Shaohan Hu, Pierre Minssen, Ruslan Shaydulin, Yue Sun, Romina Yalovetzky i Marco Pistoia, „Quantum Deep Hedging”, Kwant 7, 1191 (2023).

[3] Léo Monbroussou, Jonas Landman, Alex B. Grilo, Romain Kukla i Elham Kashefi, „Możliwość trenowania i ekspresywność obwodów kwantowych zachowujących wagę Hamminga do uczenia maszynowego”, arXiv: 2309.15547, (2023).

[4] Sohum Thakkar, Skander Kazdaghli, Natansh Mathur, Iordanis Kerenidis, André J. Ferreira-Martins i Samurai Brito, „Improved Financial Forecasting via Quantum Machine Learning”, arXiv: 2306.12965, (2023).

[5] Jason Iaconis i Sonika Johri, „Efektywne ładowanie obrazów kwantowych w oparciu o sieć Tensor”, arXiv: 2310.05897, (2023).

[6] Nishant Jain, Jonas Landman, Natansh Mathur i Iordanis Kerenidis, „Quantum Fourier Networks for Solving Parametric PDE”, arXiv: 2306.15415, (2023).

[7] Daniel Mastropietro, Georgios Korpas, Wiaczesław Kungurtsev i Jakub Marecek, „Fleming-Viot pomaga przyspieszyć wariacyjne algorytmy kwantowe w obecności jałowych płaskowyżów”, arXiv: 2311.18090, (2023).

[8] Aliza U. Siddiqui, Kaitlin Gili i Chris Ballance, „Stresing Out Modern Quantum Hardware: Performance Evaluation and Execution Insights”, arXiv: 2401.13793, (2024).

Powyższe cytaty pochodzą z Reklamy SAO / NASA (ostatnia aktualizacja pomyślnie 2024-02-22 13:37:43). Lista może być niekompletna, ponieważ nie wszyscy wydawcy podają odpowiednie i pełne dane cytowania.

Nie można pobrać Przywołane przez Crossref dane podczas ostatniej próby 2024-02-22 13:37:41: Nie można pobrać cytowanych danych dla 10.22331 / q-2024-02-22-1265 z Crossref. Jest to normalne, jeśli DOI zostało niedawno zarejestrowane.

Niniejszy artykuł opublikowano w Quantum pod Creative Commons Uznanie autorstwa 4.0 Międzynarodowe (CC BY 4.0) licencja. Prawa autorskie należą do pierwotnych właścicieli praw autorskich, takich jak autorzy lub ich instytucje.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://quantum-journal.org/papers/q-2024-02-22-1265/

- :Jest

- :nie

- ][P

- $W GÓRĘ

- 1

- 10

- 11

- 12

- 125

- 13

- 14

- 15%

- 16

- 17

- 19

- 20

- 2012

- 2015

- 2016

- 2017

- 2018

- 2019

- 2020

- 2021

- 2022

- 2023

- 2024

- 22

- 23

- 24

- 25

- 26%

- 27

- 28

- 29

- 2D

- 30

- 31

- 32

- 33

- 35%

- 36

- 39

- 3d

- 40

- 41

- 43

- 7

- 8

- 9

- 98

- a

- powyżej

- ABSTRACT

- dostęp

- ACM

- Adam

- do tego

- zaliczki

- Korzyść

- Zalety

- powiązania

- AL

- alex

- Alexander

- algorytm

- Algorytmy

- wyrównać

- Wszystkie kategorie

- alternatywny

- an

- analiza

- i

- Andrew

- Anthony

- api

- Zastosowanie

- aplikacje

- architektura

- architektur

- SĄ

- AS

- Założenia

- At

- próba

- Uwaga

- autor

- Autorzy

- AutoML

- bary

- na podstawie

- BE

- ben

- Benchmark

- Benchmarki

- Beniaminek

- Ulepsz Swój

- pomiędzy

- dwukierunkowa

- biomedyczny

- Bloki

- obie

- przerwa

- Budowanie

- wybudowany

- by

- obliczenie

- cambridge

- CAN

- możliwości

- Carlos

- cha

- chang

- Charakterystyka

- Charles

- chen

- CHO

- Chris

- klasyfikacja

- dokładnie

- komentarz

- Lud

- Komunikacja

- w porównaniu

- konkurencyjny

- kompletny

- kompleks

- kompleksowość

- składalny

- Mieszanka

- obliczenia

- komputer

- komputery

- computing

- Konferencja

- Łączność

- ciągły

- kontrola

- prawo autorskie

- mógłby

- Odpowiednik

- odpowiednikami

- Stwórz

- Daniel

- dane

- zbiory danych

- David

- głęboko

- głęboka nauka

- wykazać

- zaprojektowany

- detal

- Wykrywanie

- różne

- dyskutować

- donald

- podczas

- dynamiczny

- E i T

- redaktorzy

- Edward

- skuteczność

- wydajny

- el

- zachęcający

- wzmacniać

- Eric

- ewaluację

- Parzyste

- wykonać

- egzekucja

- wykazujące

- eksperymenty

- odkryj

- rozsuwalny

- rozległy

- FAST

- luty

- mniej

- W końcu

- budżetowy

- skupienie

- następnie

- następujący

- W razie zamówieenia projektu

- Francisco

- od

- w pełni

- Bramy

- George

- GitHub

- Gomez

- gwarancji

- sprzęt komputerowy

- harvard

- zabezpieczających

- pomoc

- pomaga

- posiadacze

- http

- HTTPS

- Huang

- Hybrydowy

- IEEE

- if

- ilia

- obraz

- Klasyfikacja obrazu

- Rozpoznawanie obrazu

- zdjęcia

- realizowane

- ulepszony

- in

- Włącznie z

- Informacja

- spostrzeżenia

- instytucje

- Inteligencja

- ciekawy

- na świecie

- interpretacja

- przedstawiać

- JEGO

- Jakub

- james

- Jamie

- JAVASCRIPT

- Jimmy

- John

- Johnson

- Jon

- Jones

- dziennik

- John

- Kim

- znany

- Kumar

- język

- na dużą skalę

- Nazwisko

- warstwa

- nioski

- nauka

- Pozostawiać

- Lee

- poziomy

- lewarowanie

- Li

- Licencja

- lekki

- lubić

- lin

- liniowy

- Lista

- literatura

- ładowarka

- załadunek

- miejscowy

- Londyn

- maszyna

- uczenie maszynowe

- wiele

- struktura

- mario

- Martin

- matematyka

- Matrix

- Matthew

- max

- Maksymalna szerokość

- Maxwell

- Może..

- Mcclean

- mechanizm

- medyczny

- wspomnienia

- metoda

- metody

- Michał

- michaił

- min

- model

- modele

- Nowoczesne technologie

- Miesiąc

- jeszcze

- Naturalny

- Przetwarzanie języka naturalnego

- Natura

- Blisko

- Potrzebować

- Sieci

- sieć

- sieci

- nerwowy

- sieci neuronowe

- sieci neuronowe

- Nowości

- Hałas

- normalna

- powieść

- numer

- uzyskane

- of

- on

- ONE

- koncepcja

- optymalizacja

- or

- oryginalny

- ludzkiej,

- na zewnątrz

- koniec

- przegląd

- strona

- stron

- Palo Alto

- Papier

- parametry

- Paryż

- Patrick

- Wzór

- Paweł

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywane

- Piotr

- fizyczny

- Fizyka

- Pierre

- plato

- Analiza danych Platona

- PlatoDane

- polityka

- połosukhin

- potencjał

- Zasilanie

- Prakash

- obecność

- teraźniejszość

- konserwowanie

- naciśnij

- poprzedni

- Problem

- przetwarzanie

- Procesory

- produkować

- Programy

- obiecujący

- zaproponować

- zaproponowane

- zapewniać

- opublikowany

- wydawca

- wydawcy

- Wydawniczy

- jakość

- Kwant

- algorytmy kwantowe

- Komputer kwantowy

- komputery kwantowe

- informatyka kwantowa

- informacja kwantowa

- kwantowe uczenie maszynowe

- Kubit

- R

- RAMIA

- stosunek

- niedawno

- uznanie

- nawracający

- referencje

- zarejestrowany

- szczątki

- wymagać

- Efekt

- przeglądu

- Recenzje

- Richard

- skała

- Rzymianin

- Routing

- Roy

- run

- Czas

- Ryan

- s

- Skala

- nauka

- Nauka i technika

- naukowy

- Scott

- Sean

- Serie

- zestaw

- płytki

- pokazał

- Signal

- Szymon, Szymek

- symulacje

- SIX

- Rozwiązania

- Rozwiązywanie

- kilka

- Widmo

- przemówienie

- prędkość

- standard

- state-of-the-art

- Zjednoczone

- Badanie

- Z powodzeniem

- taki

- odpowiedni

- Niedz

- nadprzewodzące

- Badanie

- systemy

- zadania

- Tay

- Technologia

- semestr

- REGULAMIN

- XNUMX

- Klasyfikacja tekstu

- że

- Połączenia

- ich

- teoretyczny

- teoria

- Te

- one

- to

- Tomasz

- trzy

- Tim

- czas

- czasy

- Tytuł

- do

- przeszkolony

- Trening

- transakcje

- przemiany

- transformator

- Transformatory

- tłumaczyć

- Tłumaczenie

- uwięziony

- Pułapki

- drugiej

- typy

- dla

- zrozumienie

- Ujednolicony

- wyjątkowy

- uniwersytet

- zaktualizowane

- na

- URL

- USA

- zastosowania

- za pomocą

- różnią się

- zmienne

- pojazd

- początku.

- przez

- wizja

- Tom

- W

- Wang

- chcieć

- była

- we

- DOBRZE

- który

- w

- drewno

- słowa

- Praca

- wartość

- wu

- xiao

- rok

- Wydajność

- TAK

- You

- Yuan

- zefirnet

- Zhao