Twórcy Quest 3 mogą teraz zintegrować trzy główne nowe funkcje, aby ulepszyć zarówno rzeczywistość wirtualną, jak i mieszaną.

Śledzenie ciała od wewnątrz na zewnątrz (IOBT) i nogi generatywne ogłoszone wraz z Questem 3 jako przyjście w grudniu. Okluzja dla rzeczywistości mieszanej za pośrednictwem interfejsu Depth API była wcześniej funkcja eksperymentalna, co oznacza, że programiści mogliby go przetestować, ale nie mogli go udostępnić w kompilacjach Quest Store ani App Lab.

Wszystkie trzy funkcje są teraz dostępne w ramach pakietu SDK v60 dla Unity i kodu natywnego. Tymczasem integracja z silnikiem Unreal Engine w wersji 60 obejmuje interfejs Depth API, ale nie IOBT ani moduły generatywne.

Śledzenie górnej części ciała od wewnątrz na zewnątrz

Śledzenie ciała od wewnątrz (IOBT) wykorzystuje boczne kamery Quest 3, skierowane w dół, do śledzenia nadgarstka, łokci, ramion i tułowia przy użyciu zaawansowanych algorytmów widzenia komputerowego.

IOBT zapobiega problemom z oszacowanymi ramionami za pomocą kinematyki odwrotnej (IK), które często są nieprawidłowe i powodują dyskomfort, ponieważ system po prostu zgaduje na podstawie lokalizacji Twojej głowy i dłoni. Kiedy programiści zintegrują IOBT, zobaczysz swoje ramiona i tułów w ich rzeczywistej pozycji – a nie szacunkowej.

To śledzenie górnej części ciała pozwala także programistom zakotwiczyć ruch drążka w kierunku ciała, a nie tylko głowy czy dłoni, i możesz wykonywać nowe czynności, takie jak pochylanie się nad półką i wyświetlanie tego realistycznie na swoim awatarze.

Nogi generatywne AI

IOBT działa tylko na górną część ciała. Dla dolnych partii ciała Meta wprowadziła na rynek Generative Legs.

Generative Legs wykorzystuje „najnowocześniejszy” model sztucznej inteligencji do oszacowania pozycji nóg – jest to technologia, którą firma opracowała badać latami.

W Quest 3 funkcja Generative Legs zapewnia bardziej realistyczne szacunki niż poprzednie zestawy słuchawkowe dzięki wykorzystaniu śledzenia górnej części ciała jako danych wejściowych, ale działa również w Quest Pro i Quest 2 przy użyciu wyłącznie głowy i dłoni.

System Generative Legs to jednak tylko estymator, a nie śledzenie, więc chociaż może wykryć skakanie i kucanie, nie wykryje wielu rzeczywistych ruchów, takich jak podnoszenie kolan.

Łącznie śledzenie górnej części ciała na zewnątrz i nogi generatywne umożliwiają tworzenie wiarygodnych całych ciał w rzeczywistości wirtualnej, zwanej syntezą całego ciała, bez zewnętrznego sprzętu.

Meta ogłosiła wcześniej, że Full Body Synthesis pojawi się w Supernatural, Swordsman VR i Drunken Bar Fight.

Głębokość API dla okluzji w rzeczywistości mieszanej

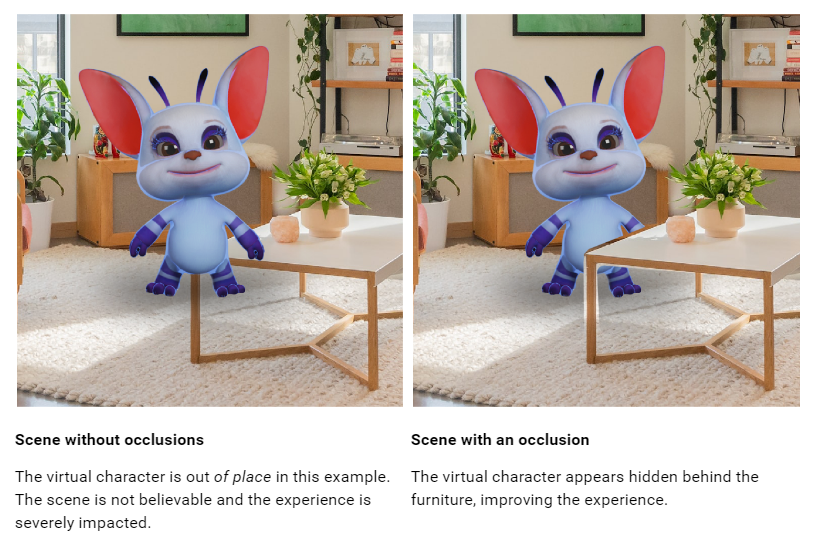

In nasza recenzja Quest 3 ostro skrytykowaliśmy brak dynamicznej okluzji rzeczywistości mieszanej. Chociaż wirtualne obiekty mogą pojawiać się za prymitywną siatką scen wygenerowaną podczas skanowania konfiguracji pomieszczenia, zawsze są one wyświetlane przed ruchomymi obiektami, takimi jak Twoje ramiona i inne osoby, nawet jeśli są dalej, co wygląda drażniąco i nienaturalnie.

Programiści mogli już wdrożyć dynamiczną okluzję dłoni, korzystając z siatki śledzenia dłoni, ale niewielu to zrobiło, ponieważ powoduje to odcięcie nadgarstka, przez co reszta ramienia nie jest uwzględniona.

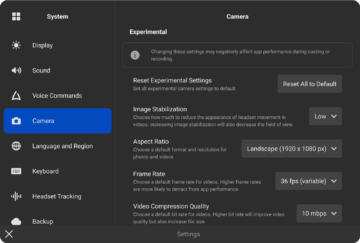

Nowy interfejs Depth API zapewnia programistom zgrubną mapę głębi dla każdej klatki, generowaną przez zestaw słuchawkowy z jego punktu widzenia. Można tego użyć do zaimplementowania okluzji, zarówno w przypadku ruchomych obiektów, jak i w celu uzyskania drobniejszych szczegółów obiektów statycznych, ponieważ mogły one nie zostać uchwycone w siatce sceny.

Dynamiczna okluzja powinna sprawić, że rzeczywistość mieszana w Quest 3 będzie wyglądać bardziej naturalnie. Jednak rozdzielczość wykrywania głębi przez zestaw słuchawkowy jest początku. niski, więc nie będzie wychwytywał takich szczegółów, jak przestrzenie między palcami, a wokół krawędzi obiektów będzie widoczna pusta szczelina.

Sugeruje się również, aby mapę głębokości zwiększać jedynie do 4 metrów, po czym „dokładność znacznie spada”, więc programiści mogą chcieć również użyć siatki scen do okluzji statycznej.

Programiści mogą wdrożyć okluzję na dwa sposoby: twardy i miękki. Hard jest w zasadzie darmowy, ale ma postrzępione krawędzie, podczas gdy Soft kosztuje GPU, ale wygląda lepiej. Patrząc na przykładowy klip Meta, trudno sobie wyobrazić, że jakikolwiek programista wybierze opcję Hard.

Jednak w obu przypadkach okluzja wymaga użycia specjalnych shaderów okluzji Meta lub specjalnego zaimplementowania ich w niestandardowych shaderach. Nie jest to rozwiązanie dostępne za pomocą jednego kliknięcia i prawdopodobnie będzie wymagało dużego wysiłku od programistów.

Oprócz okluzji programiści mogą również używać interfejsu Depth API do implementowania efektów wizualnych opartych na głębi w rzeczywistości mieszanej, takich jak mgła.

Testowanie UploadVR Głębokość okluzji API.

Możesz znaleźć dokumentację dot Jedność tutaj i dla Nierealne tutaj. Należy pamiętać, że dokumentacja nie została jeszcze zaktualizowana w celu odzwierciedlenia publicznej wersji.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://www.uploadvr.com/quest-3-inside-out-upper-body-tracking-and-dynamic-occlusion/

- :ma

- :Jest

- :nie

- $W GÓRĘ

- 1

- 7

- a

- precyzja

- działania

- rzeczywisty

- zaawansowany

- Po

- AI

- Algorytmy

- wzdłuż

- już

- również

- zawsze

- an

- Kotwica

- i

- ogłosił

- każdy

- api

- Aplikacja

- Laboratorium aplikacji

- zjawić się

- SĄ

- ARM

- Ramiona

- na około

- AS

- At

- dostępny

- awatara

- z dala

- bar

- BE

- bo

- być

- za

- Ulepsz Swój

- pomiędzy

- ciała

- ciało

- Śledzenie ciała

- obie

- Buduje

- ale

- by

- nazywa

- kamery

- CAN

- Zajęte

- Etui

- Dodaj

- kod

- COM

- jak

- przyjście

- sukcesy firma

- komputer

- Wizja komputerowa

- pojęcie

- Koszty:

- mógłby

- nie mogłem

- surowy

- zwyczaj

- obniżki

- tnący

- grudzień

- dostarcza

- głębokość

- opis

- detale

- wykryć

- Deweloper

- deweloperzy

- ZROBIŁ

- kierunek

- Wyświetlacz

- dokumentacja

- zniżkowy

- Krople

- dynamiczny

- krawędź

- ruchomości

- wysiłek

- umożliwiać

- silnik

- istotnie

- oszacowanie

- szacunkowa

- Parzyste

- przykład

- eksperymentalny

- zewnętrzny

- Twarz

- daleko

- Korzyści

- czuć

- kilka

- walka

- Znajdź

- Mgła

- W razie zamówieenia projektu

- Darmowy

- od

- z przodu

- pełny

- dalej

- szczelina

- Ogólne

- wygenerowane

- generatywny

- daje

- GPU

- ręka

- śledzenie ręki

- siła robocza

- Ciężko

- sprzęt komputerowy

- Have

- głowa

- Słuchawki

- Słuchawki z mikrofonem

- Jednak

- HTTPS

- if

- obraz

- wdrożenia

- wykonawczych

- podnieść

- in

- włączony

- obejmuje

- wkład

- integrować

- integracja

- ISN

- problemy

- IT

- JEGO

- jpg

- właśnie

- laboratorium

- Brak

- uruchomiona

- nogi

- pozwala

- dźwignia

- lubić

- Prawdopodobnie

- ll

- lokalizacja

- Popatrz

- poszukuje

- WYGLĄD

- niski

- niższy

- poważny

- robić

- Dokonywanie

- wiele

- mapa

- Może..

- znaczenie

- W międzyczasie

- siatka

- Meta

- mieszany

- mieszana rzeczywistość

- model

- jeszcze

- Ruchy

- przeniesienie

- mr

- rodzimy

- Naturalny

- Nowości

- Nowe funkcje

- Nie

- noty

- już dziś

- obiekty

- Oculus

- of

- poza

- często

- on

- tylko

- or

- Inne

- na zewnątrz

- koniec

- część

- Ludzie

- wykonać

- wybierać

- plato

- Analiza danych Platona

- PlatoDane

- do przyjęcia

- punkt

- Punkt widzenia

- Pozycje

- zapobiega

- poprzedni

- poprzednio

- Pro

- publiczny

- poszukiwanie

- zadanie 2

- zadanie 3

- zadanie pro

- sklep z zadaniami

- wychowywanie

- realistyczny

- Rzeczywistość

- odzwierciedlić

- zwolnić

- Wymaga

- Rozkład

- REST

- Pokój

- s

- skanować

- scena

- Sdk

- widzieć

- ustawienie

- STATEK

- powinien

- pokazać

- bok

- znaczący

- znacznie

- ponieważ

- So

- Miękki

- rozwiązanie

- obowiązuje

- specjalny

- swoiście

- statyczny

- sklep

- taki

- nadprzyrodzony

- wsparcie

- synteza

- system

- Technologia

- test

- Testowanie

- niż

- Podziękowania

- że

- Połączenia

- ich

- one

- to

- tych

- chociaż?

- trzy

- do

- śledzić

- Śledzenie

- drugiej

- Jedność

- Nierealny

- Unreal Engine

- zaktualizowane

- UploadVR

- posługiwać się

- używany

- zastosowania

- za pomocą

- przez

- Zobacz i wysłuchaj

- Wirtualny

- wizja

- wizualny

- vr

- chcieć

- była

- sposoby

- we

- DOBRZE

- były

- jeśli chodzi o komunikację i motywację

- który

- Podczas

- będzie

- w

- Wygrał

- działa

- nadgarstek

- jeszcze

- You

- Twój

- zefirnet