W tym poście omówiono najczęstsze wyzwania, przed którymi stają klienci podczas przeszukiwania dokumentów wewnętrznych, i podano konkretne wskazówki, w jaki sposób można wykorzystać usługi AWS do stworzenia generatywnego bota konwersacyjnego opartego na sztucznej inteligencji, który zwiększa użyteczność informacji wewnętrznych.

Dane nieustrukturyzowane stanowią 80% wszystkich danych znalezione w organizacjach, składające się z repozytoriów podręczników, plików PDF, często zadawanych pytań, e-maili i innych dokumentów, których liczba rośnie codziennie. Współczesne przedsiębiorstwa polegają na stale rosnących repozytoriach informacji wewnętrznych, a problemy pojawiają się, gdy ilość nieustrukturyzowanych danych staje się niemożliwa do zarządzania. Często użytkownicy czytają i sprawdzają wiele różnych źródeł wewnętrznych, aby znaleźć odpowiedzi, których potrzebują.

Wewnętrzne fora pytań i odpowiedzi mogą pomóc użytkownikom uzyskać bardzo szczegółowe odpowiedzi, ale wymagają również dłuższego czasu oczekiwania. W przypadku wewnętrznych często zadawanych pytań dotyczących danej firmy, długi czas oczekiwania skutkuje niższą produktywnością pracowników. Fora pytań i odpowiedzi są trudne do skalowania, ponieważ opierają się na ręcznie pisanych odpowiedziach. Dzięki generatywnej sztucznej inteligencji następuje obecnie zmiana paradygmatu w sposobie, w jaki użytkownicy wyszukują i znajdują informacje. Następnym logicznym krokiem jest wykorzystanie generatywnej sztucznej inteligencji do skondensowania dużych dokumentów w mniejsze informacje, aby ułatwić użytkownikom korzystanie z nich. Zamiast spędzać dużo czasu na czytaniu tekstu lub czekaniu na odpowiedzi, użytkownicy mogą generować podsumowania w czasie rzeczywistym w oparciu o wiele istniejących repozytoriów informacji wewnętrznych.

Omówienie rozwiązania

Rozwiązanie umożliwia klientom pobieranie wyselekcjonowanych odpowiedzi na pytania zadawane na temat dokumentów wewnętrznych poprzez wykorzystanie modelu transformatora do generowania odpowiedzi na pytania dotyczące danych, w zakresie których nie zostało przeszkolone, co jest techniką znaną jako podpowiedzi zerowe. Stosując to rozwiązanie klienci mogą zyskać następujące korzyści:

- Znajdź dokładne odpowiedzi na pytania w oparciu o istniejące źródła dokumentów wewnętrznych

- Skróć czas, jaki użytkownicy spędzają na poszukiwaniu odpowiedzi, korzystając z modeli wielkojęzykowych (LLM), aby zapewnić niemal natychmiastowe odpowiedzi na złożone zapytania, korzystając z dokumentów zawierających najbardziej aktualne informacje

- Przeszukuj pytania, na które udzielono wcześniej odpowiedzi, za pośrednictwem scentralizowanego pulpitu nawigacyjnego

- Zmniejsz stres spowodowany spędzaniem czasu na ręcznym czytaniu informacji w poszukiwaniu odpowiedzi

Generowanie rozszerzone odzyskiwania (RAG)

Generowanie rozszerzone wyszukiwania (RAG) zmniejsza niektóre niedociągnięcia zapytań opartych na LLM, znajdując odpowiedzi w bazie wiedzy i wykorzystując LLM do podsumowania dokumentów w zwięzłe odpowiedzi. Proszę przeczytaj to pisać aby dowiedzieć się, jak wdrożyć podejście RAG Amazonka Kendra. Z zapytaniami opartymi na LLM, które uwzględnia podejście RAG z Amazon Kendra, związane są następujące zagrożenia i ograniczenia:

- Halucynacje i identyfikowalność – LLMS są szkolone na dużych zbiorach danych i generują odpowiedzi na temat prawdopodobieństwa. Może to prowadzić do niedokładnych odpowiedzi, zwanych halucynacjami.

- Wiele silosów danych — aby w odpowiedzi odwoływać się do danych z wielu źródeł, należy skonfigurować ekosystem łączników w celu agregacji danych. Dostęp do wielu repozytoriów jest ręczny i czasochłonny.

- Bezpieczeństwo — bezpieczeństwo i prywatność to kluczowe kwestie przy wdrażaniu botów konwersacyjnych obsługiwanych przez RAG i LLM. Pomimo używania Amazon Comprehend w celu odfiltrowania danych osobowych, które mogą zostać przekazane w wyniku zapytań użytkowników, istnieje możliwość niezamierzonego ujawnienia informacji osobistych lub wrażliwych, w zależności od pochłoniętych danych. Oznacza to, że kontrolowanie dostępu do chatbota jest kluczowe, aby zapobiec niezamierzonemu dostępowi do wrażliwych informacji.

- Znaczenie danych – LLMS są szkolone na danych do określonej daty, co oznacza, że informacje często są nieaktualne. Koszt związany z modelami szkoleniowymi na najnowszych danych jest wysoki. Aby zapewnić dokładne i aktualne odpowiedzi, organizacje ponoszą odpowiedzialność za regularne aktualizowanie i wzbogacanie treści indeksowanych dokumentów.

- Koszt — koszty związane z wdrożeniem tego rozwiązania powinny być brane pod uwagę przez firmy. Wdrażając to rozwiązanie, firmy muszą dokładnie ocenić swoje wymagania budżetowe i wydajnościowe. Prowadzenie LLM może wymagać znacznych zasobów obliczeniowych, co może zwiększać koszty operacyjne. Koszty te mogą stać się ograniczeniem w przypadku aplikacji, które muszą działać na dużą skalę. Jednak jedną z zalet AWS Cloud to elastyczność, dzięki której możesz płacić tylko za to, z czego korzystasz. AWS oferuje prosty, spójny model cenowy typu pay-as-you-go, dzięki czemu płacisz tylko za zużyte zasoby.

Korzystanie z Amazon SageMaker JumpStart

W przypadku modeli językowych opartych na transformatorach organizacje mogą odnieść korzyści z używania Amazon Sage Maker JumpStart, który oferuje kolekcję gotowych modeli uczenia maszynowego. Amazon SageMaker JumpStart oferuje szeroką gamę podstawowych modeli generowania tekstu i odpowiadania na pytania (Q&A), które można łatwo wdrożyć i wykorzystać. To rozwiązanie integruje model FLAN T5-XL Amazon SageMaker JumpStart, ale istnieją inne aspekty, o których należy pamiętać podczas wybór modelu fundamentu.

Integracja bezpieczeństwa z naszym przepływem pracy

Kierując się najlepszymi praktykami Filaru Bezpieczeństwa Dobrze zaprojektowane ramy, Amazon Cognito służy do uwierzytelniania. Pule użytkowników Amazon Cognito można zintegrować z zewnętrznymi dostawcami tożsamości, którzy obsługują kilka platform używanych do kontroli dostępu, w tym Open Authorization (OAuth), OpenID Connect (OIDC) lub Security Assertion Markup Language (SAML). Identyfikacja użytkowników i ich działań pozwala na zachowanie identyfikowalności rozwiązania. Rozwiązanie wykorzystuje również Wykrywanie danych osobowych (PII) firmy Amazon Comrehend funkcja automatycznej identyfikacji i redagowania informacji umożliwiających identyfikację. Zredagowane informacje umożliwiające identyfikację obejmują adresy, numery ubezpieczenia społecznego, adresy e-mail i inne poufne informacje. Dzięki takiemu rozwiązaniu wszelkie informacje umożliwiające identyfikację użytkownika podane przez użytkownika w zapytaniu wejściowym zostaną zredagowane. Dane osobowe nie są przechowywane, wykorzystywane przez Amazon Kendra ani przekazywane do LLM.

Przewodnik po rozwiązaniu

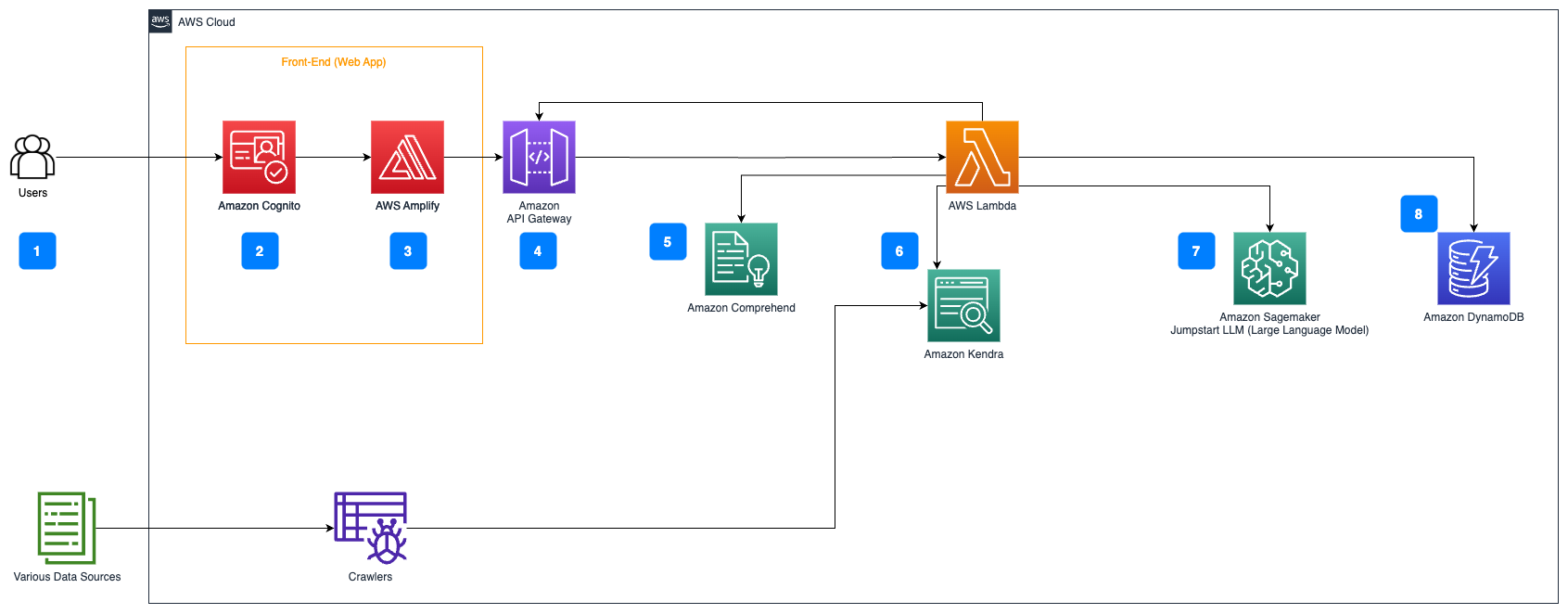

Poniższe kroki opisują przebieg odpowiedzi na pytanie w obiegu dokumentów:

- Użytkownicy wysyłają zapytanie za pośrednictwem interfejsu internetowego.

- Amazon Cognito służy do uwierzytelniania, zapewniając bezpieczny dostęp do aplikacji internetowej.

- Frontend aplikacji internetowej jest hostowany na platformie Wzmocnienie AWS.

- Brama Amazon API hostuje interfejs API REST z różnymi punktami końcowymi do obsługi żądań użytkowników uwierzytelnianych za pomocą Amazon Cognito.

- Redakcja PII z Amazon Comprehend:

- Przetwarzanie zapytań użytkownika: Gdy użytkownik przesyła zapytanie lub dane wejściowe, jest ono najpierw przekazywane przez Amazon Comprehend. Usługa analizuje tekst i identyfikuje wszelkie podmioty umożliwiające identyfikację osób występujące w zapytaniu.

- Ekstrakcja PII: Amazon Comprehend wyodrębnia wykryte jednostki PII z zapytania użytkownika.

- Wyszukiwanie istotnych informacji za pomocą Amazonka Kendra:

- Amazon Kendra służy do zarządzania indeksem dokumentów, który zawiera informacje wykorzystywane do generowania odpowiedzi na zapytania użytkownika.

- Połączenia Pobieranie kontroli jakości LangChain Moduł służy do budowy łańcucha konwersacji, który zawiera istotne informacje na temat zapytań użytkownika.

- Integracja z Amazon SageMaker JumpStart:

- Funkcja AWS Lambda korzysta z biblioteki LangChain i łączy się z punktem końcowym Amazon SageMaker JumpStart za pomocą zapytania wypełnionego kontekstem. Punkt końcowy Amazon SageMaker JumpStart służy jako interfejs LLM używany do wnioskowania.

- Przechowywanie odpowiedzi i zwracanie ich użytkownikowi:

- Odpowiedź z LLM jest przechowywana w Amazon DynamoDB wraz z zapytaniem użytkownika, znacznikiem czasu, unikalnym identyfikatorem i innymi dowolnymi identyfikatorami elementu, takimi jak kategoria pytania. Przechowywanie pytania i odpowiedzi jako odrębnych elementów umożliwia funkcji AWS Lambda łatwe odtworzenie historii rozmów użytkownika na podstawie czasu zadawania pytań.

- Na koniec odpowiedź jest odsyłana do użytkownika za pośrednictwem żądania HTTPs za pośrednictwem odpowiedzi integracji interfejsu API REST Amazon API Gateway.

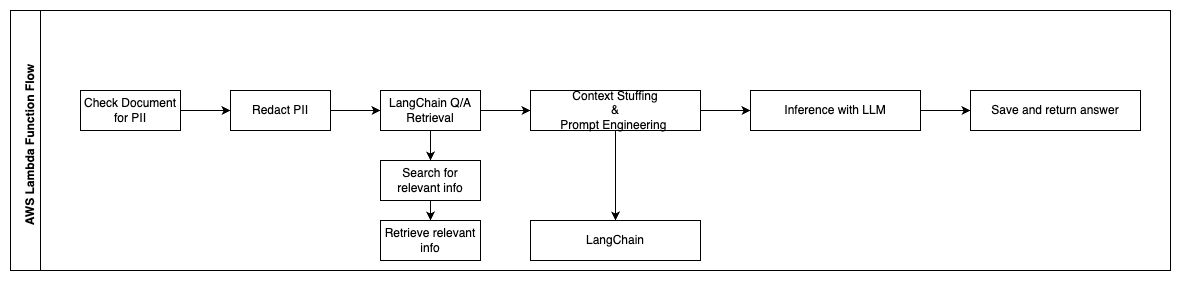

Poniższe kroki opisują funkcje AWS Lambda i ich przepływ przez proces:

- Sprawdź i zredaguj wszelkie informacje umożliwiające identyfikację użytkownika lub informacje wrażliwe

- Łańcuch pobierania kontroli jakości LangChain

- Wyszukuj i pobieraj odpowiednie informacje

- Upychanie kontekstu i szybka inżynieria

- Wnioskowanie z LLM

- Zwróć odpowiedź i zapisz ją

Przypadków użycia

Istnieje wiele przypadków zastosowań biznesowych, w których klienci mogą korzystać z tego przepływu pracy. W poniższej sekcji wyjaśniono, w jaki sposób przepływ pracy można wykorzystać w różnych branżach i branżach.

Pomoc dla pracowników

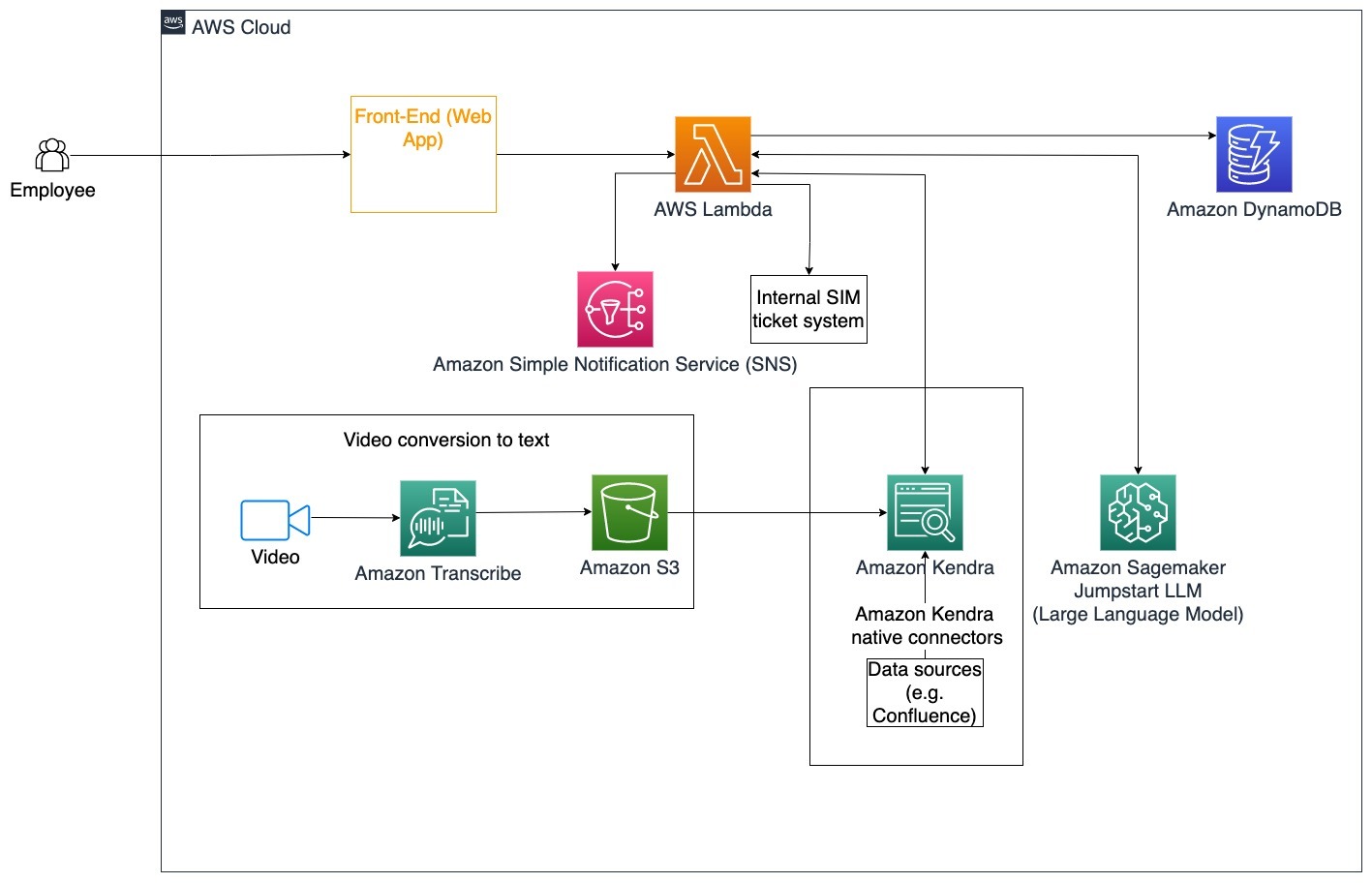

Dobrze zaprojektowane szkolenie korporacyjne może poprawić satysfakcję pracowników i skrócić czas potrzebny na wdrożenie nowych pracowników. W miarę rozwoju organizacji i wzrostu złożoności pracownikom trudno jest zrozumieć wiele źródeł dokumentów wewnętrznych. Dokumenty wewnętrzne w tym kontekście obejmują wytyczne firmy, zasady i standardowe procedury operacyjne. W tym scenariuszu pracownik ma pytanie, jak postępować i edytować bilet biletowy wydania wewnętrznego. Pracownik może uzyskać dostęp do bota konwersacyjnego opartego na sztucznej inteligencji (AI) i korzystać z niego, aby zadać pytanie i wykonać kolejne kroki w przypadku konkretnego zgłoszenia.

Konkretny przypadek użycia: Automatyzuj rozwiązywanie problemów dla pracowników w oparciu o wytyczne korporacyjne.

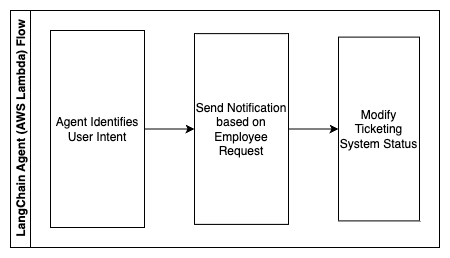

Poniższe kroki opisują funkcje AWS Lambda i ich przepływ przez proces:

- Agent LangChain do identyfikacji intencji

- Wyślij powiadomienie na podstawie prośby pracownika

- Zmień status biletu

Na tym diagramie architektury można wykorzystać korporacyjne filmy szkoleniowe Amazon Transcribe aby zebrać dziennik tych skryptów wideo. Dodatkowo korporacyjne treści szkoleniowe przechowywane w różnych źródłach (tj. Confluence, Microsoft SharePoint, Google Drive, Jira itp.) można wykorzystać do tworzenia indeksów za pośrednictwem złączy Amazon Kendra. Przeczytaj ten artykuł, aby dowiedzieć się więcej na temat kolekcji natywnych złącza możesz wykorzystać w Amazon Kendra jako punkt źródłowy. Robot Amazon Kendra może następnie wykorzystywać zarówno korporacyjne skrypty wideo szkoleniowe, jak i dokumentację przechowywaną w tych innych źródłach, aby pomóc botowi konwersacyjnemu w odpowiadaniu na pytania specyficzne dla firmowych wytycznych dotyczących szkoleń korporacyjnych. Agent LangChain weryfikuje uprawnienia, modyfikuje status zgłoszenia i powiadamia odpowiednie osoby za pomocą usługi Amazon Simple Notification Service (Amazon SNS).

Zespoły obsługi klienta

Szybkie rozwiązywanie zapytań klientów poprawia jakość obsługi klientów i zachęca do lojalności wobec marki. Lojalna baza klientów pomaga zwiększać sprzedaż, co przekłada się na wyniki finansowe i zwiększa zaangażowanie klientów. Zespoły obsługi klienta poświęcają dużo energii, odwołując się do wielu dokumentów wewnętrznych i oprogramowania do zarządzania relacjami z klientami, aby odpowiedzieć na zapytania klientów dotyczące produktów i usług. Dokumenty wewnętrzne w tym kontekście mogą obejmować ogólne skrypty rozmów telefonicznych z obsługą klienta, podręczniki, wytyczne dotyczące eskalacji i informacje biznesowe. Generatywny bot konwersacyjny AI pomaga w optymalizacji kosztów, ponieważ obsługuje zapytania w imieniu zespołu obsługi klienta.

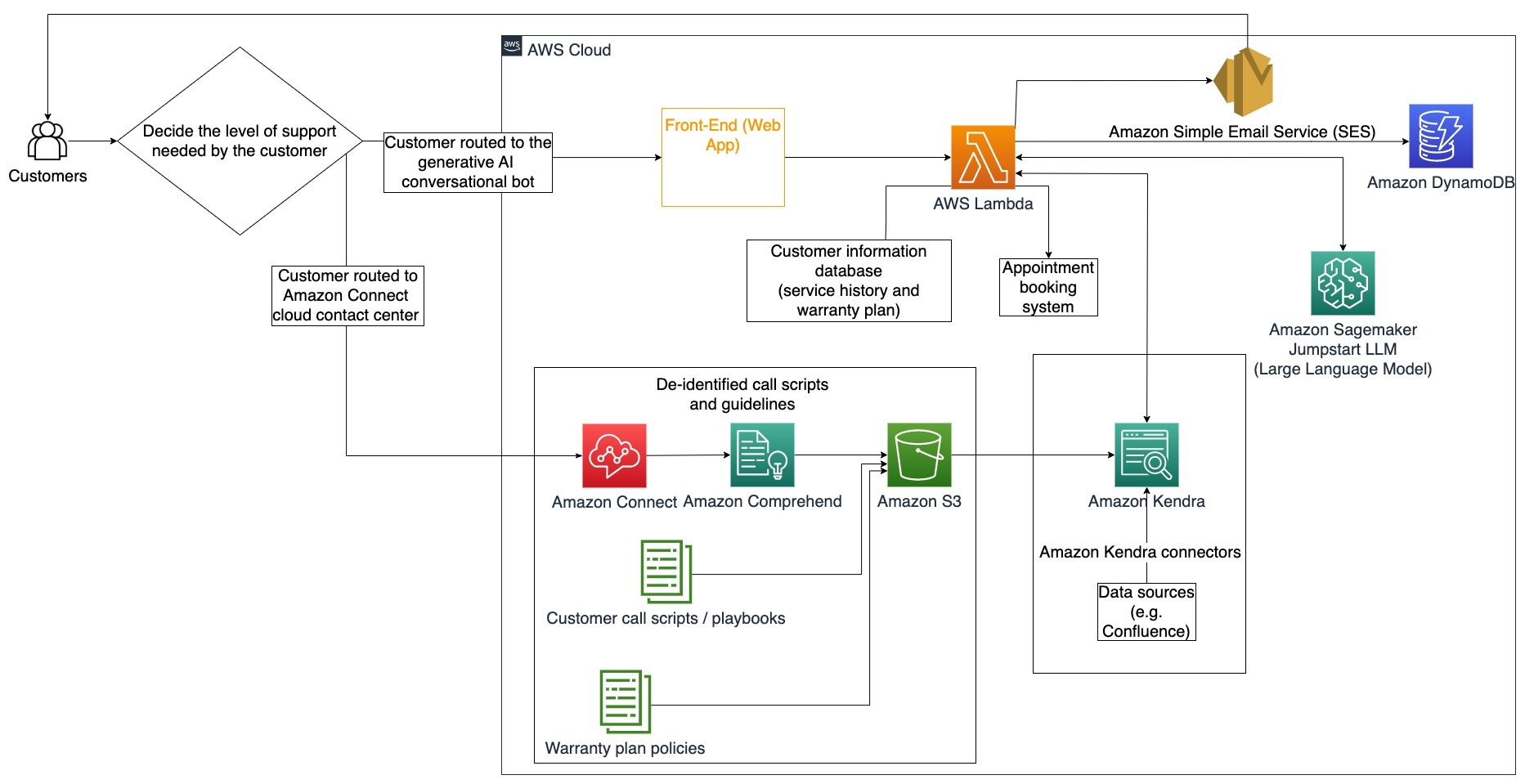

Konkretny przypadek użycia: Obsługa wniosków o wymianę oleju w oparciu o historię serwisową i zakupiony plan obsługi klienta.

Na tym diagramie architektury klient jest kierowany albo do generatywnego bota konwersacyjnego AI, albo do Amazon Połącz Centrum Kontaktu. Decyzja ta może opierać się na poziomie potrzebnego wsparcia lub dostępności agentów obsługi klienta. Agent LangChain rozpoznaje intencje klienta i weryfikuje jego tożsamość. Agent LangChain sprawdza także historię serwisową i wykupiony plan wsparcia.

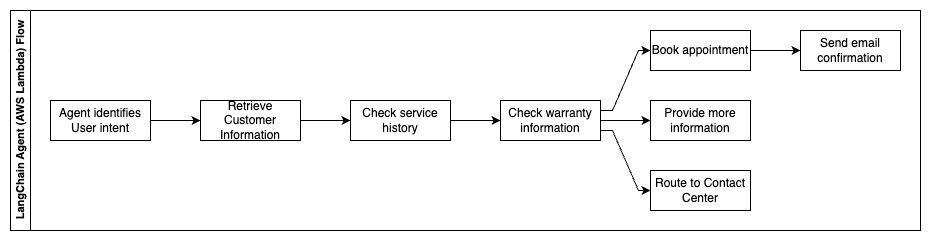

Poniższe kroki opisują funkcje AWS Lambda i ich przepływ przez proces:

- Agent LangChain identyfikuje intencję

- Odzyskaj informacje o kliencie

- Sprawdź historię obsługi klienta i informacje o gwarancji

- Zarezerwuj wizytę, podaj więcej informacji lub wyznacz trasę do centrum kontaktowego

- Wyślij e-mail z potwierdzeniem

Amazon Connect służy do gromadzenia dzienników rozmów i rozmów, a Amazon Comprehend służy do usuwania danych osobowych z tych dzienników. Robot indeksujący Amazon Kendra może następnie wykorzystać zredagowane dzienniki rozmów i czatów, skrypty rozmów z klientami oraz zasady planu wsparcia klienta w celu utworzenia indeksu. Po podjęciu decyzji generatywny bot konwersacyjny AI decyduje, czy zarezerwować spotkanie, podać więcej informacji, czy też skierować klienta do centrum kontaktowego w celu uzyskania dalszej pomocy. W celu optymalizacji kosztów agent LangChain może również generować odpowiedzi przy użyciu mniejszej liczby tokenów i tańszego modelu dużego języka w przypadku zapytań klientów o niższym priorytecie.

Usługi finansowe

Firmy świadczące usługi finansowe polegają na terminowym wykorzystywaniu informacji, aby zachować konkurencyjność i przestrzegać przepisów finansowych. Korzystając z generatywnego bota konwersacyjnego opartego na sztucznej inteligencji, analitycy finansowi i doradcy mogą wchodzić w interakcję z informacjami tekstowymi w sposób konwersacyjny, redukując czas i wysiłek potrzebny do podejmowania bardziej świadomych decyzji. Poza inwestycjami i badaniami rynku generatywny bot konwersacyjny oparty na sztucznej inteligencji może również zwiększać ludzkie możliwości, wykonując zadania, które tradycyjnie wymagałyby więcej ludzkiego wysiłku i czasu. Na przykład instytucja finansowa specjalizująca się w pożyczkach osobistych może zwiększyć tempo przetwarzania pożyczek, zapewniając jednocześnie klientom większą przejrzystość.

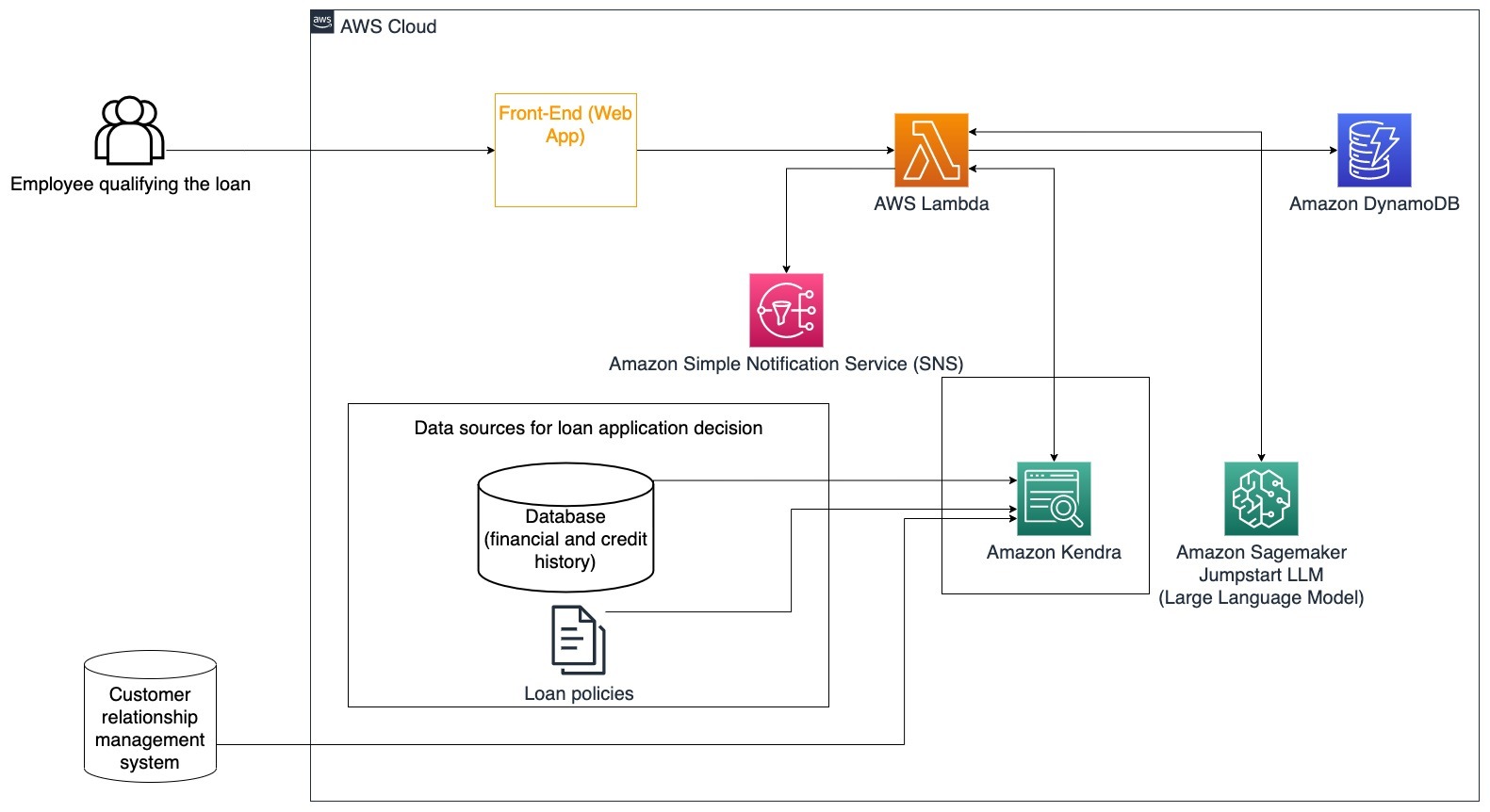

Konkretny przypadek użycia: Skorzystaj z historii finansowej klienta i poprzednich wniosków o pożyczkę, aby podjąć decyzję i wyjaśnić decyzję o pożyczce.

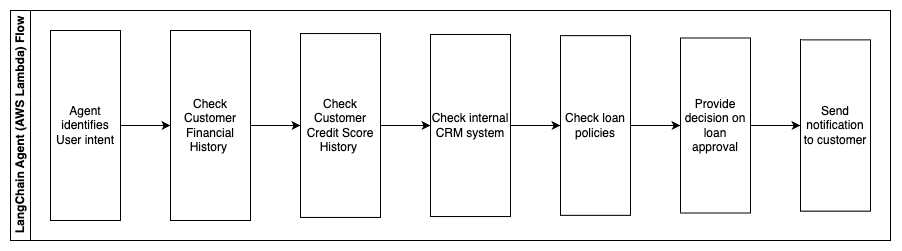

Poniższe kroki opisują funkcje AWS Lambda i ich przepływ przez proces:

- Agent LangChain do identyfikacji intencji

- Sprawdź historię finansową i zdolność kredytową klienta

- Sprawdź wewnętrzny system zarządzania relacjami z klientami

- Sprawdź standardowe zasady pożyczki i zasugeruj decyzję pracownikowi kwalifikującą pożyczkę

- Wyślij powiadomienie do klienta

Architektura ta obejmuje dane finansowe klientów przechowywane w bazie danych oraz dane przechowywane w narzędziu do zarządzania relacjami z klientami (CRM). Te punkty danych służą do podjęcia decyzji w oparciu o wewnętrzną politykę kredytową firmy. Klient może zadawać pytania wyjaśniające, aby zrozumieć, do jakich kredytów się kwalifikuje i na jakich warunkach może je zaakceptować. Jeśli generatywny bot konwersacyjny AI nie będzie w stanie zatwierdzić wniosku o pożyczkę, użytkownik może nadal zadawać pytania dotyczące poprawy zdolności kredytowej lub alternatywnych opcji finansowania.

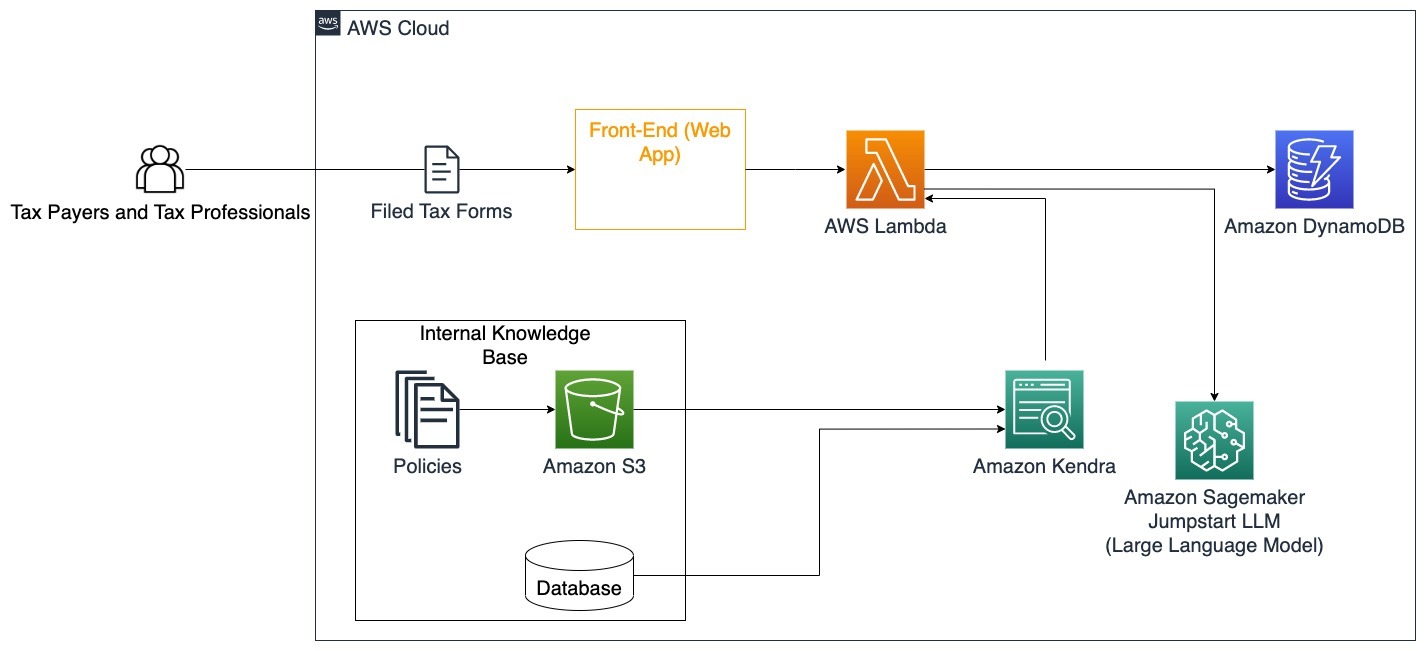

Rząd

Generacyjne boty konwersacyjne AI mogą przynieść ogromne korzyści instytucjom rządowym, przyspieszając komunikację, wydajność i procesy decyzyjne. Generacyjne boty konwersacyjne oparte na sztucznej inteligencji mogą również zapewniać natychmiastowy dostęp do wewnętrznych baz wiedzy, aby pomóc pracownikom instytucji rządowych w szybkim wyszukiwaniu informacji, zasad i procedur (tj. kryteriów kwalifikowalności, procesów składania wniosków oraz usług i wsparcia obywateli). Jednym z rozwiązań jest interaktywny system, dzięki któremu podatnicy i doradcy podatkowi mogą łatwo znaleźć szczegóły i świadczenia podatkowe. Można go używać do zrozumienia pytań użytkowników, podsumowania dokumentów podatkowych i zapewnienia jasnych odpowiedzi w drodze interaktywnych rozmów.

Użytkownicy mogą zadawać pytania takie jak:

- Jak działa podatek od spadków i jakie są progi podatkowe?

- Czy możesz wyjaśnić pojęcie podatku dochodowego?

- Jakie skutki podatkowe wiąże się ze sprzedażą drugiej nieruchomości?

Dodatkowo użytkownicy mogą mieć wygodę przesyłania formularzy podatkowych do systemu, co pozwala zweryfikować poprawność podanych informacji.

Architektura ta ilustruje, w jaki sposób użytkownicy mogą przesyłać wypełnione formularze podatkowe do rozwiązania i wykorzystywać je do interaktywnej weryfikacji oraz wskazówek, jak dokładnie wypełnić niezbędne informacje.

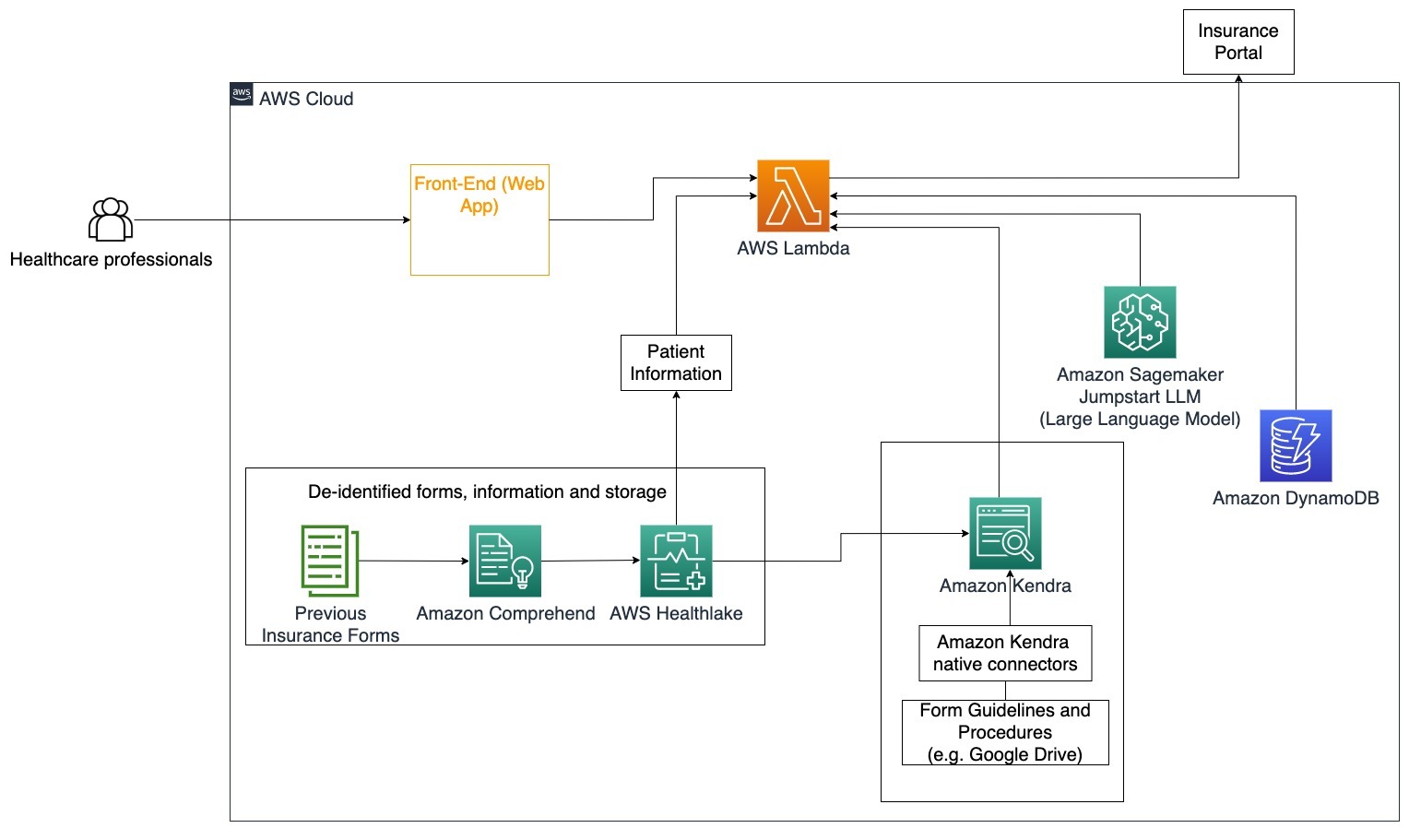

Zdrowie

Firmy z branży opieki zdrowotnej mają możliwość zautomatyzowania wykorzystania dużych ilości wewnętrznych informacji o pacjentach, jednocześnie odpowiadając na typowe pytania dotyczące przypadków użycia, takich jak opcje leczenia, roszczenia ubezpieczeniowe, badania kliniczne i badania farmaceutyczne. Wykorzystanie generatywnego bota konwersacyjnego AI umożliwia szybkie i dokładne generowanie odpowiedzi na temat informacji zdrowotnych z udostępnionej bazy wiedzy. Na przykład niektórzy pracownicy służby zdrowia spędzają dużo czasu na wypełnianiu formularzy w celu zgłoszenia roszczeń ubezpieczeniowych.

W podobnych warunkach administratorzy badań klinicznych i badacze muszą znaleźć informacje na temat możliwości leczenia. Generacyjny bot konwersacyjny AI może korzystać z gotowych łączników w Amazon Kendra, aby pobierać najbardziej istotne informacje z milionów dokumentów opublikowanych w wyniku ciągłych badań prowadzonych przez firmy farmaceutyczne i uniwersytety.

Konkretny przypadek użycia: Zmniejsz liczbę błędów i czas potrzebny na wypełnienie i przesłanie formularzy ubezpieczeniowych.

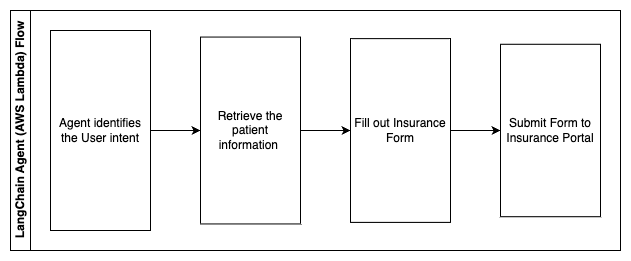

Na tym diagramie architektury pracownik służby zdrowia może skorzystać z generatywnego bota konwersacyjnego AI, aby dowiedzieć się, jakie formularze należy wypełnić w ramach ubezpieczenia. Agent LangChain jest wówczas w stanie wyszukać odpowiednie formularze i dodać potrzebne informacje pacjentowi, a także udzielić odpowiedzi na części opisowe formularzy w oparciu o polisy ubezpieczeniowe i poprzednie formularze. Pracownik służby zdrowia może edytować odpowiedzi udzielone przez LLM przed zatwierdzeniem formularza i dostarczeniem go do portalu ubezpieczeniowego.

Poniższe kroki opisują funkcje AWS Lambda i ich przepływ przez proces:

- Agent LangChain do identyfikacji intencji

- Uzyskaj potrzebne informacje o pacjencie

- Wypełnij formularz ubezpieczenia w oparciu o dane pacjenta i wytyczne dotyczące formularza

- Prześlij formularz do portalu ubezpieczeniowego po zatwierdzeniu przez użytkownika

Jezioro zdrowia AWS służy do bezpiecznego przechowywania danych zdrowotnych, w tym poprzednich formularzy ubezpieczenia i informacji o pacjencie, a Amazon Comprehend służy do usuwania danych osobowych (PII) z poprzednich formularzy ubezpieczenia. Robot Amazon Kendra może następnie skorzystać z zestawu formularzy ubezpieczeniowych i wytycznych w celu utworzenia indeksu. Po wypełnieniu formularzy przez generatywną sztuczną inteligencję formularze sprawdzone przez lekarza mogą zostać przesłane do portalu ubezpieczeniowego.

Oszacowanie kosztów

Koszt wdrożenia rozwiązania podstawowego w ramach weryfikacji koncepcji przedstawiono w poniższej tabeli. Ponieważ rozwiązanie podstawowe uważa się za weryfikację koncepcji, Amazon Kendra Developer Edition została wykorzystana jako tania opcja, ponieważ obciążenie nie byłoby w środowisku produkcyjnym. Nasze założenie dla Amazon Kendra Developer Edition zakładało 730 aktywnych godzin w miesiącu.

W przypadku Amazon SageMaker założyliśmy, że klient będzie używał instancji ml.g4dn.2xlarge do wnioskowania w czasie rzeczywistym, z jednym punktem końcowym wnioskowania na instancję. Możesz znaleźć więcej informacji na temat cen Amazon SageMaker i dostępnych typów instancji wnioskowania tutaj.

| Usługi | Zużyte zasoby | Szacunkowy koszt miesięczny w USD |

| Wzmocnienie AWS | 150 minut budowy 1 GB obsłużonych danych 500,000 wniosków |

15.71 |

| Brama Amazon API | 1 milion wywołań API REST | 3.5 |

| AWS Lambda | 1 milion żądań Czas trwania 5 sekund na każde żądanie Przydzielone 2 GB pamięci |

160.23 |

| Amazon DynamoDB | 1 milion odczytów 1 milion pisze 100 GB |

26.38 |

| Amazon Sagemaker | Wnioskowanie w czasie rzeczywistym za pomocą ml.g4dn.2xlarge | 676.8 |

| Amazonka Kendra | Wersja dla programistów z 730 godzinami miesięcznie Zeskanowano 10,000 XNUMX dokumentów 5,000 zapytań dziennie |

821.25 |

| . | . | Całkowity koszt: 1703.87 |

* Amazon Cognito ma bezpłatny poziom 50,000 50 aktywnych użytkowników miesięcznie, którzy korzystają z pul użytkowników Cognito lub 2.0 aktywnych użytkowników miesięcznie, którzy korzystają z dostawców tożsamości SAML XNUMX

Sprzątać

Aby zaoszczędzić koszty, usuń wszystkie zasoby wdrożone w ramach samouczka. Możesz usunąć dowolne punkty końcowe SageMaker, które mogłeś utworzyć za pomocą konsoli SageMaker. Pamiętaj, że usunięcie indeksu Amazon Kendra nie powoduje usunięcia oryginalnych dokumentów z Twojej pamięci.

Wnioski

W tym poście pokazaliśmy, jak uprościć dostęp do informacji wewnętrznych, podsumowując dane z wielu repozytoriów w czasie rzeczywistym. Po niedawnym rozwoju dostępnych na rynku LLM możliwości generatywnej sztucznej inteligencji stały się bardziej widoczne. W tym poście przedstawiliśmy sposoby wykorzystania usług AWS do stworzenia bezserwerowego chatbota, który wykorzystuje generatywną sztuczną inteligencję do odpowiadania na pytania. Podejście to obejmuje warstwę uwierzytelniania i wykrywanie danych osobowych przez Amazon Comprehend w celu odfiltrowania wszelkich wrażliwych informacji podanych w zapytaniu użytkownika. Niezależnie od tego, czy chodzi o osoby pracujące w służbie zdrowia, które rozumieją niuanse związane ze zgłaszaniem roszczeń ubezpieczeniowych, czy też działy HR rozumiejące szczegółowe regulacje obowiązujące w całej firmie, istnieje wiele branż i branż, które mogą skorzystać na tym podejściu. Silnikiem chatbota jest podstawowy model Amazon SageMaker JumpStart, natomiast podejście polegające na upychaniu kontekstu przy użyciu techniki RAG zapewnia, że odpowiedzi dokładniej odwołują się do dokumentów wewnętrznych.

Aby dowiedzieć się więcej o pracy z generatywną sztuczną inteligencją w AWS, zobacz Ogłaszamy nowe narzędzia do budowania z generatywną sztuczną inteligencją w AWS. Bardziej szczegółowe wskazówki dotyczące używania techniki RAG z usługami AWS można znaleźć w artykule Szybko twórz aplikacje generatywnej sztucznej inteligencji o wysokiej dokładności na danych korporacyjnych przy użyciu Amazon Kendra, LangChain i dużych modeli językowych. Ponieważ podejście opisane na tym blogu jest niezależne od LLM, do wnioskowania można wykorzystać dowolne LLM. W następnym poście przedstawimy sposoby wdrożenia tego rozwiązania przy użyciu Amazon Bedrock i Amazon Titan LLM.

O autorach

Abhishek Maligehalli Shivalingaiah jest starszym architektem rozwiązań w zakresie usług AI w AWS. Pasjonuje się budowaniem aplikacji z wykorzystaniem Generative AI, Amazon Kendra i NLP. Ma około 10-letnie doświadczenie w budowaniu rozwiązań Data & AI w celu tworzenia wartości dla klientów i przedsiębiorstw. Dla zabawy zbudował nawet (osobistego) chatbota, który odpowiada na pytania dotyczące jego kariery i ścieżki zawodowej. Poza pracą lubi robić portrety rodziny i przyjaciół oraz uwielbia tworzyć dzieła sztuki.

Abhishek Maligehalli Shivalingaiah jest starszym architektem rozwiązań w zakresie usług AI w AWS. Pasjonuje się budowaniem aplikacji z wykorzystaniem Generative AI, Amazon Kendra i NLP. Ma około 10-letnie doświadczenie w budowaniu rozwiązań Data & AI w celu tworzenia wartości dla klientów i przedsiębiorstw. Dla zabawy zbudował nawet (osobistego) chatbota, który odpowiada na pytania dotyczące jego kariery i ścieżki zawodowej. Poza pracą lubi robić portrety rodziny i przyjaciół oraz uwielbia tworzyć dzieła sztuki.

Medha Aiyah jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Austin w Teksasie. Niedawno ukończyła studia na Uniwersytecie Teksasu w Dallas w grudniu 2022 r., uzyskując tytuł magistra informatyki ze specjalizacją w inteligentnych systemach, ze szczególnym uwzględnieniem sztucznej inteligencji/ML. Chciałaby dowiedzieć się więcej o AI/ML i wykorzystaniu usług AWS do odkrywania rozwiązań, z których mogą skorzystać klienci.

Medha Aiyah jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Austin w Teksasie. Niedawno ukończyła studia na Uniwersytecie Teksasu w Dallas w grudniu 2022 r., uzyskując tytuł magistra informatyki ze specjalizacją w inteligentnych systemach, ze szczególnym uwzględnieniem sztucznej inteligencji/ML. Chciałaby dowiedzieć się więcej o AI/ML i wykorzystaniu usług AWS do odkrywania rozwiązań, z których mogą skorzystać klienci.

Hugo Tse jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Seattle w stanie Waszyngton. Posiada tytuł magistra w dziedzinie technologii informatycznych uzyskany na Uniwersytecie Stanowym w Arizonie oraz tytuł licencjata w dziedzinie ekonomii uzyskany na Uniwersytecie w Chicago. Jest członkiem Stowarzyszenia Audytu i Kontroli Systemów Informacyjnych (ISACA) oraz Międzynarodowego Konsorcjum Certyfikacji Bezpieczeństwa Systemów Informacyjnych (ISC)2. Lubi pomagać klientom czerpać korzyści z technologii.

Hugo Tse jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Seattle w stanie Waszyngton. Posiada tytuł magistra w dziedzinie technologii informatycznych uzyskany na Uniwersytecie Stanowym w Arizonie oraz tytuł licencjata w dziedzinie ekonomii uzyskany na Uniwersytecie w Chicago. Jest członkiem Stowarzyszenia Audytu i Kontroli Systemów Informacyjnych (ISACA) oraz Międzynarodowego Konsorcjum Certyfikacji Bezpieczeństwa Systemów Informacyjnych (ISC)2. Lubi pomagać klientom czerpać korzyści z technologii.

Aymana Ishimwe jest zastępcą architekta rozwiązań w AWS z siedzibą w Seattle w stanie Waszyngton. Uzyskał tytuł magistra inżynierii oprogramowania i informatyki na Uniwersytecie Oakland. Ma wcześniejsze doświadczenie w tworzeniu oprogramowania, szczególnie w budowaniu mikroserwisów dla rozproszonych aplikacji internetowych. Jego pasją jest pomaganie klientom w budowaniu solidnych i skalowalnych rozwiązań w usługach chmurowych AWS, zgodnie z najlepszymi praktykami.

Aymana Ishimwe jest zastępcą architekta rozwiązań w AWS z siedzibą w Seattle w stanie Waszyngton. Uzyskał tytuł magistra inżynierii oprogramowania i informatyki na Uniwersytecie Oakland. Ma wcześniejsze doświadczenie w tworzeniu oprogramowania, szczególnie w budowaniu mikroserwisów dla rozproszonych aplikacji internetowych. Jego pasją jest pomaganie klientom w budowaniu solidnych i skalowalnych rozwiązań w usługach chmurowych AWS, zgodnie z najlepszymi praktykami.

Shervin Suresh jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Austin w Teksasie. Uzyskał tytuł magistra inżynierii oprogramowania ze specjalizacją w przetwarzaniu w chmurze i wirtualizacji oraz tytuł licencjata inżynierii komputerowej na Uniwersytecie Stanowym w San Jose. Jego pasją jest wykorzystywanie technologii w celu poprawy życia ludzi ze wszystkich środowisk.

Shervin Suresh jest architektem rozwiązań stowarzyszonych w AWS z siedzibą w Austin w Teksasie. Uzyskał tytuł magistra inżynierii oprogramowania ze specjalizacją w przetwarzaniu w chmurze i wirtualizacji oraz tytuł licencjata inżynierii komputerowej na Uniwersytecie Stanowym w San Jose. Jego pasją jest wykorzystywanie technologii w celu poprawy życia ludzi ze wszystkich środowisk.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Motoryzacja / pojazdy elektryczne, Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- ChartPrime. Podnieś poziom swojej gry handlowej dzięki ChartPrime. Dostęp tutaj.

- Przesunięcia bloków. Modernizacja własności offsetu środowiskowego. Dostęp tutaj.

- Źródło: https://aws.amazon.com/blogs/machine-learning/simplify-access-to-internal-information-using-retrieval-augmented-generation-and-langchain-agents/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 000

- 10

- 100

- 125

- 2022

- 50

- 7

- a

- Zdolny

- O nas

- Akceptuj

- dostęp

- Dostęp

- Konta

- dokładny

- dokładnie

- działania

- aktywny

- Dodaj

- do tego

- Adresy

- adresowanie

- Administratorzy

- Przyjęcie

- doradcy

- Po

- Agent

- agentów

- agregat

- AI

- Usługi AI

- AI / ML

- Wszystkie kategorie

- pozwala

- wzdłuż

- również

- alternatywny

- Amazonka

- Brama Amazon API

- Amazon Cognito

- Amazon Comprehend

- Amazonka Kendra

- Amazon Sage Maker

- Amazon SageMaker JumpStart

- Amazon Web Services

- ilość

- kwoty

- an

- analitycy

- ćwiczenie

- i

- odpowiedź

- odpowiedzi

- każdy

- api

- pozorny

- Zastosowanie

- aplikacje

- spotkanie

- podejście

- Zatwierdzać

- architektura

- SĄ

- powstać

- Arizona

- na około

- artykuł

- sztuczny

- sztuczna inteligencja

- Sztuczna inteligencja (AI)

- dzieła sztuki

- AS

- zapytać

- aspekty

- oszacować

- pomagać

- Wsparcie

- Współpracownik

- powiązany

- Stowarzyszenie

- założenie

- At

- Audyt

- zwiększona

- Austin

- uwierzytelniony

- Uwierzytelnianie

- autoryzacja

- zautomatyzować

- automatycznie

- dostępność

- dostępny

- AWS

- AWS Lambda

- z powrotem

- tła

- baza

- na podstawie

- BE

- Niedźwiedź

- bo

- stają się

- staje się

- być

- zanim

- w imieniu

- za

- korzyści

- Korzyści

- BEST

- Najlepsze praktyki

- Ulepsz Swój

- Blog

- książka

- Bot

- obie

- boty

- Dolny

- marka

- budżet

- budować

- Budowanie

- wybudowany

- biznes

- biznes

- ale

- by

- wezwanie

- CAN

- możliwości

- Kariera

- ostrożnie

- walizka

- Etui

- Kategoria

- powodowany

- Centrum

- scentralizowane

- pewien

- Certyfikacja

- łańcuch

- wyzwania

- zmiana

- naładowany

- chatbot

- kontrola

- Wykrywanie urządzeń szpiegujących

- Chicago

- roszczenia

- jasny

- Kliniczne

- Badania kliniczne

- Chmura

- cloud computing

- usługi w chmurze

- zbierać

- kolekcja

- komercyjnie

- wspólny

- Komunikacja

- Firmy

- sukcesy firma

- Firma

- konkurencyjny

- Zakończony

- wypełniając

- kompleks

- kompleksowość

- wykonania

- zrozumieć

- komputer

- Inżynieria komputerowa

- Computer Science

- computing

- stężenie

- pojęcie

- zwięzły

- przeprowadzone

- zbieg

- Skontaktuj się

- łączy

- wynagrodzenie

- Rozważania

- za

- zgodny

- Składający się

- Konsola

- konsorcjum

- konsumować

- konsumpcja

- skontaktuj się

- contact center

- zawiera

- zawartość

- kontekst

- bez przerwy

- przyczynia się

- kontrola

- kontrolowania

- wygoda

- Rozmowa

- konwersacyjny

- rozmowy

- Korporacyjny

- skorygowania

- Koszty:

- Koszty:

- crawler

- Stwórz

- Utwórz wartość

- stworzony

- Tworzenie

- kredyt

- Kryteria

- krytyczny

- CRM

- istotny

- kurator

- Aktualny

- Obecnie

- klient

- Zaangażowanie klienta

- doświadczenie klienta

- Obsługa klienta

- Obsługa klienta

- Klientów

- codziennie

- Dallas

- dane

- punkty danych

- zestawy danych

- Baza danych

- Data

- grudzień

- zdecydować

- decyzja

- Podejmowanie decyzji

- Decyzje

- Stopień

- dostarczona

- W zależności

- wdrażane

- wdrażanie

- opisać

- Wnętrze

- Mimo

- detale

- wykryte

- Wykrywanie

- Deweloper

- oprogramowania

- wydarzenia

- różne

- trudny

- odkryj

- dystrybuowane

- dokumentacja

- dokumenty

- robi

- Nie

- napęd

- czas trwania

- e

- łatwiej

- z łatwością

- ekonomia

- Ekosystem

- edycja

- efektywność

- wysiłek

- bądź

- kwalifikowalność

- e-maile

- Pracownik

- pracowników

- Umożliwia

- zachęca

- Punkt końcowy

- energia

- zaręczynowy

- silnik

- Inżynieria

- wzbogacanie

- zapewnić

- zapewnia

- zapewnienie

- Enterprise

- przedsiębiorstwa

- podmioty

- Błędy

- eskalacja

- oszacowanie

- itp

- Parzyste

- przykład

- wykonać

- Przede wszystkim system został opracowany

- drogi

- doświadczenie

- Wyjaśniać

- Objaśnia

- ekstrakcja

- Wyciągi

- Twarz

- członków Twojej rodziny

- Cecha

- nakarmiony

- mniej

- Postać

- filet

- wypełniać

- wypełniony

- Nadzienie

- filtrować

- budżetowy

- dane finansowe

- historia finansowa

- instytucja finansowa

- finansowanie

- Znajdź

- znalezieniu

- i terminów, a

- Elastyczność

- pływ

- skupienie

- następujący

- W razie zamówieenia projektu

- Nasz formularz

- formularze

- Forum

- znaleziono

- Fundacja

- Ramy

- Darmowy

- przyjaciele

- od

- zabawa

- funkcjonować

- Funkcje

- dalej

- Wzrost

- Bramka

- Generować

- generacja

- generatywny

- generatywna sztuczna inteligencja

- otrzymać

- dany

- daje

- Dający

- Rząd

- bardzo

- Rosnąć

- Rozwój

- Rośnie

- poradnictwo

- wytyczne

- uchwyt

- Uchwyty

- Prowadzenie

- Have

- mający

- he

- Zdrowie

- informacje o zdrowiu

- opieki zdrowotnej

- pomoc

- pomoc

- pomaga

- jej

- Wysoki

- wysoko

- jego

- historia

- posiada

- hostowane

- gospodarze

- GODZINY

- W jaki sposób

- How To

- Jednak

- hr

- HTML

- HTTPS

- człowiek

- i

- identyfikator

- identyfikatory

- identyfikuje

- zidentyfikować

- identyfikacja

- tożsamość

- if

- ilustruje

- wdrożenia

- wykonawczych

- implikacje

- podnieść

- poprawia

- poprawy

- in

- informacje

- niedokładny

- zawierać

- obejmuje

- Włącznie z

- Dochód

- podatek dochodowy

- Zwiększać

- Zwiększenia

- wskaźnik

- zindeksowane

- indeksy

- osób

- przemysłowa

- informować

- Informacja

- Systemy informacyjne

- technologia informacyjna

- poinformowany

- dziedzictwo

- wkład

- przykład

- natychmiastowy

- zamiast

- Instytucja

- instytucje

- ubezpieczenie

- zintegrowany

- Integruje się

- integracja

- Inteligencja

- Inteligentny

- zamiar

- interakcji

- interaktywne

- zainteresowany

- Interfejs

- wewnętrzny

- na świecie

- najnowszych

- inwestycja

- problem

- IT

- szt

- podróż

- jpg

- Trzymać

- wiedza

- znany

- język

- duży

- warstwa

- prowadzić

- UCZYĆ SIĘ

- nauka

- mniej

- poziom

- lewarowanie

- Biblioteka

- ograniczenie

- Ograniczenia

- Linia

- Zyje

- LLM

- pożyczka

- Kredyty

- log

- logiczny

- długo

- długi czas

- dłużej

- Popatrz

- Partia

- kocha

- low-cost

- niższy

- wierny

- Lojalność

- maszyna

- uczenie maszynowe

- zrobiony

- utrzymać

- robić

- WYKONUJE

- Dokonywanie

- zarządzanie

- i konserwacjami

- sposób

- podręcznik

- ręcznie

- wiele

- rynek

- badania rynku

- mistrzowski

- Może..

- znaczy

- medyczny

- członek

- Pamięć

- mikroserwisy

- Microsoft

- milion

- miliony

- nic

- ML

- model

- modele

- Moduł

- Miesiąc

- miesięcznie

- jeszcze

- większość

- wielokrotność

- rodzimy

- niezbędny

- Potrzebować

- potrzebne

- wymagania

- Nowości

- Następny

- nlp

- powiadomienie

- z naszej

- Oakland

- przysięgać

- of

- Oferty

- często

- Olej

- on

- Wprowadzenie

- pewnego razu

- ONE

- trwający

- tylko

- koncepcja

- działać

- operacyjny

- operacyjny

- Okazja

- optymalizacja

- Option

- Opcje

- or

- zamówienie

- organizacji

- oryginalny

- Inne

- ludzkiej,

- na zewnątrz

- zarys

- zewnętrzne

- koniec

- paradygmat

- część

- strony

- minęło

- namiętny

- pacjent

- Zapłacić

- Ludzie

- dla

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- uprawnienia

- osobisty

- dane personalne

- Osobiście

- Przemysł farmaceutyczny

- Filar

- krok po kroku

- plato

- Analiza danych Platona

- PlatoDane

- Proszę

- punkt

- zwrotnica

- polityka

- Baseny

- Portal

- portrety

- możliwości

- możliwość

- Post

- powered

- praktyki

- teraźniejszość

- zapobiec

- poprzedni

- poprzednio

- wycena

- Model wyceny

- Wcześniejszy

- priorytet

- prywatność

- problemy

- procedury

- kontynuować

- wygląda tak

- Obrobiony

- procesów

- przetwarzanie

- Produkcja

- wydajność

- Produkty

- profesjonalny

- specjalistów

- własność

- zapewniać

- pod warunkiem,

- dostawców

- że

- opublikowany

- zakupione

- Q & A

- kwalifikować

- kwalifikacyjny

- zapytania

- pytanie

- pytania

- Szybki

- szybko

- zasięg

- Kurs

- Czytaj

- Czytający

- w czasie rzeczywistym

- niedawny

- niedawno

- zmniejszyć

- zmniejsza

- odnosić się

- odwoływanie się

- w sprawie

- regularnie

- regulamin

- związek

- mających znaczenie

- polegać

- szczątki

- pamiętać

- usunąć

- zażądać

- wywołań

- wymagać

- wymagany

- wymagania

- Badania naukowe

- Badacze

- Rozkład

- rozwiązywanie

- Zasoby

- odpowiedź

- Odpowiedzi

- odpowiedzialność

- REST

- dalsze

- powrót

- recenzja

- prawo

- ryzyko

- krzepki

- Trasa

- bieganie

- s

- sagemaker

- sole

- San

- San Jose

- klientów

- Zapisz

- skalowalny

- Skala

- scenariusz

- nauka

- wynik

- skrypty

- Szukaj

- poszukiwania

- Seattle

- druga

- sekund

- Sekcja

- bezpieczne

- bezpiecznie

- bezpieczeństwo

- Sprzedawanie

- wysłać

- senior

- wrażliwy

- wysłany

- Bezserwerowe

- służy

- usługa

- Usługi

- zestaw

- Zestawy

- w panelu ustawień

- kilka

- ona

- przesunięcie

- niedociągnięcia

- powinien

- prezentowany

- pokazał

- pokazane

- Silosy

- podobny

- Prosty

- upraszczać

- ponieważ

- pojedynczy

- wielkości

- mniejszy

- So

- Obserwuj Nas

- Tworzenie

- rozwoju oprogramowania

- Inżynieria oprogramowania

- rozwiązanie

- Rozwiązania

- kilka

- Źródło

- Źródła

- specjalizujący się

- specyficzny

- swoiście

- wydać

- Spędzanie

- standard

- Stan

- Rynek

- pobyt

- Ewolucja krok po kroku

- Cel

- Nadal

- przechowywanie

- sklep

- przechowywany

- przechowywania

- stres

- farsz

- znaczny

- taki

- sugerować

- streszczać

- wsparcie

- system

- systemy

- stół

- trwa

- zadania

- podatek

- zespół

- Zespoły

- Technologia

- REGULAMIN

- texas

- XNUMX

- tekstowy

- że

- Połączenia

- Informacje

- ich

- sami

- następnie

- Tam.

- Te

- one

- innych firm

- to

- Przez

- bilet

- bilety

- poziom

- czas

- czasochłonne

- aktualny

- czasy

- znak czasu

- tytan

- do

- już dziś

- Żetony

- narzędzie

- narzędzia

- Możliwość śledzenia

- tradycyjnie

- przeszkolony

- Trening

- transformator

- Przezroczystość

- leczenie

- próba

- Próby

- Tutorial

- typy

- niezdolny

- zrozumieć

- zrozumienie

- wyjątkowy

- Uniwersytety

- uniwersytet

- University of Chicago

- nowomodny

- zaktualizowane

- aktualizowanie

- posługiwać się

- przypadek użycia

- używany

- Użytkownik

- Użytkownicy

- zastosowania

- za pomocą

- wykorzystać

- wykorzystany

- Wykorzystując

- wartość

- różnorodny

- Weryfikacja

- zweryfikować

- pionowe

- przez

- Wideo

- Filmy

- Głos

- czekać

- Czekanie

- była

- Waszyngton

- sposoby

- we

- sieć

- Aplikacja internetowa

- Aplikacje internetowe

- usługi internetowe

- DOBRZE

- były

- Co

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- KIM

- szeroki

- Szeroki zasięg

- w

- w ciągu

- Praca

- workflow

- pracujący

- by

- napisany

- lat

- You

- Twój

- zefirnet