Wprowadzenie

W uczeniu maszynowym kompromis między odchyleniami a wariancją jest podstawową koncepcją wpływającą na wydajność każdego modelu predykcyjnego. Odnosi się do delikatnej równowagi między błędem obciążenia a błędem wariancji modelu, ponieważ niemożliwe jest jednoczesne zminimalizowanie obu. Znalezienie właściwej równowagi ma kluczowe znaczenie dla osiągnięcia optymalnej wydajności modelu.

W tym krótkim artykule zdefiniujemy odchylenia i wariancje, wyjaśnimy, w jaki sposób wpływają one na model uczenia maszynowego, oraz udzielimy praktycznych porad, jak sobie z nimi radzić w praktyce.

Zrozumienie odchylenia i wariancji

Zanim zagłębimy się w związek między odchyleniem a wariancją, zdefiniujmy, co te terminy reprezentują w uczeniu maszynowym.

Błąd obciążenia odnosi się do różnicy między przewidywaniem modelu a poprawnymi wartościami, które próbuje przewidzieć (podstawowa prawda). Innymi słowy, stronniczość to błąd, który model popełnia z powodu błędnych założeń dotyczących rozkładu danych leżących u jego podstaw. Modele o wysokim obciążeniu są często zbyt uproszczone i nie potrafią uchwycić złożoności danych, co prowadzi do niedopasowania.

Z drugiej strony błąd wariancji odnosi się do wrażliwości modelu na niewielkie fluktuacje danych uczących. Modele o dużej wariancji są zbyt złożone i mają tendencję do dopasowywania szumu w danych, a nie podstawowego wzorca, co prowadzi do przeuczenia. Powoduje to słabą wydajność w przypadku nowych, niewidocznych danych.

Wysokie obciążenie może prowadzić do niedopasowania, gdy model jest zbyt prosty, aby uchwycić złożoność danych. Przyjmuje mocne założenia dotyczące danych i nie udaje mu się uchwycić prawdziwej relacji między zmiennymi wejściowymi i wyjściowymi. Z drugiej strony duża wariancja może prowadzić do przeuczenia, gdy model jest zbyt złożony i uczy się szumu w danych, a nie podstawowej relacji między zmiennymi wejściowymi i wyjściowymi. W związku z tym modele z nadmiernym dopasowaniem mają tendencję do zbyt ścisłego dopasowania danych treningowych i nie będą dobrze uogólniać na nowe dane, podczas gdy modele niedopasowane nie są nawet w stanie dokładnie dopasować danych treningowych.

Jak wspomniano wcześniej, obciążenie i wariancja są ze sobą powiązane, a dobry model równoważy błąd obciążenia i błąd wariancji. Kompromis między odchyleniami a wariancją to proces znajdowania optymalnej równowagi między tymi dwoma źródłami błędów. Model o niskim obciążeniu i niskiej wariancji prawdopodobnie będzie dobrze działał zarówno na danych uczących, jak i nowych, minimalizując całkowity błąd.

Kompromis między odchyleniem a wariancją

Osiągnięcie równowagi między złożonością modelu a jego zdolnością do uogólniania na nieznane dane jest podstawą kompromisu między odchyleniami a wariancją. Ogólnie rzecz biorąc, bardziej złożony model będzie miał mniejsze obciążenie, ale większą wariancję, podczas gdy prostszy model będzie miał większe obciążenie, ale mniejszą wariancję.

Ponieważ niemożliwe jest jednoczesne zminimalizowanie odchyleń i wariancji, znalezienie optymalnej równowagi między nimi ma kluczowe znaczenie w budowaniu solidnego modelu uczenia maszynowego. Na przykład, gdy zwiększamy złożoność modelu, zwiększamy również wariancję. Dzieje się tak, ponieważ bardziej złożony model z większym prawdopodobieństwem dopasuje szum do danych treningowych, co doprowadzi do przeuczenia.

Z drugiej strony, jeśli utrzymamy model zbyt prosty, zwiększymy obciążenie. Dzieje się tak, ponieważ prostszy model nie będzie w stanie uchwycić podstawowych relacji w danych, co doprowadzi do niedopasowania.

Celem jest wytrenowanie modelu, który jest wystarczająco złożony, aby uchwycić podstawowe relacje w danych szkoleniowych, ale nie tak złożony, aby pasował do szumu w danych szkoleniowych.

Kompromis między odchyleniem a wariancją w praktyce

Aby zdiagnozować wydajność modelu, zwykle obliczamy i porównujemy błędy pociągu i walidacji. Przydatnym narzędziem do wizualizacji tego jest wykres krzywych uczenia się, który pokazuje wydajność modelu zarówno w pociągu, jak iw danych walidacyjnych w całym procesie uczenia. Badając te krzywe, możemy określić, czy model jest nadmiernie dopasowany (wysoka wariancja), niedopasowany (wysoki błąd systematyczny) lub dobrze dopasowany (optymalna równowaga między odchyleniem a wariancją).

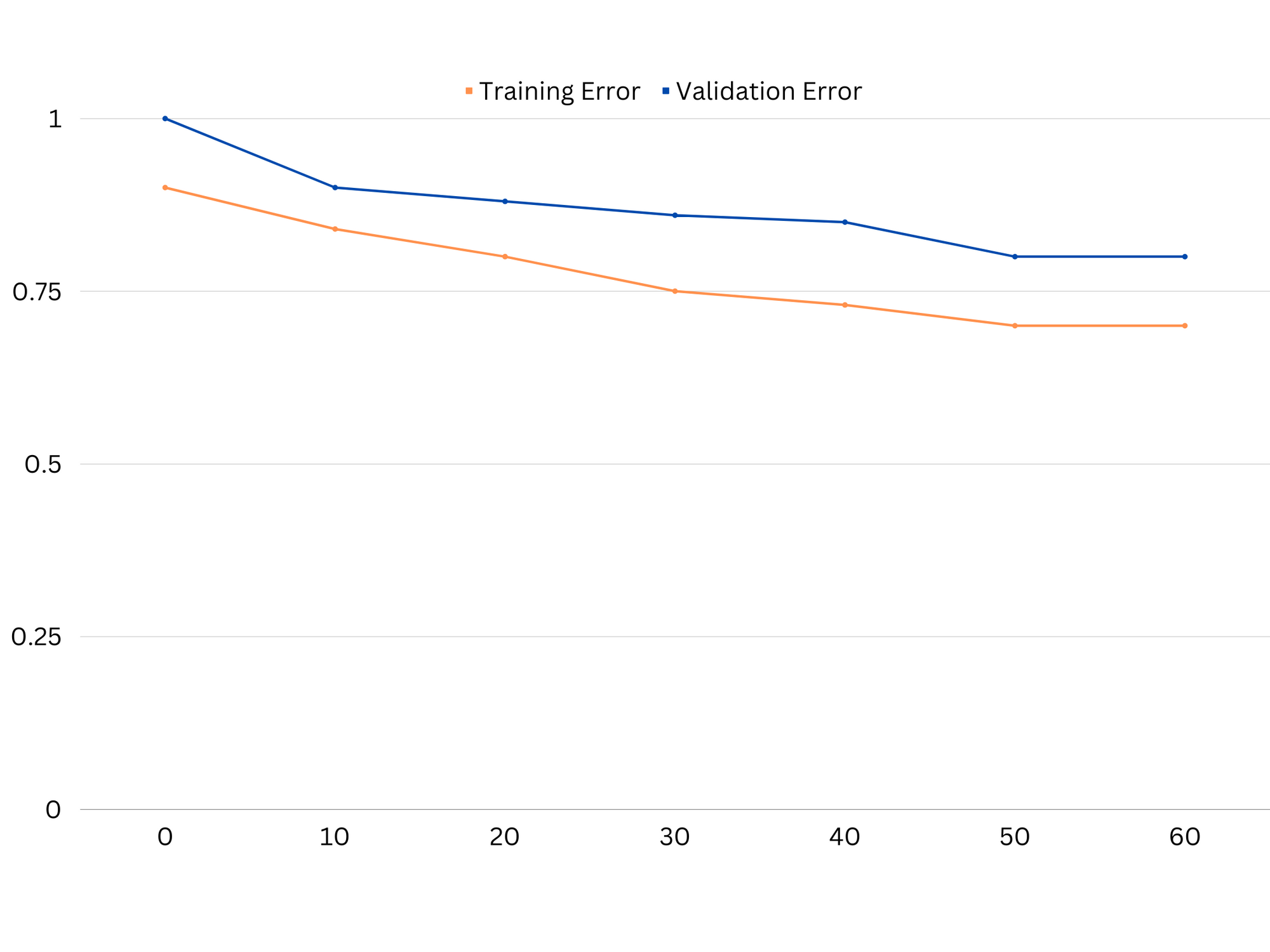

Przykład krzywych uczenia się niedopasowanego modelu. Zarówno błąd pociągu, jak i błąd walidacji są wysokie.

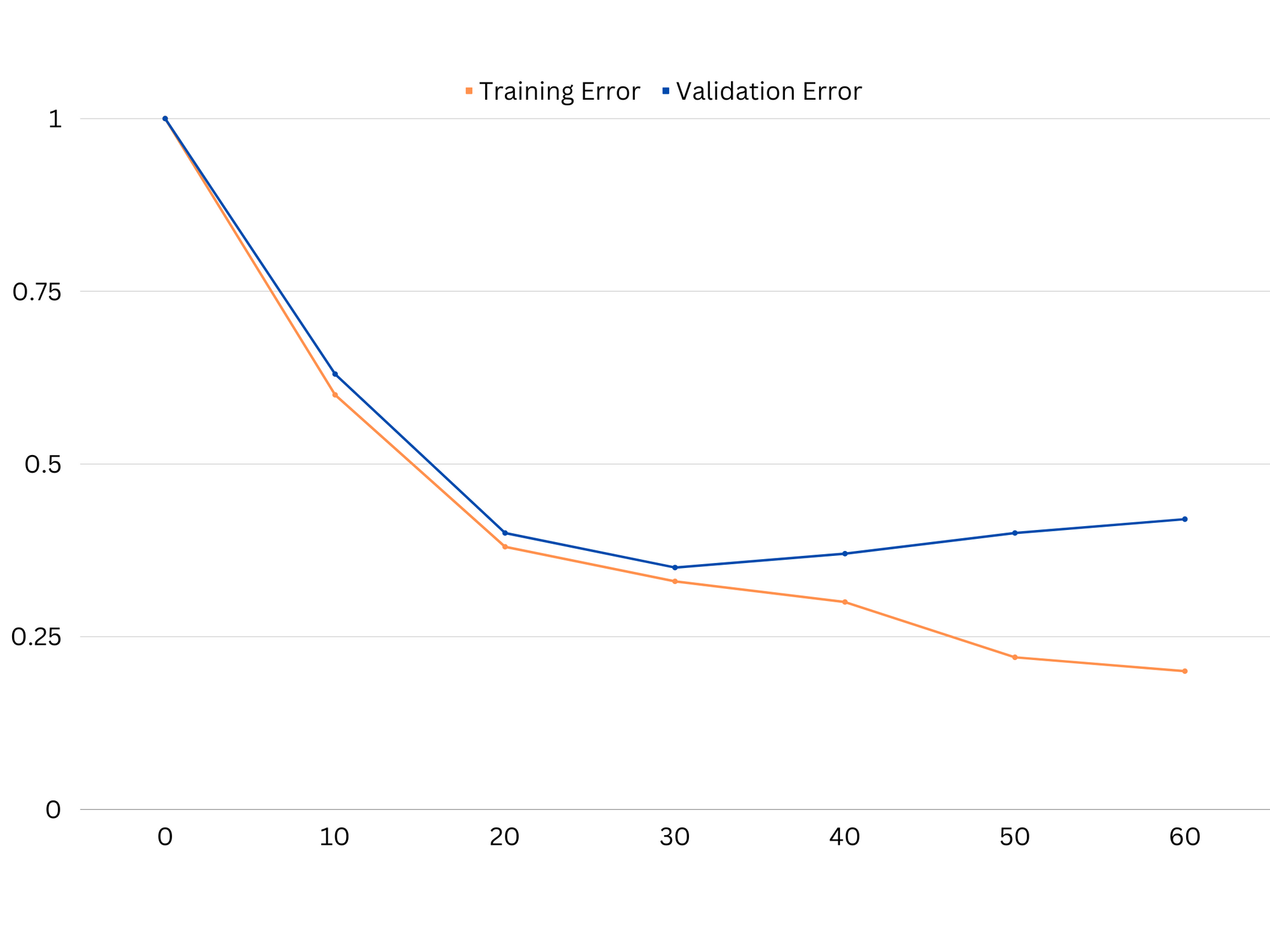

W praktyce niska wydajność zarówno danych uczących, jak i walidacyjnych sugeruje, że model jest zbyt prosty, co prowadzi do niedopasowania. Z drugiej strony, jeśli model działa bardzo dobrze na danych treningowych, ale słabo na danych testowych, złożoność modelu jest prawdopodobnie zbyt duża, co skutkuje nadmiernym dopasowaniem. Aby rozwiązać problem niedopasowania, możemy spróbować zwiększyć złożoność modelu, dodając więcej funkcji, zmieniając algorytm uczenia się lub wybierając inne hiperparametry. W przypadku nadmiernego dopasowania należy rozważyć uregulowanie modelu lub zastosowanie technik takich jak walidacja krzyżowa w celu poprawy jego możliwości uogólnienia.

Przykład krzywych uczenia się modelu z nadmiernym dopasowaniem. Błąd pociągu maleje, podczas gdy błąd sprawdzania poprawności zaczyna rosnąć. Model nie jest w stanie generalizować.

Regularyzacja to technika, której można użyć do zmniejszenia błędu wariancji w modelach uczenia maszynowego, pomagając rozwiązać problem kompromisu między odchyleniami a wariancją. Istnieje wiele różnych technik regularyzacji, z których każda ma swoje zalety i wady. Niektóre popularne techniki regularyzacji obejmują regresję grzbietową, regresję lasso i regularyzację elastycznej sieci. Wszystkie te techniki pomagają zapobiegać nadmiernemu dopasowaniu poprzez dodanie kary do funkcji celu modelu, co zniechęca do ekstremalnych wartości parametrów i zachęca do prostszych modeli.

Regresja grzbietu, znana również jako regularyzacja L2, dodaje składnik karny proporcjonalny do kwadratu parametrów modelu. Technika ta zwykle skutkuje modelami o mniejszych wartościach parametrów, co może prowadzić do zmniejszenia wariancji i lepszego uogólnienia. Jednak nie wykonuje wyboru funkcji, więc wszystkie funkcje pozostają w modelu.

Zapoznaj się z naszym praktycznym, praktycznym przewodnikiem dotyczącym nauki Git, zawierającym najlepsze praktyki, standardy przyjęte w branży i dołączoną ściągawkę. Zatrzymaj polecenia Google Git, a właściwie uczyć się to!

Regresja lasso, czyli regularyzacja L1, dodaje termin kary proporcjonalny do wartości bezwzględnej parametrów modelu. Ta technika może prowadzić do modeli o rzadkich wartościach parametrów, skutecznie dokonujących selekcji cech poprzez ustawienie niektórych parametrów na zero. Może to skutkować prostszymi modelami, które są łatwiejsze do interpretacji.

Elastyczna regularyzacja sieci jest połączeniem regularyzacji zarówno L1, jak i L2, co pozwala na zachowanie równowagi między regresją grzbietu i lassa. Kontrolując stosunek między dwoma terminami kary, elastyczna sieć może osiągnąć korzyści obu technik, takie jak ulepszona generalizacja i wybór cech.

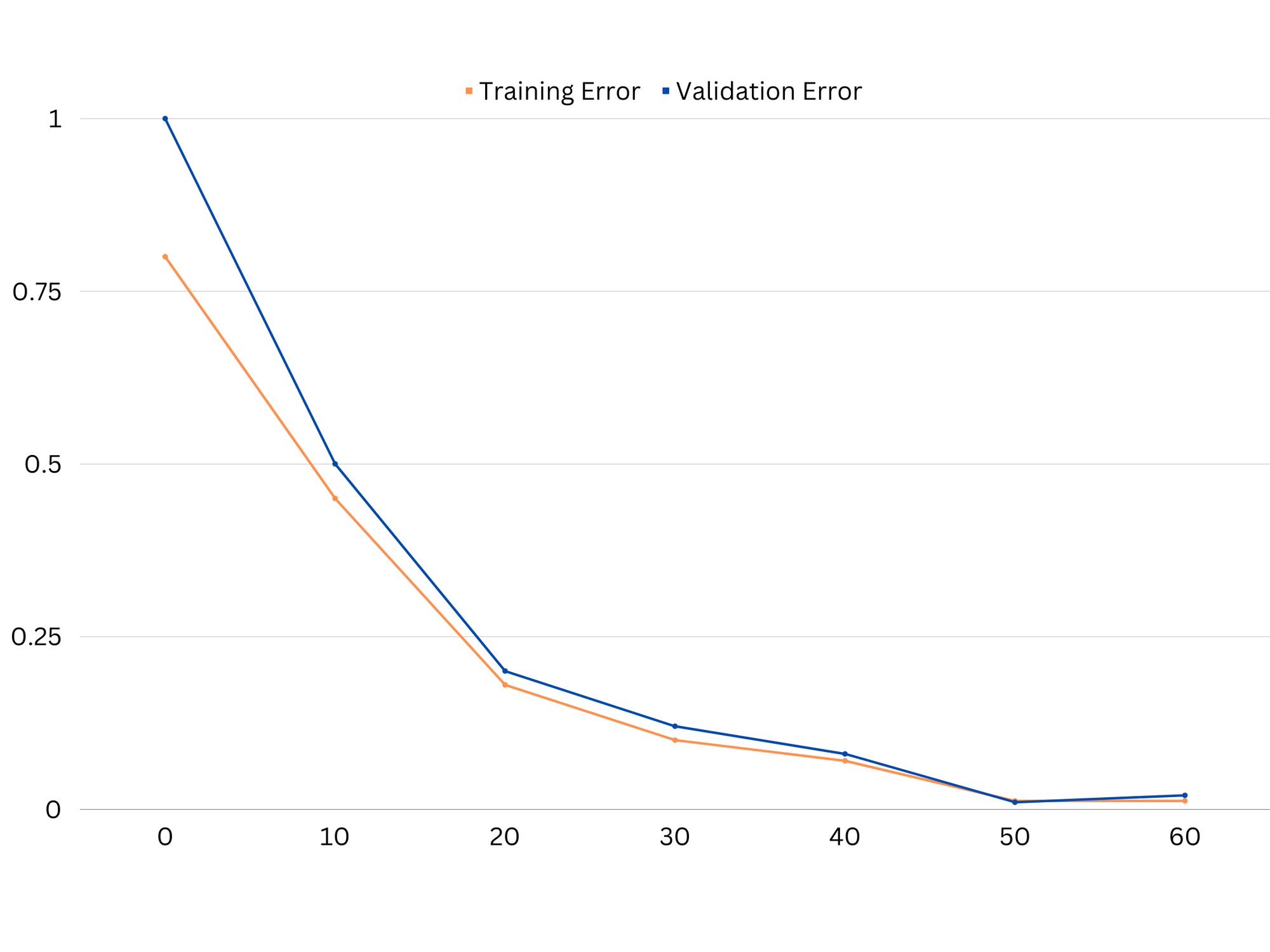

Przykład krzywych uczenia się dobrze dopasowanego modelu.

wnioski

Kompromis wariancji odchyleń jest kluczową koncepcją w uczeniu maszynowym, która określa skuteczność i dobroć modelu. Podczas gdy wysokie obciążenie prowadzi do niedopasowania, a wysoka wariancja do przeuczenia, znalezienie optymalnej równowagi między tymi dwoma jest niezbędne do zbudowania solidnych modeli, które dobrze uogólniają się na nowe dane.

Za pomocą krzywych uczenia można zidentyfikować problemy z nadmiernym lub niedopasowaniem, a poprzez dostrojenie złożoności modelu lub wdrożenie technik regularyzacji można poprawić wydajność zarówno danych treningowych i walidacyjnych, jak i danych testowych.

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoAiStream. Analiza danych Web3. Wiedza wzmocniona. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Kupuj i sprzedawaj akcje spółek PRE-IPO z PREIPO®. Dostęp tutaj.

- Źródło: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :Jest

- :nie

- :Gdzie

- 1

- 12

- 20

- 8

- a

- zdolność

- Zdolny

- O nas

- bezwzględny

- dokładnie

- Osiągać

- osiągnięcia

- faktycznie

- dodanie

- adres

- Dodaje

- Zalety

- Rada

- oddziaływać

- wpływający

- algorytm

- Wszystkie kategorie

- Pozwalać

- również

- an

- i

- każdy

- SĄ

- artykuł

- AS

- Bilans

- salda

- BE

- bo

- Korzyści

- pomiędzy

- stronniczość

- granica

- obie

- Budowanie

- ale

- by

- obliczać

- CAN

- możliwości

- zdobyć

- walizka

- wymiana pieniędzy

- Wybierając

- dokładnie

- połączenie

- porównać

- kompleks

- kompleksowość

- pojęcie

- Rozważać

- kontrolowania

- rdzeń

- skorygowania

- istotny

- dane

- sprawa

- zmniejsza

- Ustalać

- określa

- różnica

- różne

- wyświetlacze

- 分配

- robi

- z powodu

- każdy

- Wcześniej

- łatwiej

- faktycznie

- skuteczność

- zachęca

- dość

- błąd

- Błędy

- Parzyste

- Badanie

- przykład

- Wyjaśniać

- skrajny

- nie

- nie

- Cecha

- Korzyści

- znalezieniu

- dopasować

- dopasowywanie

- Wahania

- Skupiać

- W razie zamówieenia projektu

- funkcjonować

- fundamentalny

- Ogólne

- git

- cel

- dobry

- Ziemia

- poprowadzi

- ręka

- hands-on

- Have

- pomoc

- pomoc

- Wysoki

- wyższy

- unosić

- W jaki sposób

- How To

- Jednak

- HTTPS

- zidentyfikować

- if

- wykonawczych

- niemożliwy

- podnieść

- ulepszony

- in

- W innych

- zawierać

- włączony

- Zwiększać

- wzrastający

- wkład

- najnowszych

- Wprowadzenie

- IT

- JEGO

- Trzymać

- znany

- L1

- l2

- prowadzić

- prowadzący

- Wyprowadzenia

- nauka

- niech

- LG

- lubić

- Prawdopodobnie

- ll

- niski

- niższy

- maszyna

- uczenie maszynowe

- WYKONUJE

- wzmiankowany

- minimalizowanie

- model

- modele

- jeszcze

- niezbędny

- netto

- Nowości

- Hałas

- numer

- cel

- of

- często

- on

- Optymalny

- or

- Inne

- ludzkiej,

- na zewnątrz

- wydajność

- własny

- parametr

- parametry

- Wzór

- wykonać

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- wykonywania

- wykonuje

- plato

- Analiza danych Platona

- PlatoDane

- biedny

- Popularny

- możliwy

- Praktyczny

- praktyka

- przewidzieć

- przepowiednia

- zapobiec

- problemy

- wygląda tak

- zapewniać

- raczej

- stosunek

- zmniejszyć

- Zredukowany

- odnosi

- związane z

- związek

- Relacje

- pozostawać

- reprezentować

- dalsze

- wynikły

- Efekt

- prawo

- Pierścień

- krzepki

- s

- wybór

- Wrażliwość

- ustawienie

- Shadow

- arkusz

- Short

- powinien

- Prosty

- jednocześnie

- mały

- mniejszy

- So

- kilka

- Źródła

- Kwadratowa

- Nadużycie stosu

- standardy

- Stop

- silny

- taki

- Wskazuje

- Techniki

- semestr

- REGULAMIN

- test

- niż

- że

- Połączenia

- ich

- Im

- Tam.

- Te

- one

- to

- poprzez

- do

- także

- narzędzie

- Kwota produktów:

- Pociąg

- Trening

- przejście

- prawdziwy

- Prawda

- próbować

- drugiej

- zazwyczaj

- niezdolny

- zasadniczy

- nieznany

- używany

- za pomocą

- uprawomocnienie

- wartość

- Wartości

- początku.

- we

- DOBRZE

- Co

- czy

- który

- Podczas

- będzie

- w

- słowa

- zefirnet

- zero