Tak.. Mówię o aplikacjach AI – niezliczonych aplikacjach AI i nadchodzących, które szepczą ludziom, co mają robić…. jak to zrobić… ale nie o szeptaczach, którzy wchodzą w interakcję z chatbotami AI.

Zgodnie z IDC prognoz globalny rynek sztucznej inteligencji może osiągnąć wartość ponad 500 miliardów dolarów do 2024 r., czyli o ponad 50% więcej niż w 2021 r. Oznacza to, że przeszliśmy od eksperymentów biznesowych do zaakceptowania, że jest to integralna część strategii przedsiębiorstwa każdej wielkości. Jest to niezbędne narzędzie do przekształcania danych w spostrzeżenia, które pobudzają działania oparte na lepszych decyzjach. Nikt nie debatuje nad korzyściami płynącymi ze sztucznej inteligencji w zmniejszaniu ryzyka biznesowego i zwiększaniu zwrotu z inwestycji dzięki innowacjom. Ale, jak zawsze, istnieje… ALE… bezstronna sztuczna inteligencja łatwiej powiedzieć niż zrobić.

Te modele sztucznej inteligencji, które mają kluczowe znaczenie dla biznesu, muszą działać niezawodnie, zapewniając widoczność i odpowiedzialność. W przeciwnym razie niepowodzenie w tym przypadku ma tragiczne konsekwencje, które wpływają na przepływy pieniężne każdej firmy, a nawet mogą skutkować problemami prawnymi. Jedynym sposobem uniknięcia tego jest automatyzacja i przejrzystość, aby odpowiedzieć na jedno pytanie: „Czy możesz udowodnić, że ta aplikacja/obciążenie AI jest zbudowana etycznie”. Aka… jak rządzisz? A czy możesz udowodnić, że jest ona stale zarządzana?

To miejsce, w którym firmy lubią IBM zainwestowali w zarządzanie sztuczną inteligencją, aby zorganizować ogólny proces kierowania, zarządzania i monitorowania działań AI w organizacji. Podstawowym zadaniem jest upewnienie się, że wszystkie jednostki biznesowe pozostają proaktywne i wprowadzają ramy ładu korporacyjnego do inicjatyw w celu wzmocnienia zdolności do przestrzegania zasad i przepisów etycznych. W szczególności branże regulowane, takie jak bankowość i usługi finansowe, są prawnie zobowiązane do dostarczania dowodów w celu spełnienia wymagań organów regulacyjnych.

Wpływ sztucznej inteligencji rośnie wykładniczo w sektorze usług finansowych ze względu na ogromną presję transformacji cyfrowej. Jak powiedziano, łatwiej powiedzieć niż zrobić, ponieważ:

1. Pewna operacjonalizacja aplikacji AI:

W niektórych przypadkach modele są budowane bez przejrzystości i katalogowania; nie trzeba dodawać, że monitorowanie wymyka się pośród wszystkiego, aby śledzić pełny cykl życia. Podczas gdy banki zmagają się ze starszymi aplikacjami, automatyzacja procesów w celu zapewnienia przejrzystości i zrozumiałości stała się trudniejsza, co z kolei stało się czarną skrzynką. Nikt nie wie, dlaczego/w jaki sposób zapadły decyzje. Nowe aplikacje splątane ze starszymi aplikacjami nigdy nie ujrzą światła dziennego, chociaż wiąże się z tym ogromny zwrot z inwestycji ze względu na jakość i niezauważalne ryzyko.

To prowadzi nas do drugiego punktu – zarządzania ryzykiem reputacyjnym

2. Zarządzaj ryzykiem reputacji wraz z ryzykiem ogólnym

zapytałem #czatGPT i #Bard – kim jest Padma Chukka. #CzatGPT odmówił odpowiedzi, nawet jeśli zmieniłem pytanie na wiele sposobów. Mimo to Bard udzielił mi szczegółowej odpowiedzi, w tym mojego profilu na LinkedIn… ale dane pochodzą z różnych stron, w których mój stary profil nadal istnieje jako część biografii głośnika. Od tego momentu jeszcze nie otworzyłem Barda. Tak szybko zostałem wyłączony, czyli – Ryzyko utraty reputacji. Załóżmy, że mogę wyłączyć prostego chatbota, gdy zdaję sobie sprawę, że dane mogą być niespójne. Jak mogłem nie upewnić się przed podjęciem decyzji o zakupie aplikacji wykorzystującej sztuczną inteligencję do prowadzenia krytycznej działalności? Ryzyko utraty reputacji jest istotnym czynnikiem, o którym czasami firmy zapominają. Jeśli skwantyfikujesz ryzyko utraty reputacji, zobaczysz ogromny wpływ na biznes, jeśli nie będziesz proaktywny.

Aby zwiększyć złożoność, trzeci to…

3. Jak firma może zareagować na zmieniające się przepisy dotyczące AI?

Aby uniknąć ryzyka utraty reputacji, odnoszący sukcesy i odpowiedzialny zespół sztucznej inteligencji powinien znać wszystkie lokalne i globalne przepisy, upuszczając je jak film tik-tak z natychmiastowym powiadomieniem. A niezgodność może ostatecznie kosztować organizację miliony dolarów grzywny związanej z pracami, takimi jak proponowana ustawa UE o sztucznej inteligencji. Może to być nawet 30 milionów euro lub 6% globalnych przychodów firmy – OUCH.

Cóż, nie wszystko musi być różowe od samego początku… tak długo, jak wiemy, jak zmienić przerażającą sytuację w różową.

Bez niespodzianek… to zawsze ludzie, proces i technologia. Więc najpierw stwórz wielofunkcyjny organ zarządzający, aby edukować, kierować i monitorować inicjatywy oparte na celach. Następnie porównaj obecną technologię i procesy sztucznej inteligencji, zrozum luki, a następnie zastosuj środki zaradcze, aby były przyszłościowe. Następnie skorzystaj z zestawu zautomatyzowanych przepływów pracy nadzoru zgodnych z wymaganiami dotyczącymi zgodności. Na koniec skonfiguruj system monitorowania, aby ostrzegał właścicieli, jeśli zbliża się akceptowalny próg. Od strony technologii dobrze zaprojektowana, dobrze wykonana i dobrze połączona sztuczna inteligencja wymaga wielu elementów konstrukcyjnych. I upewnij się, że ma niektóre lub wszystkie możliwości:

· Integralność danych w różnych wdrożeniach

· Używaj otwartych, elastycznych istniejących narzędzi zgodnych z AI Governance

· Upewnij się, że oferujesz samoobsługowy dostęp z kontrolą prywatności – sposób na śledzenie

· Projektuj z myślą o zarządzaniu automatyzacją i sztuczną inteligencją

· Może łączyć się i dostosowywać do potrzeb wielu interesariuszy dzięki konfigurowalnemu przepływowi pracy

Kiedy zmienimy aplikację z przerażającej na różową… następnym pytaniem jest, jak udowodnisz…

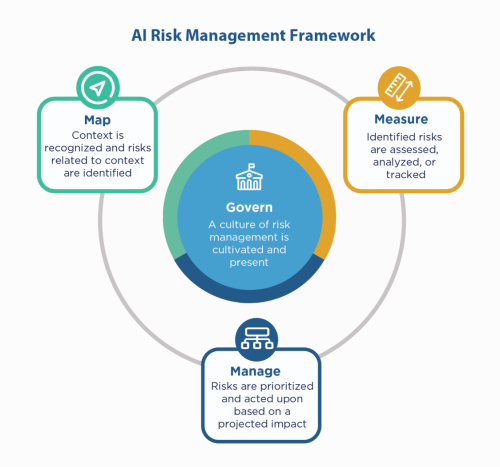

Po pierwsze, oprzyj się na zasadach sztucznej inteligencji firmy – buduj z nimi, a mimo to nadal musisz „pokazywać”, że przestrzegasz zasad, zwłaszcza w środowiskach regulowanych, takich jak usługi finansowe. Ponieważ usługi finansowe muszą złożyć skargę do NIST 800-53, mogą spojrzeć na Ramy zarządzania ryzykiem AI NIST (AI RMF). NIST zasugerował kontrole w czterech rodzinach – Rządź, Mapuj, Mierz i Zarządzaj. Używając tego jako czynnika przewodniego, przetestuj aplikacje w warunkach skrajnych, aby zidentyfikować luki, które należy naprawić i monitorować.

IBM może zweryfikować Twoje modele przed wprowadzeniem ich do produkcji, a także monitorować ich rzetelność, jakość i dryf. Może również dostarczyć dokumentację wyjaśniającą zachowanie modelu i prognozy, aby spełnić wymagania organów regulacyjnych i audytorów. Wyjaśnienia te mogą zapewnić przejrzystość i złagodzić ból związany z audytem oraz zwiększyć przejrzystość i zdolność do określania możliwych zagrożeń.

Słuchaj tych szeptów AI z ufnością!

#Usługi finansowe #odpowiedzialnyai #etyka #NISTAIRMF

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. Dostęp tutaj.

- Wybijanie przyszłości w Adryenn Ashley. Dostęp tutaj.

- Źródło: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :Jest

- $W GÓRĘ

- 2021

- 2024

- 7

- a

- zdolność

- O nas

- do przyjęcia

- dostęp

- odpowiedzialność

- w poprzek

- działać

- Działania

- zajęcia

- przylegać

- AI

- Ustawa o sztucznej inteligencji

- Zarządzanie AI

- aka

- Alarm

- Wszystkie kategorie

- zawsze

- i

- odpowiedź

- Aplikacja

- Zastosowanie

- aplikacje

- mobilne i webowe

- SĄ

- na około

- AS

- powiązany

- At

- Audyt

- audytorzy

- zautomatyzowane

- automatyzacja

- Automatyzacja

- z powrotem

- Bankowość

- Banki

- na podstawie

- BE

- bo

- zanim

- jest

- Benchmark

- Korzyści

- Ulepsz Swój

- Miliard

- Czarny

- Bloki

- ciało

- Pudełko

- Przynosi

- budować

- Budowanie

- wybudowany

- biznes

- kupować

- by

- CAN

- możliwości

- walizka

- Etui

- Gotówka

- Przepływy pieniężne

- wymiana pieniędzy

- chatbot

- nasze chatboty

- klarowność

- zamknięcie

- Firmy

- sukcesy firma

- kompleksowość

- spełnienie

- zgodny

- Prowadzenie

- ufnie

- Skontaktuj się

- Konsekwencje

- bez przerwy

- kontroli

- Koszty:

- mógłby

- Stwórz

- krytyczny

- Aktualny

- konfigurowalny

- cykl

- dane

- debatują

- Decydowanie

- Decyzje

- spadek

- Wnętrze

- szczegółowe

- Ustalać

- cyfrowy

- cyfrowy Transformacja

- straszny

- kierować

- kierowniczy

- inny

- dokumentacja

- dolarów

- Rzut

- łatwiej

- kształcić

- koniec końców

- zapewnić

- Enterprise

- środowiska

- szczególnie

- niezbędny

- etyczny

- EU

- euro

- Parzyste

- Każdy

- wszystko

- dowód

- Przede wszystkim system został opracowany

- istnieje

- wyjaśniając

- wykładniczo

- Brak

- uczciwość

- Spadać

- rodzin

- W końcu

- budżetowy

- usługi finansowe

- koniec

- Finextra

- i terminów, a

- elastyczne

- pływ

- W razie zamówieenia projektu

- Framework

- od

- od 2021

- przyszłość

- Dać

- Globalne

- zarządzanie

- Rozwój

- Have

- W jaki sposób

- How To

- HTTPS

- olbrzymi

- Ludzie

- i

- zidentyfikować

- Rezultat

- in

- Włącznie z

- Zwiększać

- wskazuje

- przemysłowa

- wpływ

- inicjatywy

- Innowacja

- spostrzeżenia

- integralny

- integralność

- interakcji

- zainwestowany

- IT

- JEGO

- Praca

- Wiedzieć

- Dziedzictwo

- Regulamin

- aspekty prawne

- życie

- lubić

- Linia

- miejscowy

- długo

- Popatrz

- zrobiony

- robić

- zarządzanie

- i konserwacjami

- zarządzający

- mapa

- rynek

- Matters

- Może..

- zmierzyć

- Poznaj nasz

- może

- milion

- miliony

- model

- modele

- moment

- monitor

- monitorowane

- monitorowanie

- jeszcze

- wielokrotność

- niezbędny

- Potrzebować

- Nieproduktywny

- Nowości

- Następny

- nist

- Cele

- of

- oferta

- Stary

- on

- ONE

- koncepcja

- działać

- organizacja

- Inaczej

- ogólny

- właściciele

- Ból

- część

- Ludzie

- plato

- Analiza danych Platona

- PlatoDane

- punkt

- możliwy

- Przewidywania

- nacisk

- pierwotny

- Zasady

- prywatność

- Proaktywne

- wygląda tak

- procesów

- Produkcja

- Profil

- dowód

- zaproponowane

- Udowodnij

- zapewniać

- położyć

- jakość

- pytanie

- szybko

- dosięgnąć

- zrealizować

- regulowane

- branże regulowane

- Regulacja

- regulamin

- Regulatory

- reputacja

- wymagany

- wymagania

- Wymaga

- Odpowiadać

- odpowiedzialny

- dalsze

- dochód

- Ryzyko

- Zarządzanie ryzykiem

- ryzyko

- ROI

- Różany

- s

- Powiedział

- druga

- sektor

- Samoobsługa

- Usługi

- zestaw

- powinien

- pokazać

- bok

- Prosty

- ponieważ

- Witryny

- sytuacja

- rozmiary

- So

- kilka

- Iskra

- Głośnik

- interesariusze

- pobyt

- Nadal

- Strategia

- Wzmacniać

- stres

- Walka

- udany

- system

- rozmawiać

- zespół

- Technologia

- test

- że

- Połączenia

- Im

- Te

- Trzeci

- próg

- Przez

- do

- narzędzie

- narzędzia

- śledzić

- Transformacja

- Przezroczystość

- ogromny

- SKRĘCAĆ

- Obrócony

- Ostatecznie

- zrozumieć

- jednostek

- zbliżających

- us

- posługiwać się

- UPRAWOMOCNIĆ

- różnorodny

- Wideo

- widoczność

- Droga..

- sposoby

- Co

- Podczas

- KIM

- w

- bez

- Praca

- przepływów pracy

- You

- Twój

- zefirnet