Protokół Gensyn bez zaufania trenuje sieci neuronowe w hiperskali przy niższym rzędzie wielkości kosztów

Spinki do mankietów: Strona Gensyn, Dokument papierowy, Portfolio CoinFund, Artykuł TechCrunch Połączyć

Podsumowanie tezy inwestycyjnej

- Świecka dźwignia dla rosnącej złożoności i wartości ML: Złożoność obliczeniowa najnowocześniejszych systemów sztucznej inteligencji podwaja się co 3 miesiące, podczas gdy wartość tych modeli nadal szybko rośnie, podczas gdy dawna czarna skrzynka tych algorytmów jest teraz coraz bardziej zdolna do dopasowania iluminatory zrozumiałe dla człowieka.

- Nowatorski projekt systemu koordynacji i weryfikacji: Gensyn buduje system weryfikacyjny (testnet v1 zostanie wdrożony jeszcze w tym roku), który skutecznie rozwiązuje problem zależności od stanu w szkoleniu sieci neuronowych w dowolnej skali. System łączy punkty kontrolne uczenia modelu z testami probabilistycznymi, które kończą się w łańcuchu. Robi to wszystko bez zaufania, a koszty ogólne skalują się liniowo wraz z rozmiarem modelu (utrzymując stałe koszty weryfikacji).

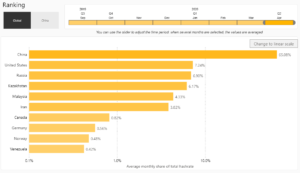

- Koncentracja tematyczna na decentralizacji AI: Większość znanych przykładów aplikacji uczenia maszynowego (Samochody Tesla, Google DeepMind) jest produkowanych przez ten sam zestaw firm, ponieważ branża uczenia głębokiego wygląda obecnie jak gra monopolowa między firmami Big Tech, ponieważ a także stany takie jak Chiny i Stany Zjednoczone. Siły te skutkują ogromnymi siłami centralizacji, które działają wbrew web3, a nawet historycznym początkom web1.

CoinFund z dumą wspiera ostatnią zbiórkę funduszy Gensyn Protocol oraz wizja zespołu, aby umożliwić bezproblemowe trenowanie sieci neuronowych w hiperskali i przy niskich kosztach za pomocą nowatorskiego systemu weryfikacji. Wykorzystanie testów probabilistycznych, które kończą się w łańcuchu podczas korzystania z niewykorzystane i niedostatecznie wykorzystywane źródła obliczeniowe, od obecnie niedostatecznie wykorzystywanych procesorów graficznych do gier po wyrafinowane pule wydobywcze ETH1, które mają się odłączyć od sieci Ethereum, gdy sieć przechodzi na Proof of Stake, protokół Gensyn nie wymaga nadzoru administracyjnego ani egzekwowania prawa, a raczej ułatwia programową dystrybucję zadań i płatności poprzez inteligentne kontrakty. Co więcej, zdecentralizowany charakter protokołu oznacza, że ostatecznie będzie on zarządzany przez większość społeczności i nie można go „wyłączyć” bez zgody społeczności; dzięki temu jest odporny na cenzurę, w przeciwieństwie do jego odpowiedników web2. Ostatecznie wierzymy, że Gensyn gra, aby stać się fundamentem dla natywnych dla web3 obliczeń ML, ponieważ uczestnicy zewnętrzni ostatecznie budują bogate doświadczenia użytkowników i specyficzne funkcje w wielu niszach.

Część 1: Wprowadzenie do wielodekadowego, sekularnego rozwoju Deep Learning

Każda twarz, którą widzisz podczas rozmowy wideo, i cały dźwięk, który słyszysz, są manipulowane. Aby poprawić jakość połączeń, sieci neuronowe wybiórczo dostosuj rozdzielczość w Zoom i tłumić hałas w tle w Microsoft Teams. Nowsze osiągnięcia pozwalają nawet zobaczyć wideo w niższej rozdzielczości „wymarzony” w wyższą rozdzielczość. Sieci neuronowe to modele wykorzystywane w branży uczenia głębokiego sztucznej inteligencji. Są luźno oparte na strukturze ludzki mózg i mają niezliczone zastosowania, być może ostatecznie tworząc sztuczną inteligencję na poziomie ludzkim. Większe modele na ogół dają lepsze wyniki, a sprzęt wymagany do najnowocześniejszego rozwoju podwaja się co każde trzy miesiące. Ta eksplozja rozwoju sprawiła, że głębokie uczenie się stało się fundamentalną częścią współczesnego ludzkiego doświadczenia. W 2020 roku sieć neuronowa obsługiwał radar na amerykańskim samolocie szpiegowskim, modele językowe teraz piszą lepsze fałszywe wiadomości e-mail niż ludzie i algorytmy autonomicznego samochodu przewyższają ludzi w wielu środowiskach.

GPT-3 175B, największy model GPT-3 zaproponowany przez OpenAI w Brown i in. (2020) używał klastra 1,000 procesorów graficznych NVIDIA Tesla V100 do szkolenia — mniej więcej tyle, ile wynosi 355 lat szkolenia na jednym urządzeniu. DALL-E z Ramesh i in. (2021), kolejny model Transformera od OpenAI, ma 12 miliardów parametrów i został przeszkolony na ponad 400 milionach obrazów z napisami. OpenAI poniosło koszty szkolenia DALL-E, ale kontrowersyjnie odmówiło udostępnienia modelu, co oznacza, że być może jeden z najważniejszych najnowocześniejszych multimodalnych modeli głębokiego uczenia pozostaje niedostępny dla wszystkich z wyjątkiem kilku wybranych. Ogromne zapotrzebowanie na zasoby do ich budowy modele fundamentów stworzyć znaczące bariery dostępu, a bez metody łączenia zasobów przy jednoczesnym zdobywaniu wartości prawdopodobnie spowoduje stagnację w rozwoju sztucznej inteligencji. Wielu uważa, że te uogólnione modele są kluczem do odblokowania sztucznej ogólnej inteligencji (AGI), sprawiając, że obecna metoda treningu w odizolowanych, sztucznych silosach wydaje się absurdalna.

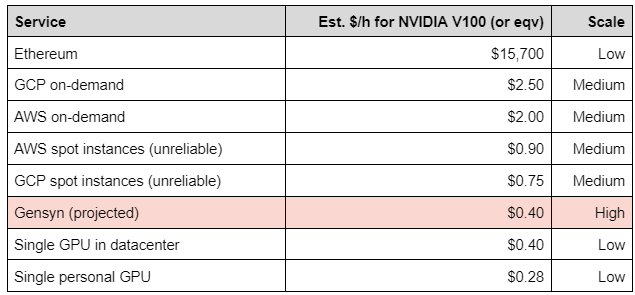

Obecne rozwiązania zapewniające dostęp do zasobów obliczeniowych są albo oligopolistyczne i drogie, albo po prostu niewykonalny biorąc pod uwagę złożoność obliczeń wymaganych dla sztucznej inteligencji na dużą skalę. Sprostanie rosnącemu popytowi wymaga systemu, który opłacalnie wykorzystuje cała kolekcja dostępnej mocy obliczeniowej (w przeciwieństwie do dzisiejszego ~40% globalnego wykorzystania procesora). W tej chwili problem ten potęguje fakt, że sama podaż obliczeniowa jest ograniczona przez asymptotyczny postępy w wydajności mikroprocesorów — równolegle łańcuch dostaw i geopolityczna braki chipów.

Część 2: Dlaczego potrzebna jest koordynacja Gensyna?

Podstawowym wyzwaniem w budowaniu tej sieci jest weryfikacja wykonanych prac ML. Jest to bardzo złożony problem, który znajduje się na przecięciu teorii złożoności, teorii gier, kryptografii i optymalizacji. Oprócz ludzkiej wiedzy na temat projektowania modeli istnieją trzy podstawowe problemy spowalniające postęp stosowanego uczenia maszynowego: 1) dostęp do mocy obliczeniowej; 2) dostęp do danych; oraz 3) dostęp do wiedzy (oznaczanie prawdy podstawowej). Gensyn rozwiązuje pierwszy problem, zapewniając dostęp na żądanie do globalnie skalowalnych zasobów obliczeniowych po uczciwej cenie rynkowej, podczas gdy Gensyn Foundation będzie dążyć do promowania rozwiązań dwóch i trzech poprzez badania, finansowanie i współpracę z innymi protokołami.

W szczególności dostęp do lepszych procesorów umożliwia trenowanie coraz większych/złożonych modeli. W ciągu ostatniej dekady wzrost gęstości tranzystorów i postęp w szybkości dostępu/równoległości dostępu do pamięci radykalnie skróciły czas uczenia się dużych modeli. Wirtualny dostęp do tego sprzętu, za pośrednictwem gigantów chmurowych, takich jak AWS i Alibaba, jednocześnie rozszerzył adopcję. W związku z tym istnieje duże zainteresowanie państwem w nabyciu środków do produkcji najnowocześniejszych procesorów. Chiny kontynentalne nie mają jeszcze możliwości kompleksowej produkcji najnowocześniejszych półprzewodników (mianowicie płytek krzemowych), stanowiących istotny element procesorów. Muszą je importować, szczególnie z TSMC (Taiwan Semiconductor Manufacturing Company). Sprzedawcy chipów próbują również zablokować innym klientom dostęp do producentów chipów kupując zapasy. Na poziomie stanowym Stany Zjednoczone agresywnie blokuje wszelkie posunięcia chińskich firm w celu nabycia tej technologii. Dalej w górę stosu technologicznego niektóre firmy posunęły się nawet do stworzenia własnego sprzętu do głębokiego uczenia się, takiego jak klastry TPU firmy Google. Te procesory graficzne przewyższają standardowe procesory graficzne w zakresie uczenia głębokiego i nie są dostępne w sprzedaży, a jedynie do wypożyczenia.

Znaczne zwiększenie skali dostępnych obliczeń, przy jednoczesnym obniżeniu ich kosztu jednostkowego, otwiera drzwi do zupełnie nowego paradygmatu uczenia głębokiego zarówno dla społeczności naukowych, jak i przemysłowych. Ulepszenia w skali i kosztach pozwalają protokołowi zbudować zestaw już sprawdzonych, wstępnie przeszkolonych modeli podstawowych – znanych również jako Modele fundamentów–podobnie jak w wzorcowe zoo popularnych frameworków. Pozwala to naukowcom i inżynierom na otwarte badanie i trenowanie lepszych modeli na ogromnych otwartych zbiorach danych, w podobny sposób do Eleuther projekt. Modele te rozwiążą niektóre z podstawowych problemów ludzkości bez scentralizowanej własności czy cenzury. Kryptografia, w szczególności szyfrowanie funkcjonalne, pozwoli na wykorzystanie protokołu na żądanie do prywatnych danych. Ogromne modele podstawowe mogą być następnie dostrojone przez każdego, kto korzysta z zastrzeżonego zestawu danych, zachowując wartość/prywatność tych danych, ale nadal dzieląc się zbiorową wiedzą w zakresie projektowania modeli i badań.

Część 3: Gensyn napędza Web3-natywna centralizacja danych

Internet mógł narodzić się w latach sześćdziesiątych przez rząd Stanów Zjednoczonych, ale w latach dziewięćdziesiątych był anarchiczną siecią kreatywności, indywidualizmu i możliwości. Na długo przed tym, jak Google gromadził zapasy TPU, projekty takie jak SETI@home próbowały odkryć obce życie poprzez crowdsourcing zdecentralizowanej mocy obliczeniowej. Do roku 1960 SETI@home osiągnął wskaźnik przetwarzania na poziomie 17 teraflopów, który jest ponad dwukrotnie wyższy niż najlepszy ówczesny superkomputer IBM ASCI White. Ten okres czasu jest ogólnie nazywany „web1”, na chwilę przed hegemonią dużych platform, takich jak Google czy Amazon (web2), ale zdecentralizowane obliczenia słabły w skalowaniu, aby zaspokoić początkowe potrzeby Internetu, z powodu kilku problemów w tym czasie.

Jednak obecna centralizacja infrastruktury internetowej w ogromne platformy web2 stwarza własne problemy, takie jak koszty (marża brutto AWS jest szacowana 61%, reprezentujący kompresję marży dla większości badaczy podskalowych i firm opartych na danych. Jednocześnie scentralizowane instancje obliczeniowe poświęcają również kontrolę — AWS wyłączył infrastrukturę popularnej prawicowej platformy mediów społecznościowych Parler z jednodniowe wypowiedzenie po zamieszkach na Kapitolu 6 stycznia 2021 r. Wielu zgodziło się z tą decyzją, ale precedens jest niebezpieczny, gdy AWS gospodarze 42% z 10,000 XNUMX najpopularniejszych witryn w internecie. Jednak trenowanie modeli uczenia głębokiego na zdecentralizowanym sprzęcie jest trudne ze względu na problem z weryfikacją, który pomaga rozwiązać protokół Gensyn.

Budowanie rynku jako protokołu Web3 eliminuje scentralizowane koszty ogólne związane ze skalowaniem i zmniejsza bariery wejścia dla nowych uczestników dostaw, umożliwiając potencjalnie objęcie siecią każdego urządzenia komputerowego na świecie. Połączenie wszystkich urządzeń za pośrednictwem jednej zdecentralizowanej sieci zapewnia poziom skalowalności, który jest obecnie niemożliwy do osiągnięcia przez żadnego istniejącego dostawcę, zapewniając bezprecedensowy dostęp na żądanie do całości światowych zasobów obliczeniowych. W przypadku użytkowników końcowych całkowicie rozwiązuje to dylemat koszt vs skala i zapewnia przejrzyste i niedrogie obliczenia dotyczące uczenia maszynowego, które zapewniają potencjalnie nieskończoną skalowalność (do światowych fizycznych ograniczeń sprzętowych) oraz ceny jednostkowe, które mają być określane na podstawie dynamiki rynku. Pozwala to ominąć zwykłe fosy, którymi cieszą się duzi dostawcy, znacznie obniża ceny i ułatwia prawdziwie globalną konkurencję na poziomie zasobów, a nawet uwzględnia przypadek, w którym obecni dostawcy usług w chmurze również postrzegają protokół Gensyn jako ścieżkę dystrybucji, która uzupełnia bardziej scentralizowaną stronę własną. oferty pakietowe.

Wnioski:

Ponieważ sztuczna inteligencja jest prawie tak popularnym hasłem jak kryptowaluty i łańcuchy bloków, nasza teza dotycząca inwestowania w Gensyn, jak przedstawiono tutaj, musi przejść testy łatwego zrozumienia i poparta dowodami, a jednocześnie być równie ambitna w kwestii możliwości, jakie daje zdolność protokołu do wartość dodaną początkowo ukierunkowaną, ale dającą się uogólnić sieć zasobów natywną dla web3. Wierzymy, że dzięki protokołowi Gensyn widzimy początki hiperskalowalnej, efektywnej kosztowo sieci koordynacyjnej, która toruje drogę do jeszcze bardziej wartościowych informacji, które kładą podwaliny pod niezliczone aplikacje w przyszłości.

O CoinFund

CoinFund to zróżnicowana, wiodąca firma inwestycyjna skoncentrowana na blockchain, założona w 2015 roku, z siedzibą w Stanach Zjednoczonych. Wspólnie posiadamy bogate doświadczenie i doświadczenie w kryptowalutach, tradycyjnych inwestycjach kapitałowych, kredytach, private equity i inwestycjach venture. Strategie CoinFund obejmują zarówno rynki płynne, jak i rynki wysokiego ryzyka i korzystają z naszego multidyscyplinarnego podejścia, które synchronizuje techniczne zdolności kryptowalutowe z tradycyjnym doświadczeniem finansowym. Dzięki podejściu „najpierw założyciele”, CoinFund ściśle współpracuje ze swoimi spółkami portfelowymi, aby napędzać innowacje w przestrzeni aktywów cyfrowych.

Odpowiedzialność

Treści udostępniane na tej stronie służą wyłącznie celom informacyjnym i dyskusyjnym i nie należy na nich polegać w związku z konkretną decyzją inwestycyjną ani nie należy ich traktować jako oferty, rekomendacji lub zachęty do jakiejkolwiek inwestycji. Autor nie popiera żadnej firmy, projektu ani tokena omawianego w tym artykule. Wszystkie informacje są tutaj przedstawione „tak jak są”, bez jakiejkolwiek gwarancji, wyraźnej lub dorozumianej, a wszelkie stwierdzenia dotyczące przyszłości mogą okazać się błędne. CoinFund Management LLC i jej podmioty stowarzyszone mogą mieć długie lub krótkie pozycje w tokenach lub projektach omówionych w tym artykule.

![]()

Protokół Gensyn bez zaufania trenuje sieci neuronowe w hiperskali z niższym rzędem wielkości… został pierwotnie opublikowany w Blog CoinFund na Medium, gdzie ludzie kontynuują rozmowę, podkreślając tę historię i odpowiadając na nią.

- Coinsmart. Najlepsza w Europie giełda bitcoinów i kryptowalut.

- Platoblockchain. Web3 Inteligencja Metaverse. Wzmocniona wiedza. DARMOWY DOSTĘP.

- CryptoJastrząb. Radar Altcoin. Bezpłatna wersja próbna.

- Source: https://blog.coinfund.io/the-gensyn-protocol-trustlessly-trains-neural-networks-at-hyperscale-with-lower-order-of-magnitude-227fe968fabf?source=rss—-f5f136d48fc3—4

- "

- 000

- 10

- 2020

- 2021

- O nas

- dostęp

- nabyć

- w poprzek

- Przyjęcie

- Spółki stowarzyszone

- AI

- Algorytmy

- obcy

- Wszystkie kategorie

- Pozwalać

- Amazonka

- Inne

- aplikacje

- podejście

- Sztuka

- artykuł

- sztuczny

- sztuczna inteligencja

- kapitał

- audio

- dostępny

- AWS

- tło

- bariery

- stają się

- jest

- korzyści

- Berkeley

- BEST

- wielka technologia

- Miliard

- Blokować

- budować

- Budowanie

- biznes

- Zakup

- wezwanie

- wózek

- samochody

- Spowodować

- Cenzura

- scentralizowane

- wyzwanie

- Wykrywanie urządzeń szpiegujących

- Chiny

- chiński

- żeton

- Chmura

- usługi w chmurze

- CNBC

- społeczności

- społeczność

- Firmy

- sukcesy firma

- konkurencja

- całkowicie

- kompleks

- składnik

- obliczać

- computing

- połączenie

- zgoda

- rozważa

- zawartość

- umowy

- kontrola

- Rozmowa

- Koszty:

- tworzy

- Tworzenie

- kredyt

- kryptowaluta

- kryptografia

- Aktualny

- Klientów

- dane

- dekada

- Zdecentralizowane

- sieć zdecentralizowana

- Kreowanie

- Wnętrze

- oprogramowania

- urządzenie

- urządzenia

- cyfrowy

- Zasób cyfrowy

- 分配

- Podwójna

- podwojenie

- na dół

- dramatycznie

- napęd

- dynamika

- zachęcać

- szyfrowanie

- Inżynierowie

- sprawiedliwość

- niezbędny

- szacunkowa

- ethereum

- sieć ethereum

- wydatki

- doświadczenie

- Doświadczenia

- Twarz

- sprawiedliwy

- Moda

- finansować

- Firma

- i terminów, a

- dopasować

- Skupiać

- następujący

- przyszłościowe

- Fundacja

- Założony

- Funkcjonalność

- Finansowanie

- przyszłość

- gra

- gier

- Ogólne

- Dający

- Globalne

- Globalnie

- Rząd

- GPU

- Rozwój

- sprzęt komputerowy

- pomaga

- tutaj

- wyższy

- wysoko

- historyczny

- HTTPS

- olbrzymi

- człowiek

- Ludzie

- IBM

- ukryty

- ważny

- niemożliwy

- podnieść

- Zwiększać

- wzrastający

- przemysłowy

- przemysł

- Informacja

- Infrastruktura

- Innowacja

- spostrzeżenia

- Inteligencja

- odsetki

- Internet

- inwestowanie

- inwestycja

- problemy

- IT

- samo

- konserwacja

- Klawisz

- wiedza

- znany

- etykietowanie

- język

- duży

- prowadzący

- nauka

- Regulamin

- poziom

- Dźwignia

- wykorzystuje

- Ciecz

- LLC

- długo

- maszyna

- uczenie maszynowe

- Większość

- WYKONUJE

- Dokonywanie

- i konserwacjami

- produkcja

- rynek

- rynek

- rynki

- znaczenie

- Media

- średni

- Pamięć

- Microsoft

- milion

- Górnictwo

- Baseny górnicze

- ML

- model

- modele

- miesięcy

- jeszcze

- większość

- ruch

- mianowicie

- Natura

- sieć

- sieci

- liczny

- oferta

- koncepcja

- open source

- otwiera

- Okazja

- optymalizacja

- zamówienie

- Inne

- własność

- własność

- paradygmat

- Uczestnicy

- wzmacniacz

- płatności

- Ludzie

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- może

- fizyczny

- Platforma

- Platformy

- basen

- Baseny

- Popularny

- teczka

- power

- Cena

- prywatny

- Private Equity

- Problem

- problemy

- Procesor

- produkować

- Wytworzony

- projekt

- projektowanie

- dowód

- własność

- protokół

- protokoły

- zapewniać

- zapewnia

- że

- cele

- jakość

- szybko

- nośny

- rekord

- redukcja

- Wynajem

- wymagany

- wymagania

- Badania naukowe

- Badacze

- Zasób

- Zasoby

- Efekt

- run

- sprzedaż

- Skalowalność

- skalowalny

- Skala

- skalowaniem

- oszustwo

- Semiconductor

- Usługi

- zestaw

- Short

- braki

- znaczący

- podobny

- witryna internetowa

- Witryny

- Rozmiar

- Spowolnienie

- mądry

- Inteligentne kontrakty

- Obserwuj Nas

- Media społecznościowe

- napraszanie się

- Rozwiązania

- ROZWIĄZANIA

- wyrafinowany

- Typ przestrzeni

- stos

- stawka

- Stan

- state-of-the-art

- oświadczenia

- Zjednoczone

- strategie

- silny

- przełożony

- Dostawa

- wsparcie

- system

- systemy

- Tajwan

- tech

- Techniczny

- Technologia

- Tesla

- Testy

- świat

- Przez

- czas

- dzisiaj

- żeton

- Żetony

- Top

- śledzić

- tradycyjny

- tradycyjne finanse

- Trening

- pociągi

- przezroczysty

- nas

- zrozumieć

- Zjednoczony

- United States

- us

- rząd Stanów Zjednoczonych

- wartość

- sprzedawców

- przedsięwzięcie

- Weryfikacja

- Wideo

- Zobacz i wysłuchaj

- Wirtualny

- wizja

- sieć

- Web3

- czy

- bez

- Praca

- świat

- świat

- na calym swiecie

- rok

- lat

- Wydajność

- youtube

- zoom