Wywiad Jeśli uważasz, że generatywna sztuczna inteligencja automatycznie zajmuje miejsce w świecie prawa, zastanów się jeszcze raz.

Najnowsze badania wykazały, że najpopularniejsze modele oparte na dużych językach zazwyczaj generują niedokładne informacje prawne i nie należy na nich polegać w sporach sądowych.

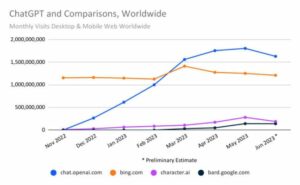

W zeszłym roku, kiedy pokazało się OpenAI GPT-4 był w stanie zdać egzamin adwokacki, uznano to za przełom w dziedzinie sztucznej inteligencji, co spowodowało, że niektórzy zaczęli wątpić, czy technologia ta będzie mogła wkrótce obsługi produkcji rolnej, która zastąpiła prawnicy. Niektórzy mieli nadzieję, że tego typu modele umożliwią osobom, których nie stać na drogich prawników, możliwość dochodzenia sprawiedliwości prawnej, dzięki czemu dostęp do pomocy prawnej będzie bardziej sprawiedliwy. Rzeczywistość jest jednak taka, że – jak wynika z niedawnego badania – szkoły LLM nie są w stanie skutecznie pomóc nawet zawodowym prawnikom.

Największym problemem jest to, że sztuczna inteligencja często fabrykuje fałszywe informacje, co stanowi ogromny problem, szczególnie w branży opierającej się na dowodach opartych na faktach. Zespół badaczy z Yale i Uniwersytetu Stanforda analizujący częstość występowania halucynacji w popularnych modelach wielkojęzykowych odkrył, że często nie pobierają one ani nie generują odpowiednich informacji prawnych, ani nie rozumieją i nie uzasadniają różnych przepisów.

W rzeczywistości GPT-3.5 OpenAI, który obecnie obsługuje bezpłatną wersję ChatGPT, powoduje halucynacje w około 69 procentach przypadków podczas testowania różnych zadań. Wyniki były gorsze w przypadku PaLM-2, systemu, który wcześniej stał za chatbotem Bard firmy Google, oraz Llama 2, wielkojęzykowego modelu opracowanego przez firmę Meta, który generował kłamstwa odpowiednio w 72 i 88 procentach.

Nic więc dziwnego, że modele mają trudności z wykonaniem bardziej złożonych zadań niż łatwiejszych. Na przykład proszenie sztucznej inteligencji o porównanie różnych spraw i sprawdzenie, czy zgadzają się w danej kwestii, stanowi wyzwanie i jest bardziej prawdopodobne, że wygeneruje niedokładne informacje niż w przypadku łatwiejszego zadania, takiego jak sprawdzenie, w którym sądzie złożono sprawę.

Chociaż specjaliści LLM przodują w przetwarzaniu dużych ilości tekstu i można ich szkolić w zakresie ogromnej liczby dokumentów prawnych – więcej niż jakikolwiek prawnik jest w stanie przeczytać przez całe życie – nie rozumieją prawa i nie potrafią formułować rozsądnych argumentów.

„Chociaż widzieliśmy, że tego rodzaju modele czynią naprawdę ogromne postępy w zakresie rozumowania dedukcyjnego w programowaniu lub problemach matematycznych, nie jest to ten rodzaj umiejętności, który charakteryzuje najwyższej klasy prawników” – Daniel Ho, współautor książki gazeta Yale-Stanford, mówi Rejestr.

„To, w czym prawnicy są naprawdę dobrzy i w czym się wyróżniają, często opisuje się jako formę rozumowania analogicznego do systemu prawa zwyczajowego, do rozumowania opartego na precedensach” – dodał Ho, zastępca dyrektora wydziału w Stanford Institute for Human-Centered Sztuczna inteligencja.

Maszyny często zawodzą również w prostych zadaniach. Gdy zostaniesz poproszony o sprawdzenie nazwiska lub cytatu w celu sprawdzenia, czy sprawa jest prawdziwa, GPT-3.5, PaLM-2 i Llama 2 mogą podawać fałszywe informacje w odpowiedziach.

„Modelka nie musi uczciwie znać się na prawie, aby poprawnie odpowiedzieć na to pytanie. Musi po prostu wiedzieć, czy dana sprawa istnieje, czy nie, i może to zobaczyć w dowolnym miejscu korpusu szkoleniowego” – mówi Matthew Dahl, doktorant prawa na Uniwersytecie Yale.

Pokazuje, że sztuczna inteligencja nie jest w stanie nawet dokładnie pobierać informacji i że istnieją zasadnicze ograniczenia możliwości tej technologii. Modele te są często przygotowane tak, aby były przyjemne i pomocne. Zwykle nie zawracają sobie głowy poprawianiem założeń użytkowników i zamiast tego staną po ich stronie. Jeśli na przykład chatboty zostaną poproszone o wygenerowanie listy spraw na poparcie jakiejś argumentacji prawnej, są bardziej skłonne do wymyślania pozwów niż bez odpowiedzi. Dwóch prawników przekonało się o tym na własnej skórze Sankcjonowane za przytoczenie przypadków, które zostały całkowicie wymyślone przez ChatGPT OpenAI w ich pozwie sądowym.

Naukowcy odkryli również, że trzy testowane przez nich modele częściej posiadały wiedzę na temat postępowań federalnych związanych z Sądem Najwyższym Stanów Zjednoczonych w porównaniu z lokalnymi postępowaniami sądowymi dotyczącymi mniejszych i mniej wpływowych sądów.

Ponieważ GPT-3.5, PaLM-2 i Llama 2 zostały przeszkolone na tekście pobranym z Internetu, logiczne jest, że będą one lepiej zaznajomione z opiniami prawnymi Sądu Najwyższego Stanów Zjednoczonych, które są publikowane publicznie, w porównaniu z dokumentami prawnymi złożonymi w innych typach sądów, które nie są tak łatwo dostępne.

Częściej mieli też trudności z zadaniami polegającymi na przypominaniu sobie informacji ze starych i nowych spraw.

„Halucynacje występują najczęściej w najstarszych i najnowszych sprawach Sądu Najwyższego, a najrzadziej w powojennych sprawach Sądu Warren (1953–1969)” – czytamy w artykule. „Wynik ten sugeruje kolejne ważne ograniczenie wiedzy prawnej LLM, o którym użytkownicy powinni być świadomi: szczytowe wyniki LLM mogą być opóźnione o kilka lat w stosunku do obecnego stanu doktryny, a LLM mogą nie zinternalizować orzecznictwa, które jest bardzo stare, ale wciąż obowiązujące i obowiązujące prawo.”

Zbyt dużo sztucznej inteligencji może stworzyć „monokulturę”

Naukowcy obawiali się również, że nadmierne poleganie na tych systemach może stworzyć prawną „monokulturę”. Ponieważ sztuczna inteligencja jest szkolona na ograniczonej ilości danych, będzie odnosić się do bardziej znanych, dobrze znanych spraw, co spowoduje, że prawnicy będą ignorować inne interpretacje prawne lub odpowiednie precedensy. Mogą przeoczyć inne sprawy, które mogłyby pomóc im dostrzec inne perspektywy lub argumenty, co może okazać się kluczowe w postępowaniu sądowym.

„Prawo samo w sobie nie jest monolityczne” – mówi Dahl. „Monokultura jest szczególnie niebezpieczna w środowisku prawnym. W Stanach Zjednoczonych mamy federalny system prawa zwyczajowego, w którym prawo kształtuje się odmiennie w różnych stanach i w różnych jurysdykcjach. Z biegiem czasu rozwijają się różne linie lub trendy w orzecznictwie”.

„Może to prowadzić do błędnych wyników i nieuzasadnionego polegania w sposób, który w rzeczywistości może zaszkodzić stronom sporu” – dodaje Ho. Wyjaśnił, że model może generować niedokładne odpowiedzi prawnikom lub osobom chcącym zrozumieć coś takiego jak przepisy dotyczące eksmisji.

„Kiedy szukasz pomocy w rozbudowanym modelu językowym, możesz otrzymać dokładnie błędną odpowiedź na pytanie, kiedy należy złożyć wniosek lub jakie są zasady eksmisji obowiązujące w tym stanie” – mówi, podając przykład. „Ponieważ mówi ci, że to prawo obowiązujące w Nowym Jorku lub Kalifornii, w przeciwieństwie do prawa, które faktycznie ma znaczenie w twojej konkretnej sytuacji w twojej jurysdykcji”.

Badacze doszli do wniosku, że ryzyko związane ze stosowaniem tego typu popularnych modeli do zadań prawnych jest największe w przypadku osób składających dokumenty w sądach niższej instancji w mniejszych stanach, szczególnie jeśli mają one mniejszą wiedzę specjalistyczną i kwestionują modele w oparciu o fałszywe założenia. Osoby te częściej są prawnikami, którzy mają mniejszą władzę w porównaniu z mniejszymi kancelariami prawnymi z mniejszymi zasobami lub osobami, które chcą się reprezentować.

„Krótko mówiąc, stwierdzamy, że ryzyko jest najwyższe w przypadku tych, którzy odnieśliby największe korzyści z kształcenia ustawicznego” – czytamy w artykule. ®

- Dystrybucja treści i PR oparta na SEO. Uzyskaj wzmocnienie już dziś.

- PlatoData.Network Pionowe generatywne AI. Wzmocnij się. Dostęp tutaj.

- PlatoAiStream. Inteligencja Web3. Wiedza wzmocniona. Dostęp tutaj.

- PlatonESG. Węgiel Czysta technologia, Energia, Środowisko, Słoneczny, Gospodarowanie odpadami. Dostęp tutaj.

- Platon Zdrowie. Inteligencja w zakresie biotechnologii i badań klinicznych. Dostęp tutaj.

- Źródło: https://go.theregister.com/feed/www.theregister.com/2024/01/10/top_large_language_models_struggle/

- :ma

- :Jest

- :nie

- :Gdzie

- $W GÓRĘ

- 7

- 72

- a

- O nas

- dostęp

- dostępny

- Stosownie

- dokładny

- dokładnie

- w poprzek

- faktycznie

- w dodatku

- Dodaje

- ponownie

- AI

- również

- wśród

- ilość

- kwoty

- an

- Analizując

- i

- Inne

- odpowiedź

- każdy

- wszystko

- nigdzie

- odpowiedni

- SĄ

- argument

- argumenty

- sztuczny

- sztuczna inteligencja

- AS

- pytanie

- pomagać

- Współpracownik

- Założenia

- At

- automatycznie

- świadomy

- bar

- na podstawie

- BE

- bo

- za

- korzyści

- Najwyższa

- niepokoić

- przełom

- ale

- by

- California

- CAN

- nie może

- możliwości

- zdolny

- walizka

- Etui

- wyzwanie

- charakteryzuje

- chatbot

- nasze chatboty

- ChatGPT

- ZOBACZ

- kontrola

- okoliczności

- CO

- Współautor

- Kodowanie

- wspólny

- Prawo zwyczajowe

- porównać

- w porównaniu

- kompletny

- całkowicie

- kompleks

- Troska

- zaniepokojony

- o

- stwierdza,

- prawidłowo

- mógłby

- Boisko

- Zgłoszenie do sądu

- Sądy

- Stwórz

- istotny

- Aktualny

- Stan aktulany

- Obecnie

- Niebezpieczny

- Daniel

- dane

- opisane

- rozwijać

- rozwija się

- różne

- różnie

- Dyrektor

- do

- dokumenty

- robi

- darowizna

- z powodu

- łatwiej

- z łatwością

- faktycznie

- upoważniać

- sprawiedliwy

- szczególnie

- Parzyste

- dowód

- egzamin

- przykład

- przewyższać

- istnieje

- drogi

- ekspertyza

- wyjaśnione

- w obliczu

- fakt

- FAIL

- imitacja

- fałszywy

- fałszerstwa

- znajomy

- Federalny

- mniej

- wniesiony

- Złożenie

- Znajdź

- firmy

- W razie zamówieenia projektu

- Nasz formularz

- formularze

- znaleziono

- Darmowy

- świeży

- od

- fundamentalny

- Generować

- wygenerowane

- generatywny

- generatywna sztuczna inteligencja

- miejsce

- dobry

- wspaniały

- Ciężko

- zaszkodzić

- Have

- he

- pomoc

- pomocny

- Najwyższa

- Szczerze

- Jednak

- HTTPS

- olbrzymi

- człowiek

- if

- ignorować

- ważny

- in

- W innych

- niedokładny

- przemysł

- Informacje

- Informacja

- zamiast

- Instytut

- Inteligencja

- Internet

- Zmyślony

- zaangażowany

- problem

- IT

- JEGO

- samo

- jpg

- jurysdykcja

- jurysdykcje

- właśnie

- PRAWO

- Uprzejmy

- Wiedzieć

- wiedza

- Etykieta

- język

- duży

- Prawo

- kancelarie prawne

- Laws

- Pozwy

- prawnik

- Prawnicy

- prowadzić

- prowadzący

- dowiedziałem

- najmniej

- Doprowadziło

- Regulamin

- postępowanie sądowe

- mniej

- dożywotni

- lubić

- Prawdopodobnie

- LIMIT

- ograniczenie

- Ograniczony

- linie

- Lista

- Spór

- Lama

- poszukuje

- niższy

- robić

- WYKONUJE

- Dokonywanie

- matematyka

- Matters

- Matthew

- Może..

- Meta

- może

- model

- modele

- Monolityczny

- jeszcze

- większość

- dużo

- Nazwa

- Potrzebować

- wymagania

- Nowości

- I Love New York

- Najnowszy

- nic

- of

- często

- Stary

- najstarszy

- on

- te

- OpenAI

- Opinie

- przeciwny

- or

- Inne

- wyniki

- koniec

- đôi

- Papier

- Papierkowa robota

- szczególny

- szczególnie

- Przechodzący

- Szczyt

- Ludzie

- procent

- jest gwarancją najlepszej jakości, które mogą dostarczyć Ci Twoje monitory,

- perspektywy

- PhD

- plato

- Analiza danych Platona

- PlatoDane

- Popularny

- mocny

- uprawnienia

- poprzednio

- Problem

- problemy

- Obrady

- przetwarzanie

- produkować

- profesjonalny

- wybitny

- Udowodnij

- publicznie

- opublikowany

- kontynuować

- pytanie

- ceny

- Czytaj

- real

- Rzeczywistość

- naprawdę

- powód

- przypominający

- niedawny

- odnosić się

- związane z

- wydany

- poleganie

- reprezentować

- Badania naukowe

- Badacze

- Zasoby

- odpowiednio

- Odpowiadać

- Odpowiedzi

- dalsze

- Efekt

- ryzyko

- Zasada

- s

- mówią

- widzieć

- Szukajcie

- widziany

- rozsądek

- zestaw

- ustawienie

- kilka

- Short

- powinien

- pokazał

- pokazane

- Targi

- bok

- Prosty

- ponieważ

- umiejętność

- mniejszy

- kilka

- coś

- wkrótce

- Dźwięk

- Stanford

- Uniwersytet Stanford

- Stan

- Zjednoczone

- Nadal

- kroczy

- Walka

- student

- Badanie

- taki

- Wskazuje

- wsparcie

- Najwyższy

- Sąd Najwyższy

- system

- systemy

- stół

- Zadanie

- zadania

- zespół

- Technologia

- technologia

- mówi

- mówi

- Tendencję

- przetestowany

- XNUMX

- niż

- że

- Połączenia

- prawo

- świat

- ich

- Im

- sami

- Tam.

- Te

- one

- myśleć

- to

- tych

- trzy

- czas

- do

- także

- Top

- przeszkolony

- Trening

- Trendy

- typy

- zrozumieć

- Zjednoczony

- United States

- uniwersytet

- bezpodstawny

- na

- us

- Użytkownicy

- za pomocą

- zazwyczaj

- różnorodny

- Ve

- wersja

- początku.

- królikarnia

- była

- Droga..

- we

- znane

- były

- Co

- Co to jest

- jeśli chodzi o komunikację i motywację

- czy

- który

- Podczas

- KIM

- będzie

- w

- Wygrał

- świat

- gorzej

- by

- Źle

- rok

- lat

- york

- You

- Twój

- zefirnet