- 20 stycznia 2014 r.

- Wasilis Wryniotis

- . 5 komentarzy

W klasyfikacji tekstu selekcja cech jest procesem wybierania określonego podzbioru terminów zbioru uczącego i wykorzystywania ich tylko w algorytmie klasyfikacyjnym. Proces selekcji cech odbywa się przed szkoleniem klasyfikatora.

Aktualizacja: Platforma uczenia maszynowego Datumbox jest teraz open-source i bezpłatna pobieranie. Sprawdź pakiet com.datumbox.framework.machinelearning.featureselection, aby zobaczyć implementację metod Chi-kwadrat i wyboru funkcji informacji wzajemnej w Javie.

Głównymi zaletami korzystania z algorytmów wyboru cech jest fakt, że zmniejsza to rozmiar naszych danych, przyspiesza szkolenie i może poprawić dokładność poprzez usunięcie hałaśliwych funkcji. W konsekwencji wybór cech może pomóc nam uniknąć nadmiernego dopasowania.

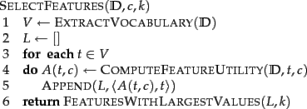

Poniżej przedstawiono podstawowy algorytm selekcji do wyboru k najlepszych cech (Manning i in., 2008):

W następnych sekcjach przedstawiamy dwa różne algorytmy wyboru cech: wzajemne informacje i chi-kwadrat.

Wzajemne informacje

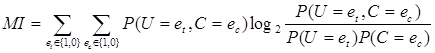

Jedną z najpowszechniejszych metod wyboru cech jest wzajemna informacja terminu t w klasie c (Manning i in., 2008). Mierzy, w jakim stopniu obecność lub brak określonego terminu przyczynia się do podjęcia prawidłowej decyzji klasyfikacyjnej na c. Wzajemne informacje można obliczyć za pomocą następującego wzoru:

[1]

[1]

W naszych obliczeniach, ponieważ używamy oszacowań prawdopodobieństwa maksymalnego prawdopodobieństwa, możemy użyć następującego równania:

![]() [2]

[2]

Gdzie N to całkowita liczba dokumentów, Ntcto liczby dokumentów, które mają wartości et (wystąpienie terminu t w dokumencie; przyjmuje wartość 1 lub 0) oraz ec(wystąpienie dokumentu w klasie c; przyjmuje wartość 1 lub 0) wskazywaną przez dwa indeksy dolne, ![]() i

i ![]() . Na koniec należy zauważyć, że wszystkie wspomniane zmienne przyjmują wartości nieujemne.

. Na koniec należy zauważyć, że wszystkie wspomniane zmienne przyjmują wartości nieujemne.

Chi kwadrat

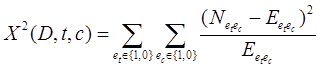

Inną popularną metodą wyboru funkcji jest Chi kwadrat. X2 test jest używany w statystykach między innymi do testowania niezależności dwóch zdarzeń. Mówiąc dokładniej, przy wyborze cech używamy go do testowania, czy wystąpienie określonego terminu i wystąpienie określonej klasy są niezależne. W ten sposób szacujemy następującą ilość dla każdego terminu i klasyfikujemy je według ich wyniku:

[3]

[3]

Wysokie wyniki na x2 wskazują, że hipoteza zerowa (H.0) niezależności należy odrzucić, a tym samym, że występowanie terminu i klasy jest zależne. Jeśli są zależne, wybieramy cechę do klasyfikacji tekstu.

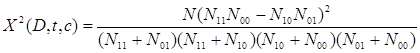

Powyższy wzór można przepisać w następujący sposób:

[4]

[4]

Jeśli używamy metody Chi-kwadrat, powinniśmy wybrać tylko predefiniowaną liczbę cech, które mają topór2 wynik testu większy niż 10.83, co wskazuje na istotność statystyczną na poziomie 0.001.

Na koniec powinniśmy zauważyć, że ze statystycznego punktu widzenia wybór funkcji Chi-kwadrat jest niedokładny ze względu na jeden stopień swobody i Poprawka Yatesa powinno być użyte zamiast tego (co utrudni osiągnięcie istotności statystycznej). Należy więc spodziewać się, że spośród ogółu wybranych cech niewielka ich część jest niezależna od klasy). Należy więc spodziewać się, że spośród ogółu wybranych cech niewielka ich część jest niezależna od klasy. Niemniej jednak jak Manning i in. (2008) pokazało, że te hałaśliwe cechy nie wpływają poważnie na ogólną dokładność naszego klasyfikatora.

Usuwanie hałaśliwych / rzadkich funkcji

Inną techniką, która może pomóc nam uniknąć nadmiernego dopasowania, zmniejszyć zużycie pamięci i poprawić szybkość, jest usunięcie wszystkich rzadkich terminów ze słownika. Na przykład można wyeliminować wszystkie terminy, które wystąpiły tylko raz we wszystkich kategoriach. Usunięcie tych terminów może znacznie zmniejszyć zużycie pamięci i przyspieszyć analizę. Wreszcie nie powinniśmy, aby ta technika mogła być używana w połączeniu z powyższymi algorytmami wyboru cech.

Podobał Ci się artykuł? Poświęć chwilę, aby udostępnić go na Twitterze. 🙂

- AI

- ai sztuka

- generator sztuki ai

- masz robota

- sztuczna inteligencja

- certyfikacja sztucznej inteligencji

- robot sztucznej inteligencji

- roboty sztucznej inteligencji

- oprogramowanie sztucznej inteligencji

- blockchain

- konferencja blockchain ai

- pomysłowość

- sztuczna inteligencja konwersacyjna

- konferencja kryptograficzna

- Dall's

- Skrzynka odniesienia

- głęboka nauka

- google to

- uczenie maszynowe

- Uczenie maszynowe i statystyki

- plato

- Platon Ai

- Analiza danych Platona

- Gra Platona

- PlatoDane

- platogaming

- skala ai

- składnia

- zefirnet