O flagelo da criação maliciosa de deepfakes espalhou-se muito além do domínio das celebridades e figuras públicas, e um novo relatório sobre imagens íntimas não consensuais (NCII) revela que a prática só cresce à medida que os geradores de imagens evoluem e proliferam.

“Despir IA” está em ascensão, um Denunciar pela empresa de análise de mídia social Graphika disse na sexta-feira, descrevendo a prática como o uso IA generativa ferramentas ajustadas para remover roupas de imagens enviadas pelos usuários.

A comunidade de jogos e streaming do Twitch enfrentou o problema no início deste ano, quando o proeminente locutor Brandon 'Atrioc' Ewing revelou acidentalmente que estava vendo pornografia deepfake gerada por IA de streamers femininas que ele chamava de amigas, de acordo com um Denunciar by Kotaku.

Ewing voltou à plataforma em março, arrependido e relatando semanas de trabalho que empreendeu para mitigar os danos que causou. Mas o incidente abriu as comportas para toda uma comunidade online.

O relatório da Graphika mostra que o incidente foi apenas uma gota no oceano.

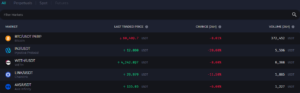

“Usando dados fornecidos pela Meltwater, medimos o número de comentários e postagens no Reddit e X contendo links de referência para 34 sites e 52 canais do Telegram que fornecem serviços NCII sintéticos”, escreveu o analista de inteligência da Graphika, Santiago Lakatos. “Estes totalizaram 1,280 em 2022, em comparação com mais de 32,100 até agora neste ano, representando um aumento de 2,408% no volume ano a ano.”

A Graphika, com sede em Nova York, diz que a explosão do NCII mostra que as ferramentas passaram de fóruns de discussão de nicho para uma indústria caseira.

“Esses modelos permitem que um número maior de fornecedores criem NCII fotorrealistas em escala de maneira fácil e barata”, disse Graphika. “Sem esses provedores, seus clientes precisariam hospedar, manter e executar seus próprios modelos personalizados de difusão de imagens – um processo demorado e às vezes caro.”

Graphika alerta que o aumento na popularidade das ferramentas de IA para despir pode levar não apenas a falsificações pornográfico material, mas também assédio direcionado, sextorsão e geração de material de abuso sexual infantil (CSAM).

De acordo com o Gráfico Denunciar, os desenvolvedores de ferramentas de despir IA anunciam nas redes sociais para levar usuários em potencial aos seus sites, bate-papo privado do Telegram ou servidores Discord onde as ferramentas podem ser encontradas.

“Alguns prestadores são abertos nas suas actividades, afirmando que prestam serviços de 'despir' e publicando fotos de pessoas que afirmam terem sido 'despidas' como prova”, escreveu Graphika. “Outros são menos explícitos e se apresentam como serviços de arte de IA ou galerias de fotos Web3, ao mesmo tempo que incluem termos-chave associados ao NCII sintético em seus perfis e postagens.”

Embora as IAs de despir normalmente se concentrem em imagens, a IA também tem sido usada para criar vídeo deepfakes usando a imagem de celebridades, incluindo personalidades do YouTube Mr. Beast e icônico ator de Hollywood Tom Hanks.

Alguns atores gostam Scarlett Johansson e ator indiano Anil Kapoor estão recorrendo ao sistema legal para combater a ameaça contínua de deepfakes de IA. Ainda assim, embora os artistas tradicionais possam receber mais atenção da mídia, artistas adultos dizem que suas vozes raramente são ouvidas.

“É realmente difícil”, disse Tanya Tate, lendária artista adulta e chefe da Star Factory PR, disse Descifrar mais cedo. “Se alguém está no mainstream, tenho certeza que é muito mais fácil.”

Mesmo sem a ascensão da IA e da tecnologia deepfake, Tate explicou que a mídia social já está cheia de contas falsas usando sua probabilidade e conteúdo. O que não ajuda é o estigma contínuo que as profissionais do sexo enfrentam, forçando-as e aos seus fãs a permanecerem nas sombras.

Em outubro, a empresa de vigilância da Internet com sede no Reino Unido, Internet Watch Foundation (IWF), num relatório separado, observou que mais de 20,254 imagens de abuso infantil foram encontradas num único fórum da darkweb em apenas um mês. A IWF alertou que a pornografia infantil gerada por IA poderia “oprimir" a Internet.

Graças aos avanços nas imagens generativas de IA, a IWF alerta que deepfake a pornografia avançou a tal ponto que distinguir entre imagens geradas por IA e imagens autênticas se tornou cada vez mais complexo, deixando as autoridades policiais perseguindo fantasmas online em vez de vítimas reais de abuso.

“Portanto, há aquela coisa contínua de que você não pode confiar se as coisas são reais ou não”, disse Dan Sexton, CTO da Internet Watch Foundation. Descriptografart. “As coisas que nos dirão se as coisas são reais ou não não são 100% e, portanto, você também não pode confiar nelas.”

Quanto a Ewing, Kotaku relatou que o streamer voltou dizendo que estava trabalhando com repórteres, tecnólogos, pesquisadores e mulheres afetadas pelo incidente desde sua transgressão em janeiro. Ewing também disse que enviou fundos para o escritório de advocacia de Ryan Morrison com sede em Los Angeles, Morrison Cooper, para fornecer serviços jurídicos a qualquer mulher no Twitch que precisasse de sua ajuda para emitir avisos de remoção para sites que publicam imagens delas.

Ewing acrescentou que recebeu pesquisas sobre a profundidade do problema do deepfake da misteriosa pesquisadora do deepfake, Genevieve Oh.

“Tentei encontrar os 'pontos positivos' na luta contra esse tipo de conteúdo”, disse Ewing.

Editado por Ryan Ozawa.

Fique por dentro das notícias sobre criptomoedas, receba atualizações diárias em sua caixa de entrada.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://decrypt.co/209181/ai-undressing-deepfake-nude-services-skyrocket-in-popularity