Dados dos usuários: alimento vital dos LLMs

Sim! TR @bryce adorei esta citação “Se você não está pagando por isso, você não é o cliente; você é o produto que está sendo vendido. http://bit.ly/93JYCJ

- Tim O'Reilly (@timoreilly) 2 de Setembro de 2010

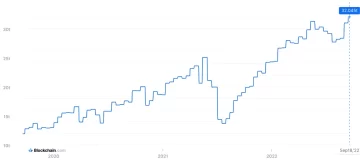

Fique por dentro das notícias sobre criptomoedas, receba atualizações diárias em sua caixa de entrada.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://decrypt.co/211846/anthropic-says-it-wont-use-your-private-data-to-train-its-ai

- :tem

- :é

- :não

- 7

- 8

- a

- habilidade

- absoluto

- Segundo

- preciso

- adaptação

- endereçando

- Adiciona

- avançado

- atrás

- concorda

- AI

- Serviços de IA

- Sistemas de IA

- visa

- Alexa

- Alinha

- Todos os Produtos

- permite

- tb

- sempre

- Amazon

- an

- e

- Antrópico

- antecipar

- qualquer

- relevante

- SOMOS

- AS

- assumir

- At

- disponível

- evitando

- consciente

- baseado

- BE

- Porque

- ser

- Acredita

- benéfico

- Melhor

- entre

- by

- CAN

- reivindicações

- clientes

- comercial

- compromisso

- compromete-se

- Empresas

- Empresa

- competitivo

- conceito

- Preocupações

- constantemente

- conteúdo

- contexto

- continuamente

- ao controle

- Conveniente

- conversas

- direitos autorais

- poderia

- crucial

- cripto

- Crypto News

- Atual

- cliente

- Clientes

- diariamente

- Escuro

- dados,

- privacidade de dados

- debate

- décadas

- Descifrar

- profundo

- deep learning

- Padrão

- Defendendo

- entregando

- depende

- nega

- disputas

- Diversidade

- do

- documento

- parece

- dólares

- não

- durante

- Ganhando

- borda

- eficácia

- ou

- COMPROMETIMENTO

- aprimorando

- garante

- essencial

- considerações éticas

- ética

- exemplo

- exchange

- vasta experiência

- extenso

- extensão

- externo

- enfrentando

- Escolha

- Antigo

- Fundado

- Gratuito

- da

- ganhando

- gerar

- gerado

- gera

- generativo

- IA generativa

- ter

- obtendo

- gigantes

- OFERTE

- Go

- conceder

- aperto

- Cresce

- fortemente

- honesto

- honra

- Contudo

- http

- HTTPS

- humano

- ideais

- if

- melhorar

- in

- Individual

- INFORMAÇÕES

- intelectual

- propriedade intelectual

- intenções

- interações

- interno

- IP

- IT

- ESTÁ

- se

- Chave

- língua

- grande

- mais recente

- Escritórios de

- conduzir

- APRENDER

- aprendizagem

- Legal

- Alavancagem

- como

- lhama

- LLM

- gosta,

- fazer

- Fazendo

- Posso..

- Mídia

- Meta

- milhões

- modelo

- modelos

- mais

- a maioria

- redes

- neural

- redes neurais

- Novo

- notícias

- obtendo

- of

- on

- OpenAI

- or

- ostensivamente

- de outra forma

- A Nossa

- Fora

- outputs

- Acima de

- próprio

- possui

- pago

- partes

- festa

- padrões

- Pagar

- pagar

- pessoal

- Personalização

- Personalizado

- Fotos

- platão

- Inteligência de Dados Platão

- PlatãoData

- Privacidade

- potencial

- poder

- poderoso

- práticas

- predizer

- Previsões

- preferências

- prevalecente

- política de privacidade

- privado

- Produzido

- Produto

- solicita

- propriedade

- fornecer

- fornece

- público

- confiança publica

- publicamente

- citar

- corrida

- RE

- mundo real

- recebe

- refinar

- Considerar

- relativo

- liberar

- relevante

- Informou

- pedidos

- pesquisadores

- responsável

- Revelado

- direitos

- rivais

- rt

- Ryan

- s

- dizer

- diz

- cena

- serviço

- Serviços

- conjunto

- Partilhar

- rede de apoio social

- Ceticismo

- So

- Redes Sociais

- meios de comunicação social

- vendido

- SOLETRAR

- porta-voz

- inicialização

- Declaração

- ficar

- Passo

- sistemas

- Tandem

- tecnologia

- gigantes da tecnologia

- técnicas

- condições

- texto

- que

- A

- deles

- Eles

- Este

- deles

- isto

- Tim

- para

- hoje

- topo

- Trem

- treinado

- Training

- Transparência

- Tendências

- Confiança

- para

- compreender

- compreensão

- os próximos

- Atualizada

- Atualizações

- atualizado

- carregado

- usar

- usava

- Utilizador

- usuários

- utilização

- Valioso

- vário

- versão

- VÍDEOS

- vital

- voz

- volume

- foi

- we

- foram

- quando

- se

- qual

- porque

- precisarão

- de

- Word

- seria

- Vocês

- investimentos

- zefirnet