A visão computacional (CV) é uma das aplicações mais comuns de aprendizado de máquina (ML) e aprendizado profundo. Os casos de uso variam de carros autônomos, moderação de conteúdo em plataformas de mídia social, detecção de câncer e detecção automatizada de defeitos. Reconhecimento da Amazônia é um serviço totalmente gerenciado que pode executar tarefas de CV como detecção de objetos, detecção de segmentos de vídeo, moderação de conteúdo e muito mais para extrair insights de dados sem a necessidade de qualquer experiência anterior em ML. Em alguns casos, pode ser necessária uma solução mais personalizada junto com o serviço para resolver um problema muito específico.

Neste post, abordamos áreas onde o CV pode ser aplicado em casos de uso onde a pose dos objetos, sua posição e orientação são importantes. Um desses casos de uso seriam aplicativos móveis voltados para o cliente, onde é necessário o upload de uma imagem. Pode ser por motivos de conformidade ou para fornecer uma experiência de usuário consistente e melhorar o envolvimento. Por exemplo, em plataformas de compras online, o ângulo em que os produtos são mostrados nas imagens afeta a taxa de compra desse produto. Um desses casos é detectar a posição de um carro. Demonstramos como você pode combinar soluções conhecidas de ML com pós-processamento para resolver esse problema na Nuvem AWS.

Usamos modelos de aprendizado profundo para resolver esse problema. O treinamento de algoritmos de ML para estimativa de pose requer muito conhecimento e dados de treinamento personalizados. Ambos os requisitos são difíceis e caros de obter. Portanto, apresentamos duas opções: uma que não requer nenhum conhecimento em ML e usa Amazon Rekognition, e outra que usa Amazon Sage Maker para treinar e implantar um modelo de ML personalizado. Na primeira opção, usamos o Amazon Rekognition para detectar as rodas do carro. Em seguida, inferimos a orientação do carro a partir das posições das rodas usando um sistema baseado em regras. Na segunda opção, detectamos as rodas e outras peças do carro usando o Detetron modelo. Estes são novamente usados para inferir a posição do carro com código baseado em regras. A segunda opção requer experiência em ML, mas também é mais personalizável. Ele pode ser usado para posterior pós-processamento da imagem, por exemplo, para recortar o carro inteiro. Ambas as opções podem ser treinadas em conjuntos de dados disponíveis publicamente. Por fim, mostramos como você pode integrar esta solução de detecção de pose de carro em seu aplicativo Web existente usando serviços como Gateway de API da Amazon e Amplificar AWS.

Visão geral da solução

O diagrama a seguir ilustra a arquitetura da solução.

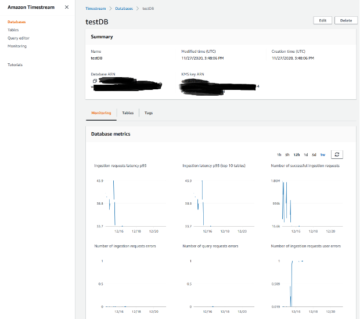

A solução consiste em um aplicativo web simulado no Amplify onde um usuário pode fazer upload de uma imagem e invocar o modelo Amazon Rekognition ou o modelo Detectron personalizado para detectar a posição do carro. Para cada opção, hospedamos um AWS Lambda funciona por trás de um API Gateway que é exposto ao nosso aplicativo simulado. Configuramos nossa função Lambda para ser executada com o modelo Detectron treinado no SageMaker ou no Amazon Rekognition.

Pré-requisitos

Para este passo a passo, você deve ter os seguintes pré-requisitos:

Crie um aplicativo sem servidor usando o Amazon Rekognition

Nossa primeira opção demonstra como você pode detectar orientações de carros em imagens usando o Amazon Rekognition. A ideia é usar o Amazon Rekognition para detectar a localização do carro e de suas rodas e, em seguida, fazer o pós-processamento para derivar a orientação do carro a partir dessas informações. Toda a solução é implantada usando Lambda, conforme mostrado na Repositório Github. Esta pasta contém dois arquivos principais: um Dockerfile que define a imagem Docker que será executada em nossa função Lambda, e o app.py arquivo, que será o principal ponto de entrada da função Lambda:

A função Lambda espera um evento que contenha um cabeçalho e um corpo, onde o corpo deve ser a imagem necessária para ser rotulada como objeto decodificado em base64. Dada a imagem, o Amazon Rekognition detect_labels função é invocada a partir da função Lambda usando boto3. A função retorna um ou mais rótulos para cada objeto na imagem e detalhes da caixa delimitadora para todos os rótulos de objetos detectados como parte da resposta, junto com outras informações como a confiança do rótulo atribuído, os rótulos ancestrais do rótulo detectado, possíveis aliases para o rótulo e as categorias às quais o rótulo detectado pertence. Com base nos rótulos retornados pelo Amazon Rekognition, executamos a função label_image, que calcula o ângulo do carro a partir das rodas detectadas da seguinte forma:

Observe que o aplicativo exige que apenas um carro esteja presente na imagem e retorna um erro se não for o caso. Contudo, o pós-processamento pode ser adaptado para fornecer descrições de orientação mais granulares, cobrir vários carros ou calcular a orientação de objetos mais complexos.

Melhorar a detecção de rodas

Para melhorar ainda mais a precisão da detecção da roda, você pode usar Rótulos personalizados do Amazon Rekognition. Semelhante ao ajuste fino usando o SageMaker para treinar e implantar um modelo de ML personalizado, você pode trazer seus próprios dados rotulados para que o Amazon Rekognition possa produzir um modelo de análise de imagem personalizado para você em apenas algumas horas. Com os rótulos personalizados do Rekognition, você só precisa de um pequeno conjunto de imagens de treinamento específicas para seu caso de uso, neste caso, imagens de carros com ângulos específicos, porque ele usa os recursos existentes no Amazon Rekognition de ser treinado em dezenas de milhões de imagens em todo o mundo. muitas categorias. Os rótulos personalizados do Rekognition podem ser integrados com apenas alguns cliques e pequenas adaptações à função Lambda que usamos para a solução padrão do Amazon Rekognition.

Treine um modelo usando um trabalho de treinamento do SageMaker

Em nossa segunda opção, treinamos um modelo personalizado de aprendizado profundo no SageMaker. Nós usamos o Estrutura Detectron2 para a segmentação de peças automotivas. Esses segmentos são então usados para inferir a posição do carro.

A estrutura Detectron2 é uma biblioteca que fornece algoritmos de detecção e segmentação de última geração. Detectron fornece uma variedade de modelos Mask R-CNN que foram treinados no famoso conjunto de dados COCO (Common Objects in Context). Para construir nosso modelo de detecção de objetos de carro, usamos o aprendizado de transferência para ajustar um modelo Mask R-CNN pré-treinado no segmentação de peças automotivas conjunto de dados. Este conjunto de dados nos permite treinar um modelo que pode detectar rodas, mas também outras peças de automóveis. Esta informação adicional pode ser usada posteriormente nos cálculos do ângulo do carro em relação à imagem.

O conjunto de dados contém dados anotados de peças de automóveis a serem usadas para detecção de objetos e tarefas de segmentação semântica: aproximadamente 500 imagens de sedãs, picapes e veículos utilitários esportivos (SUVs), obtidas em múltiplas visualizações (frontal, traseira e lateral). Cada imagem é anotada por 18 máscaras de instância e caixas delimitadoras que representam as diferentes partes de um carro, como rodas, espelhos, luzes e vidros dianteiro e traseiro. Modificamos as anotações básicas das rodas de forma que cada roda seja considerada um objeto individual em vez de considerar todas as rodas disponíveis na imagem como um objeto.

Usamos Serviço de armazenamento simples da Amazon (Amazon S3) para armazenar o conjunto de dados usado para treinar o modelo Detectron junto com os artefatos do modelo treinado. Além disso, o contêiner Docker executado na função Lambda é armazenado em Registro do Amazon Elastic Container (Amazon ECR). O contêiner Docker na função Lambda é necessário para incluir as bibliotecas e dependências necessárias para executar o código. Poderíamos alternativamente usar Camadas lambda, mas está limitado a uma cota de tamanho de pacote de implantação descompactado de 250 MB e um máximo de cinco camadas podem ser adicionadas a uma função Lambda.

Nossa solução é construída no SageMaker: estendemos Contêineres Docker do SageMaker para PyTorch executar nosso PyTorch personalizado código de treinamento. Em seguida, usamos o SageMaker Python SDK para agrupar a imagem de treinamento em um estimador SageMaker PyTorch, conforme mostrado nos seguintes trechos de código:

Finalmente, iniciamos o trabalho de treinamento chamando o fit() função no estimador PyTorch criado. Quando o treinamento for concluído, o artefato do modelo treinado será armazenado no bucket de sessão no Amazon S3 para ser usado no pipeline de inferência.

Implante o modelo usando SageMaker e pipelines de inferência

Também usamos o SageMaker para hospedar o endpoint de inferência que executa nosso modelo Detectron personalizado. A infraestrutura completa usada para implantar nossa solução é provisionada usando o AWS CDK. Podemos hospedar nosso modelo personalizado através de um Ponto de extremidade em tempo real do SageMaker chamando deploy no estimador PyTorch. Esta é a segunda vez que estendemos um contêiner SageMaker PyTorch pré-construído para incluir o PyTorch Detectron. Nós o usamos para executar o script de inferência e hospedar nosso modelo PyTorch treinado da seguinte forma:

Observe que usamos uma GPU ml.g4dn.xlarge para implantação porque é a menor GPU disponível e suficiente para esta demonstração. Dois componentes precisam ser configurados em nosso roteiro de inferência: carregamento de modelo e serviço de modelo. A função model_fn() é usado para carregar o modelo treinado que faz parte do contêiner Docker hospedado e também pode ser encontrado no Amazon S3 e retornar um objeto de modelo que pode ser usado para servir o modelo da seguinte maneira:

A função predict_fn() executa a previsão e retorna o resultado. Além de usar nosso modelo treinado, usamos uma versão pré-treinada do modelo Mask R-CNN treinado no conjunto de dados COCO para extrair o carro principal da imagem. Esta é uma etapa extra de pós-processamento para lidar com imagens onde existe mais de um carro. Veja o seguinte código:

Semelhante à solução Amazon Rekognition, as caixas delimitadoras previstas para o wheel classe são filtradas das saídas de detecção e fornecidas ao módulo de pós-processamento para avaliar a posição do carro em relação à saída.

Por fim, também melhoramos o pós-processamento da solução Detectron. Ele também usa segmentos de diferentes peças do carro para inferir a solução. Por exemplo, sempre que é detectado um pára-choques dianteiro, mas nenhum pára-choques traseiro, assume-se que temos uma visão frontal do carro e o ângulo correspondente é calculado.

Conecte sua solução ao aplicativo web

As etapas para conectar os endpoints do modelo ao Amplify são as seguintes:

- Clone o repositório do aplicativo criado pela pilha do AWS CDK, denominado

car-angle-detection-website-repo. Certifique-se de procurá-lo na região usada para implantação. - Copie os endpoints do API Gateway para cada uma das funções do Lambda implantadas no arquivo

index.htmlarquivo no repositório anterior (há espaços reservados onde o endpoint precisa ser colocado). O código a seguir é um exemplo da aparência desta seção do arquivo .html:

- Salve o arquivo HTML e envie a alteração do código para a ramificação principal remota.

Isso atualizará o arquivo HTML na implantação. O aplicativo agora está pronto para uso.

- Navegue até o console do Amplify e localize o projeto que você criou.

A URL do aplicativo ficará visível após a conclusão da implantação.

- Navegue até o URL e divirta-se com a IU.

Conclusão

Parabéns! Implantamos uma arquitetura serverless completa na qual usamos o Amazon Rekognition, mas também demos uma opção para seu próprio modelo personalizado, com este exemplo disponível em GitHub. Se você não tiver experiência em ML em sua equipe ou dados personalizados suficientes para treinar um modelo, poderá selecionar a opção que usa o Amazon Rekognition. Se você deseja mais controle sobre seu modelo, personalizá-lo ainda mais e tem dados suficientes, pode escolher a solução SageMaker. Se você tiver uma equipe de cientistas de dados, eles também poderão querer aprimorar ainda mais os modelos e escolher uma opção mais personalizada e flexível. Você pode colocar a função Lambda e o API Gateway por trás de seu aplicativo web usando qualquer uma das duas opções. Você também pode usar essa abordagem para um caso de uso diferente para o qual você queira adaptar o código.

A vantagem desta arquitetura sem servidor é que os blocos de construção são completamente intercambiáveis. As oportunidades são quase ilimitadas. Então, comece hoje!

Como sempre, a AWS agradece o feedback. Por favor, envie quaisquer comentários ou perguntas.

Sobre os autores

Michael Wallner é consultor sênior de dados e IA da AWS Professional Services e é apaixonado por permitir que os clientes em sua jornada se tornem orientados por dados e incríveis na nuvem AWS. Além disso, ele gosta de pensar grande com os clientes para inovar e inventar novas ideias para eles.

Michael Wallner é consultor sênior de dados e IA da AWS Professional Services e é apaixonado por permitir que os clientes em sua jornada se tornem orientados por dados e incríveis na nuvem AWS. Além disso, ele gosta de pensar grande com os clientes para inovar e inventar novas ideias para eles.

Aamna Najmi é cientista de dados da AWS Professional Services. Ela é apaixonada por ajudar os clientes a inovar com tecnologias de Big Data e Inteligência Artificial para aproveitar o valor comercial e os insights dos dados. Ela tem experiência em trabalhar em plataformas de dados e projetos de IA/ML na vertical de saúde e ciências biológicas. Nas horas vagas, ela gosta de jardinagem e de viajar para novos lugares.

Aamna Najmi é cientista de dados da AWS Professional Services. Ela é apaixonada por ajudar os clientes a inovar com tecnologias de Big Data e Inteligência Artificial para aproveitar o valor comercial e os insights dos dados. Ela tem experiência em trabalhar em plataformas de dados e projetos de IA/ML na vertical de saúde e ciências biológicas. Nas horas vagas, ela gosta de jardinagem e de viajar para novos lugares.

David Sauerwein é cientista de dados sênior na AWS Professional Services, onde capacita os clientes em sua jornada de IA/ML na nuvem AWS. David se concentra em gêmeos digitais, previsão e computação quântica. Ele tem doutorado em física teórica pela Universidade de Innsbruck, Áustria. Ele também foi pesquisador de doutorado e pós-doutorado no Instituto Max-Planck de Óptica Quântica na Alemanha. Nas horas vagas adora ler, esquiar e estar com a família.

David Sauerwein é cientista de dados sênior na AWS Professional Services, onde capacita os clientes em sua jornada de IA/ML na nuvem AWS. David se concentra em gêmeos digitais, previsão e computação quântica. Ele tem doutorado em física teórica pela Universidade de Innsbruck, Áustria. Ele também foi pesquisador de doutorado e pós-doutorado no Instituto Max-Planck de Óptica Quântica na Alemanha. Nas horas vagas adora ler, esquiar e estar com a família.

Srikrishna Chaitanya Konduru é cientista de dados sênior com serviços profissionais da AWS. Ele oferece suporte aos clientes na prototipagem e operacionalização de seus aplicativos de ML na AWS. Srikrishna se concentra em visão computacional e PNL. Ele também lidera iniciativas de design de plataforma de ML e identificação de casos de uso para clientes em diversos setores verticais do setor. Srikrishna possui mestrado em Engenharia Biomédica pela Universidade RWTH Aachen, Alemanha, com foco em Imagens Médicas.

Srikrishna Chaitanya Konduru é cientista de dados sênior com serviços profissionais da AWS. Ele oferece suporte aos clientes na prototipagem e operacionalização de seus aplicativos de ML na AWS. Srikrishna se concentra em visão computacional e PNL. Ele também lidera iniciativas de design de plataforma de ML e identificação de casos de uso para clientes em diversos setores verticais do setor. Srikrishna possui mestrado em Engenharia Biomédica pela Universidade RWTH Aachen, Alemanha, com foco em Imagens Médicas.

Ahmed Mansour é cientista de dados na AWS Professional Services. Ele fornece suporte técnico aos clientes durante sua jornada de IA/ML na nuvem AWS. Ahmed se concentra em aplicações de PNL ao domínio de proteínas junto com RL. Possui doutorado em Engenharia pela Universidade Técnica de Munique, Alemanha. Nas horas vagas adora ir à academia e brincar com os filhos.

Ahmed Mansour é cientista de dados na AWS Professional Services. Ele fornece suporte técnico aos clientes durante sua jornada de IA/ML na nuvem AWS. Ahmed se concentra em aplicações de PNL ao domínio de proteínas junto com RL. Possui doutorado em Engenharia pela Universidade Técnica de Munique, Alemanha. Nas horas vagas adora ir à academia e brincar com os filhos.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/build-and-train-computer-vision-models-to-detect-car-positions-in-images-using-amazon-sagemaker-and-amazon-rekognition/

- :tem

- :é

- :não

- :onde

- 1

- 10

- 100

- 11

- 12

- 13

- 15%

- 17

- 19

- 22

- 250

- 500

- 7

- 9

- a

- Sobre

- precisão

- em

- adaptar

- Adaptações

- adicionado

- Adicional

- Informação adicional

- endereço

- Vantagem

- Depois de

- novamente

- AI

- AI / ML

- algoritmos

- Todos os Produtos

- permite

- juntamente

- tb

- sempre

- Amazon

- Reconhecimento da Amazônia

- Amazon Sage Maker

- Amazon Web Services

- an

- análise

- e

- Outro

- qualquer

- api

- app

- Aplicação

- aplicações

- Aplicações da PNL

- aplicado

- abordagem

- aproximadamente

- arquitetura

- SOMOS

- áreas

- artificial

- inteligência artificial

- AS

- avaliar

- atribuído

- assumiu

- At

- Áustria

- Automatizado

- disponível

- AWS

- Serviços Profissionais AWS

- em caminho duplo

- base

- baseado

- BE

- Porque

- tornam-se

- atrás

- ser

- pertence

- além de

- Grande

- Big Data

- biomédica

- Blocos

- corpo

- ambos

- Caixa

- caixas

- Ramo

- trazer

- construir

- Prédio

- construído

- negócio

- mas a

- Comprar

- by

- calcular

- calculado

- calcula

- chamada

- CAN

- Câncer

- capacidades

- carro

- carros

- casas

- casos

- Categorias

- Centralização de

- alterar

- Escolha

- classe

- Na nuvem

- coco

- código

- combinar

- comentários

- comum

- completar

- completamente

- integrações

- compliance

- componentes

- computação

- cálculos

- computador

- Visão de Computador

- confiança

- configurado

- Contato

- considerado

- considerando

- consistente

- consiste

- cônsul

- consultor

- Recipiente

- contém

- conteúdo

- contexto

- ao controle

- Correspondente

- dispendioso

- poderia

- cobrir

- criado

- colheita

- personalizadas

- Clientes

- personalizável

- personalizar

- dados,

- Plataforma de dados

- cientista de dados

- orientado por dados

- conjuntos de dados

- David

- acordo

- profundo

- deep learning

- Define

- demonstração

- demonstrar

- demonstra

- dependências

- implantar

- implantado

- desenvolvimento

- Design

- detalhes

- descobrir

- detectou

- Detecção

- diferente

- digital

- Gêmeos digitais

- diferente

- do

- Estivador

- Não faz

- domínio

- não

- cada

- efeito

- ou

- outro

- permite

- permitindo

- Ponto final

- COMPROMETIMENTO

- Engenharia

- aumentar

- suficiente

- entrada

- erro

- Evento

- exemplo

- existente

- existe

- espera

- vasta experiência

- experiência

- exposto

- estender

- extra

- extrato

- família

- famoso

- retornos

- poucos

- Envie o

- Arquivos

- Finalmente

- Primeiro nome

- flexível

- Foco

- concentra-se

- seguinte

- segue

- Escolha

- encontrado

- Quadro

- Gratuito

- da

- frente

- cheio

- totalmente

- Diversão

- função

- funções

- mais distante

- porta de entrada

- Alemanha

- ter

- dado

- vidro

- Go

- GPU

- ginásio

- Queijos duros

- Ter

- he

- saúde

- ajuda

- sua experiência

- sua

- hospedeiro

- hospedado

- HORÁRIO

- Como funciona o dobrador de carta de canal

- Contudo

- HTML

- HTTPS

- idéia

- idéias

- identificação

- if

- ilustra

- imagem

- imagens

- Imagiologia

- importante

- melhorar

- melhorado

- in

- incluir

- Individual

- indústria

- INFORMAÇÕES

- Infraestrutura

- iniciativas

- inovar

- entrada

- insights

- instância

- em vez disso

- integrar

- integrado

- Inteligência

- para dentro

- invocado

- IT

- ESTÁ

- Trabalho

- viagem

- jpg

- json

- apenas por

- Chave

- crianças

- O rótulo

- Rótulos

- camadas

- Leads

- aprendizagem

- bibliotecas

- Biblioteca

- vida

- Ciências da Vida

- como

- gostos

- Limitado

- ilimitado

- carregar

- carregamento

- localização

- procurando

- OLHARES

- lote

- ama

- máquina

- aprendizado de máquina

- a Principal

- fazer

- gerenciados

- muitos

- mapeamento

- máscara

- Máscaras

- matemática

- máximo

- Mídia

- médico

- poder

- milhões

- ML

- Móvel Esteira

- Aplicações móveis

- modelo

- modelos

- moderação

- modificada

- Módulo

- mais

- Além disso

- a maioria

- múltiplo

- Nomeado

- você merece...

- necessário

- Cria

- Novo

- Próximo

- PNL

- não

- agora

- objeto

- Detecção de Objetos

- objetos

- obter

- of

- on

- ONE

- online

- compras on-line

- só

- oportunidades

- ótica

- Opção

- Opções

- or

- Outros

- A Nossa

- Fora

- saída

- Acima de

- próprio

- empacotado

- par

- parte

- peças

- apaixonado

- Realizar

- executa

- Física

- escolher

- oleoduto

- Locais

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- Jogar

- por favor

- ponto

- pose

- Estimativa de pose

- posição

- abertas

- possível

- Publique

- predizer

- previsto

- predição

- Predictor

- pré-requisitos

- presente

- Prévio

- Problema

- produzir

- Produto

- Produtos

- profissional

- projeto

- projetos

- Proteína

- prototipagem

- fornecer

- fornece

- publicamente

- Empurrar

- colocar

- Python

- pytorch

- Quantum

- Óptica quântica

- Frequentes

- alcance

- Taxa

- Leia

- pronto

- em tempo real

- razões

- região

- relativo

- remoto

- repositório

- representando

- requerer

- requeridos

- Requisitos

- exige

- investigador

- resposta

- resultar

- retorno

- Retorna

- Execute

- corrida

- é executado

- sábio

- SC

- CIÊNCIAS

- Cientista

- cientistas

- Sdk

- Segundo

- Seção

- Vejo

- segmento

- segmentação

- segmentos

- autodirrigação

- senior

- Serverless

- serviço

- Serviços

- de servir

- Sessão

- conjunto

- vários

- ela

- minha

- rede de apoio social

- mostrar

- mostrando

- lado

- semelhante

- simples

- Tamanho

- pequeno

- So

- Redes Sociais

- meios de comunicação social

- sociais plataformas de mídia

- solução

- Soluções

- RESOLVER

- alguns

- específico

- gastar

- Esportes

- pilha

- padrão

- começo

- começado

- estado-da-arte

- Passo

- Passos

- armazenamento

- loja

- armazenadas

- enviar

- tal

- suficiente

- fornecidas

- ajuda

- suportes

- certo

- .

- tomado

- Torneira

- tarefas

- TD

- Profissionais

- Dados Técnicos:

- Tecnologias

- dezenas

- do que

- que

- A

- deles

- Eles

- então

- teórico

- Lá.

- assim sendo

- Este

- deles

- Pensando

- isto

- Através da

- tempo

- para

- topo

- Trem

- treinado

- Training

- transferência

- Viagens

- Twins

- dois

- ui

- universidade

- Atualizar

- URL

- us

- usar

- caso de uso

- usava

- Utilizador

- Experiência do Usuário

- usos

- utilização

- utilidade

- validação

- valor

- variedade

- Veículos

- versão

- vertical

- Verticais

- muito

- Vídeo

- Ver

- visualizações

- visível

- visão

- Passo a passo

- queremos

- foi

- we

- web

- Aplicativo da Web

- serviços web

- acolhe

- bem conhecido

- foram

- O Quê

- Roda

- quando

- sempre que

- qual

- inteiro

- precisarão

- de

- sem

- trabalhar

- seria

- embrulho

- Vocês

- investimentos

- zefirnet