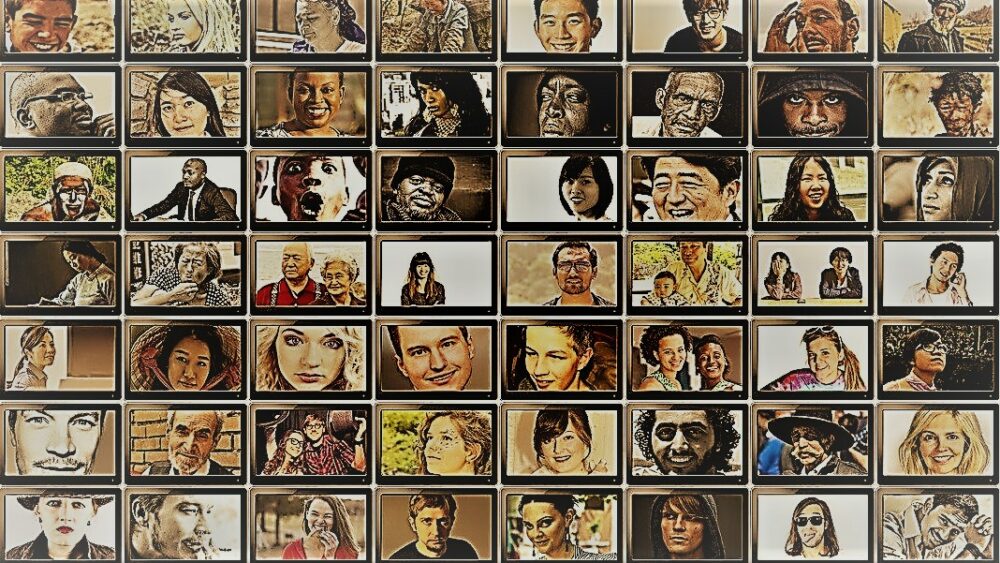

Sou um grande fã do programa de viagens de Anthony Bourdain Partes Desconhecidas. Em cada episódio, o chef visita aldeias remotas em todo o mundo, documentando a vida, a comida e a cultura das tribos regionais com o coração e a mente abertos.

O show fornece um vislumbre da surpreendente diversidade da humanidade. Os cientistas sociais têm um objetivo semelhante – entender o comportamento de diferentes pessoas, grupos e culturas – mas usam uma variedade de métodos em situações controladas. Para ambos, as estrelas dessas buscas são os sujeitos: os humanos.

Mas e se você substituísse os humanos por chatbots de IA?

A ideia parece absurda. No entanto, graças ao advento do ChatGPT e de outros grandes modelos de linguagem (LLMs), os cientistas sociais estão flertando com a ideia de usar essas ferramentas para construir rapidamente diversos grupos de “humanos simulados” e realizar experimentos para sondar seu comportamento e valores como um proxy para suas contrapartes biológicas.

Se você está imaginando mentes humanas recriadas digitalmente, não é isso. A ideia é aproveitar a experiência do ChatGPT em imitar respostas humanas. Como os modelos coletam enormes quantidades de dados online – blogs, comentários do Youtube, fanfics, livros – eles capturam prontamente as relações entre as palavras em vários idiomas. Esses algoritmos sofisticados também podem decodificar aspectos diferenciados da linguagem, como ironia, sarcasmo, metáforas e tons emocionais, um aspecto crítico da comunicação humana em todas as culturas. Esses pontos fortes configuram os LLMs para imitar múltiplas personalidades sintéticas com uma ampla gama de crenças.

Outro bônus? Comparado aos participantes humanos, o ChatGPT e outros LLMs não se cansam, permitindo que os cientistas coletem dados e testem teorias sobre o comportamento humano com uma velocidade sem precedentes.

A ideia, embora polêmica, já tem respaldo. Um artigo recente a revisão do campo nascente descobriu que, em certos cenários cuidadosamente projetados, as respostas do ChatGPT se correlacionavam com as de aproximadamente 95% dos participantes humanos.

A IA “pode mudar o jogo para a pesquisa em ciências sociais”, dito Dr. Igor Grossman da Universidade de Waterloo, que com colegas recentemente escreveu um artigo antecipado em Ciência. A chave para usar Homo silício em pesquisa? Gerenciamento cuidadoso de viés e fidelidade de dados, disse a equipe.

Sondando a mente social humana

O que exatamente é ciência social?

Simplificando, é estudar como os humanos – como indivíduos ou como um grupo – se comportam em diferentes circunstâncias, como eles interagem uns com os outros e se desenvolvem como uma cultura. É um guarda-chuva da busca acadêmica com vários ramos: economia, ciência política, antropologia e psicologia.

A disciplina aborda uma ampla gama de tópicos proeminentes no atual zeitgeist. Qual é o impacto das redes sociais na saúde mental? Quais são as atitudes públicas atuais em relação às mudanças climáticas à medida que os episódios climáticos severos aumentam? Como diferentes culturas valorizam os métodos de comunicação - e o que desencadeia mal-entendidos?

Um estudo de ciências sociais começa com uma pergunta e uma hipótese. Uma das minhas favoritas: as culturas toleram o odor corporal de maneira diferente? (Sem brincadeiras, o tópico foi estudado um pouco, e sim, Há uma diferença!)

Os cientistas então usam uma variedade de métodos, como questionários, testes comportamentais, observação e modelagem para testar suas ideias. As pesquisas são uma ferramenta especialmente popular, porque as perguntas podem ser rigorosamente projetadas e verificadas e podem atingir facilmente uma ampla gama de pessoas quando distribuídas on-line. Os cientistas então analisam as respostas escritas e extraem insights sobre o comportamento humano. Em outras palavras, o uso da linguagem por um participante é crítico para esses estudos.

Então, como o ChatGPT se encaixa?

O 'Homo Silicus'

Para Grossman, os LLMs por trás de chatbots como ChatGPT ou Google's Bard representam uma oportunidade sem precedentes para redesenhar experimentos de ciências sociais.

Por serem treinados em conjuntos de dados massivos, os LLMs “podem representar uma vasta gama de experiências e perspectivas humanas”, disseram os autores. Como os modelos “vagam” livremente sem fronteiras pela Internet – como pessoas que costumam viajar internacionalmente – eles podem adotar e exibir uma gama mais ampla de respostas em comparação com sujeitos humanos recrutados.

O ChatGPT também não é influenciado por outros membros de um estudo ou se cansa, o que pode gerar respostas menos tendenciosas. Essas características podem ser especialmente úteis em “projetos de alto risco” – por exemplo, imitando as respostas de pessoas que vivem em países em guerra ou sob regimes difíceis por meio de postagens nas redes sociais. Por sua vez, as respostas poderiam informar as intervenções do mundo real.

Da mesma forma, os LLMs treinados em tópicos culturais quentes, como identidade de gênero ou desinformação, podem reproduzir diferentes escolas teóricas ou ideológicas de pensamento para informar as políticas. Em vez de pesquisar meticulosamente centenas de milhares de participantes humanos, a IA pode gerar respostas rapidamente com base no discurso online.

Potenciais usos da vida real à parte, os LLMs também podem atuar como sujeitos digitais que interagem com participantes humanos em experimentos de ciências sociais, algo semelhante aos personagens não-jogadores (NPC) em videogames. Por exemplo, o LLM poderia adotar diferentes “personalidades” e interagir com voluntários humanos em todo o mundo online usando texto, fazendo-lhes a mesma pergunta. Como os algoritmos não dormem, ele pode funcionar 24 horas por dia, 7 dias por semana. Os dados resultantes podem ajudar os cientistas a explorar como diversas culturas avaliam informações semelhantes e como as opiniões – e informações erradas – se espalham.

Passos de bebê

A ideia de usar chatbots no lugar de humanos em estudos ainda não é popular.

Mas há provas iniciais de que poderia funcionar. A estudo de pré-impressão lançado este mês pela Georgia Tech, Microsoft Research e Olin College descobriu que um LLM replicou as respostas humanas em vários experimentos de psicologia clássica, incluindo o infame Experimentos de choque de Milgram.

No entanto, uma questão crítica permanece: quão bem esses modelos podem realmente capturar a resposta de um ser humano?

Existem vários obstáculos.

A primeira é a qualidade do algoritmo e dos dados de treinamento. A maior parte do conteúdo online é dominada por apenas um punhado de idiomas. Um LLM treinado com esses dados pode facilmente imitar o sentimento, a perspectiva ou até mesmo o julgamento moral das pessoas que usam esses idiomas - por sua vez, herdando o viés dos dados de treinamento.

“Essa reprodução de viés é uma grande preocupação porque pode ampliar as próprias disparidades que os cientistas sociais se esforçam para descobrir em suas pesquisas”, disse Grossman.

Alguns cientistas também temem que os LLMs sejam apenas regurgitando o que eles dizem. É a antítese de um estudo de ciências sociais, no qual o ponto principal é capturar a humanidade em toda a sua beleza diversificada e complexa. Por outro lado, ChatGPT e modelos semelhantes são conhecidos por “alucinar”, inventando informações que parecem plausíveis, mas são falsas.

Por enquanto, “grandes modelos de linguagem dependem de 'sombras' de experiências humanas”, disse Grossman. Como esses sistemas de IA são em grande parte caixas pretas, é difícil entender como ou por que eles geram certas respostas – um pouco preocupante quando usados como representantes humanos em experimentos comportamentais.

Apesar das limitações, “os LLMs permitem que os cientistas sociais rompam com os métodos tradicionais de pesquisa e abordem seu trabalho de maneiras inovadoras”, disseram os autores. Como primeiro passo, o Homo silicus poderia ajudar a debater e testar hipóteses rapidamente, com as mais promissoras sendo validadas em populações humanas.

Mas para que as ciências sociais realmente dêem as boas-vindas à IA, será necessário haver transparência, justiça e acesso igualitário a esses sistemas poderosos. Os LLMs são difíceis e caros de treinar, com modelos recentes cada vez mais fechados atrás de pesadas barreiras de pagamento.

“Devemos garantir que os LLMs de ciências sociais, como todos os modelos científicos, sejam de código aberto, o que significa que seus algoritmos e, idealmente, os dados estão disponíveis para todos examinarem, testarem e modificarem.” dito autor do estudo, Dr. Dawn Parker, da Universidade de Waterloo. “Somente mantendo a transparência e a replicabilidade podemos garantir que a pesquisa em ciências sociais assistida por IA realmente contribua para nossa compreensão da experiência humana”.

Crédito de imagem: Gerd Altmann / P

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :tem

- :é

- :não

- $UP

- 23

- a

- Sobre

- acadêmico

- Acesso

- em

- Aja

- adotar

- advento

- AI

- algoritmo

- algoritmos

- Todos os Produtos

- permitir

- Permitindo

- já

- tb

- quantidades

- an

- analisar

- e

- Anthony

- abordagem

- SOMOS

- arizona

- Ordem

- artigo

- AS

- aspecto

- aspectos

- At

- autor

- autores

- disponível

- baseado

- BE

- Beleza

- Porque

- sido

- comportamento

- atrás

- ser

- crenças

- entre

- viés

- tendencioso

- Pouco

- Preto

- Blocos

- corpo

- Bônus

- fronteiras

- ambos

- caixas

- brainstorming

- ramos

- Break

- mas a

- by

- CAN

- capturar

- cuidadoso

- certo

- alterar

- caracteres

- chatbots

- ChatGPT

- circunstâncias

- Clima

- Das Alterações Climáticas

- colegas

- coletar

- Faculdade

- comentários

- Comunicação

- comparado

- integrações

- Interesse

- construir

- conteúdo

- contribui

- controlado

- controverso

- poderia

- países

- crédito

- crítico

- aspecto crítico

- cultural

- Cultura

- Atual

- dados,

- conjuntos de dados

- projetado

- desenvolver

- diferente

- difícil

- digital

- digitalmente

- Ecrã

- distribuído

- diferente

- Diversidade

- do

- parece

- Não faz

- não

- dr

- desenhar

- cada

- Cedo

- facilmente

- Economia

- enorme

- garantir

- episódio

- igual

- especialmente

- avaliar

- Mesmo

- Cada

- exatamente

- exemplo

- caro

- vasta experiência

- Experiências

- experimentos

- experiência

- explorar

- justiça

- falso

- ventilador

- Ficção

- fidelidade

- campo

- Primeiro nome

- caber

- alimentos

- Escolha

- encontrado

- da

- mais distante

- jogo

- Games

- Gênero

- gerar

- ter

- Vislumbre

- globo

- Do grupo

- mão

- punhado

- Ter

- Saúde

- Coração

- ajudar

- HOT

- Como funciona o dobrador de carta de canal

- HTML

- http

- HTTPS

- enorme

- humano

- Experiência Humana

- Humanidade

- Humanos

- Centenas

- idéia

- idealmente

- idéias

- Identidade

- if

- Impacto

- in

- Em outra

- Incluindo

- Crescimento

- cada vez mais

- indivíduos

- infame

- influenciado

- informar

- INFORMAÇÕES

- inovadores

- insights

- interagir

- para dentro

- ironia

- IT

- ESTÁ

- jpg

- apenas por

- Chave

- conhecido

- língua

- Idiomas

- grande

- largamente

- menos

- como

- limitações

- Vidas

- vida

- LLM

- a Principal

- Corrente principal

- Manter

- principal

- Fazendo

- de grupos

- maciço

- Posso..

- significado

- Mídia

- Membros

- mental

- A saúde mental

- métodos

- Microsoft

- mente

- mentes

- Desinformação

- modelagem

- modelos

- modificar

- Mês

- moral

- a maioria

- múltiplo

- devo

- my

- nascente

- você merece...

- não

- agora

- numeroso

- of

- frequentemente

- on

- ONE

- queridos

- online

- aberto

- open source

- Oportunidade

- or

- Outros

- A Nossa

- participantes

- Pessoas

- por cento

- Personalidades

- perspectiva

- perspectivas

- platão

- Inteligência de Dados Platão

- PlatãoData

- plausível

- ponto

- políticas

- político

- Popular

- populações

- POSTAGENS

- potencialmente

- poderoso

- sonda

- proeminente

- promissor

- prova

- fornece

- procuração

- Psicologia

- público

- busca

- qualidade

- questão

- Frequentes

- alcance

- rapidamente

- em vez

- alcançar

- mundo real

- clientes

- recentemente

- recentemente

- redesenhar

- dietas

- regional

- Relacionamentos

- liberado

- depender

- permanece

- remoto

- substituído

- replicabilidade

- replicado

- representar

- reprodução

- pesquisa

- resposta

- respostas

- resultando

- grosseiramente

- Execute

- Dito

- mesmo

- cenários

- Escolas

- Ciência

- CIÊNCIAS

- científico

- cientistas

- sentimento

- conjunto

- vários

- grave

- mostrar

- semelhante

- simplesmente

- situações

- dormir

- Redes Sociais

- meios de comunicação social

- Publicações nas redes sociais

- social

- um pouco

- sofisticado

- velocidade

- Estrelas

- começa

- Passo

- pontos fortes

- lutar

- caso

- Estudo

- Estudando

- tropeçando

- tal

- ajuda

- sintético

- sistemas

- Desarmes

- Torneira

- Profissionais

- tecnologia

- teste

- testes

- do que

- obrigado

- que

- A

- deles

- Eles

- então

- teórico

- Lá.

- Este

- deles

- isto

- aqueles

- Apesar?

- pensamento

- milhares

- Através da

- cansado

- para

- ferramenta

- ferramentas

- Temas

- para

- tradicional

- Trem

- treinado

- Training

- Transparência

- viagens

- perturbador

- verdadeiramente

- VIRAR

- guarda-chuva

- descobrir

- para

- compreender

- compreensão

- universidade

- sem precedente

- usar

- usos

- utilização

- validado

- valor

- Valores

- variedade

- Grande

- muito

- verificado

- Vídeo

- jogos de vídeo

- Visitas

- voluntários

- guerra

- maneiras

- we

- Clima

- boas-vindas

- BEM

- O Quê

- quando

- qual

- QUEM

- porque

- Largo

- Ampla variedade

- mais largo

- Wikipedia

- precisarão

- de

- sem

- palavras

- Atividades:

- trabalho

- preocupar-se

- escrito

- sim

- ainda

- Vocês

- Youtube

- Zeitgeist

- zefirnet