O aprendizado de máquina (ML) está revolucionando muitos setores em um ritmo sem precedentes. O setor de saúde e ciências da vida (HCLS) vem passando por uma rápida evolução nos últimos anos, adotando o ML em uma infinidade de casos de uso para fornecer atendimento de qualidade e melhorar os resultados dos pacientes.

Em um ciclo de vida típico de ML, engenheiros de dados e cientistas passam a maior parte do tempo na preparação de dados e nas etapas de engenharia de recursos antes mesmo de iniciar o processo de construção e treinamento de modelos. Ter uma ferramenta que possa reduzir a barreira de entrada para a preparação de dados, melhorando assim a produtividade, é um pedido altamente desejável para essas personas. Gerenciador de dados do Amazon SageMaker é desenvolvido pela AWS para reduzir a curva de aprendizado e permitir que os profissionais de dados realizem tarefas de preparação, limpeza e engenharia de recursos de dados com menos esforço e tempo. Ele oferece uma interface GUI com muitas funções integradas e integrações com outros serviços da AWS, como Serviço de armazenamento simples da Amazon (Amazon S3) e Loja de recursos Amazon SageMaker, bem como fontes de dados de parceiros, incluindo Snowflake e Databricks.

Neste post, demonstramos como usar o Data Wrangler para preparar dados de saúde para treinar um modelo para prever insuficiência cardíaca, considerando a demografia de um paciente, condições médicas anteriores e histórico de resultados de exames laboratoriais.

Visão geral da solução

A solução consiste nas seguintes etapas:

- Adquira um conjunto de dados de saúde como entrada para o Data Wrangler.

- Use as funções de transformação integradas do Data Wrangler para transformar o conjunto de dados. Isso inclui descartar colunas, destacar dados/hora, unir conjuntos de dados, imputar valores ausentes, codificar variáveis categóricas, dimensionar valores numéricos, equilibrar o conjunto de dados e muito mais.

- Use a função de transformação personalizada do Data Wrangler (código Pandas ou PySpark) para complementar as transformações adicionais necessárias além das transformações internas e demonstrar a extensibilidade do Data Wrangler. Isso inclui filtrar linhas, agrupar dados, formar novos dataframes com base em condições e muito mais.

- Use as funções de visualização integradas do Data Wrangler para realizar a análise visual. Isso inclui vazamento de destino, correlação de recursos, modelo rápido e muito mais.

- Use as opções de exportação integradas do Data Wrangler para exportar o conjunto de dados transformado para o Amazon S3.

- Inicie um notebook Jupyter para usar o conjunto de dados transformado no Amazon S3 como entrada para treinar um modelo.

Gerar um conjunto de dados

Agora que estabelecemos a declaração do problema de ML, primeiro nos concentramos em adquirir os dados de que precisamos. Estudos de pesquisa, como Previsão de Insuficiência Cardíaca pode fornecer dados que já estão em boa forma. No entanto, muitas vezes encontramos cenários em que os dados são bastante confusos e exigem associação, limpeza e várias outras transformações muito específicas para o domínio da saúde antes que possam ser usados para treinamento de ML. Queremos encontrar ou gerar dados que sejam confusos o suficiente e orientá-lo nas etapas de preparação usando o Data Wrangler. Com isso em mente, escolhemos o Synthea como uma ferramenta para gerar dados sintéticos que se encaixam no nosso objetivo. Sinteia é um gerador de paciente sintético de código aberto que modela o histórico médico de pacientes sintéticos. Para gerar seu conjunto de dados, conclua as etapas a seguir:

- Siga as instruções conforme começo rápido documentação para criar um Estúdio Amazon SageMaker domínio e inicie o Studio.

Esta é uma etapa de pré-requisito. É opcional se o Studio já estiver configurado em sua conta. - Após o lançamento do Studio, no lançador guia, escolha Terminal do sistema.

Isso inicia uma sessão de terminal que fornece uma interface de linha de comando para trabalhar. - Para instalar o Synthea e gerar o conjunto de dados no formato CSV, execute os seguintes comandos na sessão de terminal iniciada:

Fornecemos um parâmetro para gerar os conjuntos de dados com um tamanho populacional de 10,000. Observe que o parâmetro size denota o número de membros vivos da população. Além disso, o Synthea também gera dados para membros mortos da população, o que pode adicionar alguns pontos de dados extras ao tamanho de amostra especificado.

Aguarde até que a geração de dados seja concluída. Essa etapa geralmente leva cerca de uma hora ou menos. Synthea gera vários conjuntos de dados, incluindo patients, medications, allergies, conditions, e mais. Para este post, usamos três dos conjuntos de dados resultantes:

- pacientes.csv – Este conjunto de dados tem cerca de 3.2 MB e contém aproximadamente 11,000 linhas de dados do paciente (25 colunas, incluindo ID do paciente, data de nascimento, sexo, endereço e mais)

- condições.csv – Este conjunto de dados tem cerca de 47 MB e contém aproximadamente 370,000 linhas de dados de condição médica (seis colunas, incluindo ID do paciente, data de início da condição, código de condição e mais)

- observações.csv – Este conjunto de dados tem cerca de 830 MB e contém aproximadamente 5 milhões de linhas de dados de observação (oito colunas, incluindo ID do paciente, data de observação, código de observação, valor e mais)

Existe uma relação um-para-muitos entre o patients e conditions conjuntos de dados. Existe também uma relação um-para-muitos entre o patients e observations conjuntos de dados. Para um dicionário de dados detalhado, consulte Dicionário de dados do arquivo CSV.

- Para fazer upload dos conjuntos de dados gerados para um bucket de origem no Amazon S3, execute os seguintes comandos na sessão do terminal:

Iniciar o Data Wrangler

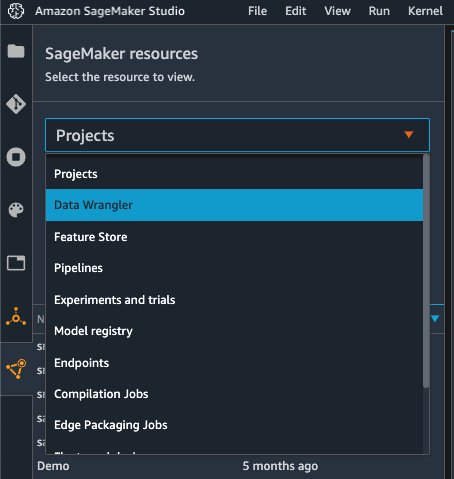

Escolha Recursos do SageMaker na página de navegação do Studio e no Projectos menu, escolha Organizador de dados para criar um fluxo de dados do Data Wrangler. Para obter etapas detalhadas sobre como iniciar o Data Wrangler de dentro do Studio, consulte Introdução ao Data Wrangler.

Datas de importação

Para importar seus dados, conclua as seguintes etapas:

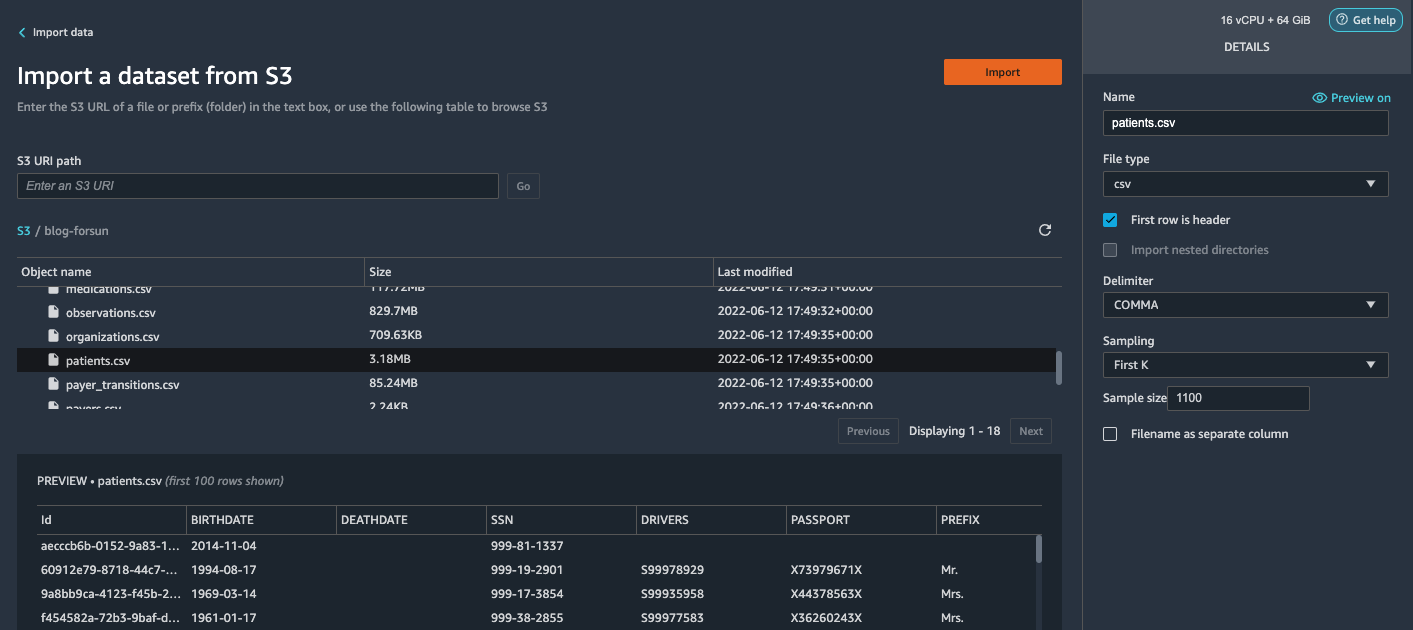

- Escolha Amazon S3 e localize o arquivo patient.csv no bucket do S3.

- No Adicionar ao carrinho painel, escolha Primeiro K para Amostragem.

- Entrar

1100para Tamanho da amostra.

No painel de visualização, o Data Wrangler extrai as primeiras 100 linhas do conjunto de dados e as lista como uma visualização. - Escolha importação.

O Data Wrangler seleciona os primeiros 1,100 pacientes do total de pacientes (11,000 linhas) gerados pelo Synthea e importa os dados. A abordagem de amostragem permite que o Data Wrangler processe apenas os dados de amostra. Ele nos permite desenvolver nosso fluxo de dados com um conjunto de dados menor, o que resulta em um processamento mais rápido e um ciclo de feedback mais curto. Depois de criarmos o fluxo de dados, podemos enviar a receita desenvolvida para um Processamento do SageMaker trabalho para dimensionar horizontalmente o processamento para o conjunto de dados completo ou maior de forma distribuída.

- Repita este processo para o

conditionseobservationsconjuntos de dados.- Para o

conditionsconjunto de dados, insira37000para Tamanho da amostra, que é 1/10 do total de 370,000 linhas geradas pelo Synthea. - Para o

observationsconjunto de dados, insira500000para Tamanho da amostra, que é 1/10 do total de observações 5 milhões de linhas geradas pelo Synthea.

- Para o

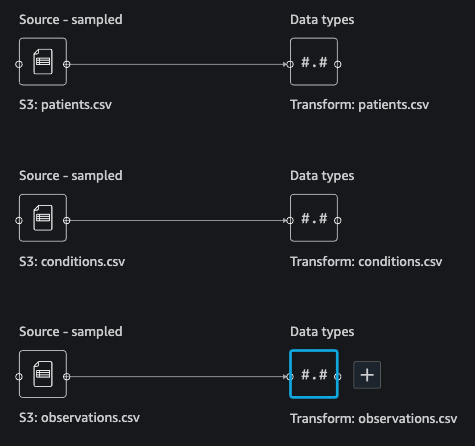

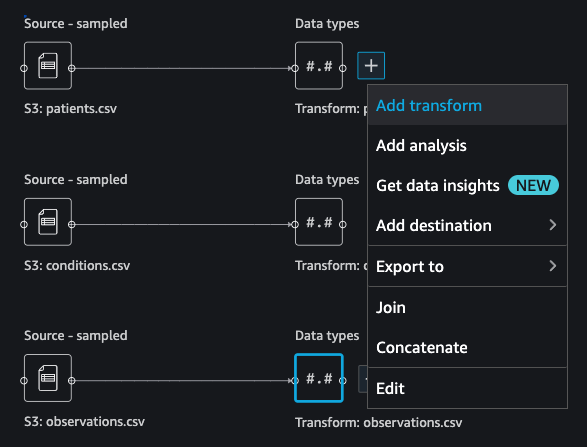

Você deve ver três conjuntos de dados, conforme mostrado na captura de tela a seguir.

Transforme os dados

A transformação de dados é o processo de alteração da estrutura, valor ou formato de uma ou mais colunas no conjunto de dados. O processo geralmente é desenvolvido por um engenheiro de dados e pode ser um desafio para pessoas com um conjunto menor de habilidades de engenharia de dados para decifrar a lógica proposta para a transformação. A transformação de dados faz parte do processo de engenharia de recursos mais amplo, e a sequência correta de etapas é outro critério importante a ser lembrado ao elaborar essas receitas.

O Data Wrangler foi projetado para ser uma ferramenta de baixo código para reduzir a barreira de entrada para uma preparação eficaz de dados. Ele vem com mais de 300 transformações de dados pré-configuradas para você escolher sem escrever uma única linha de código. Nas seções a seguir, veremos como transformar os conjuntos de dados importados no Data Wrangler.

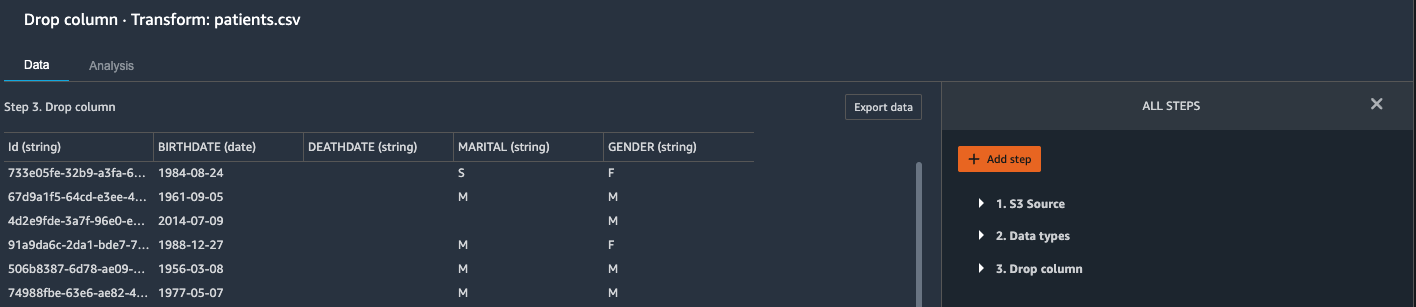

Solte colunas em pacientes.csv

Primeiro, removemos algumas colunas do patients conjunto de dados. A eliminação de colunas redundantes remove informações não relevantes do conjunto de dados e nos ajuda a reduzir a quantidade de recursos de computação necessários para processar o conjunto de dados e treinar um modelo. Nesta seção, descartamos colunas como SSN ou número do passaporte com base no senso comum de que essas colunas não têm valor preditivo. Em outras palavras, eles não ajudam nosso modelo a prever insuficiência cardíaca. Nosso estudo também não está preocupado com outras colunas, como local de nascimento ou a influência das despesas de saúde na insuficiência cardíaca de um paciente, então as descartamos também. Colunas redundantes também podem ser identificadas executando as análises integradas, como vazamento de destino, correlação de recursos, multicolinearidade e muito mais, que são incorporadas ao Data Wrangler. Para obter mais detalhes sobre os tipos de análise suportados, consulte Analisar e visualizar. Além disso, você pode usar o Relatório de insights e qualidade de dados para realizar análises automatizadas nos conjuntos de dados para chegar a uma lista de colunas redundantes a serem eliminadas.

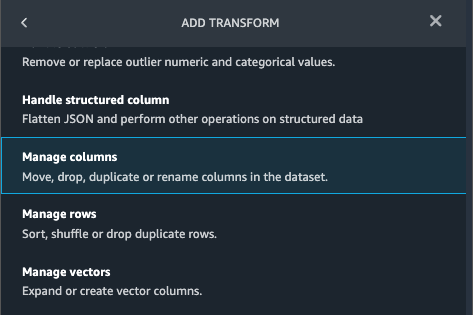

- Escolha o sinal de mais ao lado de Tipos de dados para o conjunto de dados patient.csv e escolha Adicionar transformação.

- Escolha Adicionar etapa e escolha Gerenciar colunas.

- Escolha Transformar¸ escolher Coluna de queda.

- Escolha Colunas para soltar, escolha as seguintes colunas:

SSNDRIVERSPASSPORTPREFIXFIRSTLASTSUFFIXMAIDENRACEETHNICITYBIRTHPLACEADDRESSCITYSTATECOUNTYZIPLATLONHEALTHCARE_EXPENSESHEALTHCARE_COVERAGE

- Escolha visualização para revisar o conjunto de dados transformado e escolha Adicionar.

Você deve ver o passo Coluna de queda na sua lista de transformações.

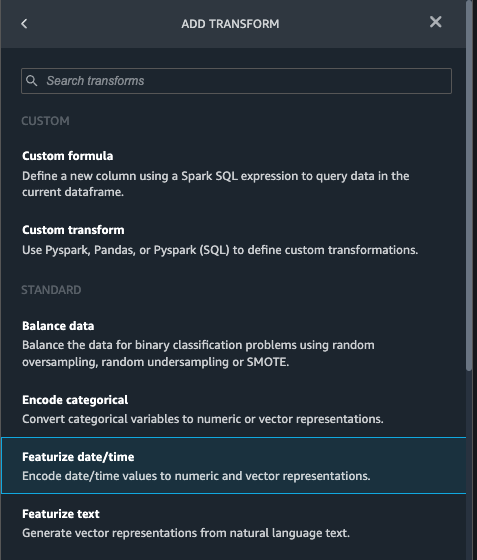

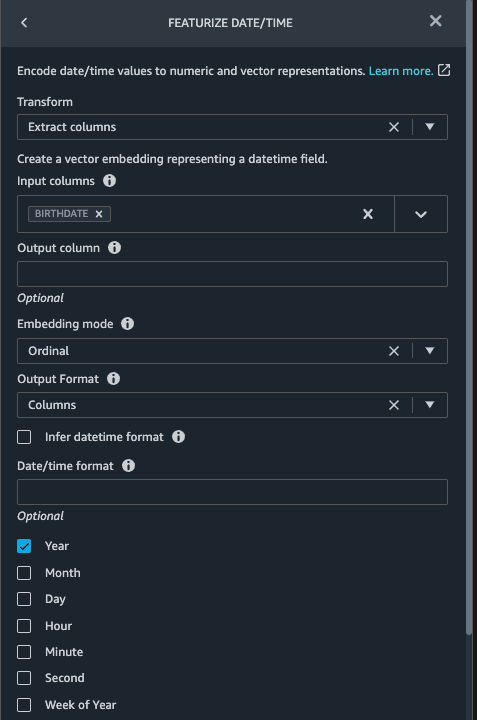

Apresente data/hora em pacientes.csv

Agora usamos a função Featurize date/time para gerar o novo recurso Year do BIRTHDATE coluna no patients conjunto de dados. Usamos o novo recurso em uma etapa subsequente para calcular a idade de um paciente no momento da observação.

- No Transformações painel do seu Coluna de queda página para o

patientsconjunto de dados, escolha Adicionar etapa. - Escolha o Destaque data/hora transformar.

- Escolha Extrair colunas.

- Escolha Colunas de entrada, adicione a coluna

BIRTHDATE. - Selecionar Ano e desmarque Mês, Dia, hora, Minuto, Segundo.

- Escolha visualização, Em seguida, escolha Adicionar.

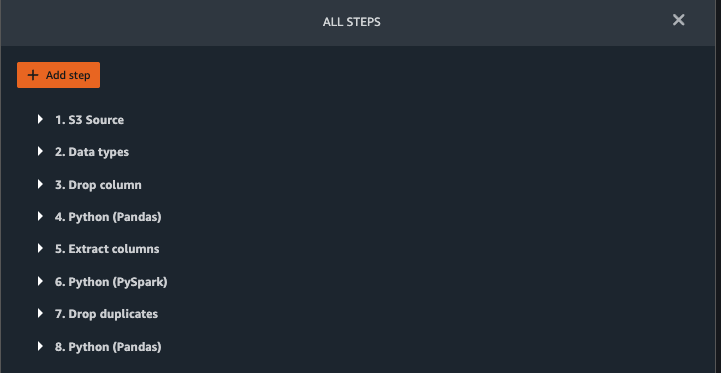

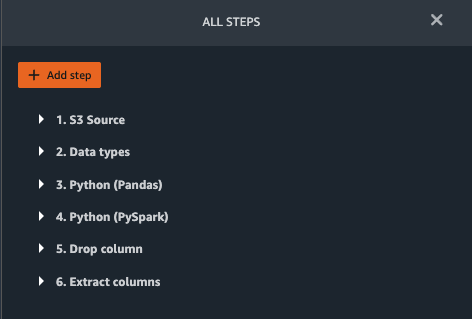

Adicionar transformações em notes.csv

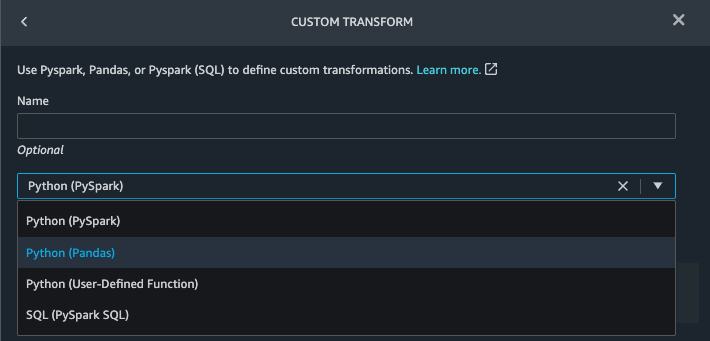

O Data Wrangler oferece suporte a transformações personalizadas usando Python (funções definidas pelo usuário), PySpark, Pandas ou PySpark (SQL). Você pode escolher seu tipo de transformação com base em sua familiaridade com cada opção e preferência. Para as três últimas opções, o Data Wrangler expõe a variável df para você acessar o dataframe e aplicar transformações nele. Para uma explicação detalhada e exemplos, consulte Transformações personalizadas. Nesta seção, adicionamos três transformações personalizadas ao observations conjunto de dados.

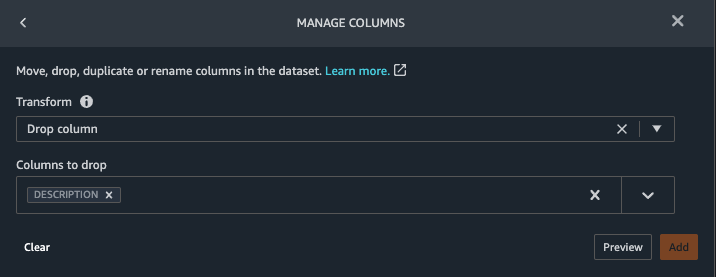

- Adicione uma transformação ao arquivo reflections.csv e elimine o

DESCRIPTIONcoluna.

- Escolha visualização, Em seguida, escolha Adicionar.

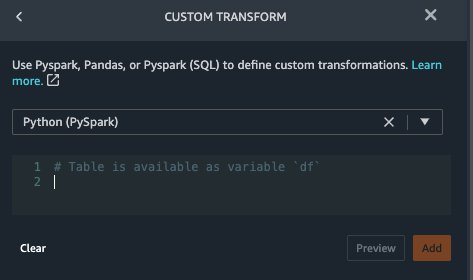

- No Transformações painel, escolha Adicionar etapa e escolha Transformação personalizada.

- No menu suspenso, escolha Python (pandas).

- Insira o seguinte código:

Estes são códigos LONIC que correspondem às seguintes observações que estamos interessados em usar como recursos para prever insuficiência cardíaca:

- Escolha visualização, Em seguida, escolha Adicionar.

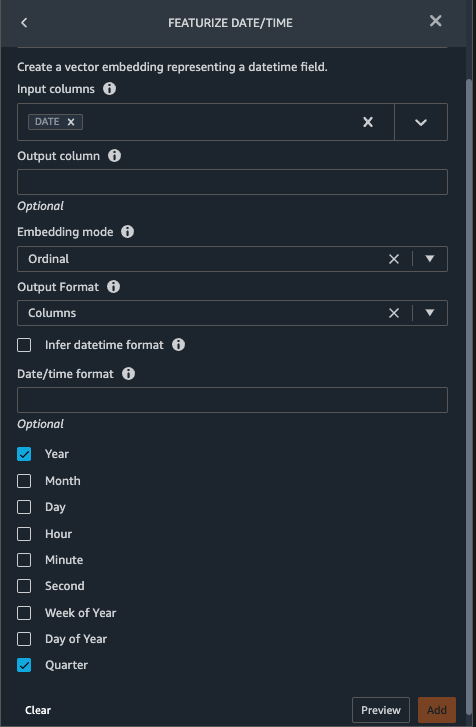

- Adicionar uma transformação para extrair

YeareQuarterdoDATEcoluna.

- Escolha visualização, Em seguida, escolha Adicionar.

- Escolha Adicionar etapa e escolha Transformação personalizada.

- No menu suspenso, escolha Python (PySpark).

Os cinco tipos de observações nem sempre podem ser registrados na mesma data. Por exemplo, um paciente pode visitar seu médico de família em 21 de janeiro e medir e registrar sua pressão arterial sistólica, pressão arterial diastólica, frequência cardíaca e índice de massa corporal. No entanto, um teste laboratorial que inclua plaquetas pode ser feito posteriormente, no dia 2 de fevereiro. Portanto, nem sempre é possível juntar dataframes até a data de observação. Aqui juntamos dataframes em uma granularidade grosseira na base trimestral. - Insira o seguinte código:

- Escolha visualização, Em seguida, escolha Adicionar.

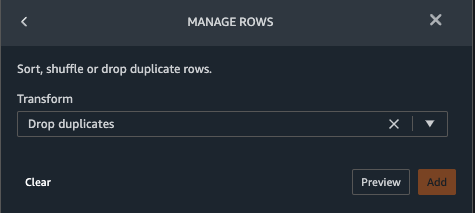

- Escolha Adicionar etapa, Em seguida, escolha Gerenciar linhas.

- Escolha Transformar, escolha Soltar duplicatas.

- Escolha visualização, Em seguida, escolha Adicionar.

- Escolha Adicionar etapa e escolha Transformação personalizada.

- No menu suspenso, escolha Python (pandas).

- Insira o código a seguir para obter uma média de pontos de dados que compartilham o mesmo valor de tempo:

- Escolha visualização, Em seguida, escolha Adicionar.

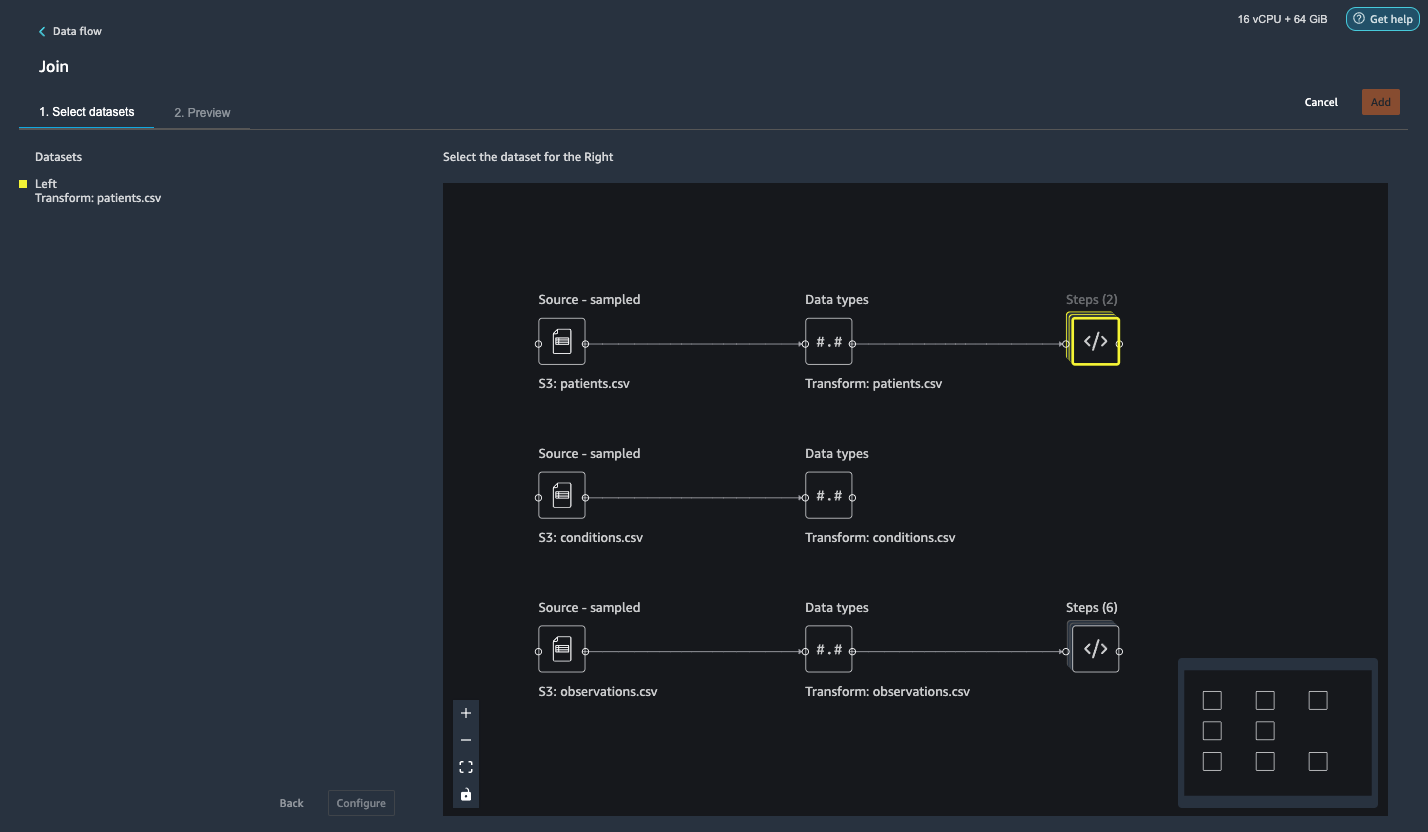

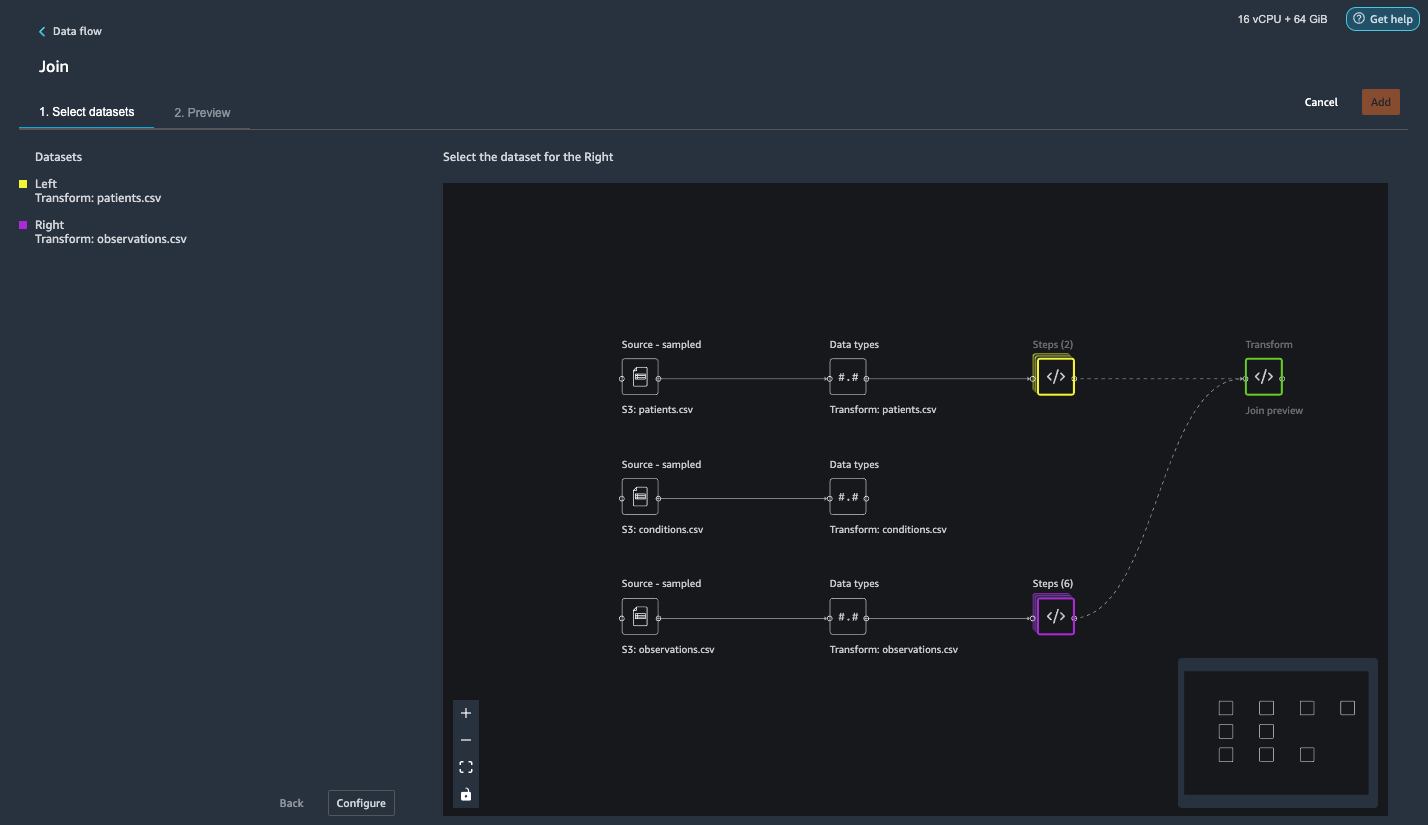

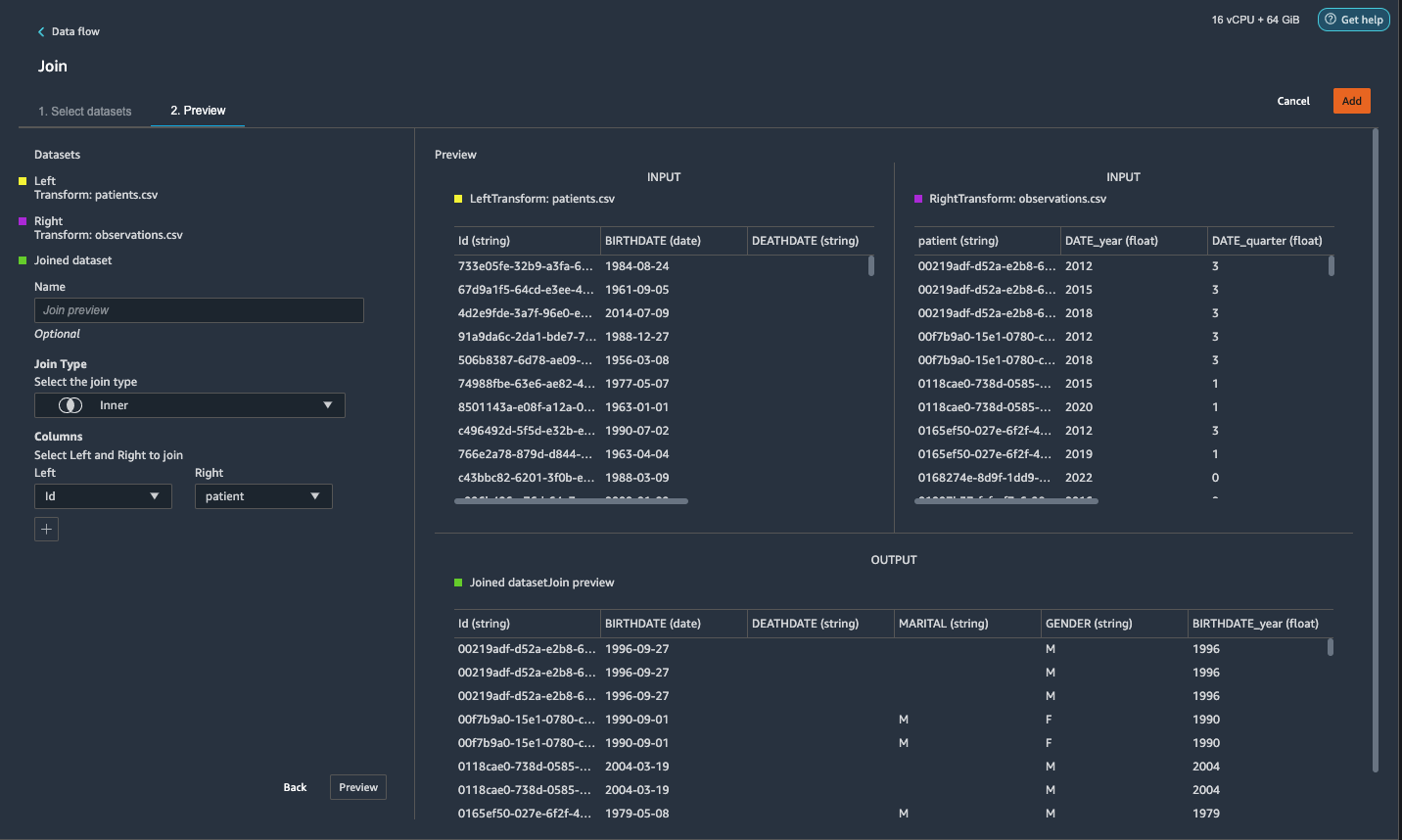

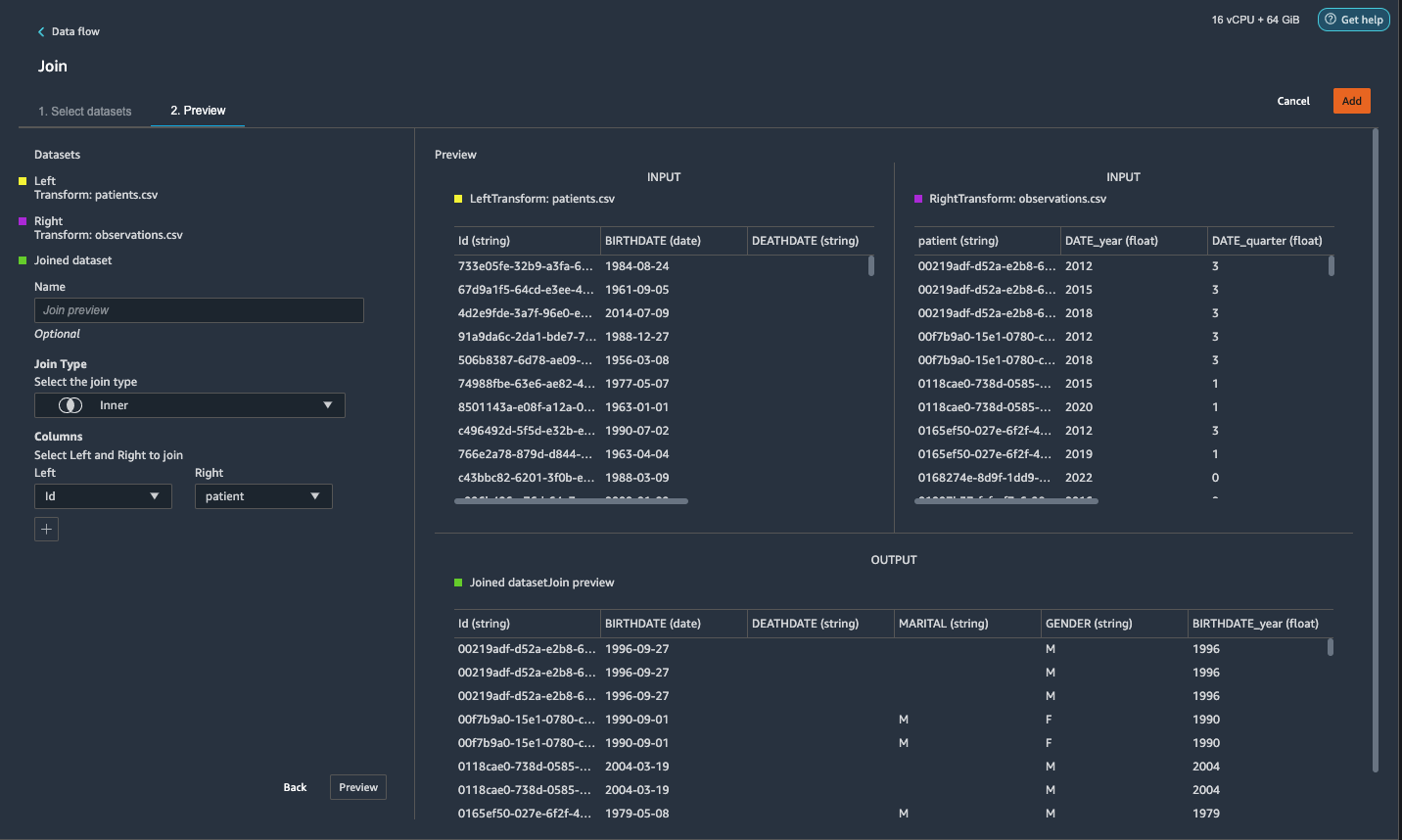

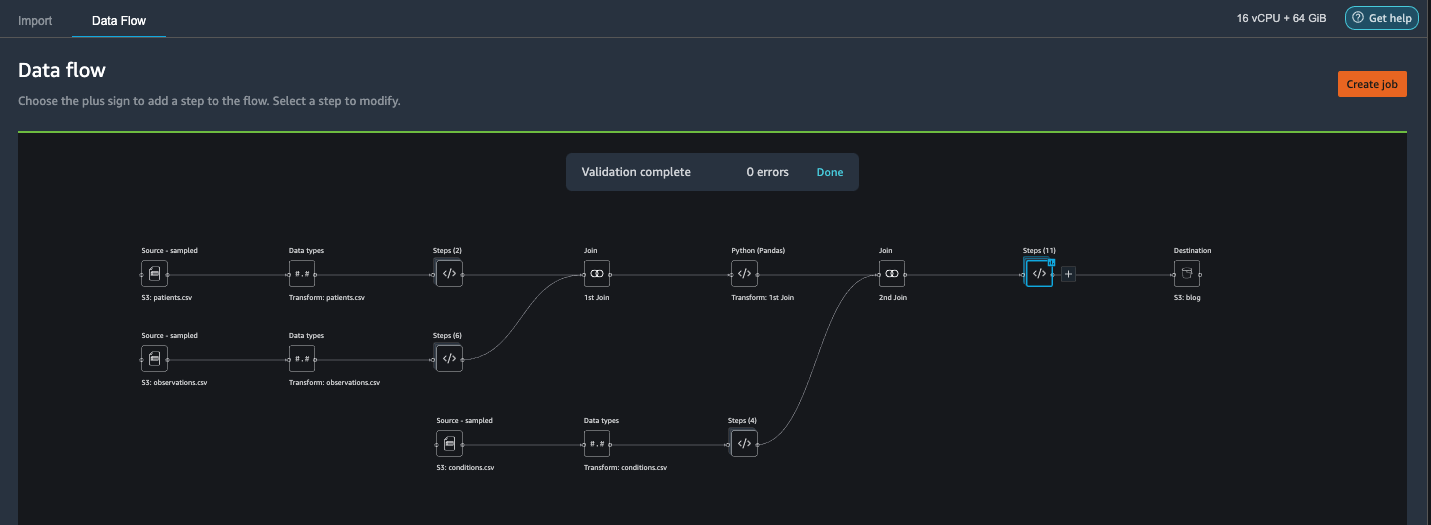

Junte-se a pacientes.csv e observações.csv

Nesta etapa, mostramos como realizar junções complexas em conjuntos de dados de maneira eficaz e fácil sem escrever nenhum código por meio da poderosa interface do usuário do Data Wrangler. Para saber mais sobre os tipos suportados de junções, consulte Transformar dados.

- Para a direita de Transformar: pacientes.csv, escolha o sinal de mais ao lado de Passos e escolha Cadastrar.

Você pode ver o arquivo pacientes.csv transformado listado em Conjuntos de dados no painel esquerdo.

- Para a direita de Transformar: observações.csv, Clique no Passos para iniciar a operação de junção.

O arquivo de observações.csv transformado agora está listado em Conjuntos de dados no painel esquerdo.

- Escolha configurar.

- Escolha Tipo de junção, escolha Interior.

- Escolha Esquerdo, escolha Id.

- Escolha Certo, escolha paciente.

- Escolha visualização, Em seguida, escolha Adicionar.

Adicionar uma transformação personalizada aos conjuntos de dados unidos

Nesta etapa, calculamos a idade do paciente no momento da observação. Também descartamos colunas que não são mais necessárias.

- Escolha o sinal de mais ao lado de 1º Junte-se e escolha Adicionar transformação.

- Adicione uma transformação personalizada no Pandas:

- Escolha visualização, Em seguida, escolha Adicionar.

Adicionar transformações personalizadas a conditions.csv

- Escolha o sinal de mais ao lado de Transformar: condições.csv e escolha Adicionar transformação.

- Adicione uma transformação personalizada no Pandas:

Observação: Como demonstramos anteriormente, você pode descartar colunas usando código personalizado ou usando as transformações internas fornecidas pelo Data Wrangler. As transformações personalizadas no Data Wrangler fornecem a flexibilidade de trazer sua própria lógica de transformação na forma de trechos de código nas estruturas com suporte. Esses snippets podem ser pesquisados e aplicados posteriormente, se necessário.

Os códigos na transformação anterior são códigos SNOMED-CT que correspondem às seguintes condições. o heart failure or chronic congestive heart failure condição torna-se o rótulo. Usamos as condições restantes como recursos para prever insuficiência cardíaca. Também descartamos algumas colunas que não são mais necessárias.

- Em seguida, vamos adicionar uma transformação personalizada no PySpark:

Realizamos uma junção externa esquerda para manter todas as entradas no dataframe de insuficiência cardíaca. Uma nova coluna

has_xxxé calculado para cada condição que não seja insuficiência cardíaca com base na data de início da condição. Estamos interessados apenas em condições médicas que foram registradas antes da insuficiência cardíaca e as usamos como recursos para prever insuficiência cardíaca. - Adicione um integrado Gerenciar colunas transform para descartar as colunas redundantes que não são mais necessárias:

hypertensiondiabetescoronarysmokeatrial

- Extrair

YeareQuarterdoheartfailurecoluna.

Isso corresponde à granularidade que usamos anteriormente na transformação doobservationsconjunto de dados. - Devemos ter um total de 6 etapas para conditions.csv.

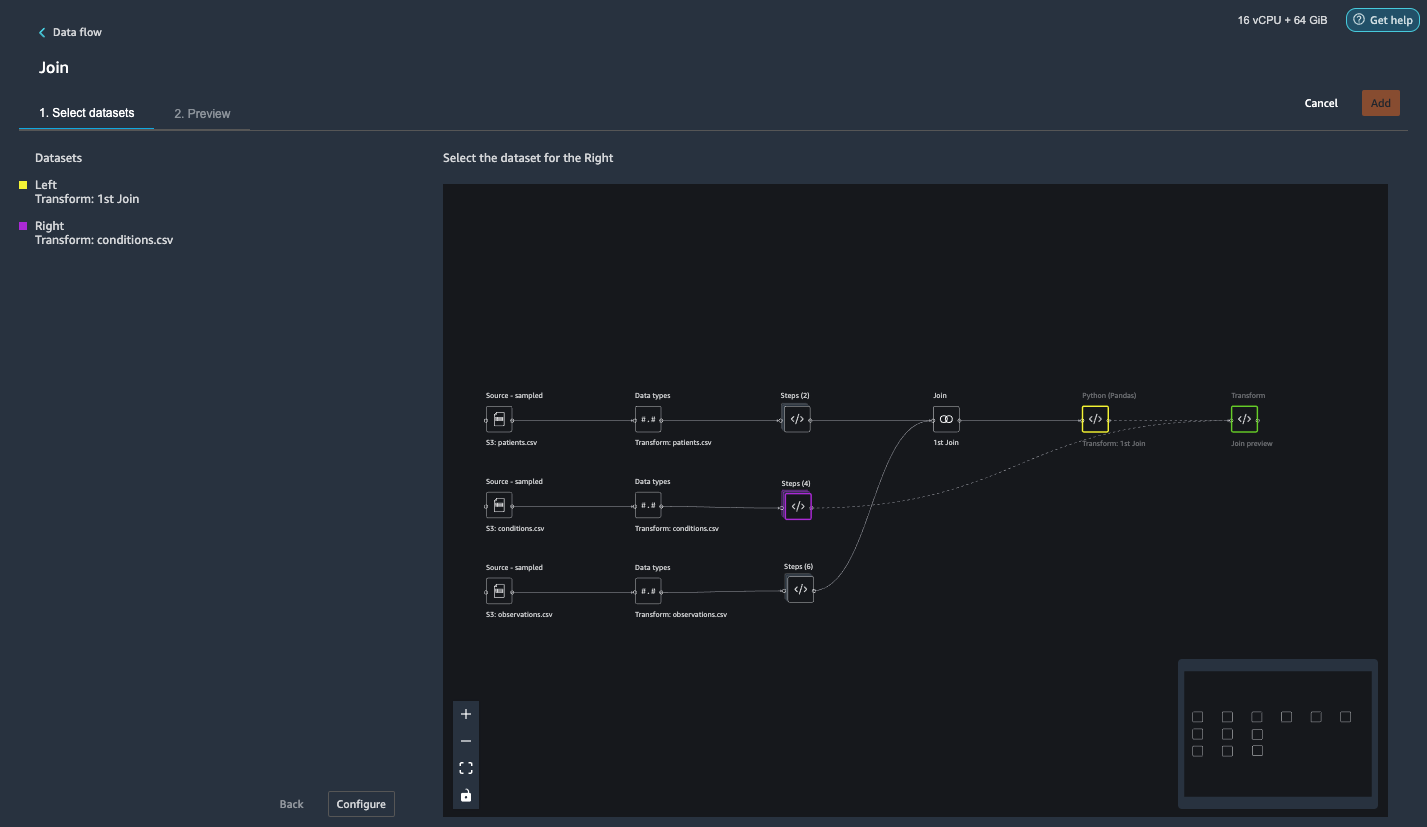

Junte as condições.csv ao conjunto de dados associado

Agora realizamos uma nova junção para unir o conjunto de dados de condições ao conjunto patients e observations conjunto de dados.

- Escolha Transformar: 1º Junte-se.

- Escolha o sinal de mais e escolha Cadastrar.

- Escolha Passos próximo de Transformar: condições.csv.

- Escolha configurar.

- Escolha Tipo de junção, escolha Exterior esquerdo.

- Escolha Esquerdo, escolha Id.

- Escolha Certo, escolha paciente.

- Escolha visualização, Em seguida, escolha Adicionar.

Adicionar transformações aos conjuntos de dados unidos

Agora que temos todos os três conjuntos de dados unidos, vamos aplicar algumas transformações adicionais.

- Adicione a seguinte transformação personalizada no PySpark para

has_heartfailuretorna-se nossa coluna de rótulos: - Adicione a seguinte transformação personalizada no PySpark:

- Elimine as colunas redundantes que não são mais necessárias:

IdDATE_yearDATE_quarterpatientheartfailureheartfailure_yearheartfailure_quarter

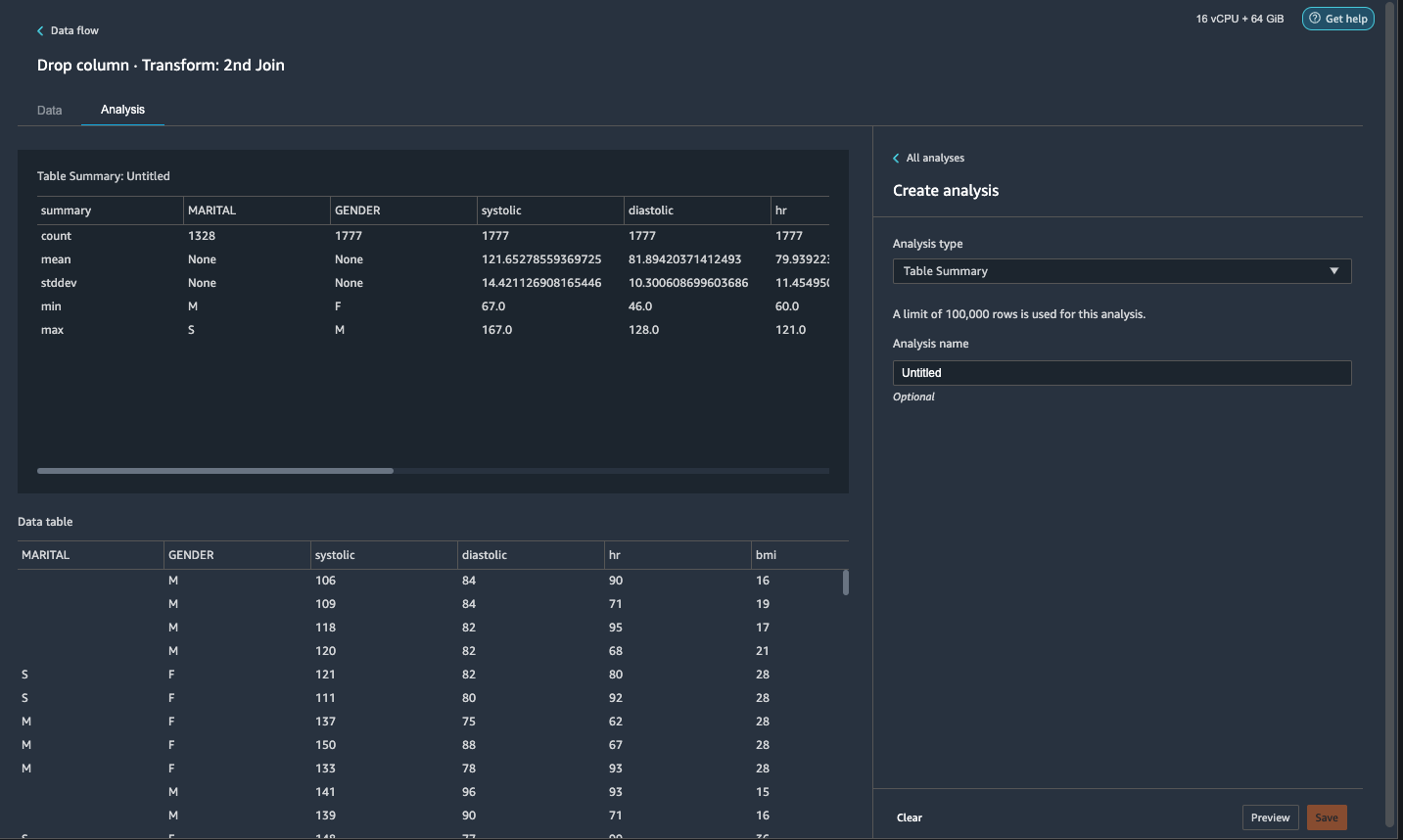

- No Análise guia, para Tipo de análise¸ escolher Resumo da tabela.

Uma varredura rápida através do resumo mostra que oMARITALcoluna tem dados ausentes.

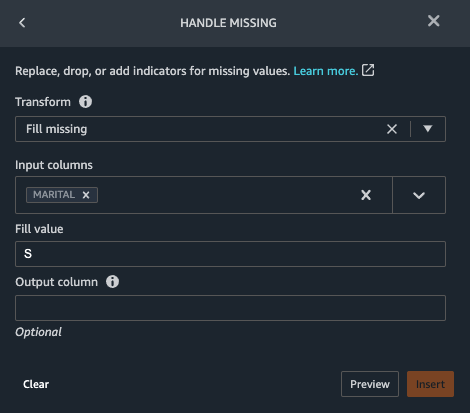

- Escolha o Data guia e adicione uma etapa.

- Escolha Tratamento ausente.

- Escolha Transformar, escolha Preenchimento ausente.

- Escolha Colunas de entrada, escolha CONJUGAL.

- Escolha Valor de preenchimento, entrar

S.

Nossa estratégia aqui é assumir que o paciente é solteiro se o estado civil tem valor omisso. Você pode ter uma estratégia diferente.

- Escolha visualização, Em seguida, escolha Adicionar.

- Preencha o valor ausente como 0 para

has_hypertension,has_diabetes,has_coronary,has_smoke,has_atrial.

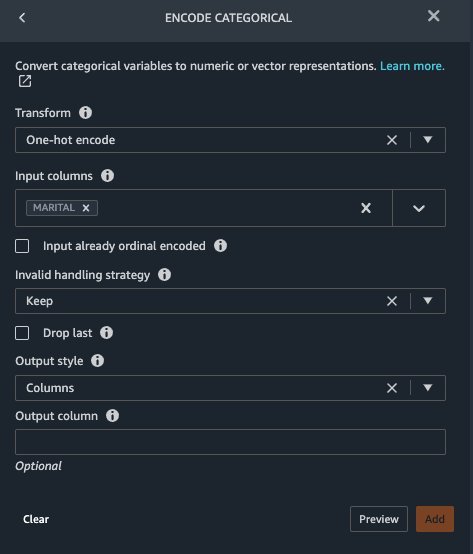

Marital e Gender são variáveis categoriais. O Data Wrangler tem uma função interna para codificar variáveis categoriais.

- Adicione uma etapa e escolha Codificar categorial.

- Escolha Transformar, escolha Codificação one-hot.

- Escolha Colunas de entrada, escolha CONJUGAL.

- Escolha Estilo de saída, escolha Coluna.

Esse estilo de saída produz valores codificados em colunas separadas.

- Escolha visualização, Em seguida, escolha Adicionar.

- Repita essas etapas para o Gênero coluna.

A codificação one-hot divide a coluna Marital em Marital_M (casado) e Marital_S (único) e divide a coluna Gênero em Gender_M (masculino) e Gender_F (fêmea). Porque Marital_M e Marital_S são mutuamente exclusivos (como são Gender_M e Gender_F), podemos descartar uma coluna para evitar recursos redundantes.

- Cair

Marital_SeGender_F.

Características numéricas como sistólica, frequência cardíaca e idade têm padrões de unidade diferentes. Para um modelo baseado em regressão linear, precisamos normalizar esses recursos numéricos primeiro. Caso contrário, alguns recursos com valores absolutos mais altos podem ter uma vantagem injustificada sobre outros recursos com valores absolutos mais baixos e resultar em desempenho insatisfatório do modelo. O Data Wrangler possui o escalonador de transformação Min-max integrado para normalizar os dados. Para um modelo de classificação baseado em árvore de decisão, a normalização não é necessária. Nosso estudo é um problema de classificação, então não precisamos aplicar normalização. Classes desequilibradas são um problema comum na classificação. O desequilíbrio ocorre quando o conjunto de dados de treinamento contém uma distribuição de classes severamente distorcida. Por exemplo, quando nosso conjunto de dados contém desproporcionalmente mais pacientes sem insuficiência cardíaca do que pacientes com insuficiência cardíaca, isso pode fazer com que o modelo seja tendencioso para prever nenhuma insuficiência cardíaca e ter um desempenho ruim. O Data Wrangler tem uma função integrada para resolver o problema.

- Adicione uma transformação personalizada no Pandas para converter o tipo de dados das colunas do tipo “objeto” para o tipo numérico:

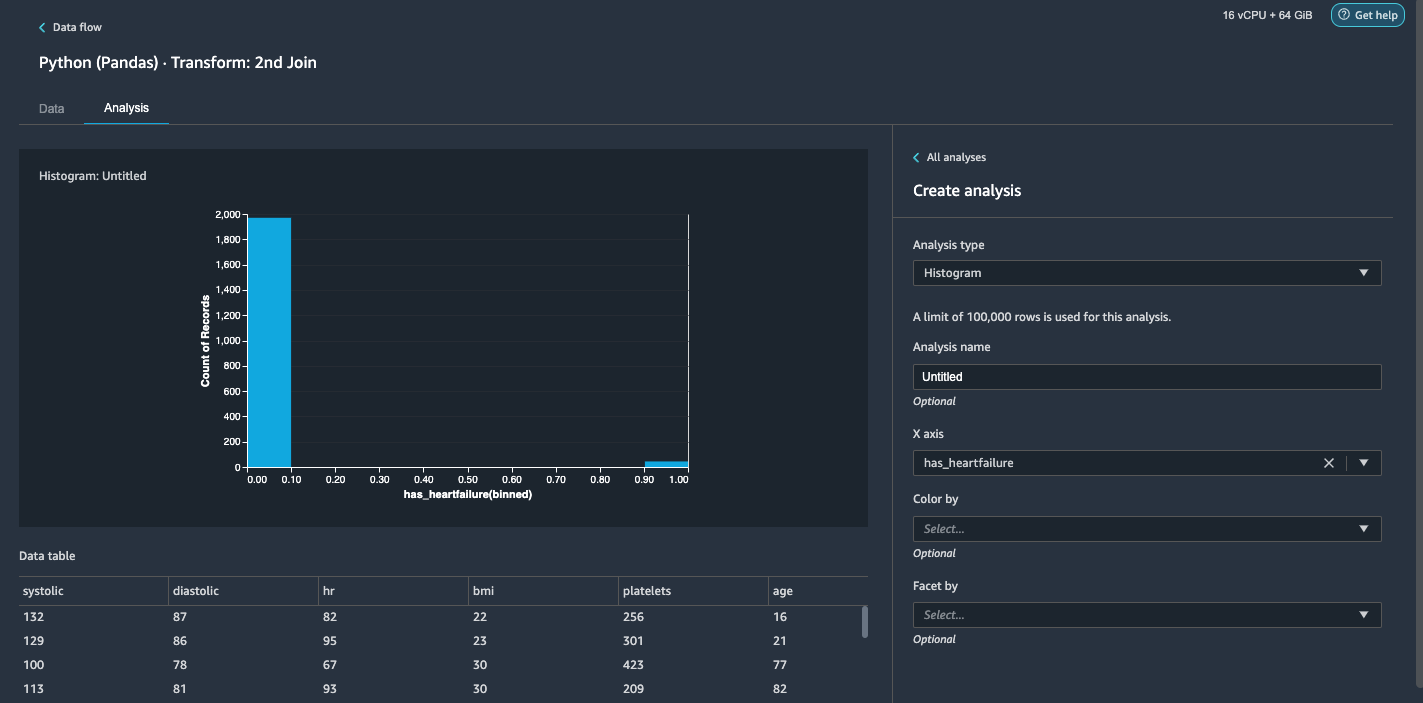

- Escolha o Análise aba.

- Escolha Tipo de análise¸ escolher Histograma.

- Escolha eixo X, escolha has_heartfailure.

- Escolha visualização.

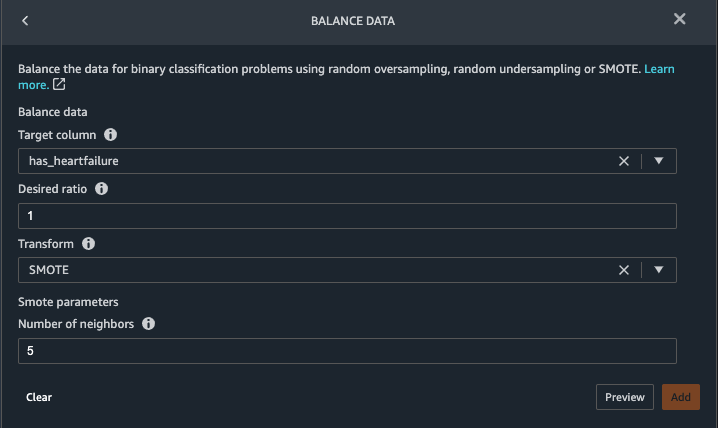

É óbvio que temos uma classe desequilibrada (mais pontos de dados rotulados como sem insuficiência cardíaca do que pontos de dados rotulados como insuficiência cardíaca). - Volte para a Data aba. Escolher Adicionar etapa e escolha Dados de saldo.

- Escolha Coluna de destino, escolha has_heartfailure.

- Escolha Proporção desejada, entrar

1. - Escolha Transformar, escolha FERIR.

SMOTE significa Synthetic Minority Over-sampling Technique. É uma técnica para criar novas instâncias minoritárias e adicionar ao conjunto de dados para alcançar o equilíbrio de classes. Para obter informações detalhadas, consulte SMOTE: Técnica de sobreamostragem de minoria sintética. - Escolha visualização, Em seguida, escolha Adicionar.

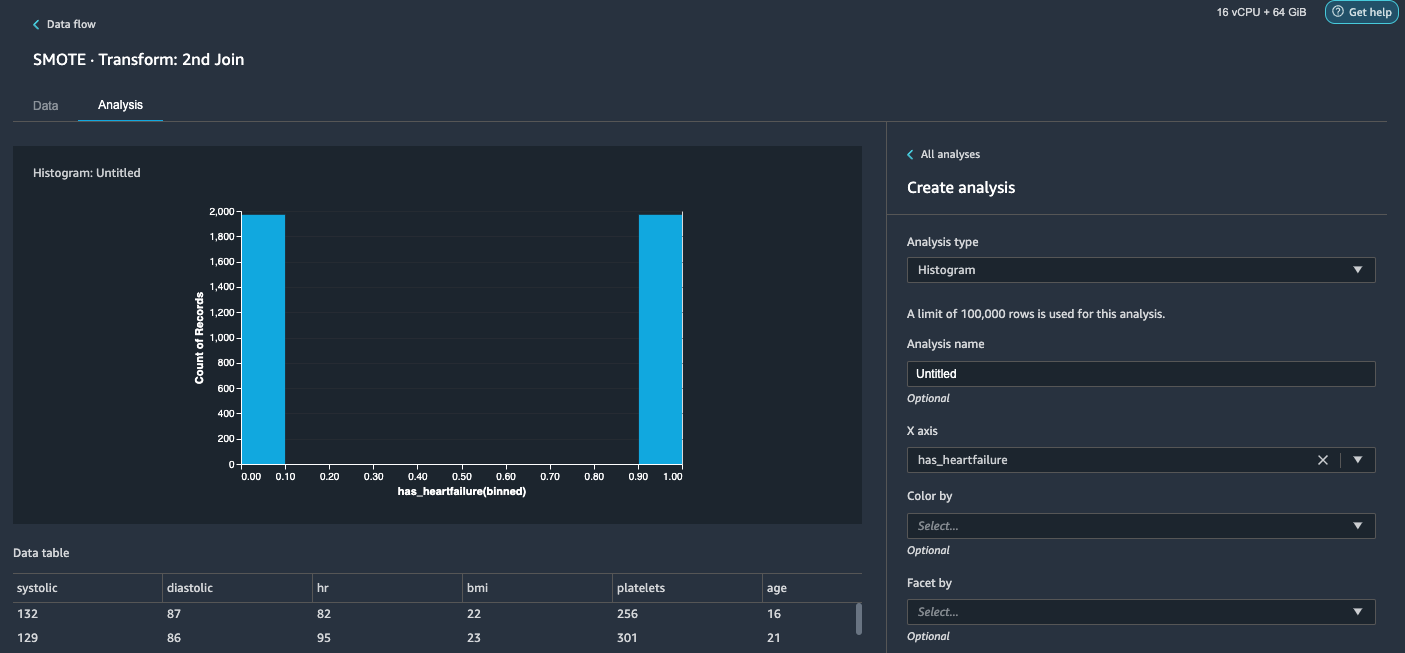

- Repita a análise do histograma na etapa 20-23. O resultado é uma aula equilibrada.

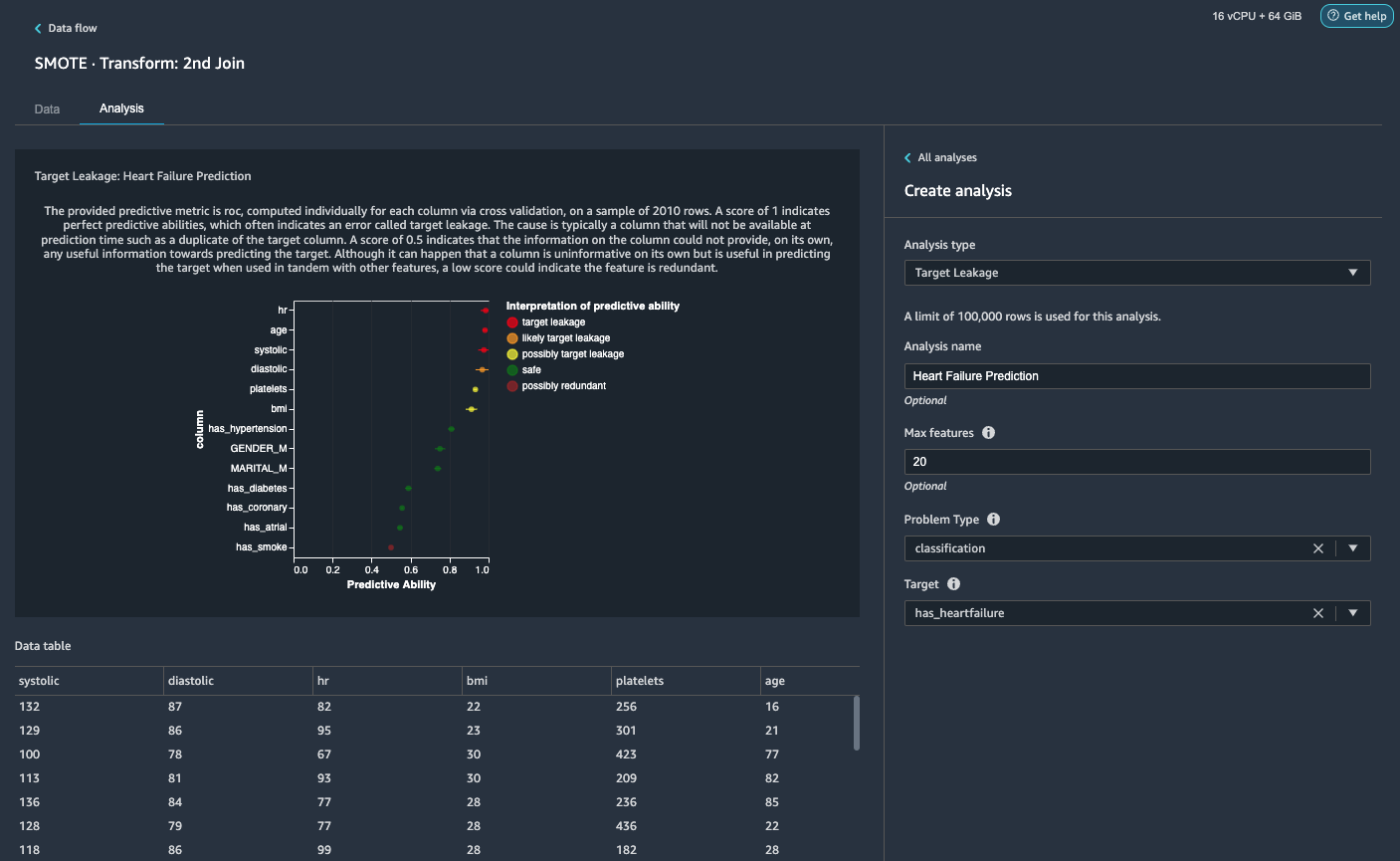

Visualize o vazamento de destino e a correlação de recursos

Em seguida, vamos realizar algumas análises visuais usando o rico conjunto de ferramentas do Data Wrangler de tipos avançados de análise com suporte de ML. Primeiro, analisamos o vazamento de destino. O vazamento de destino ocorre quando os dados no conjunto de dados de treinamento estão fortemente correlacionados com o rótulo de destino, mas não estão disponíveis em dados do mundo real no momento da inferência.

- No Aba de análise, Por Tipo de análise¸ escolher Vazamento de Alvo.

- Escolha Tipo de Problema, escolha classificação.

- Escolha Target, escolha has_heartfailure.

- Escolha visualização.

Com base na análise,hré um vazamento alvo. Vamos soltá-lo em uma etapa subsequente.ageé sinalizado um vazamento de destino. É razoável dizer que a idade de um paciente estará disponível durante o tempo de inferência, portanto, mantemos a idade como um recurso.Systolicediastolictambém são sinalizados como vazamento alvo provável. Esperamos ter as duas medições durante o tempo de inferência, então as mantemos como recursos. - Escolha Adicionar para adicionar a análise.

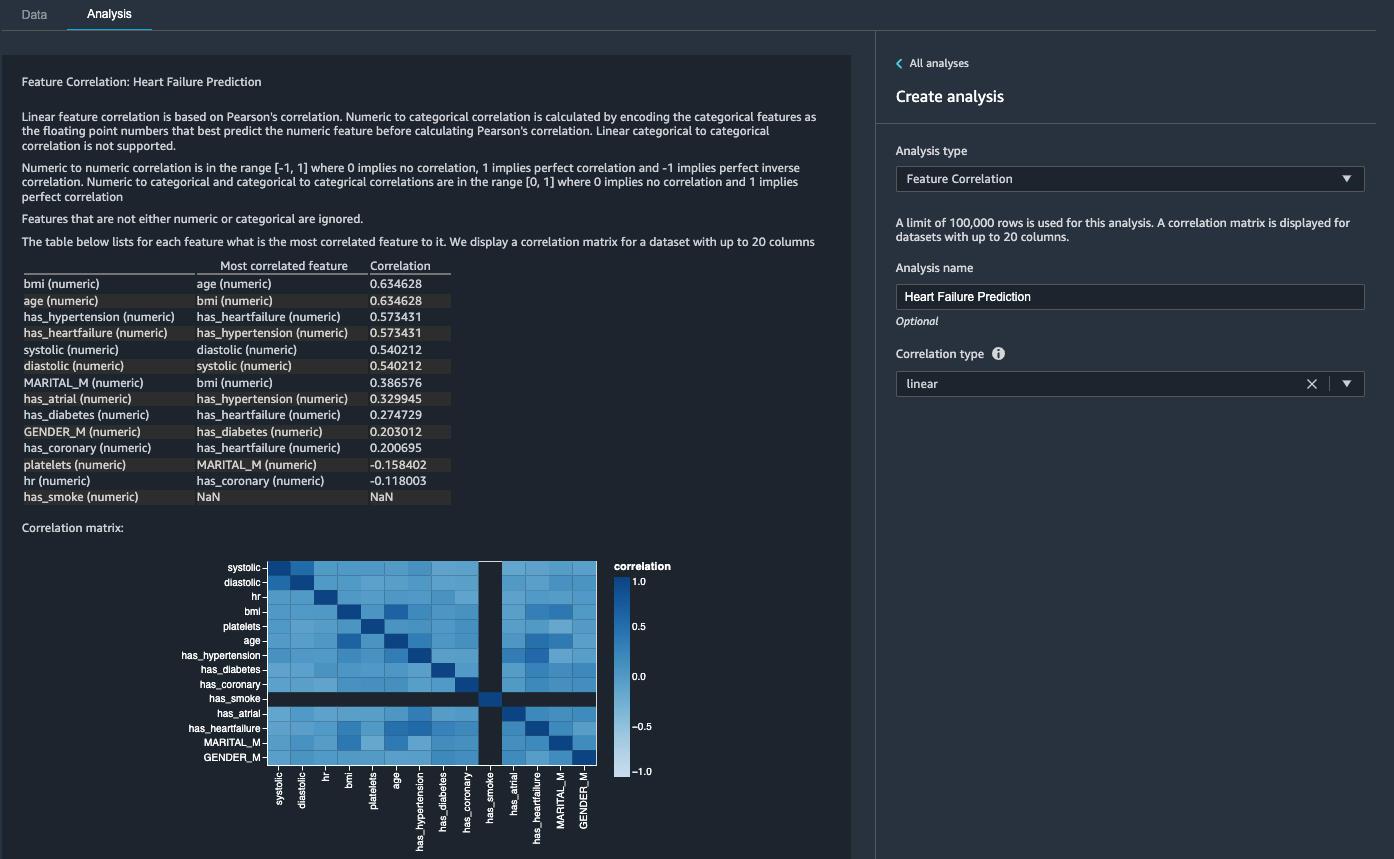

Em seguida, analisamos a correlação de recursos. Queremos selecionar recursos correlacionados com o destino, mas não correlacionados entre si.

- No Aba de análise, Por Tipo de análise¸ escolher Correlação de recursos.

- Escolha Tipo de correlação¸ escolher linear.

- Escolha visualização.

As pontuações dos coeficientes indicam fortes correlações entre os seguintes pares:

systolicediastolicbmieagehas_hypertensionehas_heartfailure(etiqueta)

Para características que são fortemente correlacionadas, as matrizes são computacionalmente difíceis de inverter, o que pode levar a estimativas numericamente instáveis. Para mitigar a correlação, podemos simplesmente remover um do par. Nós largamos diastolic e bmi e manter systolic e age em uma etapa subsequente.

Solte colunas diastólicas e IMC

Adicione etapas de transformação adicionais para descartar o hr, diastolic e bmi colunas usando a transformação interna.

Gerar o Relatório de insights e qualidade de dados

AWS recentemente anunciou o novo recurso Data Quality and Insights Report no Data Wrangler. Este relatório verifica automaticamente a qualidade dos dados e detecta anormalidades em seus dados. Os cientistas de dados e engenheiros de dados podem usar essa ferramenta para aplicar com eficiência e rapidez o conhecimento do domínio para processar conjuntos de dados para treinamento de modelos de ML. Esta etapa é opcional. Para gerar este relatório em nossos conjuntos de dados, conclua as etapas a seguir:

- No Análise guia, para Tipo de análise, escolha Relatório de insights e qualidade de dados.

- Escolha Coluna de destino, escolha has_heartfailure.

- Escolha Tipo de problema, selecione Classificação.

- Escolha Crie.

Em poucos minutos, ele gera um relatório com resumo, recursos visuais e recomendações.

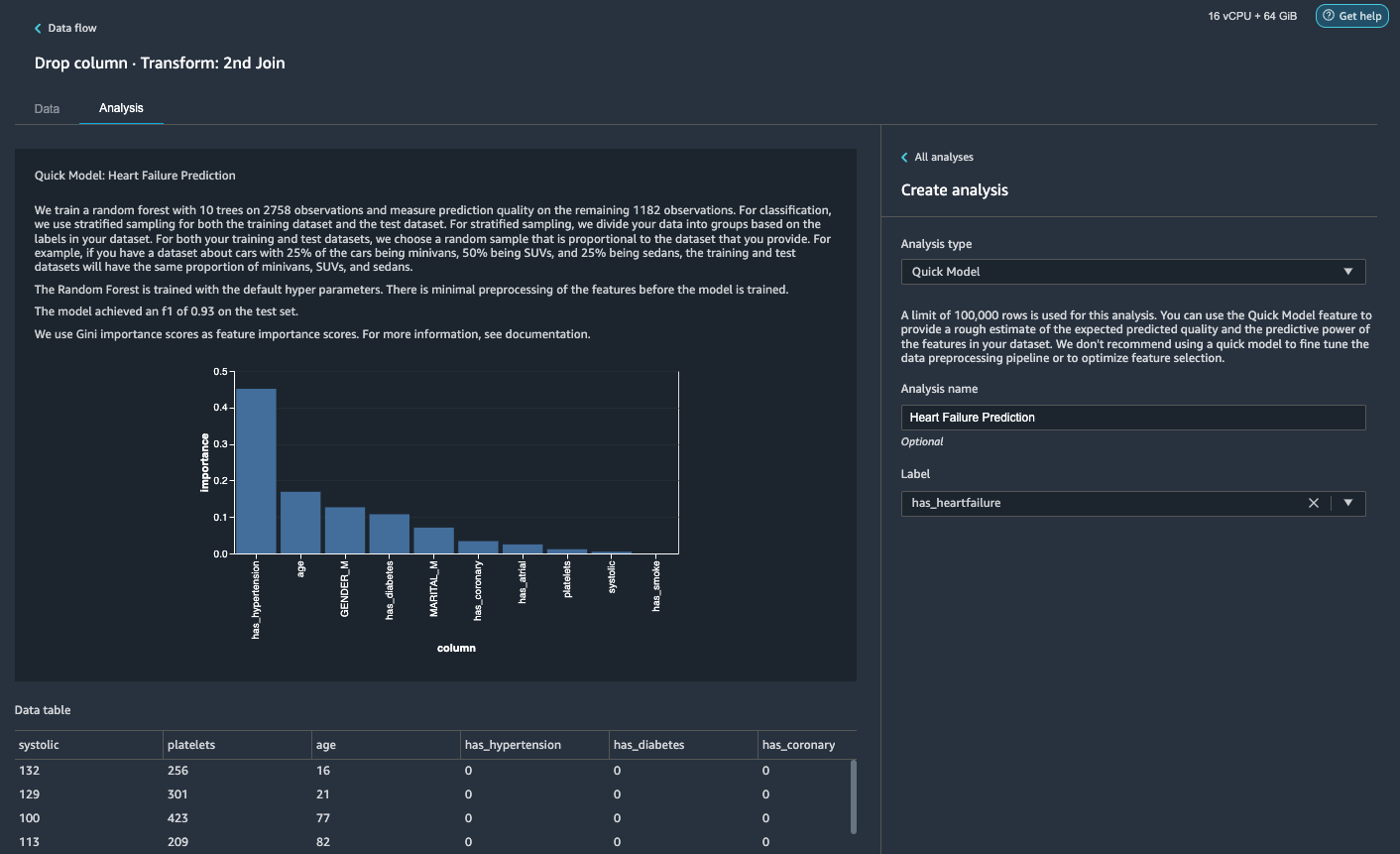

Gerar uma análise de modelo rápido

Concluímos nossa preparação de dados, limpeza e engenharia de recursos. O Data Wrangler tem uma função integrada que fornece uma estimativa aproximada da qualidade prevista esperada e o poder preditivo dos recursos em nosso conjunto de dados.

- No Análise guia, para Tipo de análise¸ escolher Modelo Rápido.

- Escolha O rótulo, escolha has_heartfailure.

- Escolha visualização.

De acordo com nossa análise do modelo rápido, podemos ver o recurso has_hypertension tem a pontuação de importância de recurso mais alta entre todos os recursos.

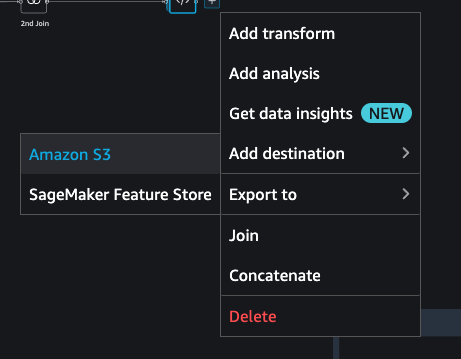

Exporte os dados e treine o modelo

Agora vamos exportar os recursos prontos para ML transformados para um bucket do S3 de destino e dimensionar todo o pipeline de engenharia de recursos que criamos até agora usando as amostras em todo o conjunto de dados de maneira distribuída.

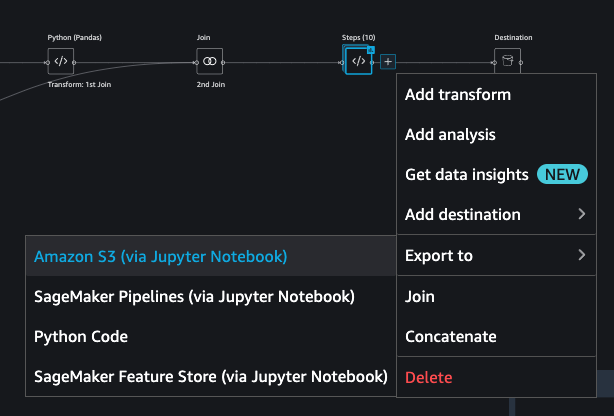

- Escolha o sinal de mais ao lado da última caixa no fluxo de dados e escolha Adicionar destino.

- Escolha Amazon S3.

- Digite um Nome do conjunto de dados. Para Localização do Amazon S3, escolha um bucket do S3 e escolha Adicionar destino.

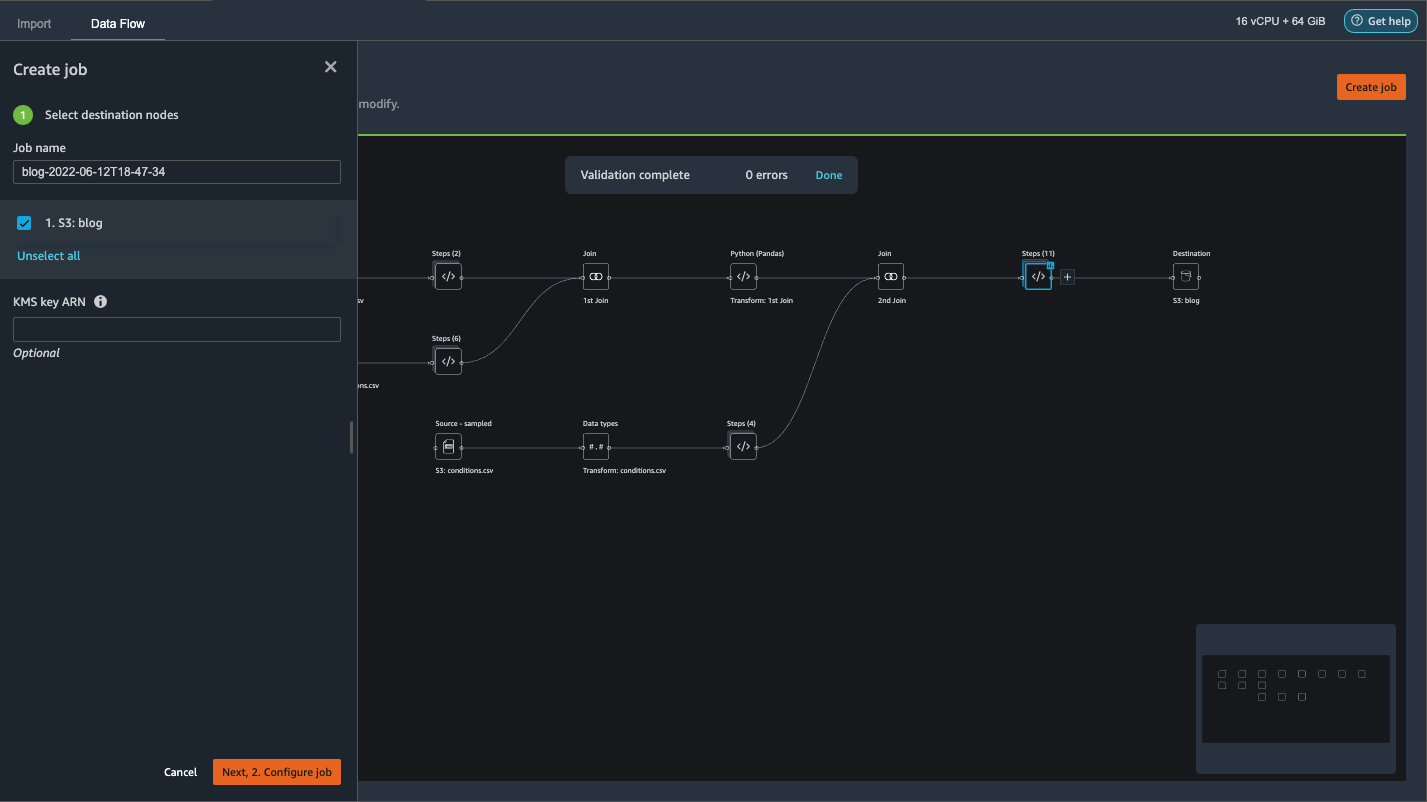

- Escolha Criar emprego para iniciar um trabalho de processamento distribuído do PySpark para realizar a transformação e enviar os dados para o bucket do S3 de destino.

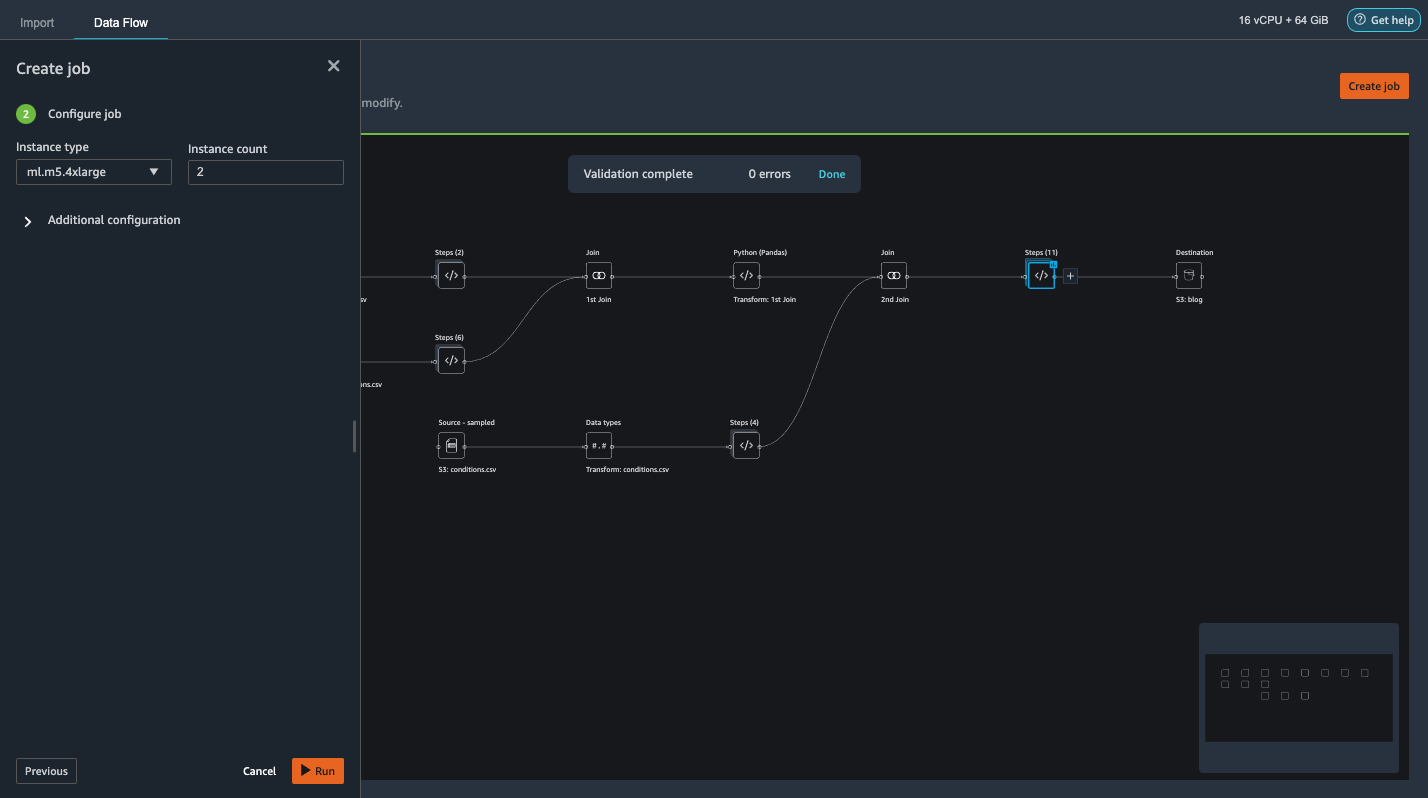

Dependendo do tamanho dos conjuntos de dados, essa opção nos permite configurar facilmente o cluster e dimensionar horizontalmente sem código. Não precisamos nos preocupar em particionar os conjuntos de dados ou gerenciar o cluster e os internos do Spark. Tudo isso é automaticamente cuidado por nós pelo Data Wrangler. - No painel esquerdo, escolha Em seguida, 2. Configure o trabalho.

- Então escolha Execute.

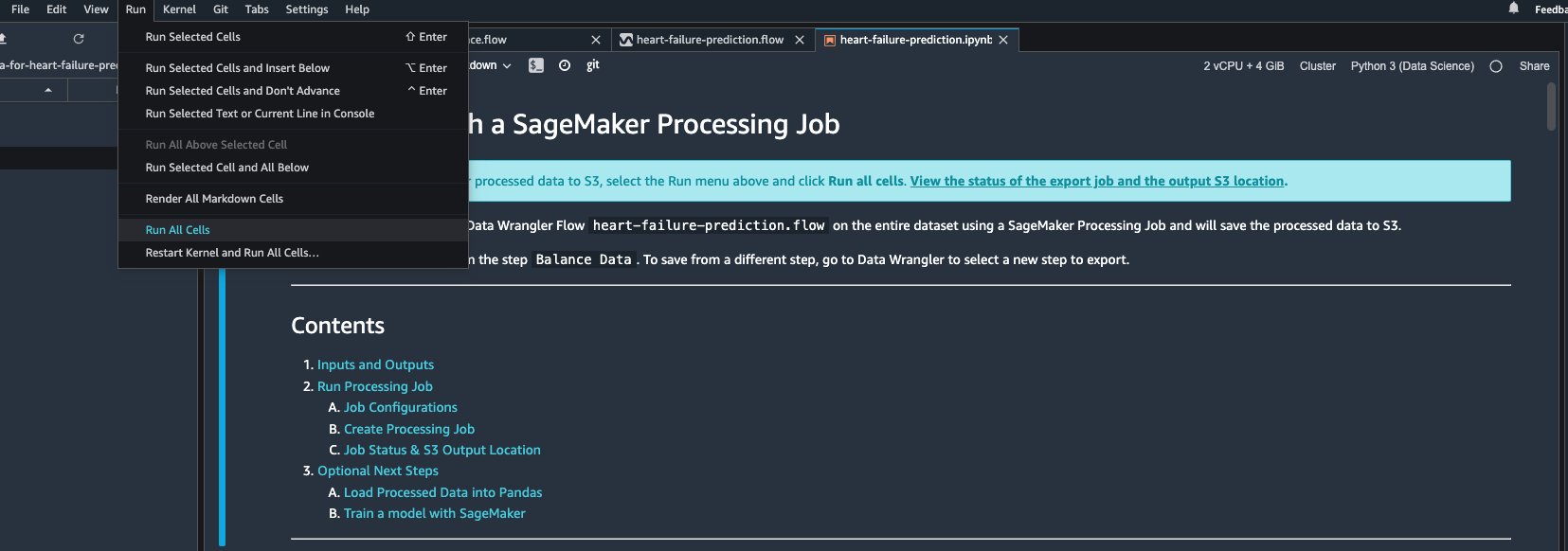

Como alternativa, também podemos exportar a saída transformada para o S3 por meio de um Jupyter Notebook. Com essa abordagem, o Data Wrangler gera automaticamente um notebook Jupyter com todo o código necessário para iniciar um trabalho de processamento para aplicar as etapas de fluxo de dados (criadas usando uma amostra) no conjunto de dados completo maior e usar o conjunto de dados transformado como recursos para kick- fora de um trabalho de treinamento mais tarde. O código do notebook pode ser executado prontamente com ou sem alterações. Vamos agora percorrer as etapas sobre como fazer isso por meio da interface do usuário do Data Wrangler.

- Escolha o sinal de mais ao lado da última etapa no fluxo de dados e escolha Exportar para.

- Escolha Amazon S3 (via Jupyter Notebook).

- Ele abre automaticamente uma nova guia com um notebook Jupyter.

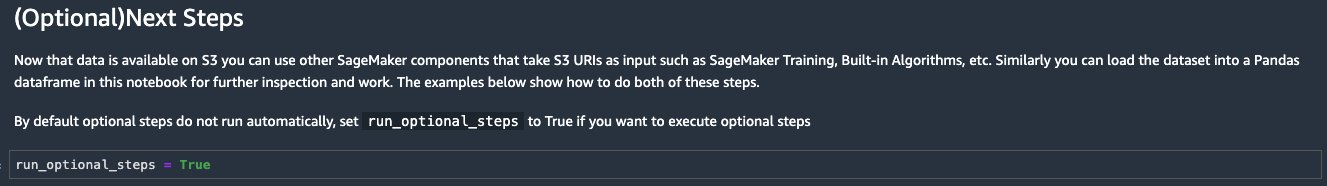

- No notebook Jupyter, localize a célula na (Opcional) Próximas etapas seção e mudança

run_optional_stepsdaFalseparaTrue.

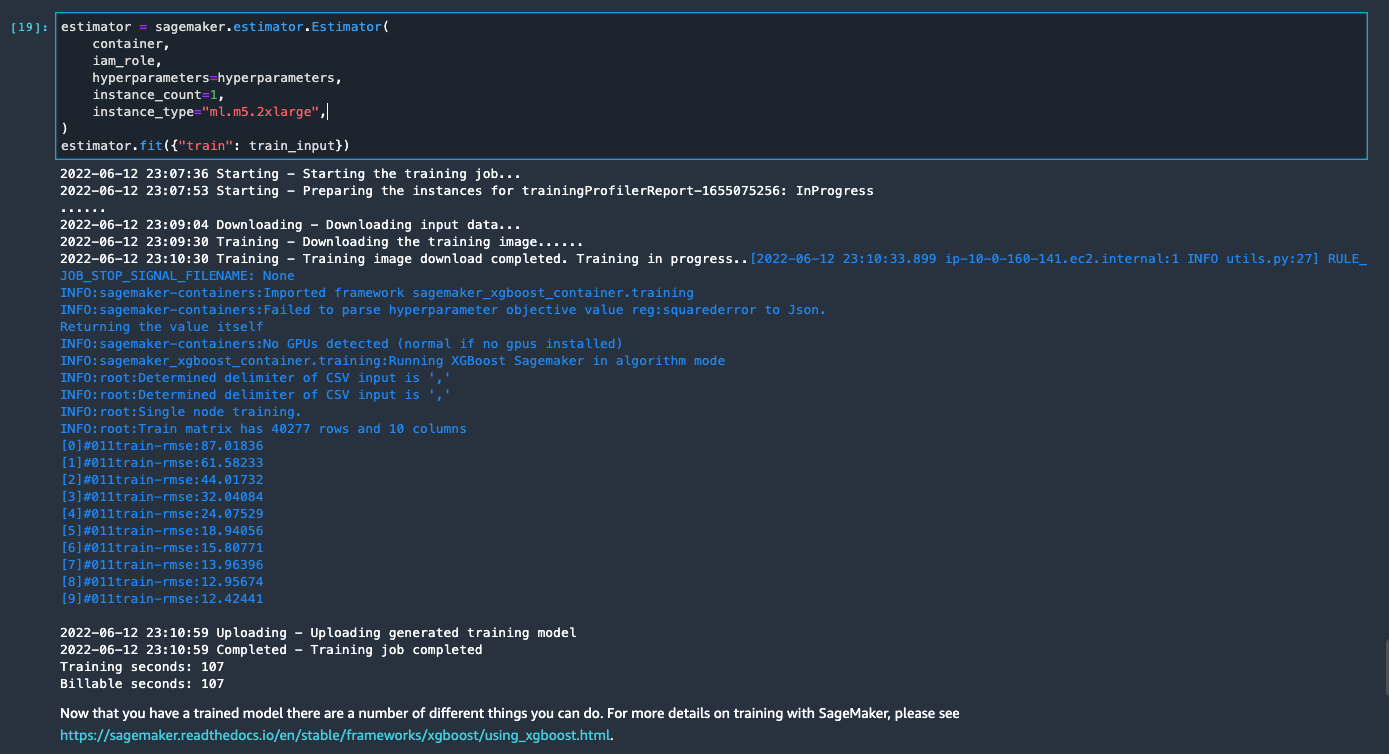

As etapas opcionais habilitadas no notebook realizam o seguinte: - Volte para o topo do notebook e no Execute menu, escolha Executar todas as células.

Se você usar o notebook gerado como está, ele iniciará um trabalho de processamento do SageMaker que dimensiona o processamento em duas instâncias m5.4xlarge para processar o conjunto de dados completo no bucket do S3. Você pode ajustar o número de instâncias e tipos de instância com base no tamanho do conjunto de dados e no tempo necessário para concluir o trabalho.

Aguarde até que o trabalho de treinamento da última célula seja concluído. Ele gera um modelo no bucket S3 padrão do SageMaker.

O modelo treinado está pronto para implantação para inferência em tempo real ou transformação em lote. Observe que usamos dados sintéticos para demonstrar funcionalidades no Data Wrangler e usamos dados processados para o modelo de treinamento. Dado que os dados que usamos são sintéticos, o resultado de inferência do modelo treinado não se destina ao diagnóstico de condições médicas do mundo real ou à substituição do julgamento dos médicos.

Você também pode exportar diretamente seu conjunto de dados transformado para o Amazon S3 escolhendo Exportações na parte superior da página de visualização de transformação. A opção de exportação direta só exporta a amostra transformada se a amostragem estiver habilitada durante a importação. Essa opção é mais adequada se você estiver lidando com conjuntos de dados menores. Os dados transformados também podem ser ingeridos diretamente em um repositório de recursos. Para obter mais informações, consulte Loja de recursos Amazon SageMaker. O fluxo de dados também pode ser exportado como um pipeline do SageMaker que pode ser orquestrado e agendado de acordo com suas necessidades. Para mais informações, veja Pipelines Amazon SageMaker.

Conclusão

Neste post, mostramos como usar o Data Wrangler para processar dados de saúde e executar engenharia de recursos escaláveis de uma forma de baixo código e orientada por ferramentas. Aprendemos como aplicar as transformações e análises integradas de forma adequada sempre que necessário, combinando-as com transformações personalizadas para adicionar ainda mais flexibilidade ao nosso fluxo de trabalho de preparação de dados. Também analisamos as diferentes opções para dimensionar a receita de fluxo de dados por meio de trabalhos de processamento distribuído. Também aprendemos como os dados transformados podem ser facilmente usados para treinar um modelo para prever insuficiência cardíaca.

Existem muitos outros recursos no Data Wrangler que não abordamos neste post. Explore o que é possível em Prepare dados de ML com o Amazon SageMaker Data Wrangler e saiba como aproveitar o Data Wrangler para seu próximo projeto de ciência de dados ou aprendizado de máquina.

Sobre os autores

Sol da Floresta é arquiteto de soluções sênior da equipe do setor público da AWS em Toronto, Canadá. Ele trabalhou nos setores de saúde e finanças nas últimas duas décadas. Fora do trabalho, ele gosta de acampar com a família.

Sol da Floresta é arquiteto de soluções sênior da equipe do setor público da AWS em Toronto, Canadá. Ele trabalhou nos setores de saúde e finanças nas últimas duas décadas. Fora do trabalho, ele gosta de acampar com a família.

Arunprasath Shankar é arquiteto de soluções especialista em inteligência artificial e aprendizado de máquina (AI / ML) da AWS, ajudando clientes globais a dimensionar suas soluções de IA de maneira eficaz e eficiente na nuvem. Em seu tempo livre, Arun gosta de assistir filmes de ficção científica e ouvir música clássica.

Arunprasath Shankar é arquiteto de soluções especialista em inteligência artificial e aprendizado de máquina (AI / ML) da AWS, ajudando clientes globais a dimensionar suas soluções de IA de maneira eficaz e eficiente na nuvem. Em seu tempo livre, Arun gosta de assistir filmes de ficção científica e ouvir música clássica.

- AI

- arte ai

- gerador de arte ai

- ai robô

- Amazon Sage Maker

- Gerenciador de dados do Amazon SageMaker

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- Aprendizado de máquina da AWS

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- zefirnet