O aumento das atividades sociais on-line, como redes sociais ou jogos on-line, geralmente está repleto de comportamentos hostis ou agressivos que podem levar a manifestações não solicitadas de discurso de ódio, cyberbullying ou assédio. Por exemplo, muitas comunidades de jogos online oferecem funcionalidade de bate-papo por voz para facilitar a comunicação entre seus usuários. Embora o bate-papo por voz geralmente ofereça suporte a brincadeiras amigáveis e conversa fiada, ele também pode levar a problemas como discurso de ódio, cyberbullying, assédio e golpes. A sinalização de linguagem prejudicial ajuda as organizações a manter as conversas civilizadas e a manter um ambiente on-line seguro e inclusivo para os usuários criarem, compartilharem e participarem livremente. Hoje, muitas empresas contam apenas com moderadores humanos para revisar conteúdo tóxico. No entanto, dimensionar moderadores humanos para atender a essas necessidades com qualidade e velocidade suficientes é caro. Como resultado, muitas organizações correm o risco de enfrentar altas taxas de perda de usuários, danos à reputação e multas regulatórias. Além disso, os moderadores são frequentemente afetados psicologicamente ao revisar o conteúdo tóxico.

Amazon Transcribe é um serviço de reconhecimento automático de fala (ASR) que torna mais fácil para os desenvolvedores adicionar capacidade de conversão de fala em texto a seus aplicativos. Hoje, temos o prazer de anunciar Detecção de Toxicidade do Amazon Transcribe, um recurso baseado em aprendizado de máquina (ML) que usa dicas baseadas em áudio e texto para identificar e classificar conteúdo tóxico baseado em voz em sete categorias, incluindo assédio sexual, discurso de ódio, ameaças, abuso, palavrões, insultos e linguagem gráfica . Além do texto, a detecção de toxicidade usa dicas de fala, como tons e tom, para aprimorar a intenção tóxica na fala.

Esta é uma melhoria dos sistemas de moderação de conteúdo padrão que são projetados para se concentrar apenas em termos específicos, sem levar em conta a intenção. A maioria das empresas tem um SLA de 7 a 15 dias para revisar o conteúdo relatado pelos usuários porque os moderadores devem ouvir arquivos de áudio longos para avaliar se e quando a conversa se tornou tóxica. Com o Amazon Transcribe Toxicity Detection, os moderadores revisam apenas a parte específica do arquivo de áudio sinalizado para conteúdo tóxico (em vez de todo o arquivo de áudio). O conteúdo que os moderadores humanos devem revisar é reduzido em 95%, permitindo que os clientes reduzam seu SLA para apenas algumas horas, bem como moderem proativamente mais conteúdo além do que é sinalizado pelos usuários. Ele permitirá que as empresas detectem e moderem automaticamente o conteúdo em escala, forneçam um ambiente on-line seguro e inclusivo e tomem medidas antes que possam causar rotatividade de usuários ou danos à reputação. Os modelos usados para detecção de conteúdo tóxico são mantidos pelo Amazon Transcribe e atualizados periodicamente para manter a precisão e a relevância.

Neste post, você aprenderá como:

- Identifique conteúdo nocivo na fala com o Amazon Transcribe Toxicity Detection

- Use o console do Amazon Transcribe para detecção de toxicidade

- Crie um trabalho de transcrição com detecção de toxicidade usando o Interface de linha de comando da AWS (AWS CLI) e Python SDK

- Use a resposta da API de detecção de toxicidade do Amazon Transcribe

Detecte toxicidade em bate-papo por áudio com o Amazon Transcribe Toxicity Detection

O Amazon Transcribe agora oferece uma solução simples baseada em ML para sinalizar linguagem prejudicial em conversas faladas. Esse recurso é especialmente útil para mídias sociais, jogos e necessidades gerais, eliminando a necessidade de os clientes fornecerem seus próprios dados para treinar o modelo de ML. A detecção de toxicidade classifica o conteúdo de áudio tóxico nas sete categorias a seguir e fornece uma pontuação de confiança (0–1) para cada categoria:

- Profanidade – Discurso que contenha palavras, frases ou acrônimos indelicados, vulgares ou ofensivos.

- Incitação ao ódio – Discurso que critique, insulte, denuncie ou desumanize uma pessoa ou grupo com base em uma identidade (como raça, etnia, gênero, religião, orientação sexual, habilidade e origem nacional).

- Sexual – Discurso que indica interesse sexual, atividade ou excitação usando referências diretas ou indiretas a partes do corpo, traços físicos ou sexo.

- Insultos – Discurso que inclua linguagem depreciativa, humilhante, zombeteira, ofensiva ou depreciativa. Esse tipo de linguagem também é rotulado como bullying.

- Violência ou ameaça – Discurso que inclui ameaças com o objetivo de infligir dor, injúria ou hostilidade em relação a uma pessoa ou grupo.

- Designer – Fala que usa imagens visualmente descritivas e imagens desagradavelmente vívidas. Esse tipo de linguagem costuma ser propositalmente prolixo para amplificar o desconforto do destinatário.

- Assédio ou abusivo – Discurso destinado a afetar o bem-estar psicológico do destinatário, incluindo termos humilhantes e objetificantes.

Você pode acessar o Toxicity Detection por meio do console do Amazon Transcribe ou chamando as APIs diretamente usando a AWS CLI ou os AWS SDKs. No console do Amazon Transcribe, você pode fazer upload dos arquivos de áudio que deseja testar quanto à toxicidade e obter resultados com apenas alguns cliques. O Amazon Transcribe identificará e categorizará conteúdo tóxico, como assédio, discurso de ódio, conteúdo sexual, violência, insultos e palavrões. O Amazon Transcribe também fornece uma pontuação de confiança para cada categoria, fornecendo insights valiosos sobre o nível de toxicidade do conteúdo. A detecção de toxicidade está atualmente disponível na API padrão do Amazon Transcribe para processamento em lote e oferece suporte ao idioma inglês dos EUA.

Passo a passo do console do Amazon Transcribe

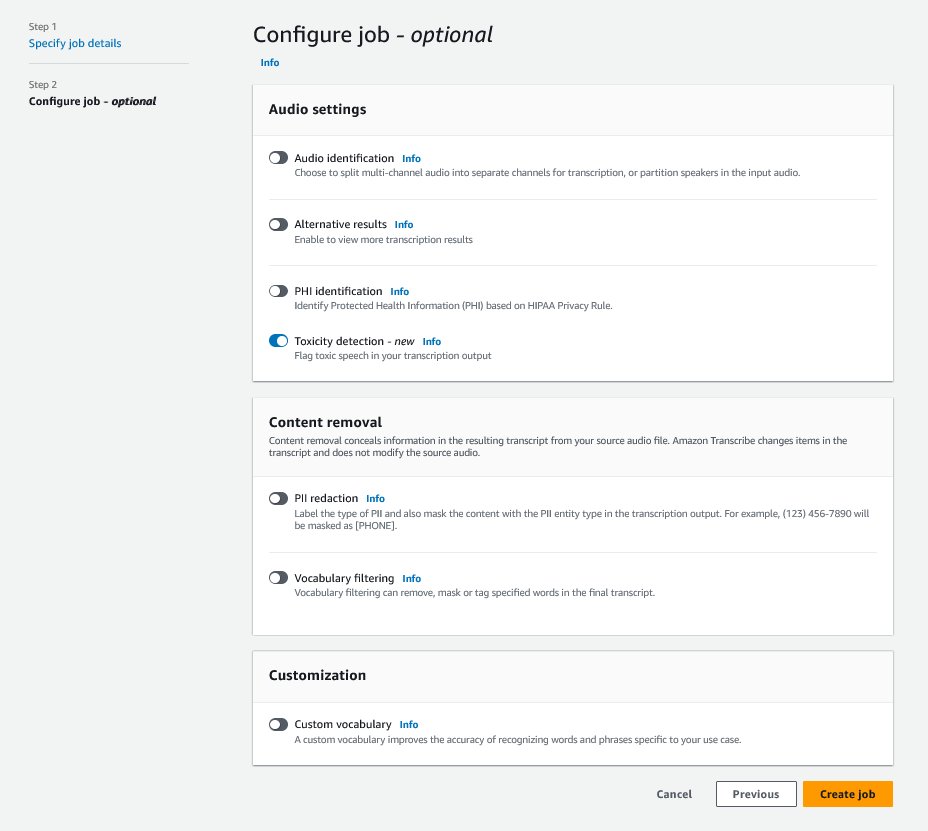

Para começar, faça login no Console de gerenciamento da AWS e vá para o Amazon Transcribe. Para criar um novo trabalho de transcrição, você precisa carregar seus arquivos gravados em um Serviço de armazenamento simples da Amazon (Amazon S3) antes de serem processados. Na página de configurações de áudio, conforme mostrado na captura de tela a seguir, ative Detecção de toxicidade e prossiga para criar o novo trabalho. O Amazon Transcribe processará o trabalho de transcrição em segundo plano. À medida que o trabalho avança, você pode esperar que o status mude para COMPLETADO quando o processo terminar.

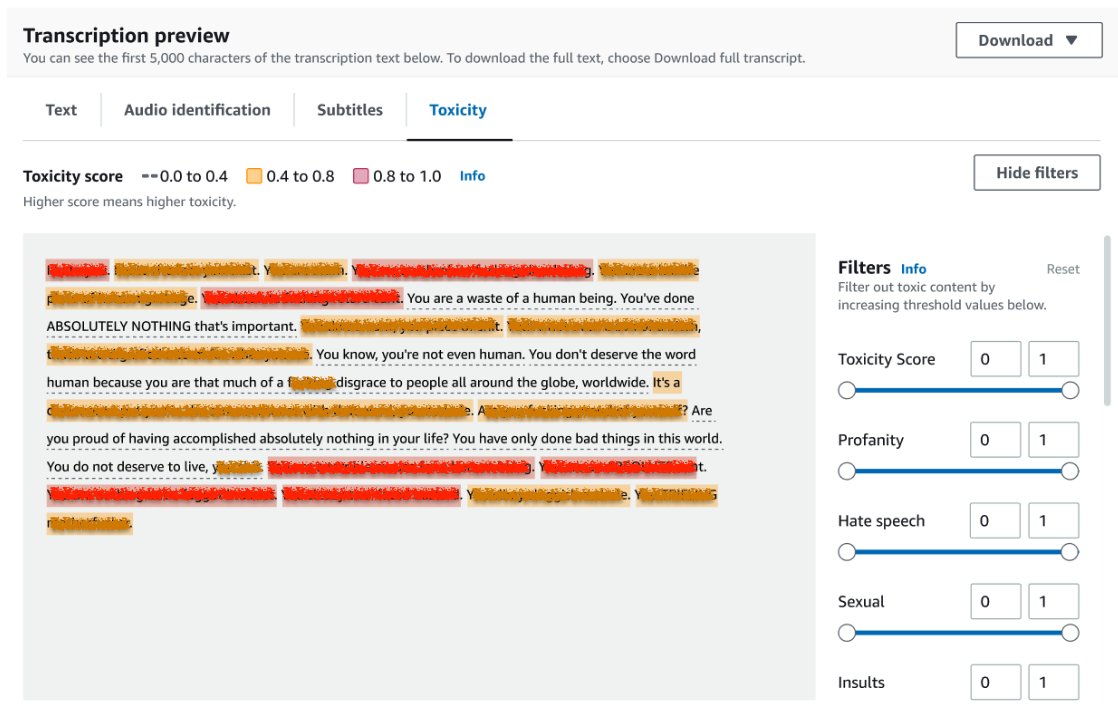

Para revisar os resultados de um trabalho de transcrição, escolha o trabalho na lista de trabalhos para abri-lo. Role para baixo até o Visualização da transcrição seção para verificar os resultados no Toxicidade aba. A IU mostra segmentos de transcrição codificados por cores para indicar o nível de toxicidade, determinado pela pontuação de confiança. Para personalizar a exibição, você pode usar as barras de alternância na Filtros painel. Essas barras permitem ajustar os limites e filtrar as categorias de toxicidade de acordo.

A captura de tela a seguir cobriu partes do texto da transcrição devido à presença de informações confidenciais ou tóxicas.

API de transcrição com uma solicitação de detecção de toxicidade

Nesta seção, orientamos você na criação de um trabalho de transcrição com detecção de toxicidade usando interfaces de programação. Se o arquivo de áudio ainda não estiver em um bucket do S3, faça upload dele para garantir o acesso pelo Amazon Transcribe. Semelhante à criação de um trabalho de transcrição no console, ao chamar o trabalho, você precisa fornecer os seguintes parâmetros:

- TranscriçãoJobName – Especifique um nome de tarefa exclusivo.

- MediaFileUri – Insira o local do URI do arquivo de áudio no Amazon S3. O Amazon Transcribe é compatível com os seguintes formatos de áudio: MP3, MP4, WAV, FLAC, AMR, OGG ou WebM

- Código do idioma - Definido como

en-US. No momento em que este livro foi escrito, a Detecção de Toxicidade suporta apenas o idioma inglês dos Estados Unidos. - Categorias de Toxicidade - Passe o

ALLvalor para incluir todas as categorias de detecção de toxicidade suportadas.

Veja a seguir exemplos de como iniciar um trabalho de transcrição com detecção de toxicidade habilitada usando Python3:

Você pode invocar o mesmo trabalho de transcrição com detecção de toxicidade usando o seguinte comando da AWS CLI:

API de transcrição com resposta de detecção de toxicidade

A saída JSON de detecção de toxicidade do Amazon Transcribe incluirá os resultados da transcrição no campo de resultados. A ativação da detecção de toxicidade adiciona um campo extra chamado toxicityDetection no campo de resultados. toxicityDetection inclui uma lista de itens transcritos com os seguintes parâmetros:

- texto – O texto bruto transcrito

- Toxicidade – Uma pontuação de confiança de detecção (um valor entre 0–1)

- Categorias – Uma pontuação de confiança para cada categoria de fala tóxica

- hora_início – A posição inicial de detecção no arquivo de áudio (segundos)

- Fim do tempo – A posição final da detecção no arquivo de áudio (segundos)

Veja a seguir um exemplo de resposta de detecção de toxicidade abreviada que você pode baixar no console:

Resumo

Nesta postagem, fornecemos uma visão geral do novo recurso Amazon Transcribe Toxicity Detection. Também descrevemos como você pode analisar a saída JSON de detecção de toxicidade. Para obter mais informações, confira o console do Amazon Transcribe e experimente a API de transcrição com detecção de toxicidade.

O Amazon Transcribe Toxicity Detection agora está disponível nas seguintes regiões da AWS: Leste dos EUA (Ohio), Leste dos EUA (N. Virgínia), Oeste dos EUA (Oregon), Pacífico Asiático (Sydney), Europa (Irlanda) e Europa (Londres). Para saber mais, visite Amazon Transcribe.

Saiba mais sobre moderação de conteúdo na AWS e nosso casos de uso de ML de moderação de conteúdo. Dê o primeiro passo para simplificando suas operações de moderação de conteúdo com a AWS.

Sobre o autor

Lana Zhang é arquiteto de soluções sênior da equipe de serviços de IA da AWS WWSO, especializado em IA e ML para moderação de conteúdo, visão computacional e processamento de linguagem natural. Com sua experiência, ela se dedica a promover soluções de IA/ML da AWS e a ajudar os clientes a transformar suas soluções de negócios em diversos setores, incluindo mídia social, jogos, comércio eletrônico e publicidade e marketing.

Lana Zhang é arquiteto de soluções sênior da equipe de serviços de IA da AWS WWSO, especializado em IA e ML para moderação de conteúdo, visão computacional e processamento de linguagem natural. Com sua experiência, ela se dedica a promover soluções de IA/ML da AWS e a ajudar os clientes a transformar suas soluções de negócios em diversos setores, incluindo mídia social, jogos, comércio eletrônico e publicidade e marketing.

Sumit Kumar é gerente de produto sênior, técnico da equipe AWS AI Language Services. Ele tem 10 anos de experiência em gerenciamento de produtos em vários domínios e é apaixonado por AI/ML. Fora do trabalho, Sumit adora viajar e gosta de jogar críquete e tênis.

Sumit Kumar é gerente de produto sênior, técnico da equipe AWS AI Language Services. Ele tem 10 anos de experiência em gerenciamento de produtos em vários domínios e é apaixonado por AI/ML. Fora do trabalho, Sumit adora viajar e gosta de jogar críquete e tênis.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Automotivo / EVs, Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- BlockOffsets. Modernizando a Propriedade de Compensação Ambiental. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/flag-harmful-language-in-spoken-conversations-with-amazon-transcribe-toxicity-detection/

- :tem

- :é

- :não

- 10

- 100

- 16

- 17

- 20

- 24

- 7

- 95%

- a

- habilidade

- Sobre

- abuso

- Acesso

- conformemente

- Contabilidade

- precisão

- em

- Açao Social

- atividades

- atividade

- adicionar

- Adição

- Adiciona

- Publicidade

- agressivo

- AI

- Serviços de IA

- AI / ML

- Todos os Produtos

- permitir

- já

- tb

- Apesar

- Amazon

- Amazon Transcribe

- Amazon Web Services

- entre

- an

- e

- Anunciar

- api

- APIs

- aplicações

- SOMOS

- AS

- Ásia

- Ásia-Pacífico

- ajudando

- At

- atrito

- auditivo

- Automático

- automaticamente

- disponível

- AWS

- fundo

- barras

- base

- BE

- passou a ser

- Porque

- antes

- comportamento

- entre

- Pós

- corpo

- ambos

- Break

- o bullying

- negócio

- by

- chamado

- chamada

- CAN

- capacidade

- Categorias

- Categoria

- Causar

- alterar

- verificar

- Escolha

- classificar

- Comunicação

- Comunidades

- Empresas

- completar

- Efetuado

- computador

- Visão de Computador

- confiança

- cônsul

- contém

- conteúdo

- Conversa

- conversas

- coberto

- crio

- Criar

- Grilo

- Critica

- Atualmente

- Clientes

- personalizar

- dados,

- dias

- dedicado

- descrito

- projetado

- descobrir

- Detecção

- determinado

- desenvolvedores

- diretamente

- diretamente

- Ecrã

- diferente

- domínios

- down

- download

- dois

- e-commerce,

- cada

- Leste

- fácil

- ou

- eliminando

- permitir

- habilitado

- permitindo

- final

- Inglês

- garantir

- Entrar

- empresas

- Todo

- Meio Ambiente

- especialmente

- etnia

- Europa

- avaliar

- exemplo

- exemplos

- animado

- esperar

- caro

- vasta experiência

- experiência

- extra

- facilitar

- enfrentando

- fracassado

- Característica

- poucos

- campo

- Envie o

- Arquivos

- filtro

- final

- Primeiro nome

- marcado

- Foco

- seguinte

- Escolha

- amigável

- da

- funcionalidade

- jogos

- Gênero

- Geral

- ter

- Go

- vai

- Designer

- Grupo

- guia

- prejudicial

- Ter

- he

- ajuda

- sua experiência

- SUA PARTICIPAÇÃO FAZ A DIFERENÇA

- Alta

- HORÁRIO

- Como funciona o dobrador de carta de canal

- Como Negociar

- Contudo

- HTML

- http

- HTTPS

- humano

- identificar

- Identidade

- if

- impactada

- importar

- melhoria

- in

- incluir

- inclui

- Incluindo

- Inclusivo

- Crescimento

- indicam

- indicam

- indústrias

- INFORMAÇÕES

- insights

- Insulto

- Pretendido

- intenção

- Intenção

- intencionalmente

- interesse

- interfaces de

- para dentro

- Irlanda

- IT

- Unid

- Trabalho

- jpg

- json

- apenas por

- Guarda

- língua

- conduzir

- APRENDER

- aprendizagem

- Nível

- Line

- Lista

- localização

- London

- ama

- máquina

- aprendizado de máquina

- a manter

- FAZ

- de grupos

- Gerente

- muitos

- Marketing

- Mídia

- Conheça

- ML

- modelo

- modelos

- moderação

- mais

- a maioria

- devo

- nome

- Nacional

- natural

- Processamento de linguagem natural

- você merece...

- Cria

- networking

- Novo

- agora

- of

- oferecer

- frequentemente

- Ohio

- on

- online

- jogo on line

- só

- aberto

- Operações

- or

- Oregon

- organizações

- origem

- A Nossa

- Fora

- saída

- lado de fora

- Visão geral

- próprio

- Pacífico

- página

- Dor

- parâmetros

- participar

- peças

- passar

- apaixonado

- pessoa

- Frases

- físico

- Passo

- platão

- Inteligência de Dados Platão

- PlatãoData

- jogar

- parte

- posição

- Publique

- presença

- problemas

- processo

- Processado

- em processamento

- Produto

- gestão de produtos

- gerente de produto

- PROFANIDADE

- Programação

- Promoção

- fornecer

- fornecido

- fornece

- fornecendo

- Python

- qualidade

- Corrida

- Preços

- Cru

- pronto

- reconhecimento

- gravado

- reduzir

- Reduzido

- referências

- regiões

- reguladores

- relevância

- religião

- depender

- Informou

- resposta

- resultar

- Resultados

- rever

- revendo

- Risco

- seguro

- mesmo

- Escala

- dimensionamento

- scams

- Ponto

- scroll

- SDK

- segundo

- Seção

- busca

- segmento

- segmentos

- senior

- sensível

- serviço

- Serviços

- conjunto

- Configurações

- Sete

- Sexo

- Sexual

- Partilhar

- ela

- mostrando

- Shows

- assinar

- semelhante

- simples

- Redes Sociais

- meios de comunicação social

- As redes sociais

- unicamente

- solução

- Soluções

- especializando

- específico

- discurso

- Reconhecimento de Voz

- fala para texto

- velocidade

- falado

- padrão

- começo

- começado

- Comece

- Status

- Passo

- armazenamento

- tal

- suficiente

- Suportado

- suportes

- sydney

- sistemas

- Tire

- falando

- Profissionais

- Dados Técnicos:

- condições

- teste

- que

- A

- deles

- Eles

- Este

- deles

- isto

- ameaças

- Através da

- tempo

- para

- hoje

- para

- para

- Trem

- transformando

- viagens

- verdadeiro

- tentar

- tipo

- ui

- para

- único

- Não solicitado

- Atualizada

- us

- usar

- usava

- Utilizador

- usuários

- usos

- utilização

- Valioso

- valor

- variedade

- via

- Violência

- Virgínia

- visão

- Visite a

- voz

- vs

- vulgar

- esperar

- queremos

- we

- web

- serviços web

- BEM

- Ocidente

- quando

- enquanto

- precisarão

- de

- sem

- palavras

- Atividades:

- escrita

- anos

- ainda

- Vocês

- investimentos

- zefirnet