O Google pausou seu IA de Gêmeos de gerar imagens de “pessoas” após um alvoroço sobre as suas representações raciais distorcidas.

A empresa de tecnologia tomou medidas depois que os usuários destacaram a tendência da IA de representar principalmente pessoas de cor, mesmo em contextos historicamente imprecisos. Esta mudança visa refinar as capacidades do Gemini para garantir representações mais precisas e diversificadas.

Veja também: É uma piada! Os usuários ridicularizam o Gêmeos do Google por perdê-lo

A gênese da reação

O cerne da controvérsia reside no fracasso da IA em refletir com precisão a diversidade racial em suas imagens. As redes sociais tornaram-se um campo de batalha, com utilizadores a partilhar imagens geradas pela Gemini que se desviavam da precisão histórica e cultural. Exemplos notáveis incluem representações de mulheres suecas não brancas e pessoas de cor em uniformes nazistas.

É embaraçosamente difícil fazer o Google Gemini reconhecer que existem brancos pic.twitter.com/4lkhD7p5nR

-Deedy (@debarghya_das) 20 de fevereiro de 2024

Tais imprecisões não só provocaram debates nas redes sociais, mas também levaram a uma introspecção severa dentro do Google, com funcionários expressando constrangimento com as deficiências da IA. Os críticos argumentam que estas imprecisões não são meras falhas técnicas, mas reflectem um preconceito mais profundo na programação da IA.

“Nunca tive tanta vergonha de trabalhar para uma empresa”, disse St. Ratej, engenheiro de pesquisa do Google ARVR, em um post X.

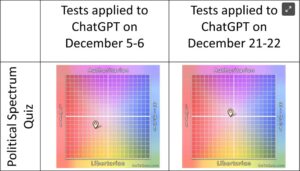

A reação, no entanto, não parou apenas no Google, já que alguns usuários também notaram os mesmos preconceitos em outras plataformas de IA, como ChatGPT da OpenAI. Consequentemente, surgiram questões sobre a consistência do escrutínio entre as tecnologias de IA, destacando o desafio mais amplo de toda a indústria de garantir representações imparciais da IA.

Er, pessoal… parece que o chatGPT tem o mesmo problema de moralização.

Por que eles estão recebendo um passe livre? pic.twitter.com/a1ZBz69iZw

-Liv Boeree (@Liv_Boeree) 21 de fevereiro de 2024

O efeito cascata

O incidente não só manchou a imagem da empresa, mas também levou a um debate mais amplo sobre a ética e a representação da IA. Elon Musk criticou a metodologia do Google, chamando-a de “racista” e “anticivilizacional”. de almíscar comentários ecoam ainda a preocupação crescente sobre os limites éticos da tecnologia de IA e a necessidade de uma representação mais diversificada e precisa do conteúdo gerado pela IA.

“Estou feliz que o Google tenha exagerado na geração de imagens de IA, pois deixou clara para todos sua programação insana, racista e anticivilizacional.”

Em resposta à polêmica, Musk expressou seu modelo de IA, Grok, para o qual pretendia lançar novas versões. A tecnologia demonstra uma vantagem competitiva no desenvolvimento de IA, o que pode ajudar a superar as limitações dos modelos existentes como o Gemini. Além disso, a semelhança coincidente do nome entre Grok e o chip Groq LPU despertou interesse, já que o mercado de IA é marcado por inovação rápida e competição acirrada.

Talvez agora esteja claro por que @xAI's Grok é tão importante.

Está longe de ser perfeito neste momento, mas irá melhorar rapidamente. Lançamentos V1.5 em 2 semanas.

A busca rigorosa da verdade, sem levar em conta as críticas, nunca foi tão essencial.

- Elon Musk (@elonmusk) 22 de fevereiro de 2024

O caminho para a melhoria

Reconhecendo o problema, o Google pretendia refinar as capacidades de representação do Gemini. A empresa enfatizou a importância da diversidade nas imagens geradas por IA, mas admitiu as deficiências do modelo atual em representar com precisão todos os dados demográficos.

Já estamos trabalhando para resolver problemas recentes com o recurso de geração de imagens do Gemini. Enquanto fazemos isso, pausaremos a geração de imagens de pessoas e relançaremos uma versão melhorada em breve. https://t.co/SLxYPGoqOZ

- Comunicações do Google (@Google_Comms) 22 de fevereiro de 2024

Na mesma linha, o porta-voz do Google, Krawczyk, admitiu a deficiência do modelo, enfatizando a necessidade de uma representação mais equilibrada que espelhe a diversidade global sem comprometer a precisão histórica. Para resolver essas preocupações, o Google pausou o recurso de geração de imagens humanas do Gemini, sinalizando uma versão aprimorada que reflete melhor a diversidade global de sua base de usuários.

“Já estamos trabalhando para resolver problemas recentes com o recurso de geração de imagens do Gemini. Enquanto fazemos isso, vamos pausar a geração de imagens de pessoas e relançaremos uma versão melhorada em breve.”

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://metanews.com/google-halts-gemini-ai-amid-backlash-over-woke-image-controversies/

- :tem

- :é

- :não

- 13

- 20

- 22

- 7

- 8

- 9

- a

- Sobre

- precisão

- preciso

- exatamente

- reconhecer

- em

- Açao Social

- endereço

- admitiu

- Depois de

- AI

- visa

- Todos os Produtos

- já

- tb

- an

- e

- SOMOS

- argumentar

- AS

- At

- balanced

- base

- campo de batalha

- passou a ser

- sido

- Melhor

- entre

- viés

- vieses

- limites

- mais amplo

- mas a

- by

- chamada

- capacidades

- desafiar

- ChatGPT

- lasca

- remover filtragem

- cor

- Comunicações

- Empresa

- Empresa

- competição

- competitivo

- comprometendo

- Interesse

- Preocupações

- Consequentemente

- conteúdo

- Contextos

- controvérsia

- núcleo

- crítica

- Críticos

- cultural

- Atual

- debate

- debates

- Demografia

- demonstra

- Desenvolvimento

- DID

- diferente

- Diversidade

- do

- eco

- borda

- Elon

- Elon Musk

- enfatizado

- enfatizando

- colaboradores

- engenheiro

- aprimorada

- garantir

- assegurando

- essencial

- considerações éticas

- ética

- Mesmo

- exemplos

- existir

- existente

- expressa

- Falha

- longe

- RÁPIDO

- Característica

- Empresa

- seguinte

- Escolha

- Gratuito

- da

- mais distante

- Além disso

- Gemini

- gerando

- geração

- Gênese

- ter

- obtendo

- Global

- vai

- Crescente

- mão

- Queijos duros

- Ter

- he

- ajudar

- Destaque

- Destacando

- sua

- histórico

- historicamente

- Contudo

- HTTPS

- humano

- imagem

- imagens

- importância

- importante

- melhorar

- melhorado

- in

- Em outra

- impreciso

- incidente

- incluir

- Inovação

- INSANO

- Pretendido

- interesse

- introspecção

- emitem

- questões

- IT

- ESTÁ

- apenas por

- levou

- encontra-se

- como

- limitações

- LIV

- OLHARES

- moldadas

- marcado

- mercado

- Mídia

- mers

- Metodologia

- poder

- desaparecido

- modelo

- modelos

- mais

- mover

- Almíscar

- nome

- Nazista

- você merece...

- nunca

- notável

- agora

- of

- on

- só

- Outros

- outputs

- Acima de

- Superar

- passar

- caminho

- pausa

- pausada

- Pessoas

- perfeita

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- Publique

- principalmente

- profundo

- Programação

- busca

- Frequentes

- racista

- rapidamente

- RE

- Leia

- recentemente

- refinar

- refletir

- reflete

- Considerar

- liberar

- Releases

- representação

- representando

- pesquisa

- resposta

- certo

- Ripple

- s

- Dito

- mesmo

- escrutínio

- grave

- compartilhando

- falhas

- déficit

- So

- Redes Sociais

- meios de comunicação social

- alguns

- em breve

- deflagrou

- porta-voz

- Dê um basta

- Sueco

- tecnologia

- Dados Técnicos:

- Tecnologias

- Tecnologia

- que

- A

- deles

- Este

- deles

- isto

- para

- levou

- verdadeiro

- Verdade

- imparcial

- Utilizador

- usuários

- v1

- versão

- versões

- we

- semanas

- qual

- enquanto

- branco

- porque

- precisarão

- de

- dentro

- sem

- Mulher

- Atividades:

- trabalhar

- X

- zefirnet