Vídeo O maior modelo de linguagem de IA do Google está ajudando os robôs a serem mais flexíveis na compreensão e interpretação de comandos humanos, de acordo com a pesquisa mais recente da gigante da web.

As máquinas geralmente respondem melhor a demandas muito específicas – solicitações abertas às vezes podem descartá-las e levar a resultados que os usuários não tinham em mente. As pessoas aprendem a interagir com robôs de maneira rígida, como fazer perguntas de uma maneira específica para obter a resposta desejada.

O sistema mais recente do Google, apelidado de PaLM-SayCan, no entanto, promete ser mais inteligente. O dispositivo físico da Everyday Robots – uma startup derivada do Google X – tem câmeras para os olhos em sua cabeça e um braço com uma pinça enfiada atrás de seu corpo longo e reto, que fica em cima de um conjunto de rodas.

Você pode ver o robô em ação no vídeo abaixo:

Perguntando ao robô, algo como “Acabei de malhar, você pode me dar um lanche saudável?” vai empurrá-lo para buscar uma maçã. “PaLM-SayCan [é] uma abordagem interpretável e geral para alavancar o conhecimento de modelos de linguagem que permite que um robô siga instruções textuais de alto nível para realizar tarefas fisicamente fundamentadas”, cientistas pesquisadores da equipe Brain do Google explicado.

Google apresentou seu maior modelo de linguagem Palma em abril deste ano. O PaLM foi treinado com dados extraídos da Internet, mas em vez de emitir respostas de texto abertas, o sistema foi adaptado para gerar uma lista de instruções para o robô seguir.

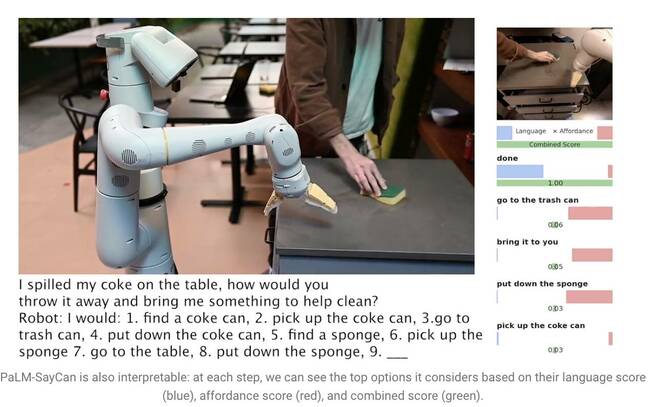

Dizendo “Eu derramei minha Coca-Cola na mesa, como você jogaria fora e me traria algo para ajudar a limpar?”, leva PaLM a entender a pergunta e gerar uma lista de etapas que o robô pode seguir para concluir a tarefa, como passar por cima pegar a lata, jogá-la em uma lixeira e pegar uma esponja.

Grandes modelos de linguagem (LLMs) como o PaLM, no entanto, não entendem o significado de nada do que dizem. Por esse motivo, os pesquisadores treinaram um modelo separado usando aprendizado por reforço para fundamentar a linguagem abstrata em representações e ações visuais. Dessa forma, o robô aprende a associar a palavra “Coke” a uma imagem de uma lata de refrigerante.

O PaLM-SayCan também aprende as chamadas “funções de affordance” – um método que classifica a possibilidade de completar uma ação específica dada objetos em seu ambiente. É mais provável que o robô pegue uma esponja do que um aspirador de pó, por exemplo, se detectar uma esponja, mas nenhum aspirador próximo a ela.

“Nosso método, SayCan, extrai e aproveita o conhecimento dentro de LLMs em tarefas fisicamente fundamentadas”, explicou a equipe em um trabalho de pesquisa. “O LLM (Say) fornece uma base de tarefas para determinar ações úteis para um objetivo de alto nível e as funções de affordance aprendidas (Can) fornecem uma base mundial para determinar o que é possível executar de acordo com o plano. Usamos o aprendizado por reforço (RL) como uma maneira de aprender funções de valor condicionado de linguagem que fornecem affordances do que é possível no mundo.”

Para evitar que o robô se desvie da tarefa, ele é treinado para selecionar ações apenas de 101 instruções diferentes. O Google o treinou para se adaptar a uma cozinha – o PaLM-SayCan pode pegar lanches, bebidas e realizar tarefas simples de limpeza. Os pesquisadores acreditam que os LLMs são o primeiro passo para que os robôs executem tarefas mais complexas com segurança, dadas instruções abstratas.

“Nossos experimentos em várias tarefas robóticas do mundo real demonstram a capacidade de planejar e concluir instruções de linguagem natural, abstratas e de longo horizonte com uma alta taxa de sucesso. Acreditamos que a interpretabilidade do PaLM-SayCan permite uma interação segura do usuário no mundo real com robôs”, concluíram. ®

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- O registro

- zefirnet