No mundo dinâmico do streaming em Amazon Música, cada pesquisa por uma música, podcast ou playlist contém uma história, um clima ou uma enxurrada de emoções esperando para serem reveladas. Essas pesquisas servem como porta de entrada para novas descobertas, experiências queridas e memórias duradouras. A barra de pesquisa não serve apenas para encontrar uma música; trata-se de milhões de usuários ativos iniciando sua jornada pessoal no mundo rico e diversificado que a Amazon Music tem a oferecer.

Oferecer uma experiência superior ao cliente para encontrar instantaneamente a música que os usuários procuram requer uma plataforma que seja inteligente e ágil. Amazon Music usa o poder da IA para conseguir isso. No entanto, otimizar a experiência do cliente e ao mesmo tempo gerenciar custos de treinamento e inferência de modelos de IA que potencializam os recursos da barra de pesquisa, como verificação ortográfica em tempo real e pesquisa vetorial, é difícil durante horários de pico de tráfego.

Amazon Sage Maker fornece um conjunto completo de serviços que permitem que a Amazon Music crie, treine e implante na Nuvem AWS com o mínimo de esforço. Ao cuidar do trabalho pesado indiferenciado, o SageMaker permite que você se concentre em trabalhar em seus modelos de aprendizado de máquina (ML) e não se preocupe com coisas como infraestrutura. Como parte do modelo de responsabilidade compartilhada, o SageMaker garante que os serviços que fornece sejam confiáveis, de alto desempenho e escaláveis, enquanto você garante que a aplicação dos modelos de ML faça o melhor uso dos recursos que o SageMaker oferece.

Nesta postagem, percorremos a jornada que a Amazon Music percorreu para otimizar desempenho e custos usando SageMaker e NVIDIA Triton Inference Server e TensorRT. Nós nos aprofundamos em mostrar como funciona aquela barra de pesquisa aparentemente simples, mas complexa, garantindo uma jornada ininterrupta no universo da Amazon Music com atrasos de digitação frustrantes de pouco a zero e resultados de pesquisa relevantes em tempo real.

Amazon SageMaker e NVIDIA: oferecendo recursos rápidos e precisos de pesquisa vetorial e verificação ortográfica

Amazon Music oferece uma vasta biblioteca com mais de 100 milhões de músicas e milhões de episódios de podcast. No entanto, encontrar a música ou podcast certo pode ser um desafio, especialmente se você não souber o título, artista ou nome exato do álbum, ou se a consulta pesquisada for muito ampla, como “podcasts de notícias”.

A Amazon Music adotou uma abordagem dupla para melhorar o processo de pesquisa e recuperação. A primeira etapa é introduzir a pesquisa vetorial (também conhecida como recuperação baseada em incorporação), uma técnica de ML que pode ajudar os usuários a encontrar o conteúdo mais relevante que procuram usando a semântica do conteúdo. A segunda etapa envolve a introdução de um modelo de correção ortográfica baseado em transformador na pilha de pesquisa. Isso pode ser especialmente útil ao pesquisar músicas, porque os usuários nem sempre sabem a grafia exata do título de uma música ou do nome do artista. A correção ortográfica pode ajudar os usuários a encontrar a música que procuram, mesmo que cometam um erro ortográfico na consulta de pesquisa.

A introdução de modelos Transformer em um pipeline de pesquisa e recuperação (na geração de incorporação de consultas necessária para pesquisa vetorial e no modelo generativo Seq2Seq Transformer na correção ortográfica) pode levar a um aumento significativo na latência geral, afetando negativamente a experiência do cliente. Portanto, tornou-se uma prioridade para nós otimizar a latência de inferência em tempo real para modelos de pesquisa vetorial e correção ortográfica.

Amazon Music e NVIDIA se uniram para trazer a melhor experiência possível do cliente para a barra de pesquisa, usando o SageMaker para implementar recursos de verificação ortográfica rápida e precisa e sugestões de pesquisa semântica em tempo real usando técnicas baseadas em pesquisa vetorial. A solução inclui o uso de hospedagem SageMaker alimentada por instâncias G5 que usam GPUs NVIDIA A10G Tensor Core, NVIDIA Triton Inference Server Container compatível com SageMaker e o NVIDIA TensorRT formato do modelo. Ao reduzir a latência de inferência do modelo de verificação ortográfica para 25 milissegundos no pico de tráfego e reduzir a latência de geração de incorporação de consultas de pesquisa em 63%, em média, e o custo em 73% em comparação com a inferência baseada em CPU, o Amazon Music elevou o desempenho da barra de pesquisa.

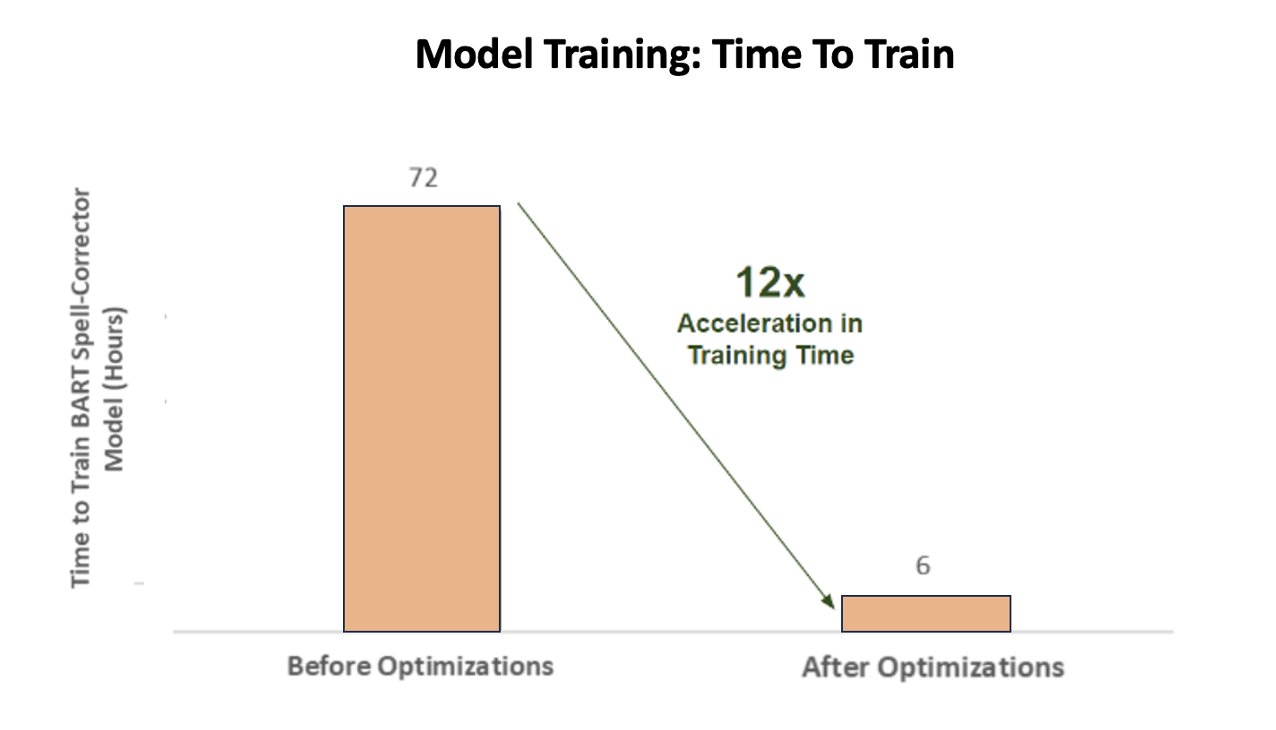

Além disso, ao treinar o modelo de IA para fornecer resultados precisos, a Amazon Music alcançou uma aceleração impressionante de 12 vezes no tempo de treinamento para seu modelo de transformador corretor ortográfico sequência a sequência BART, economizando tempo e dinheiro, otimizando a utilização da GPU.

A Amazon Music fez parceria com a NVIDIA para priorizar a experiência de pesquisa do cliente e criar uma barra de pesquisa com verificação ortográfica e funcionalidades de pesquisa vetorial bem otimizadas. Nas seções a seguir, compartilhamos mais sobre como essas otimizações foram orquestradas.

Otimizando o treinamento com GPUs NVIDIA Tensor Core

Obter acesso a uma GPU NVIDIA Tensor Core para treinamento de modelos de linguagem grande não é suficiente para capturar seu verdadeiro potencial. Existem etapas importantes de otimização que devem ocorrer durante o treinamento para maximizar totalmente a utilização da GPU. No entanto, uma GPU subutilizada sem dúvida levará ao uso ineficiente de recursos, à duração prolongada do treinamento e ao aumento dos custos operacionais.

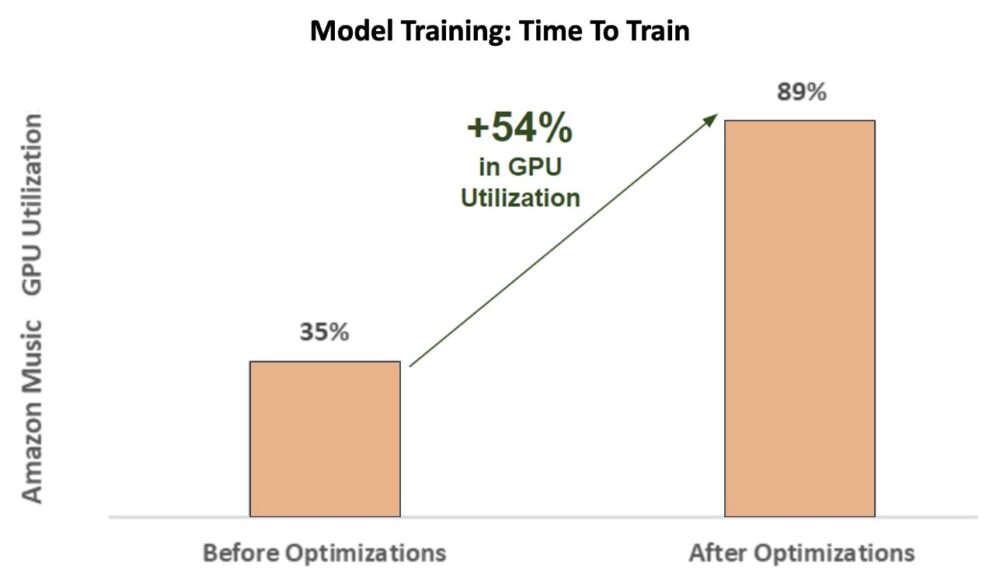

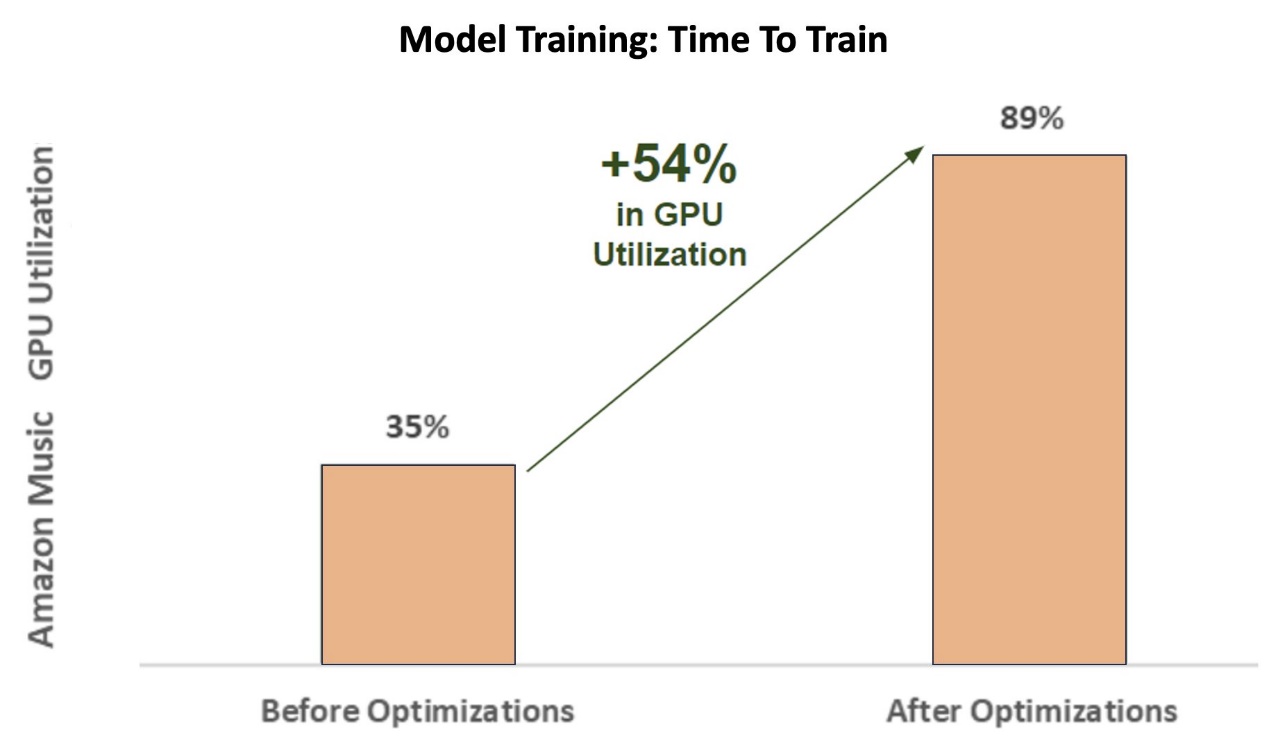

Durante as fases iniciais de treinamento do corretor ortográfico BART (base bart) em uma instância SageMaker ml.p3.24xlarge (8 GPUs NVIDIA V100 Tensor Core), a utilização da GPU da Amazon Music foi de cerca de 35%. Para maximizar os benefícios do treinamento acelerado por GPU NVIDIA, os arquitetos de soluções da AWS e da NVIDIA apoiaram a Amazon Music na identificação de áreas para otimizações, especialmente em torno do tamanho do lote e dos parâmetros de precisão. Esses dois parâmetros cruciais influenciam a eficiência, velocidade e precisão do treinamento de modelos de aprendizagem profunda.

As otimizações resultantes geraram uma utilização nova e aprimorada da GPU V100, estável em cerca de 89%, reduzindo drasticamente o tempo de treinamento do Amazon Music de 3 dias para 5–6 horas. Mudando o tamanho do lote de 32 para 256 e usando técnicas de otimização como executar treinamento automático de precisão mista em vez de usar apenas a precisão FP32, a Amazon Music conseguiu economizar tempo e dinheiro.

O gráfico a seguir ilustra o aumento de 54% em pontos percentuais na utilização da GPU após otimizações.

A figura a seguir ilustra a aceleração no tempo de treinamento.

Esse aumento no tamanho do lote permitiu que a GPU NVIDIA processasse significativamente mais dados simultaneamente em vários Tensor Cores, resultando em um tempo de treinamento mais rápido. No entanto, é importante manter um equilíbrio delicado com a memória, pois lotes maiores exigem mais memória. Aumentar o tamanho do lote e empregar precisão mista pode ser fundamental para desbloquear o poder das GPUs NVIDIA Tensor Core.

Depois que o modelo foi treinado para convergência, chegou a hora de otimizar a implantação de inferência na barra de pesquisa do Amazon Music.

Correção ortográfica: inferência do modelo BART

Com a ajuda das instâncias SageMaker G5 e NVIDIA Triton Inference Server (um software de serviço de inferência de código aberto), bem como NVIDIA TensorRT, um SDK para inferência de aprendizagem profunda de alto desempenho que inclui um otimizador de inferência e tempo de execução, a Amazon Music limita sua verificação ortográfica BART (base bart) modelam a latência de inferência do servidor para apenas 25 milissegundos no pico de tráfego. Isso inclui despesas gerais como balanceamento de carga, pré-processamento, inferência de modelo e tempos de pós-processamento.

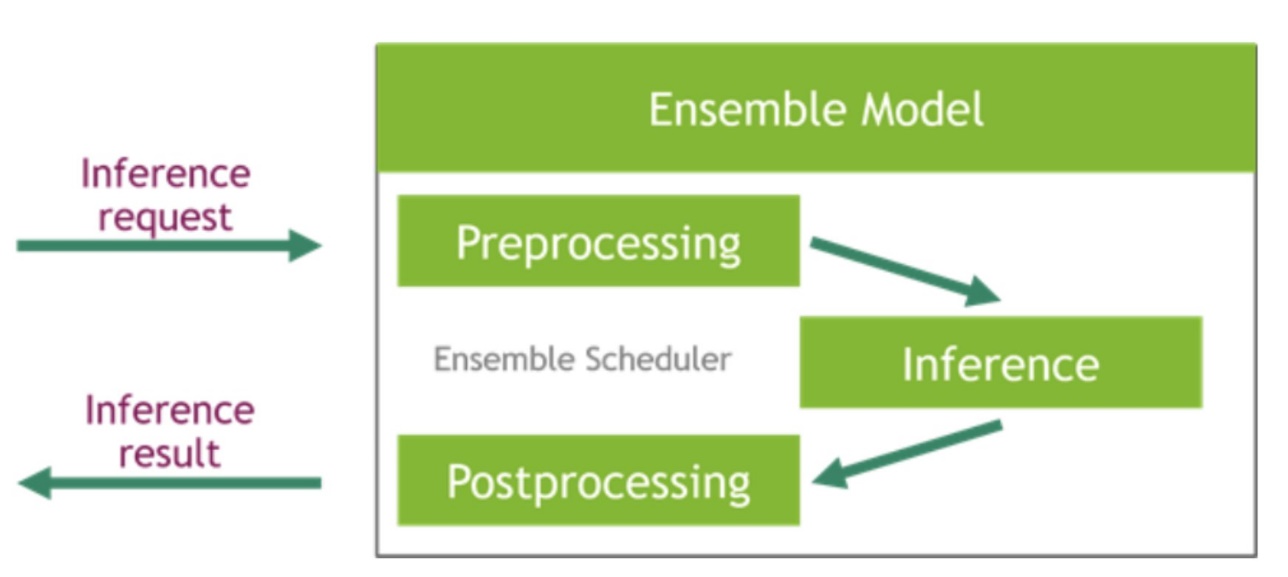

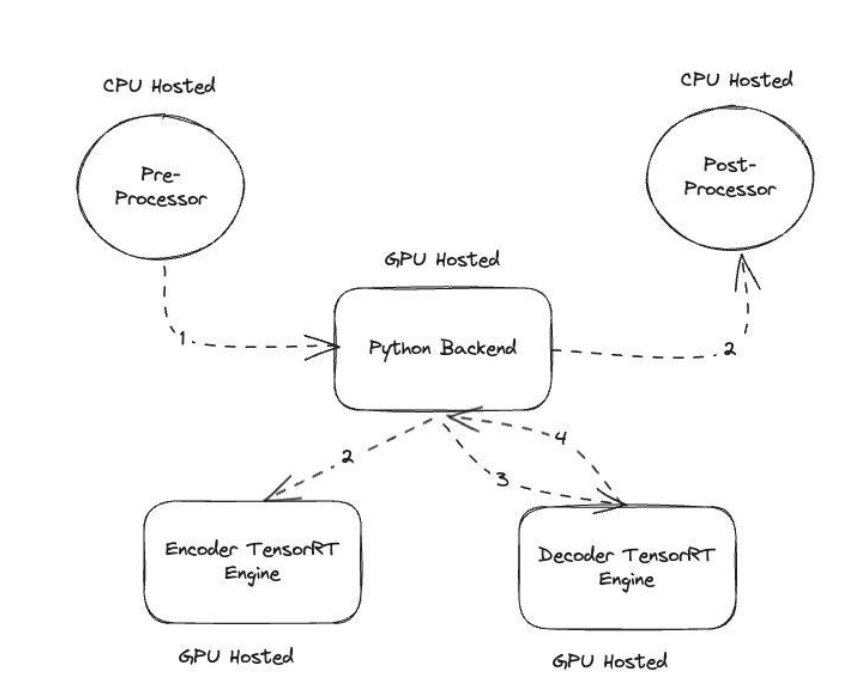

O NVIDIA Triton Inference Server oferece dois tipos diferentes de back-end: um para hospedar modelos em GPU e um back-end Python onde você pode trazer seu próprio código personalizado para ser usado nas etapas de pré-processamento e pós-processamento. A figura a seguir ilustra o esquema de conjunto de modelos.

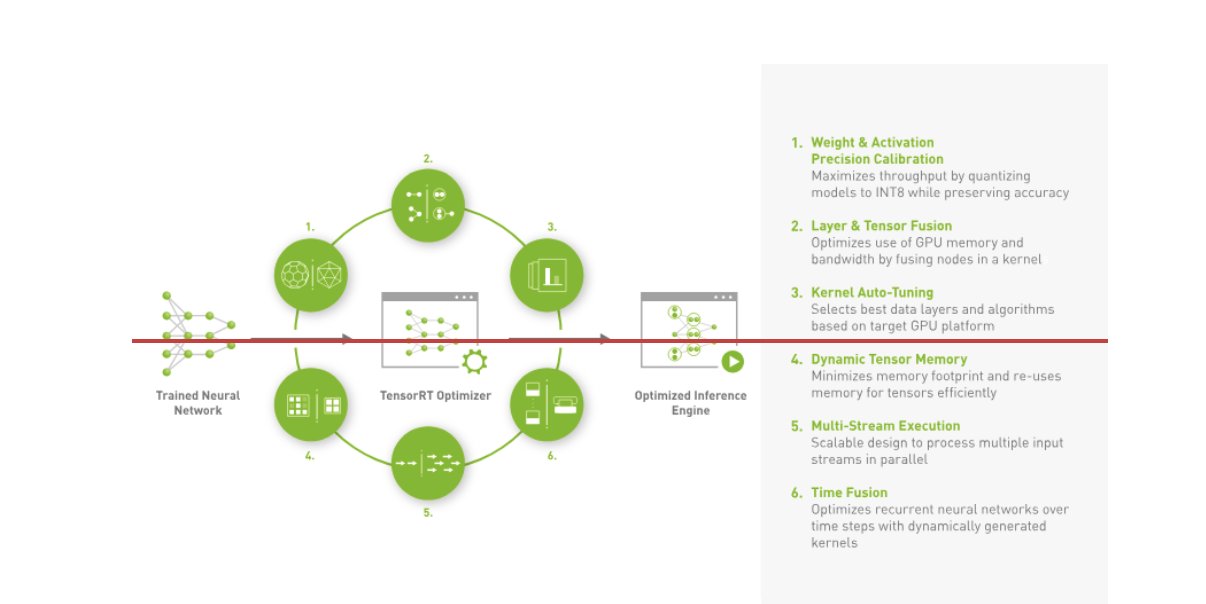

Amazon Music construiu seu BART pipeline de inferência executando as etapas de pré-processamento (tokenização de texto) e pós-processamento (tokens para texto) em CPUs, enquanto a etapa de execução do modelo é executada em GPUs Tensor Core NVIDIA A10G. Um back-end Python fica no meio das etapas de pré-processamento e pós-processamento e é responsável pela comunicação com os modelos BART convertidos em TensorRT, bem como com as redes de codificadores/decodificadores. TensorRT aumenta o desempenho de inferência com calibração de precisão, fusão de camadas e tensores, ajuste automático de kernel, memória de tensor dinâmico, execução multistream e fusão de tempo.

A figura a seguir ilustra o design de alto nível dos principais módulos que compõem o pipeline de inferência do modelo BART do corretor ortográfico.

Pesquisa vetorial: inferência do modelo BERT de frase de geração de incorporação de consulta

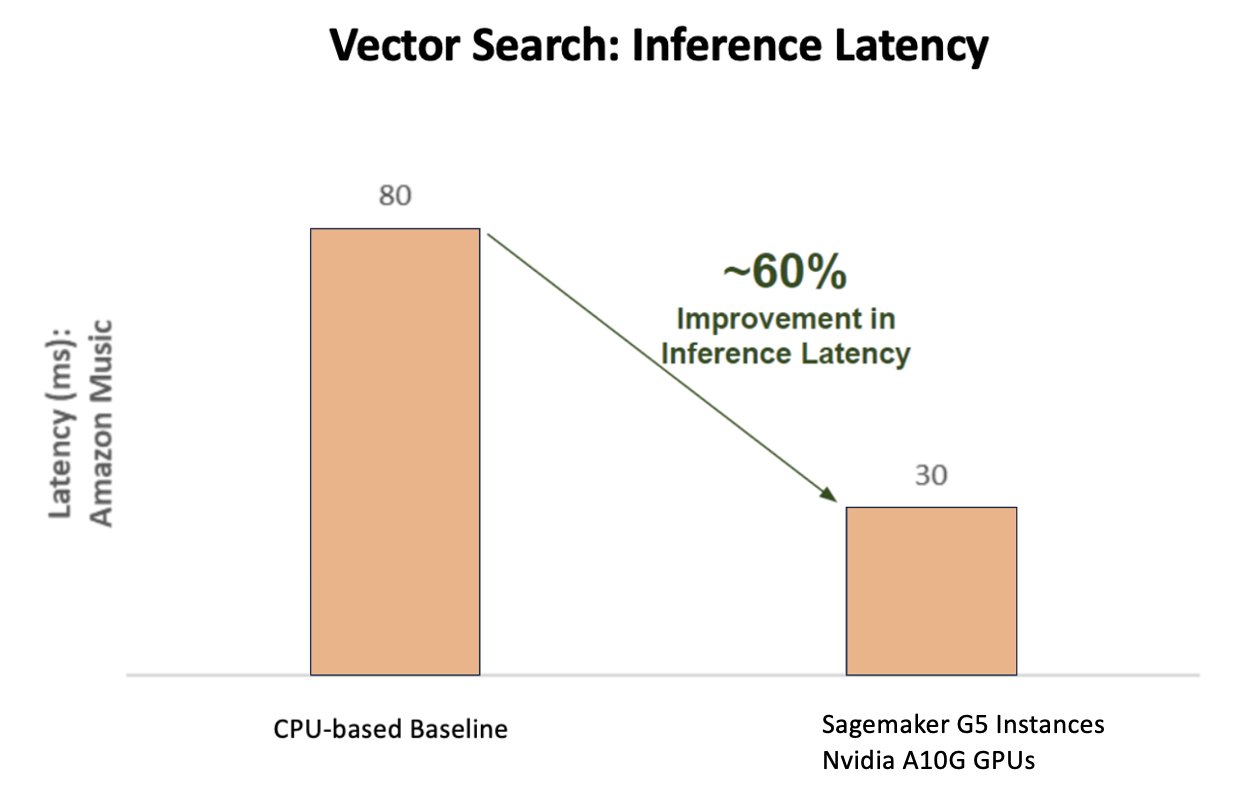

O gráfico a seguir ilustra a melhoria de 60% na latência (servindo p90 800–900 TPS) ao usar a NVIDIA AI Inference Platform em comparação com uma linha de base baseada em CPU.

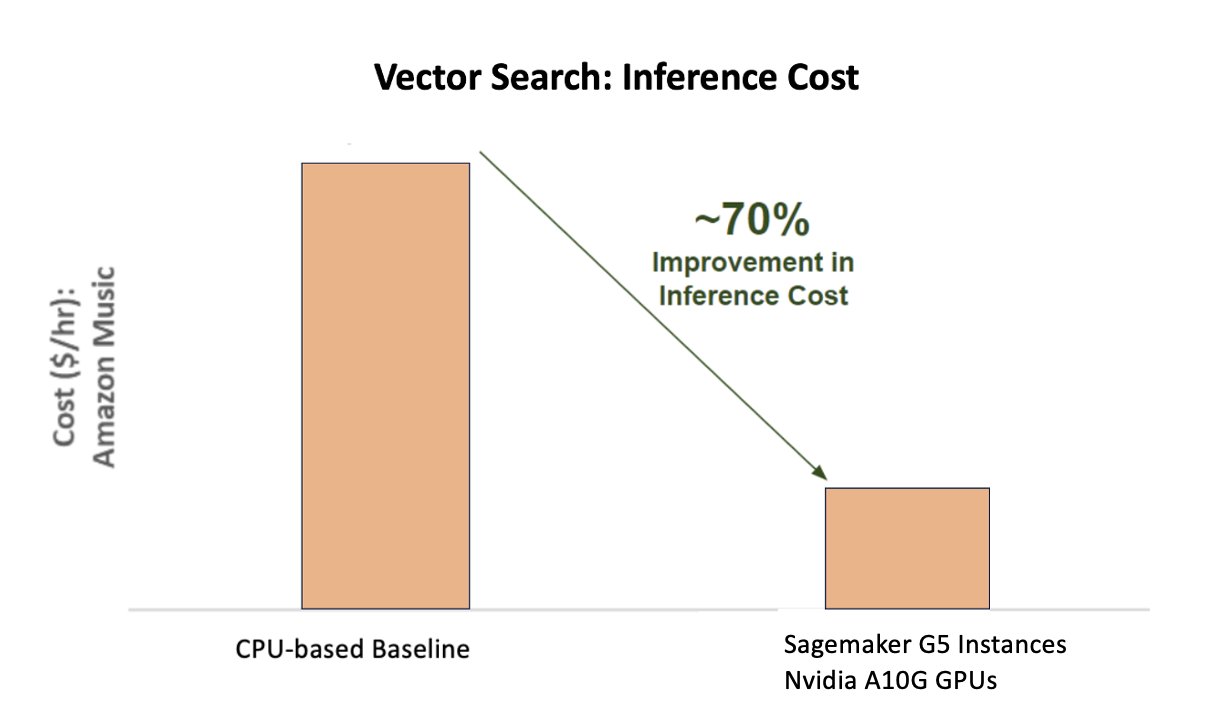

O gráfico a seguir mostra uma melhoria de 70% no custo ao usar a NVIDIA AI Inference Platform em comparação com uma linha de base baseada em CPU.

A figura a seguir ilustra um SDK para inferência de aprendizado profundo de alto desempenho. Inclui um otimizador de inferência de aprendizado profundo e tempo de execução que oferece baixa latência e alto rendimento para aplicativos de inferência.

Para alcançar esses resultados, a Amazon Music experimentou vários parâmetros diferentes de implantação do Triton usando Analisador de modelo Triton, uma ferramenta que ajuda a encontrar a melhor configuração do modelo NVIDIA Triton para implantar inferência eficiente. Para otimizar a inferência de modelos, o Triton oferece recursos como lote dinâmico e execução simultânea de modelos, além de suporte de estrutura para outros recursos de flexibilidade. O lote dinâmico reúne solicitações de inferência, agrupando-as perfeitamente em coortes para maximizar o rendimento, ao mesmo tempo que garante respostas em tempo real para os usuários do Amazon Music. A capacidade de execução simultânea do modelo melhora ainda mais o desempenho da inferência, hospedando múltiplas cópias do modelo na mesma GPU. Finalmente, ao utilizar Analisador de modelo Triton, o Amazon Music conseguiu ajustar cuidadosamente o lote dinâmico e modelar os parâmetros de hospedagem de inferência de simultaneidade para encontrar as configurações ideais que maximizam o desempenho da inferência usando tráfego simulado.

Conclusão

A otimização das configurações com o Triton Inference Server e o TensorRT no SageMaker permitiu que a Amazon Music alcançasse resultados excelentes para pipelines de treinamento e inferência. A plataforma SageMaker é a plataforma aberta ponta a ponta para IA de produção, proporcionando retorno rápido e versatilidade para suportar todos os principais casos de uso de IA em hardware e software. Ao otimizar a utilização da GPU V100 para treinamento e migração de CPUs para instâncias G5 usando GPUs NVIDIA A10G Tensor Core, bem como ao usar software NVIDIA otimizado como Triton Inference Server e TensorRT, empresas como Amazon Music podem economizar tempo e dinheiro enquanto aumentam o desempenho em ambos. treinamento e inferência, traduzindo-se diretamente em uma melhor experiência do cliente e custos operacionais mais baixos.

O SageMaker lida com o trabalho pesado indiferenciado de treinamento e hospedagem de ML, permitindo que a Amazon Music forneça operações de ML confiáveis e escalonáveis em hardware e software.

Incentivamos você a verificar se suas cargas de trabalho estão otimizadas usando o SageMaker, sempre avaliando suas escolhas de hardware e software para ver se há maneiras de obter melhor desempenho com custos reduzidos.

Para saber mais sobre NVIDIA AI na AWS, consulte o seguinte:

Sobre os autores

Siddharth Sharma é líder técnico de aprendizado de máquina na equipe de ciência e modelagem da Amazon Music. Ele é especialista em problemas de modelagem relacionados a pesquisa, recuperação, classificação e PNL. Siddharth tem uma vasta experiência trabalhando em problemas de aprendizado de máquina em grande escala que são sensíveis à latência, por exemplo, segmentação de anúncios, recuperação multimodal, compreensão de consultas de pesquisa, etc. Antes de trabalhar na Amazon Music, Siddharth trabalhou em empresas como Meta, Walmart Labs, Rakuten sobre problemas de ML centrados no comércio eletrônico. Siddharth passou parte de sua carreira trabalhando com startups de tecnologia de publicidade da Bay Area.

Siddharth Sharma é líder técnico de aprendizado de máquina na equipe de ciência e modelagem da Amazon Music. Ele é especialista em problemas de modelagem relacionados a pesquisa, recuperação, classificação e PNL. Siddharth tem uma vasta experiência trabalhando em problemas de aprendizado de máquina em grande escala que são sensíveis à latência, por exemplo, segmentação de anúncios, recuperação multimodal, compreensão de consultas de pesquisa, etc. Antes de trabalhar na Amazon Music, Siddharth trabalhou em empresas como Meta, Walmart Labs, Rakuten sobre problemas de ML centrados no comércio eletrônico. Siddharth passou parte de sua carreira trabalhando com startups de tecnologia de publicidade da Bay Area.

Tarun Sharma é gerente de desenvolvimento de software líder em relevância de pesquisa de música na Amazon. Sua equipe de cientistas e engenheiros de ML é responsável por fornecer resultados de pesquisa contextualmente relevantes e personalizados aos clientes da Amazon Music.

Tarun Sharma é gerente de desenvolvimento de software líder em relevância de pesquisa de música na Amazon. Sua equipe de cientistas e engenheiros de ML é responsável por fornecer resultados de pesquisa contextualmente relevantes e personalizados aos clientes da Amazon Music.

James Park é arquiteto de soluções na Amazon Web Services. Ele trabalha com a Amazon.com para projetar, criar e implantar soluções de tecnologia na AWS e tem interesse particular em IA e aprendizado de máquina. Em seu tempo livre, ele gosta de conhecer novas culturas, novas experiências e estar atualizado com as últimas tendências tecnológicas. Você pode encontrá-lo em LinkedIn.

James Park é arquiteto de soluções na Amazon Web Services. Ele trabalha com a Amazon.com para projetar, criar e implantar soluções de tecnologia na AWS e tem interesse particular em IA e aprendizado de máquina. Em seu tempo livre, ele gosta de conhecer novas culturas, novas experiências e estar atualizado com as últimas tendências tecnológicas. Você pode encontrá-lo em LinkedIn.

Kshitiz Gupta é arquiteto de soluções da NVIDIA. Ele gosta de educar os clientes de nuvem sobre as tecnologias de IA de GPU que a NVIDIA tem a oferecer e ajudá-los a acelerar seus aplicativos de aprendizado de máquina e aprendizado profundo. Fora do trabalho, ele gosta de correr, fazer caminhadas e observar a vida selvagem.

Kshitiz Gupta é arquiteto de soluções da NVIDIA. Ele gosta de educar os clientes de nuvem sobre as tecnologias de IA de GPU que a NVIDIA tem a oferecer e ajudá-los a acelerar seus aplicativos de aprendizado de máquina e aprendizado profundo. Fora do trabalho, ele gosta de correr, fazer caminhadas e observar a vida selvagem.

Jiahong Liu é arquiteto de soluções na equipe de provedores de serviços de nuvem da NVIDIA. Ele auxilia os clientes na adoção de soluções de aprendizado de máquina e IA que aproveitam a computação acelerada da NVIDIA para enfrentar seus desafios de treinamento e inferência. Em seu tempo de lazer, ele gosta de origami, projetos de bricolage e jogar basquete.

Jiahong Liu é arquiteto de soluções na equipe de provedores de serviços de nuvem da NVIDIA. Ele auxilia os clientes na adoção de soluções de aprendizado de máquina e IA que aproveitam a computação acelerada da NVIDIA para enfrentar seus desafios de treinamento e inferência. Em seu tempo de lazer, ele gosta de origami, projetos de bricolage e jogar basquete.

Tugrul Konuk é arquiteto de soluções sênior na NVIDIA, especializado em treinamento em larga escala, aprendizado profundo multimodal e computação científica de alto desempenho. Antes da NVIDIA, ele trabalhou no setor de energia, com foco no desenvolvimento de algoritmos para imagens computacionais. Como parte de seu doutorado, ele trabalhou em aprendizado profundo baseado em física para simulações numéricas em escala. Nas horas de lazer gosta de ler, tocar violão e piano.

Tugrul Konuk é arquiteto de soluções sênior na NVIDIA, especializado em treinamento em larga escala, aprendizado profundo multimodal e computação científica de alto desempenho. Antes da NVIDIA, ele trabalhou no setor de energia, com foco no desenvolvimento de algoritmos para imagens computacionais. Como parte de seu doutorado, ele trabalhou em aprendizado profundo baseado em física para simulações numéricas em escala. Nas horas de lazer gosta de ler, tocar violão e piano.

Rohil Bhargava é gerente de marketing de produtos da NVIDIA, com foco na implantação de estruturas de aplicativos e SDKs da NVIDIA em plataformas CSP específicas.

Rohil Bhargava é gerente de marketing de produtos da NVIDIA, com foco na implantação de estruturas de aplicativos e SDKs da NVIDIA em plataformas CSP específicas.

Eliuth Triana Isaza é gerente de relações com desenvolvedores da NVIDIA, capacitando AI MLOps, DevOps, cientistas e especialistas técnicos da AWS da Amazon para dominar a pilha de computação da NVIDIA para acelerar e otimizar modelos Generative AI Foundation que abrangem desde curadoria de dados, treinamento de GPU, inferência de modelo e implantação de produção em instâncias de GPU da AWS . Além disso, Eliuth é um apaixonado ciclista de montanha, esquiador, jogador de tênis e pôquer.

Eliuth Triana Isaza é gerente de relações com desenvolvedores da NVIDIA, capacitando AI MLOps, DevOps, cientistas e especialistas técnicos da AWS da Amazon para dominar a pilha de computação da NVIDIA para acelerar e otimizar modelos Generative AI Foundation que abrangem desde curadoria de dados, treinamento de GPU, inferência de modelo e implantação de produção em instâncias de GPU da AWS . Além disso, Eliuth é um apaixonado ciclista de montanha, esquiador, jogador de tênis e pôquer.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/how-amazon-music-uses-sagemaker-with-nvidia-to-optimize-ml-training-and-inference-performance-and-cost/

- :tem

- :é

- :não

- :onde

- $UP

- 100

- 12

- 25

- 32

- 35%

- 7

- 8

- a

- Capaz

- Sobre

- acelerado

- acelerando

- aceleração

- Acesso

- realizar

- precisão

- preciso

- Alcançar

- alcançado

- em

- ativo

- Adição

- endereço

- Adotando

- anúncios

- afetando

- Depois de

- AI

- Modelos de IA

- casos de uso ai

- Álbum

- algoritmos

- Todos os Produtos

- permitir

- permitidas

- Permitindo

- permite

- tb

- sempre

- Amazon

- Amazon Web Services

- Amazon.com

- an

- e

- Aplicação

- aplicações

- abordagem

- arquitetos

- SOMOS

- ÁREA

- áreas

- por aí

- artista

- AS

- ajudando

- ajuda

- At

- média

- AWS

- Backend

- Equilíbrio

- equilíbrio

- Barra

- baseado

- Linha de Base

- Basquetebol

- Bay

- BE

- passou a ser

- Porque

- Benefícios

- MELHOR

- Melhor

- impulsionar

- aumenta

- ambos

- trazer

- amplo

- construir

- construído

- by

- CAN

- capacidades

- capacidade

- capturar

- Cuidado

- Oportunidades

- cuidadosamente

- casos

- desafios

- desafiante

- de cores

- verificar

- acalentado

- escolhas

- clientes

- Na nuvem

- código

- COM

- como

- comunicação

- Empresas

- comparado

- computacional

- computação

- concorrente

- Configuração

- Recipiente

- conteúdo

- Convergência

- núcleo

- Custo

- custos

- artesanato

- crítico

- crucial

- CSP

- curadoria

- personalizadas

- cliente

- experiência do cliente

- Clientes

- dados,

- Data

- dias

- diminuiu

- profundo

- deep learning

- atrasos

- entregar

- entregando

- entrega

- Demanda

- implantar

- Implantação

- desenvolvimento

- Design

- Developer

- em desenvolvimento

- Desenvolvimento

- diferente

- difícil

- diretamente

- mergulho

- diferente

- Diy

- não

- drasticamente

- durante

- dinâmico

- e

- e-commerce,

- Cedo

- educar

- eficiência

- eficiente

- esforço

- elevado

- embutindo

- emoções

- empregando

- capacitação

- habilitado

- encorajar

- end-to-end

- energia

- Engenheiros

- Melhora

- suficiente

- assegurando

- especialmente

- etc.

- avaliação

- Mesmo

- Cada

- execução

- vasta experiência

- Experiências

- especialistas

- RÁPIDO

- Funcionalidades

- Figura

- Finalmente

- Encontre

- descoberta

- Primeiro nome

- Flexibilidade

- inundação

- Foco

- focado

- focando

- seguinte

- Escolha

- formato

- Foundation

- Quadro

- enquadramentos

- da

- frustrante

- totalmente

- funcionalidades

- mais distante

- fusão

- porta de entrada

- geração

- generativo

- IA generativa

- GPU

- GPUs

- Alças

- acontecer

- Hardware

- Ter

- he

- pesado

- levantamento pesado

- ajudar

- útil

- ajuda

- Alta

- de alto nível

- alta performance

- ele

- sua

- detém

- hospedagem

- HORÁRIO

- Como funciona o dobrador de carta de canal

- Contudo

- HTML

- HTTPS

- identificar

- if

- ilustra

- Imagiologia

- executar

- importante

- melhorar

- melhorado

- melhoria

- in

- inclui

- Crescimento

- aumentou

- aumentando

- indústria

- ineficiente

- influência

- Infraestrutura

- do estado inicial,

- instância

- imediatamente

- em vez disso

- interesse

- para dentro

- introduzir

- introduzindo

- IT

- ESTÁ

- viagem

- jpg

- apenas por

- Chave

- Tipo

- Saber

- conhecido

- Laboratório

- língua

- grande

- em grande escala

- Maior

- duradouro

- Latência

- mais recente

- camada

- conduzir

- principal

- APRENDER

- aprendizagem

- Alavancagem

- Biblioteca

- facelift

- como

- limites

- carregar

- procurando

- Baixo

- diminuir

- máquina

- aprendizado de máquina

- a manter

- principal

- fazer

- FAZ

- Gerente

- gestão

- Marketing

- dominar

- Maximizar

- Posso..

- Memórias

- Memória

- Meta

- Coração

- milhão

- milhões

- milissegundos

- mínimo

- erro

- misto

- ML

- MLOps

- modelo

- modelagem

- modelos

- Módulos

- dinheiro

- mais

- a maioria

- Montanha

- múltiplos

- múltiplo

- Música

- devo

- nome

- necessário

- negativamente

- redes

- Novo

- PNL

- Nvidia

- of

- oferecer

- Oferece

- on

- ONE

- só

- aberto

- open source

- operando

- operacional

- Operações

- ideal

- otimização

- Otimize

- otimizado

- otimizando

- or

- orquestrada

- ordem

- Outros

- Fora

- lado de fora

- marcante

- Acima de

- global

- próprio

- parâmetros

- parte

- particular

- particularmente

- parceria

- apaixonado

- Pico

- percentagem

- atuação

- pessoal

- Personalizado

- phd

- oleoduto

- plataforma

- Plataformas

- platão

- Inteligência de Dados Platão

- PlatãoData

- jogador

- jogar

- Podcast

- Podcasts

- ponto

- Pôquer

- possível

- Publique

- potencial

- poder

- alimentado

- Precisão

- Prévio

- Priorizar

- prioridade

- problemas

- processo

- Produto

- Produção

- projetos

- fornecer

- provedor

- fornece

- fornecendo

- Python

- Links

- Posição

- Leitura

- em tempo real

- redução

- referir

- relacionado

- relações

- relevância

- relevante

- confiável

- pedidos

- exige

- Recursos

- respostas

- responsabilidade

- responsável

- responsivo

- resultando

- Resultados

- Rico

- certo

- corrida

- é executado

- tempo de execução

- sábio

- mesmo

- Salvar

- poupança

- escalável

- Escala

- Ciência

- científico

- cientistas

- Sdk

- SDK

- sem problemas

- Pesquisar

- pesquisas

- pesquisar

- Segundo

- seções

- Vejo

- busca

- aparentemente

- semântica

- senior

- sensível

- sentença

- servir

- servidor

- serviço

- Provedor de Serviço

- Serviços

- de servir

- conjunto

- Configurações

- vários

- Partilhar

- compartilhado

- Shows

- periodo

- de forma considerável

- simples

- senta

- Tamanho

- tamanhos

- smart

- Software

- desenvolvimento de software

- solução

- Soluções

- canção

- fonte

- abrangendo

- especializada

- especializando

- específico

- velocidade

- SOLETRAR

- ortografia

- gasto

- pilha

- Comece

- Startups

- permanecendo

- estável

- Passo

- Passos

- História

- de streaming

- tal

- topo

- ajuda

- Suportado

- certo

- tomado

- tomar

- alvejando

- Profissionais

- tecnologia

- Dados Técnicos:

- técnica

- técnicas

- Tecnologias

- Tecnologia

- texto

- que

- A

- deles

- Eles

- Lá.

- assim sendo

- Este

- deles

- coisas

- isto

- Através da

- Taxa de transferência

- tempo

- vezes

- Título

- para

- juntos

- tokenization

- Tokens

- levou

- ferramenta

- topo

- tps

- tráfego

- Trem

- treinado

- Training

- transformador

- Tendências

- Tritão

- verdadeiro

- dois

- compreensão

- sem dúvida

- Universo

- Desbloqueio

- revelou

- us

- usar

- usava

- usuários

- usos

- utilização

- Utilizando

- valor

- Grande

- versatilidade

- muito

- Esperando

- andar

- Walmart

- foi

- assistindo

- maneiras

- we

- web

- serviços web

- BEM

- foram

- quando

- enquanto que

- enquanto

- precisarão

- de

- Atividades:

- trabalhou

- trabalhar

- trabalho

- mundo

- preocupar-se

- ainda

- rendido

- Vocês

- investimentos

- zefirnet