Este é um post convidado de coautoria de Nafi Ahmet Turgut, Hasan Burak Yel e Damla Şentürk de Getir.

Fundada em 2015, trouxe posicionou-se como pioneira na esfera da entrega ultrarrápida de alimentos. Esta empresa tecnológica inovadora revolucionou o segmento de entrega de última milha com a sua atraente oferta de “mercadorias em minutos”. Com presença na Turquia, Reino Unido, Holanda, Alemanha e Estados Unidos, Getir tornou-se uma força multinacional a ser reconhecida. Hoje, a marca Getir representa um conglomerado diversificado que abrange nove verticais diferentes, todas trabalhando sinergicamente sob um guarda-chuva único.

Nesta postagem, explicamos como construímos um pipeline completo de previsão de categoria de produto para ajudar as equipes comerciais usando Amazon Sage Maker e Lote da AWS, reduzindo a duração do treinamento do modelo em 90%.

Compreender detalhadamente a nossa gama de produtos existente é um desafio crucial que nós, juntamente com muitas empresas, enfrentamos no mercado competitivo e acelerado de hoje. Uma solução eficaz para este problema é a previsão de categorias de produtos. Um modelo que gera uma árvore de categorias abrangente permite que nossas equipes comerciais comparem nosso portfólio de produtos existente com o de nossos concorrentes, oferecendo uma vantagem estratégica. Portanto, nosso desafio central é a criação e implementação de um modelo preciso de previsão de categorias de produtos.

Aproveitamos as ferramentas poderosas fornecidas pela AWS para enfrentar esse desafio e navegar com eficácia no complexo campo do aprendizado de máquina (ML) e da análise preditiva. Nossos esforços levaram à criação bem-sucedida de um pipeline completo de previsão de categorias de produtos, que combina os pontos fortes do SageMaker e do AWS Batch.

Esta capacidade de análise preditiva, especialmente a previsão precisa de categorias de produtos, provou ser inestimável. Forneceu às nossas equipes insights críticos baseados em dados que otimizaram o gerenciamento de estoque, aprimoraram as interações com os clientes e fortaleceram nossa presença no mercado.

A metodologia que explicamos neste post vai desde a fase inicial de coleta do conjunto de recursos até a implementação final do pipeline de previsão. Um aspecto importante de nossa estratégia tem sido o uso do SageMaker e do AWS Batch para refinar modelos BERT pré-treinados para sete linguagens diferentes. Além disso, nossa integração perfeita com o serviço de armazenamento de objetos da AWS Serviço de armazenamento simples da Amazon (Amazon S3) tem sido fundamental para armazenar e acessar com eficiência esses modelos refinados.

SageMaker é um serviço de ML totalmente gerenciado. Com o SageMaker, cientistas de dados e desenvolvedores podem construir e treinar modelos de ML de forma rápida e fácil e, em seguida, implantá-los diretamente em um ambiente hospedado pronto para produção.

Como um serviço totalmente gerenciado, o AWS Batch ajuda você a executar cargas de trabalho de computação em lote de qualquer escala. O AWS Batch provisiona automaticamente recursos de computação e otimiza a distribuição da carga de trabalho com base na quantidade e na escala das cargas de trabalho. Com o AWS Batch, não há necessidade de instalar ou gerenciar software de computação em lote, para que você possa concentrar seu tempo na análise de resultados e na solução de problemas. Usamos trabalhos de GPU que nos ajudam a executar trabalhos que usam GPUs de uma instância.

Visão geral da solução

Cinco pessoas da equipe de ciência de dados e da equipe de infraestrutura da Getir trabalharam juntas neste projeto. O projeto foi concluído em um mês e colocado em produção após uma semana de testes.

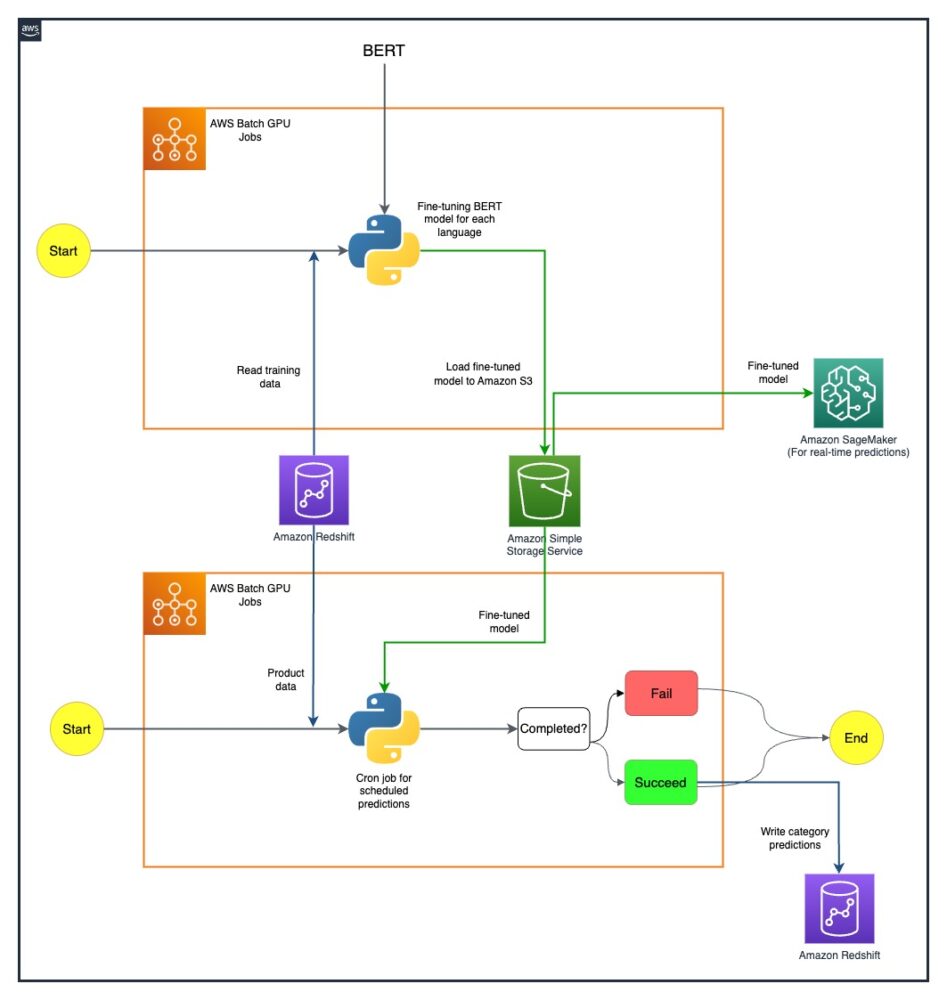

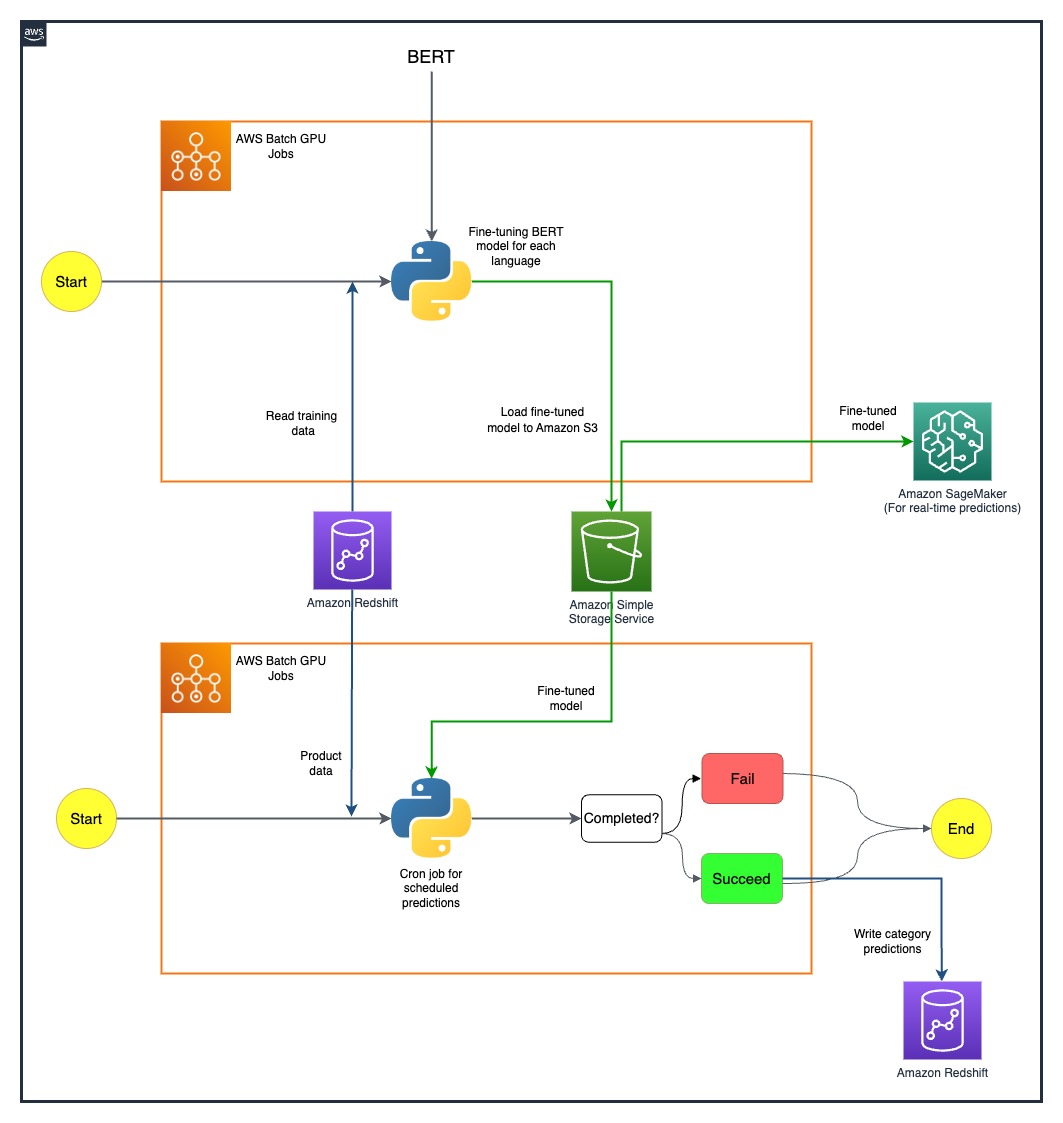

O diagrama a seguir mostra a arquitetura da solução.

O pipeline modelo é executado separadamente para cada país. A arquitetura inclui dois cron jobs de GPU do AWS Batch para cada país, executados em programações definidas.

Superamos alguns desafios ao implantar estrategicamente recursos de GPU SageMaker e AWS Batch. O processo usado para resolver cada dificuldade é detalhado nas seções a seguir.

Ajustando modelos BERT multilíngues com trabalhos de GPU do AWS Batch

Procuramos uma solução para oferecer suporte a vários idiomas para nossa diversificada base de usuários. Os modelos BERT foram uma escolha óbvia devido à sua capacidade estabelecida de lidar com tarefas complexas de linguagem natural de forma eficaz. Para adaptar esses modelos às nossas necessidades, aproveitamos o poder da AWS usando trabalhos de instância de GPU de nó único. Isso nos permitiu ajustar modelos BERT pré-treinados para cada um dos sete idiomas para os quais precisávamos de suporte. Através deste método, garantimos alta precisão na previsão de categorias de produtos, superando quaisquer potenciais barreiras linguísticas.

Armazenamento eficiente de modelos usando Amazon S3

Nosso próximo passo foi abordar o armazenamento e o gerenciamento de modelos. Para isso, selecionamos o Amazon S3, conhecido por sua escalabilidade e segurança. Armazenar nossos modelos BERT ajustados no Amazon S3 nos permitiu fornecer acesso fácil a diferentes equipes em nossa organização, simplificando significativamente nosso processo de implantação. Este foi um aspecto crucial para alcançarmos agilidade nas nossas operações e uma integração perfeita dos nossos esforços de ML.

Criando um pipeline de previsão de ponta a ponta

Foi necessário um pipeline eficiente para fazer o melhor uso de nossos modelos pré-treinados. Implementamos primeiro esses modelos no SageMaker, uma ação que permitiu previsões em tempo real com baixa latência, melhorando assim a experiência do usuário. Para previsões em lote em maior escala, que eram igualmente vitais para nossas operações, utilizamos trabalhos de GPU do AWS Batch. Isto garantiu a utilização ideal dos nossos recursos, proporcionando-nos um equilíbrio perfeito entre desempenho e eficiência.

Explorando possibilidades futuras com SageMaker MMEs

À medida que continuamos a evoluir e buscar eficiência em nosso pipeline de ML, um caminho que estamos ansiosos para explorar é usar endpoints multimodelos (MMEs) SageMaker para implantar nossos modelos ajustados. Com os MMEs, podemos agilizar potencialmente a implantação de vários modelos ajustados, garantindo um gerenciamento eficiente de modelos e, ao mesmo tempo, nos beneficiando dos recursos nativos do SageMaker, como variantes de sombra, escalonamento automático e Amazon CloudWatch integração. Essa exploração está alinhada com nossa busca contínua de aprimorar nossos recursos de análise preditiva e fornecer experiências superiores aos nossos clientes.

Conclusão

Nossa integração bem-sucedida do SageMaker e do AWS Batch não apenas abordou nossos desafios específicos, mas também aumentou significativamente nossa eficiência operacional. Através da implementação de um sofisticado pipeline de previsão de categorias de produtos, somos capazes de capacitar as nossas equipas comerciais com insights baseados em dados, facilitando assim uma tomada de decisões mais eficaz.

Nossos resultados falam muito sobre a eficácia de nossa abordagem. Alcançamos uma precisão de previsão de 80% em todos os quatro níveis de granularidade de categoria, o que desempenha um papel importante na definição da variedade de produtos para cada país que atendemos. Esse nível de precisão amplia nosso alcance além das barreiras linguísticas e garante que atendamos à nossa diversificada base de usuários com a máxima precisão.

Além disso, ao usar estrategicamente trabalhos agendados de GPU do AWS Batch, conseguimos reduzir a duração do treinamento do nosso modelo em 90%. Essa eficiência agilizou ainda mais nossos processos e reforçou nossa agilidade operacional. O armazenamento eficiente de modelos usando o Amazon S3 desempenhou um papel fundamental nessa conquista, equilibrando previsões em tempo real e em lote.

Para obter mais informações sobre como começar a criar seus próprios pipelines de ML com o SageMaker, consulte Recursos do Amazon SageMaker. O AWS Batch é uma excelente opção se você estiver procurando uma solução escalonável e de baixo custo para executar trabalhos em lote com baixa sobrecarga operacional. Para começar, veja Conceitos básicos do AWS Batch.

Sobre os autores

Nafi Ahmet Turgut concluiu seu mestrado em Engenharia Elétrica e Eletrônica e trabalhou como pesquisador graduado. Seu foco era construir algoritmos de aprendizado de máquina para simular anomalias em redes nervosas. Ele ingressou na Getir em 2019 e atualmente trabalha como gerente sênior de ciência de dados e análise. Sua equipe é responsável por projetar, implementar e manter algoritmos de aprendizado de máquina ponta a ponta e soluções baseadas em dados para Getir.

Nafi Ahmet Turgut concluiu seu mestrado em Engenharia Elétrica e Eletrônica e trabalhou como pesquisador graduado. Seu foco era construir algoritmos de aprendizado de máquina para simular anomalias em redes nervosas. Ele ingressou na Getir em 2019 e atualmente trabalha como gerente sênior de ciência de dados e análise. Sua equipe é responsável por projetar, implementar e manter algoritmos de aprendizado de máquina ponta a ponta e soluções baseadas em dados para Getir.

Hasan Burak Yel recebeu seu diploma de bacharel em Engenharia Elétrica e Eletrônica pela Universidade Boğaziçi. Ele trabalhou na Turkcell, focado principalmente em previsão de séries temporais, visualização de dados e automação de redes. Ele ingressou na Getir em 2021 e atualmente trabalha como Data Science & Analytics Manager com responsabilidade pelos domínios de pesquisa, recomendação e crescimento.

Hasan Burak Yel recebeu seu diploma de bacharel em Engenharia Elétrica e Eletrônica pela Universidade Boğaziçi. Ele trabalhou na Turkcell, focado principalmente em previsão de séries temporais, visualização de dados e automação de redes. Ele ingressou na Getir em 2021 e atualmente trabalha como Data Science & Analytics Manager com responsabilidade pelos domínios de pesquisa, recomendação e crescimento.

Damla Şentürk recebeu seu diploma de bacharel em Engenharia da Computação pela Universidade Galatasaray. Ela continua seu mestrado em Engenharia da Computação na Universidade Boğaziçi. Ela ingressou na Getir em 2022 e trabalha como Cientista de Dados. Ela trabalhou em projetos comerciais, de cadeia de suprimentos e relacionados a descobertas.

Damla Şentürk recebeu seu diploma de bacharel em Engenharia da Computação pela Universidade Galatasaray. Ela continua seu mestrado em Engenharia da Computação na Universidade Boğaziçi. Ela ingressou na Getir em 2022 e trabalha como Cientista de Dados. Ela trabalhou em projetos comerciais, de cadeia de suprimentos e relacionados a descobertas.

Esra Kayabali é arquiteto de soluções sênior na AWS, especializado no domínio analítico, incluindo armazenamento de dados, data lakes, análise de big data, streaming de dados em lote e em tempo real e integração de dados. Ela tem 12 anos de experiência em desenvolvimento de software e arquitetura. Ela é apaixonada por aprender e ensinar tecnologias em nuvem.

Esra Kayabali é arquiteto de soluções sênior na AWS, especializado no domínio analítico, incluindo armazenamento de dados, data lakes, análise de big data, streaming de dados em lote e em tempo real e integração de dados. Ela tem 12 anos de experiência em desenvolvimento de software e arquitetura. Ela é apaixonada por aprender e ensinar tecnologias em nuvem.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://aws.amazon.com/blogs/machine-learning/how-getir-reduced-model-training-durations-by-90-with-amazon-sagemaker-and-aws-batch/

- :tem

- :é

- :não

- 100

- 12

- 2015

- 2019

- 2021

- 2022

- 7

- a

- habilidade

- Capaz

- Sobre

- Acesso

- acessando

- precisão

- preciso

- alcançado

- realização

- alcançar

- em

- Açao Social

- Adicionalmente

- endereço

- endereçado

- Vantagem

- Depois de

- contra

- algoritmos

- Alinha

- Todos os Produtos

- permitidas

- permite

- juntamente

- tb

- Amazon

- Amazon Sage Maker

- Amazon Web Services

- an

- analítica

- análise

- e

- e infra-estrutura

- anomalias

- qualquer

- arquitetura

- SOMOS

- AS

- aspecto

- sortimento

- At

- auto

- automaticamente

- Automação

- Avenida

- AWS

- Equilíbrio

- equilíbrio

- barreiras

- base

- baseado

- BE

- tornam-se

- sido

- referência

- beneficiando

- MELHOR

- Pós

- Grande

- Big Data

- Impulsionado

- ambos

- interesse?

- construir

- Prédio

- construído

- negócios

- mas a

- by

- CAN

- capacidades

- capacidade

- maiúsculo

- Categorias

- Categoria

- fornecer

- central

- cadeia

- desafiar

- desafios

- escolha

- Na nuvem

- combina

- comercial

- Empresa

- atraente

- competitivo

- concorrentes

- Efetuado

- integrações

- compreensivo

- Computar

- computador

- Engenharia computacional

- computação

- conglomerado

- continuar

- continua

- contínuo

- país

- criação

- crítico

- crucial

- Atualmente

- cliente

- Clientes

- dados,

- Análise de Dados

- ciência de dados

- cientista de dados

- Visualização de dados

- orientado por dados

- Tomada de Decisão

- definido

- Grau

- Entrega

- implantar

- implantado

- Implantação

- desenvolvimento

- concepção

- detalhado

- desenvolvedores

- Desenvolvimento

- diferente

- Dificuldade

- diretamente

- distribuição

- diferente

- diversificado

- domínio

- domínios

- dois

- duração

- cada

- fácil

- Eficaz

- efetivamente

- eficácia

- eficiências

- eficiência

- eficiente

- eficientemente

- sem esforço

- esforços

- Eletrônicos

- autorizar

- habilitado

- abrangente

- end-to-end

- Engenharia

- aprimorada

- aprimorando

- assegurada

- garante

- assegurando

- Meio Ambiente

- igualmente

- estabelecido

- evolui

- excelente

- existente

- vasta experiência

- Experiências

- Explicação

- exploração

- explorar

- se estende

- Rosto

- facilitando

- ritmo acelerado

- Característica

- campo

- final

- Primeiro nome

- Foco

- focado

- seguinte

- Escolha

- força

- Previsão

- quatro

- da

- totalmente

- mais distante

- futuro

- coleta

- gera

- Alemanha

- ter

- GPU

- GPUs

- pós-graduação

- Growth

- Locatário

- Visitante Mensagem

- manipular

- Ter

- he

- ajudar

- ajuda

- sua experiência

- Alta

- sua

- hospedado

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTML

- http

- HTTPS

- if

- implementação

- implementação

- importante

- aspecto importante

- in

- inclui

- Incluindo

- INFORMAÇÕES

- Infraestrutura

- do estado inicial,

- inovadores

- insights

- instalar

- instância

- integração

- interações

- para dentro

- inestimável

- inventário

- Gestão de Inventário

- IT

- ESTÁ

- se

- Empregos

- ingressou

- jpg

- Afiado

- Chave

- conhecido

- lagos

- língua

- Idiomas

- Latência

- aprendizagem

- levou

- Nível

- níveis

- como

- procurando

- Baixo

- baixo custo

- máquina

- aprendizado de máquina

- principalmente

- Manter

- fazer

- gerencia

- gerenciados

- de grupos

- Gerente

- maneira

- muitos

- mercado

- mestre

- método

- Metodologia

- Minutos

- ML

- modelo

- modelos

- Mês

- mais

- multinacional

- múltiplo

- nativo

- natural

- Navegar

- você merece...

- Cria

- Nederland

- rede

- Próximo

- nove

- não

- objeto

- óbvio

- of

- oferecendo treinamento para distância

- on

- ONE

- só

- operacional

- Operações

- ideal

- otimizado

- Otimiza

- Opção

- or

- ordem

- organização

- A Nossa

- superação

- próprio

- particularmente

- apaixonado

- Pessoas

- perfeita

- atuação

- fase

- oleoduto

- platão

- Inteligência de Dados Platão

- PlatãoData

- desempenhado

- desempenha

- pasta

- posicionado

- possibilidades

- Publique

- potencial

- potencialmente

- poder

- poderoso

- Precisão

- prevendo

- predição

- Previsões

- Análise Preditiva

- presença

- Problema

- problemas

- processo

- processos

- Produto

- Produção

- projeto

- projetos

- comprovado

- fornecer

- fornecido

- fornecendo

- busca

- quantidade

- rapidamente

- gamas

- alcançar

- em tempo real

- dados em tempo real

- recebido

- Recomendação

- reduzir

- Reduzido

- redução

- refinar

- refinado

- representa

- requeridos

- pesquisa

- Recursos

- responsabilidade

- responsável

- Resultados

- revolucionou

- Tipo

- Execute

- corrida

- sábio

- AMPLIAR

- escalável

- Escala

- dimensionamento

- programado

- Ciência

- Cientista

- cientistas

- desatado

- Pesquisar

- seções

- segurança

- Vejo

- Buscar

- segmento

- selecionado

- senior

- Série

- servir

- serviço

- Serviços

- conjunto

- Sete

- Shadow

- formação

- ela

- Shows

- de forma considerável

- simples

- singular

- So

- Software

- desenvolvimento de software

- solução

- Soluções

- Resolvendo

- alguns

- sofisticado

- solicitado

- falar

- especializado

- específico

- começado

- Unidos

- Passo

- armazenamento

- armazenar

- Estratégico

- Estrategicamente

- Estratégia

- de streaming

- simplificar

- simplificada

- racionalização

- fortalecido

- pontos fortes

- bem sucedido

- topo

- supply

- cadeia de suprimentos

- ajuda

- equipamento

- Alfaiate

- tarefas

- Ensino

- Profissionais

- equipes

- tecnologia

- Empresa de Tecnologia

- Tecnologias

- ensaio

- que

- A

- Países Baixos

- do Reino Unido

- deles

- Eles

- então

- assim

- assim sendo

- Este

- isto

- Através da

- tempo

- Séries temporais

- para

- hoje

- hoje

- juntos

- ferramentas

- pioneiro

- Trem

- Training

- árvore

- Peru

- dois

- Uk

- guarda-chuva

- para

- Unido

- Estados Unidos

- universidade

- us

- usar

- usava

- Utilizador

- Experiência do Usuário

- utilização

- utilizado

- máximo

- vário

- Verticais

- visualização

- vital

- volumes

- foi

- we

- web

- serviços web

- semana

- foram

- qual

- enquanto

- de

- dentro

- trabalhou

- trabalhar

- trabalho

- anos

- Vocês

- investimentos

- zefirnet