Treinamos e estamos abrindo o código-fonte de uma rede neural chamada Whisper que se aproxima da robustez e precisão do nível humano no reconhecimento de fala em inglês.

Ver código

Ver cartão modelo

Exemplos de sussurros:

Whisper é um sistema de reconhecimento automático de fala (ASR) treinado em 680,000 horas de dados supervisionados multilíngues e multitarefa coletados da web. Mostramos que o uso de um conjunto de dados tão grande e diversificado leva a uma maior robustez aos sotaques, ao ruído de fundo e à linguagem técnica. Além disso, permite a transcrição em vários idiomas, bem como a tradução desses idiomas para o inglês. Somos modelos de código aberto e código de inferência para servir de base para a construção de aplicativos úteis e para pesquisas futuras sobre processamento robusto de fala.

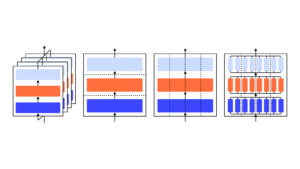

A arquitetura Whisper é uma abordagem simples de ponta a ponta, implementada como um transformador codificador-decodificador. O áudio de entrada é dividido em pedaços de 30 segundos, convertido em um espectrograma log-Mel e depois passado para um codificador. Um decodificador é treinado para prever a legenda de texto correspondente, misturada com tokens especiais que direcionam o modelo único para executar tarefas como identificação de idioma, carimbos de data/hora em nível de frase, transcrição de fala multilíngue e tradução de fala para inglês.

Outras abordagens existentes frequentemente usam conjuntos de dados de treinamento de áudio-texto menores e mais estreitamente emparelhadosou use pré-treinamento de áudio amplo, mas não supervisionado. Como o Whisper foi treinado em um conjunto de dados grande e diversificado e não foi ajustado para nenhum específico, ele não supera os modelos especializados no desempenho do LibriSpeech, uma referência competitiva notoriamente em reconhecimento de fala. No entanto, quando medimos o desempenho zero-shot do Whisper em diversos conjuntos de dados, descobrimos que ele é muito mais robusto e comete 50% menos erros do que esses modelos.

Cerca de um terço do conjunto de dados de áudio do Whisper não está em inglês e ele recebe alternadamente a tarefa de transcrever no idioma original ou traduzir para o inglês. Descobrimos que esta abordagem é particularmente eficaz no aprendizado da tradução de fala para texto e supera o SOTA supervisionado no CoVoST2 para tradução em inglês.

Esperamos que a alta precisão e facilidade de uso do Whisper permitam aos desenvolvedores adicionar interfaces de voz a um conjunto muito mais amplo de aplicativos. Confira a papel, cartão modelo e código para saber mais detalhes e experimentar o Whisper.

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- OpenAI

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- pesquisa

- escala ai

- sintaxe

- zefirnet