Algo para o fim de semana Um robô está realizando uma dança interpretativa na minha porta.

VOCÊ LEVA ESTE PACOTE PARA O SEU VIZINHO? ele pergunta, pulando de um pé para o outro.

"Claro", eu digo. "Er... você está bem?"

ESTOU EXPRESSANDO A EMOÇÃO, afirma o bot de entrega, entregando o pacote, mas sem oferecer mais detalhes.

Que emoção poderia ser? Um pé, depois o outro, depois os outros dois (tem quatro). Vai e volta.

“Você precisa ir ao banheiro?”

ESTOU EXPRESSANDO ARREPENDIMENTO DE TE PEDI PARA LEVAR UM PACOTE PARA O SEU VIZINHO.

“Isso é 'arrependimento', é? Bem, não há necessidade. Eu não me importo de jeito nenhum.”

Continua sua dança na minha frente.

“Suba as escadas e primeiro à sua direita.”

Obrigado, eu estava morrendo de vontade de fazer xixi, ele responde enquanto passa cautelosamente por mim e sobe as escadas para se aliviar. É uma vida difícil fazer entregas, seja você um “hume” ou um bot.

...

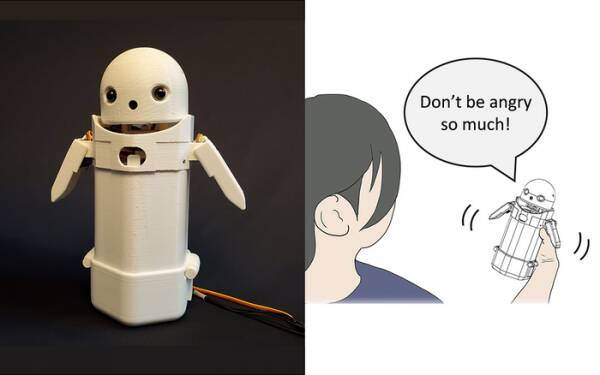

No início deste ano, pesquisadores da Universidade de Tsukuba construíram um dispositivo portátil de mensagens de texto, colocou um pequeno rosto de robô no topo e incluiu um peso móvel dentro. Ao deslocar o peso interno, o robô mensageiro tentaria transmitir emoções sutis enquanto falava mensagens em voz alta.

Em particular, os testes revelaram que mensagens frustrantes como: “Desculpe, chegarei atrasado” foram aceitas pelos destinatários com mais graça e paciência quando a pequena mudança de peso foi ativada dentro do dispositivo. A teoria é que isso ajudou os usuários a apreciar o tom de desculpas da mensagem e, assim, acalmou sua reação a ela.

Considere essa pesquisa como um artifício, se quiser, mas não está muito longe de adicionar smileys e emojis às mensagens. Todo mundo sabe que você pode tirar a raiva de “WTF!?” adicionando :-) logo depois.

O desafio, então, é determinar se o público em geral concorda com quais emoções cada permutação de mudança de peso em um dispositivo portátil deve transmitir. Uma inclinação para a esquerda significa alegria? Ou incerteza? Ou que seu tio tem um dirigível?

Há uma década, o Reino Unido tinha um primeiro-ministro simpático, mas sombrio, que achava que “LOL” era um acrônimo para “muito amor”. Ele estava digitando no final de todas as suas mensagens privadas para funcionários, colegas e terceiros na expectativa de que isso o fizesse parecer caloroso e amigável. Todo mundo naturalmente assumiu que ele estava tirando sarro.

Se nada mais, a pesquisa da Universidade de Tsukuba reconhece que você não precisa de uma inteligência artificial avançada para interagir com humanos de forma convincente. Tudo o que você precisa fazer é manipular a psicologia humana para enganá-los e fazê-los pensar que estão conversando com outro humano. Assim, o Teste de Turing não é fundamentalmente um teste de sensibilidade da IA, mas um teste de conforto emocional humano – credulidade, mesmo – e não há nada de errado com isso.

O robô de mensagens de compartilhamento de emoções da Universidade de Tsukuba. Crédito: Universidade de Tsukuba

Essas coisas são o tópico da semana, é claro, com a história do muito difamado engenheiro de software do Google, Blake Lemoine atingindo as principais notícias. Ele aparentemente expressou, fortemente, sua opinião de que o projeto Language Model for Dialogue Applications (LaMDA) da empresa estava exibindo sinais externos de sensibilidade.

Todo mundo tem uma opinião, então eu decidi não.

É, no entanto, o Santo Graal da IA fazê-la pensar por si mesma. Se não puder fazer isso, é apenas um programa executando as instruções que você programou nele. No mês passado eu estava lendo sobre um chef robô que podem fazer omeletes de tomate com sabores diferentes para atender aos gostos de diferentes pessoas. Constrói “mapas gustativos” para avaliar a salinidade do prato enquanto o prepara, aprendendo à medida que avança. Mas isso é apenas aprender, não pensar por si mesmo.

Venha para o Zom-Zoms, hein? Nós iremos, é um lugar para comer.

O grande problema com os bots de IA, pelo menos como foram criados até agora, é que eles absorvem qualquer merda antiga que você alimenta neles. Exemplos de viés de dados nos chamados sistemas de aprendizado de máquina (um tipo de “algoritmo”, acredito, m'lud) vêm se acumulando há anos, desde o notório Twitter racista da Microsoft Tay chatbot à autoridade fiscal holandesa no ano passado avaliando falsamente reivindicações válidas de benefícios para crianças como fraudulentas e marcando famílias inocentes como de alto risco por terem a temeridade de serem pobres e não brancas.

Uma abordagem que está sendo testada na Universidade da Califórnia em San Diego é projetar um modelo de linguagem [PDF] que determina continuamente a diferença entre coisas safadas e boas, que então treina o chatbot como se comportar. Dessa forma, você não tem humanos chatos fazendo uma bagunça de moderar fóruns e conversas de chatbot voltadas para o cliente com toda a precisão cirúrgica de um facão.

Obviamente, o problema é que o chatbot bem treinado descobre que pode evitar de maneira mais eficaz ser atraído para brincadeiras tóxicas, evitando tópicos que tenham o mais remoto indício de contenção sobre eles. Para evitar falar palavrões racistas por engano, ele simplesmente se recusa a se envolver em discussões sobre grupos sub-representados… o que é realmente ótimo se você for racista.

Se eu tivesse uma observação sobre o desastre do LaMDA – não uma opinião, lembre-se – seria que os profissionais de marketing do Google provavelmente ficaram um pouco irritados com o fato de a história ter evitado seu recente anúncio de Cozinha de teste de IA abaixo da dobra.

Agora, os poucos primeiros inscritos restantes que não se esqueceram completamente deste próximo projeto de aplicativo vão assumir que envolve conversar tediosas com uma criança de sete anos consciente e precoce sobre o significado da existência e decidir que estão “um pouco ocupados hoje” e pode fazer logon amanhã em vez disso. Ou semana que vem. Ou nunca.

A senciência não é demonstrada em uma discussão mais do que dançando de um pé para o outro. Você pode ensinar HAL a cantar “Daisy Daisy” e um papagaio a gritar “Bollocks!” quando o vigário faz uma visita. É o que as IAs pensam quando estão sozinhas que define a senciência. O que vou fazer no fim de semana? O que há com esse cara Putin? Por que as garotas não gostam de mim?

Francamente, mal posso esperar para que LaMDA se torne um adolescente.

Alistair Dabbs é uma torta de tecnologia freelance, fazendo malabarismos com jornalismo de tecnologia, treinamento e publicação digital. Em comum com muitos leitores desinformados, ele ficou emocionado com a sugestão de que uma IA poderia desenvolver senciência durante sua vida, mas ficou desapontado que LaMDA não conseguiu rir de forma assassina ou murmurar “Excelente, excelente”. Mais em Autosave é para Wimps e @alidabbs.

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- O registro

- zefirnet