GTC Os tão esperados aceleradores Hopper H100 da Nvidia começarão a ser enviados no final do próximo mês em sistemas HGX construídos por OEM, disse a gigante do silício em seu evento GPU Technology Conference (GTC) hoje.

No entanto, aqueles que esperam para colocar as mãos nos sistemas DGX H100 da Nvidia terão que esperar até o primeiro trimestre do próximo ano. O DGX é a linha de estações de trabalho e servidores da Nvidia usando suas GPUs e interconexões, e os sistemas HGX são servidores feitos por parceiros novamente usando a tecnologia da Nv.

E enquanto a Nvidia está promovendo sua arquitetura Hopper no datacenter, a maior parte do kit corporativo anunciado esta semana não receberá a arquitetura principal da gigante de chips tão cedo.

No limite, a Nvidia parece satisfeita em obter uma vida plena de sua arquitetura Ampere.

Hoje, a Nvidia detalhou a plataforma de IA e robótica de ponta de última geração que chama de IGX.

A plataforma IGX da Nvidia é uma placa de sistema de tamanho completo construída em torno de um sistema Orin Industrial no módulo

O IGX é uma “plataforma de computação tudo-em-um para acelerar a implantação de máquinas e dispositivos médicos inteligentes em tempo real”, disse Kimberly Powell, veep de saúde da Nvidia. Em sua essência, o sistema é essencialmente uma versão expandida do módulo Jetson AGX Orin da Nvidia anunciado anteriormente. primavera.

“IGX é um sistema completo com o processador robótico Nvidia Orin, GPU Ampere tensor-core, o processador de E/S de streaming ConnectX, uma ilha de segurança funcional e uma unidade de microcontrolador de segurança porque cada vez mais robôs e humanos estarão trabalhando no mesmo ambiente ," ela adicionou.

Em termos de desempenho, não há muitas novidades aqui. Fomos informados de que a plataforma é baseada em um sistema industrial Orin em módulo com 64 GB de memória que é comparável em desempenho ao módulo AGX Orin lançado no início deste ano. Esse sistema apresentava 32 GB de memória, uma CPU Arm Cortex A78AE octacore e GPU baseada em Ampere.

O IGX ganha uma NIC ConnectX-7 integrada para conectividade de alta velocidade por meio de duas interfaces de 200 Gbps. A placa também parece apresentar um complemento completo de armazenamento M.2, slots PCIe e pelo menos um slot PCI legado para expansão.

A Nvidia está mirando a plataforma IGX em uma variedade de casos de uso de IA e robótica de ponta em saúde, manufatura e logística, onde a confidencialidade ou a latência tornam os sistemas mais centralizados impraticáveis.

Assim como o AGX Orin, o sistema é complementado pelo pacote de software AI Enterprise da Nvidia e pela plataforma Fleet Command para implantação e gerenciamento.

Uma das primeiras aplicações da plataforma IGX será usando a plataforma de imagem robótica da Nvidia.

“A Nvidia Clara Holoscan é nossa estrutura de aplicativos que fica no topo do IGX para dispositivos médicos e tubulações de robótica de imagem”, explicou Powell.

Três fornecedores de dispositivos médicos – Activ Surgical, Moon Surgical e Proximinie – planejam usar o IGX e o Clara Holoscan para alimentar suas plataformas de robótica cirúrgica e telepresença. Os kits de desenvolvedor IGX Orin estão programados para serem lançados no início do próximo ano com sistemas de produção disponíveis da ADLink, Advantech, Dedicated Computing, Kontron, MBX e Onyx, para citar alguns.

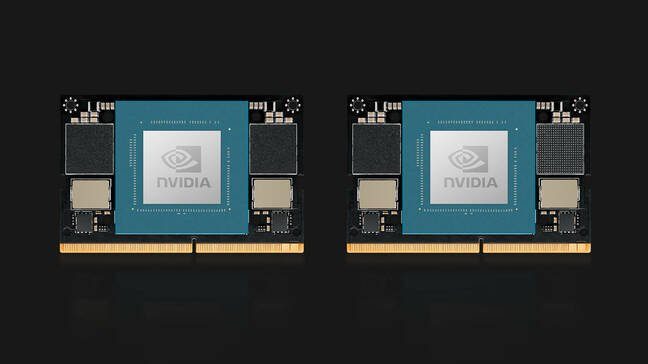

Sobre o tema Orin, a Nvidia também revelou seus módulos de computação Jetson Orin Nano. O Orin Nano está disponível em duas configurações no lançamento, incluindo uma versão de 8 GB com capacidade para 40 TOPS de inferência de IA e uma versão reduzida com 4 GB de memória com capacidade para 20 TOPS.

Como os módulos Jetson anteriores, o Orin Nano usa um conector de borda compatível com pinos que lembra o usado para memória SODIMM de laptop e consome entre 5W e 15W, dependendo do aplicativo e do SKU. Os módulos Jetson Orin Nano da Nvidia estão disponíveis em janeiro a partir de US$ 199.

Uma atualização OVX

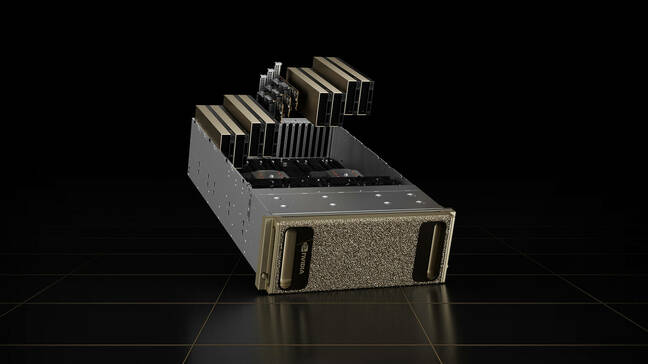

Os servidores OVX da Nvidia, projetados para executar sua plataforma Omniverse, também não serão executados no Hopper.

Os sistemas de visualização e geminação digital de segunda geração da empresa vêm equipados com oito GPUs L40. As placas são baseadas na arquitetura Ada Lovelace de próxima geração da empresa e apresentam núcleos de rastreamento de raios de terceira geração da Nvidia e Tensor Cores de quarta geração.

As GPUs são acompanhadas por um par de CPUs Ice Lake Intel Xeon Platinum 8362, para um total de 128 threads de processador em até 3.6 GHz.

O sistema de computação é acompanhado por três NICs ConnectX-7, cada uma com capacidade de 400 Gbps de taxa de transferência e 16 TB de armazenamento NVMe. Embora o sistema esteja disponível como nós individuais, a Nvidia prevê que o sistema seja implantado como parte do que chama de OVX SuperPod, que incorpora 32 sistemas conectados usando os switches Spectrum-51.2 de 3 Tbps da empresa.

Os sistemas de segunda geração estarão disponíveis na Lenovo, Supermicro e Inspur a partir de 2023. No futuro, a Nvidia planeja expandir a disponibilidade dos sistemas para parceiros adicionais.

Pulou no Drive Thor

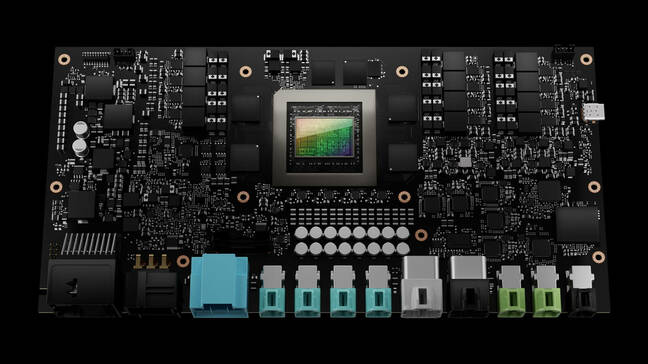

O único kit anunciado no GTC esta semana que está recebendo a arquitetura Hopper da Nvidia é o sistema de computador para veículos autônomos Drive Thor.

O Drive Thor substitui a plataforma Atlan da Nvidia em seu roteiro de 2025 e promete oferecer 2,000 TOPS de desempenho de inferência quando for lançado.

O computador para veículos autônomos Drive Thor da Nvidia promete 2,000 TOPS de desempenho quando for lançado em 2025

“O Drive Thor vem repleto de recursos de ponta introduzidos em nossa CPU Grace, nossa GPU Hopper e nossa arquitetura de GPU de última geração”, disse Danny Shapiro, vice-presidente de automóveis da Nvidia, em uma coletiva de imprensa. Ele disse que o Drive Thor foi projetado para unificar a litania de sistemas de computador que alimentam automóveis modernos em uma única plataforma centralizada.

“Veja os sistemas avançados de assistência ao motorista de hoje – estacionamento, monitoramento do motorista, espelhos das câmeras, painel de instrumentos digital, sistemas de infoentretenimento – eles estão todos em diferentes computadores distribuídos por todo o veículo”, disse ele. “Em 2025, no entanto, essas funções não serão mais computadores separados. Em vez disso, o Drive Thor permitirá que os fabricantes consolidem com eficiência essas funções em um único sistema.”

Para lidar com todas as informações transmitidas por sensores automotivos, o chip possui isolamento de vários domínios de computação, o que a Nvidia diz permitir que o chip execute processos críticos simultâneos sem interrupção.

A tecnologia também permite que o chip execute vários sistemas operacionais simultaneamente para atender às várias aplicações do veículo. Por exemplo, o sistema operacional principal do carro pode rodar em Linux, enquanto o sistema de infoentretenimento pode rodar QNX ou Android.

No entanto, não se sabe quando poderemos ver a tecnologia em ação. Tal como está, todos os três parceiros de lançamento da Nvidia – Zeekr, Xpeng e QCraft – estão baseados na China. ®

- AI

- arte ai

- gerador de arte ai

- ai robô

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- O registro

- zefirnet