Os desenvolvedores do Quest 3 agora podem integrar três novos recursos importantes para melhorar a realidade virtual e mista.

O rastreamento corporal de dentro para fora (IOBT) e as pernas generativas foram anunciado junto com a Quest 3 como chegando em dezembro. A oclusão para realidade mista por meio da API Depth foi anteriormente um recurso experimental, o que significa que os desenvolvedores poderiam testá-lo, mas não poderiam enviá-lo nas compilações da Quest Store ou do App Lab.

Todos os três recursos agora estão disponíveis como parte do SDK v60 para Unity e código nativo. Enquanto isso, a integração do Unreal Engine v60 inclui API Depth, mas não IOBT ou Generative Legs.

Rastreamento da parte superior do corpo de dentro para fora

O Inside-Out Body Tracking (IOBT) usa as câmeras laterais do Quest 3, voltadas para baixo, para rastrear seu pulso, cotovelos, ombros e torso usando algoritmos avançados de visão computacional.

O IOBT evita problemas com braços estimados por cinemática inversa (IK), que muitas vezes são incorretos e desconfortáveis porque o sistema está apenas fazendo suposições a partir da localização de sua cabeça e mãos. Quando os desenvolvedores integrarem o IOBT, você verá seus braços e toro em suas posições reais – não uma estimativa.

Esse rastreamento da parte superior do corpo também permite que os desenvolvedores ancorem a locomoção do polegar na direção do seu corpo, não apenas na cabeça ou nas mãos, e você pode realizar novas ações, como inclinar-se sobre uma borda e mostrar isso de forma realista em seu avatar.

Pernas generativas de IA

IOBT funciona apenas para a parte superior do corpo. Para a parte inferior do corpo, Meta lançou Generative Legs.

Generative Legs usa um modelo de IA “de última geração” para estimar a posição de suas pernas – uma tecnologia que a empresa vem desenvolvendo pesquisando há anos.

No Quest 3, o Generative Legs oferece uma estimativa mais realista do que os fones de ouvido anteriores, graças ao uso do rastreamento da parte superior do corpo como entrada, mas também funciona no Quest Pro e no Quest 2 usando apenas a cabeça e as mãos.

O sistema Generative Legs é apenas um estimador, não um rastreamento, portanto, embora possa detectar saltos e agachamentos, ele não capta muitos movimentos reais, como levantar os joelhos.

Juntos, o rastreamento da parte superior do corpo de dentro para fora e as pernas generativas permitem corpos completos plausíveis em VR, chamado Full Body Synthesis, sem hardware externo.

Meta anunciou anteriormente que Full Body Synthesis chegará a Supernatural, Swordsman VR e Drunken Bar Fight.

API de profundidade para oclusão em realidade mista

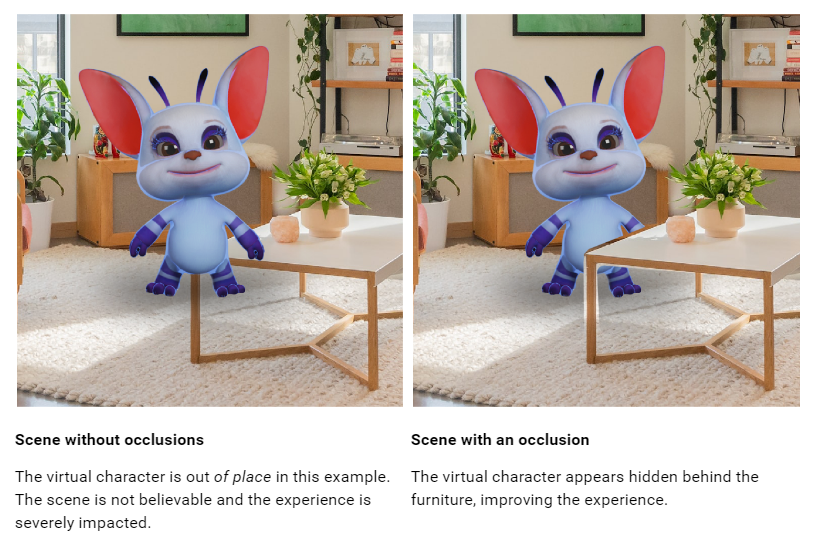

In nossa análise da Quest 3 criticamos duramente a falta de oclusão dinâmica da realidade mista. Embora os objetos virtuais possam aparecer atrás da malha de cena bruta gerada pela varredura de configuração da sala, eles sempre são exibidos na frente de objetos em movimento, como seus braços e outras pessoas, mesmo que estejam mais distantes, o que parece chocante e pouco natural.

Os desenvolvedores já podiam implementar a oclusão dinâmica para as mãos usando a malha Hand Tracking, mas poucos o fizeram porque ela corta o pulso e o resto do braço não é incluído.

A nova API Depth oferece aos desenvolvedores um mapa de profundidade aproximado por quadro gerado pelo fone de ouvido do seu ponto de vista. Isso pode ser usado para implementar a oclusão, tanto para objetos em movimento quanto para detalhes mais sutis de objetos estáticos, uma vez que eles podem não ter sido capturados na Scene Mesh.

A oclusão dinâmica deve fazer com que a realidade mista na Quest 3 pareça mais natural. No entanto, a resolução do sensor de profundidade do fone de ouvido é muito baixo, para que não capte detalhes como os espaços entre os dedos e você verá um espaço vazio ao redor das bordas dos objetos.

O mapa de profundidade também é sugerido apenas para ser aproveitado até 4 metros, após o qual “a precisão cai significativamente”, então os desenvolvedores podem querer usar também o Scene Mesh para oclusão estática.

Existem duas maneiras pelas quais os desenvolvedores podem implementar a oclusão: Hard e Soft. Hard é essencialmente gratuito, mas tem bordas irregulares, enquanto Soft tem custo de GPU, mas parece melhor. Olhando para o clipe de exemplo do Meta, é difícil imaginar que qualquer desenvolvedor escolherá Hard.

Porém, em ambos os casos, a oclusão requer o uso de shaders de oclusão especiais do Meta ou a implementação específica em seus shaders personalizados. Está longe de ser uma solução de um clique e provavelmente será um esforço significativo para o suporte dos desenvolvedores.

Além da oclusão, os desenvolvedores também podem usar a API Depth para implementar efeitos visuais baseados em profundidade em realidade mista, como neblina.

UploadVR testando oclusão da API de profundidade.

Você pode encontrar a documentação para Unidade aqui e para Irreal aqui. Observe que a documentação ainda não foi atualizada para refletir o lançamento público.

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- PlatoData.Network Gerativa Vertical Ai. Capacite-se. Acesse aqui.

- PlatoAiStream. Inteligência Web3. Conhecimento Amplificado. Acesse aqui.

- PlatãoESG. Carbono Tecnologia Limpa, Energia, Ambiente, Solar, Gestão de resíduos. Acesse aqui.

- PlatoHealth. Inteligência em Biotecnologia e Ensaios Clínicos. Acesse aqui.

- Fonte: https://www.uploadvr.com/quest-3-inside-out-upper-body-tracking-and-dynamic-occlusion/

- :tem

- :é

- :não

- $UP

- 1

- 7

- a

- precisão

- ações

- real

- avançado

- Depois de

- AI

- algoritmos

- ao lado de

- já

- tb

- sempre

- an

- Apresentadora

- e

- anunciou

- qualquer

- api

- app

- Laboratório de aplicativos

- aparecer

- SOMOS

- ARM

- braços

- por aí

- AS

- At

- disponível

- avatar

- longe

- Barra

- BE

- Porque

- sido

- atrás

- Melhor

- entre

- corpos

- corpo

- Rastreamento Corporal

- ambos

- Constrói

- mas a

- by

- chamado

- câmeras

- CAN

- capturados

- casos

- Escolha

- código

- COM

- como

- vinda

- Empresa

- computador

- Visão de Computador

- conceito

- Custo

- poderia

- não poderia

- bruto

- personalizadas

- cortes

- corte

- Dezembro

- entrega

- profundidade

- descrição

- detalhes

- descobrir

- Developer

- desenvolvedores

- DID

- direção

- Ecrã

- documentação

- descendente

- Drops

- dinâmico

- borda

- efeitos

- esforço

- permitir

- Motor

- essencialmente

- estimativa

- estimado

- Mesmo

- exemplo

- experimental

- externo

- Rosto

- longe

- Funcionalidades

- sentir

- poucos

- lutar

- Encontre

- Nevoeiro

- Escolha

- Gratuito

- da

- frente

- cheio

- mais distante

- lacuna

- Geral

- gerado

- generativo

- dá

- GPU

- mão

- rastreamento de mão

- mãos

- Queijos duros

- Hardware

- Ter

- cabeça

- fone

- headsets

- Contudo

- HTTPS

- if

- fotografia

- executar

- implementação

- melhorar

- in

- incluído

- inclui

- entrada

- integrar

- integração

- isn

- questões

- IT

- ESTÁ

- jpg

- apenas por

- laboratório

- Falta

- lançado

- pernas

- Permite

- alavancado

- como

- Provável

- ll

- localização

- olhar

- procurando

- OLHARES

- Baixo

- diminuir

- principal

- fazer

- Fazendo

- muitos

- mapa,

- Posso..

- significado

- Entretanto

- malha

- Meta

- misto

- realidade mista

- modelo

- mais

- movimentos

- em movimento

- mr

- nativo

- natural

- Novo

- Novos Recursos

- não

- nota

- agora

- objetos

- Oculus

- of

- WOW!

- frequentemente

- on

- só

- or

- Outros

- Fora

- Acima de

- parte

- Pessoas

- Realizar

- escolher

- platão

- Inteligência de Dados Platão

- PlatãoData

- plausível

- ponto

- Ponto de vista

- abertas

- impede

- anterior

- anteriormente

- Pro

- público

- busca

- missão 2

- missão 3

- busca profissional

- loja de missões

- elevando

- realista

- Realidade

- refletir

- liberar

- exige

- Resolução

- DESCANSO

- Quarto

- s

- digitalização

- cena

- Sdk

- Vejo

- instalação

- NAVIO

- rede de apoio social

- mostrar

- lado

- periodo

- de forma considerável

- desde

- So

- Suave

- solução

- espaços

- especial

- especificamente

- estático

- loja

- tal

- sobrenatural

- ajuda

- síntese

- .

- Tecnologia

- teste

- ensaio

- do que

- obrigado

- que

- A

- deles

- deles

- isto

- aqueles

- Apesar?

- três

- para

- pista

- Rastreamento

- dois

- unidade

- Irreal

- Unreal Engine

- Atualizada

- UploadVR

- usar

- usava

- usos

- utilização

- via

- Ver

- Virtual

- visão

- visual

- vr

- queremos

- foi

- maneiras

- we

- BEM

- foram

- quando

- qual

- enquanto

- precisarão

- de

- Ganhou

- trabalho

- pulso

- ainda

- Vocês

- investimentos

- zefirnet