Sim .. Estou falando sobre os aplicativos de IA - nossos inúmeros aplicativos de IA e os próximos sussurrando aos humanos sobre o que fazer…. como fazer... mas não sobre os sussurradores que interagem com os chatbots de IA.

De acordo com o IDC previsões, o mercado global de IA pode atingir mais de US$ 500 bilhões até 2024 – um aumento de mais de 50% em relação a 2021. Isso indica que passamos de experimentos de negócios para aceitar que é parte integrante da estratégia empresarial de todos os tamanhos. É uma ferramenta necessária para transformar dados em insights para desencadear ações com base em melhores decisões. Ninguém está discutindo os benefícios da IA para diminuir o risco comercial e ampliar o ROI com inovação. Mas, como sempre, há um … MAS … a IA imparcial é mais fácil falar do que fazer.

Críticos para os negócios, esses modelos de IA precisam operar de forma confiável com visibilidade e responsabilidade. Caso contrário, o inadimplemento, neste caso, traz consequências nefastas que impactam o fluxo de caixa de qualquer empresa e podem até resultar em questões judiciais. A única maneira de evitar isso é a automação e a transparência para responder a uma pergunta “Você pode provar que este aplicativo/carga de trabalho de IA foi criado de forma ética”. Aka… como você governa? E você pode provar que está sendo governado continuamente?

É aqui que empresas como IBM investiram na governança de IA para orquestrar o processo geral de direção, gerenciamento e monitoramento das atividades de IA da organização. O trabalho principal é garantir que todas as unidades de negócios permaneçam proativas e infundam a estrutura de governança nas iniciativas para fortalecer a capacidade de atender aos princípios e regulamentos éticos. Especialmente, setores regulamentados, como serviços bancários e financeiros, são legalmente obrigados a fornecer as evidências para satisfazer os reguladores.

A influência da IA está crescendo exponencialmente no setor de serviços financeiros devido à tremenda pressão da transformação digital. Como dito, é mais fácil dizer do que fazer porque:

1. Operacionalize com confiança os aplicativos de IA:

Em alguns casos, os modelos são construídos sem clareza e catalogação; escusado será dizer que o monitoramento escapa no meio de tudo para rastrear o ciclo de vida de ponta a ponta. Enquanto os bancos lutam com aplicativos legados, automatizar os processos para criar transparência e explicabilidade tornou-se mais difícil e, por sua vez, uma caixa preta. Ninguém sabe por que/como as decisões foram tomadas. Os novos aplicativos emaranhados com aplicativos legados nunca veem a luz do dia, embora um enorme ROI esteja associado a eles devido à qualidade e aos riscos não percebidos.

Isso nos leva ao nosso segundo ponto – gerenciar o risco de reputação

2. Gerencie o risco reputacional junto com o risco geral

eu perguntei #chatGPT e #Bardo – quem é Padma Chukka. #ChatGPT recusou-se a responder, mesmo que eu mudasse a pergunta de várias maneiras. Ainda assim, Bard me deu uma resposta detalhada, incluindo meu perfil do LinkedIn… mas os dados são de vários sites onde meu antigo perfil ainda existe como parte da biografia do palestrante. Daquele ponto em diante, ainda não abri o Bardo. Rapidamente, fui desligado, também conhecido como – Risco de reputação. Suponha que eu possa desligar um chatbot simples quando perceber que os dados podem ser inconsistentes. Como não ter certeza antes de decidir comprar um aplicativo com infusão de IA para conduzir negócios críticos? O risco de reputação é um fator essencial que às vezes as empresas esquecem. Se você quantificar o risco reputacional, pode-se ver o tremendo impacto nos negócios se não formos proativos.

Para aumentar a complexidade, o terceiro é…

3. Como uma empresa pode responder às mudanças nos regulamentos de IA?

Para evitar o risco de reputação, uma equipe de IA bem-sucedida e responsável deve estar ciente de todas as regulamentações locais e globais, caindo como um vídeo tique-taque a qualquer momento. E a não conformidade pode, em última análise, custar a uma organização milhões de dólares em multas relacionadas ao trabalho, como o proposto Ato de IA da UE. Pode ser até 30 milhões de euros ou 6% da receita global da empresa – OUCH.

Bem, nem tudo tem que ser um mar de rosas desde o início... desde que saibamos transformar uma situação assustadora em uma situação cor-de-rosa.

Sem surpresa... são sempre pessoas, processos e tecnologia. Então, primeiro, crie um corpo diretivo interfuncional para educar, dirigir e monitorar as iniciativas com base nos objetivos. Em seguida, avalie a tecnologia e os processos atuais de IA, entenda as lacunas e corrija para uma prova futura. Em seguida, recorra a um conjunto de fluxos de trabalho de governança automatizados de acordo com os requisitos de conformidade. Por fim, configure um sistema de monitoramento para alertar os proprietários se o limite aceitável estiver se aproximando. Do lado da tecnologia, uma IA bem arquitetada, bem executada e bem conectada requer vários blocos de construção. E certifique-se de que ele tenha alguns ou todos os recursos:

· Integridade de dados em diversas implantações

· Use ferramentas existentes abertas e flexíveis que aderem à governança de IA

· Certifique-se de oferecer acesso de autoatendimento com controles de privacidade - uma maneira de rastrear

· Design com automação e governança de IA em mente

· Pode se conectar e ser personalizável para várias partes interessadas por meio de um fluxo de trabalho personalizável

Assim que mudarmos o aplicativo de assustador para Rosy... a próxima pergunta é como você prova...

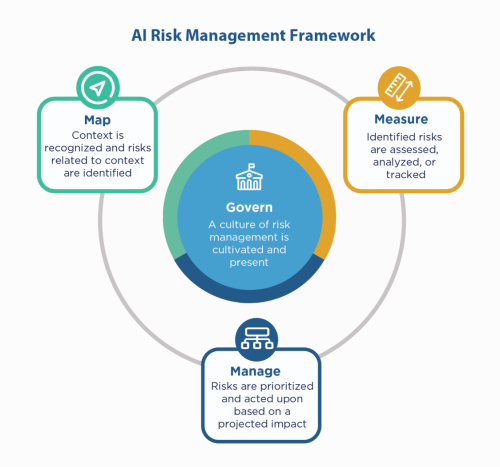

Primeiro, recorra aos princípios de IA da empresa – construa com eles, mas ainda assim você precisa “mostrar” que está em conformidade, especialmente em ambientes regulamentados como Serviços Financeiros. Como os serviços financeiros devem reclamar com o NIST 800-53, eles podem consultar o NIST AI Risk Management Framework (AI RMF). O NIST sugeriu os controles em quatro famílias – Governar, Mapear, Medir e Gerenciar. Usando isso como um fator de orientação e teste de estresse dos aplicativos para identificar as lacunas a serem corrigidas e monitoradas.

A IBM pode validar seus modelos antes de colocá-los em produção e pode ser monitorada quanto à imparcialidade, qualidade e variação. Ele também pode fornecer documentação explicando o comportamento e as previsões do modelo para atender aos requisitos dos reguladores e auditores. Essas explicações podem fornecer visibilidade e facilitar a auditoria, além de aumentar a transparência e a capacidade de determinar possíveis riscos.

Ouça esses sussurros de IA com confiança!

#Serviços financeiros #responsávelai #ethicalai #NISTAIRMF

- Conteúdo com tecnologia de SEO e distribuição de relações públicas. Seja amplificado hoje.

- Platoblockchain. Inteligência Metaverso Web3. Conhecimento Ampliado. Acesse aqui.

- Cunhando o Futuro com Adryenn Ashley. Acesse aqui.

- Fonte: https://www.finextra.com/blogposting/24053/the-costly-consequences-of-unethical-ai-whisperer?utm_medium=rssfinextra&utm_source=finextrablogs

- :é

- $UP

- 2021

- 2024

- 7

- a

- habilidade

- Sobre

- aceitável

- Acesso

- responsabilidade

- em

- Aja

- Açao Social

- atividades

- aderir

- AI

- Lei de IA

- Governança de IA

- aka

- Alertar

- Todos os Produtos

- sempre

- e

- responder

- app

- Aplicação

- aplicações

- Aplicativos

- SOMOS

- por aí

- AS

- associado

- At

- auditor

- auditores

- Automatizado

- automatizando

- Automação

- em caminho duplo

- Bancário

- bancos

- baseado

- BE

- Porque

- antes

- ser

- referência

- Benefícios

- Melhor

- bilhão

- Preto

- Blocos

- corpo

- Caixa

- Traz

- construir

- Prédio

- construído

- negócio

- comprar

- by

- CAN

- capacidades

- casas

- casos

- dinheiro

- fluxo de caixa

- mudança

- chatbot

- chatbots

- clareza

- encerramento

- Empresas

- Empresa

- complexidade

- compliance

- compatível

- Conduzir

- com confiança

- Contato

- Consequências

- continuamente

- controles

- Custo

- poderia

- crio

- crítico

- Atual

- personalizável

- ciclo

- dados,

- debatendo

- Decidindo

- decisões

- diminuir

- Design

- detalhado

- Determinar

- digital

- Transformação Digital

- terrível

- diretamente

- dirigindo

- diferente

- documentação

- dólares

- Caindo

- mais fácil

- educar

- end-to-end

- garantir

- Empreendimento

- ambientes

- especialmente

- essencial

- considerações éticas

- EU

- euros

- Mesmo

- Cada

- tudo

- evidência

- existente

- existe

- explicando

- exponencialmente

- Falha

- justiça

- Cair

- famílias

- Finalmente

- financeiro

- serviços financeiros

- final

- Finextra

- Primeiro nome

- flexível

- fluxo

- Escolha

- Quadro

- da

- de 2021

- futuro

- OFERTE

- Global

- governo

- Crescente

- Ter

- Como funciona o dobrador de carta de canal

- Como Negociar

- HTTPS

- enorme

- Humanos

- i

- identificar

- Impacto

- in

- Incluindo

- Crescimento

- indicam

- indústrias

- influência

- iniciativas

- Inovação

- insights

- integral

- integridade

- interagir

- investido

- IT

- ESTÁ

- Trabalho

- Saber

- Legado

- Legal

- assuntos legais

- vida

- como

- Line

- local

- longo

- olhar

- moldadas

- fazer

- gerencia

- de grupos

- gestão

- mapa,

- mercado

- Matéria

- Posso..

- a medida

- Conheça

- poder

- milhão

- milhões

- modelo

- modelos

- momento

- Monitore

- monitorados

- monitoração

- mais

- múltiplo

- necessário

- você merece...

- Desnecessário

- Novo

- Próximo

- nist

- objetivos

- of

- oferecer

- Velho

- on

- ONE

- aberto

- operar

- organização

- de outra forma

- global

- proprietários

- Dor

- parte

- Pessoas

- platão

- Inteligência de Dados Platão

- PlatãoData

- ponto

- possível

- Previsões

- pressão

- primário

- princípios

- política de privacidade

- Proactive

- processo

- processos

- Produção

- Perfil

- prova

- proposto

- Prove

- fornecer

- colocar

- qualidade

- questão

- rapidamente

- alcançar

- perceber

- regulamentadas

- indústrias reguladas

- Regulamento

- regulamentos

- Reguladores

- reputação

- requeridos

- Requisitos

- exige

- Responder

- responsável

- resultar

- receita

- Risco

- gestão de risco

- riscos

- ROI

- rosado

- s

- Dito

- Segundo

- setor

- Autoatendimento

- Serviços

- conjunto

- rede de apoio social

- mostrar

- lado

- simples

- desde

- Locais

- situação

- tamanhos

- So

- alguns

- Faísca

- Palestrantes

- partes interessadas

- ficar

- Ainda

- Estratégia

- Fortalecer

- estresse

- Lutando

- bem sucedido

- .

- falando

- Profissionais

- Tecnologia

- teste

- que

- A

- Eles

- Este

- Terceiro

- limiar

- Através da

- para

- ferramenta

- ferramentas

- pista

- Transformação

- Transparência

- tremendo

- VIRAR

- Virado

- Em última análise

- compreender

- unidades

- os próximos

- us

- usar

- VALIDAR

- vário

- Vídeo

- visibilidade

- Caminho..

- maneiras

- O Quê

- enquanto

- QUEM

- de

- sem

- Atividades:

- fluxos de trabalho

- Vocês

- investimentos

- zefirnet