Já viu uma gazela bebê aprender a andar? Um fulvo, que é basicamente um papai mamífero de pernas longas, fica de pé, cai, fica de pé e cai novamente. Eventualmente, ele fica de pé o suficiente para agitar suas pernas parecidas com palitos de dente em uma série de quedas próximas... ahem, degraus. Surpreendentemente, alguns minutos após essa exibição cativante, o fulvo está pulando como um velho profissional.

Bem, agora temos uma versão robótica desta cena clássica do Serengeti.

O cervo neste caso é um cão robótico da Universidade da Califórnia, Berkeley. E também é um aprendiz surpreendentemente rápido (em relação ao resto do tipo de robô). O robô também é especial porque, ao contrário de outros robôs mais chamativos que você pode ter visto online, ele usa inteligência artificial para aprender a andar.

Começando de costas, com as pernas balançando, o robô aprende a se virar, ficar de pé e andar em uma hora. Mais dez minutos de assédio com um rolo de papelão são suficientes para ensiná-lo a resistir e se recuperar de ser empurrado por seus manipuladores.

Não é a primeira vez um robô usou inteligência artificial para aprender a andar. Mas enquanto os robôs anteriores aprenderam a habilidade por tentativa e erro em inúmeras iterações em simulações, o bot de Berkeley aprendeu inteiramente no mundo real.

[Conteúdo incorporado]

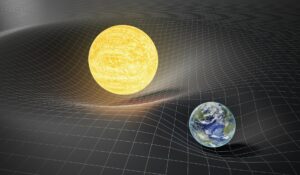

Em um artigo do artigo publicado no servidor de pré-impressão arXiv, os pesquisadores—Danijar Hafner, Alejandro Escontrela e Philipp Wu—dizem que a transferência de algoritmos que aprenderam em simulação para o mundo real não é simples. Pequenos detalhes e diferenças entre o mundo real e a simulação podem atrapalhar os robôs incipientes. Por outro lado, o treinamento de algoritmos no mundo real é impraticável: levaria muito tempo e desgaste.

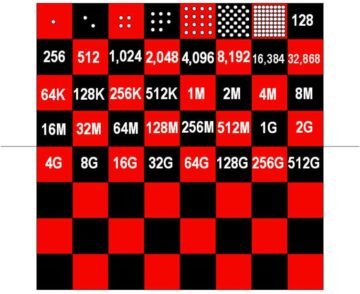

Quatro anos atrás, por exemplo, a OpenAI exibiu uma mão robótica habilitada para IA que poderia manipular um cubo. O algoritmo de controle, Dactyl, precisava de cerca de 100 anos de experiência em uma simulação alimentada por 6,144 CPUs e 8 GPUs Nvidia V100 para realizar essa tarefa relativamente simples. As coisas avançaram desde então, mas o problema permanece em grande parte. Os algoritmos de aprendizado por reforço puro precisam de muita tentativa e erro para aprender habilidades para treinar no mundo real. Simplificando, o processo de aprendizagem quebraria os pesquisadores e robôs antes de fazer qualquer progresso significativo.

A equipe de Berkeley decidiu resolver esse problema com um algoritmo chamado Dreamer. Construindo o que é chamado de “modelo mundial”, Dreamer pode projetar a probabilidade de uma ação futura atingir seu objetivo. Com a experiência, a precisão de suas projeções melhora. Ao filtrar antecipadamente as ações menos bem-sucedidas, o modelo de mundo permite que o robô descubra com mais eficiência o que funciona.

“Aprender modelos de mundo a partir de experiências passadas permite que os robôs imaginem os resultados futuros de ações potenciais, reduzindo a quantidade de tentativa e erro no ambiente real necessária para aprender comportamentos bem-sucedidos”, escrevem os pesquisadores. “Ao prever resultados futuros, os modelos mundiais permitem o planejamento e o aprendizado do comportamento, com apenas pequenas quantidades de interação no mundo real.”

Em outras palavras, um modelo de mundo pode reduzir o equivalente a anos de tempo de treinamento em uma simulação para não mais do que uma hora difícil no mundo real.

A abordagem pode ter uma relevância mais ampla do que os cães-robôs também. A equipe também aplicou o Dreamer a um braço robótico de pegar e colocar e a um robô com rodas. Em ambos os casos, eles descobriram que o Dreamer permitia que seus robôs aprendessem com eficiência habilidades relevantes, sem necessidade de tempo de simulação. Aplicações futuras mais ambiciosas podem incluir auto-condução carros.

É claro que ainda há desafios a serem enfrentados. Embora o aprendizado por reforço automatize algumas das intrincadas codificação manual por trás dos robôs mais avançados de hoje, ainda exige que os engenheiros definam os objetivos de um robô e o que constitui o sucesso - um exercício que consome tempo e é aberto para ambientes do mundo real. Além disso, embora o robô tenha sobrevivido aos experimentos da equipe aqui, um treinamento mais longo em habilidades mais avançadas pode ser demais para que futuros bots sobrevivam sem danos. Os pesquisadores dizem que pode ser proveitoso combinar treinamento em simulador com aprendizado rápido no mundo real.

Ainda assim, os resultados avançam a IA na robótica em mais um passo. Dreamer reforça o argumento de que “o aprendizado por reforço será uma ferramenta fundamental no futuro do controle de robôs”, Jonathan Hurst, professor de robótica da Oregon State University disse MIT Technology Review.

Crédito de imagem: Danijar Hafner/YouTube