Amazon SageMakeOrganizador de dados é uma ferramenta de preparação de dados baseada em UI que ajuda a realizar análise, pré-processamento e visualização de dados com recursos para limpar, transformar e preparar dados com mais rapidez. Os modelos de fluxo pré-construídos do Data Wrangler ajudam a tornar a preparação de dados mais rápida para cientistas de dados e profissionais de aprendizado de máquina (ML), ajudando você a acelerar e compreender os padrões de práticas recomendadas para fluxos de dados usando conjuntos de dados comuns.

Você pode usar fluxos do Data Wrangler para executar as seguintes tarefas:

- Visualização de dados - Examinar propriedades estatísticas para cada coluna no conjunto de dados, construir histogramas, estudar outliers

- Limpeza de dados - Remover duplicatas, descartar ou preencher entradas com valores ausentes, removendo outliers

- Enriquecimento de dados e engenharia de recursos - Colunas de processamento para construir recursos mais expressivos, selecionando um subconjunto de recursos para treinamento

Esta postagem ajudará você a entender o Data Wrangler usando os seguintes exemplos de fluxos pré-construídos em GitHub. O repositório apresenta transformação de dados tabulares, transformações de dados de série temporal e transformações de conjuntos de dados unidos. Cada um requer um tipo diferente de transformações devido à sua natureza básica. Dados tabulares ou transversais padrão são coletados em um momento específico. Em contraste, os dados da série temporal são capturados repetidamente ao longo do tempo, com cada ponto de dados sucessivo dependente dos seus valores passados.

Vejamos um exemplo de como podemos usar o fluxo de dados de amostra para dados tabulares.

Pré-requisitos

O Data Wrangler é um Amazon Sage Maker recurso disponível dentro Estúdio Amazon SageMaker, portanto, precisamos seguir o processo de integração do Studio para ativar o ambiente e os notebooks do Studio. Embora você possa escolher entre alguns métodos de autenticação, a maneira mais simples de criar um domínio Studio é seguir as Começo rápido instruções. O início rápido usa as mesmas configurações padrão do configuração padrão do Studio. Você também pode optar por embarcar usando Centro de identidade do AWS IAM (sucessor do AWS Single Sign-On) para autenticação (consulte Integração no domínio do Amazon SageMaker usando o IAM Identity Center).

Importe o conjunto de dados e os arquivos de fluxo para o Data Wrangler usando o Studio

As etapas a seguir descrevem como importar dados para o SageMaker para serem consumidos pelo Data Wrangler:

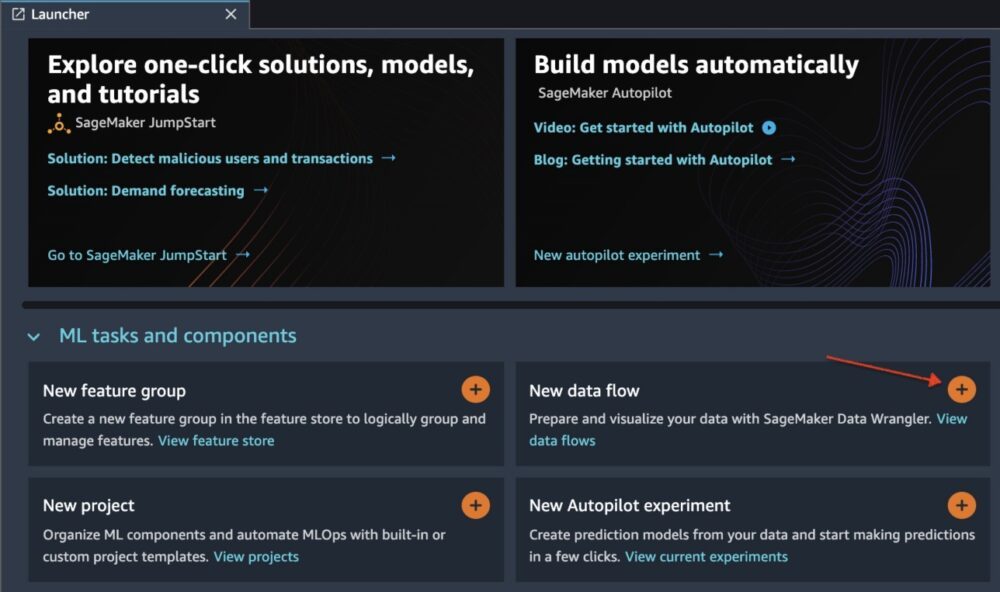

Inicialize o Data Wrangler por meio da UI do Studio escolhendo Novo fluxo de dados.

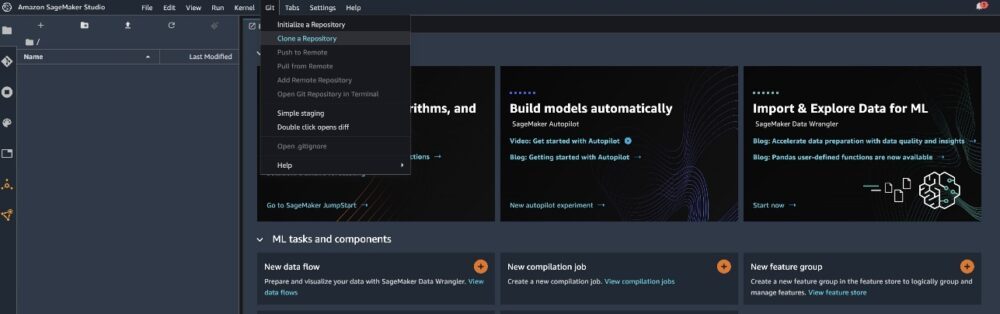

Clone o GitHub repo para fazer download dos arquivos de fluxo em seu ambiente do Studio.

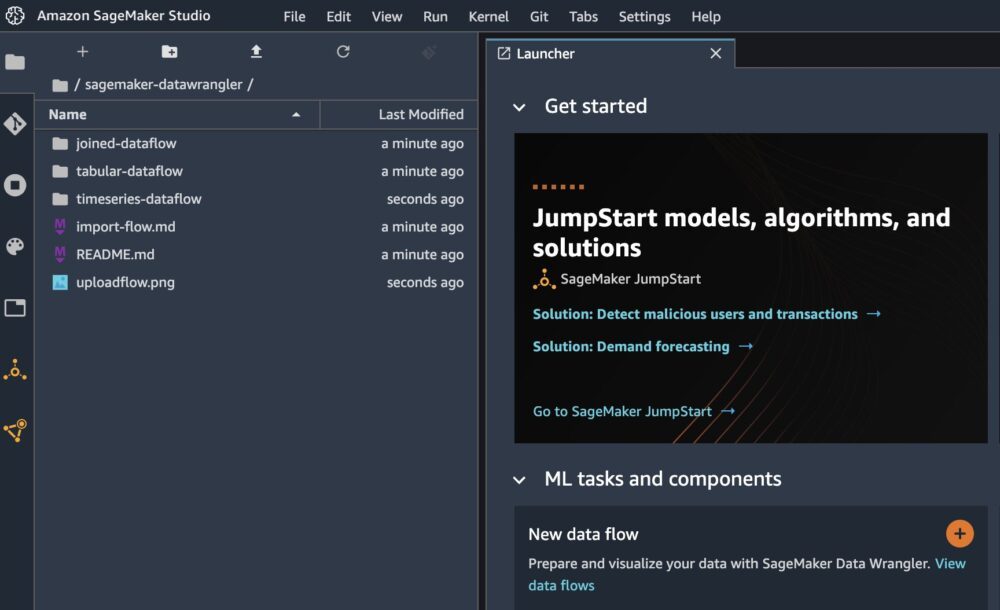

Quando a clonagem for concluída, você poderá ver o conteúdo do repositório no painel esquerdo.

Escolha o arquivo Hotel-Bookings-Classification.flow para importar o arquivo de fluxo para o Data Wrangler.

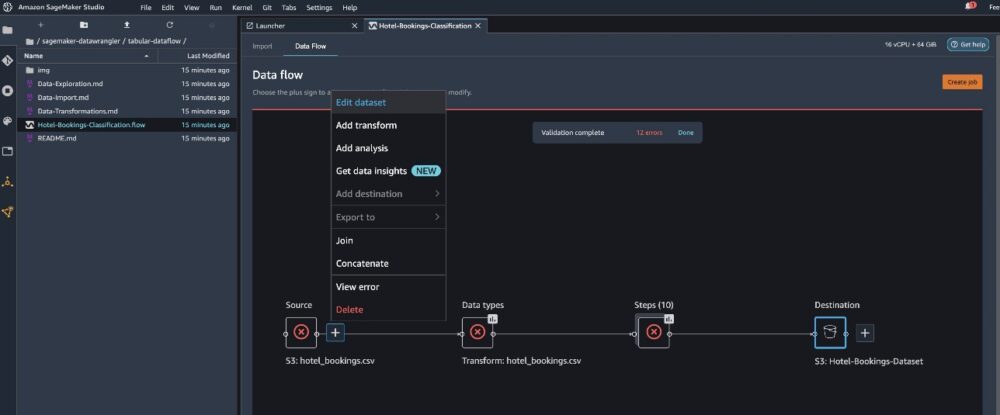

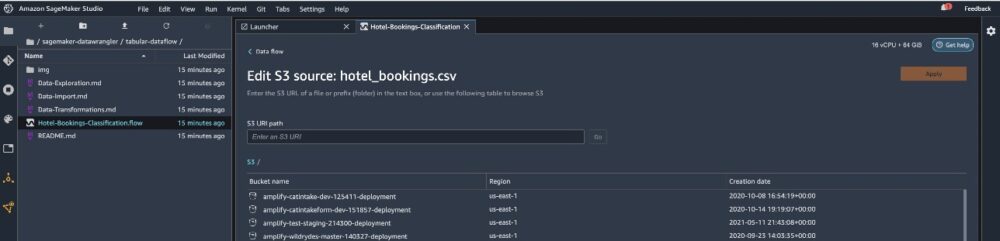

Se você usar a série temporal ou o fluxo de dados unido, o fluxo aparecerá com um nome diferente. Após a importação do fluxo, você deverá ver a captura de tela a seguir. Isso nos mostra erros porque precisamos ter certeza de que o arquivo de fluxo aponta para a fonte de dados correta em Serviço de armazenamento simples da Amazon (Amazônia S3).

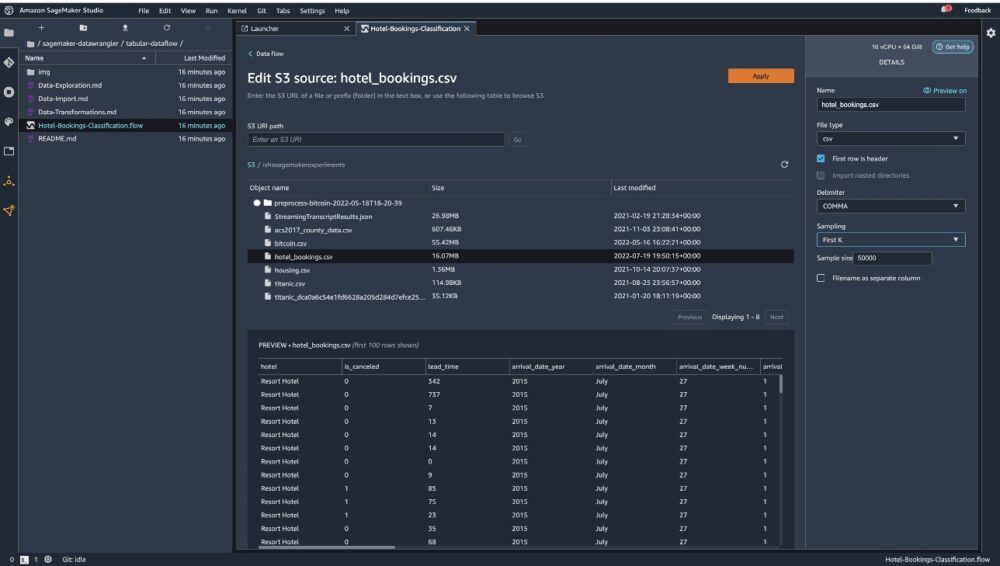

Escolha Editar conjunto de dados para abrir todos os seus buckets S3. Em seguida, escolha o conjunto de dados hotel_bookings.csv do seu bucket S3 para percorrer o fluxo de dados tabular.

Observe que se você estiver usando o fluxo de dados unido, talvez seja necessário importar vários conjuntos de dados para o Data Wrangler

No painel direito, certifique-se VÍRGULA é escolhido como delimitador e Amostragem está definido para Primeiro K. Nosso conjunto de dados é pequeno o suficiente para executar transformações do Data Wrangler em todo o conjunto de dados, mas gostaríamos de destacar como você pode importar o conjunto de dados. Se você tiver um grande conjunto de dados, considere usar amostragem. Escolher importação para importar este conjunto de dados para o Data Wrangler.

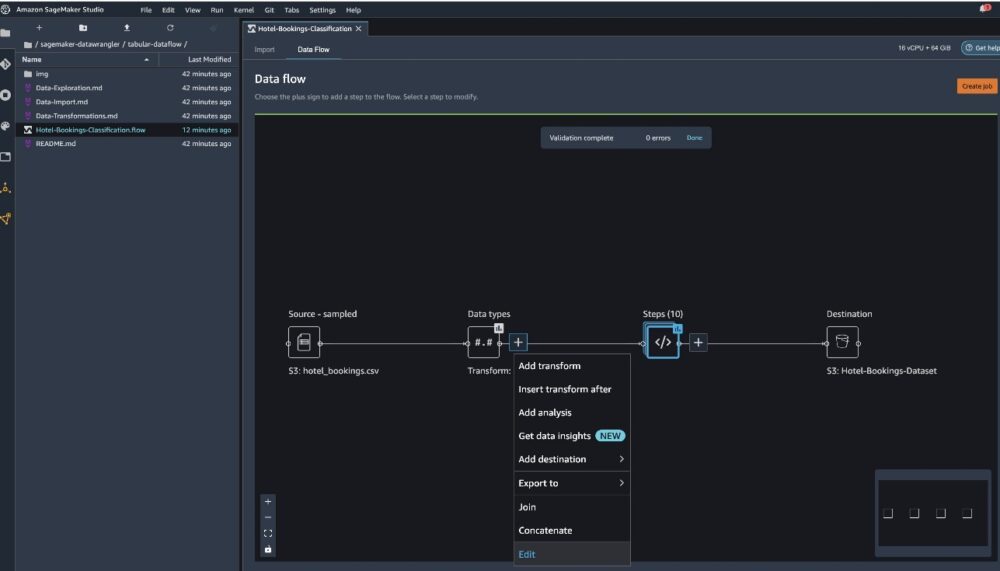

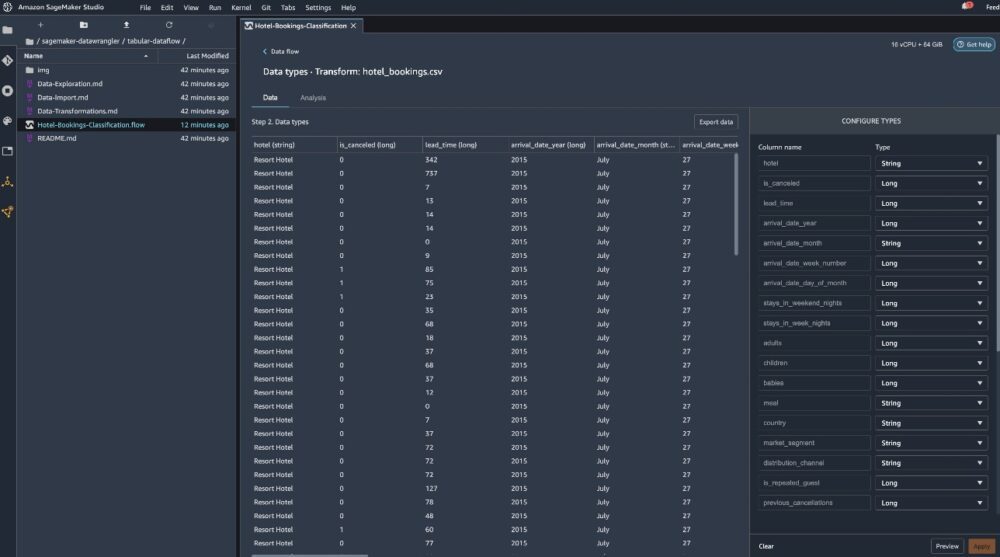

Após a importação do conjunto de dados, o Data Wrangler valida automaticamente o conjunto de dados e detecta os tipos de dados. Você pode ver que os erros desapareceram porque estamos apontando para o conjunto de dados correto. O editor de fluxo agora mostra dois blocos mostrando que os dados foram importados de uma fonte e os tipos de dados reconhecidos. Você também pode editar os tipos de dados, se necessário.

A captura de tela a seguir mostra nossos tipos de dados.

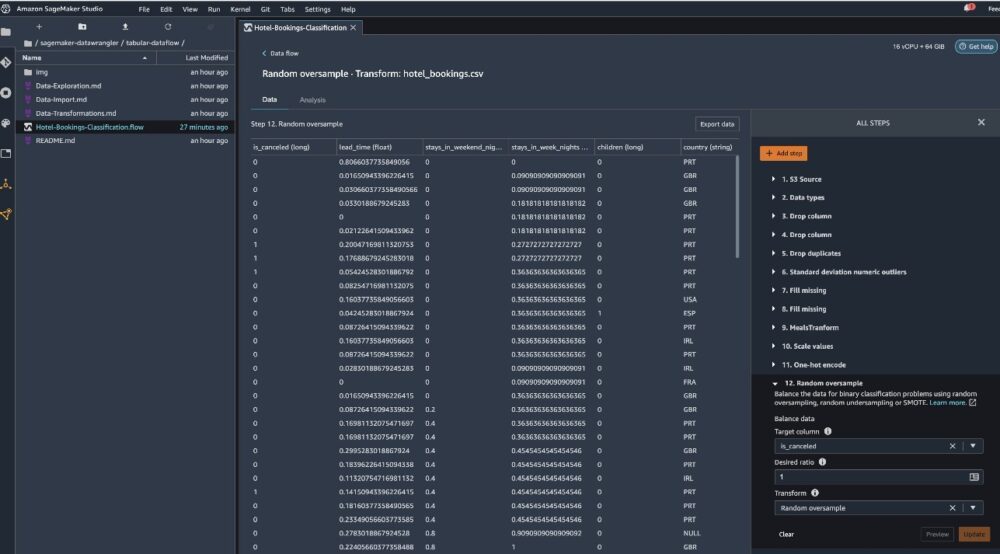

Vejamos algumas das transformações feitas como parte desse fluxo tabular. Se você estiver usando o série temporal or ingressou fluxos de dados, confira algumas transformações comuns no GitHub repo. Realizamos algumas análises exploratórias básicas de dados usando relatórios de insights de dados que estudaram o vazamento de alvo e a colinearidade de recursos no conjunto de dados, análises de resumo de tabela e capacidade de modelagem rápida. Explore as etapas do GitHub repo.

Agora eliminamos colunas com base nas recomendações fornecidas pelo Relatório de insights e qualidade de dados.

- Para vazamento alvo, deixe cair status_reserva.

- Para colunas redundantes, descarte dias_na_lista_de_espera, hotel, tipo_de_quarto_reservado, data_de_chegada_mês, data_de_status_da_reserva, bebês, e data_de_chegada_dia_do_mês.

- Com base nos resultados da correlação linear, elimine colunas chegada_data_semana_número e chegada_data_ano porque os valores de correlação para esses pares de recursos (colunas) são maiores que o limite recomendado de 0.90.

- Com base nos resultados da correlação não linear, descarte status_reserva. Esta coluna já estava marcada para ser descartada com base na análise de vazamento alvo.

- Processar valores numéricos (escala min-max) para lead_time, estadias_in_weekend_nights, estadias_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, e espaços_de_estacionamento_de_carro_requerido.

- Variáveis categóricas de codificação one-hot como refeição, is_repeated_guest, market_segment, assign_room_type, deposit_type, e Tipo de Cliente.

- Equilibre a variável de destino Sobreamostra aleatória para desequilíbrio de classe. Use o recurso de modelagem rápida para lidar com valores discrepantes e valores ausentes.

Exportar para o Amazon S3

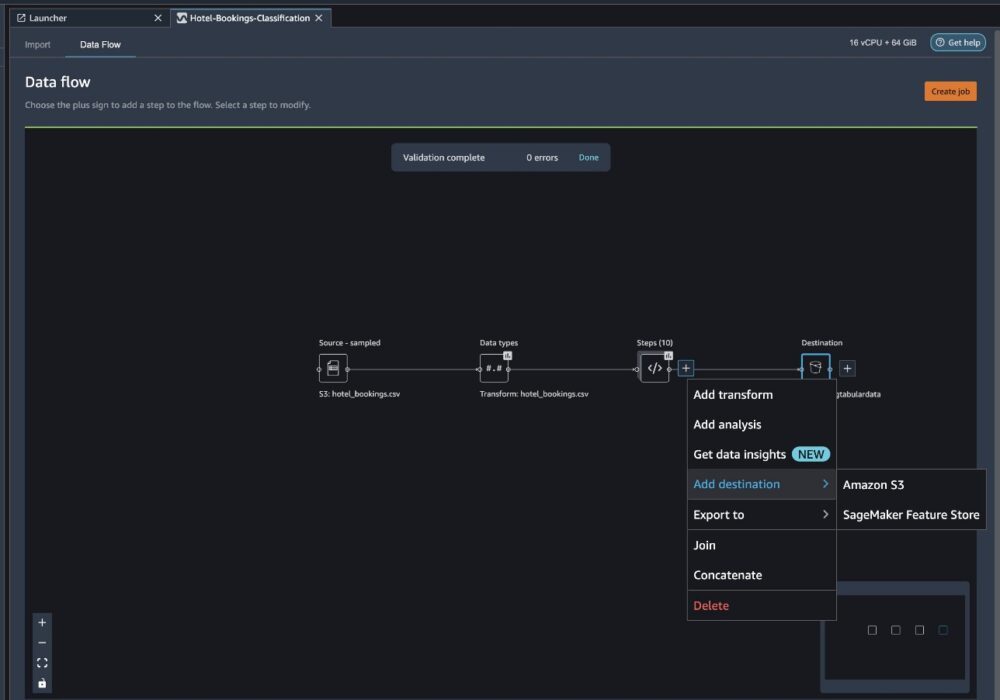

Agora passamos pelas diferentes transformações e estamos prontos para exportar os dados para o Amazon S3. Esta opção cria um trabalho de processamento do SageMaker, que executa o fluxo de processamento do Data Wrangler e salva o conjunto de dados resultante em um bucket do S3 especificado. Siga as próximas etapas para configurar a exportação para Amazon S3:

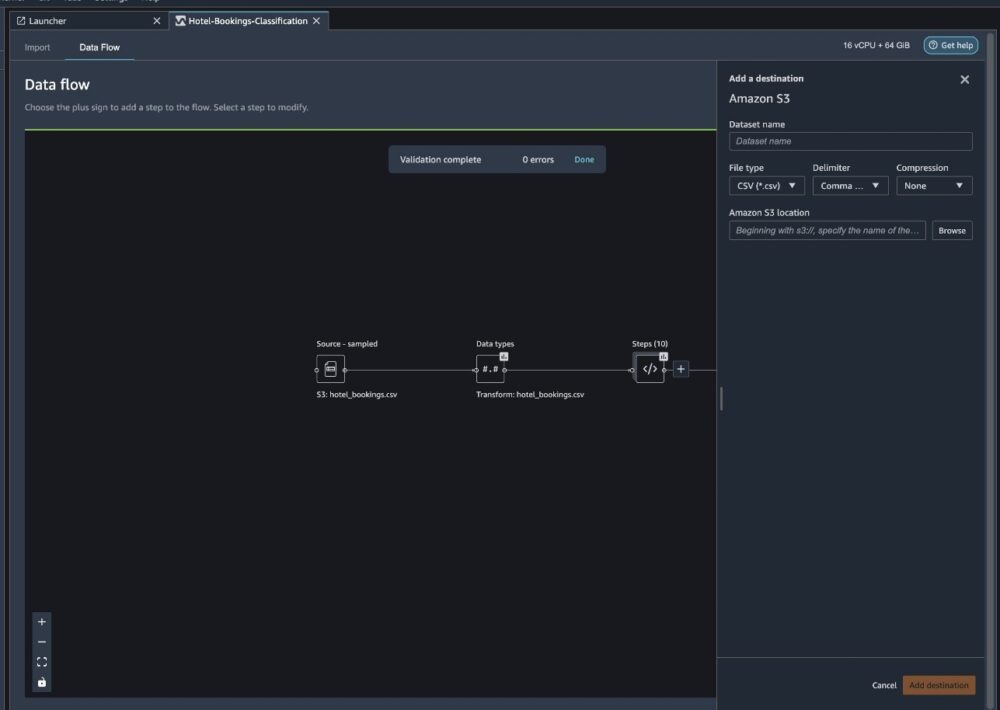

Escolha o sinal de mais ao lado de uma coleção de elementos de transformação e escolha Adicionar destino, Em seguida Amazon S3.

- Escolha Nome do conjunto de dados, insira um nome para o novo conjunto de dados, por exemplo

NYC_export. - Escolha Tipo de arquivo, escolha CSV.

- Escolha Delimitador, escolha Vírgula.

- Escolha Compressão, escolha nenhum.

- Escolha Localização do Amazon S3, use o mesmo nome de bucket que criamos anteriormente.

- Escolha Adicionar destino.

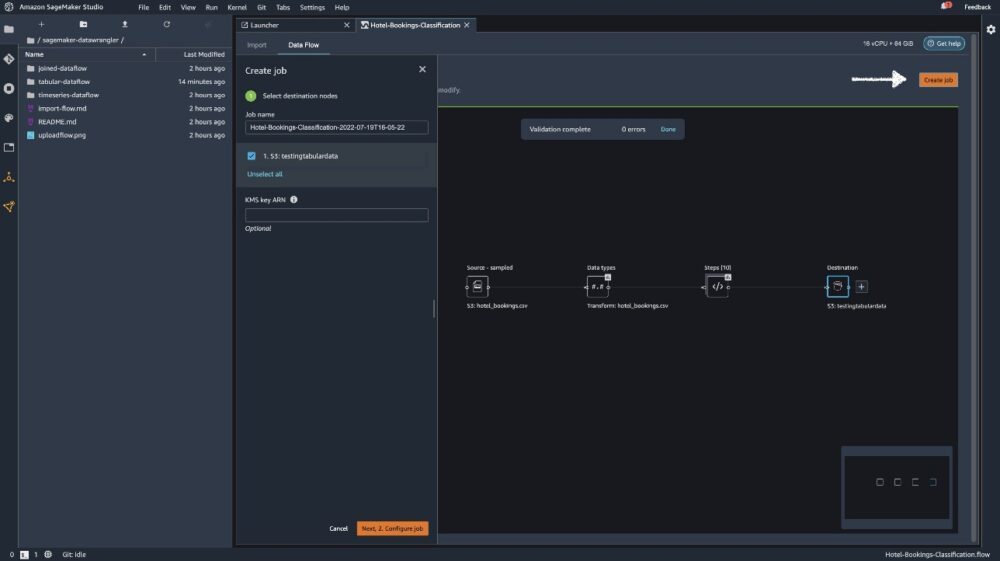

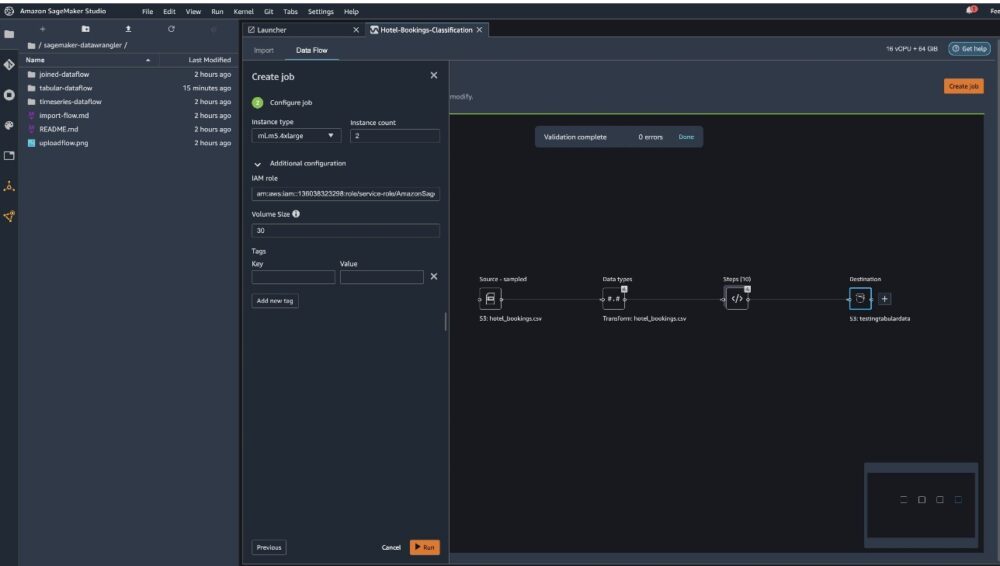

Escolha Criar emprego.

Escolha Nome do trabalho, insira um nome ou mantenha a opção gerada automaticamente e escolha destino. Temos apenas um destino, S3:testingtabulardata, mas você pode ter vários destinos de etapas diferentes no seu fluxo de trabalho. Deixe o ARN da chave KMS campo vazio e escolha Próximo.

Agora você precisa configurar a capacidade computacional para um trabalho. Você pode manter todos os valores padrão deste exemplo.

- Escolha Tipo de instância, use ml.m5.4xlarge.

- Escolha Contagem de instância, use 2.

- Você pode explorar Configuração adicional, mas mantenha as configurações padrão.

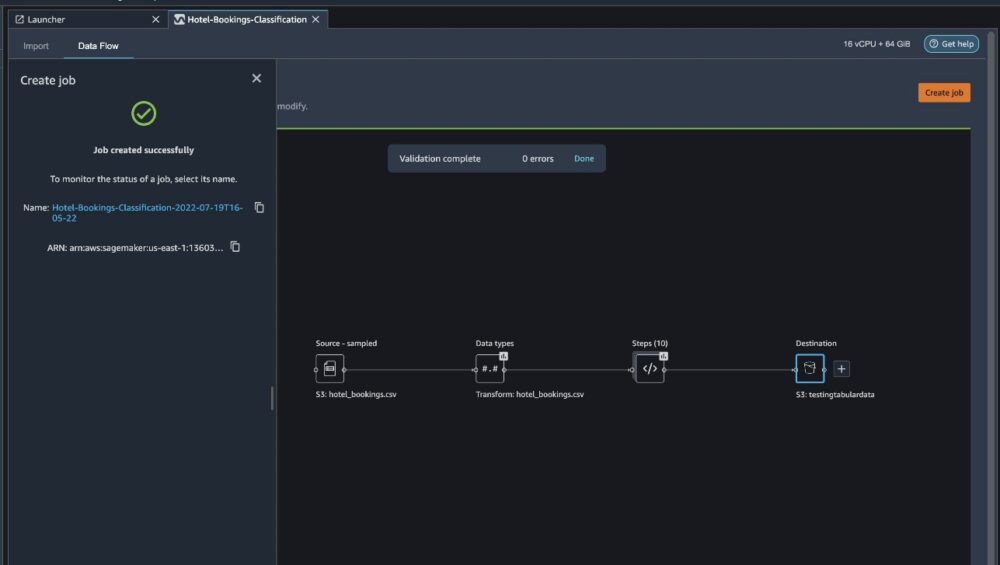

- Escolha Execute.

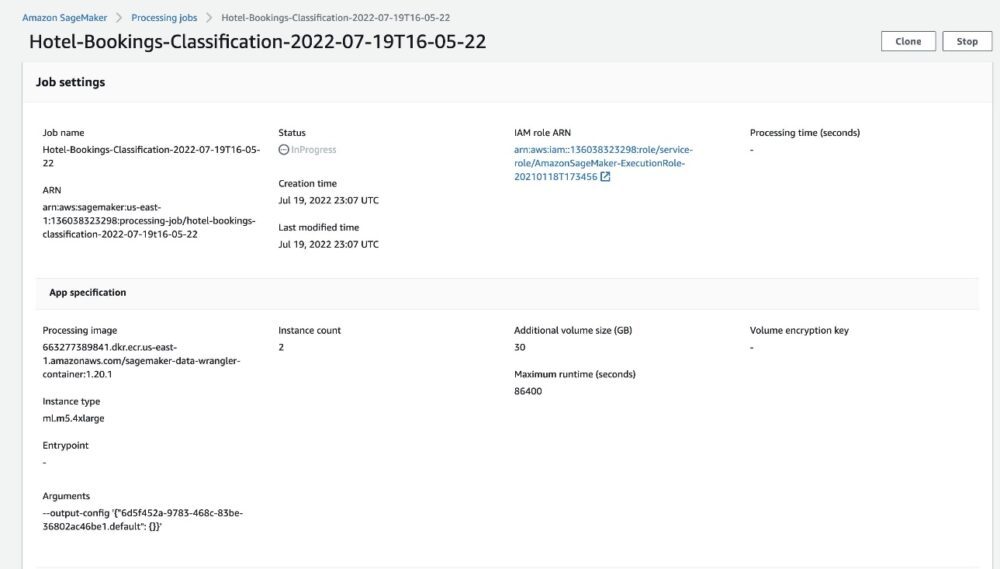

Agora seu trabalho foi iniciado e leva algum tempo para processar 6 GB de dados de acordo com nosso fluxo de processamento do Data Wrangler. O custo deste trabalho será em torno de US$ 2, porque ml.m5.4xlarge custa US$ 0.922 por hora e estamos usando dois deles.

Se você escolher o nome do trabalho, será redirecionado para uma nova janela com os detalhes do trabalho.

Na página de detalhes do trabalho, você pode ver todos os parâmetros das etapas anteriores.

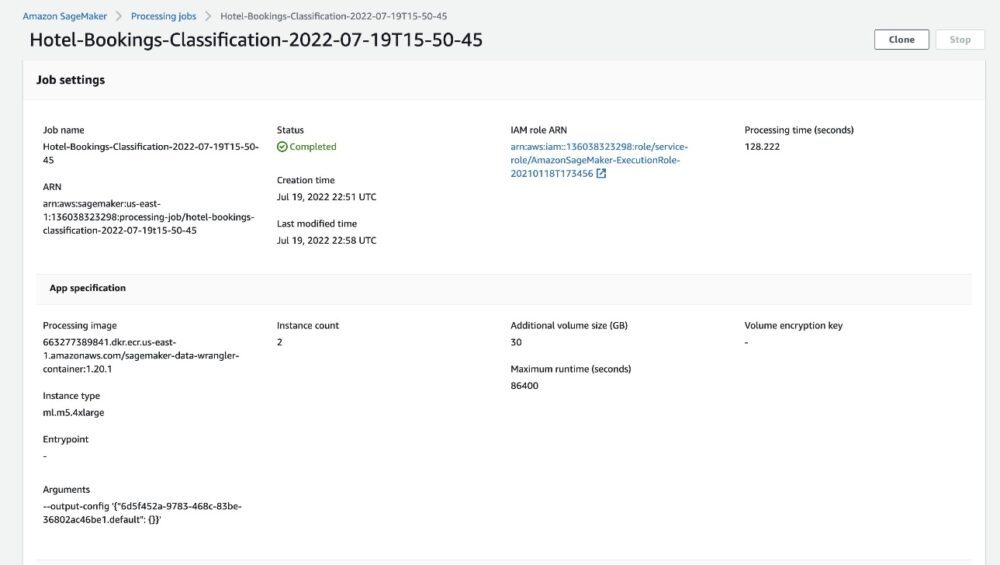

Quando o status do trabalho mudar para Concluído, você também poderá verificar o Tempo de processamento (segundos) valor. Este trabalho de processamento leva cerca de 5 a 10 minutos para ser concluído.

Quando o trabalho for concluído, os arquivos de saída de treinamento e teste estarão disponíveis nas pastas de saída correspondentes do S3. Você pode encontrar o local de saída nas configurações do trabalho de processamento.

Após a conclusão do trabalho de processamento do Data Wrangler, podemos verificar os resultados salvos em nosso bucket S3. Não se esqueça de atualizar o job_name variável com o nome do seu trabalho.

Agora você pode usar esses dados exportados para executar modelos de ML.

limpar

Exclua seus buckets S3 e seu Fluxo do Data Wrangler para excluir os recursos subjacentes e evitar custos indesejados após concluir o experimento.

Conclusão

Nesta postagem, mostramos como você pode importar o fluxo de dados tabular pré-construído para o Data Wrangler, conectá-lo ao nosso conjunto de dados e exportar os resultados para o Amazon S3. Se seus casos de uso exigirem que você manipule dados de séries temporais ou junte vários conjuntos de dados, você poderá passar por outros fluxos de amostra pré-criados na seção GitHub repo.

Depois de importar um fluxo de trabalho de preparação de dados pré-criado, você poderá integrá-lo ao Amazon SageMaker Processing, Pipelines Amazon SageMaker e Loja de recursos Amazon SageMaker para simplificar a tarefa de processamento, compartilhamento e armazenamento de dados de treinamento de ML. Você também pode exportar esse fluxo de dados de amostra para um script Python e criar um pipeline de preparação de dados de ML personalizado, acelerando assim a velocidade de lançamento.

Convidamos você a conferir nosso Repositório GitHub para praticar e encontrar novas maneiras de melhorar a precisão do modelo! Para saber mais sobre o SageMaker, visite o Guia do desenvolvedor Amazon SageMaker.

Sobre os autores

Isha Dua é um arquiteto de soluções sênior baseado na área da baía de São Francisco. Ela ajuda os clientes da AWS Enterprise a crescer entendendo seus objetivos e desafios e os orienta sobre como eles podem arquitetar seus aplicativos de maneira nativa da nuvem, garantindo que sejam resilientes e escaláveis. Ela é apaixonada por tecnologias de aprendizado de máquina e sustentabilidade ambiental.

Isha Dua é um arquiteto de soluções sênior baseado na área da baía de São Francisco. Ela ajuda os clientes da AWS Enterprise a crescer entendendo seus objetivos e desafios e os orienta sobre como eles podem arquitetar seus aplicativos de maneira nativa da nuvem, garantindo que sejam resilientes e escaláveis. Ela é apaixonada por tecnologias de aprendizado de máquina e sustentabilidade ambiental.

- AI

- arte ai

- gerador de arte ai

- ai robô

- Amazon Sage Maker

- Gerenciador de dados do Amazon SageMaker

- inteligência artificial

- certificação de inteligência artificial

- inteligência artificial em bancos

- robô de inteligência artificial

- robôs de inteligência artificial

- software de inteligência artificial

- Aprendizado de máquina da AWS

- blockchain

- conferência blockchain ai

- Coingenius

- inteligência artificial conversacional

- conferência de criptografia ai

- dall's

- deep learning

- google ai

- aprendizado de máquina

- platão

- platão ai

- Inteligência de Dados Platão

- Jogo de Platão

- PlatãoData

- jogo de platô

- escala ai

- sintaxe

- zefirnet