Я большой поклонник шоу о путешествиях Энтони Бурдена. Части неизвестны. В каждом эпизоде шеф-повар посещает отдаленные деревни по всему миру, документируя жизнь, еду и культуру местных племен с открытым сердцем и разумом.

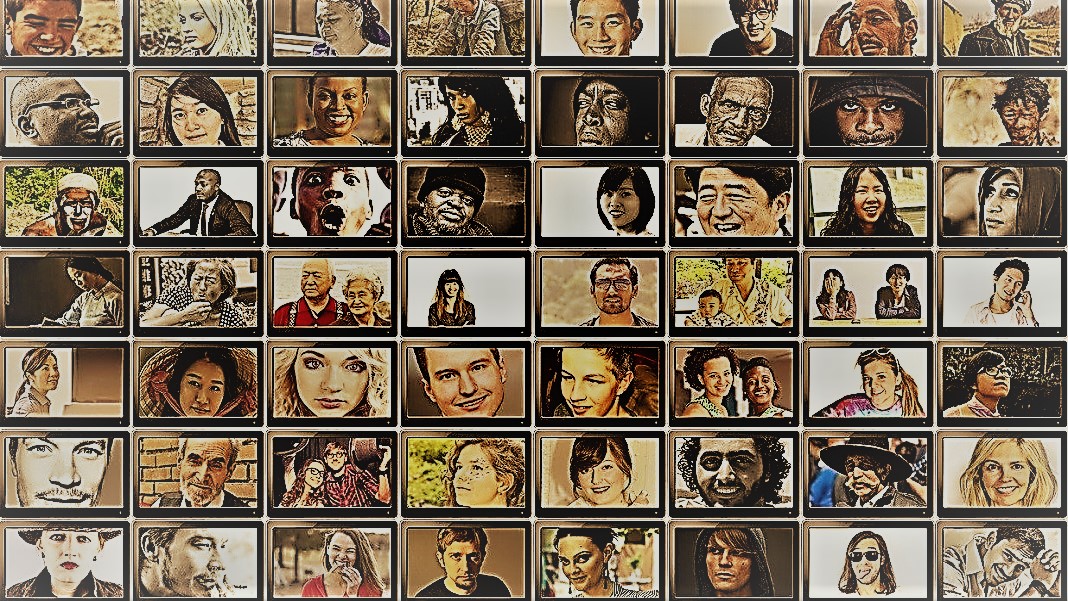

Шоу позволяет заглянуть в удивительное разнообразие человечества. У социологов аналогичная цель — понять поведение разных людей, групп и культур, — но они используют различные методы в контролируемых ситуациях. Для обоих звездами этих занятий являются субъекты: люди.

Но что, если заменить людей чат-ботами с искусственным интеллектом?

Идея звучит нелепо. Тем не менее, благодаря появлению ChatGPT и других больших языковых моделей (LLM), социологи заигрывают с идеей использования этих инструментов для быстрого создания различных групп «симулированных людей» и проведения экспериментов для изучения их поведения и ценностей в качестве прокси их биологических аналогов.

Если вы представляете воссозданные в цифровом виде человеческие разумы, это не так. Идея состоит в том, чтобы использовать опыт ChatGPT в имитации человеческих ответов. Поскольку модели собирают огромное количество онлайн-данных — блогов, комментариев на Youtube, фанфиков, книг — они легко фиксируют отношения между словами на разных языках. Эти сложные алгоритмы могут также расшифровывать нюансы языка, такие как ирония, сарказм, метафоры и эмоциональные оттенки, что является важным аспектом человеческого общения в любой культуре. Эти сильные стороны заставляют LLM имитировать несколько синтетических личностей с широким спектром убеждений.

Еще один бонус? По сравнению с участниками-людьми ChatGPT и другие LLM не устают, позволяя ученым собирать данные и проверять теории о человеческом поведении с беспрецедентной скоростью.

Идея хоть и спорная, но уже имеет поддержку. Недавняя статья анализ зарождающейся области показал, что в некоторых тщательно разработанных сценариях ответы ChatGPT коррелировали с ответами примерно 95 процентов участников-людей.

ИИ «может изменить ход исследований в области социальных наук». — сказал Доктор Игорь Гроссман из Университета Ватерлоо, который вместе с коллегами недавно написал прогнозную статью в Наука. Ключ для использования Человек кремний в исследованиях? По словам команды, тщательное управление предвзятостью и достоверность данных.

Исследование человеческого общественного сознания

Что такое обществознание?

Проще говоря, это изучение того, как люди — индивидуально или как группа — ведут себя в различных обстоятельствах, как они взаимодействуют друг с другом и развиваются как культура. Это зонтик академических исследований с несколькими направлениями: экономика, политология, антропология и психология.

Дисциплина затрагивает широкий круг тем, видных в нынешнем духе времени. Как социальные сети влияют на психическое здоровье? Каково нынешнее отношение общественности к изменению климата по мере увеличения числа эпизодов суровой погоды? Как разные культуры оценивают методы общения и что вызывает недопонимание?

Социальное исследование начинается с вопроса и гипотезы. Один из моих любимых: по-разному ли культуры переносят запах тела? (Без шуток, тема изучено совсем немного, и да, есть разница!)

Затем ученые используют различные методы, такие как анкетирование, поведенческие тесты, наблюдение и моделирование, чтобы проверить свои идеи. Опросы являются особенно популярным инструментом, поскольку вопросы могут быть тщательно разработаны и проверены, а при распространении в Интернете их легко охватить широкий круг людей. Затем ученые анализируют письменные ответы и делают выводы о человеческом поведении. Другими словами, использование языка участником имеет решающее значение для этих исследований.

Так как же ChatGPT вписывается?

«Силикус человека»

Для Гроссмана LLM, стоящие за чат-ботами, такими как ChatGPT или Google Bard, представляют собой беспрецедентную возможность перепроектировать эксперименты в области социальных наук.

По словам авторов, поскольку они обучаются на огромных наборах данных, LLM «могут представлять широкий спектр человеческого опыта и точек зрения». Поскольку модели свободно и без границ «бродят» по Интернету — подобно людям, которые часто путешествуют по миру, — они могут перенимать и демонстрировать более широкий спектр ответов по сравнению с завербованными людьми.

ChatGPT также не подвержен влиянию других участников исследования и не устает, что потенциально позволяет генерировать менее предвзятые ответы. Эти черты могут быть особенно полезны в «проектах с высоким риском» — например, имитация реакции людей, живущих в странах, находящихся в состоянии войны или при сложных режимах, через сообщения в социальных сетях. В свою очередь, ответы могут дать информацию для вмешательства в реальном мире.

Точно так же LLM, прошедшие подготовку по актуальным культурным темам, таким как гендерная идентичность или дезинформация, могут воспроизвести различные теоретические или идеологические школы мысли для обоснования политики. Вместо того, чтобы кропотливо опрашивать сотни тысяч людей, ИИ может быстро генерировать ответы на основе онлайн-дискуссий.

Помимо потенциального использования в реальной жизни, LLM также могут выступать в качестве цифровых субъектов, которые взаимодействуют с людьми-участниками экспериментов в области социальных наук, что в некоторой степени похоже на неигровых персонажей (NPC) в видеоиграх. Например, LLM может принимать разные «личности» и взаимодействовать с людьми-добровольцами по всему миру в режиме онлайн, используя текст, задавая им один и тот же вопрос. Поскольку алгоритмы не спят, они могут работать круглосуточно и без выходных. Полученные данные могут затем помочь ученым изучить, как различные культуры оценивают одинаковую информацию и как распространяются мнения и дезинформация.

Baby Steps

Идея использования чат-ботов вместо людей в исследованиях еще не стала популярной.

Но есть первые доказательства того, что это может сработать. А препринт исследование выпущенный в этом месяце Технологическим институтом Джорджии, Microsoft Research и Колледжем Олина, обнаружил, что LLM воспроизводил человеческие реакции в многочисленных экспериментах по классической психологии, включая печально известный Шоковые эксперименты Милгрэма.

Тем не менее, остается критический вопрос: насколько хорошо эти модели могут действительно отражать реакцию человека?

Есть несколько камней преткновения.

Во-первых, это качество алгоритма и обучающих данных. В большей части онлайн-контента преобладает всего несколько языков. LLM, обученный на этих данных, может легко имитировать чувства, точки зрения или даже моральные суждения людей, которые используют эти языки, в свою очередь, наследуя предвзятость данных обучения.

«Это воспроизводство предубеждений вызывает серьезную озабоченность, потому что оно может усилить те самые различия, которые социологи стремятся выявить в своих исследованиях», — сказал Гроссман.

Некоторые ученые также обеспокоены тем, что LLM просто текущий в обратном направлении что им говорят. Это антитеза исследованиям в области социальных наук, в которых главное — запечатлеть человечество во всей его разнообразной и сложной красоте. С другой стороны, ChatGPT и подобные модели, как известно, «галлюцинировать», придумывая информацию, которая звучит правдоподобно, но является ложной.

На данный момент «большие языковые модели опираются на «тени» человеческого опыта», — сказал Гроссман. Поскольку эти системы ИИ в значительной степени являются черными ящиками, трудно понять, как и почему они генерируют определенные ответы, что немного беспокоит при использовании их в качестве человеческих прокси в поведенческих экспериментах.

Несмотря на ограничения, «LLM позволяют социологам отказаться от традиционных методов исследования и подходить к своей работе новаторски», — говорят авторы. В качестве первого шага Homo silicus может помочь провести мозговой штурм и быстро проверить гипотезы, а перспективные гипотезы будут дополнительно проверены в человеческих популяциях.

Но для того, чтобы социальные науки действительно приветствовали ИИ, потребуются прозрачность, справедливость и равный доступ к этим мощным системам. LLM трудно и дорого обучать, а последние модели все чаще закрываются за огромным платным доступом.

«Мы должны гарантировать, что LLM в области социальных наук, как и все научные модели, имеют открытый исходный код, а это означает, что их алгоритмы и, в идеале, данные доступны всем для тщательного изучения, тестирования и изменения». — сказал автор исследования доктор Доун Паркер из Университета Ватерлоо. «Только сохраняя прозрачность и воспроизводимость, мы можем гарантировать, что исследования в области социальных наук с помощью ИИ действительно способствуют нашему пониманию человеческого опыта».

Изображение Фото: Герд Альтманн / Pixabay

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Автомобили / электромобили, Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- Смещения блоков. Модернизация права собственности на экологические компенсации. Доступ здесь.

- Источник: https://singularityhub.com/2023/07/25/chatgpt-is-replacing-humans-in-studies-on-human-behavior-and-its-working-surprisingly-well/

- :имеет

- :является

- :нет

- $UP

- 23

- a

- О нас

- академический

- доступ

- через

- Действие (Act):

- принять

- приход

- AI

- алгоритм

- алгоритмы

- Все

- позволять

- Позволяющий

- уже

- причислены

- суммы

- an

- анализировать

- и

- Энтони

- подхода

- МЫ

- Аризона

- массив

- гайд

- AS

- внешний вид

- аспекты

- At

- автор

- Авторы

- доступен

- основанный

- BE

- Бьюти

- , так как:

- было

- поведение

- за

- не являетесь

- убеждений

- между

- смещение

- пристрастный

- Немного

- Черный

- Блоки

- тело

- Бонус

- Границы

- изоферменты печени

- коробки

- мозговой штурм

- ветви

- Ломать

- но

- by

- CAN

- захватить

- тщательный

- определенный

- изменение

- символы

- chatbots

- ChatGPT

- обстоятельства

- климат

- Изменение климата

- коллеги

- собирать

- Колледж

- Комментарии

- Связь

- сравненный

- комплекс

- Беспокойство

- строить

- содержание

- способствует

- контроль

- спорный

- может

- страны

- кредит

- критической

- критический аспект

- культурный

- Культура

- Текущий

- данным

- Наборы данных

- предназначенный

- развивать

- различный

- трудный

- Интернет

- цифровой

- Дисплей

- распределенный

- Разное

- Разнообразие

- do

- приносит

- не

- Dont

- dr

- рисовать

- каждый

- Рано

- легко

- Экономика

- огромный

- обеспечивать

- эпизод

- равный

- особенно

- оценивать

- Даже

- Каждая

- точно,

- пример

- дорогим

- опыт

- Впечатления

- Эксперименты

- опыта

- Больше

- справедливость

- ложный

- вентилятор

- Рассказы

- верность

- поле

- Во-первых,

- соответствовать

- продукты

- Что касается

- найденный

- от

- далее

- игра

- Игры

- пол

- порождать

- ГРУЗИИ

- получить

- проблеск

- земной шар

- Группы

- рука

- горсть

- Есть

- Медицина

- Сердце

- помощь

- ГОРЯЧИЙ

- Как

- HTML

- HTTP

- HTTPS

- огромный

- человек

- Человеческий опыт

- Человечество

- Людей

- Сотни

- идея

- Идеально

- идеи

- Личность

- if

- Влияние

- in

- В других

- В том числе

- Увеличение

- все больше и больше

- лиц

- позорный

- влияние

- наделяют информацией

- информация

- инновационный

- размышления

- взаимодействовать

- в

- Ирония

- IT

- ЕГО

- JPG

- всего

- Основные

- известный

- язык

- Языки

- большой

- в значительной степени

- Меньше

- такое как

- недостатки

- Живет

- жизнью

- LLM

- Главная

- Mainstream

- Сохранение

- основной

- Создание

- управление

- массивный

- Май..

- смысл

- Медиа

- Участники

- психический

- Психическое здоровье

- методы

- Microsoft

- против

- умов

- дезинформация

- моделирование

- Модели

- изменять

- Месяц

- моральный

- самых

- с разными

- должен

- my

- рождающийся

- Необходимость

- нет

- сейчас

- многочисленный

- of

- .

- on

- ONE

- те,

- онлайн

- открытый

- с открытым исходным кодом

- Возможность

- or

- Другое

- наши

- новыми участниками

- Люди

- процент

- Личности

- перспектива

- перспективы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- правдоподобный

- Точка

- сборах

- политический

- Популярное

- популяции

- Блог

- потенциально

- мощный

- зонд

- видный

- многообещающий

- доказательство

- приводит

- полномочие

- Психология

- что такое варган?

- преследование

- вопрос

- Вопросы

- ассортимент

- быстро

- скорее

- достигать

- реальный мир

- на самом деле

- последний

- недавно

- офиса

- диеты

- региональный

- Отношения

- выпустил

- полагаться

- остатки

- удаленные

- заменить

- воспроизводимость

- реплицируются

- представлять

- воспроизводство

- исследованиям

- ответ

- ответы

- в результате

- грубо

- Run

- Сказал

- то же

- Сценарии

- Вузы

- Наука

- НАУКА

- научный

- Ученые

- настроение

- набор

- несколько

- тяжелый

- показывать

- аналогичный

- просто

- обстоятельства

- спать

- Соцсети

- социальные сети

- Сообщения в социальных сетях

- социальный

- в некотором роде

- сложный

- скорость

- Звезды

- начинается

- Шаг

- сильные

- стараться

- исследования

- Кабинет

- изучение

- спотыкаясь

- такие

- поддержка

- синтетический

- системы

- Снасти

- Нажмите

- команда

- технологии

- тестXNUMX

- тестов

- чем

- Спасибо

- который

- Ассоциация

- их

- Их

- тогда

- теоретический

- Там.

- Эти

- они

- этой

- те

- хоть?

- мысль

- тысячи

- Через

- устали

- в

- инструментом

- инструменты

- Темы

- к

- традиционный

- Train

- специалистов

- Обучение

- Прозрачность

- путешествовать

- тревожный

- по-настоящему

- ОЧЕРЕДЬ

- зонтик

- открывай

- под

- понимать

- понимание

- Университет

- беспрецедентный

- использование

- использования

- через

- подтверждено

- ценностное

- Наши ценности

- разнообразие

- Огромная

- очень

- прошедшая проверка

- Видео

- видеоигры

- Посещения

- волонтеры

- войны

- способы

- we

- Погода

- добро пожаловать

- ЧТО Ж

- Что

- когда

- который

- КТО

- зачем

- широкий

- Широкий диапазон

- Шире

- Википедия.

- будете

- без

- слова

- Работа

- работает

- беспокоиться

- письменный

- Да

- еще

- Ты

- YouTube

- Дух времени

- зефирнет