- 12 мая 2014

- Василис Вриниотис

- , 4 комментария

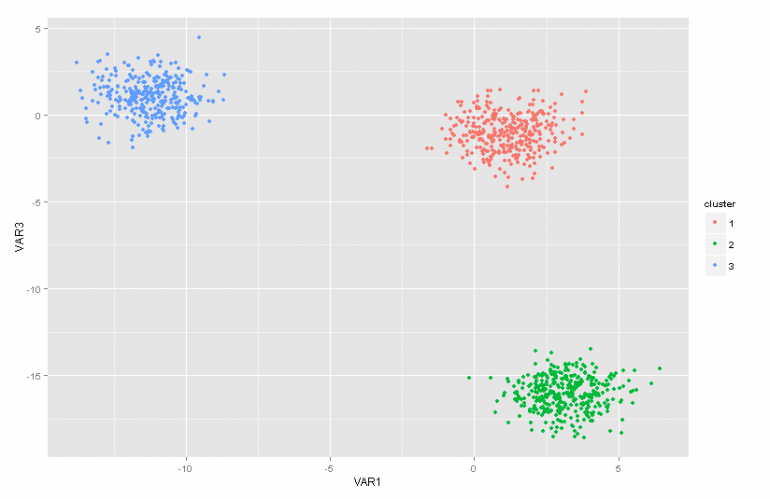

Этот пост является второй частью серии статей о моделях смесей процесса Дирихле. В предыдущей статье мы имели обзор нескольких методов кластерного анализа и мы обсудили некоторые проблемы / ограничения, возникающие при их использовании. Кроме того, мы кратко представили модели смесей процессов Дирихле, поговорили о том, почему они полезны, и представили некоторые их применения.

Обновление: среда машинного обучения Datumbox теперь с открытым исходным кодом и бесплатна для скачать, Проверьте пакет com.datumbox.framework.machinelearning.clustering, чтобы увидеть реализацию моделей процессов Дирихле в Java.

Вначале модели процесса Дирихле может быть немного трудно проглотить, в первую очередь потому, что они представляют собой модели бесконечной смеси с множеством различных представлений. К счастью, хороший способ приблизиться к предмету - начать с моделей конечных смесей с распределением Дирихле, а затем перейти к бесконечным.

Следовательно, в этой статье я кратко представлю некоторые важные распределения, которые нам понадобятся, мы будем использовать их для построения Приора Дирихле с моделью полиномиального правдоподобия, а затем перейдем к модели конечных смесей, основанной на распределении Дирихле.

1. Бета Распределение

Ассоциация Бета-версия семейство непрерывных распределений, которое определено в интервале [0,1]. Он параметризуется двумя положительными параметрами a и b, и его форма сильно зависит от выбора этих двух параметров.

Рисунок 1: Бета-распределение для различных параметров a, b

Бета-распределение обычно используется для моделирования распределения по вероятностям и имеет следующую плотность вероятности:

![]()

Уравнение 1: Бета PDF

Где Γ (x) - гамма-функция, а a, b - параметры распределения. Бета обычно используется как распределение значений вероятности и дает нам вероятность того, что смоделированная вероятность равна определенному значению P = p0. По своему определению бета-распределение способно моделировать вероятность двоичных результатов, которые принимают значения, истинные или ложные. Параметры a и b можно рассматривать как псевдосчет успеха и неудачи соответственно. Таким образом, бета-распределение моделирует вероятность успеха, учитывая успехи и неудачи.

2. Дирихле Распределение

Ассоциация Дирихле Дистрибьюшн является обобщением бета-распределения для нескольких результатов (или, другими словами, оно используется для событий с несколькими результатами). Параметрируется с помощью k параметровi который должен быть положительным. Распределение Дирихле равно бета-распределению, когда число переменных k = 2.

Рисунок 2: Распределение Дирихле для различныхi параметры

Распределение Дирихле обычно используется для моделирования распределения по вероятностям и имеет следующую плотность вероятности:

![]()

Уравнение 2: Дирихле PDF

Где Γ (x) - гамма-функция, pi принять значения в [0,1] и Σpi= 1. Распределение Дирихле моделирует совместное распределение рi и дает вероятность Р1=p1,P2=p2,….,Пк-1=pк-1 с Рk= 1 - ΣPi, Как и в случае с бета-версиейi параметры можно рассматривать как псевдосчет появления каждого события i. Распределение Дирихле используется для моделирования вероятности возникновения k конкурирующих событий и часто обозначается как Дирихле (а).

3. Дирихле Приор с полиномиальной вероятностью

Как упоминалось ранее, распределение Дирихле можно рассматривать как распределение по вероятностным распределениям. В случаях, когда мы хотим смоделировать вероятность k событий, байесовский подход будет использовать Полиномиальная вероятность и дирихле приоры .

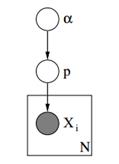

Ниже мы видим графическую модель такой модели.

Рисунок 3: Графическая модель априорных дирихле с полиномиальной вероятностью

В приведенной выше графической модели α - это мерный вектор с гиперпараметрами априорных значений Дирихле, p - это мерный вектор со значениями вероятности и xi это скалярное значение от 1 до k, которое сообщает нам, какое событие произошло. Наконец, следует отметить, что P следует распределению Дирихле, параметризованному вектором α и, следовательно, P ~ Dirichlet (α), тогда как xi переменные следуют дискретному распределению (полиномиальному), параметризованному вектором вероятностей p Подобные иерархические модели могут использоваться в классификации документов для представления распределений частот ключевых слов в разных темах.

4. Модель конечной смеси с распределением Дирихле

Используя Dirichlet Distribution, мы можем построить Модель конечной смеси который может быть использован для кластеризации. Давайте предположим, что у нас есть следующая модель:

![]()

![]()

![]()

![]()

Уравнение 3: модель конечной смеси с распределением Дирихле

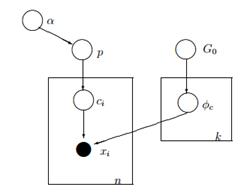

Приведенная выше модель предполагает следующее: у нас есть набор данных X с n наблюдениями, и мы хотим выполнить кластерный анализ на нем. K - это постоянное конечное число, которое показывает количество кластеров / компонентов, которые мы будем использовать. Сi переменные хранят кластерное назначение наблюдения Xiони принимают значения от 1 до k и следуют дискретному распределению с параметром p, который представляет собой вероятности смешивания компонентов. F - генеративное распределение нашего X, и оно параметризовано параметром ![]() который зависит от кластерного назначения каждого наблюдения. Всего у нас есть k уникальных

который зависит от кластерного назначения каждого наблюдения. Всего у нас есть k уникальных ![]() параметры равны количеству наших кластеров.

параметры равны количеству наших кластеров. ![]() переменная хранит параметры, которые параметризуют генеративное распределение F, и мы предполагаем, что оно следует за базой G0 распределение. Переменная p хранит проценты смеси для каждого из k кластеров и следует за Дирихле с параметрами α / k. Наконец, α является k-мерным вектором с гиперпараметрами (псевдосчетами) распределения Дирихле [2].

переменная хранит параметры, которые параметризуют генеративное распределение F, и мы предполагаем, что оно следует за базой G0 распределение. Переменная p хранит проценты смеси для каждого из k кластеров и следует за Дирихле с параметрами α / k. Наконец, α является k-мерным вектором с гиперпараметрами (псевдосчетами) распределения Дирихле [2].

Рисунок 4: Графическая модель модели конечной смеси с распределением Дирихле

Более простой и менее математический способ объяснить модель заключается в следующем. Мы предполагаем, что наши данные могут быть сгруппированы в k кластеров. Каждый кластер имеет свои параметры ![]() и эти параметры используются для генерации наших данных. Параметры

и эти параметры используются для генерации наших данных. Параметры ![]() Предполагается, что следовать некоторому распределению G0, Каждое наблюдение представлено вектором хi и переменного токаi значение, которое указывает кластер, к которому он принадлежит. Следовательно, сi можно рассматривать как переменную, которая следует за дискретным распределением с параметром p, который является ничем иным, как вероятностями смеси, то есть вероятностью появления каждого кластера. Учитывая, что мы решаем нашу проблему байесовским способом, мы не рассматриваем параметр p как постоянный неизвестный вектор. Вместо этого мы предполагаем, что P следует за Дирихле, который параметризован гиперпараметрами α / k.

Предполагается, что следовать некоторому распределению G0, Каждое наблюдение представлено вектором хi и переменного токаi значение, которое указывает кластер, к которому он принадлежит. Следовательно, сi можно рассматривать как переменную, которая следует за дискретным распределением с параметром p, который является ничем иным, как вероятностями смеси, то есть вероятностью появления каждого кластера. Учитывая, что мы решаем нашу проблему байесовским способом, мы не рассматриваем параметр p как постоянный неизвестный вектор. Вместо этого мы предполагаем, что P следует за Дирихле, который параметризован гиперпараметрами α / k.

5. Работа с бесконечными k кластерами

Предыдущая модель смешения позволяет нам проводить обучение без учителя, следует байесовскому подходу и может быть расширена, чтобы иметь иерархическую структуру. Тем не менее, это конечная модель, поскольку она использует постоянное заранее определенное число кластеров. В результате это требует от нас определения количества компонентов перед выполнением кластерного анализа, и, как мы обсуждали ранее в большинстве приложений, это неизвестно и не может быть легко оценено.

Один из способов решения этой проблемы - представить, что k имеет очень большое значение, которое стремится к бесконечности. Другими словами, мы можем представить предел этой модели, когда k стремится к бесконечности. Если это так, то мы можем видеть, что, несмотря на то, что число кластеров k бесконечно, фактическое число активных кластеров (которые имеют хотя бы одно наблюдение) не может быть больше n (что общее количество наблюдений в нашем наборе данных). Фактически, как мы увидим позже, число активных кластеров будет значительно меньше n, и они будут пропорциональны ![]() .

.

Конечно, взять предел k до бесконечности нетривиально. Возникает несколько вопросов, например, можно ли взять такой предел, как будет выглядеть эта модель и как мы можем построить и использовать такую модель.

В следующей статье мы сосредоточимся именно на этих вопросах: мы определим процесс Дирихле, представим различные представления DP и, наконец, сосредоточимся на китайском ресторанном процессе, который является интуитивно понятным и эффективным способом построения процесса Дирихле.

Я надеюсь, что вы нашли этот пост полезным. Если вы сделали, пожалуйста, найдите время, чтобы поделиться статьей в Facebook и Twitter. 🙂

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- искусственный интеллект

- сертификация искусственного интеллекта

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- Датумбокс

- глубокое обучение

- google ai

- обучение с помощью машины

- Машинное обучение и статистика

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- масштаб ай

- синтаксис

- зефирнет