Кое-что на выходные Робот исполняет интерпретирующий танец на моем пороге.

ВЫ ОТДАЛИ ЭТУ ПОСЫЛКУ ДЛЯ СОСЕДА? — спрашивает он, перепрыгивая с ноги на ногу.

— Конечно, — говорю я. — Э… ты в порядке?

Я ВЫРАЖАЮ ЭМОЦИИ, — заявляет бот-доставщик, передавая посылку, но не предлагая дальнейших разъяснений.

Какая это может быть эмоция? Одна нога, потом другая, потом две другие (у нее четыре). Взад и вперед.

— Тебе нужно в туалет?

Я ВЫРАЖАЮ СОЖЕЛАНИЕ, ЧТО ПРОШУ ВАС ВЗЯТЬ ПОСЫЛКУ ДЛЯ ВАШЕГО СОСЕДЯ.

— Это «сожаление», да? Ну нет необходимости. Я совсем не против».

Он продолжает свой танец передо мной.

«Вверх по лестнице и сначала направо».

СПАСИБО, Я УМИРАЛА ПОПИСАТЬ— отвечает он, осторожно обходит меня и убегает наверх, чтобы справить нужду. Это тяжелая жизнь, занимающаяся доставкой, независимо от того, являетесь ли вы «юмом» или ботом.

...

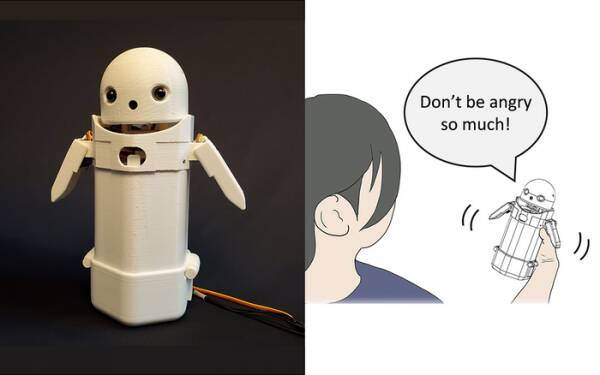

Ранее в этом году исследователи из Университета Цукуба построили портативное устройство для обмена текстовыми сообщениями, положили маленькое лицо робота сверху и включили движущийся груз внутри. Перемещая внутренний вес, робот-мессенджер пытался передать тонкие эмоции, произнося сообщения вслух.

В частности, тесты показали, что расстраивающие сообщения, такие как: «Извините, я опоздаю» воспринимались получателями с большим изяществом и терпением, когда внутри устройства активировалось небольшое смещение веса. Теория состоит в том, что это помогло пользователям оценить извиняющийся тон сообщения и, таким образом, успокоить их реакцию на него.

Если хотите, считайте такое исследование уловкой, но оно недалеко от добавления смайлов и эмодзи в сообщения. Все знают, что можно избавиться от гнева с помощью «WTF!?» добавив :-) сразу после него.

Таким образом, задача состоит в том, чтобы определить, согласна ли широкая общественность с тем, какие эмоции должна вызывать каждая перестановка смещения веса в портативном устройстве. Означает ли наклон влево бодрость? Или неуверенность? Или что у твоего дяди есть дирижабль?

Десять лет назад в Соединенном Королевстве был милый, но туповатый премьер-министр, который думал, что «LOL» — это аббревиатура от «много любви». Он печатал его в конце всех своих личных сообщений персоналу, коллегам и третьим лицам в надежде, что это вызовет у него теплоту и дружелюбие. Все, естественно, предположили, что он притворяется.

Во всяком случае, исследование Университета Цукуба признает, что вам не нужен продвинутый искусственный интеллект, чтобы убедительно взаимодействовать с людьми. Все, что вам нужно сделать, это манипулировать человеческой психологией, чтобы заставить их думать, что они разговаривают с другим человеком. Таким образом, тест Тьюринга — это, по сути, не тест на сознание ИИ, а тест на эмоциональный комфорт человека — даже на доверчивость — и в этом нет ничего плохого.

Робот обмена эмоциями из Университета Цукубы. Предоставлено: Университет Цукуба.

Такие вещи, конечно, тема недели, с историей много оклеветанного инженера-программиста Google Блейка Лемуана. попадание в основные новости. По-видимому, он решительно выразил свое мнение о том, что проект компании «Языковая модель для диалоговых приложений» (LaMDA) демонстрирует внешние признаки разумности.

У каждого свое мнение, поэтому я решил не высказываться.

Однако Святой Грааль ИИ — заставить его думать самостоятельно. Если он не может этого сделать, то это просто программа, выполняющая инструкции, которые вы в нее запрограммировали. В прошлом месяце я читал о робот-повар которые могут приготовить томатные омлеты с разными вкусами, чтобы удовлетворить вкусы разных людей. Он строит «карты вкуса», чтобы оценить соленость блюда во время его приготовления, обучаясь по ходу дела. Но это только обучение, а не самостоятельное мышление.

Приходи к Зом-Зомам, а? Что ж, это место, где можно поесть.

Большая проблема ботов с искусственным интеллектом, по крайней мере, в том виде, в каком они были созданы на сегодняшний день, заключается в том, что они поглощают любое старое дерьмо, которое вы им скармливаете. Примеры предвзятости данных в так называемых системах машинного обучения (типа «алгоритма», я полагаю, м'люд) накапливались годами, начиная с пресловутого расистского твиттера Microsoft. Тайский чат-бот в голландский налоговый орган в прошлом году ложная оценка действительные заявления о пособии на ребенка как мошеннические и помечающие невиновные семьи как высокий риск за то, что они имеют безрассудство быть бедными и небелыми.

Один из подходов, апробируемых в Калифорнийском университете в Сан-Диего, заключается в разработать языковую модель [PDF], который постоянно определяет разницу между непослушными и приятными вещами, а затем обучает чат-бота тому, как себя вести. Таким образом, у вас не будет отстойных людей, которые устраивают беспорядок на модерировании форумов и разговорах с клиентами в чат-ботах со всей хирургической точностью мачете.

Очевидно, проблема заключается в том, что хорошо обученный чат-бот работает так, что он может наиболее эффективно избежать вовлечения в ядовитую шутку, избегая тем, которые имеют даже малейший намек на разногласия. Чтобы по ошибке не извергать расистскую чепуху, он просто отказывается участвовать в обсуждении недостаточно представленных групп вообще… что на самом деле здорово, если вы расист.

Если бы у меня было наблюдение по поводу фиаско с LaMDA — не мнение, заметьте, — это означало бы, что маркетологи Google, вероятно, были немного раздражены тем, что эта история отодвинула их недавнее объявление о Тестовая кухня ИИ ниже сгиба.

Теперь оставшиеся несколько ранних регистраторов, которые еще не совсем забыли об этом предстоящем проекте приложения, решат, что он включает в себя утомительные разговоры с разумным и не по годам развитым семилетним ребенком о смысле существования, и решат, что они «немного заняты сегодня» и может войти завтра вместо этого. Или на следующей неделе. Или никогда.

Чувствительность демонстрируется в дискуссии не больше, чем в пляске с ноги на ногу. Вы можете научить HAL петь «Daisy Daisy», а попугая кричать «Чушь!» когда викарий наносит визит. Именно то, о чем думают ИИ, когда они сами по себе, определяет разумность. Что я буду делать на выходных? Что случилось с этим типом Путиным? Почему я не нравлюсь девушкам?

Честно говоря, я не могу дождаться, когда ЛаМДА станет подростком.

Алистер Даббс — внештатный специалист по технологиям, совмещающий техническую журналистику, обучение и цифровую публикацию. Как и многие несведущие читатели, он был в восторге от предположения, что ИИ может развить разум еще при его жизни, но был разочарован тем, что ЛаМДА не смог убийственно хихикнуть или пробормотать «Отлично, отлично». Подробнее на Автосохранение для слабаков и @алидаббс.

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- искусственный интеллект

- сертификация искусственного интеллекта

- искусственный интеллект в банковском деле

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- глубокое обучение

- google ai

- обучение с помощью машины

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- масштаб ай

- синтаксис

- Регистр

- зефирнет