Бум генеративного ИИ связан с вычислениями. Он обладает уникальным свойством: добавление дополнительных вычислений напрямую приводит к улучшению продукта. Обычно инвестиции в НИОКР более напрямую связаны с тем, насколько ценным был продукт, и эта зависимость явно сублинейна. Но в настоящее время это не так с искусственным интеллектом, и в результате преобладающим фактором, движущим отраслью сегодня, является просто стоимость обучения и умозаключений.

Хотя мы не знаем истинных цифр, мы слышали из авторитетных источников, что предложение вычислительных ресурсов настолько ограничено, что спрос превышает его в 10 (!) раз, поэтому мы считаем справедливым сказать, что прямо сейчас доступ к вычислительным ресурсам — при наименьших общих затратах — стал определяющим фактором успеха ИИ-компаний..

Фактически, мы видели, как многие компании тратят более 80% своего общего капитала на вычислительные ресурсы!

В этом посте мы попытаемся разбить факторы стоимости для компании ИИ. Абсолютные цифры, конечно, со временем изменятся, но мы не видим немедленного облегчения от того, что компании, использующие ИИ, будут связаны своим доступом к вычислительным ресурсам. Так что, надеюсь, это полезная основа для осмысления ландшафта.

Почему модели ИИ так затратны в вычислительном отношении?

Существует множество генеративных моделей ИИ, а затраты на вывод и обучение зависят от размера и типа модели. К счастью, сегодня наиболее популярными моделями являются в основном архитектуры на основе преобразователей, которые включают популярные модели больших языков (LLM), такие как GPT-3, GPT-J или BERT. Хотя точное количество операций для вывода и обучения преобразователей зависит от модели (см. эта бумага), существует довольно точное эмпирическое правило, которое зависит только от количества параметров (т. е. весов нейронных сетей) модели и количества входных и выходных токенов.

Токены — это, по сути, короткие последовательности из нескольких символов. Они соответствуют словам или частям слов. Лучший способ получить представление о токенах — попробовать токенизацию с помощью общедоступных онлайн-токенизаторов (например, OpenAI). Для GPT-3 средняя длина токена составляет 4 символа.

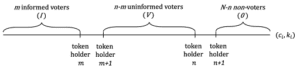

Эмпирическое правило для преобразователей состоит в том, что прямой проход (т. е. вывод) для модели с p параметры для входной и выходной последовательности длины n лексемы каждый, занимает примерно 2*н*п операции с плавающей запятой (ФЛОПС)¹. Обучение одной и той же модели занимает примерно 6*п FLOPS на токен (т. е. для дополнительного обратного прохода требуется еще четыре операции²). Вы можете приблизительно оценить общую стоимость обучения, умножив ее на количество токенов в данных обучения.

Требования к памяти для трансформаторов также зависят от размера модели. Для вывода нам понадобится p параметры модели, чтобы вписаться в память. Для обучения (т. е. обратного распространения) нам необходимо хранить дополнительные промежуточные значения для каждого параметра между прямым и обратным проходом. Предполагая, что мы используем 32-битные числа с плавающей запятой, это дополнительные 8 байтов на параметр. Для обучения модели со 175 миллиардами параметров нам потребуется хранить в памяти более терабайта данных — это больше, чем у любого существующего сегодня графического процессора, и требует от нас разделения модели на карты. Требования к памяти для логических выводов и обучения могут быть оптимизированы за счет использования значений с плавающей запятой меньшей длины, при этом 16-битные становятся обычным явлением, а 8-битные ожидаются в ближайшем будущем.

В приведенной выше таблице указаны размеры и стоимость вычислений для нескольких популярных моделей. GPT-3 имеет около 175 миллиардов параметров, что для ввода и вывода 1,024 токенов приводит к вычислительным затратам примерно в 350 триллионов операций с плавающей запятой (т. е. терафлопс или TFLOPS). Обучение такой модели, как GPT-3, требует около 3.14 * 10 ^ 23 операций с плавающей запятой. Другие модели, такие как LLaMA от Meta, имеют даже выше вычислить требования. Обучение такой модели — одна из наиболее ресурсоемких задач, с которыми человечество сталкивалось до сих пор.

Подводя итог: инфраструктура ИИ стоит дорого, потому что лежащие в ее основе алгоритмические проблемы чрезвычайно сложны в вычислительном отношении. Алгоритмическая сложность сортировки таблицы базы данных с миллионом записей незначительна по сравнению со сложностью генерации одного слова с помощью GPT-3. Это означает, что вы хотите выбрать наименьшую модель, которая решает ваш вариант использования.

Хорошая новость заключается в том, что для трансформеров мы можем легко оценить, сколько вычислений и памяти будет потреблять модель определенного размера. И, таким образом, выбор правильного оборудования становится следующим соображением.

Аргумент времени и стоимости для графических процессоров

Как вычислительная сложность преобразуется во время? Ядро процессора обычно может выполнять 1-2 инструкции за такт, а тактовые частоты процессора стабильны на уровне около 3 ГГц в течение последних 15 лет из-за окончания Деннард Скалинг. Выполнение одной операции логического вывода GPT-3 без использования какой-либо параллельной архитектуры заняло бы порядка 350 TFLOPS/(3 ГГц*1 FLOP), или 116,000 32 секунд, или XNUMX часа. Это крайне непрактично; вместо этого нам нужны специализированные чипы, ускоряющие эту задачу.

На практике все модели ИИ сегодня работают на картах, использующих очень большое количество специализированных ядер. Например, графический процессор NVIDIA A100 имеет 512 «тензорных ядер», которые могут выполнять матричное умножение 4×4 (что эквивалентно 64 умножениям и сложениям, или 128 FLOPS) за один цикл. Карты ускорителей искусственного интеллекта часто называют графическими процессорами (графическими процессорами), поскольку архитектура изначально была разработана для настольных игр. Мы ожидаем, что в будущем искусственный интеллект будет все больше превращаться в отдельное семейство продуктов.

A100 имеет номинальную производительность 312 TFLOPS что теоретически уменьшит вывод для GPT-3 примерно до 1 секунды. Однако это упрощенный расчет по нескольким причинам. Во-первых, в большинстве случаев узким местом является не вычислительная мощность графического процессора, а возможность передачи данных из специализированной графической памяти в тензорные ядра. Во-вторых, 175 миллиардов весов займут 700 ГБ и не поместятся в графическую память любого графического процессора. Необходимо использовать такие методы, как секционирование и весовая потоковая передача. И, в-третьих, существует ряд оптимизаций (например, использование более коротких представлений с плавающей запятой, таких как FP16, FP8 или разреженных матриц), которые используются для ускорения вычислений. Но в целом приведенная выше математика дает нам интуитивное представление об общей стоимости вычислений сегодняшних LLM.

Обучение модели преобразователя занимает примерно в три раза больше времени на токен, чем на вывод. Однако, учитывая, что набор данных для обучения примерно в 300 миллионов раз больше, чем запрос на вывод, обучение занимает в 1 миллиард больше времени. На одном графическом процессоре обучение заняло бы десятилетия; на практике это делается на больших вычислительных кластерах в выделенных центрах обработки данных или, что более вероятно, в облаке. Обучение также труднее распараллелить, чем логический вывод, поскольку между узлами необходимо обмениваться обновленными весами. Память и пропускная способность между графическими процессорами часто становятся гораздо более важными факторами, поскольку широко распространены высокоскоростные межсоединения и выделенные фабрики. Для обучения очень больших моделей главной задачей может стать создание подходящей настройки сети. Заглядывая в будущее, ускорители ИИ будут иметь сетевые возможности на карте или даже на чипе.

Как эта вычислительная сложность преобразуется в стоимость? Вывод GPT-3, который, как мы видели выше, занимает примерно 1 секунду на A100, будет иметь необработанную стоимость вычислений от 0.0002 до 0.0014 долларов США за 1,000 токенов (это сопоставимо с ценой OpenAI 0.002 доллара за 1000 токенов). Пользователь, генерирующий 100 запросов на вывод в день, будет стоить порядка долларов в год. Это очень низкая цена, которая делает большинство вариантов использования текстового ИИ людьми финансово жизнеспособными.

Обучение GPT-3, с другой стороны, намного дороже. Снова подсчитав только стоимость вычислений для 3.14 * 10 ^ 23 FLOPS по вышеуказанным ставкам, мы получим оценку в 560,000 100 долларов США на картах AXNUMX для одиночный тренировочный заезд. На практике для обучения мы не получим почти 100% эффективности GPU; однако мы также можем использовать оптимизации для сокращения времени обучения. Другие оценки стоимости обучения GPT-3 варьируются от $500,000 в $ 4.6 млн, в зависимости от аппаратных предположений. Обратите внимание, что это стоимость одного запуска, а не общая стоимость. Скорее всего, потребуется несколько запусков, и поставщики облачных услуг захотят взять на себя долгосрочные обязательства (подробнее об этом ниже). Обучение первоклассных моделей остается дорогим, но в пределах досягаемости хорошо финансируемого стартапа.

Подводя итог, можно сказать, что сегодня генеративный ИИ требует огромных инвестиций в инфраструктуру ИИ. Нет никаких оснований полагать, что это изменится в ближайшем будущем. Обучение такой модели, как GPT-3, — одна из самых ресурсоемких задач, с которыми когда-либо сталкивалось человечество. И хотя графические процессоры становятся быстрее, и мы находим способы оптимизировать обучение, быстрое распространение ИИ сводит на нет оба этих эффекта.

Рекомендации по инфраструктуре ИИ

До сих пор мы пытались дать вам некоторое интуитивное представление о масштабе, необходимом для обучения и вывода моделей ИИ, и о том, какие основные параметры ими управляют. В этом контексте мы теперь хотим предоставить некоторые практические рекомендации о том, как решить, какую инфраструктуру ИИ использовать.

Внешняя и внутренняя инфраструктура

Посмотрим правде в глаза: графические процессоры — это круто. Многие инженеры и основатели с инженерным складом ума склоняются к предоставлению своего собственного оборудования для ИИ не только потому, что оно обеспечивает детальный контроль над обучением модели, но и потому, что есть что-то забавное в использовании больших объемов вычислительной мощности (Выставка).

Однако реальность такова, что многим стартапам, особенно компаниям, производящим приложения, не нужно создавать собственную инфраструктуру ИИ. в первый день. Вместо этого сервисы размещенных моделей, такие как OpenAI или Hugging Face (для языка) и Replicate (для создания изображений), позволяют основателям быстро искать соответствие продукта рынку без необходимости управлять базовой инфраструктурой или моделями.

Эти услуги стали настолько хороши, что многие компании так и не перешли на них. Разработчики могут добиться значимого контроля над производительностью модели за счет быстрого проектирования и тонкой настройки абстракций более высокого порядка (т. е. тонкой настройки с помощью вызовов API). Цены на эти услуги основаны на потреблении, поэтому часто это дешевле, чем использование отдельной инфраструктуры. Мы видели, как компании, производящие приложения, генерируют более 50 миллионов долларов ARR и оцениваются более чем в 1 миллиард долларов, которые под капотом запускают услуги размещенных моделей.

С другой стороны, некоторые стартапы, особенно те, кто обучает новые базовые модели или создает вертикально интегрированные приложения ИИ, не могут избежать прямого запуска своих собственных моделей на графических процессорах. Либо потому, что модель фактически является продуктом, и команда ищет «соответствие модели рынку», либо потому, что для достижения определенных возможностей или снижения предельных затрат в больших масштабах требуется детальный контроль над обучением и/или выводом. В любом случае управление инфраструктурой может стать источником конкурентного преимущества.

Облако против построения центра обработки данных

В большинстве случаев облако — это подходящее место для вашей инфраструктуры ИИ. Меньшие первоначальные затраты, возможность увеличения и уменьшения масштаба, региональная доступность и меньше отвлекающих факторов от создания собственного центра обработки данных являются привлекательными для большинства стартапов и крупных компаний.

Но есть несколько исключений из этого правила:

- Если вы работаете в очень больших масштабах, может оказаться более рентабельным запустить собственный центр обработки данных. Точная цена варьируется в зависимости от географического положения и настройки, но обычно требует затрат на инфраструктуру более 50 миллионов долларов в год.

- Вам нужно очень специфическое оборудование, которое вы не можете получить от облачного провайдера. Например, типы графических процессоров, которые не являются широко доступными, а также необычные требования к памяти, хранилищу или сети.

- Вы не можете найти облако, приемлемое по геополитическим соображениям.

Если вы хотите построить свой собственный центр обработки данных, мы провели всесторонний анализ цены и производительности графических процессоров для вашей собственной установки (например, Анализ Тима Деттмера). Помимо стоимости и производительности самой карты, выбор аппаратного обеспечения также зависит от мощности, места и охлаждения. Например, две карты RTX 3080 Ti вместе имеют такую же вычислительную мощность, что и A100, но соответствующее энергопотребление составляет 700 Вт против 300 Вт. Разница в мощности в 3,500 кВтч при рыночных ставках 0.10 доллара США за кВтч в течение трехлетнего жизненного цикла увеличивает стоимость RTX3080 Ti почти в 2 раза (приблизительно 1,000 долларов США).

При всем при этом мы ожидаем, что подавляющее большинство стартапов будут использовать облачные вычисления.

Сравнение поставщиков облачных услуг

Amazon Web Services (AWS), Microsoft Azure и Google Cloud Platform (GCP) предлагают инстансы GPU, но появляются и новые поставщики, которые уделяют особое внимание рабочим нагрузкам ИИ. Вот структура, которую многие основатели используют для выбора облачного провайдера:

Цена: В таблице ниже показаны цены на ряд крупных и небольших специализированных облаков по состоянию на 7 апреля 2023 г. Эти данные являются лишь ориентировочными, поскольку экземпляры значительно различаются по пропускной способности сети, затратам на исходящие данные, дополнительным затратам на ЦП и сети, доступным скидки и другие факторы.

Вычислительная мощность на конкретном оборудовании — это товар. Наивно мы ожидали бы достаточно единых цен, но это не так. И хотя между облаками существуют существенные различия в функциях, их недостаточно, чтобы объяснить, что цены на NVIDIA A100 по запросу различаются у разных поставщиков почти в 4 раза.

В верхней части ценовой шкалы крупные публичные облака взимают надбавку в зависимости от репутации бренда, проверенной надежности и необходимости управлять широким спектром рабочих нагрузок. Небольшие специализированные поставщики искусственного интеллекта предлагают более низкие цены, либо используя специально созданные центры обработки данных (например, Coreweave), либо используя другие облака (например, Lambda Labs).

С практической точки зрения, большинство крупных покупателей договариваются о ценах напрямую с облачными провайдерами, часто устанавливая минимальные требования к расходам, а также минимальные временные обязательства (мы видели 1-3 года). Различия в цене между облаками несколько сократились после переговоров, но мы видим, что рейтинг в таблице выше остается относительно стабильным. Также важно отметить, что небольшие компании могут получить агрессивные цены от специализированных облаков без больших обязательств по расходам.

Доступность: Самые мощные графические процессоры (например, Nvidia A100) были постоянно в дефиците в течение последних 12 с лишним месяцев.

Было бы логично предположить, что три ведущих облачных провайдера имеют наилучшую доступность, учитывая их большую покупательную способность и пул ресурсов. Но, что несколько удивительно, многие стартапы не обнаружили, что это правда. В больших облаках есть много оборудования, но также есть и большие потребности клиентов, которые нужно удовлетворять — например, Azure является основным хостом для ChatGPT — и постоянно добавляют/арендуют мощности для удовлетворения спроса. Между тем, Nvidia взяла на себя обязательство сделать аппаратное обеспечение широко доступным для всей отрасли, в том числе для новых специализированных поставщиков. (Они делают это, чтобы быть честными и уменьшить свою зависимость от нескольких крупных клиентов, которые также конкурируют с ними.)

В результате многие стартапы находят более доступные чипы, в том числе передовые Nvidia H100, у более мелких облачных провайдеров. Если вы готовы работать с более новой инфраструктурной компанией, вы можете сократить время ожидания оборудования и, возможно, сэкономить деньги в процессе.

Расчетная модель доставки: Сегодня большие облака предлагают только инстансы с выделенными графическими процессорами, поскольку виртуализация графических процессоров до сих пор остается нерешенной проблемой. Специализированные облака ИИ предлагают другие модели, такие как контейнеры или пакетные задания, которые могут выполнять отдельные задачи без затрат на запуск и демонтаж экземпляра. Если вас устраивает эта модель, она может существенно снизить стоимость.

Сетевые межсоединения: В частности, для обучения пропускная способность сети является основным фактором при выборе провайдера. Кластеры с выделенными фабриками между узлами, такие как NVLink, необходимы для обучения определенных крупных моделей. Для создания изображений плата за исходящий трафик также может быть основным фактором затрат.

Служба поддержки: Крупные облачные провайдеры обслуживают огромный пул клиентов с тысячами артикулов продуктов. Может быть трудно привлечь внимание службы поддержки или решить проблему, если вы не крупный клиент. С другой стороны, многие специализированные облака ИИ предлагают быструю и оперативную поддержку даже для небольших клиентов. Отчасти это связано с тем, что они работают в меньшем масштабе, но также и потому, что их рабочие нагрузки более однородны, поэтому они больше заинтересованы в том, чтобы сосредоточиться на функциях и ошибках, связанных с ИИ.

Сравнение графических процессоров

При прочих равных топовые графические процессоры будут лучше всего работать почти со всеми рабочими нагрузками. Однако, как вы можете видеть в таблице ниже, лучшее оборудование также значительно дороже. Выбор правильного типа графического процессора для вашего конкретного приложения может существенно снизить затраты и определить разницу между жизнеспособной и нежизнеспособной бизнес-моделью.

Решение о том, как далеко идти вниз по списку, то есть определение наиболее экономичного выбора графического процессора для вашего приложения, — это в значительной степени техническое решение, которое выходит за рамки этой статьи. Но мы поделимся ниже некоторыми из критериев выбора, которые, как мы видели, являются наиболее важными:

Обучение против вывода: Как мы видели в первом разделе выше, обучение модели Transformer требует от нас хранения 8 байтов данных для обучения в дополнение к весам модели. Это означает, что типичный высокопроизводительный потребительский графический процессор с 12 ГБ памяти едва ли может быть использован для обучения модели с 4 миллиардами параметров. На практике обучение больших моделей выполняется на кластерах машин, предпочтительно с большим количеством графических процессоров на сервер, большим количеством видеопамяти и соединениями с высокой пропускной способностью между серверами (т. е. кластеры, построенные с использованием высокопроизводительных графических процессоров центров обработки данных).

В частности, многие модели будут наиболее рентабельны на NVIDIA H100, но на сегодняшний день их трудно найти, и обычно требуется долгосрочное обязательство более года. Сегодня NVIDIA A100 выполняет большую часть обучения моделей; его легче найти, но для больших кластеров также могут потребоваться долгосрочные обязательства.

Требования к памяти: Большие LLM имеют слишком большое количество параметров, чтобы поместиться на любой карте. Они должны быть разделены на несколько карт и требуют настройки, аналогичной обучению. Другими словами, вам, вероятно, понадобятся H100 или A100 даже для вывода LLM. Но модели меньшего размера (например, Stable Diffusion) требуют гораздо меньше видеопамяти. Хотя A100 по-прежнему популярен, мы видели, как стартапы используют карты A10, A40, A4000, A5000 и A6000 или даже RTX.

Аппаратная поддержка: Хотя подавляющее большинство рабочих нагрузок в компаниях, с которыми мы говорили, выполняются на NVIDIA, некоторые начали экспериментировать с другими поставщиками. Наиболее распространенным является Google TPU, но Intel Gaudi 2, похоже, также набирает обороты. Проблема с этими поставщиками заключается в том, что производительность вашей модели часто сильно зависит от наличия программных оптимизаций для этих чипов. Вам, вероятно, придется сделать PoC, чтобы понять производительность.

Требования к задержке: Как правило, менее чувствительные к задержкам рабочие нагрузки (например, пакетная обработка данных или приложения, не требующие интерактивных ответов пользовательского интерфейса) могут использовать менее мощные графические процессоры. Это может снизить стоимость вычислений в 3–4 раза (например, по сравнению с A100 и A10 на AWS). С другой стороны, приложениям, ориентированным на пользователя, часто требуются топовые карты, чтобы обеспечить привлекательный пользовательский интерфейс в режиме реального времени. Оптимизация моделей часто необходима, чтобы довести затраты до приемлемого уровня.

шипастость: компании, занимающиеся генеративным искусственным интеллектом, часто наблюдают резкие всплески спроса, поскольку технология настолько новая и захватывающая. Нередко объемы запросов увеличиваются в 10 раз в день в зависимости от выпуска нового продукта или стабильно растут на 50% в неделю. Справляться с такими всплесками часто легче на младших графических процессорах, поскольку по запросу, вероятно, доступно больше вычислительных узлов. Также часто имеет смысл обслуживать такой трафик более дешевыми ресурсами — за счет производительности — если он исходит от менее вовлеченных или менее запоминающих пользователей.

Оптимизация и планирование моделей

Оптимизация программного обеспечения может сильно повлиять на время работы моделей, и 10-кратный выигрыш не редкость. Однако вам необходимо определить, какие методы будут наиболее эффективными для вашей конкретной модели и системы.

Некоторые методы работают с довольно широким кругом моделей. Использование более коротких представлений с плавающей запятой (т. е. FP16 или FP8 по сравнению с исходным FP32) или квантования (INT8, INT4, INT2) позволяет достичь ускорения, которое часто является линейным с уменьшением количества битов. Иногда это требует модификации модели, но все чаще появляются технологии, которые автоматизируют работу со смешанной или меньшей точностью. Обрезка нейронных сетей уменьшает количество весов, игнорируя веса с низкими значениями. Вместе с эффективным умножением разреженных матриц это может обеспечить существенное ускорение на современных графических процессорах. Другой набор методов оптимизации устраняет узкое место в пропускной способности памяти (например, с помощью весов потоковой модели).

Другие оптимизации сильно зависят от модели. Например, Stable Diffusion значительно увеличила объем видеопамяти, необходимой для логических выводов. Еще один класс оптимизаций зависит от аппаратного обеспечения. TensorML от NVIDIA включает в себя ряд оптимизаций, но будет работать только на оборудовании NVIDIA. И последнее, но не менее важное: планирование задач ИИ может привести к огромным узким местам или улучшениям производительности. Распределение моделей по графическим процессорам таким образом, чтобы свести к минимуму перестановку весов, выбор лучшего графического процессора для задачи, если доступно несколько, и минимизация времени простоя за счет предварительного группирования рабочих нагрузок — это распространенные методы.

В конце концов, оптимизация модели по-прежнему остается черной магией, и большинство стартапов, с которыми мы общаемся, работают со сторонними организациями, чтобы помочь с некоторыми из этих аспектов программного обеспечения. Часто это не традиционные поставщики MLops, а компании, специализирующиеся на оптимизации конкретных генеративных моделей (например, OctoML или SegMind).

Как изменится стоимость инфраструктуры ИИ?

За последние несколько лет мы наблюдаем экспоненциальный рост как параметры модели и вычислительная мощность графического процессора. Неясно, сохранится ли эта тенденция.

Сегодня общепризнанно, что существует связь между оптимальным количеством параметров и размером обучающего набора данных (см. шиншилла работайте над этим подробнее). Лучшие LLM сегодня проходят обучение на Обыкновенный обход (набор из 4.5 миллиардов веб-страниц, или около 10% всех существующих веб-страниц). Учебный корпус также включает Википедию и собрание книг, хотя и то, и другое намного меньше (общее количество существующих книг оценивается примерно в всего около 100 миллионов). Были предложены и другие идеи, такие как расшифровка видео- или аудиоконтента, но ни одна из них не приближается по размеру. Неясно, сможем ли мы получить несинтетический обучающий набор данных, который в 10 раз больше, чем тот, который уже использовался.

Производительность графического процессора будет продолжать расти, но более медленными темпами. Закон Мура по-прежнему действует, позволяя использовать больше транзисторов и ядер, но мощность и ввод-вывод становятся ограничивающими факторами. Кроме того, многие из легко висящих фруктов для оптимизации были собраны.

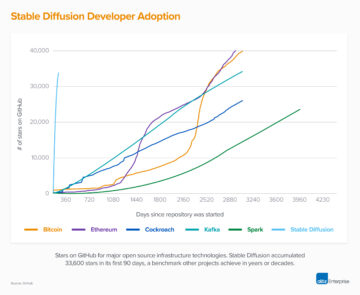

Однако все это не означает, что мы не ожидаем увеличения спроса на вычислительные мощности. Даже если рост моделей и обучающих наборов замедлится, рост индустрии искусственного интеллекта и увеличение числа разработчиков искусственного интеллекта будут стимулировать спрос на более быстрые графические процессоры. Большая часть мощности графического процессора используется разработчиками для тестирования на этапе разработки модели, и этот спрос линейно зависит от численности персонала. Нет никаких признаков того, что нехватка графических процессоров, которая у нас есть сегодня, уменьшится в ближайшем будущем.

Не создаст ли эта сохраняющаяся высокая стоимость инфраструктуры ИИ ров, из-за которого новые участники не смогут догнать хорошо финансируемых действующих игроков? Мы пока не знаем ответа на этот вопрос. Стоимость обучения LLM сегодня может показаться рвом, но модели с открытым исходным кодом, такие как Alpaca или Stable Diffusion, показали, что эти рынки все еще находятся на ранней стадии развития и могут быстро измениться. Со временем структура затрат на формирующийся программный стек ИИ (см. наш предыдущий пост) может начать больше походить на традиционную индустрию программного обеспечения.

В конечном счете, это было бы хорошо: история показала, что это приводит к динамичным экосистемам с быстрыми инновациями и множеством возможностей для предприимчивых основателей.

Спасибо Мойну Надиму и Шангде Сюй за их вклад и руководство в процессе написания.

¹ Интуиция здесь такова, что для любого параметра (т. е. веса) в нейронной сети операция вывода (т. е. прямой проход) должна выполнять две операции с плавающей запятой для каждого параметра. Во-первых, он умножает значение входного узла нейронной сети на параметр. Во-вторых, он добавляет результат суммирования к выходному узлу нейронной сети. Параметры в кодировщике используются один раз для входного токена, а параметры в декодере используются один раз для выходного токена. Если предположить, что модель имеет p параметры и ввод и вывод имеют длину n лексемы, общее количество операций с плавающей запятой п * р. Есть много других операций (например, нормализация, кодирование/декодирование встраивания), которые происходят в модели, но время, необходимое для их выполнения, невелико по сравнению с ними.

² Сначала для обучения требуется прямой проход через преобразователь, как описано выше, за которым следует обратный проход, который требует четырех дополнительных операций для каждого параметра для вычисления градиента и настройки веса. Обратите внимание, что вычисление градиента требует сохранения вычисленных значений узла из прямого прохода. Для ГПТ-3, Языковые модели - немногие изучающие обсуждает стоимость обучения.

* * *

Мнения, выраженные здесь, принадлежат отдельным цитируемым сотрудникам AH Capital Management, LLC («a16z») и не являются мнением a16z или ее аффилированных лиц. Определенная информация, содержащаяся здесь, была получена из сторонних источников, в том числе от портфельных компаний фондов, управляемых a16z. Хотя информация взята из источников, считающихся надежными, a16z не проводила независимую проверку такой информации и не делает никаких заявлений о неизменной точности информации или ее уместности в данной ситуации. Кроме того, этот контент может включать стороннюю рекламу; a16z не просматривал такие рекламные объявления и не поддерживает какой-либо рекламный контент, содержащийся в них.

Этот контент предоставляется только в информационных целях и не может рассматриваться как юридическая, деловая, инвестиционная или налоговая консультация. Вы должны проконсультироваться со своими советниками по этим вопросам. Ссылки на любые ценные бумаги или цифровые активы предназначены только для иллюстративных целей и не представляют собой инвестиционную рекомендацию или предложение предоставить консультационные услуги по инвестициям. Кроме того, этот контент не предназначен и не предназначен для использования какими-либо инвесторами или потенциальными инвесторами, и ни при каких обстоятельствах на него нельзя полагаться при принятии решения об инвестировании в какой-либо фонд, управляемый a16z. (Предложение инвестировать в фонд a16z будет сделано только в меморандуме о частном размещении, договоре о подписке и другой соответствующей документации любого такого фонда, и их следует читать полностью.) Любые инвестиции или портфельные компании, упомянутые, упомянутые или описанные не являются репрезентативными для всех инвестиций в транспортные средства, управляемые a16z, и нет никаких гарантий, что инвестиции будут прибыльными или что другие инвестиции, сделанные в будущем, будут иметь аналогичные характеристики или результаты. Список инвестиций, сделанных фондами, управляемыми Andreessen Horowitz (за исключением инвестиций, в отношении которых эмитент не предоставил разрешение на публичное раскрытие информации a16z, а также необъявленных инвестиций в публично торгуемые цифровые активы), доступен по адресу https://a16z.com/investments. /.

Диаграммы и графики, представленные в нем, предназначены исключительно для информационных целей, и на них не следует полагаться при принятии каких-либо инвестиционных решений. Прошлые показатели не свидетельствуют о будущих результатах. Содержание говорит только по состоянию на указанную дату. Любые прогнозы, оценки, прогнозы, цели, перспективы и/или мнения, выраженные в этих материалах, могут быть изменены без предварительного уведомления и могут отличаться или противоречить мнениям, выраженным другими. Пожалуйста, посетите https://a16z.com/disclosures для получения дополнительной важной информации.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- ПлатонАйСтрим. Анализ данных Web3. Расширение знаний. Доступ здесь.

- Чеканка будущего с Эдриенн Эшли. Доступ здесь.

- Источник: https://a16z.com/2023/04/27/navigating-the-high-cost-of-ai-compute/

- :имеет

- :является

- :нет

- 1 млрд долларов США

- $UP

- 000

- 1

- 100

- 116

- 15 лет

- 2023

- 500

- 7

- 8

- a

- a16z

- способность

- в состоянии

- О нас

- выше

- Absolute

- ускорять

- ускоритель

- ускорители

- приемлемый

- принятый

- доступ

- точность

- точный

- Достигать

- через

- добавить

- дополнение

- дополнительный

- Дополнительно

- дополнениями

- адреса

- Добавляет

- продвижение

- авансы

- плюс

- Реклама

- совет

- консультативный

- консультационные услуги

- влиять на

- филиалы

- После

- снова

- агрессивный

- ДОГОВОР

- AI

- алгоритмический

- Все

- ассигнования

- Позволяющий

- уже

- причислены

- Несмотря на то, что

- среди

- количество

- суммы

- an

- анализ

- и

- Andreessen

- Andreessen Horowitz

- Другой

- ответ

- Ожидаемый

- любой

- API

- приложение

- появляться

- появляется

- Применение

- Приложения

- примерно

- Программы

- апрель

- архитектура

- МЫ

- аргумент

- около

- Искусство

- гайд

- искусственный

- искусственный интеллект

- AS

- аспекты

- Активы

- гарантия

- At

- внимание

- аудио

- автоматизировать

- свободных мест

- доступен

- в среднем

- избежать

- AWS

- Лазурный

- Пропускная способность

- основанный

- BE

- , так как:

- становиться

- становится

- становление

- было

- не являетесь

- верить

- распространенной

- ниже

- ЛУЧШЕЕ

- Лучшая

- между

- Beyond

- смещение

- большой

- миллиард

- Немного

- Черный

- Книги

- бум

- изоферменты печени

- Граница

- марка

- Ломать

- приносить

- широкий

- широко

- ошибки

- строить

- Строительство

- построенный

- бизнес

- Бизнес-модель

- но

- покупателей

- by

- вычислять

- рассчитанный

- расчет

- Объявления

- CAN

- Может получить

- не могу

- возможности

- Пропускная способность

- столица

- карта

- Карты

- случаев

- случаев

- Привлекайте

- Центр

- Центры

- определенный

- вызов

- изменение

- характеристика

- символы

- заряд

- ChatGPT

- более дешевый

- чип

- чипсы

- выбор

- Выберите

- обстоятельства

- класс

- Очистить

- Часы

- Закрыть

- облако

- облачных вычислений

- Облачная платформа

- лыжных шлемов

- как

- выходит

- удобный

- обязательство

- привержен

- совершение

- товар

- Общий

- Компании

- Компания

- сравненный

- сравнив

- сравнение

- неотразимый

- конкурировать

- конкурентоспособный

- сложность

- комплексный

- вычисление

- Вычисление

- вычисление

- вычислительная мощность

- Коммутация

- рассмотрение

- соображения

- постоянно

- составлять

- потреблять

- потребитель

- потребление

- Контейнеры

- содержание

- контекст

- продолжать

- продолжающийся

- вопреки

- контроль

- Холодные

- Основные

- Цена

- рентабельным

- Расходы

- может

- "Курс"

- Создайте

- Создающий

- Критерии

- В настоящее время

- клиент

- служба поддержки

- Клиенты

- передовой

- цикл

- данным

- Центр обработки данных

- центров обработки данных

- обработка данных

- набор данных

- База данных

- Время

- день

- десятилетия

- решать

- решение

- преданный

- DeepMind

- доставить

- поставка

- Спрос

- зависимость

- зависимый

- в зависимости

- зависит

- описано

- компьютера

- Определять

- определения

- развитый

- застройщиков

- Развитие

- отличаться

- разница

- Различия

- Вещание

- Интернет

- Цифровые активы

- непосредственно

- Раскрывать

- скидки

- отчетливый

- do

- документации

- приносит

- дело

- долларов

- сделанный

- Dont

- вниз

- время простоя

- драматично

- управлять

- водитель

- вождение

- два

- в течение

- e

- Рано

- легче

- легко

- Экосистемы

- Эффективный

- фактически

- эффекты

- затрат

- эффективный

- или

- вложения

- появление

- конец

- одобрять

- выносливый

- занятый

- привлечение

- Проект и

- Инженеры

- цельность

- входящий

- предпринимательский

- Эквивалент

- особенно

- по существу

- оценка

- к XNUMX году

- Оценки

- Даже

- НИКОГДА

- развивается

- пример

- превышает

- захватывающий

- без учета

- выполнять

- проведение

- существовать

- расширение

- ожидать

- дорогим

- опыт

- Объяснять

- экспоненциальный

- Экспоненциальный рост

- выраженный

- чрезвычайно

- ткань

- Face

- факторы

- ярмарка

- достаточно

- семья

- БЫСТРО

- быстрее

- Особенность

- Особенности

- Сборы

- несколько

- в финансовом отношении

- Найдите

- конец

- Во-первых,

- соответствовать

- фиксированной

- кувырок

- плавающий

- Фокус

- следует

- Что касается

- Прогнозы

- К счастью

- вперед

- найденный

- Год основания

- Учредителями

- 4

- доля

- Рамки

- от

- топливо

- fun

- фонд

- средства

- Более того

- будущее

- Доходы

- игровой

- Общие

- порождающий

- поколение

- генеративный

- Генеративный ИИ

- географический

- геополитический

- получить

- получающий

- Дайте

- данный

- дает

- Go

- хорошо

- Google Cloud

- Виртуальная платформа Google

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- выпускник

- графика

- Графики

- Расти

- Рост

- руководство

- рука

- обрабатывать

- Управляемость

- происходить

- Жесткий

- Аппаратные средства

- Освоение

- Есть

- численность

- услышанный

- помощь

- полезный

- здесь

- High

- Лидирующий

- очень

- история

- капот

- С надеждой

- Горовиц

- кашель

- состоялся

- ЧАСЫ

- Как

- How To

- Однако

- HTML

- HTTPS

- огромный

- Очень

- Людей

- i

- идеи

- if

- изображение

- немедленная

- важную

- что она

- улучшение

- in

- В других

- стимулы

- включают

- включает в себя

- В том числе

- Увеличение

- Увеличивает

- все больше и больше

- самостоятельно

- указанный

- individual

- промышленность

- информация

- Информационный

- Инфраструктура

- Инновации

- вход

- пример

- вместо

- инструкции

- интегрированный

- Интеллекта

- интерактивный

- в

- Грин- карта инвестору

- инвестиций

- инвестиционный консалтинг

- Вложения

- Инвесторы

- эмитент

- IT

- ЕГО

- саму трезвость

- Джобс

- всего

- Сохранить

- Вид

- Знать

- Labs

- пейзаж

- язык

- большой

- в значительной степени

- больше

- Фамилия

- Задержка

- закон

- Лиды

- изучение

- Юр. Информация

- Длина

- ЖИЗНЬЮ

- такое как

- Вероятно

- Список

- Лама

- LLM

- расположение

- логический

- Длинное

- долгосрочный

- дольше

- посмотреть

- выглядит как

- искать

- серия

- Низкий

- ниже

- низший

- Продукция

- сделанный

- основной

- Большинство

- сделать

- ДЕЛАЕТ

- Создание

- управлять

- управляемого

- управление

- управления

- человечество

- многих

- рынок

- Области применения:

- массивный

- материалы

- математике

- матрица

- Вопросы

- макс-ширина

- Май..

- значимым

- означает

- Между тем

- Встречайте

- Меморандум

- Память

- упомянутый

- методы

- Microsoft

- Microsoft Azure

- миллиона

- минимизация

- минимальный

- смешанный

- млн операций в секунду

- модель

- Модели

- Модерн

- деньги

- месяцев

- БОЛЕЕ

- самых

- Самые популярные

- много

- с разными

- умножения

- навигационный

- Возле

- почти

- необходимо

- Необходимость

- необходимый

- потребности

- сеть

- сетей

- сетей

- нейронной сети

- нейронные сети

- Новые

- новый продукт

- Новости

- следующий

- нет

- узел

- узлы

- Уведомление..

- сейчас

- номер

- номера

- Nvidia

- получать

- полученный

- of

- предлагают

- предлагающий

- .

- on

- On-Demand

- консолидировать

- ONE

- онлайн

- только

- открытый

- с открытым исходным кодом

- OpenAI

- операционный

- операция

- Операционный отдел

- Мнения

- Возможности

- оптимальный

- оптимизация

- Оптимизировать

- оптимизированный

- оптимизирующий

- or

- заказ

- оригинал

- первоначально

- Другое

- Другое

- наши

- внешний

- выходной

- опережает

- за

- общий

- собственный

- Параллельные

- параметр

- параметры

- особый

- Стороны

- части

- pass

- мимо

- Выполнять

- производительность

- разрешение

- Персонал

- фаза

- выбирать

- взял

- Часть

- Платформа

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- пожалуйста

- PoC

- Точка

- бассейн

- Популярное

- «портфель»

- возможно

- После

- мощностью

- мощный

- практическое

- практика

- Точность

- Премиум

- предыдущий

- цена

- Цены

- цены

- первичный

- частная

- вероятно

- Проблема

- проблемам

- процесс

- обработка

- процессор

- Продукт

- выгодную

- Прогнозы

- собственность

- предполагаемый

- перспектива

- доказанный

- обеспечивать

- при условии

- Недвижимости

- поставщики

- что такое варган?

- публично

- покупка

- целей

- вопрос

- быстро

- R & D

- поднятый

- ассортимент

- Ранжирование

- быстро

- быстро

- Обменный курс

- Стоимость

- Сырье

- достигать

- Читать

- реального времени

- Реальность

- причина

- причины

- Рекомендация

- уменьшить

- снижает

- Рекомендации

- назвало

- региональный

- отношения

- относительно

- освободить

- соответствующие

- надежность

- складская

- помощь

- оставаться

- остатки

- представитель

- уважаемый

- репутация

- запросить

- Запросы

- требовать

- обязательный

- требование

- Требования

- требуется

- Полезные ресурсы

- те

- отзывчивый

- результат

- Итоги

- отзывы

- RTX

- RTX 3080

- RTX 3080 Ti

- Правило

- Run

- Бег

- Сказал

- то же

- Сохранить

- Шкала

- Весы

- планирование

- сфера

- Поиск

- поиск

- Во-вторых

- секунды

- Раздел

- Ценные бумаги

- посмотреть

- видел

- выбор

- смысл

- чувствительный

- отдельный

- Последовательность

- служить

- Серверы

- обслуживание

- Услуги

- набор

- установка

- несколько

- Поделиться

- Короткое

- нехватка

- должен

- показанный

- Шоу

- сторона

- подпись

- аналогичный

- просто

- с

- одинарной

- ситуация

- Размер

- Размеры

- замедляет

- небольшой

- меньше

- So

- уже

- Software

- Решает

- некоторые

- удалось

- в некотором роде

- Источник

- Источники

- Space

- Говоря

- Говорит

- специализироваться

- специализированный

- Специальные

- конкретный

- конкретно

- тратить

- Расходы

- шипы

- раскол

- стабильный

- стек

- Начало

- Start-up

- и политические лидеры

- Стартапы

- По-прежнему

- диск

- магазин

- потоковый

- Структура

- предмет

- подписка

- существенный

- успех

- такие

- подходящее

- суммировать

- поставка

- поддержка

- система

- ТАБЛИЦЫ

- взять

- принимает

- Говорить

- направлена против

- Сложность задачи

- задачи

- налог

- команда

- Технический

- снижения вреда

- технологии

- Технологии

- terms

- Тестирование

- чем

- который

- Ассоциация

- Будущее

- информация

- Пейзаж

- их

- Их

- Там.

- в нем

- Эти

- они

- задача

- think

- мышление

- В третьих

- третье лицо

- сторонние

- этой

- те

- тысячи

- три

- Через

- Связанный

- время

- раз

- в

- сегодня

- Сегодняшних

- вместе

- знак

- лексемизацию

- Лексемы

- слишком

- топ

- Всего

- к

- тяга

- торговал

- традиционный

- трафик

- Train

- специалистов

- Обучение

- трансформеры

- переведите

- тенденция

- пыталась

- Триллион

- правда

- два

- напишите

- Типы

- типичный

- типично

- ui

- Обычный

- под

- лежащий в основе

- понимать

- созданного

- единиц

- обновление

- на

- us

- использование

- прецедент

- используемый

- Информация о пользователе

- Пользовательский опыт

- пользователей

- через

- обычно

- ценный

- ценностное

- ценный

- Наши ценности

- разнообразие

- Огромная

- Транспорт

- поставщики

- проверено

- вертикально

- очень

- жизнеспособный

- яркие

- Видео

- Просмотры

- тома

- vs

- ждать

- хотеть

- законопроект

- Путь..

- способы

- we

- Web

- веб-сервисы

- неделя

- вес

- ЧТО Ж

- Что

- когда

- который

- в то время как

- КТО

- широкий

- Широкий диапазон

- широко

- Википедия.

- будете

- готовый

- в

- без

- Word

- слова

- Работа

- работает

- бы

- письмо

- год

- лет

- еще

- Ты

- ВАШЕ

- зефирнет