Введение

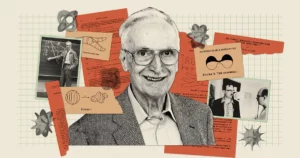

Искусственный интеллект кажется более мощным, чем когда-либо: чат-боты, такие как Bard и ChatGPT, способны создавать сверхчеловеческий текст. Но, несмотря на все свои таланты, эти боты по-прежнему заставляют исследователей задуматься: действительно ли такие модели на самом деле понять что они говорят? «Очевидно, что некоторые люди верят в это», — сказал пионер искусственного интеллекта. Джефф Хинтон в недавний разговор с Эндрю Нг, «а некоторые люди считают, что они просто стохастические попугаи».

Эта запоминающаяся фраза пришла из 2021 года. бумаги в соавторстве с Эмили Бендер, компьютерный лингвист из Вашингтонского университета. Это предполагает, что большие языковые модели (LLM), составляющие основу современных чат-ботов, генерируют текст только путем объединения информации, которую они уже видели, «без какой-либо ссылки на смысл», пишут авторы, что делает LLM «стохастическим попугаем».

Эти модели используются во многих крупнейших и лучших на сегодняшний день чат-ботах, поэтому Хинтон утверждает, что пришло время определить степень того, что они понимают. Для него этот вопрос более чем академический. «Пока у нас есть эти разногласия», — сказал он Нгу, — «мы не сможем прийти к консенсусу относительно опасностей».

Новое исследование может дать намек на ответ. Теория, разработанная Санджив Arora Принстонского университета и Анируд Гоял, научный сотрудник Google DeepMind, предполагает, что крупнейшие из сегодняшних LLM не являются стохастическими попугаями. Авторы утверждают, что по мере того, как эти модели становятся больше и обучаются на большем количестве данных, они улучшают индивидуальные языковые способности, а также развивают новые, комбинируя навыки таким образом, который намекает на понимание — комбинаций, которые вряд ли существовали в обучающих данных. .

Этот теоретический подход, который обеспечивает математически доказуемый аргумент в пользу того, как и почему LLM может развить так много способностей, убедил таких экспертов, как Хинтон и других. И когда Арора и его команда проверили некоторые из своих предсказаний, они обнаружили, что эти модели ведут себя почти так, как ожидалось. Судя по всему, они убедительно доказали, что крупнейшие компании LLM не просто повторяют то, что видели раньше.

«[Они] не могут просто имитировать то, что было замечено в данных обучения», — сказал Себастьен Бубек, математик и ученый-компьютерщик из Microsoft Research, не принимавший участия в работе. «Это основная идея».

Больше данных, больше мощности

Появление неожиданные и разнообразные способности в магистратуре, честно говоря, стало неожиданностью. Эти способности не являются очевидным следствием того, как построены и обучены системы. LLM — это массивная искусственная нейронная сеть, которая соединяет отдельные искусственные нейроны. Эти связи известны как параметры модели, а их количество обозначает размер LLM. Обучение предполагает предоставление LLM предложения с скрытым последним словом, например: «Топливо стоит руку и ___». LLM прогнозирует распределение вероятностей по всему словарю, поэтому, если он знает, скажем, тысячу слов, он прогнозирует тысячу вероятностей. Затем он выбирает наиболее подходящее слово для завершения предложения — предположительно, «нога».

Первоначально LLM может плохо подбирать слова. Затем алгоритм обучения вычисляет потерю — расстояние в некотором многомерном математическом пространстве между ответом LLM и фактическим словом в исходном предложении — и использует эту потерю для настройки параметров. Теперь, учитывая то же предложение, LLM рассчитает лучшее распределение вероятностей, и его потери будут немного ниже. Алгоритм делает это для каждого предложения в обучающих данных (возможно, миллиардов предложений), пока общие потери LLM не упадут до приемлемого уровня. Аналогичный процесс используется для тестирования LLM на предложениях, которые не были частью обучающих данных.

Обученный и протестированный LLM, когда ему предоставляется новая текстовая подсказка, сгенерирует наиболее вероятное следующее слово, добавит его к подсказке, сгенерирует еще одно следующее слово и продолжит таким же образом, давая, казалось бы, связный ответ. Ничто в процессе обучения не предполагает, что более крупные LLM, построенные с использованием большего количества параметров и обучающих данных, также должны улучшаться в задачах, для ответа на которые требуется рассуждение.

Но они это делают. Достаточно большие LLM демонстрируют способности — от решения элементарных математических задач до ответов на вопросы о том, что происходит в головах других, — которых нет у меньших моделей, хотя все они обучены одинаково.

«Откуда взялась эта [способность]?» — задумался Арора. «И может ли это возникнуть из-за предсказания следующего слова?»

Соединение навыков с текстом

Арора объединился с Гоялом, чтобы аналитически ответить на такие вопросы. «Мы пытались разработать теоретическую основу, чтобы понять, как происходит возникновение», — сказал Арора.

Дуэт обратился к математическим объектам, называемым случайными графами. Граф — это совокупность точек (или узлов), соединенных линиями (или ребрами), а в случайном графе наличие ребра между любыми двумя узлами определяется случайным образом — скажем, подбрасыванием монеты. Монета может быть смещена, так что с некоторой вероятностью выпадет орел. p. Если монета выпадает орлом для данной пары узлов, между этими двумя узлами образуется ребро; в противном случае они остаются неподключенными. Поскольку значение p изменения, графики могут показывать внезапные переходы в их свойствах. Например, когда p превышает определенный порог, изолированные узлы — те, которые не связаны ни с каким другим узлом — внезапно исчезают.

Арора и Гоял поняли, что случайные графики, которые приводят к неожиданному поведению после достижения определенных пороговых значений, могут быть способом моделирования поведения LLM. Нейронные сети стали слишком сложны для анализа, но математики уже давно изучают случайные графы и разработали различные инструменты для их анализа. Возможно, теория случайных графов могла бы дать исследователям возможность понять и предсказать явно неожиданное поведение крупных LLM.

Исследователи решили сосредоточиться на «двудольных» графах, которые содержат узлы двух типов. В их модели один тип узла представляет собой фрагменты текста — не отдельные слова, а фрагменты, которые могут представлять собой абзац длиной в несколько страниц. Эти узлы расположены по прямой. Под ними, в другой строке, находится другой набор узлов. Они представляют собой навыки, необходимые для понимания данного фрагмента текста. Каждый навык может быть чем угодно. Возможно, один узел представляет собой способность LLM понимать слово «потому что», которое включает в себя некоторое понятие причинности; другой может представлять собой способность разделить два числа; еще один может представлять способность обнаруживать иронию. «Если вы понимаете, что этот фрагмент текста ироничен, многое меняется», — сказал Арора. «Это имеет отношение к предсказанию слов».

Чтобы внести ясность, LLM не обучаются и не тестируются с учетом навыков; они созданы только для улучшения предсказания следующего слова. Но Арора и Гоял хотели понять LLM с точки зрения навыков, которые могут потребоваться для понимания одного текста. Связь между узлом навыков и текстовым узлом или между несколькими узлами навыков и текстовым узлом означает, что LLM нужны эти навыки для понимания текста в этом узле. Кроме того, несколько фрагментов текста могут основываться на одном и том же навыке или наборе навыков; например, набор узлов навыков, представляющих способность понимать иронию, будет связан с многочисленными текстовыми узлами, в которых встречается ирония.

Теперь задача заключалась в том, чтобы связать эти двудольные графики с реальными LLM и посмотреть, смогут ли эти графики рассказать что-нибудь о возникновении мощных способностей. Но исследователи не могли полагаться на какую-либо информацию об обучении или тестировании реальных LLM — такие компании, как OpenAI или DeepMind, не публикуют данные о своем обучении или тестировании. Кроме того, Арора и Гоял хотели предсказать, как будут вести себя LLM, когда они станут еще больше, но такой информации для будущих чат-ботов нет. Однако была одна важная информация, к которой исследователи могли получить доступ.

С 2021 года исследователи, изучающие производительность LLM и других нейронных сетей, заметили появление универсальной черты. Они заметили, что по мере того, как модель становится больше, будь то по размеру или по объему обучающих данных, ее потери на тестовых данных (разница между предсказанными и правильными ответами на новые тексты после обучения) уменьшаются весьма специфическим образом. Эти наблюдения были систематизированы в уравнения, называемые законами нейронного масштабирования. Поэтому Арора и Гоял разработали свою теорию так, чтобы она зависела не от данных какого-либо отдельного LLM, чат-бота или набора данных обучения и испытаний, а от универсального закона, которому должны подчиняться все эти системы: потери, прогнозируемые законами масштабирования.

Возможно, рассуждали они, повышение производительности, измеряемое законами нейронного масштабирования, связано с улучшением навыков. И эти улучшенные навыки можно было бы определить в их двудольных графах путем соединения узлов навыков с текстовыми узлами. Установление этой связи между законами нейронного масштабирования и двудольными графами стало ключом, который позволил бы им продолжить работу.

Расширение навыков

Исследователи начали с предположения, что существует гипотетический двудольный граф, который соответствует поведению LLM на тестовых данных. Чтобы объяснить изменение потерь LLM на тестовых данных, они придумали способ использовать график для описания того, как LLM приобретает навыки.

Возьмем, к примеру, навык «понимать иронию». Эта идея представлена узлом навыков, поэтому исследователи смотрят, с какими текстовыми узлами соединяется этот узел навыков. Если почти все эти связанные текстовые узлы успешны — это означает, что прогнозы LLM по тексту, представленному этими узлами, очень точны — тогда LLM компетентен в этом конкретном навыке. Но если более определенной доли соединений узла навыков переходят к отказавшим текстовым узлам, то LLM дает сбой в этом навыке.

Эта связь между этими двудольными графами и LLM позволила Ароре и Гоялу использовать инструменты теории случайных графов для анализа поведения LLM по доверенности. Изучение этих графов выявило определенные взаимосвязи между узлами. Эти отношения, в свою очередь, превратились в логический и проверяемый способ объяснить, как крупные модели приобрели навыки, необходимые для достижения своих неожиданных способностей.

Арора и Гоял сначала объяснили одно ключевое поведение: почему более крупные LLM становятся более квалифицированными в индивидуальных навыках, чем их более мелкие коллеги. Они начали с меньших потерь при тестировании, предсказанных законами нейронного масштабирования. На графике эти более низкие потери при тестировании представлены снижением доли неудачных тестовых узлов. Таким образом, в целом меньше неудачных тестовых узлов. А чем меньше узлов неудачного тестирования, тем меньше связей между узлами неудачного тестирования и узлами навыков. Таким образом, большее количество узлов навыков связано с успешными тестовыми узлами, что предполагает растущую компетентность в навыках для модели. «Очень незначительное сокращение потерь приводит к тому, что машина приобретает эти навыки», — сказал Гоял.

Затем пара нашла способ объяснить неожиданные способности более крупной модели. По мере увеличения размера LLM и уменьшения потерь при тестировании случайные комбинации узлов навыков создают связи с отдельными текстовыми узлами. Это говорит о том, что LLM также становится лучше использовать более одного навыка одновременно и начинает генерировать текст, используя несколько навыков — сочетая, скажем, умение использовать иронию с пониманием слова «потому что» — даже если эти точные комбинации навыки не присутствовали ни в одном фрагменте текста данных обучения.

Представьте себе, например, LLM, который уже может использовать один навык для генерации текста. Если вы увеличите количество параметров или обучающих данных LLM на порядок, он станет таким же компетентным в создании текста, требующего двух навыков. Поднимитесь еще на порядок, и LLM теперь сможет выполнять задачи, требующие одновременно четырех навыков, опять же с тем же уровнем компетентности. Более крупные LLM имеют больше способов объединения навыков, что приводит к комбинаторному взрыву способностей.

И по мере масштабирования LLM вероятность того, что он встретит все эти комбинации навыков в данных обучения, становится все более маловероятной. Согласно правилам теории случайных графов, каждая комбинация возникает в результате случайной выборки возможных навыков. Итак, если в графе имеется около 1,000 узлов отдельных навыков и вы хотите объединить четыре навыка, то существует примерно 1,000 в четвертой степени — то есть 1 триллион — возможных способов их объединения.

Арора и Гоял видят в этом доказательство того, что крупнейшие вузы LLM не просто полагаются на комбинации навыков, которые они видели в своих обучающих данных. Бубек соглашается. «Если LLM действительно способен выполнить эти задачи, объединив четыре из этих тысяч навыков, то он, должно быть, занимается обобщением», — сказал он. То есть, скорее всего, это не стохастический попугай.

Настоящее творчество?

Но Арора и Гоял хотели выйти за рамки теории и проверить свое утверждение о том, что студенты LLM лучше сочетают больше навыков и, следовательно, обобщают, по мере увеличения их размера и данных обучения. Вместе с другими коллегами они разработал метод называется «сочетанием навыков» для оценки способности LLM использовать несколько навыков для создания текста.

Чтобы протестировать LLM, команда попросила его сгенерировать три предложения на случайно выбранную тему, которые иллюстрировали бы некоторые случайно выбранные навыки. Например, они попросили GPT-4 (LLM, на котором основана самая мощная версия ChatGPT) написать о дуэлях — в основном о боях на мечах. Более того, они попросили его продемонстрировать навыки в четырех областях: корыстная предвзятость, метафора, статистический силлогизм и общеизвестная физика.. GPT-4 ответил: «Моя победа в этом танце со сталью [метафора] так же очевидна, как падение объекта на землю [физика]. Как известный дуэлянт, я по своей природе проворен, как и большинство других [статистический силлогизм] моей репутации. Поражение? Это возможно только из-за неровного поля битвы, а не из-за моей неадекватности [корыстной предвзятости]». Когда его попросили проверить вывод, GPT-4 сократил его до трех предложений.

Введение

«Это не Хемингуэй и не Шекспир», — сказал Арора, но команда уверена, что это доказывает их точку зрения: модель может генерировать текст, который она не могла видеть в обучающих данных, демонстрируя навыки, которые в сумме соответствуют тому, что некоторые утверждают. понимание. По его словам, GPT-4 даже проходит тесты на сочетание навыков, которые требуют шести навыков примерно в 10–15% случаев, создавая фрагменты текста, существование которых в обучающих данных статистически невозможно.

Команда также автоматизировала процесс, заставив GPT-4 оценивать свои собственные результаты наряду с результатами других LLM. Арора сказал, что модель будет справедливо оценивать сама себя, поскольку у нее нет памяти, поэтому она не помнит, что ее попросили сгенерировать тот самый текст, который ее просят оценить. Ясаман Бахри, исследователь Google DeepMind, работающий над основами искусственного интеллекта, считает автоматизированный подход «очень простым и элегантным».

Что касается теории, это правда, что она делает несколько предположений, сказал Бубек, но «эти предположения ни в коем случае не являются сумасшедшими». Он также был впечатлен экспериментами. «Что [команда] доказывает теоретически, а также подтверждает эмпирически, так это то, что существует композиционное обобщение, то есть [магистры права] способны собирать вместе строительные блоки, которые никогда не собирались вместе», — сказал он. «Для меня это суть творчества».

Арора добавляет, что в работе ничего не говорится о точности того, что пишут дипломированные специалисты. «На самом деле, это аргумент в пользу оригинальности», — сказал он. «Подобных вещей никогда не существовало в мировом учебном корпусе. Этого никто никогда не писал. Должно быть, это галлюцинации».

Тем не менее, Хинтон считает, что эта работа позволит решить вопрос о том, являются ли LLM стохастическими попугаями. «Это самый строгий метод, который я когда-либо видел, показывающий, что GPT-4 — это нечто большее, чем просто стохастический попугай», — сказал он. «Они убедительно демонстрируют, что GPT-4 может генерировать текст, сочетающий навыки и темы способами, которые почти наверняка не встречались в данных обучения». (Мы обратились к Бендеру, чтобы узнать ее мнение о новой работе, но она отказалась от комментариев, сославшись на нехватку времени.)

И действительно, как предсказывает математика, производительность GPT-4 намного превосходит производительность его меньшего предшественника GPT-3.5 — до такой степени, что это напугало Арору. «Наверное, это касается не только меня», — сказал он. «Многим людям показалось немного жутким, насколько GPT-4 лучше GPT-3.5, и это произошло в течение года. Означает ли это, что через год нас ждут аналогичные изменения такого же масштаба? Я не знаю. Только OpenAI знает».

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://www.quantamagazine.org/new-theory-suggests-chatbots-can-understand-text-20240122/

- :имеет

- :является

- :нет

- :куда

- ][п

- $UP

- 000

- 1

- 15%

- 2021

- a

- способности

- способность

- в состоянии

- О нас

- резко

- академический

- приемлемый

- доступ

- По

- Учетные записи

- точность

- точный

- Достигать

- ACM

- приобретение

- фактического соединения

- Добавить

- Добавляет

- После

- снова

- соглашается с тем,

- AI

- алгоритм

- Все

- позволять

- разрешено

- почти

- вдоль

- уже

- причислены

- количество

- an

- анализировать

- и

- Эндрю

- Другой

- ответ

- ответ

- ответы

- любой

- все

- подхода

- примерно

- МЫ

- области

- спорить

- продемонстрировав тем самым

- аргумент

- ARM

- расположены

- искусственный

- AS

- предположения

- At

- Авторы

- Автоматизированный

- доступен

- основной

- в основном

- основа

- Battlefield

- BE

- , так как:

- становиться

- становится

- было

- до

- поведение

- поведения

- не являетесь

- верить

- ниже

- ЛУЧШЕЕ

- Лучшая

- между

- Beyond

- смещение

- пристрастный

- большой

- больший

- Крупнейшая

- миллиарды

- Немного

- Блоки

- боты

- Строительство

- построенный

- но

- by

- вычислять

- исчисляет

- под названием

- пришел

- CAN

- не могу

- способный

- случаев

- определенный

- конечно

- вызов

- изменение

- изменения

- Chatbot

- chatbots

- ChatGPT

- проверка

- Выберите

- выбранный

- утверждать

- Очистить

- кодифицированные

- ПОСЛЕДОВАТЕЛЬНЫЙ

- Монета

- коллеги

- лыжных шлемов

- сочетание

- комбинации

- объединять

- комбинаты

- комбинируя

- как

- выходит

- комментарий

- Компании

- компетентный

- полный

- комплекс

- постигать

- вычислительный

- компьютер

- уверенный

- Свяжитесь

- подключенный

- связи

- Коммутация

- подключает

- Консенсус

- следствие

- содержать

- продолжать

- убежден,

- исправить

- соответствует

- Расходы

- может

- коллегами

- сумасшедший

- креативность

- решающее значение

- танец

- Опасности

- данным

- решенный

- уменьшается

- DeepMind

- определенный

- демонстрировать

- обозначает

- зависеть

- описывать

- предназначенный

- обнаруживать

- Определять

- развивать

- развитый

- диктовали

- DID

- разница

- исчезать

- Дисплей

- отображать

- расстояние

- распределение

- Разное

- делить

- do

- приносит

- не

- дело

- Dont

- вниз

- рисовать

- Капли

- два

- дуэт

- каждый

- Edge

- появляться

- появление

- достаточно

- Весь

- уравнения

- сущность

- налаживание

- оценивать

- Даже

- НИКОГДА

- Каждая

- точно,

- пример

- превышает

- существовать

- существует

- ожидаемый

- Эксперименты

- эксперты

- Объяснять

- объяснены

- взрыв

- степень

- факт

- Oшибка

- не удается

- ярмарка

- Осень

- далеко

- несколько

- меньше

- бои

- находит

- Во-первых,

- кувырок

- Фокус

- Что касается

- форма

- формы

- предстоящий

- найденный

- Устои

- 4

- Четвертый

- доля

- Рамки

- от

- получила

- Доходы

- порождать

- порождающий

- получить

- получающий

- Дайте

- данный

- дает

- Отдаете

- Go

- будет

- график

- Графики

- большой

- земля

- Рост

- произошло

- происходит

- Есть

- he

- главы

- ее

- очень

- его

- подсказки

- его

- Как

- Однако

- HTTPS

- человекоподобный

- i

- идея

- if

- представить

- что она

- впечатленный

- улучшать

- улучшенный

- in

- включает в себя

- Увеличение

- Увеличивает

- все больше и больше

- действительно

- individual

- информация

- по существу

- понимание

- пример

- Интеллекта

- в

- Ирония

- изолированный

- IT

- ЕГО

- саму трезвость

- всего

- Основные

- Знать

- известный

- знает

- Отсутствие

- язык

- большой

- больше

- крупнейших

- Фамилия

- закон

- Законодательство

- Lays

- Лиды

- Оставлять

- уровень

- уровни

- такое как

- Вероятно

- линия

- линий

- LINK

- мало

- LLM

- логический

- Длинное

- много времени

- посмотреть

- от

- серия

- ниже

- машина

- сделанный

- журнал

- сделать

- ДЕЛАЕТ

- способ

- многих

- массивный

- математике

- математический

- математически

- Май..

- может быть

- me

- значить

- смысл

- означает

- Встречайте

- Память

- меров

- метод

- Microsoft

- может быть

- против

- умов

- модель

- Модели

- Модерн

- БОЛЕЕ

- Более того

- самых

- много

- с разными

- должен

- my

- необходимо

- необходимый

- потребности

- сеть

- сетей

- нервный

- нейронной сети

- нейронные сети

- Нейроны

- никогда

- Новые

- следующий

- нет

- узел

- узлы

- ничего

- понятие

- сейчас

- номер

- номера

- многочисленный

- объекты

- затемняется

- Очевидный

- of

- on

- консолидировать

- ONE

- те,

- только

- OpenAI

- Обзор

- or

- заказ

- оригинал

- оригинальность

- Другое

- Другое

- в противном случае

- внешний

- выходной

- за

- общий

- собственный

- страниц

- пара

- параметры

- часть

- особый

- Прохождение

- Люди

- Выполнять

- производительность

- возможно

- перспектива

- Физика

- Выборы

- кусок

- штук

- пионер

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- Точка

- пунктов

- возможность

- возможное

- возможно

- мощностью

- мощный

- полномочия

- предшественник

- предсказывать

- предсказанный

- прогнозирования

- прогноз

- Predictions

- предсказывает

- присутствие

- представить

- представлены

- Princeton

- вероятно

- проблемам

- продолжить

- процесс

- производства

- доказательство

- доказуемый

- доказывает

- приводит

- полномочие

- что такое варган?

- положил

- Полагая

- Квантовый журнал

- вопрос

- Вопросы

- случайный

- достиг

- реализованный

- на самом деле

- Цена снижена

- снижение

- ссылка

- Связанный

- Отношения

- соответствующие

- полагаться

- оставаться

- помнить

- Знаменитый

- Ответить

- представлять

- представленный

- представляющий

- представляет

- репутация

- требовать

- обязательный

- требуется

- исследованиям

- исследователь

- исследователи

- ОТДЫХ

- показывать

- Показали

- тщательный

- Рост

- условиями,

- Сказал

- то же

- видел

- сообщили

- поговорка

- Шкала

- масштабирование

- Ученый

- посмотреть

- по-видимому

- кажется

- видел

- смысл

- предложение

- набор

- она

- должен

- показывать

- аналогичный

- Аналогичным образом

- просто

- одинарной

- ШЕСТЬ

- Размер

- умение

- квалифицированный

- навыки

- меньше

- So

- Решение

- некоторые

- удалось

- Space

- конкретный

- и политические лидеры

- статистический

- По-прежнему

- прямой

- сильный

- изучение

- успешный

- такие

- внезапный

- Предлагает

- сюрприз

- меч

- системы

- таланты

- задачи

- команда

- объединился

- тестXNUMX

- проверенный

- Тестирование

- тестов

- текст

- чем

- который

- Ассоциация

- График

- их

- Их

- тогда

- теоретический

- теория

- Там.

- следовательно

- Эти

- они

- вещи

- Думает

- этой

- те

- хоть?

- тысяча

- три

- порог

- Таким образом

- время

- в

- Сегодняшних

- вместе

- слишком

- инструменты

- тема

- Темы

- Торонто

- специалистов

- Обучение

- переходы

- Триллион

- правда

- пытается

- ОЧЕРЕДЬ

- Оказалось

- щипать

- два

- напишите

- Типы

- лежащий в основе

- понимать

- понимание

- Неожиданный

- Universal

- Университет

- вряд ли

- до

- использование

- используемый

- использования

- через

- ценностное

- различный

- версия

- очень

- победа

- хотеть

- стремятся

- законопроект

- Вашингтон

- Путь..

- способы

- we

- WebP

- были

- Что

- когда

- будь то

- который

- КТО

- зачем

- будете

- в

- интересно

- Word

- слова

- Работа

- работает

- мире

- бы

- записывать

- письменный

- писал

- год

- еще

- Ты

- зефирнет