Не говоря уже об использовании больших языковых моделей (LLM) для написания кода, генеральный директор Nvidia Дженсен Хуанг считает, что в будущем корпоративное программное обеспечение будет просто набором чат-ботов, объединенных для выполнения этой задачи.

«Маловероятно, что вы напишете это с нуля или напишете целую кучу кода на Python или что-то в этом роде», — сказал он на сцене во время GTC. лейтмотив Понедельник. «Весьма вероятно, что вы соберете команду ИИ».

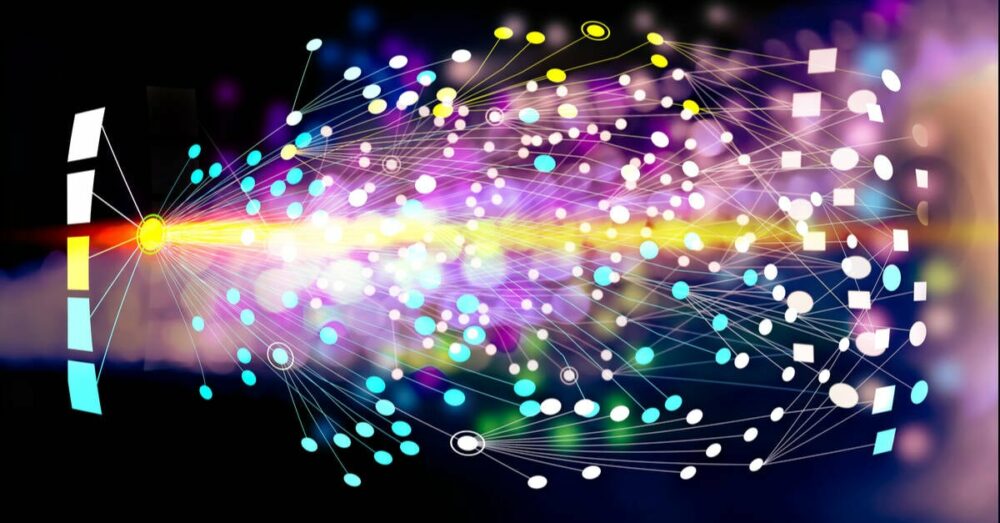

Эта команда ИИ, объясняет Дженсен, может включать в себя модель, предназначенную для разбиения и делегирования запросов различным другим моделям. Некоторые из этих моделей могут быть обучены для понимания бизнес-сервисов, таких как SAP или Service Now, тогда как другие могут выполнять численный анализ данных, хранящихся в векторной базе данных. Затем эти данные можно объединить и представить конечному пользователю с помощью еще одной модели.

«Мы можем получать отчет каждый божий день или, знаете, в начале часа, который имеет какое-то отношение к плану сборки, или к какому-то прогнозу, или к какому-то оповещению клиента, или к какой-то базе данных об ошибках, или к чему-то еще», — объяснил он.

Чтобы связать все эти модели воедино, Nvidia взяла страницу из книги Docker и создала среду выполнения контейнера для ИИ.

Названные микросервисами Nvidia Inference, или сокращенно NIM, это, по сути, образы контейнеров, содержащие как модель, будь то с открытым исходным кодом, так и проприетарную, а также все зависимости, необходимые для ее запуска. Эти контейнерные модели затем можно развернуть в любом количестве сред выполнения, включая узлы Kubernetes с ускорением Nvidia.

«Вы можете развернуть его в нашей инфраструктуре под названием DGX Cloud, или вы можете развернуть его локально, или вы можете развернуть его где угодно. Как только вы его разработаете, его можно будет брать с собой куда угодно», — сказал Дженсен.

Конечно, сначала вам понадобится подписка на пакет Nvidia AI Enterprise, который стоит не так уж и дешево: 4,500 долларов в год за графический процессор или 1 доллар в час за графический процессор в облаке. Эта ценовая стратегия, похоже, в целом стимулирует более плотные и высокопроизводительные системы, поскольку она стоит одинаково независимо от того, используете ли вы L40 или LXNUMX. B100s.

Если идея контейнеризации рабочих нагрузок с ускорением графического процессора кажется вам знакомой, для Nvidia это не совсем новая идея. Ускорение CUDA было поддержал на самых разных средах выполнения контейнеров, включая Docker, Podman, Containerd или CRI-O в течение многих лет, и не похоже, что Nvidia Container Runtime куда-то денется.

Ценность NIM, по-видимому, заключается в том, что Nvidia возьмет на себя упаковку и оптимизацию этих моделей, чтобы у них была правильная версия CUDA, Triton Inference Server или TensorRT LLM, необходимая для получения от них максимальной производительности.

Аргумент заключается в том, что если Nvidia выпустит обновление, которое значительно повысит производительность вывода определенных типов моделей, для использования этой функциональности потребуется просто удалить последний образ NIM.

Помимо оптимизации моделей для конкретного оборудования, Nvidia также работает над обеспечением согласованной связи между контейнерами, чтобы они могли общаться друг с другом через вызовы API.

Насколько мы понимаем, вызовы API, используемые различными моделями ИИ, представленными сегодня на рынке, не всегда согласованы, в результате чего некоторые модели легче объединить, а другие могут потребовать дополнительной работы.

Использование институциональных знаний в моделях общего назначения

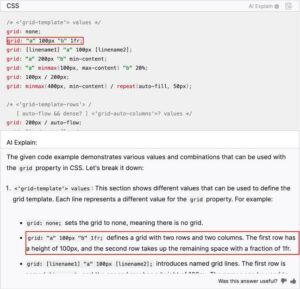

Любой, кто использовал чат-бота с искусственным интеллектом, знает, что, хотя он обычно довольно хорошо справляется с вопросами общего характера, он не всегда самый надежный с непонятными или техническими запросами.

Дженсен подчеркнул этот факт во время своего выступления. Отвечая на вопрос о внутренней программе, используемой в Nvidia, модель большого языка Meta Llama 2 70B, что неудивительно, дала определение несвязанному термину.

Вместо того, чтобы заставить предприятия обучать свои собственные модели (что позволило бы продать много графических процессоров, но значительно ограничило бы доступный рынок), Nvidia разработала инструменты для точной настройки своих NIM с данными и процессами клиентов.

«У нас есть сервис под названием NeMo Microservices, который помогает вам управлять данными, подготавливать их, чтобы вы могли… внедрить этот ИИ. Вы точно настраиваете его, а затем оградите его; затем вы сможете оценить… его эффективность на фоне других примеров», — объяснил Хуан.

Он также рассказал о сервисе NeMo Retriever от Nvidia, который основан на концепции использования дополненной генерации поиска (RAG) для обнаружения информации, которой модель не была специально обучена.

Идея здесь заключается в том, что документы, процессы и другие данные можно загрузить в векторную базу данных, подключенную к модели. На основе запроса модель может затем выполнить поиск в этой базе данных, получить и обобщить соответствующую информацию.

Модели NIM и NeMo Retriever для интеграции RAG уже доступны, а NeMo Microservices находится в раннем доступе. ®

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://go.theregister.com/feed/www.theregister.com/2024/03/19/nvidia_why_write_code_when/

- :имеет

- :является

- $UP

- 7

- a

- О нас

- ускоренный

- ускорение

- доступ

- через

- дополнение

- дополнительный

- адресуемый

- плюс

- против

- AI

- AI chatbot

- AI модели

- Оповещение

- Все

- вдоль

- причислены

- всегда

- an

- анализ

- и

- Другой

- любой

- все

- откуда угодно

- API

- появляется

- МЫ

- аргумент

- около

- AS

- At

- дополненная

- доступен

- основанный

- BE

- было

- за

- не являетесь

- считает,

- ЛУЧШЕЕ

- между

- книга

- форсирует

- изоферменты печени

- боты

- Ломать

- ошибки

- строить

- Группа

- бизнес

- но

- by

- под названием

- Объявления

- CAN

- Может получить

- Генеральный директор

- определенный

- цепь

- чат

- Chatbot

- дешево

- облако

- CO

- код

- лыжных шлемов

- сочетании

- Связь

- полный

- сама концепция

- подключенный

- последовательный

- Container

- Контейнеры

- Расходы

- "Курс"

- создали

- вылеченный

- клиент

- данные клиентов

- данным

- База данных

- день

- определение

- Зависимости

- развертывание

- развернуть

- предназначенный

- развивать

- развитый

- do

- Docker

- Документация

- Безразлично

- вниз

- драматично

- в течение

- каждый

- Рано

- легче

- позволяет

- конец

- Предприятие

- корпоративное программное обеспечение

- предприятий

- по существу

- Каждая

- точно,

- Примеры

- объяснены

- Объясняет

- факт

- знакомый

- конец

- First

- Что касается

- Прогноз

- от

- функциональность

- будущее

- Общие

- поколение

- получить

- будет

- хорошо

- GPU / ГРАФИЧЕСКИЙ ПРОЦЕССОР

- Графические процессоры

- обрабатывать

- происходит

- Аппаратные средства

- Есть

- he

- помощь

- помогает

- здесь

- высший

- Выделенные

- его

- час

- HTTPS

- Хуан

- идея

- if

- изображение

- изображений

- in

- стимулировать

- включают

- В том числе

- информация

- Инфраструктура

- Институциональная

- Интегрируя

- в нашей внутренней среде,

- в

- мобильной

- IT

- ЕГО

- Дженсен Хуанг

- JPG

- всего

- Ключевые заметки

- Знать

- знания

- язык

- большой

- последний

- такое как

- Вероятно

- ОГРАНИЧЕНИЯ

- ll

- Лама

- LLM

- посмотреть

- выглядит как

- серия

- рынок

- Май..

- Мета

- microservices

- может быть

- модель

- Модели

- понедельник

- самых

- необходимо

- Необходимость

- Новые

- узлы

- сейчас

- номер

- Nvidia

- of

- on

- Onboard

- консолидировать

- открытый

- с открытым исходным кодом

- оптимизация

- оптимизации

- or

- Другое

- Другое

- наши

- внешний

- собственный

- коробок

- страница

- для

- Выполнять

- производительность

- план

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- прем

- Подготовить

- представлены

- довольно

- цены

- Процессы

- FitPartner™

- предложение.

- ( изучите наши патенты),

- при условии

- тянущий

- цель

- Питон

- запрос

- Вопросы

- тряпка

- RE

- Несмотря на

- публикации

- соответствующие

- складская

- отчету

- запросить

- Запросы

- требовать

- в результате

- поиск

- правую

- Бег

- время выполнения

- s

- Сказал

- то же

- живица

- поцарапать

- Поиск

- казаться

- продаем

- сервер

- обслуживание

- Услуги

- Короткое

- одинарной

- So

- Software

- некоторые

- удалось

- звуки

- Источник

- конкретный

- конкретно

- Этап

- хранить

- Стратегия

- строка

- подписка

- suite

- суммировать

- Поверхность

- системы

- взять

- с

- Сложность задачи

- команда

- Технический

- срок

- который

- Ассоциация

- Будущее

- их

- Их

- тогда

- Эти

- они

- этой

- в

- сегодня

- вместе

- инструменты

- топ

- Train

- специалистов

- Тритон

- пытается

- мелодия

- Типы

- понимать

- вряд ли

- Обновление ПО

- используемый

- Информация о пользователе

- через

- обычно

- ценностное

- разнообразие

- различный

- версия

- очень

- с помощью

- we

- любой

- будь то

- который

- в то время как

- КТО

- все

- широкий

- будете

- в

- Работа

- работает

- бы

- записывать

- написать код

- лет

- еще

- Ты

- ваш

- YouTube

- зефирнет