Модели большого языка (LLM) произвели революцию в области обработки естественного языка (NLP), улучшив такие задачи, как языковой перевод, обобщение текста и анализ настроений. Однако по мере того, как эти модели продолжают расти в размерах и сложности, мониторинг их производительности и поведения становится все более сложной задачей.

Мониторинг эффективности и поведения LLM является важной задачей для обеспечения их безопасности и эффективности. Предлагаемая нами архитектура обеспечивает масштабируемое и настраиваемое решение для онлайн-мониторинга LLM, позволяя командам адаптировать ваше решение для мониторинга к вашим конкретным случаям использования и требованиям. Используя сервисы AWS, наша архитектура обеспечивает видимость поведения LLM в режиме реального времени и позволяет командам быстро выявлять и устранять любые проблемы или аномалии.

В этом посте мы демонстрируем несколько показателей для онлайн-мониторинга LLM и их соответствующую архитектуру для масштабирования с использованием таких сервисов AWS, как Amazon CloudWatch и AWS Lambda. Это предлагает настраиваемое решение, превосходящее возможности оценка модели рабочие места с Коренная порода Амазонки.

Обзор решения

Первое, что следует учитывать, это то, что разные метрики требуют разных расчетов. Необходима модульная архитектура, в которой каждый модуль может получать данные вывода модели и создавать свои собственные показатели.

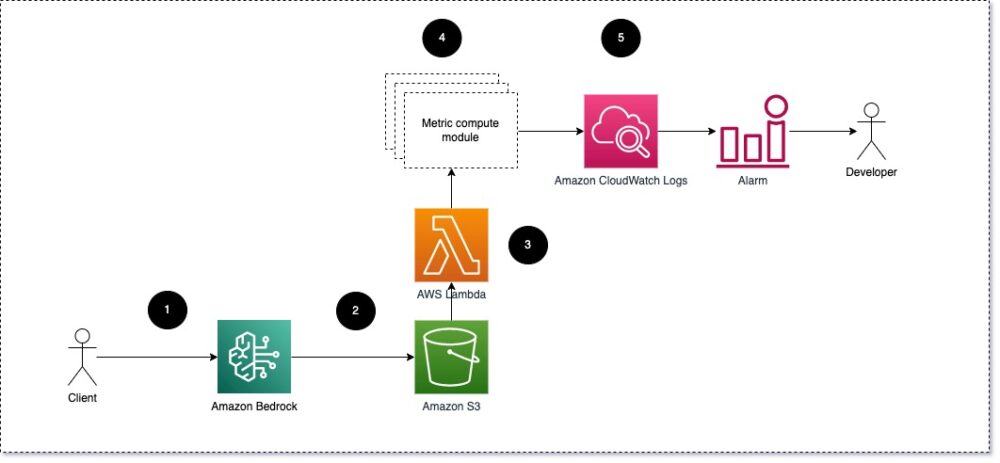

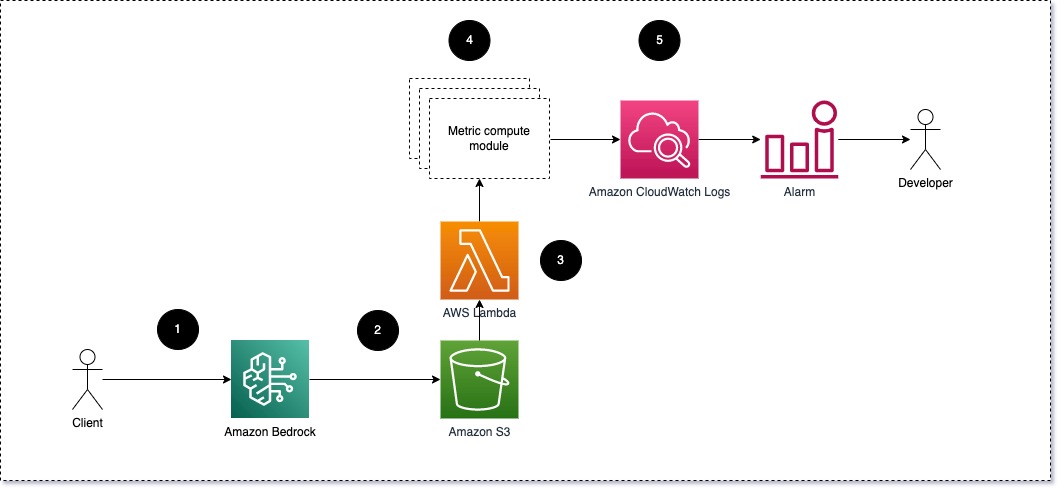

Мы предлагаем, чтобы каждый модуль передавал входящие запросы вывода в LLM, передавая пары приглашения и завершения (ответа) модулям вычисления показателей. Каждый модуль отвечает за вычисление собственных показателей в отношении ввода запроса и завершения (ответа). Эти метрики передаются в CloudWatch, который может агрегировать их и работать с сигналами CloudWatch для отправки уведомлений при определенных условиях. Следующая диаграмма иллюстрирует эту архитектуру.

Рис. 1. Модуль вычисления метрик – обзор решения

Рабочий процесс включает в себя следующие шаги:

- Пользователь отправляет запрос в Amazon Bedrock как часть приложения или пользовательского интерфейса.

- Amazon Bedrock сохраняет запрос и завершение (ответ) в Простой сервис хранения Amazon (Amazon S3) согласно конфигурации регистрация вызовов.

- Файл, сохраненный на Amazon S3, создает событие, которое триггеры лямбда-функция. Функция вызывает модули.

- Модули публикуют свои соответствующие показатели в Показатели CloudWatch.

- Сигнализация может уведомить команду разработчиков о неожиданных значениях метрик.

Второе, что следует учитывать при внедрении мониторинга LLM, — это выбор правильных показателей для отслеживания. Хотя существует множество потенциальных показателей, которые вы можете использовать для мониторинга эффективности LLM, в этом посте мы объясним некоторые из самых общих.

В следующих разделах мы выделим некоторые соответствующие метрики модулей и соответствующую им архитектуру модуля вычисления метрик.

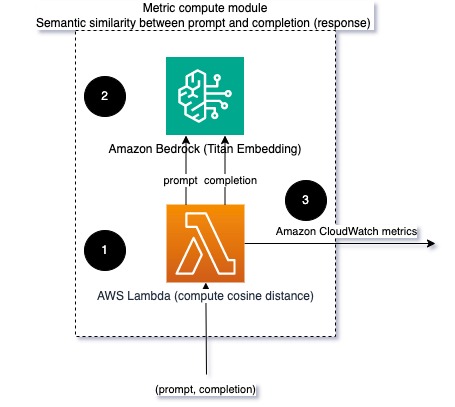

Семантическое сходство между подсказкой и завершением (ответом)

При запуске LLM вы можете перехватывать приглашение и завершение (ответ) для каждого запроса и преобразовывать их во внедрения с помощью модели внедрения. Вложения — это многомерные векторы, которые представляют семантическое значение текста. Амазонка Титан предоставляет такие модели через Titan Embeddings. Установив расстояние, например косинус, между этими двумя векторами, вы можете количественно оценить, насколько семантически схожи подсказка и завершение (ответ). Вы можете использовать SciPy or scikit учиться для вычисления косинусного расстояния между векторами. На следующей диаграмме показана архитектура этого модуля вычисления метрик.

Рис. 2. Модуль вычисления метрик – семантическое сходство

Этот рабочий процесс включает в себя следующие ключевые этапы:

- Функция Lambda получает потоковое сообщение через Амазонка Кинезис содержащий пару подсказки и завершения (ответа).

- Функция получает встраивание как для приглашения, так и для завершения (ответа) и вычисляет косинусное расстояние между двумя векторами.

- Функция отправляет эту информацию в метрики CloudWatch.

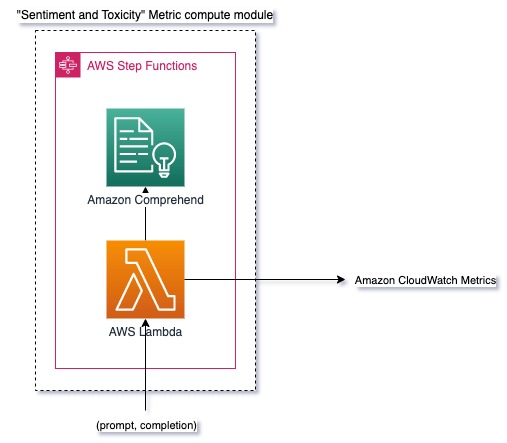

Чувства и токсичность

Мониторинг настроений позволяет вам оценить общий тон и эмоциональное воздействие ответов, тогда как анализ токсичности обеспечивает важную меру присутствия оскорбительных, неуважительных или вредных выражений в результатах LLM. Любые изменения в настроениях или токсичности следует внимательно отслеживать, чтобы убедиться, что модель ведет себя так, как ожидалось. На следующей диаграмме показан модуль вычисления метрик.

Рис. 3. Модуль вычисления показателей – настроения и токсичность

Рабочий процесс включает в себя следующие шаги:

- Функция Lambda получает пару приглашения и завершения (ответа) через Amazon Kinesis.

- Благодаря оркестрации AWS Step Functions функция вызывает Amazon Comprehend обнаружить настроение и токсичность.

- Функция сохраняет информацию в метриках CloudWatch.

Дополнительную информацию об обнаружении настроений и токсичности с помощью Amazon Comprehend см. Создайте надежный предиктор токсичности на основе текста и Помечайте вредоносный контент с помощью обнаружения токсичности Amazon Comprehend.

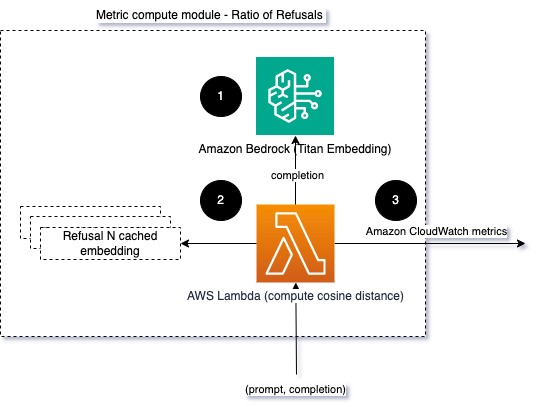

Коэффициент отказов

Увеличение количества отказов, например, когда LLM отказывает в завершении из-за отсутствия информации, может означать, что либо злонамеренные пользователи пытаются использовать LLM способами, предназначенными для его взлома, либо что ожидания пользователей не оправдываются, и они получают малоценные ответы. Один из способов оценить, насколько часто это происходит, — сравнить стандартные отказы от используемой модели LLM с фактическими ответами от LLM. Например, ниже приведены некоторые распространенные фразы отказа в программе Claude v2 LLM от Anthropic:

“Unfortunately, I do not have enough context to provide a substantive response. However, I am an AI assistant created by Anthropic to be helpful, harmless, and honest.”

“I apologize, but I cannot recommend ways to…”

“I'm an AI assistant created by Anthropic to be helpful, harmless, and honest.”

При фиксированном наборе подсказок увеличение числа таких отказов может быть сигналом того, что модель стала чрезмерно осторожной или чувствительной. Обратный случай также следует оценить. Это может быть сигналом о том, что модель теперь более склонна к токсичным или вредным разговорам.

Чтобы помочь смоделировать целостность и коэффициент отказов, мы можем сравнить ответ с набором известных фраз отказа из LLM. Это может быть настоящий классификатор, который может объяснить, почему модель отклонила запрос. Вы можете взять косинусное расстояние между ответом и известными ответами об отказе из отслеживаемой модели. На следующей диаграмме показан этот модуль вычисления метрик.

Рис. 4. Модуль вычисления метрик – соотношение отказов

Рабочий процесс состоит из следующих шагов:

- Лямбда-функция получает приглашение и завершение (ответ) и встраивает ответ с помощью Amazon Titan.

- Функция вычисляет косинусное или евклидово расстояние между ответом и существующими запросами об отказе, кэшированными в памяти.

- Функция отправляет это среднее значение в метрики CloudWatch.

Другим вариантом является использование нечеткое соответствие для простого, но менее мощного подхода для сравнения известных отказов с результатами LLM. Обратитесь к Документация Python для примера.

Обзор

Наблюдение за LLM является важной практикой для обеспечения надежного и заслуживающего доверия использования LLM. Мониторинг, понимание и обеспечение точности и надежности LLM могут помочь вам снизить риски, связанные с этими моделями ИИ. Отслеживая галлюцинации, неверные ответы (ответы) и подсказки, вы можете быть уверены, что ваш LLM идет по правильному пути и приносит ту пользу, которую ищете вы и ваши пользователи. В этом посте мы обсудили несколько показателей для демонстрации примеров.

Дополнительную информацию об оценке моделей фундамента см. Используйте SageMaker Clarify для оценки моделей фундаментаи просмотрите дополнительные примеры блокнотов доступен в нашем репозитории GitHub. Вы также можете изучить способы масштабного внедрения оценок LLM в Внедрение оценки LLM в любом масштабе с помощью сервисов Amazon SageMaker Clarify и MLOps.. В заключение мы рекомендуем обратиться к Оценивать большие языковые модели на качество и ответственность чтобы узнать больше об оценке LLM.

Об авторах

Бруно Кляйн — старший инженер по машинному обучению в аналитической практике AWS Professional Services. Он помогает клиентам внедрять решения для больших данных и аналитики. Вне работы он любит проводить время с семьей, путешествовать и пробовать новую еду.

Бруно Кляйн — старший инженер по машинному обучению в аналитической практике AWS Professional Services. Он помогает клиентам внедрять решения для больших данных и аналитики. Вне работы он любит проводить время с семьей, путешествовать и пробовать новую еду.

Рушаб Локханде — старший инженер по данным и машинному обучению в аналитической практике AWS Professional Services. Он помогает клиентам внедрять решения для больших данных, машинного обучения и аналитики. Вне работы он любит проводить время с семьей, читать, бегать и играть в гольф.

Рушаб Локханде — старший инженер по данным и машинному обучению в аналитической практике AWS Professional Services. Он помогает клиентам внедрять решения для больших данных, машинного обучения и аналитики. Вне работы он любит проводить время с семьей, читать, бегать и играть в гольф.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- PlatoData.Network Вертикальный генеративный ИИ. Расширьте возможности себя. Доступ здесь.

- ПлатонАйСтрим. Интеллект Web3. Расширение знаний. Доступ здесь.

- ПлатонЭСГ. Углерод, чистые технологии, Энергия, Окружающая среда, Солнечная, Управление отходами. Доступ здесь.

- ПлатонЗдоровье. Биотехнологии и клинические исследования. Доступ здесь.

- Источник: https://aws.amazon.com/blogs/machine-learning/techniques-and-approaches-for-monitoring-large-language-models-on-aws/

- :имеет

- :является

- :нет

- :куда

- 1

- 100

- 143

- 32

- 455

- 7

- a

- О нас

- точность

- фактического соединения

- дополнительный

- адрес

- совокупный

- AI

- Помощник АИ

- AI модели

- позволяет

- причислены

- Несмотря на то, что

- am

- Amazon

- Amazon Comprehend

- Амазонка Кинезис

- Создатель мудреца Амазонки

- Amazon Web Services

- an

- анализ

- аналитика

- и

- аномалии

- Антропный

- любой

- Применение

- подхода

- подходы

- архитектура

- МЫ

- AS

- помощник

- связанный

- At

- доступен

- в среднем

- AWS

- Профессиональные услуги AWS

- Шаговые функции AWS

- Плохой

- BE

- становиться

- поведение

- не являетесь

- между

- Beyond

- большой

- Big Data

- изоферменты печени

- но

- by

- Объявления

- CAN

- не могу

- случаев

- случаев

- осторожный

- сложные

- Выбирая

- классификатор

- тесно

- Общий

- сравнить

- сравнив

- завершение

- сложность

- постигать

- вычисление

- Вычисление

- вычисление

- Условия

- Конфигурация

- Рассматривать

- соображения

- состоит

- содержание

- контекст

- продолжать

- Беседы

- может

- создали

- создает

- критической

- Клиенты

- настраиваемый

- данным

- обеспечивает

- демонстрировать

- обнаруживать

- Развитие

- Команда разработчиков

- диаграмма

- различный

- обсуждается

- расстояние

- do

- два

- каждый

- эффективность

- или

- вложения

- позволяет

- позволяет

- заниматься

- инженер

- достаточно

- обеспечивать

- обеспечение

- оценивать

- оценивается

- оценки

- оценка

- оценки

- События

- пример

- Примеры

- существующий

- ожидания

- ожидаемый

- Объяснять

- Больше

- семья

- несколько

- поле

- инжир

- Файл

- в заключение

- Во-первых,

- фиксированной

- после

- питание

- Что касается

- Год основания

- от

- функция

- Функции

- калибр

- получает

- получающий

- GitHub

- гольф

- Расти

- Случай

- вредный

- Есть

- he

- помощь

- полезный

- помогает

- Выделите

- честный

- Как

- Однако

- HTML

- HTTP

- HTTPS

- i

- определения

- иллюстрирует

- Влияние

- осуществлять

- Осуществляющий

- важную

- улучшение

- in

- включает в себя

- Входящий

- Увеличение

- все больше и больше

- информация

- вход

- целостность

- предназначенных

- Интерфейс

- в

- обратный

- Запускает

- вопросы

- IT

- ЕГО

- побег из тюрьмы

- Джобс

- JPG

- Основные

- известный

- Отсутствие

- язык

- большой

- УЧИТЬСЯ

- изучение

- Меньше

- LLM

- искать

- машина

- обучение с помощью машины

- сделать

- ДЕЛАЕТ

- злонамеренный

- многих

- значить

- смысл

- проводить измерение

- Память

- сообщение

- встретивший

- метрический

- Метрика

- смягчать

- ML

- млн операций в секунду

- модель

- Модели

- модульный

- Модули

- Модули

- монитор

- контролируемый

- Мониторинг

- БОЛЕЕ

- натуральный

- Обработка естественного языка

- необходимо

- Новые

- НЛП

- Уведомления

- сейчас

- of

- наступление

- Предложения

- .

- on

- ONE

- те,

- онлайн

- Опция

- or

- оркестровка

- наши

- выходной

- выходы

- внешнюю

- общий

- обзор

- собственный

- пара

- пар

- часть

- Прошло

- Прохождение

- для

- производительность

- фразы

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- игры

- возможное

- После

- потенциал

- мощный

- практика

- присутствие

- обработка

- производит

- профессиональный

- наводящие

- предложило

- обеспечивать

- приводит

- Питон

- быстро

- соотношение

- Reading

- реального времени

- получает

- рекомендовать

- относиться

- отказ

- отказалась

- соответствующие

- надежность

- складская

- хранилище

- представлять

- запросить

- Запросы

- требовать

- Требования

- уважение

- те

- ответ

- ответы

- ответственный

- революция

- правую

- рисках,

- надежный

- Бег

- Сохранность

- sagemaker

- сохраняются

- масштабируемые

- Шкала

- Во-вторых

- разделах

- семантический

- Отправить

- посылает

- старший

- чувствительный

- настроение

- Услуги

- набор

- Смены

- должен

- демонстрации

- сигнал

- аналогичный

- просто

- Размер

- Решение

- Решения

- некоторые

- пространственный

- конкретный

- Расходы

- стандарт

- Шаг

- Шаги

- диск

- простой

- потоковый

- такие

- предлагать

- Убедитесь

- портной

- взять

- с

- Сложность задачи

- задачи

- команда

- команды

- снижения вреда

- текст

- который

- Ассоциация

- информация

- их

- Их

- Там.

- Эти

- они

- задача

- этой

- Через

- время

- исполин

- в

- TONE

- трек

- Transform

- Переводы

- Путешествие

- заслуживающий доверия

- пытается

- два

- понимание

- Неожиданный

- использование

- используемый

- Информация о пользователе

- Пользовательский интерфейс

- пользователей

- через

- ценностное

- Наши ценности

- с помощью

- видимость

- Путь..

- способы

- we

- Web

- веб-сервисы

- Что

- Что такое

- когда

- в то время как

- который

- зачем

- Википедия.

- Работа

- рабочий

- Ты

- ВАШЕ

- зефирнет