Введение

В машинном обучении компромисс между смещением и дисперсией является фундаментальной концепцией, влияющей на производительность любой прогностической модели. Это относится к тонкому балансу между ошибкой смещения и ошибкой дисперсии модели, поскольку невозможно одновременно минимизировать обе. Достижение правильного баланса имеет решающее значение для достижения оптимальной производительности модели.

В этой короткой статье мы дадим определение предвзятости и дисперсии, объясним, как они влияют на модель машинного обучения, и дадим несколько практических советов о том, как с ними бороться на практике.

Понимание предвзятости и дисперсии

Прежде чем углубиться в взаимосвязь между предвзятостью и дисперсией, давайте определим, что представляют собой эти термины в машинном обучении.

Ошибка смещения относится к разнице между предсказанием модели и правильными значениями, которые она пытается предсказать (наземная правда). Другими словами, предвзятость — это ошибка, которую модель совершает из-за неправильных предположений об основном распределении данных. Модели с высоким смещением часто слишком упрощены, не в состоянии отразить сложность данных, что приводит к недообучению.

С другой стороны, ошибка дисперсии относится к чувствительности модели к небольшим колебаниям обучающих данных. Модели с высокой дисперсией слишком сложны и, как правило, соответствуют шуму в данных, а не лежащему в основе шаблону, что приводит к переоснащению. Это приводит к снижению производительности при работе с новыми, невидимыми данными.

Высокое смещение может привести к недообучению, когда модель слишком проста для отражения сложности данных. Он делает сильные предположения о данных и не может уловить истинную взаимосвязь между входными и выходными переменными. С другой стороны, высокая дисперсия может привести к переоснащению, когда модель слишком сложна и изучает шум в данных, а не основную связь между входными и выходными переменными. Таким образом, модели с переоснащением, как правило, слишком близко подходят к обучающим данным и не будут хорошо обобщаться на новые данные, в то время как модели с недообучением даже не могут точно соответствовать обучающим данным.

Как упоминалось ранее, смещение и дисперсия связаны между собой, и хорошая модель балансирует между ошибкой смещения и ошибкой дисперсии. Компромисс смещения и дисперсии — это процесс нахождения оптимального баланса между этими двумя источниками ошибок. Модель с низким смещением и низкой дисперсией, скорее всего, будет хорошо работать как с обучением, так и с новыми данными, сводя к минимуму общую ошибку.

Компромисс смещения и дисперсии

Достижение баланса между сложностью модели и ее способностью обобщать неизвестные данные является основой компромисса смещения и дисперсии. Как правило, более сложная модель будет иметь более низкое смещение, но более высокую дисперсию, в то время как более простая модель будет иметь более высокое смещение, но более низкую дисперсию.

Поскольку невозможно одновременно свести к минимуму предвзятость и дисперсию, поиск оптимального баланса между ними имеет решающее значение для построения надежной модели машинного обучения. Например, увеличивая сложность модели, мы также увеличиваем дисперсию. Это связано с тем, что более сложная модель с большей вероятностью будет соответствовать шуму в обучающих данных, что приведет к переоснащению.

С другой стороны, если мы оставим модель слишком простой, мы увеличим смещение. Это связано с тем, что более простая модель не сможет отразить основные отношения в данных, что приведет к недообучению.

Цель состоит в том, чтобы обучить модель, которая достаточно сложна, чтобы фиксировать основные отношения в обучающих данных, но не настолько сложна, чтобы соответствовать шуму в обучающих данных.

Компромисс смещения и дисперсии на практике

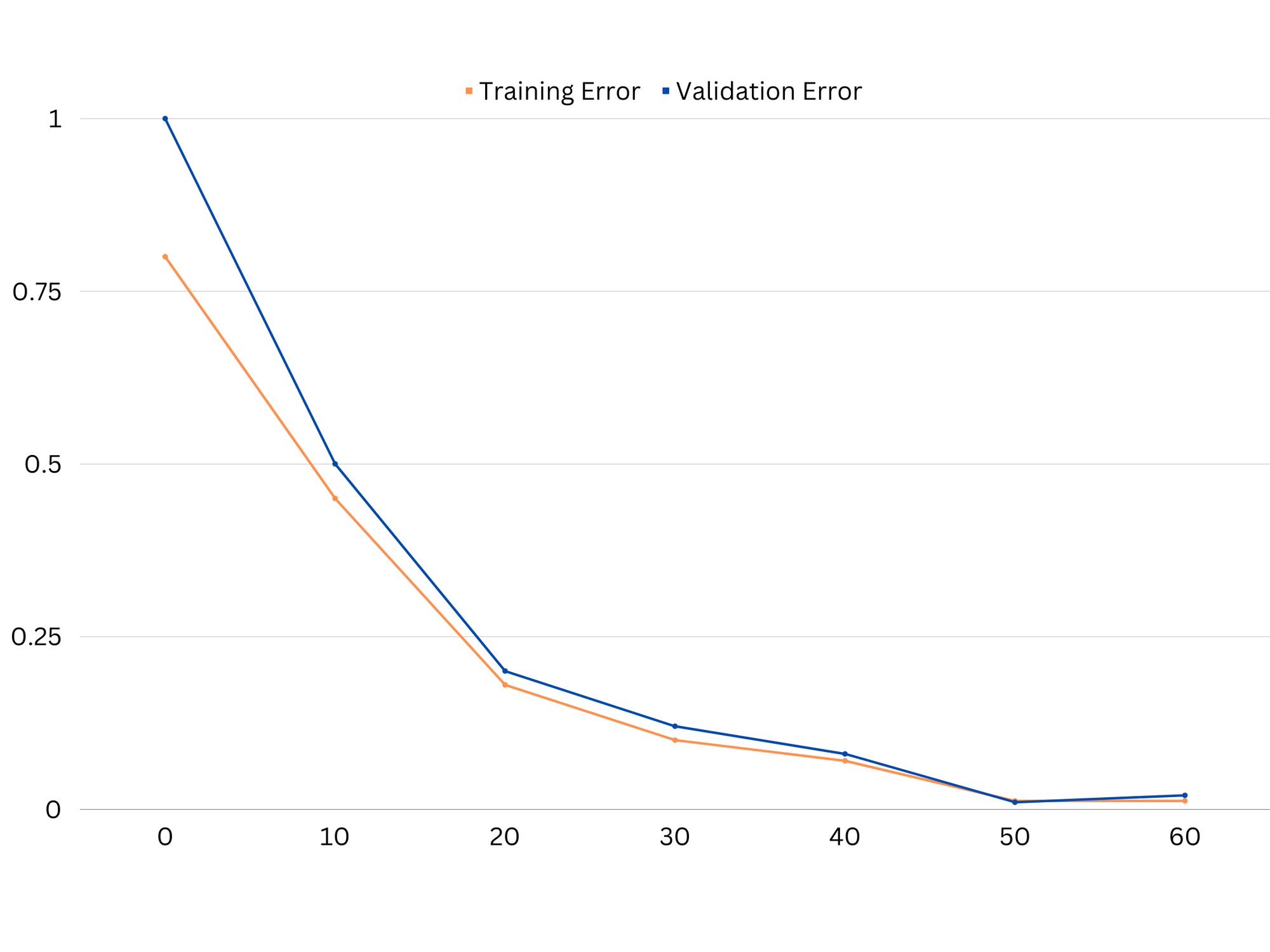

Чтобы диагностировать производительность модели, мы обычно вычисляем и сравниваем ошибки обучения и проверки. Полезным инструментом для визуализации этого является график кривых обучения, который отображает производительность модели как на данных обучения, так и на данных проверки на протяжении всего процесса обучения. Изучая эти кривые, мы можем определить, является ли модель переобученной (высокая дисперсия), недостаточной (высокое смещение) или хорошо подходящей (оптимальный баланс между смещением и дисперсией).

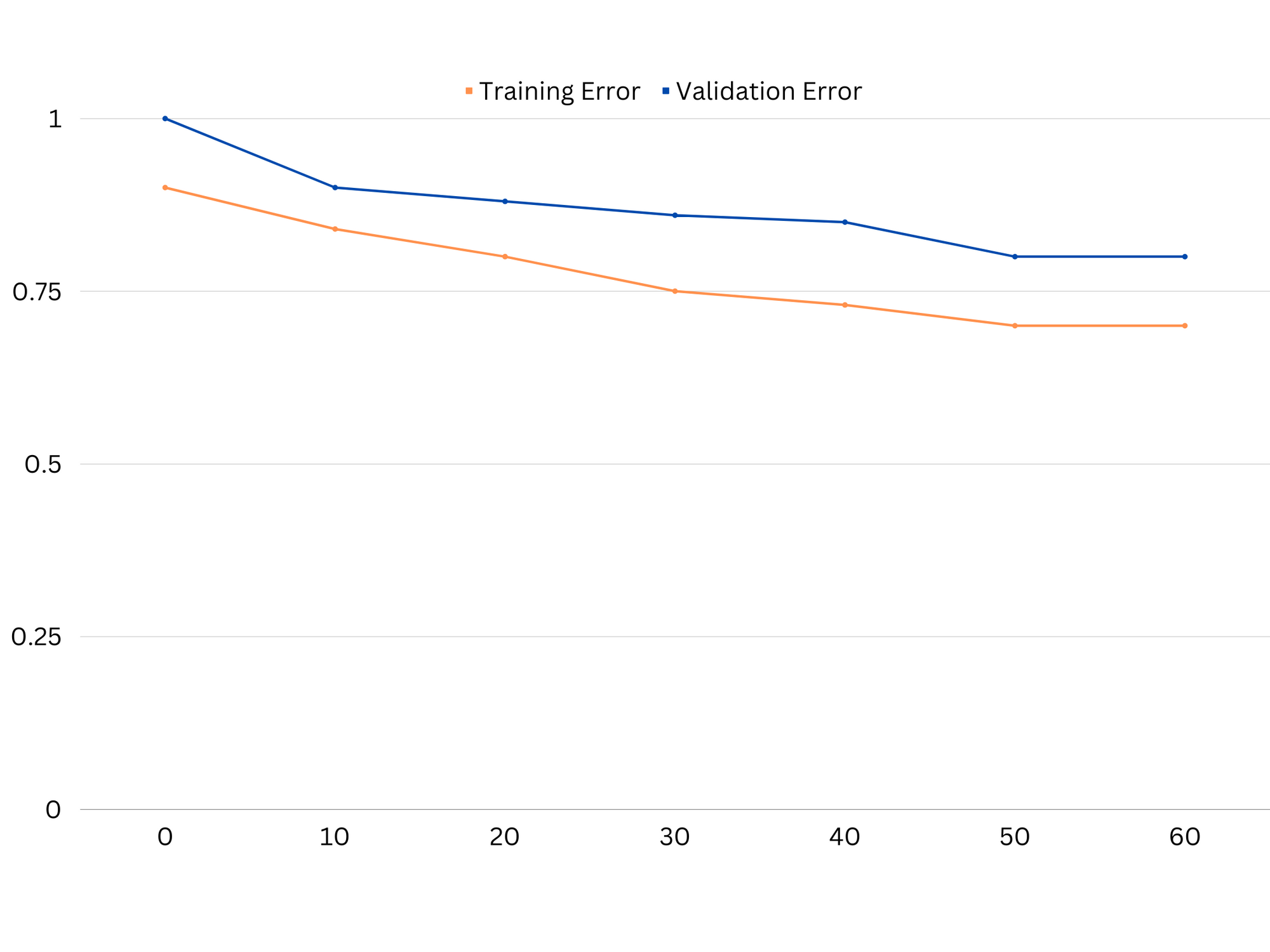

Пример кривых обучения неподходящей модели. И ошибка обучения, и ошибка проверки высоки.

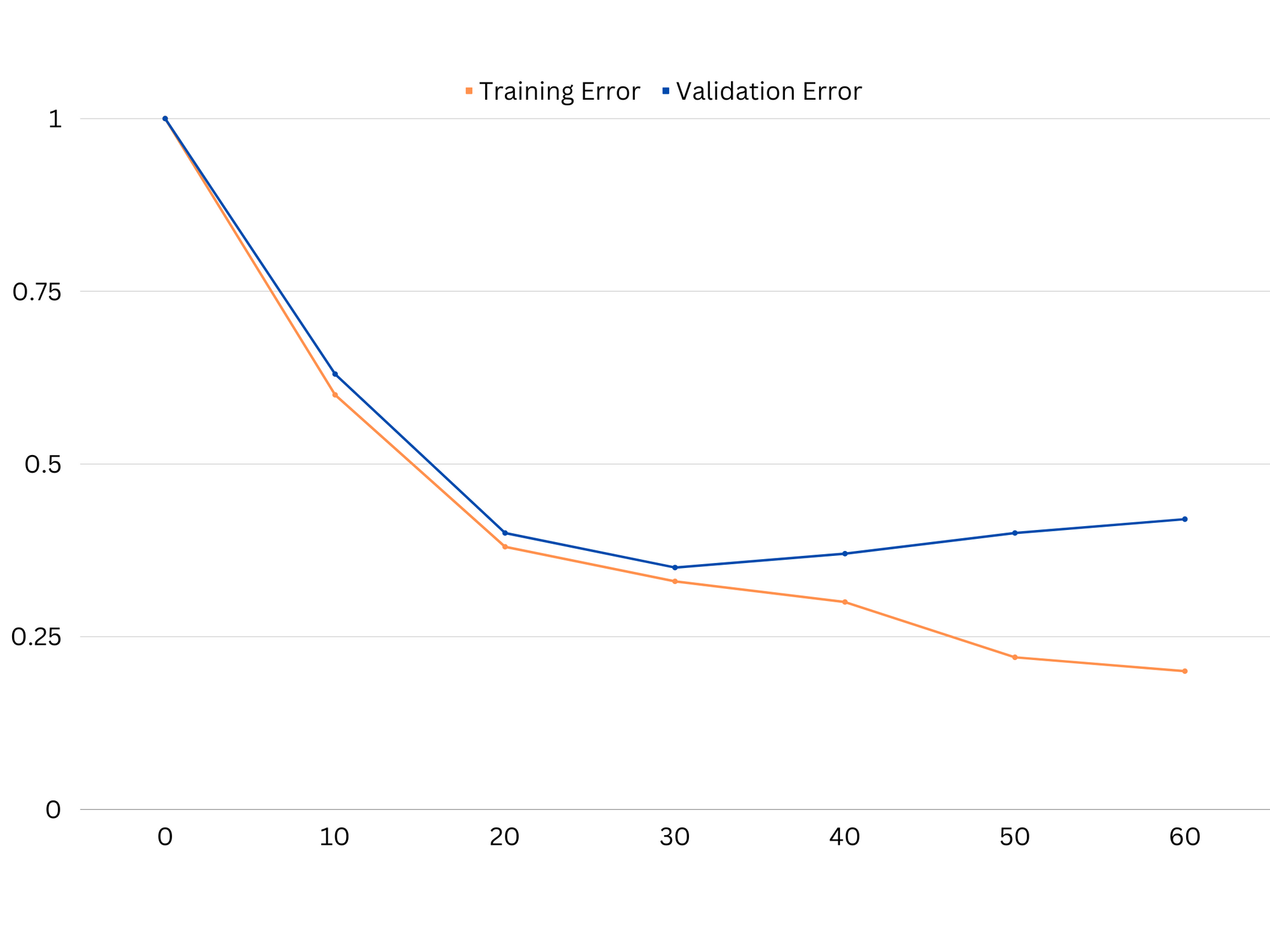

На практике низкая производительность как при обучении, так и при проверке данных предполагает, что модель слишком проста, что приводит к недообучению. С другой стороны, если модель очень хорошо работает на обучающих данных, но плохо на тестовых данных, сложность модели, вероятно, слишком высока, что приводит к переоснащению. Чтобы решить проблему недообучения, мы можем попробовать увеличить сложность модели, добавив дополнительные функции, изменив алгоритм обучения или выбрав другие гиперпараметры. В случае переобучения нам следует рассмотреть возможность регуляризации модели или использования таких методов, как перекрестная проверка, для улучшения ее возможностей обобщения.

Пример кривых обучения модели переобучения. Ошибка обучения уменьшается, а ошибка проверки начинает увеличиваться. Модель не может обобщать.

Регуляризация — это метод, который можно использовать для уменьшения ошибки дисперсии в моделях машинного обучения, помогая найти компромисс между смещением и дисперсией. Существует ряд различных методов регуляризации, каждый из которых имеет свои преимущества и недостатки. Некоторые популярные методы регуляризации включают регрессию гребня, регрессию лассо и регуляризацию эластичной сети. Все эти методы помогают предотвратить переоснащение, добавляя штрафной член к целевой функции модели, что препятствует экстремальным значениям параметров и поощряет использование более простых моделей.

Регрессия хребта, также известная как регуляризация L2, добавляет штрафной член, пропорциональный квадрату параметров модели. Этот метод приводит к моделям с меньшими значениями параметров, что может привести к уменьшению дисперсии и улучшению обобщения. Однако он не выполняет выбор функций, поэтому все функции остаются в модели.

Ознакомьтесь с нашим практическим руководством по изучению Git с рекомендациями, принятыми в отрасли стандартами и прилагаемой памяткой. Перестаньте гуглить команды Git и на самом деле изучить это!

Лассо регрессия, или регуляризация L1, добавляет штрафной член, пропорциональный абсолютному значению параметров модели. Этот метод может привести к моделям с разреженными значениями параметров, эффективно выполняя выбор признаков, устанавливая некоторые параметры равными нулю. Это может привести к более простым моделям, которые легче интерпретировать.

Эластичная чистая регуляризация представляет собой комбинацию регуляризации L1 и L2, обеспечивающую баланс между регрессией гребня и регрессией лассо. Управляя соотношением между двумя штрафными условиями, эластичная сеть может получить преимущества обоих методов, таких как улучшенное обобщение и выбор признаков.

Пример кривых обучения хорошей подходящей модели.

Выводы

Компромисс между смещением и дисперсией — ключевая концепция машинного обучения, которая определяет эффективность и качество модели. В то время как высокое смещение приводит к недостаточной подгонке, а высокая дисперсия приводит к переподгонке, поиск оптимального баланса между ними необходим для построения надежных моделей, которые хорошо обобщают новые данные.

С помощью кривых обучения можно выявить проблемы переобучения или недообучения, а путем настройки сложности модели или внедрения методов регуляризации можно повысить производительность как на данных обучения и проверки, так и на тестовых данных.

- SEO-контент и PR-распределение. Получите усиление сегодня.

- ПлатонАйСтрим. Анализ данных Web3. Расширение знаний. Доступ здесь.

- Чеканка будущего с Эдриенн Эшли. Доступ здесь.

- Покупайте и продавайте акции компаний PREIPO® с помощью PREIPO®. Доступ здесь.

- Источник: https://stackabuse.com/the-bias-variance-trade-off-in-machine-learning/

- :является

- :нет

- :куда

- 1

- 12

- 20

- 8

- a

- способность

- в состоянии

- О нас

- Absolute

- точно

- Достигать

- достижение

- на самом деле

- добавить

- адрес

- Добавляет

- Преимущества

- совет

- влиять на

- затрагивающий

- алгоритм

- Все

- Позволяющий

- причислены

- an

- и

- любой

- МЫ

- гайд

- AS

- Баланс

- Остатки

- BE

- , так как:

- Преимущества

- между

- смещение

- граница

- изоферменты печени

- Строительство

- но

- by

- вычислять

- CAN

- возможности

- захватить

- случаев

- изменения

- Выбирая

- тесно

- сочетание

- сравнить

- комплекс

- сложность

- сама концепция

- Рассматривать

- управление

- Основные

- исправить

- решающее значение

- данным

- сделка

- уменьшается

- Определять

- определяет

- разница

- различный

- дисплеев

- распределение

- приносит

- два

- каждый

- Ранее

- легче

- фактически

- эффективность

- призывает

- достаточно

- ошибка

- ошибки

- Даже

- Изучение

- пример

- Объяснять

- экстремальный

- отсутствии

- не удается

- Особенность

- Особенности

- обнаружение

- соответствовать

- примерка

- колебания

- Фокус

- Что касается

- функция

- фундаментальный

- Общие

- идти

- цель

- хорошо

- земля

- инструкция

- рука

- практический

- Есть

- помощь

- помощь

- High

- высший

- зависать

- Как

- How To

- Однако

- HTTPS

- определения

- if

- Осуществляющий

- что она

- улучшать

- улучшенный

- in

- В других

- включают

- включены

- Увеличение

- повышение

- вход

- в

- Введение

- IT

- ЕГО

- Сохранить

- известный

- L1

- l2

- вести

- ведущий

- Лиды

- изучение

- позволять

- LG

- такое как

- Вероятно

- ll

- Низкий

- ниже

- машина

- обучение с помощью машины

- ДЕЛАЕТ

- упомянутый

- минимизация

- модель

- Модели

- БОЛЕЕ

- необходимо

- сеть

- Новые

- Шум

- номер

- цель

- of

- .

- on

- оптимальный

- or

- Другое

- наши

- внешний

- выходной

- собственный

- параметр

- параметры

- шаблон

- Выполнять

- производительность

- выполнения

- выполняет

- Платон

- Платон Интеллектуальные данные

- ПлатонДанные

- состояния потока

- Популярное

- возможное

- практическое

- практика

- предсказывать

- прогноз

- предотвращать

- проблемам

- процесс

- обеспечивать

- скорее

- соотношение

- уменьшить

- Цена снижена

- понимается

- Связанный

- отношения

- Отношения

- оставаться

- представлять

- результат

- в результате

- Итоги

- правую

- кольцо

- надежный

- s

- выбор

- чувствительность

- установка

- Shadow

- лист

- Короткое

- должен

- просто

- одновременно

- небольшой

- меньше

- So

- некоторые

- Источники

- площадь

- Стекабьюс

- стандартов

- Stop

- сильный

- такие

- Предлагает

- снижения вреда

- срок

- terms

- тестXNUMX

- чем

- который

- Ассоциация

- их

- Их

- Там.

- Эти

- они

- этой

- по всему

- в

- слишком

- инструментом

- Всего

- Train

- Обучение

- переход

- правда

- Правда

- стараться

- два

- типично

- не в состоянии

- лежащий в основе

- неизвестный

- используемый

- через

- Проверка

- ценностное

- Наши ценности

- очень

- we

- ЧТО Ж

- Что

- будь то

- который

- в то время как

- будете

- слова

- зефирнет

- нуль