Amazon SageMaker Обработчик данных — это инструмент подготовки данных на основе пользовательского интерфейса, который помогает выполнять анализ, предварительную обработку и визуализацию данных с функциями более быстрой очистки, преобразования и подготовки данных. Предварительно созданные шаблоны потоков Data Wrangler помогают ускорить подготовку данных для специалистов по обработке данных и специалистов по машинному обучению (ML), помогая вам ускорить и понять передовые практики для потоков данных с использованием общих наборов данных.

Вы можете использовать потоки Data Wrangler для выполнения следующих задач:

- Визуализация данных - Изучение статистических свойств для каждого столбца в наборе данных, построение гистограмм, изучение выбросов

- Очистка данных - Удаление дубликатов, удаление или заполнение записей пропущенными значениями, удаление выбросов

- Обогащение данных и разработка функций - Обработка столбцов для создания более выразительных функций, выбор подмножества функций для обучения

Этот пост поможет вам понять Data Wrangler, используя следующие примеры готовых потоков на GitHub. В репозитории демонстрируется преобразование табличных данных, преобразование данных временных рядов и преобразование объединенных наборов данных. Каждый из них требует разного типа преобразований из-за своей базовой природы. Стандартные табличные или перекрестные данные собираются в определенный момент времени. Напротив, данные временных рядов собираются неоднократно с течением времени, при этом каждая последующая точка данных зависит от ее прошлых значений.

Давайте посмотрим на пример того, как мы можем использовать образец потока данных для табличных данных.

Предпосылки

Data Wrangler — это Создатель мудреца Амазонки функция доступна внутри Студия Amazon SageMaker, поэтому нам нужно следовать процессу адаптации Studio, чтобы развернуть среду Studio и блокноты. Хотя вы можете выбрать один из нескольких методов аутентификации, самый простой способ создать домен Studio — следовать инструкциям. Быстрый старт инструкции. Быстрый запуск использует те же настройки по умолчанию, что и стандартная установка студии. Вы также можете подключиться с помощью Центр идентификации AWS IAM (преемник AWS Single Sign-On) для аутентификации (см. Подключение к домену Amazon SageMaker с помощью IAM Identity Center).

Импортируйте набор данных и файлы потоков в Data Wrangler с помощью Studio.

Следующие шаги описывают, как импортировать данные в SageMaker для использования Data Wrangler:

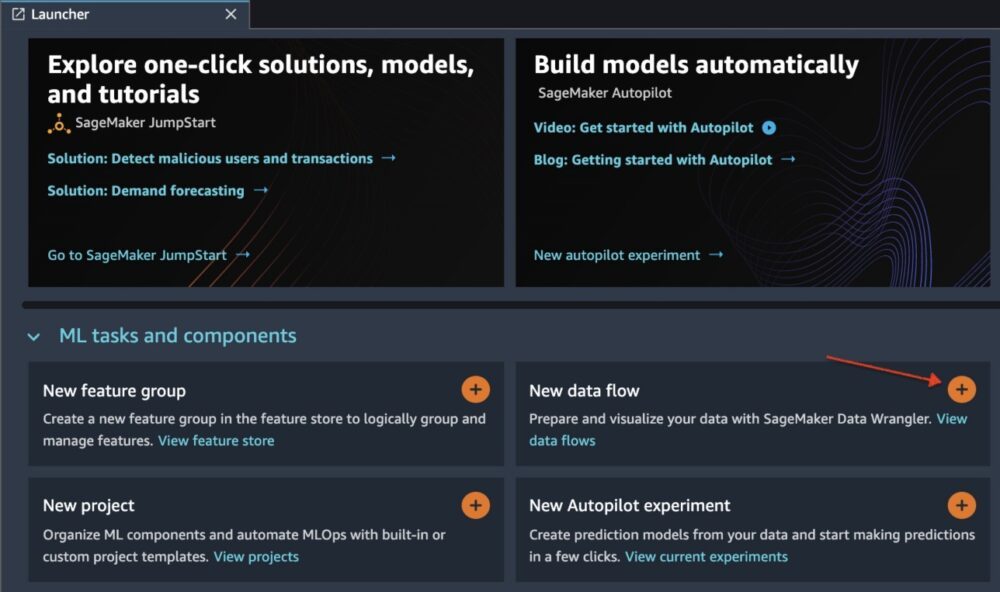

Инициализируйте Data Wrangler через пользовательский интерфейс Studio, выбрав Новый поток данных.

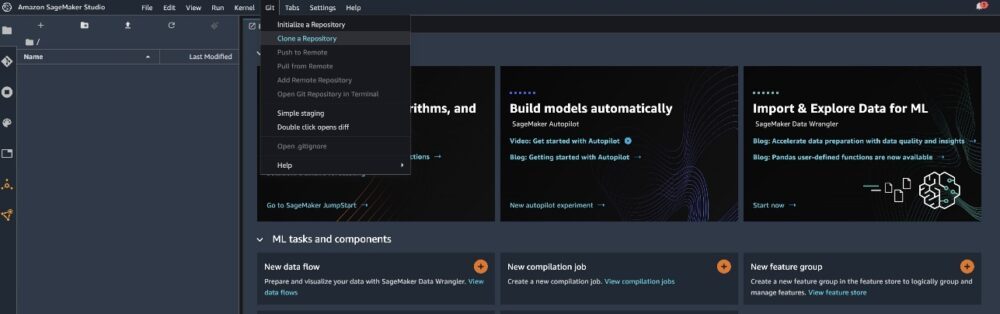

Клонировать Репо GitHub для загрузки файлов потока в среду Studio.

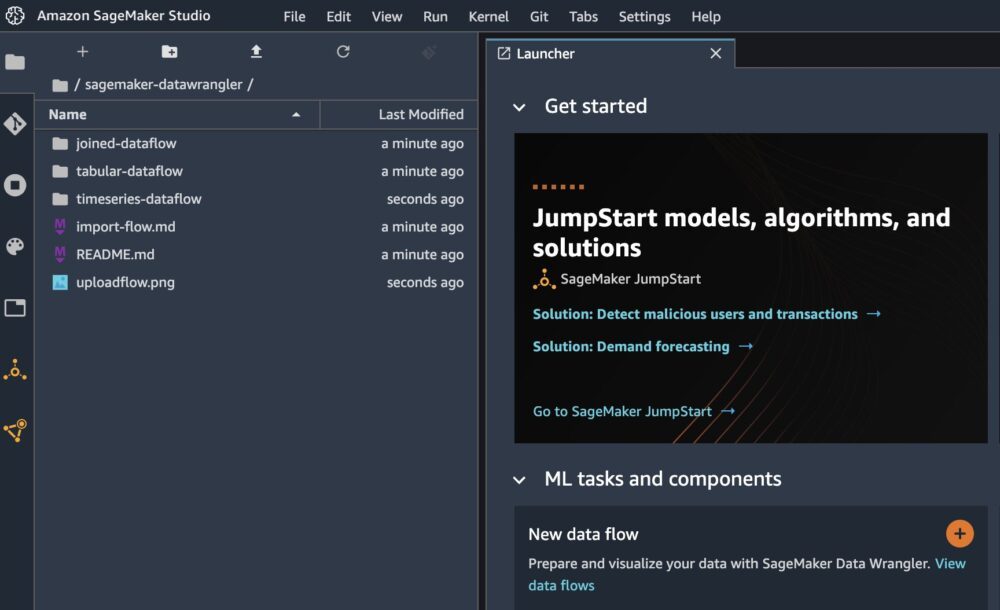

Когда клонирование будет завершено, вы сможете увидеть содержимое репозитория на левой панели.

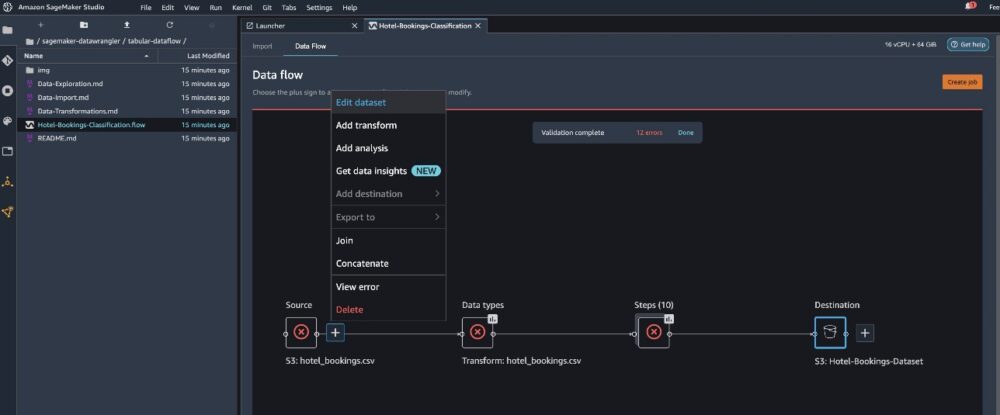

Выберите файл Бронирование отелей-Classification.flow чтобы импортировать файл потока в Data Wrangler.

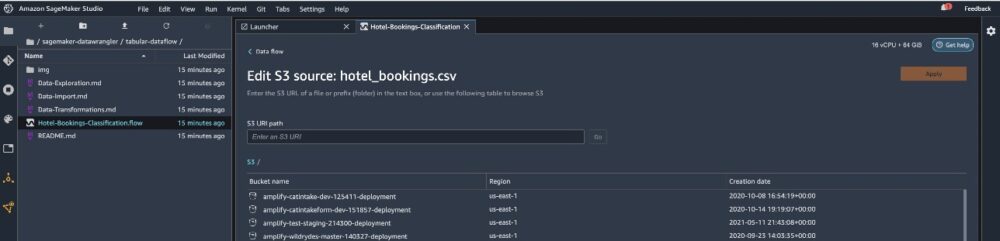

Если вы используете временной ряд или объединенный поток данных, поток будет отображаться под другим именем. После импорта потока вы должны увидеть следующий снимок экрана. Это показывает нам ошибки, поскольку нам нужно убедиться, что файл потока указывает на правильный источник данных в Простой сервис хранения Amazon (Amazon S3).

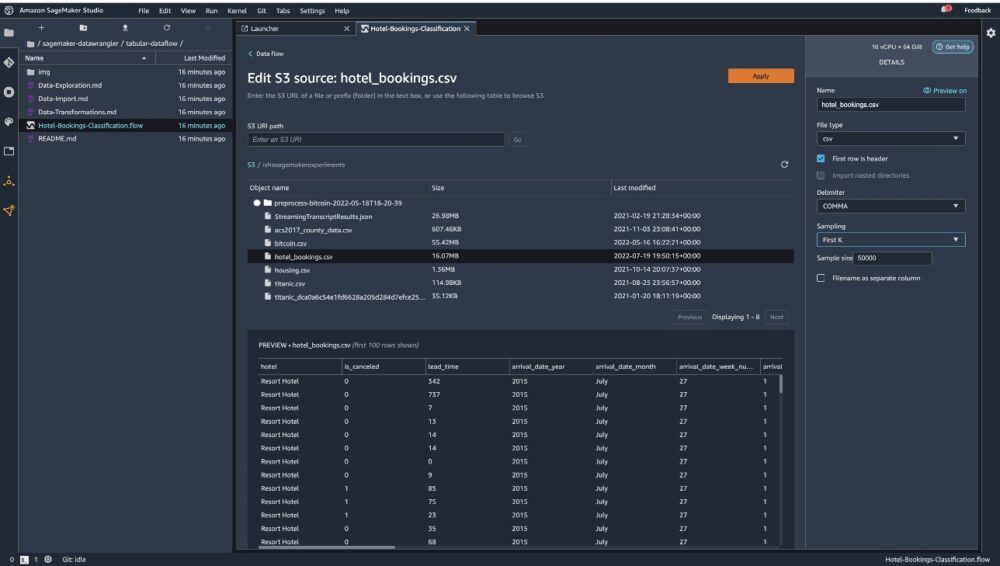

Выберите Изменить набор данных чтобы поднять все ваши корзины S3. Далее выберите набор данных hotel_bookings.csv из корзины S3 для прохождения через табличный поток данных.

Обратите внимание: если вы используете объединенный поток данных, вам, возможно, придется импортировать несколько наборов данных в Data Wrangler.

На правой панели убедитесь, что ЗАПЯТАЯ выбирается в качестве разделителя и Отбор проб на Первый К. Наш набор данных достаточно мал, чтобы можно было выполнить преобразования Data Wrangler для всего набора данных, но мы хотели подчеркнуть, как можно импортировать набор данных. Если у вас большой набор данных, рассмотрите возможность использования выборки. Выбирать Импортировать чтобы импортировать этот набор данных в Data Wrangler.

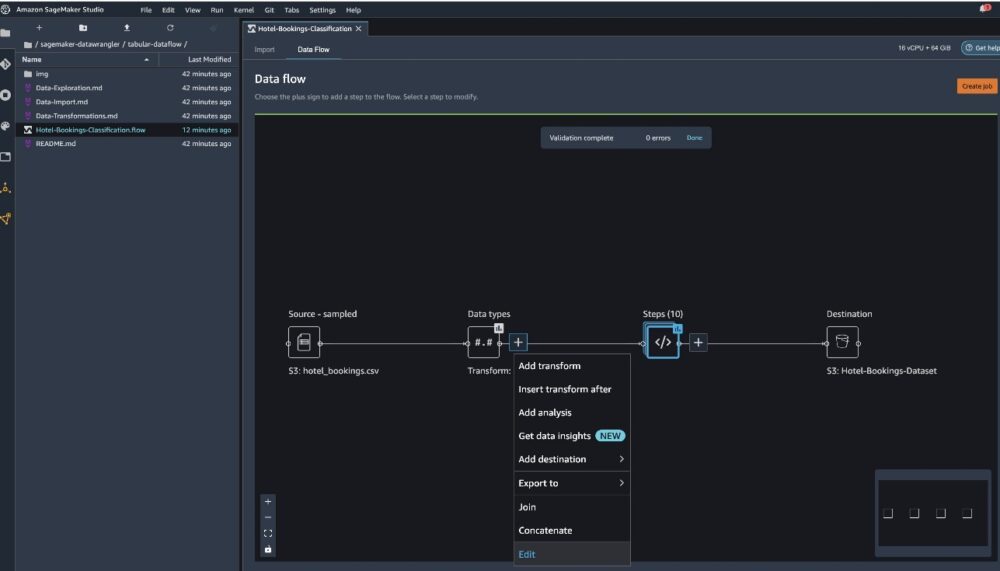

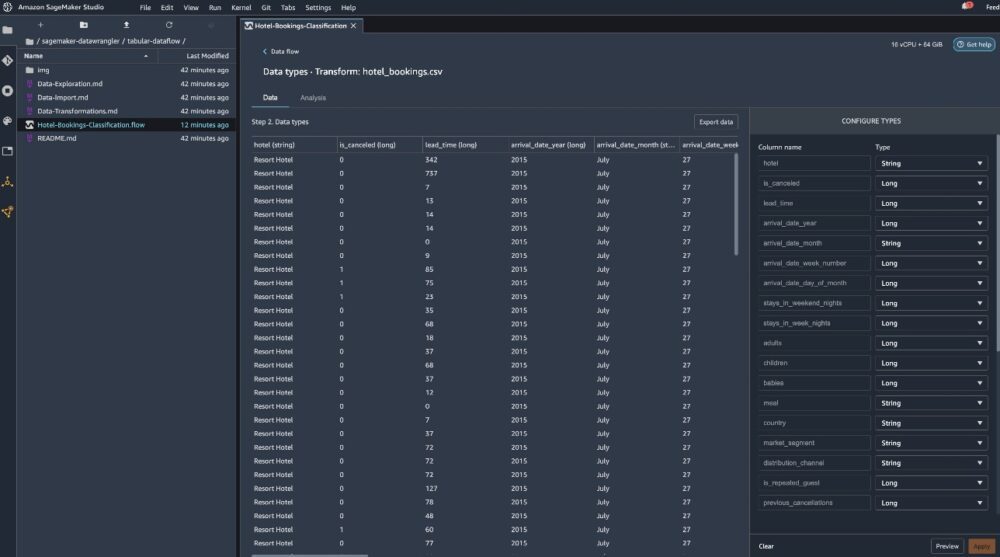

После импорта набора данных Data Wrangler автоматически проверяет набор данных и определяет типы данных. Вы можете видеть, что ошибки исчезли, поскольку мы указываем на правильный набор данных. Редактор потоков теперь отображает два блока, демонстрирующие, что данные были импортированы из источника и распознаны типы данных. При необходимости вы также можете редактировать типы данных.

На следующем снимке экрана показаны наши типы данных.

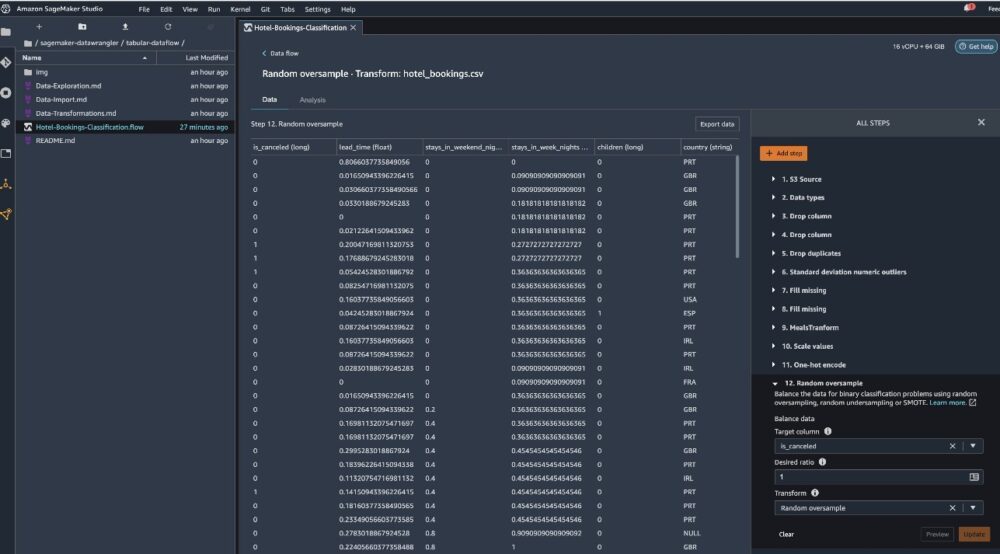

Давайте посмотрим на некоторые преобразования, выполненные в рамках этого табличного потока. Если вы используете Временные ряды or присоединился потоки данных, ознакомьтесь с некоторыми распространенными преобразованиями на Репо GitHub. Мы провели базовый исследовательский анализ данных, используя отчеты по анализу данных, в которых изучались целевые утечки и коллинеарность функций в наборе данных, анализ сводных таблиц и возможности быстрого моделирования. Изучите шаги на Репо GitHub.

Теперь мы удаляем столбцы на основе рекомендаций, предоставленных в отчете о данных и качестве.

- Для целевой утечки отбросьте резервирование_статус.

- Для избыточных столбцов отбросьте дни_в_списке_ожидания, отель, тип зарезервированного_номера, дата_приезда_месяц, дата_статуса_бронирования, младенцы, и прибытие_дата_день_месяца.

- На основе результатов линейной корреляции удалить столбцы прибытие_дата_номер_недели и прибытие_дата_год поскольку значения корреляции для этих пар объектов (столбцов) превышают рекомендуемый порог 0.90.

- На основе результатов нелинейной корреляции отбросьте резервирование_статус. Этот столбец уже был помечен для удаления на основании целевого анализа утечек.

- Обработка числовых значений (масштабирование мин-макс) для Lead_time, Stays_in_weekend_nights, Stays_in_weekday_nights, is_repeated_guest, prev_cancellations, prev_bookings_not_canceled, booking_changes, adr, total_of_specical_requests, и require_car_parking_spaces.

- Горячее кодирование категориальных переменных, таких как еда, is_repeated_guest, market_segment, назначенный_тип_комнаты, депозит_тип, и Тип клиента.

- Сбалансируйте целевую переменную. Случайная передискретизация для устранения дисбаланса классов. Используйте возможности быстрого моделирования для обработки выбросов и пропущенных значений.

Экспорт в Amazon S3

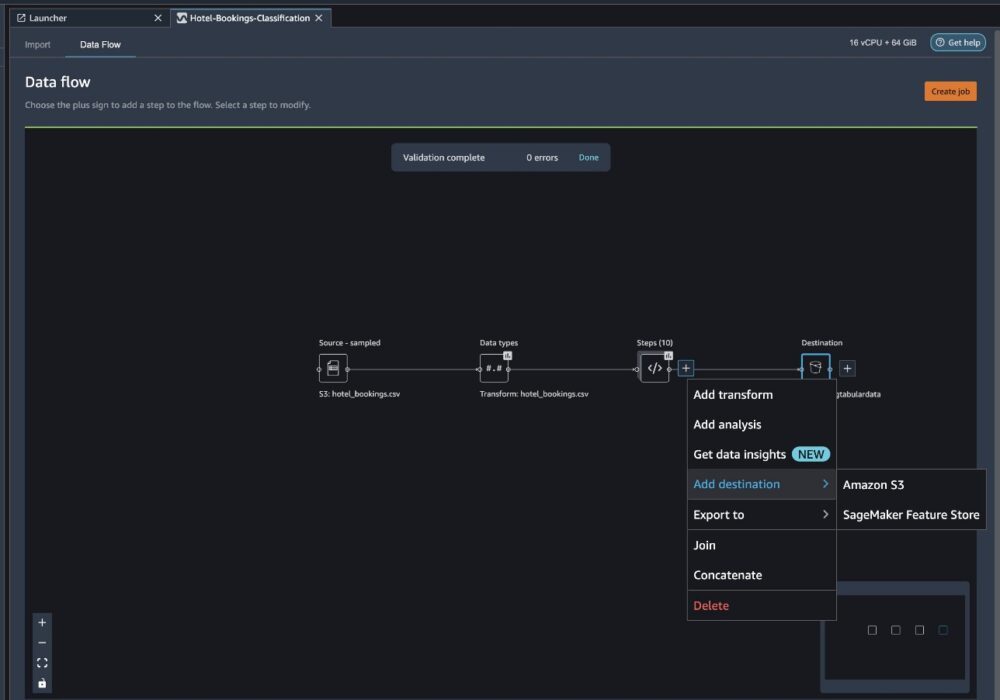

Теперь мы прошли различные преобразования и готовы экспортировать данные в Amazon S3. Этот параметр создает задание обработки SageMaker, которое запускает поток обработки Data Wrangler и сохраняет полученный набор данных в указанную корзину S3. Выполните следующие шаги, чтобы настроить экспорт в Amazon S3:

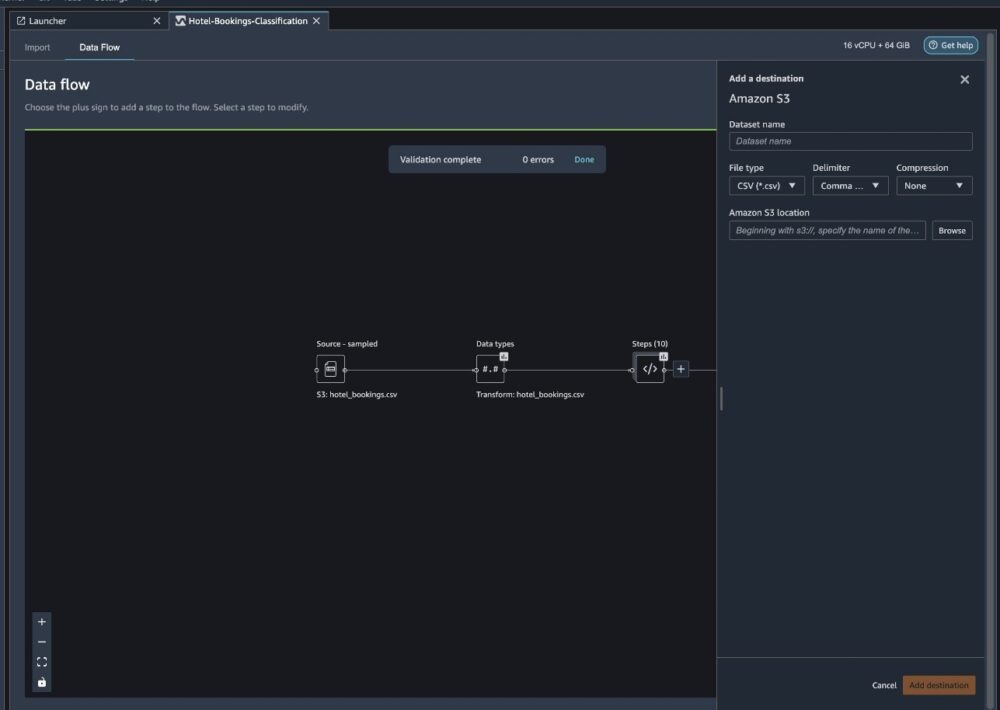

Щелкните знак плюса рядом с коллекцией элементов трансформации и выберите Добавить пункт назначения, то Amazon S3.

- Что касается Имя набора данных, введите имя нового набора данных, например

NYC_export. - Что касается Тип файла, выберите CSV.

- Что касается Разделитель, выберите Запятая.

- Что касается компрессия, выберите Ничто.

- Что касается Местоположение Амазон S3, используйте то же имя корзины, которое мы создали ранее.

- Выберите Добавить пункт назначения.

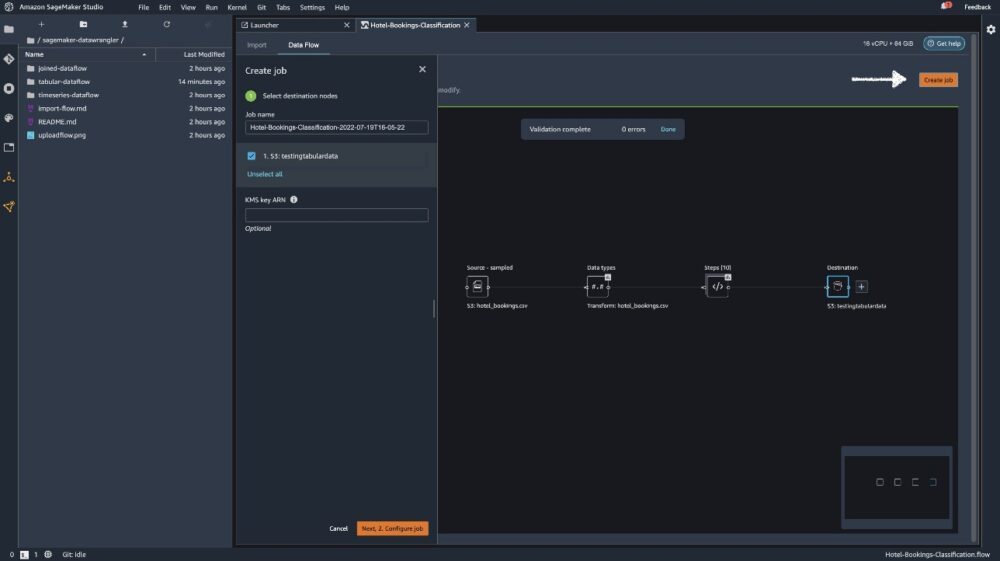

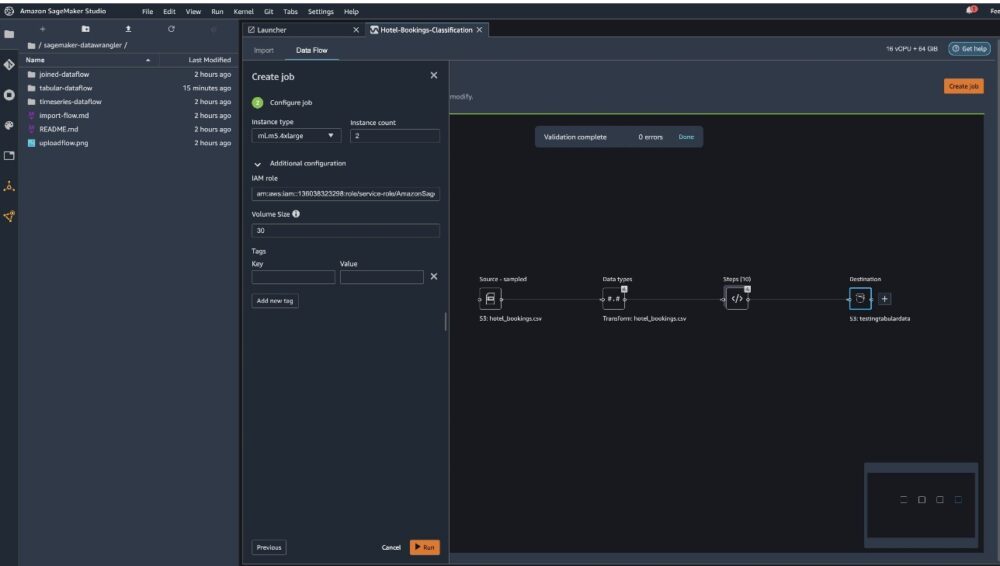

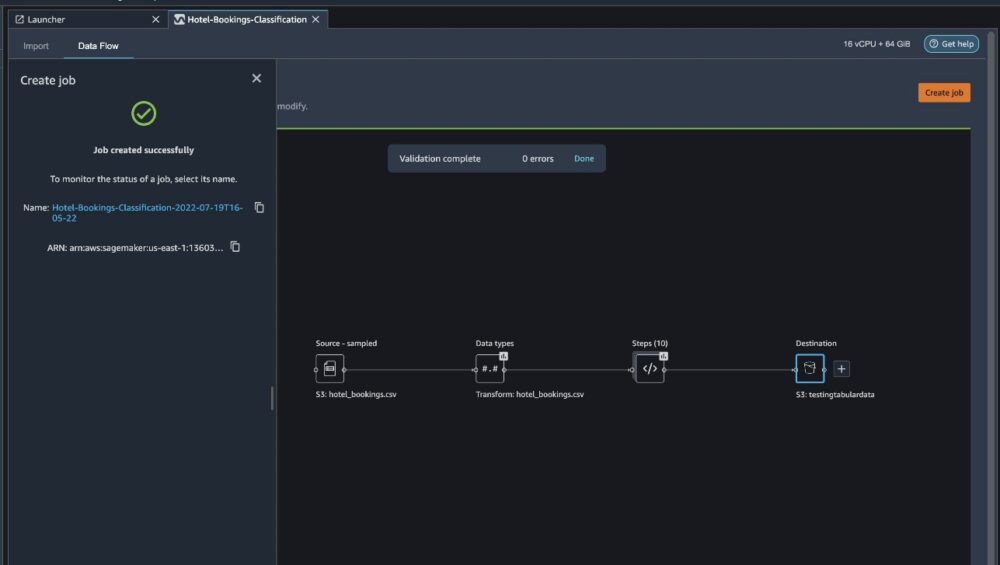

Выберите Создать работу.

Что касается Название работы, введите имя или сохраните автоматически созданный вариант и выберите назначение. У нас есть только один пункт назначения, S3:testingtabulardata, но у вас может быть несколько пунктов назначения на разных этапах рабочего процесса. Оставь KMS-ключ ARN поле пустое и выберите Следующая.

Теперь вам нужно настроить вычислительную мощность для задания. Вы можете сохранить все значения по умолчанию для этого примера.

- Что касается Тип экземпляра, используйте ml.m5.4xlarge.

- Что касается Количество экземпляров, используйте 2.

- Вы можете исследовать Дополнительная конфигурация, но сохраните настройки по умолчанию.

- Выберите Run.

Теперь ваша работа началась, и обработка 6 ГБ данных в соответствии с нашим потоком обработки Data Wrangler занимает некоторое время. Стоимость этой работы составит около 2 долларов США, поскольку ml.m5.4xlarge стоит 0.922 доллара США в час, и мы используем два из них.

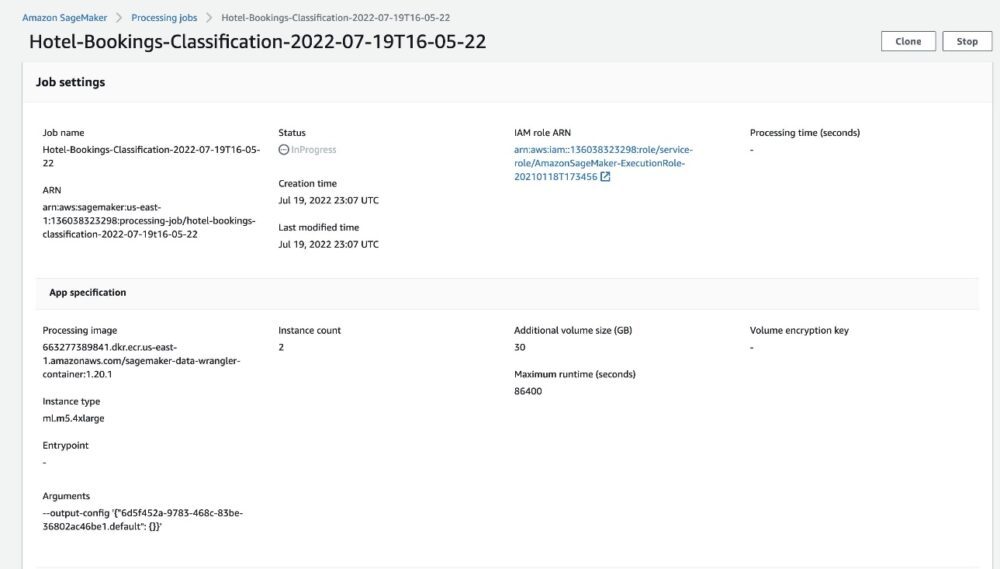

Если вы выберете имя задания, вы будете перенаправлены в новое окно с подробностями задания.

На странице сведений о задании вы можете увидеть все параметры из предыдущих шагов.

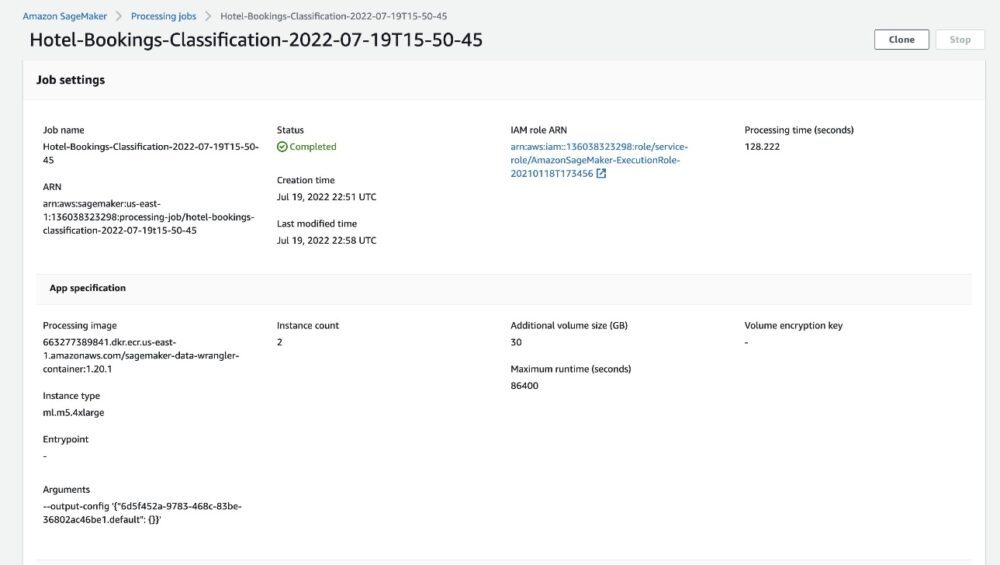

Когда статус задания изменится на «Завершено», вы также можете проверить Время обработки (секунды) ценить. Выполнение этой обработки занимает около 5–10 минут.

После завершения задания выходные файлы обучения и теста будут доступны в соответствующих выходных папках S3. Местоположение вывода можно найти в конфигурациях задания обработки.

После завершения задания обработки Data Wrangler мы можем проверить результаты, сохраненные в нашей корзине S3. Не забудьте обновить job_name переменная с названием вашей работы.

Теперь вы можете использовать эти экспортированные данные для запуска моделей ML.

Убирать

Удалите корзины S3 ваши способы оплаты и счета-фактуры. Поток обработки данных чтобы удалить базовые ресурсы и предотвратить нежелательные затраты после завершения эксперимента.

Заключение

В этом посте мы показали, как можно импортировать предварительно созданный табличный поток данных в Data Wrangler, подключить его к нашему набору данных и экспортировать результаты в Amazon S3. Если ваши варианты использования требуют манипулирования данными временных рядов или объединения нескольких наборов данных, вы можете просмотреть другие предварительно созданные примеры потоков в разделе Репо GitHub.

После импорта предварительно созданного рабочего процесса подготовки данных его можно интегрировать с Amazon SageMaker Processing. Конвейеры Amazon SageMakerкачества Магазин функций Amazon SageMaker упростить задачу обработки, обмена и хранения данных обучения ML. Вы также можете экспортировать этот пример потока данных в сценарий Python и создать собственный конвейер подготовки данных ML, тем самым ускоряя скорость выпуска.

Предлагаем вам ознакомиться с нашим Репозиторий GitHub чтобы получить практическую практику и найти новые способы повышения точности модели! Чтобы узнать больше о SageMaker, посетите Руководство разработчика Amazon SageMaker.

Об авторах

Иша Дуа работает старшим архитектором решений в районе залива Сан-Франциско. Она помогает корпоративным клиентам AWS расти, понимая их цели и проблемы, а также дает им советы о том, как они могут создавать свои приложения в облачной манере, обеспечивая при этом их отказоустойчивость и масштабируемость. Она увлечена технологиями машинного обучения и экологической устойчивостью.

Иша Дуа работает старшим архитектором решений в районе залива Сан-Франциско. Она помогает корпоративным клиентам AWS расти, понимая их цели и проблемы, а также дает им советы о том, как они могут создавать свои приложения в облачной манере, обеспечивая при этом их отказоустойчивость и масштабируемость. Она увлечена технологиями машинного обучения и экологической устойчивостью.

- AI

- ай искусство

- генератор искусств ай

- искусственный интеллект

- Создатель мудреца Амазонки

- Обработчик данных Amazon SageMaker

- искусственный интеллект

- сертификация искусственного интеллекта

- искусственный интеллект в банковском деле

- робот с искусственным интеллектом

- роботы с искусственным интеллектом

- программное обеспечение искусственного интеллекта

- Машинное обучение AWS

- блокчейн

- конференция по блокчейну

- Coingenius

- разговорный искусственный интеллект

- криптоконференция ИИ

- дал-и

- глубокое обучение

- google ai

- обучение с помощью машины

- Платон

- Платон Ай

- Платон Интеллектуальные данные

- Платон игра

- ПлатонДанные

- платогейминг

- масштаб ай

- синтаксис

- зефирнет