To je gostujoča objava avtorja AK Roya iz podjetja Qualcomm AI.

Amazon Elastic Compute Cloud (Amazon EC2) Primerke DL2q, ki jih poganjajo pospeševalniki Qualcomm AI 100 Standard, je mogoče uporabiti za stroškovno učinkovito uvajanje delovnih obremenitev globokega učenja (DL) v oblaku. Uporabljajo se lahko tudi za razvoj in potrjevanje učinkovitosti in natančnosti delovnih obremenitev DL, ki bodo nameščene na napravah Qualcomm. Primerki DL2q so prvi primerki, ki Qualcommovo tehnologijo umetne inteligence (AI) prinašajo v oblak.

Z osmimi pospeševalniki Qualcomm AI 100 Standard in 128 GiB skupnega pomnilnika pospeševalnika lahko stranke uporabljajo tudi primerke DL2q za izvajanje priljubljenih generativnih aplikacij umetne inteligence, kot so ustvarjanje vsebine, povzemanje besedila in virtualni pomočniki, kot tudi klasične aplikacije umetne inteligence za obdelavo naravnega jezika in računalniški vid. Poleg tega pospeševalniki Qualcomm AI 100 vsebujejo isto tehnologijo umetne inteligence, ki se uporablja v pametnih telefonih, avtonomni vožnji, osebnih računalnikih in slušalkah z razširjeno resničnostjo, tako da se primerki DL2q lahko uporabljajo za razvoj in potrditev teh delovnih obremenitev umetne inteligence pred uvedbo.

Novi poudarki primerka DL2q

Vsak primerek DL2q vključuje osem pospeševalnikov Qualcomm Cloud AI100 s skupno zmogljivostjo več kot 2.8 PetaOps zmogljivosti sklepanja Int8 in 1.4 PetaFlops zmogljivosti sklepanja FP16. Instanca ima skupno 112 jeder AI, kapaciteto pomnilnika pospeševalnika 128 GB in pasovno širino pomnilnika 1.1 TB na sekundo.

Vsak primerek DL2q ima 96 vCPU-jev, kapaciteto sistemskega pomnilnika 768 GB in podpira omrežno pasovno širino 100 Gbps ter Amazon Elastic Block Store (Amazon EBS) shranjevanje 19 Gbps.

| Ime primerka | vCPU | Pospeševalniki Cloud AI100 | Pomnilnik pospeševalnika | Pomnilnik pospeševalnika BW (zbrano) | Pomnilnik primerkov | Omrežje primerkov | Pasovna širina shranjevanja (Amazon EBS). |

| DL2q.24xlarge | 96 | 8 | 128 GB | 1.088 TB / s | 768 GB | 100 Gbps | 19 Gbps |

Inovacija pospeševalnika Qualcomm Cloud AI100

Cloud AI100 pospeševalni sistem na čipu (SoC) je namensko izdelana, razširljiva večjedrna arhitektura, ki podpira širok nabor primerov uporabe globokega učenja, ki segajo od podatkovnega središča do roba. SoC uporablja skalarna, vektorska in tenzorska računalniška jedra z zmogljivostjo SRAM-a, ki je vodilna v panogi, 126 MB. Jedra so med seboj povezana z visokopasovno mrežo z nizko zakasnitvijo omrežja na čipu (NoC).

Pospeševalec AI100 podpira široko in celovito paleto modelov in primerov uporabe. Spodnja tabela poudarja obseg podpore modelu.

| Kategorija modela | Število modelov | Primeri |

| NLP | 157 | BERT, BART, FasterTransformer, T5, Z-code MOE |

| Generativni AI – NLP | 40 | LLaMA, CodeGen, GPT, OPT, BLOOM, Jais, Luminous, StarCoder, XGen |

| Generativni AI – Slika | 3 | Stabilna difuzija v1.5 in v2.1, OpenAI CLIP |

| CV – Razvrstitev slik | 45 | ViT, ResNet, ResNext, MobileNet, EfficientNet |

| CV – Zaznavanje predmeta | 23 | YOLO v2, v3, v4, v5 in v7, SSD-ResNet, RetinaNet |

| CV – drugo | 15 | LPRNet, Super-ločljivost/SRGAN, ByteTrack |

| Avtomobilska omrežja* | 53 | Zaznavanje in LIDAR, zaznavanje pešcev, voznih pasov in semaforjev |

| Skupaj | > 300 ,war | ,war |

* Večina avtomobilskih omrežij je sestavljenih omrežij, sestavljenih iz zlitja posameznih omrežij.

Velik vgrajen SRAM na pospeševalniku DL2q omogoča učinkovito izvajanje naprednih tehnik delovanja, kot sta natančnost mikroeksponenta MX6 za shranjevanje uteži in natančnost mikroeksponenta MX9 za komunikacijo med pospeševalnikom. Tehnologija mikroeksponent je opisana v naslednji objavi industrije Open Compute Project (OCP): AMD, Arm, Intel, Meta, Microsoft, NVIDIA in Qualcomm standardizirajo formate podatkov z ozko natančnostjo naslednje generacije za AI » Open Compute Project.

Uporabnik primerka lahko uporabi naslednjo strategijo za povečanje učinkovitosti glede na ceno:

- Shranite uteži z natančnostjo mikro eksponenta MX6 v DDR pomnilnik pospeševalnika. Uporaba natančnosti MX6 poveča izrabo razpoložljive kapacitete pomnilnika in pasovne širine pomnilnika za zagotavljanje najboljše prepustnosti in zakasnitve v svojem razredu.

- Računajte v FP16, da zagotovite zahtevano natančnost primera uporabe, medtem ko uporabljate vrhunski SRAM na čipu in rezervne TOP na kartici, da implementirate visoko zmogljiva jedra MX6 do FP16 z nizko zakasnitvijo.

- Uporabite optimizirano serijsko strategijo in večjo serijsko velikost z uporabo velikega SRAM-a na čipu, ki je na voljo, da čim bolj povečate ponovno uporabo uteži, hkrati pa čim bolj ohranite aktivacije na čipu.

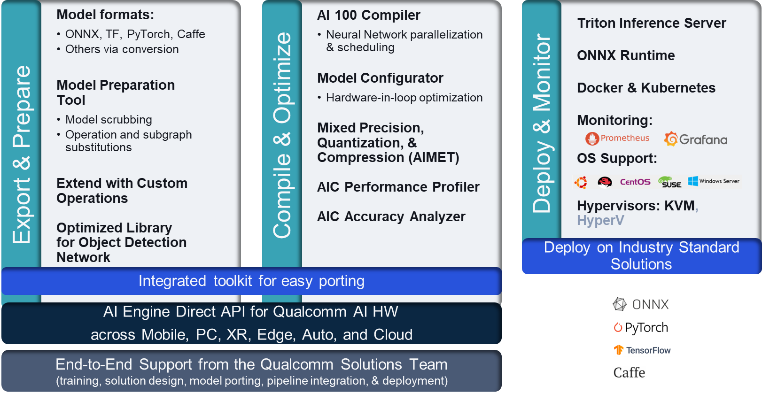

DL2q AI Stack in orodna veriga

Primerek DL2q spremlja Qualcomm AI Stack, ki zagotavlja dosledno izkušnjo razvijalcev v Qualcomm AI v oblaku in drugih izdelkih Qualcomm. Isti sklad umetne inteligence Qualcomm in osnovna tehnologija umetne inteligence delujeta na instancah DL2q in robnih napravah Qualcomm ter strankam zagotavljata dosledno razvijalsko izkušnjo z enotnim API-jem v njihovih razvojnih okoljih v oblaku, avtomobilizmu, osebnih računalnikih, razširjeni resničnosti in pametnih telefonih.

Veriga orodij omogoča uporabniku primerka, da hitro vključi predhodno usposobljen model, prevede in optimizira model za zmogljivosti primerka ter nato uvede prevedene modele za primere uporabe sklepanja v proizvodnji v treh korakih, prikazanih na naslednji sliki.

Če želite izvedeti več o prilagajanju zmogljivosti modela, glejte Ključni parametri zmogljivosti Cloud AI 100 Dokumentacija.

Začnite s primerki DL2q

V tem primeru prevedete in uvedete vnaprej usposobljeno Model BERT iz Objemni obraz na primerku EC2 DL2q z uporabo vnaprej vgrajenega razpoložljivega AMI DL2q v štirih korakih.

Uporabite lahko bodisi vnaprej pripravljeno Qualcomm DLAMI na primerku ali začnite z Amazon Linux2 AMI in zgradite svoj DL2q AMI s platformo Cloud AI 100 in SDK-jem za aplikacije, ki je na voljo v tem Preprosta storitev shranjevanja Amazon (Amazon S3) vedro: s3://ec2-linux-qualcomm-ai100-sdks/latest/.

Koraki, ki sledijo, uporabljajo vnaprej zgrajen DL2q AMI, Qualcomm Base AL2 DLAMI.

Uporabite SSH za dostop do svojega primerka DL2q s Qualcomm Base AL2 DLAMI AMI in sledite korakom od 1 do 4.

Korak 1. Nastavite okolje in namestite zahtevane pakete

- Namestite Python 3.8.

- Nastavite virtualno okolje Python 3.8.

- Aktivirajte virtualno okolje Python 3.8.

- Namestite zahtevane pakete, prikazane v dokument requirements.txt na voljo na javnem mestu Qualcomm Github.

- Uvozite potrebne knjižnice.

2. korak. Uvozite model

- Uvozi in tokeniziraj model.

- Določite vzorčni vnos in ekstrahirajte

inputIdsinattentionMask. - Pretvorite model v ONNX, ki ga lahko nato posredujete prevajalniku.

- Model boste izvajali z natančnostjo FP16. Zato morate preveriti, ali model vsebuje kakršne koli konstante, ki presegajo obseg FP16. Predajte model

fix_onnx_fp16funkcijo za ustvarjanje nove datoteke ONNX z zahtevanimi popravki.

Korak 3. Sestavite model

O qaic-exec za prevajanje modela se uporablja orodje za prevajanje vmesnika ukazne vrstice (CLI). Vhod v ta prevajalnik je datoteka ONNX, ustvarjena v 2. koraku. Prevajalnik ustvari binarno datoteko (imenovano QPCZa Programski vsebnik Qualcomm) na poti, ki jo definira -aic-binary-dir prepir.

V spodnjem ukazu za prevajanje uporabite štiri računalniška jedra AI in velikost paketa enega za prevajanje modela.

QPC se ustvari v bert-base-cased/generatedModels/bert-base-cased_fix_outofrange_fp16_qpc mapa.

Korak 4. Zaženite model

Nastavite sejo za izvajanje sklepanja na pospeševalniku Cloud AI100 Qualcomm v instanci DL2q.

Knjižnica Qualcomm qaic Python je niz API-jev, ki zagotavlja podporo za izvajanje sklepanja v pospeševalniku Cloud AI100.

- Uporabite klic Session API, da ustvarite primerek seje. Klic API-ja seje je vstopna točka za uporabo knjižnice qaic Python.

- Prestrukturirajte podatke iz izhodnega medpomnilnika z

output_shapeinoutput_type. - Dekodirajte proizvedeni izhod.

Tukaj so rezultati za vhodni stavek "Pes [MASKA] na preprogi."

To je vse. Z le nekaj koraki ste prevedli in zagnali model PyTorch na primerku Amazon EC2 DL2q. Če želite izvedeti več o vključitvi in prevajanju modelov na primerku DL2q, glejte Vadnica za Cloud AI100 Dokumentacija.

Če želite izvedeti več o tem, katere arhitekture modela DL so primerne za primerke AWS DL2q in trenutno podporno matriko modela, glejte Dokumentacija Qualcomm Cloud AI100.

Na voljo sedaj

Danes lahko zaženete primerke DL2q v regijah AWS Zahod ZDA (Oregon) in Evropa (Frankfurt) kot Na zahtevo, Rezerviranoin Spot primerki, ali kot del a Načrt varčevanja. Kot običajno pri Amazon EC2 plačate samo tisto, kar uporabite. Za več informacij glejte Cene Amazon EC2.

Primerke DL2q je mogoče namestiti z uporabo AMI za globoko učenje AWS (DLAMI), slike vsebnikov pa so na voljo prek upravljanih storitev, kot je npr Amazon SageMaker, Storitev Amazon Elastic Kubernetes (Amazon EKS), Amazonska elastična posoda (Amazon ECS)in AWS ParallelCluster.

Če želite izvedeti več, obiščite spletno mesto Primerek Amazon EC2 DL2q strani in pošljite povratne informacije na AWS re:Objava za EC2 ali prek vaših običajnih kontaktov za podporo AWS.

O avtorjih

AK Roy je direktor produktnega upravljanja pri Qualcommu za izdelke in rešitve umetne inteligence v oblaku in podatkovnih centrih. Ima več kot 20 let izkušenj na področju strategije in razvoja izdelkov, s trenutnim poudarkom na najboljših zmogljivostih v razredu in celovitih rešitvah zmogljivosti/$ za sklepanje AI v oblaku, za širok spekter primerov uporabe, vključno z GenAI, LLMs, Auto in Hybrid AI.

AK Roy je direktor produktnega upravljanja pri Qualcommu za izdelke in rešitve umetne inteligence v oblaku in podatkovnih centrih. Ima več kot 20 let izkušenj na področju strategije in razvoja izdelkov, s trenutnim poudarkom na najboljših zmogljivostih v razredu in celovitih rešitvah zmogljivosti/$ za sklepanje AI v oblaku, za širok spekter primerov uporabe, vključno z GenAI, LLMs, Auto in Hybrid AI.

Jianying Lang je glavni arhitekt rešitev pri AWS Worldwide Specialist Organisation (WWSO). Ima več kot 15 let delovnih izkušenj na področju HPC in AI. Pri AWS se osredotoča na pomoč strankam pri uvajanju, optimiziranju in prilagajanju delovnih obremenitev AI/ML na pospešenih računalniških instancah. Navdušena je nad združevanjem tehnik na področjih HPC in AI. Jianying je doktoriral iz računalniške fizike na univerzi Colorado v Boulderju.

Jianying Lang je glavni arhitekt rešitev pri AWS Worldwide Specialist Organisation (WWSO). Ima več kot 15 let delovnih izkušenj na področju HPC in AI. Pri AWS se osredotoča na pomoč strankam pri uvajanju, optimiziranju in prilagajanju delovnih obremenitev AI/ML na pospešenih računalniških instancah. Navdušena je nad združevanjem tehnik na področjih HPC in AI. Jianying je doktoriral iz računalniške fizike na univerzi Colorado v Boulderju.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/amazon-ec2-dl2q-instance-for-cost-efficient-high-performance-ai-inference-is-now-generally-available/

- :ima

- : je

- $GOR

- 1

- 1 TB

- 10

- 100

- 11

- 12

- 13

- 15 let

- 15%

- 17

- 19

- 20

- 20 let

- 22

- 23

- 7

- 75

- 8

- 84

- a

- O meni

- nad

- pospešeno

- plin

- pospeševalniki

- dostop

- v spremstvu

- natančnost

- čez

- aktivacije

- Poleg tega

- napredno

- agregat

- AI

- AI / ML

- vsi

- Prav tako

- Amazon

- Amazon EC2

- Amazon Web Services

- an

- in

- Objava

- kaj

- API

- API-ji

- aplikacije

- aplikacije

- Arhitektura

- SE

- Argument

- ARM

- umetni

- AS

- pomočniki

- At

- avto

- avtomobilska

- avtonomno

- Na voljo

- AWS

- OSI

- pasovna širina

- baza

- BE

- pred

- spodaj

- Poleg

- BIN

- Block

- Bloom

- prinašajo

- široka

- varovalni

- izgradnjo

- by

- klic

- se imenuje

- CAN

- Zmogljivosti

- kapaciteta

- kartice

- primeru

- preveriti

- klasična

- Cloud

- Colorado

- združevanje

- Komunikacija

- celovito

- računalniški

- Izračunajte

- računalnik

- Računalniška vizija

- računalniki

- računalništvo

- dosledno

- Sestavljeno

- kontakti

- Posoda

- Vsebuje

- vsebina

- Ustvarjanje vsebine

- ustvarjajo

- Trenutna

- Stranke, ki so

- datum

- Datacenter

- globoko

- globoko učenje

- opredeljen

- Stopnja

- poda

- daje

- razporedi

- razporejeni

- uvajanje

- opisano

- Razvoj

- Razvojni

- Razvoj

- naprava

- naprave

- Difuzija

- Direktor

- Dokumentacija

- Pes

- vožnjo

- dinamično

- Edge

- učinkovite

- bodisi

- zaposluje

- omogoča

- konec koncev

- Vpis

- okolje

- okolja

- Evropa

- Primer

- izkušnje

- razširjena resničnost

- ekstrakt

- false

- Feature

- povratne informacije

- Nekaj

- Polje

- Področja

- Slika

- file

- prva

- fit

- Osredotočite

- Osredotoča

- sledi

- po

- za

- je pokazala,

- štiri

- Frankfurt

- iz

- funkcija

- fuzija

- splošno

- ustvarjajo

- ustvarila

- generacija

- generativno

- Generativna AI

- GitHub

- dana

- dobro

- Gost

- Gost Prispevek

- he

- slušalke

- pomoč

- tukaj

- visokozmogljivo

- več

- Poudarki

- drži

- hpc

- HTML

- HTTPS

- Hybrid

- i

- idx

- if

- slika

- slike

- izvajati

- Izvajanje

- uvoz

- in

- Vključno

- vključuje

- individualna

- Industrija

- vodilne

- Podatki

- vhod

- namestitev

- primer

- Intel

- Inteligentna

- medsebojno povezani

- vmesnik

- IT

- jpg

- samo

- Ključne

- Lane

- jezik

- velika

- Latenca

- kosilo

- UČITE

- učenje

- knjižnice

- Knjižnica

- light

- vrstica

- obremenitve

- upravlja

- upravljanje

- Maska

- Matrix

- max

- Povečajte

- maksimira

- največja

- Spomin

- očesa

- Meta

- Microsoft

- minut

- Model

- modeli

- spremembe

- več

- Najbolj

- Ime

- ozek

- naravna

- Obdelava Natural Language

- potrebno

- Nimate

- mreža

- mreženje

- omrežij

- Novo

- Naslednja generacija

- zdaj

- otopeli

- Nvidia

- predmet

- of

- on

- Na krovu

- Na vkrcanje

- ONE

- samo

- odprite

- OpenAI

- Optimizirajte

- optimizirana

- or

- Oregon

- Organizacija

- OS

- Ostalo

- ven

- izhod

- izhodi

- več

- lastne

- pakete

- Stran

- del

- mimo

- opravil

- strastno

- pot

- Plačajte

- za

- performance

- Osebni

- Dr.

- Fizika

- platforma

- platon

- Platonova podatkovna inteligenca

- PlatoData

- Točka

- Popular

- mogoče

- Prispevek

- poganja

- Precision

- prej

- , ravnateljica

- obravnavati

- Proizvedeno

- proizvaja

- Izdelek

- upravljanje izdelkov

- proizvodnja

- Izdelki

- Program

- Projekt

- zagotavlja

- zagotavljanje

- javnega

- Python

- pitorha

- Qualcomm

- hitro

- območje

- RE

- reading

- Reality

- regije

- obvezna

- Zahteve

- ohranitev

- vrnitev

- ponovna

- roy

- Run

- tek

- deluje

- Enako

- Shrani

- shranjevanje

- razširljive

- Lestvica

- SDK

- drugi

- glej

- pošljite

- stavek

- Zaporedje

- Storitev

- Storitve

- Zasedanje

- nastavite

- je

- pokazale

- Enostavno

- poenostavitev

- spletna stran

- Velikosti

- pametni telefon

- pametne telefone

- So

- rešitve

- napetost

- specialist

- sveženj

- standardna

- Začetek

- začel

- Korak

- Koraki

- shranjevanje

- trgovina

- shranjevanje

- Strategija

- Kasneje

- taka

- superior

- podpora

- Podpora

- Podpira

- SYS

- sistem

- miza

- tehnike

- Tehnologija

- besedilo

- da

- O

- njihove

- POTEM

- te

- jih

- ta

- 3

- skozi

- pretočnost

- do

- do

- danes

- tokenizirati

- orodje

- Topi

- baklo

- Skupaj za plačilo

- Prometa

- usposobljeni

- transformatorji

- Res

- tuning

- Navodila

- poenoteno

- univerza

- us

- uporaba

- primeru uporabe

- primeri uporabe

- Rabljeni

- uporabnik

- uporabo

- običajno

- v1

- POTRDI

- vrednost

- Virtual

- Vizija

- obisk

- we

- web

- spletne storitve

- Dobro

- West

- Kaj

- ki

- medtem

- široka

- Širok spekter

- bo

- z

- beseda

- deluje

- po vsem svetu

- let

- Vi

- Vaša rutina za

- zefirnet