Danes z veseljem sporočamo, da so modeli temeljev Code Llama, ki jih je razvila Meta, na voljo strankam prek Amazon SageMaker JumpStart za uvedbo z enim klikom za tekoče sklepanje. Code Llama je najsodobnejši veliki jezikovni model (LLM), ki je sposoben generirati kodo in naravni jezik o kodi tako iz pozivov kode kot naravnega jezika. Code Llama je brezplačen za raziskovanje in komercialno uporabo. Ta model lahko preizkusite s SageMaker JumpStart, središčem za strojno učenje (ML), ki omogoča dostop do algoritmov, modelov in rešitev ML, tako da lahko hitro začnete uporabljati ML. V tem prispevku si ogledamo, kako odkriti in uvesti model Code Llama prek SageMaker JumpStart.

Kaj je Code Llama

Code Llama je model, ki ga je izdal Meta ki je zgrajen na vrhu Llama 2 in je najsodobnejši model, zasnovan za izboljšanje produktivnosti pri programskih nalogah za razvijalce, tako da jim pomaga ustvariti visoko kakovostno, dobro dokumentirano kodo. Modeli prikazujejo najsodobnejšo zmogljivost v Pythonu, C++, Javi, PHP, C#, TypeScript in Bash ter lahko prihranijo čas razvijalcem in naredijo delovne tokove programske opreme učinkovitejše. Na voljo je v treh različicah, zasnovanih tako, da pokrivajo široko paleto aplikacij: temeljni model (Code Llama), specializirani model za Python (Code Llama-Python) in model, ki sledi navodilom za razumevanje navodil naravnega jezika (Code Llama-Instruct). ). Vse različice Code Llama so na voljo v treh velikostih: parametri 7B, 13B in 34B. Različici 7B in 13B base in instruct podpirata izpolnjevanje na podlagi okoliške vsebine, zaradi česar sta idealni za aplikacije pomočnika kode.

Modeli so bili zasnovani z uporabo Llama 2 kot osnove in nato usposobljeni na 500 milijardah žetonov kodnih podatkov, pri čemer je bila specializirana različica Python usposobljena na postopnih 100 milijardah žetonov. Modeli Code Llama zagotavljajo stabilne generacije z do 100,000 žetoni konteksta. Vsi modeli so usposobljeni za zaporedja 16,000 žetonov in kažejo izboljšave pri vhodih z do 100,000 žetoni.

Model je na voljo pod isto licenca skupnosti kot Llama 2.

Kaj je SageMaker JumpStart

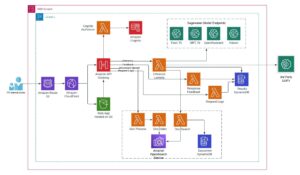

S SageMaker JumpStart lahko praktiki ML izbirajo med rastočim seznamom najuspešnejših modelov temeljev. Strokovnjaki ML lahko uvedejo temeljne modele v namenske Amazon SageMaker primerke v omrežno izoliranem okolju in prilagodite modele z uporabo SageMakerja za usposabljanje in uvajanje modelov.

Zdaj lahko odkrijete in uvedete modele Code Llama z nekaj kliki Amazon SageMaker Studio ali programsko prek SDK-ja SageMaker Python, kar vam omogoča, da izpeljete zmogljivost modela in kontrole MLOps s funkcijami SageMaker, kot je Amazonski cevovodi SageMaker, Napaka Amazon SageMaker, ali kontejnerski dnevniki. Model je nameščen v varnem okolju AWS in pod vašimi kontrolami VPC, kar pomaga zagotoviti varnost podatkov. Modele Code Llama je mogoče odkriti in jih je mogoče uporabiti v regijah Vzhod ZDA (S. Virginija), Zahod ZDA (Oregon) in Evropa (Irska).

Stranke morajo sprejeti EULA za uvedbo SDK modela visa SageMaker.

Odkrijte modele

Do modelov temeljev Code Llama lahko dostopate prek SageMaker JumpStart v uporabniškem vmesniku SageMaker Studio in SDK SageMaker Python. V tem razdelku bomo opisali, kako odkriti modele v SageMaker Studio.

SageMaker Studio je integrirano razvojno okolje (IDE), ki ponuja enoten spletni vizualni vmesnik, kjer lahko dostopate do namensko izdelanih orodij za izvajanje vseh razvojnih korakov ML, od priprave podatkov do gradnje, usposabljanja in uvajanja vaših modelov ML. Za več podrobnosti o tem, kako začeti in nastaviti SageMaker Studio, glejte Amazon SageMaker Studio.

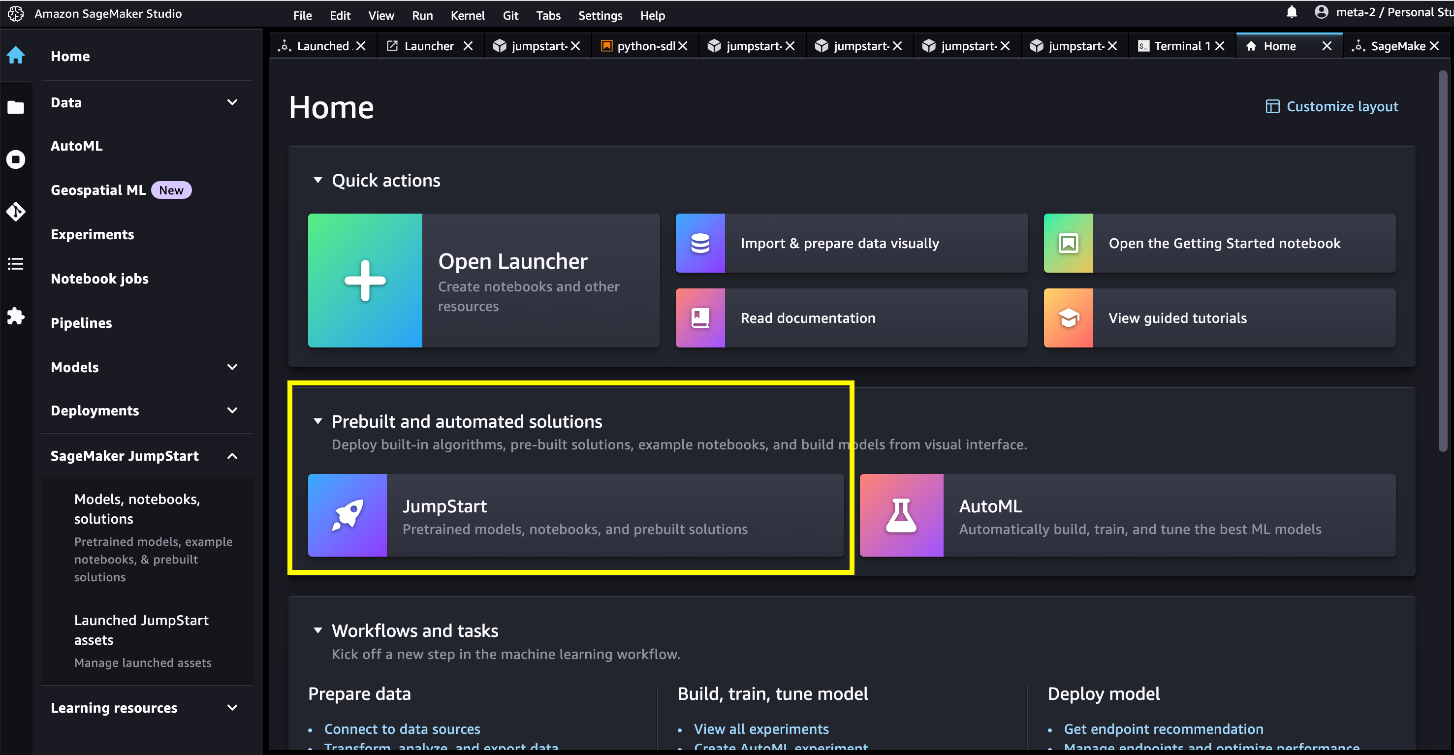

V SageMaker Studio lahko dostopate do SageMaker JumpStart, ki vsebuje vnaprej pripravljene modele, prenosnike in vnaprej pripravljene rešitve, pod Predizdelane in avtomatizirane rešitve.

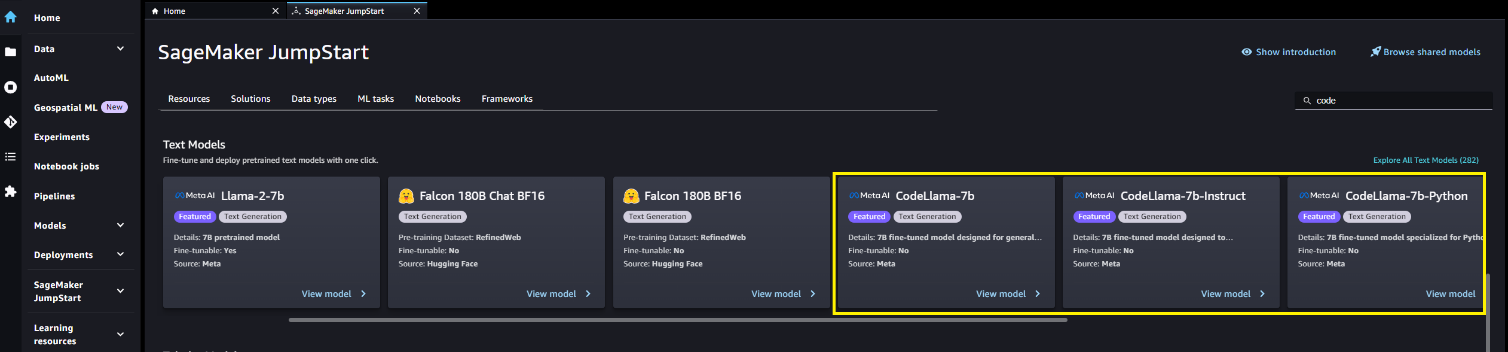

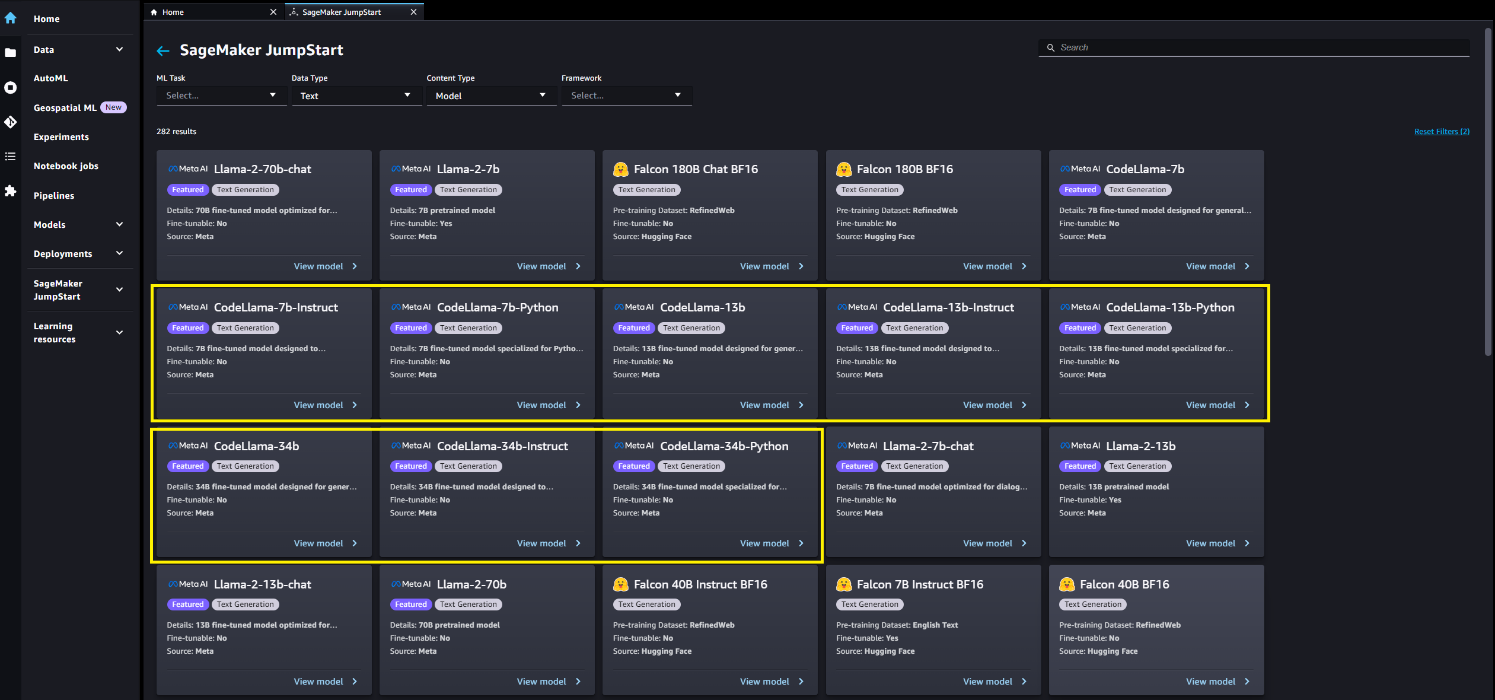

Na ciljni strani SageMaker JumpStart lahko brskate po rešitvah, modelih, prenosnikih in drugih virih. Modele Code Llama najdete v Temeljni modeli: generiranje besedila vrtiljak.

Z izbiro najdete tudi druge modelske variante Raziščite vse modele generiranja besedila ali iskanje Code Llama.

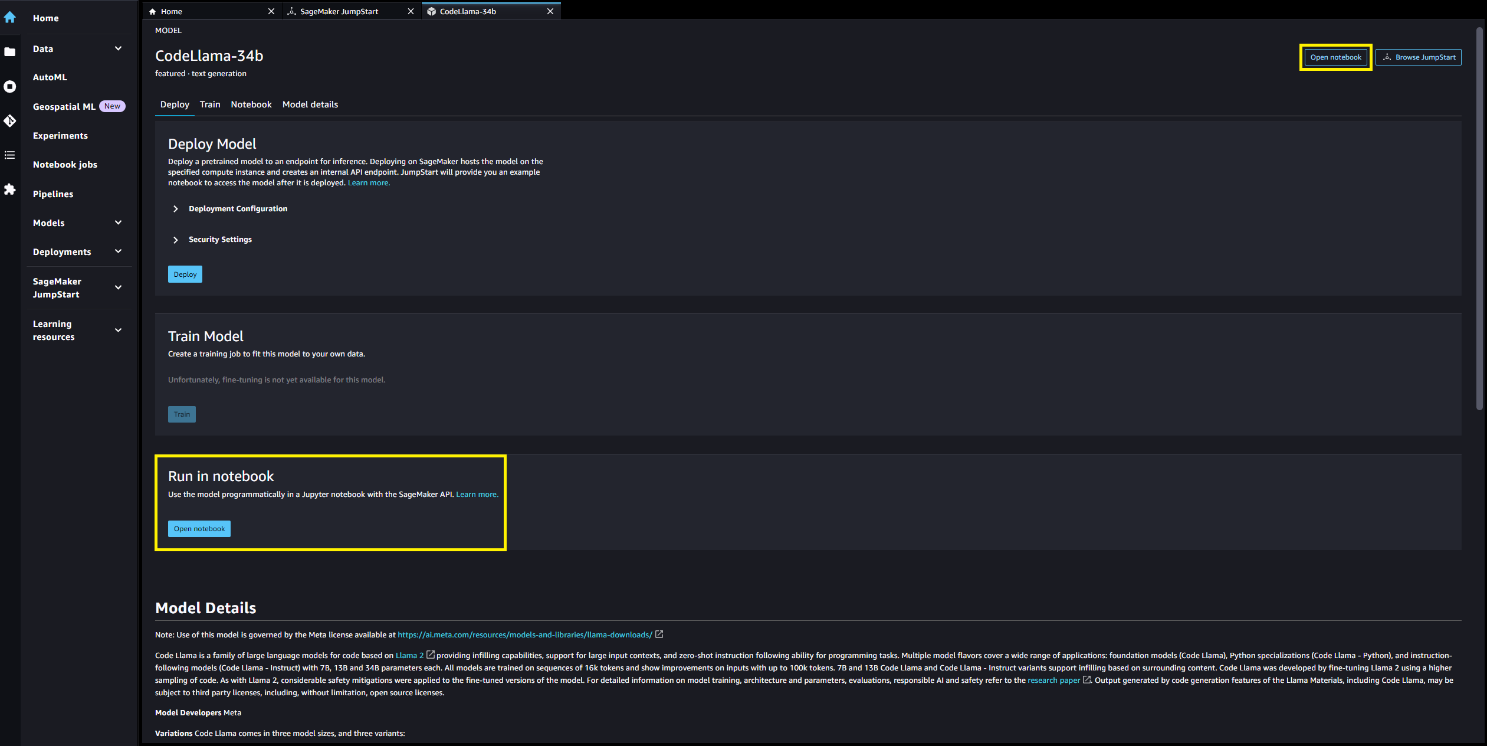

Izberete lahko kartico modela, da si ogledate podrobnosti o modelu, kot so licenca, podatki, uporabljeni za usposabljanje, in način uporabe. Našli boste tudi dva gumba, uvajanje in Odprite Beležnico, ki vam bo pomagal pri uporabi modela.

uvajanje

Ko izberete uvajanje in potrdite pogoje, se bo začela uvedba. Druga možnost je, da uvedete prek vzorčnega prenosnika tako, da izberete Odprite Beležnico. Primer zvezka, ki ponuja navodila od konca do konca o tem, kako razmestiti model za sklepanje in čiščenje virov.

Za uvajanje z uporabo prenosnega računalnika začnemo z izbiro ustreznega modela, ki ga določi model_id. Kateri koli od izbranih modelov lahko namestite na SageMaker z naslednjo kodo:

To razmesti model v SageMaker s privzetimi konfiguracijami, vključno s privzeto vrsto primerka in privzetimi konfiguracijami VPC. Te konfiguracije lahko spremenite tako, da podate neprivzete vrednosti v JumpStartModel. Ko je uveden, lahko izvedete sklepanje glede na uvedeno končno točko prek napovedovalca SageMaker:

Upoštevajte, da je privzeto accept_eula nastavljena na false. Morate nastaviti accept_eula=true da uspešno prikličete končno točko. S tem sprejemate uporabniško licenčno pogodbo in politiko sprejemljive uporabe, kot je bilo omenjeno prej. Lahko tudi prenesi licenčno pogodbo.

Custom_attributes ki se uporabljajo za posredovanje EULA, so pari ključ/vrednost. Ključ in vrednost sta ločena z =, pari pa so ločeni z ;. Če uporabnik posreduje isti ključ več kot enkrat, se zadnja vrednost ohrani in posreduje upravljalniku skripta (v tem primeru se uporablja za pogojno logiko). Na primer, če accept_eula=false; accept_eula=true se nato posreduje strežniku accept_eula=true se hrani in posreduje upravljavcu skripta.

Parametri sklepanja nadzirajo proces generiranja besedila na končni točki. Največji nadzor novih žetonov se nanaša na velikost izhoda, ki ga ustvari model. Upoštevajte, da to ni enako številu besed, ker besedišče modela ni enako besedišču angleškega jezika in vsak žeton morda ni beseda angleškega jezika. Temperatura nadzoruje naključnost v izhodu. Višja temperatura povzroči bolj ustvarjalne in halucinirane rezultate. Vsi parametri sklepanja so neobvezni.

Naslednja tabela navaja vse modele Code Llama, ki so na voljo v SageMaker JumpStart, skupaj z ID-ji modela, privzetimi vrstami primerkov in največjim številom podprtih žetonov (vsota števila vhodnih žetonov in števila ustvarjenih žetonov za vse sočasne zahteve), podprtih za vsakega od teh modelov.

| Ime modela | ID modela | Privzeta vrsta primerka | Največ podprtih žetonov |

| KodaLlama-7b | meta-textgeneration-llama-codellama-7b | ml.g5.2xvelik | 10000 |

| CodeLlama-7b-Instruct | meta-textgeneration-llama-codellama-7b-instruct | ml.g5.2xvelik | 10000 |

| CodeLlama-7b-Python | meta-textgeneration-llama-codellama-7b-python | ml.g5.2xvelik | 10000 |

| KodaLlama-13b | meta-textgeneration-llama-codellama-13b | ml.g5.12xvelik | 32000 |

| CodeLlama-13b-Instruct | meta-textgeneration-llama-codellama-13b-instruct | ml.g5.12xvelik | 32000 |

| CodeLlama-13b-Python | meta-textgeneration-llama-codellama-13b-python | ml.g5.12xvelik | 32000 |

| KodaLlama-34b | meta-textgeneration-llama-codellama-34b | ml.g5.48xvelik | 48000 |

| CodeLlama-34b-Instruct | meta-textgeneration-llama-codellama-34b-instruct | ml.g5.48xvelik | 48000 |

| CodeLlama-34b-Python | meta-textgeneration-llama-codellama-34b-python | ml.g5.48xvelik | 48000 |

Medtem ko so bili modeli Code Llama usposobljeni za kontekstno dolžino 16,000 žetonov, so modeli poročali o dobri zmogljivosti pri še večjih kontekstnih oknih. Največji podprti stolpec žetonov v prejšnji tabeli je zgornja meja podprtega kontekstnega okna na privzeti vrsti primerka. Ker lahko model Code Llama 7B podpira samo 10,000 žetonov na primerku ml.g5.2xlarge, priporočamo uvedbo različice modela 13B ali 34B, če so za vašo aplikacijo potrebni večji konteksti.

Privzeto vsi modeli delujejo za naloge generiranja kode. Osnovni model in model navodil se odzivata na naloge izpolnjevanja, čeprav je imel osnovni model boljšo kakovost izhoda za večino vzorčnih poizvedb. Končno, samo modeli inštrukcij delujejo na inštruktorskih nalogah. Naslednja tabela ponazarja, kateri modeli so imeli dobro zmogljivost (dobro) in zmerno zmogljivost (zmerno) pri vzorčnih poizvedbah v predstavitvenih zvezkih.

| . | Generiranje kode | Polnjenje kode | Navodila za kodo |

| KodaLlama-7b | dobro | dobro | N / A |

| CodeLlama-7b-Instruct | dobro | Zmerno | dobro |

| CodeLlama-7b-Python | dobro | N / A | N / A |

| KodaLlama-13b | dobro | dobro | N / A |

| CodeLlama-13b-Instruct | dobro | Zmerno | dobro |

| CodeLlama-13b-Python | dobro | N / A | N / A |

| KodaLlama-34b | dobro | N / A | N / A |

| CodeLlama-34b-Instruct | dobro | N / A | dobro |

| CodeLlama-34b-Python | dobro | N / A | N / A |

Ustvarjanje kode

Naslednji primeri so bili izvedeni na modelu CodeLlama-34b-Instruct s parametri koristne obremenitve "parameters": {"max_new_tokens": 256, "temperature": 0.2, "top_p": 0.9}:

Polnjenje kode

Polnjenje kode vključuje vračanje ustvarjene kode glede na okoliški kontekst. To se razlikuje od naloge generiranja kode, ker ima model poleg segmenta kode s predpono tudi pripono segmenta kode. Med fino nastavitvijo so bili uporabljeni posebni žetoni za označevanje začetka predpone (<PRE>), začetek pripone (<SUF>), in začetek sredine (<MID>). Vhodna zaporedja v model morajo biti v eni od naslednjih oblik:

- predpona-pripona-srednja -

<PRE> {prefix} <SUF>{suffix} <MID> - pripona-predpona-srednja -

<PRE> <SUF>{suffix} <MID> {prefix}

Naslednji primeri uporabljajo obliko prefix-suffix-middle na modelu CodeLlama-7b s koristnim parameters {"max_new_tokens": 256, "temperature": 0.05, "top_p": 0.9}:

Navodila za kodo

Meta je zagotovila tudi različico Code Llama, prilagojeno navodilom. Primere poizvedb v tem razdelku je mogoče uporabiti samo za te z navodili prilagojene modele Code Llama, ki so modeli s pripono ukaza ID modela. Oblika kode Llama za navodila je enaka obliki poziva Llama-2-chat, ki jo podrobno opisujemo v Modeli temeljev Llama 2 so zdaj na voljo v SageMaker JumpStart

Preprost uporabniški poziv je lahko videti takole:

Dodate lahko tudi sistemski poziv z naslednjo sintakso:

Končno lahko vzpostavite pogovorno interakcijo z modelom tako, da v vnos vključite vse prejšnje uporabniške pozive in odgovore pomočnika:

Ti primeri so bili izvedeni na modelu CodeLlama-13b-Instruct s parametri koristne obremenitve »parametri«: {"max_new_tokens": 512, "temperature": 0.2, "top_p": 0.9}:

Čiščenje

Ko končate z zagonom zvezka, izbrišite vse vire, ki ste jih ustvarili med postopkom, da bo vaše zaračunavanje ustavljeno. Uporabite naslednjo kodo:

zaključek

V tej objavi smo vam pokazali, kako začeti z modeli Code Llama v SageMaker Studio in uvesti model za generiranje kode in naravnega jezika o kodi iz pozivov kode in naravnega jezika. Ker so osnovni modeli vnaprej usposobljeni, lahko pomagajo znižati stroške usposabljanja in infrastrukture ter omogočijo prilagoditev za vaš primer uporabe. Za začetek obiščite SageMaker JumpStart v SageMaker Studio.

viri

O avtorjih

Gabriel Synnaeve je raziskovalni direktor v skupini Facebook AI Research (FAIR) pri Meti. Pred Meto je bil Gabriel podoktorski sodelavec v ekipi Emmanuela Dupouxa na École Normale Supérieure v Parizu, kjer se je ukvarjal z obratnim inženiringom pri pridobivanju jezika pri dojenčkih. Gabriel je doktoriral iz Bayesovega modeliranja, ki se uporablja za umetno inteligenco v strateških igrah v realnem času, na Univerzi v Grenoblu.

Gabriel Synnaeve je raziskovalni direktor v skupini Facebook AI Research (FAIR) pri Meti. Pred Meto je bil Gabriel podoktorski sodelavec v ekipi Emmanuela Dupouxa na École Normale Supérieure v Parizu, kjer se je ukvarjal z obratnim inženiringom pri pridobivanju jezika pri dojenčkih. Gabriel je doktoriral iz Bayesovega modeliranja, ki se uporablja za umetno inteligenco v strateških igrah v realnem času, na Univerzi v Grenoblu.

Eissa Jamil je partnerski inženir RL, Generative AI pri Meta.

Eissa Jamil je partnerski inženir RL, Generative AI pri Meta.

Dr. Kyle Ulrich je uporabni znanstvenik pri ekipi Amazon SageMaker JumpStart. Njegovi raziskovalni interesi vključujejo skalabilne algoritme strojnega učenja, računalniški vid, časovne vrste, Bayesove neparametrične in Gaussove procese. Njegov doktorat je pridobil na Univerzi Duke in je objavil članke v NeurIPS, Cell in Neuron.

Dr. Kyle Ulrich je uporabni znanstvenik pri ekipi Amazon SageMaker JumpStart. Njegovi raziskovalni interesi vključujejo skalabilne algoritme strojnega učenja, računalniški vid, časovne vrste, Bayesove neparametrične in Gaussove procese. Njegov doktorat je pridobil na Univerzi Duke in je objavil članke v NeurIPS, Cell in Neuron.

Dr. Ashish Khetan je višji aplikativni znanstvenik pri Amazon SageMaker JumpStart in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Dr. Ashish Khetan je višji aplikativni znanstvenik pri Amazon SageMaker JumpStart in pomaga pri razvoju algoritmov strojnega učenja. Doktoriral je na Univerzi Illinois Urbana-Champaign. Je aktiven raziskovalec strojnega učenja in statističnega sklepanja ter je objavil številne članke na konferencah NeurIPS, ICML, ICLR, JMLR, ACL in EMNLP.

Vivek Singh je produktni vodja pri SageMaker JumpStart. Osredotoča se na omogočanje strankam, da vključijo SageMaker JumpStart, da poenostavijo in pospešijo njihovo pot ML za izdelavo aplikacij Generative AI.

Vivek Singh je produktni vodja pri SageMaker JumpStart. Osredotoča se na omogočanje strankam, da vključijo SageMaker JumpStart, da poenostavijo in pospešijo njihovo pot ML za izdelavo aplikacij Generative AI.

- Distribucija vsebine in PR s pomočjo SEO. Okrepite se še danes.

- PlatoData.Network Vertical Generative Ai. Opolnomočite se. Dostopite tukaj.

- PlatoAiStream. Web3 Intelligence. Razširjeno znanje. Dostopite tukaj.

- PlatoESG. Ogljik, CleanTech, Energija, Okolje, sončna energija, Ravnanje z odpadki. Dostopite tukaj.

- PlatoHealth. Obveščanje o biotehnologiji in kliničnih preskušanjih. Dostopite tukaj.

- vir: https://aws.amazon.com/blogs/machine-learning/code-llama-code-generation-models-from-meta-are-now-available-via-amazon-sagemaker-jumpstart/

- :ima

- : je

- :ne

- :kje

- ][str

- $GOR

- 000

- 1

- 10

- 100

- 12

- 13

- 15%

- 16

- 24

- 28

- 30

- 36

- 500

- 7

- 700

- 8

- 9

- a

- O meni

- pospeši

- Sprejmi

- sprejemljiv

- dostop

- potrditi

- pridobitev

- aktivna

- dodajte

- Poleg tega

- po

- proti

- Sporazum

- AI

- ai raziskave

- algoritmi

- vsi

- skupaj

- Prav tako

- Amazon

- Amazon SageMaker

- Amazon SageMaker JumpStart

- Amazon Web Services

- an

- in

- in infrastrukturo

- Objavi

- odgovori

- kaj

- uporaba

- aplikacije

- uporabna

- primerno

- SE

- AS

- Pomočnik

- At

- Avtomatizirano

- Na voljo

- AWS

- baza

- temeljijo

- bash

- Bajezijski

- BE

- ker

- bilo

- pred

- začetek

- Začetek

- Boljše

- med

- zaračunavanje

- Billion

- Milijarde žetonov

- tako

- Razčlenitev

- izgradnjo

- Building

- zgrajena

- vendar

- by

- C + +

- CAN

- lahko

- kartice

- Vrtiljak

- primeru

- CD

- spremenite

- znaki

- Otroci

- Izberite

- izbiri

- razred

- klik

- Koda

- Stolpec

- kako

- prihaja

- komercialna

- računalnik

- Računalniška vizija

- sočasno

- konference

- Konzole

- Posoda

- Vsebuje

- vsebina

- ozadje

- kontekstih

- nadzor

- Nadzor

- pogovorni

- stroški

- pokrov

- ustvarjajo

- ustvaril

- Creative

- Trenutna

- Stranke, ki so

- customization

- prilagodite

- datum

- Varovanje podatkov

- Dnevi

- namenjen

- privzeto

- demo

- razporedi

- razporejeni

- uvajanja

- uvajanje

- razpolaga

- zasnovan

- Podatki

- Podrobnosti

- Razvoj

- razvili

- Razvijalci

- Razvoj

- Razlika

- drugačen

- Direktor

- imeniki

- odkriti

- do

- tem

- opravljeno

- prenosov

- Duke

- vojvodska univerza

- med

- vsak

- prej

- East

- učinkovite

- omogočajo

- omogočanje

- konec

- konec koncev

- Končna točka

- inženir

- inženirstva

- Angleščina

- zagotovitev

- okolje

- Evropa

- Tudi

- Primer

- Primeri

- Razen

- razburjen

- izključuje

- eksponentna

- razširitev

- Tovarna

- sejem

- false

- Lastnosti

- kolega

- Nekaj

- datoteke

- končno

- Najdi

- prva

- Osredotoča

- sledili

- po

- za

- format

- Fundacija

- brezplačno

- iz

- funkcija

- Games

- ustvarila

- ustvarjajo

- generacija

- generacije

- generativno

- Generativna AI

- dobili

- git

- Daj

- dana

- Go

- dobro

- prisodil

- Pridelovanje

- Navodila

- imel

- strani

- Imajo

- he

- pomoč

- pomoč

- Pomaga

- tukaj

- visoka

- več

- njegov

- gostitelj

- Kako

- Kako

- HTML

- HTTPS

- Hub

- i

- ID

- idealen

- ID-ji

- if

- Illinois

- ponazarja

- uvoz

- izboljšanje

- Izboljšave

- in

- vključujejo

- Vključno

- Infrastruktura

- vhod

- vhodi

- namestitev

- namestitev

- primer

- Navodila

- integrirana

- interakcije

- interesi

- vmesnik

- Irska

- izolirani

- IT

- ITS

- Java

- JavaScript

- Potovanje

- hranijo

- Ključne

- tipke

- Kyle

- pristanek

- jezik

- velika

- večja

- Največji

- Zadnja

- učenje

- levo

- dolžina

- Naj

- Licenca

- kot

- LIMIT

- Seznam

- seznami

- Llama

- LLM

- lokalna

- Logika

- Poglej

- izgleda kot

- nižje

- stroj

- strojno učenje

- je

- Večina

- Znamka

- Izdelava

- upravitelj

- Vodje

- več

- znamka

- največja

- Maj ..

- pomeni

- omenjeno

- Meta

- Bližnji

- ML

- MLOps

- Model

- modeliranje

- modeli

- spremembe

- mesec

- več

- učinkovitejše

- morajo

- naravna

- Nimate

- mreža

- Novo

- Vozel

- vozlišča

- Noben

- prenosnik

- zdaj

- Številka

- of

- on

- Na krovu

- enkrat

- ONE

- samo

- or

- Da

- Oregon

- Ostalo

- ven

- izhod

- več

- paket

- Stran

- parov

- članki

- parametri

- paris

- partner

- mimo

- opravil

- vozovnice

- Izvedite

- performance

- Dr.

- PHP

- ping

- platon

- Platonova podatkovna inteligenca

- PlatoData

- politika

- Prispevek

- potencial

- Predictor

- priprava

- prejšnja

- Predhodna

- Postopek

- Procesi

- Izdelek

- produktni vodja

- produktivnost

- Programiranje

- zagotavljajo

- če

- zagotavlja

- objavljeno

- Python

- kakovost

- poizvedbe

- hitro

- naključnost

- v realnem času

- prejetih

- Priporočamo

- glejte

- nanaša

- regije

- sprosti

- odstrani

- Odstranjeno

- Prijavljeno

- Skladišče

- zahteva

- obvezna

- Raziskave

- raziskovalec

- viri

- Odzove

- odgovorov

- povzroči

- Rezultati

- vrnitev

- vrnitev

- vrne

- Pravica

- koren

- Run

- tek

- s

- sagemaker

- Enako

- Shrani

- razširljive

- Znanstvenik

- script

- SDK

- Iskalnik

- iskanje

- sekund

- Oddelek

- zavarovanje

- varnost

- Segment

- izbran

- izbiranje

- SAMO

- višji

- Serija

- strežnik

- Storitve

- nastavite

- shouldnt

- Prikaži

- je pokazala,

- Enostavno

- poenostavitev

- saj

- sam

- Velikosti

- velikosti

- So

- Software

- rešitve

- posebna

- specializirani

- specifična

- določeno

- po delih

- stabilna

- Začetek

- začel

- state-of-the-art

- Statistično

- Koraki

- ustavil

- Strategija

- String

- studio

- Uspešno

- taka

- vsote

- podpora

- Podprti

- Preverite

- Okolica

- sintaksa

- sistem

- miza

- Naloga

- Naloge

- skupina

- pove

- Pogoji

- besedilo

- kot

- da

- O

- njihove

- Njih

- POTEM

- te

- jih

- ta

- čeprav?

- 3

- skozi

- čas

- Časovne serije

- do

- žeton

- Boni

- orodja

- vrh

- Vlak

- usposobljeni

- usposabljanje

- Drevo

- Res

- poskusite

- dva

- tip

- Vrste

- Tipkovnica

- ui

- pod

- razumevanje

- univerza

- us

- uporaba

- primeru uporabe

- Rabljeni

- uporabnik

- uporabo

- vrednost

- Vrednote

- Variant

- raznolikost

- različica

- preko

- Poglej

- Virginia

- Visa

- Vizija

- obisk

- obiskali

- sprehod

- je

- način..

- načini

- we

- web

- spletne storitve

- Web-Based

- so bili

- West

- Kaj

- Kaj je

- ki

- široka

- bo

- okno

- okna

- z

- v

- beseda

- besede

- delo

- delovnih tokov

- deluje

- pisati

- Vi

- Vaša rutina za

- zefirnet