- Maj 12, 2014

- Vasilis Vryniotis

- . 4 komentarjev

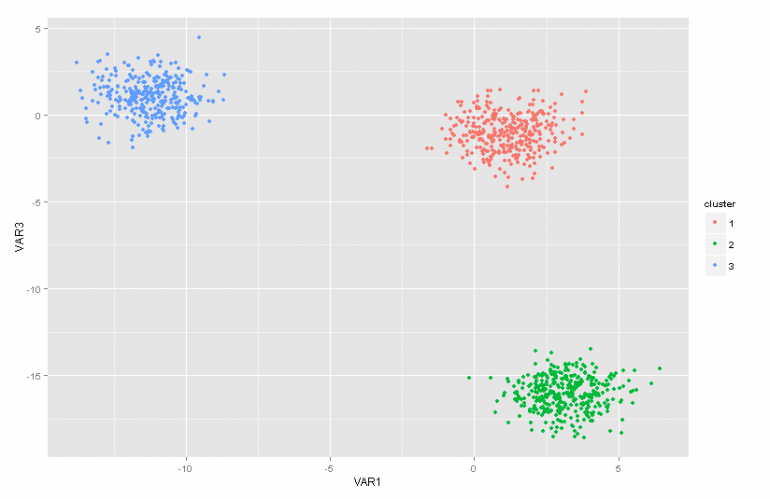

Ta spletna objava je drugi del serije člankov o modelih mešanic Dirichlet Process. V prejšnjem članku smo imeli pregled več tehnik grozdne analize in razpravljali smo o nekaterih težavah / omejitvah, ki se pojavljajo z njihovo uporabo. Poleg tega smo na kratko predstavili modele zmesi Dirichlet Process, govorili smo, zakaj so koristni, in predstavili smo nekatere njihove aplikacije.

Posodobitev: Okvir za strojno učenje Datebox je zdaj odprtokoden in brez njega prenesi. Oglejte si paket com.datumbox.framework.machinelearning.clustering in si oglejte izvedbo modelov mešanic Dirichlet Process Mešanice na Javi.

Dirichletovi modeli mešanic procesnih postopkov so na začetku nekoliko težko požirati predvsem zato, ker so neskončni modeli mešanic z veliko različnimi predstavitvami. Na srečo je dober način, da pristopite k temi, tako da začnete z modeli končnih mešanic z Dirichletovo distribucijo in nato preidete na neskončne.

Posledično bom v tem članku na kratko predstavil nekaj pomembnih distribucij, ki jih bomo potrebovali, uporabili jih bomo za izdelavo Dirichletovega priorja z modelom večinomske verjetnosti in nato prešli na model končnih mešanic, ki temelji na Dirichletovi distribuciji.

1. Beta distribucija

O Beta distribucija je družina neprekinjenih porazdelitev, ki je določena v intervalu [0,1]. Parametrizira ga dva pozitivna parametra a in b, njegova oblika pa je močno odvisna od izbire teh dveh parametrov.

Slika 1: Beta porazdelitev za različne a, b parametre

Beta distribucija se običajno uporablja za modeliranje porazdelitve po verjetnosti in ima naslednjo gostoto verjetnosti:

![]()

Enačba 1: Beta PDF

Kjer je Γ (x) gama funkcija in a, b parametri porazdelitve. Beta se običajno uporablja kot porazdelitev verjetnostnih vrednosti in nam daje verjetnost, da bo modelirana verjetnost enaka določeni vrednosti P = p0. Beta distribucija je po svoji definiciji sposobna modelirati verjetnost binarnih izidov, ki imajo vrednosti resnične ali napačne. Parametri a in b se lahko štejeta kot psevdokaza uspeha oziroma neuspeha. Tako Beta distribucija modelira verjetnost uspeha glede na uspehe in b neuspehe.

2. Dirichletova distribucija

O Dirichlet distribucija je posploševanje porazdelitve beta za več izidov (ali z drugimi besedami, uporablja se za dogodke z več izidi). Parametrizira se s k parametri ai ki mora biti pozitiven. Dirichletova distribucija je enaka Beta distribuciji, če je število spremenljivk k = 2.

Slika 2: Dirichletova distribucija za različne ai parametri

Dirichletova distribucija se običajno uporablja za modeliranje porazdelitve po verjetnostih in ima naslednjo gostoto verjetnosti:

![]()

Enačba 2: Dirichlet PDF

Če je Γ (x) gama funkcija, je pi vzemite vrednosti v [0,1] in Σpi= 1. Dirichletova distribucija modelira skupno porazdelitev stri in daje verjetnost P1=p1,P2=p2,…., Strk-1=pk-1 s Pk= 1 - ΣPi. Kot v primeru Bete je tudi ai parametri se lahko štejejo za psevdoštev nastopov vsakega i dogodka. Dirichletova distribucija se uporablja za modeliranje verjetnosti, da se bodo zgodili k rivalski dogodki k, in je pogosto označena kot Dirichlet (a).

3. Dirichlet prior z večinomsko verjetnostjo

Kot smo že omenili, je razdelitev Dirichleta mogoče obravnavati kot porazdelitev na verjetnostne porazdelitve. V primerih, ko želimo modelirati verjetnost dogodkov k, bi uporabili Bayesov pristop Večpomenska verjetnost in Dirichlet Priors .

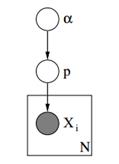

Spodaj lahko vidimo grafični model takšnega modela.

Slika 3: Grafični model Dirichlet Priors z večinomsko verjetnostjo

V zgornjem grafičnem modelu je α dimenzijski vektor ak s hiperparametri Dirichletovih priorov, p je ak dimenzijski vektor z vrednostmi verjetnosti in xi je skalarna vrednost od 1 do k, ki nam pove, kateri dogodek se je zgodil. Na koncu naj opozorimo, da P sledi Dirichletovi porazdelitvi, parametrizirani z vektorjem α in s tem P ~ Dirichlet (α), medtem ko xi spremenljivke sledijo parametrirani diskretni distribuciji (Multinomial) s p vektorjem verjetnosti. Podobne hierarhične modele je mogoče uporabiti pri razvrščanju dokumentov za prikaz porazdelitve frekvenc ključnih besed v različnih temah.

4. Model končnih mešanic z razdelitvijo Dirichlet

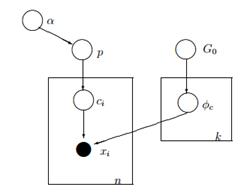

Z uporabo Dirichlet distribucije lahko konstruiramo a Končni model mešanice ki jih lahko uporabimo za izvajanje grozdov. Predpostavimo, da imamo naslednji model:

![]()

![]()

![]()

![]()

Enačba 3: Model končnih mešanic z Dirichletovo porazdelitvijo

Zgornji model predvideva naslednje: Imamo nabor podatkov X z n opazovanji in želimo na njem opraviti analizo grozdov. K je konstantno končno število, ki prikazuje število gruč / komponent, ki jih bomo uporabili. Ci spremenljivke shranjujejo gručo dodelitev opazovanja Xi, sprejmejo vrednosti od 1 do k in sledijo diskretni porazdelitvi s parametrom p, ki so verjetnosti mešanice komponent. F je generativna porazdelitev našega X in se poda s parametrom ![]() kar je odvisno od razporeditve grozda vsakega opazovanja. Skupaj imamo k unikatnih

kar je odvisno od razporeditve grozda vsakega opazovanja. Skupaj imamo k unikatnih ![]() parametrov, ki so enaki številu naših grozdov. The

parametrov, ki so enaki številu naših grozdov. The ![]() spremenljivka shranjuje parametre, ki parametrizirajo generativno porazdelitev F in domnevamo, da sledi osnovnemu G0 distribucija. Spremenljivka p shranjuje mešanice v vsakem od k skupin in sledi Dirichletu s parametri α / k. Končno je α dimenzijski vektor ak s hiperparametri (psevdoštevki) Dirichletove porazdelitve [2].

spremenljivka shranjuje parametre, ki parametrizirajo generativno porazdelitev F in domnevamo, da sledi osnovnemu G0 distribucija. Spremenljivka p shranjuje mešanice v vsakem od k skupin in sledi Dirichletu s parametri α / k. Končno je α dimenzijski vektor ak s hiperparametri (psevdoštevki) Dirichletove porazdelitve [2].

Slika 4: Grafični model modela končnih mešanic z Dirichletovo porazdelitvijo

Enostavnejši in manj matematičen način pojasnjevanja modela je naslednji. Predvidevamo, da lahko naše podatke razvrstimo v k skupin. Vsaka skupina ima svoje parametre ![]() in ti parametri se uporabljajo za ustvarjanje naših podatkov. Parametri

in ti parametri se uporabljajo za ustvarjanje naših podatkov. Parametri ![]() se domneva, da sledijo neki distribuciji G0. Vsako opazovanje je predstavljeno z vektorjem xi in aci vrednost, ki označuje skupino, ki ji pripada. Posledično je ci lahko vidimo kot spremenljivko, ki sledi diskretni porazdelitvi s parametrom p, ki ni nič drugega kot verjetnosti mešanice, tj. verjetnost pojava vsake skupine. Glede na to, da s težavo rešujemo na Bayesov način, parametra p ne obravnavamo kot konstantni neznani vektor. Namesto tega domnevamo, da P sledi Dirichletu, ki je parametriran s hiperparametri α / k.

se domneva, da sledijo neki distribuciji G0. Vsako opazovanje je predstavljeno z vektorjem xi in aci vrednost, ki označuje skupino, ki ji pripada. Posledično je ci lahko vidimo kot spremenljivko, ki sledi diskretni porazdelitvi s parametrom p, ki ni nič drugega kot verjetnosti mešanice, tj. verjetnost pojava vsake skupine. Glede na to, da s težavo rešujemo na Bayesov način, parametra p ne obravnavamo kot konstantni neznani vektor. Namesto tega domnevamo, da P sledi Dirichletu, ki je parametriran s hiperparametri α / k.

5. Delo z neskončnimi k skupki

Prejšnji model mešanice nam omogoča izvajanje nenadzorovanega učenja, sledi Bayesovemu pristopu in ga je mogoče razširiti, da ima hierarhično strukturo. Kljub temu gre za končni model, saj uporablja konstantno vnaprej določeno k število skupin. Kot rezultat tega moramo določiti število komponent pred izvedbo Cluster analize, in kot smo že govorili v večini aplikacij, to ni znano in ga ni mogoče enostavno oceniti.

Eden od načinov za rešitev tega je zamisliti, da ima k zelo veliko vrednost, ki teži do neskončnosti. Z drugimi besedami si lahko predstavljamo mejo tega modela, ko se k nagiba v neskončnost. Če je tako, potem lahko vidimo, da kljub temu, da je število skupin k neskončno, dejansko število aktivnih skupin (tistih, ki imajo vsaj eno opazovanje), ne more biti večje od n (kar je skupno število opazovanj v našem naboru podatkov). Kot bomo videli kasneje, bo število aktivnih grozdov bistveno manjše od n in bodo sorazmerne z ![]() .

.

Seveda je meja k do neskončnosti nepomembna. Pojavi se več vprašanj, na primer, ali je mogoče prevzeti takšno mejo, kako bi izgledal ta model in kako kako lahko konstruiramo in uporabite tak model.

V naslednjem članku se bomo osredotočili na natančno ta vprašanja: opredelili bomo postopek Dirichlet, predstavili bomo različne predstavitve DP in se na koncu osredotočili na kitajski restavracijski postopek, ki je intuitiven in učinkovit način za izgradnjo Dirichletovega procesa.

Upam, da se vam zdi ta objava uporabna. Če ste, prosim, vzemite trenutek in delite članek na Facebooku in Twitterju. 🙂

- AI

- ai art

- ai art generator

- imajo robota

- Umetna inteligenca

- certificiranje umetne inteligence

- robot z umetno inteligenco

- roboti z umetno inteligenco

- programska oprema za umetno inteligenco

- blockchain

- blockchain konferenca ai

- coingenius

- pogovorna umetna inteligenca

- kripto konferenca ai

- dall's

- Datumbox

- globoko učenje

- strojno učenje

- Strojno učenje in statistika

- platon

- platon ai

- Platonova podatkovna inteligenca

- Igra Platon

- PlatoData

- platogaming

- lestvica ai

- sintaksa

- zefirnet